Téknik Ajakan

Ngartos LLM Fine-Tuning: Nyaluyukeun Modél Basa Gedé pikeun Sarat Unik Anjeun

Nalika urang nangtung dina Séptémber 2023, bentang Modél Basa Besar (LLM) masih nyaksian kebangkitan modél kalebet Alpaca, Falcon, Lemah 2, GPT-4, sareng seueur anu sanésna.

Aspék penting pikeun ngamangpaatkeun poténsi LLM ieu aya dina prosés fine-tuning, strategi anu ngamungkinkeun kustomisasi modél anu tos dilatih pikeun nyayogikeun tugas-tugas khusus kalayan presisi. Ngaliwatan fine-tuning ieu model ieu sabenerna bisa align kalawan syarat individualized, nawarkeun solusi anu duanana inovatif tur tailored ka kabutuhan unik.

Najan kitu, hal anu penting pikeun dicatet yén teu sakabéh jalan fine-tuning dijieun sarua. Contona, ngakses kamampuh fine-tuning tina GPT-4 asalna di premium, merlukeun langganan mayar nu kawilang leuwih mahal dibandingkeun pilihan séjén sadia di pasar. Di sisi séjén, domain open-source sibuk ku alternatip anu nawiskeun jalur anu langkung gampang diaksés pikeun ngamangpaatkeun kakuatan modél basa anu ageung. Pilihan open-source ieu ngadémokrasikeun aksés kana téknologi AI canggih, ngabina inovasi sareng inklusivitas dina bentang AI anu ngembang pesat.

Naha LLM fine-tuning penting?

LLM fine-tuning leuwih ti hiji enhancement teknis; éta mangrupa aspék krusial tina ngembangkeun model LLM anu ngamungkinkeun pikeun aplikasi leuwih husus sarta refined dina sagala rupa tugas. Fine-tuning nyaluyukeun model anu tos dilatih supados langkung cocog sareng set data khusus, ningkatkeun kinerjana dina tugas-tugas khusus sareng mastikeun aplikasi anu langkung sasar. Éta ngahasilkeun kamampuan LLM anu luar biasa pikeun adaptasi sareng data énggal, nunjukkeun kalenturan anu penting dina minat anu terus-terusan ngembang dina aplikasi AI.

Fine-tuning model basa badag muka nepi loba kasempetan, sahingga aranjeunna unggul dina tugas husus mimitian ti analisis sentimen ka ulasan literatur médis. Ku nyaluyukeun modél dasar kana kasus pamakean khusus, kami muka konci kamungkinan anyar, ningkatkeun efisiensi sareng akurasi modél. Leuwih ti éta, éta mempermudah a utilization leuwih ekonomis sumberdaya sistem, sakumaha fine-tuning merlukeun kakuatan komputasi kirang dibandingkeun latihan model ti scratch.

Nalika urang langkung jero kana pituduh ieu, urang bakal ngabahas intricacies of LLM fine-tuning, masihan anjeun tinjauan komprehensif anu dumasar kana kamajuan panganyarna sareng prakték pangsaéna di lapangan.

Paréntah-Dumasar Rupa-Tuning

Fase fine-tuning dina AI Generatif lifecycle, digambarkeun dina gambar di handap ieu dicirikeun ku integrasi inputs instruksi jeung outputs, gandeng ku conto hambalan-demi-hambalan nalar. Pendekatan ieu ngagampangkeun modél dina ngahasilkeun réspon anu henteu ngan ukur relevan tapi ogé saluyu sareng petunjuk khusus anu dilebetkeun kana éta. Dina fase ieu modél anu tos dilatih diadaptasi pikeun ngabéréskeun tugas anu béda sareng kasus pamakean, ngagunakeun set data pribadi pikeun ningkatkeun fungsionalitasna.

Tunggal-Tugas Fine-Tuning

Tunggal-tugas fine-tuning museurkeun kana honing kaahlian model urang dina tugas husus, kayaning summarization. Pendekatan ieu hususna mangpaat pikeun ngaoptimalkeun alur kerja anu ngalibetkeun dokumén ageung atanapi utas paguneman, kalebet dokumén hukum sareng tikét dukungan pelanggan. Éstuning, fine-tuning ieu bisa ngahontal perbaikan kinerja signifikan kalawan set relatif leutik conto, mimitian ti 500 nepi ka 1000, kontras jeung milyaran tokens garapan dina fase pre-latihan.

Yayasan LLM Fine-Tuning LLM: Arsitéktur Transformer sareng Saluareun

Lalampahan pamahaman LLM fine-tuning dimimitian ku keupeul unsur dasar nu mangrupakeun LLMs. Dina manah model ieu perenahna di arsitéktur trafo, jaringan saraf nu leverages mékanisme timer perhatian pikeun prioritas konteks kecap leuwih deukeut maranéhanana dina kalimah. Pendekatan inovatif ieu ngagampangkeun pamahaman anu langkung jero ngeunaan hubungan anu jauh antara token dina input.

Nalika urang napigasi ngaliwatan intricacies of trafo, urang sapatemon prosés multi-hambalan nu dimimitian ku encoder nu. Fase awal ieu ngalibatkeun tokenizing input sareng nyiptakeun vektor embedding anu ngagambarkeun input sareng posisina dina kalimah. Tahap satuluyna ngalibatkeun runtuyan itungan ngagunakeun matriks katelah nyangsikeun, ajen, sarta konci, culminating dina skor timer perhatian nu dictates fokus kana bagian béda tina kalimah sarta sagala rupa tokens.

Fine-tuning nangtung salaku fase kritis dina ngembangkeun LLMs, prosés nu diperlukeun nyieun pangaluyuan halus pikeun ngahontal kaluaran leuwih desirable. Tahap ieu, sanaos penting, nampilkeun sakumpulan tantangan, kalebet tungtutan komputasi sareng neundeun pikeun nanganan sajumlah ageung parameter. Parameter Efficient Fine-Tuning (PEFT) nawiskeun téknik pikeun ngirangan jumlah parameter anu kedah disaluyukeun, ku kituna nyederhanakeun prosés latihan.

LLM Pra-Latihan: Ngadegkeun Base Strong

Dina tahap awal pangwangunan LLM, pra-latihan nyandak tahap tengah, ngagunakeun trafo over-parameterized salaku arsitéktur dasar. Prosés ieu ngalibatkeun modél basa alami dina rupa-rupa tatakrama sapertos bidirectional, autoregressive, atanapi sequence-to-sequence on corpora unsupervised skala badag. Tujuanana di dieu nyaéta pikeun nyiptakeun dasar anu tiasa disaluyukeun engke pikeun tugas-tugas hilir khusus ku cara ngenalkeun tujuan khusus tugas.

Tren anu penting dina widang ieu nyaéta kanaékan skala LLM anu tos dilatih, diukur ku jumlah parameter. Data empiris konsistén nunjukkeun yén modél anu langkung ageung gandeng sareng langkung seueur data ampir sok ngahasilkeun pagelaran anu langkung saé. Salaku conto, GPT-3, kalayan 175 milyar parameterna, parantos netepkeun patokan pikeun ngahasilkeun basa alami anu kualitas luhur sareng ngalaksanakeun rupa-rupa tugas nol-shot kalayan pinter.

Fine-Tuning: Jalan ka Modél Adaptasi

Saatos pra-latihan, LLM ngalaman fine-tuning pikeun adaptasi jeung tugas husus. Sanajan kinerja ngajangjikeun ditémbongkeun ku learning in-konteks dina LLMs pre-dilatih kayaning GPT-3, fine-tuning tetep unggul dina setélan tugas-spésifik. Sanajan kitu, pendekatan kaprah tina pinuh parameter fine-tuning nampilkeun tantangan, kaasup tungtutan komputasi tinggi na memori, utamana lamun kaayaan model skala badag.

Pikeun modél basa anu ageung kalayan langkung ti samilyar parameter, manajemén efisien GPU RAM mangrupikeun pivotal. Parameter model tunggal dina precision 32-bit pinuh merlukeun 4 bait spasi, narjamahkeun kana sarat 4GB GPU RAM ngan pikeun muka model parameter 1 milyar. Prosés palatihan saleresna nungtut langkung seueur mémori pikeun nampung sababaraha komponén kalebet kaayaan pangoptimal sareng gradién, anu berpotensi ngabutuhkeun dugi ka 80GB GPU RAM pikeun modél skala ieu.

Pikeun nganapigasi watesan GPU RAM, kuantisasi dipaké nu mangrupakeun téhnik nu ngurangan precision parameter model, kukituna nurunna syarat memori. Contona, ngarobah precision tina 32-bit ka 16-bit bisa ngurangan satengah mémori diperlukeun pikeun loading jeung latihan model. Engké dina artikel ieu. urang bakal diajar ngeunaan Qlora anu ngagunakeun konsép kuantisasi pikeun tuning.

Ngajalajah Kategori Métode PEFT

Dina prosés pinuh fine-tuning Modél Basa Besar, hal anu penting pikeun boga setelan komputasi nu éfisién bisa nanganan teu ngan beurat model badag, nu keur model paling canggih ayeuna ngahontal ukuran dina ratusan gigabytes, tapi ogé ngatur. runtuyan elemen kritis séjén. Ieu kalebet alokasi mémori pikeun kaayaan pangoptimal, ngatur gradién, aktivasina maju, sareng ngagampangkeun mémori samentawis salami sababaraha tahapan prosedur latihan.

Métode aditif

Jenis tuning ieu tiasa ngagedekeun modél anu tos dilatih sareng parameter tambahan atanapi lapisan, fokus kana latihan ngan ukur parameter anu nembé ditambah. Sanaos ningkatkeun jumlah parameter, metode ieu ningkatkeun waktos latihan sareng efisiensi rohangan. Métode aditif salajengna dibagi kana sub-kategori:

- Adapters: Incorporating jaringan leutik pinuh disambungkeun pos trafo sub-lapisan, kalawan conto kasohor keur AdaMix, KronA, jeung Compactor.

- Lemes Ajakan: Fine-tuning bagean tina embeddings input model urang ngaliwatan gradién turunan, jeung IPT, awalan-tuning, sareng WARP janten conto anu kasohor.

- Pendekatan Aditif séjén: Kalebet téknik sapertos LeTS, AttentionFusion, sareng Ladder-Side Tuning.

Métode Selektif

PEFTs Selektif nyaluyukeun sajumlah kawates lapisan luhur dumasar kana jinis lapisan sareng struktur modél internal. Kategori ieu ngawengku métode kawas BitFit jeung LN tuning, nu museurkeun kana tuning elemen husus kayaning model biases atawa baris husus.

Métode dumasar-Reparametrization

Métode ieu ngagunakeun répréséntasi réngking rendah pikeun ngirangan jumlah parameter anu tiasa dilatih, anu paling kasohor nyaéta Adaptasi Rengking Rendah atanapi LoRA. Metoda ieu ngamangpaatkeun dékomposisi matriks rengking-rendah saderhana pikeun ngaparameterkeun pembaruan beurat, nunjukkeun panyetelan anu épéktip dina subspasi pangkat rendah.

1) LoRA (Adaptasi Rengking Rendah)

LoRA mecenghul salaku téhnik PEFT groundbreaking, diwanohkeun dina kertas ku Edward J. Hu sareng anu sanésna dina 2021. Ieu beroperasi dina kategori reparameterization, katirisan beurat aslina tina LLM sarta ngahijikeun trainable matriks low-rank anyar kana unggal lapisan arsitektur Transformer. Pendekatan ieu henteu ngan ukur ngirangan jumlah parameter anu tiasa dilatih tapi ogé ngirangan waktos latihan sareng sumber komputasi anu dipikabutuh, ku kituna nampilkeun alternatif anu langkung éfisién pikeun nyempurnakeun pinuh.

Pikeun ngartos mékanika LoRA, urang kedah ningali deui arsitektur trafo dimana ajakan input ngalaman tokenisasi sareng konvérsi kana vektor embedding. Vektor-vektor ieu ngaliwat bagéan encoder sareng/atawa dekoder trafo, mendakan jaringan-perhatian diri sareng jaringan maju anu beuratna parantos dilatih.

LoRA ngagunakeun konsép tina Dékomposisi Nilai Tunggal (SVD). Intina, SVD ngabedah matriks kana tilu matriks anu béda, salah sahiji nyaéta matriks diagonal anu ngandung nilai tunggal. Nilai tunggal ieu penting sabab ngukur pentingna diménsi anu béda dina matriks, kalayan nilai anu langkung ageung nunjukkeun pentingna anu langkung luhur sareng anu langkung alit nunjukkeun signifikansi anu langkung alit.

Pendekatan ieu ngamungkinkeun LoRA ngajaga ciri penting tina data bari ngirangan dimensi, ku kituna ngaoptimalkeun prosés fine-tuning.

LoRA campur dina prosés ieu, katirisan sadaya parameter modél asli sareng ngenalkeun sapasang "matriks dékomposisi pangkat" sareng beurat aslina. Ieu matriks leutik, dilambangkeun salaku A jeung B, ngalaman latihan ngaliwatan learning diawasan.

Unsur pivotal dina strategi ieu parameter disebut rank ('r'), nu dictates ukuran matrices low-rank. Pilihan taliti tina 'r' bisa ngahasilkeun hasil impressive, sanajan kalawan nilai nu leuwih leutik, kukituna nyieun hiji matriks low-rank kalawan parameter pangsaeutikna pikeun ngalatih. Strategi ieu parantos dilaksanakeun sacara efektif nganggo perpustakaan open-source sapertos HuggingFace Transformers, ngagampangkeun LoRA fine-tuning pikeun sagala rupa tugas kalayan efisiensi anu luar biasa.

2) QLoRA: Nyandak LoRA Efisiensi Luhur

Ngawangun dina yayasan diteundeun ku LoRA, QLoRA salajengna ngaminimalkeun sarat memori. Diwanohkeun ku Tim Dettmers sareng anu sanésna dina 2023, éta ngagabungkeun adaptasi réngking rendah sareng kuantisasi, ngagunakeun format kuantisasi 4-bit anu disebut Biasa Ngambang or nf4. Kuantisasi dina dasarna mangrupikeun prosés anu mindahkeun data tina répréséntasi inpormasi anu langkung luhur ka anu kirang inpormasi. Pendekatan ieu ngajaga efficacy métode fine-tuning 16-bit, dequantizing beurat 4-bit ka 16-bit sakumaha diperlukeun salila prosés komputasi.

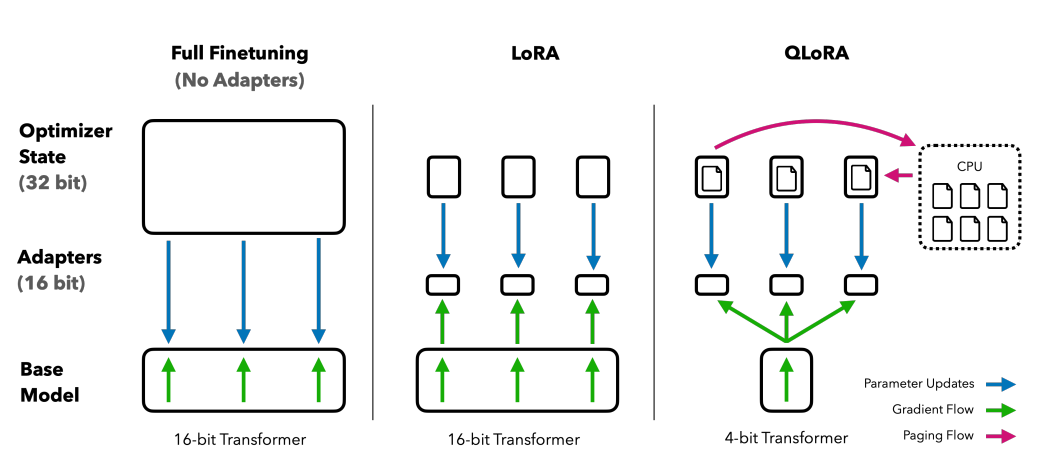

Ngabandingkeun metode finetuning: QLORA ningkatkeun LoRA kalayan kuantisasi presisi 4-bit sareng pangoptimal paged pikeun manajemén spike memori

QLoRA ngungkit NumericFloat4 (nf4), nargétkeun unggal lapisan dina arsitéktur trafo, sareng ngenalkeun konsép kuantisasi ganda pikeun ngaleutikan deui tapak mémori anu dipikabutuh pikeun nyaluyukeun. Hal ieu dihontal ku ngalaksanakeun kuantisasi dina konstanta anu parantos dikuantisasi, strategi anu ngahindarkeun spike mémori pamariksaan gradién has ngaliwatan pamanfaatan pangoptimal paged sareng manajemén mémori ngahiji.

guanaco, nu mangrupakeun ensemble QLORA-katala, susunan patokan dina solusi chatbot open-source. Kinerjana, disahkeun ngaliwatan penilaian manusa sareng otomatis sacara sistematis, negeskeun dominasi sareng efisiensi di lapangan.

Versi 65B sareng 33B Guanaco, disaluyukeun nganggo versi anu dirobih tina OASST1 dataset, muncul salaku contenders formidable pikeun model renowned kawas Ngobrol GPT komo GPT-4.

Fine-tuning ngagunakeun Pangajaran Reinforcement tina Umpan Balik Manusa

Pangajaran Panguatan tina Umpan Balik Manusa (RLHF) dimaénkeun nalika nyaluyukeun modél basa anu tos dilatih pikeun nyaluyukeun langkung raket sareng nilai-nilai manusa. Konsep ieu diwanohkeun ku Open AI dina 2017 peletakan pondasi pikeun kasimpulan dokumen ditingkatkeun jeung ngembangkeun InstructGPT.

Inti RLHF nyaéta paradigma pembelajaran penguatan, jinis téknik pembelajaran mesin dimana an agen diajar kumaha kalakuanana dina hiji lingkungan ku pintonan ancoan jeung narima ganjaran. Ieu loop kontinyu tina aksi jeung eupan balik, dimana agén ieu incentivized nyieun pilihan anu bakal ngahasilkeun ganjaran pangluhurna.

Narjamahkeun ieu ranah model basa, teh agen nyaeta model sorangan, operasi dina lingkungan tina jandela konteks dibikeun tur nyieun kaputusan dumasar kana kaayaan, nu diartikeun ku tokens ayeuna dina jandela konteks. The"rohangan aksi"ngawengku sakabéh token poténsi model bisa milih ti, kalawan tujuan pikeun milih token nu aligns paling raket jeung preferensi manusa.

Prosés RLHF ngamangpaatkeun réspon manusa sacara éksténsif, ngamangpaatkeunana pikeun ngalatih modél ganjaran. Modél ieu maénkeun peran anu penting dina ngabimbing modél anu tos dilatih salami prosés nyempurnakeun, ngadorong éta ngahasilkeun kaluaran anu langkung saluyu sareng nilai-nilai manusa. Ieu prosés dinamis sarta iterative, dimana model diajar ngaliwatan runtuyan "rollouts," istilah dipaké pikeun ngajelaskeun runtuyan kaayaan jeung lampah ngarah kana ganjaran dina konteks generasi basa.

Salah sahiji poténsi anu luar biasa tina RLHF nyaéta kamampuan pikeun ngamajukeun personalisasi dina asisten AI, nyaluyukeun aranjeunna pikeun cocog sareng karesep pangguna individu, naha éta rasa humor atanapi rutinitas sapopoé. Éta muka jalan pikeun nyiptakeun sistem AI anu henteu ngan ukur pinter sacara téknis tapi ogé cerdas émosional, sanggup ngarti sareng ngaréspon kana nuansa komunikasi manusa.

Nanging, penting pikeun dicatet yén RLHF sanés solusi anu teu kaduga. Modelna masih rentan pikeun ngahasilkeun kaluaran anu teu dihoyongkeun, cerminan data anu lega sareng sering henteu diatur sareng bias anu aranjeunna dilatih.

kacindekan

Prosés fine-tuning, hiji lengkah kritis dina leveraging poténsi pinuh LLMs kayaning Alpaca, Falcon, jeung GPT-4, geus jadi leuwih refined jeung fokus, nawarkeun solusi tailored kana rupa-rupa pancén.

Urang geus katempo single-tugas fine-tuning, nu specializes di model dina peran husus, jeung métode Parameter-Efisien Fine-Tuning (PEFT) kaasup LoRA jeung QLoRA, nu boga tujuan pikeun nyieun prosés latihan leuwih efisien jeung ongkos-éféktif. Kamajuan ieu muka panto pikeun fungsionalitas AI tingkat luhur pikeun pamiarsa anu langkung lega.

Saterusna, bubuka Pangajaran Reinforcement ti Umpan Balik Manusa (RLHF) ku Open AI mangrupakeun lengkah pikeun nyieun sistem AI anu ngarti tur align leuwih raket jeung nilai manusa sarta preferensi, netepkeun panggung pikeun asisten AI anu henteu ngan pinter tapi ogé sénsitip kana. kabutuhan individu pamaké. Duanana RLHF sareng PEFT damel dina sinergi pikeun ningkatkeun fungsionalitas sareng efisiensi Modél Basa Besar.

Nalika usaha, perusahaan, sareng individu ningali pikeun ngahijikeun LLM anu disampurnakeun ieu kana operasina, aranjeunna dina dasarna ngabagéakeun masa depan dimana AI langkung ti hiji alat; Éta mangrupikeun pasangan anu ngartos sareng nyaluyukeun kana kontéks manusa, nawiskeun solusi anu inovatif sareng pribadi.