Промпт Енгинееринг

Разумевање финог подешавања ЛЛМ-а: прилагођавање великих језичких модела вашим јединственим захтевима

Како стојимо у септембру 2023. године, пејзаж великих језичких модела (ЛЛМ) и даље је сведок пораста модела укључујући Алпаку, Фалцон, Лама 2, ГПТ-4 и многи други.

Важан аспект коришћења потенцијала ових ЛЛМ-а лежи у процесу финог подешавања, стратегији која омогућава прилагођавање унапред обучених модела како би се прецизно испунили специфични задаци. Кроз ово фино подешавање ови модели могу заиста да се ускладе са индивидуализованим захтевима, нудећи решења која су иновативна и прилагођена јединственим потребама.

Међутим, битно је напоменути да нису сви начини финог подешавања створени једнаки. На пример, приступ могућностима финог подешавања ГПТ-4 је премиум, захтевајући плаћену претплату која је релативно скупља у поређењу са другим опцијама доступним на тржишту. С друге стране, домен отвореног кода врви од алтернатива које нуде приступачнији пут за искориштавање моћи великих језичких модела. Ове опције отвореног кода демократизују приступ напредној АИ технологији, подстичући иновације и инклузивност у брзом развоју АИ пејзажа.

Зашто је фино подешавање ЛЛМ важно?

ЛЛМ фино подешавање је више од техничког побољшања; то је кључни аспект развоја ЛЛМ модела који омогућава конкретнију и рафиниранију примену у различитим задацима. Фино подешавање прилагођава унапред обучене моделе да боље одговарају специфичним скуповима података, побољшавајући њихове перформансе у одређеним задацима и обезбеђујући циљанију примену. Он доноси изузетну способност ЛЛМ-а да се прилагоде новим подацима, показујући флексибилност која је од виталног значаја за стално растуће интересовање за АИ апликације.

Фино подешавање великих језичких модела отвара много могућности, омогућавајући им да се истичу у специфичним задацима у распону од анализе осећања до прегледа медицинске литературе. Подешавањем основног модела на специфичан случај употребе, откључавамо нове могућности, повећавајући ефикасност и тачност модела. Штавише, олакшава економичније коришћење системских ресурса, пошто фино подешавање захтева мање рачунарске снаге у поређењу са обучавањем модела од нуле.

Како будемо дубље улазили у овај водич, разговараћемо о замршеностима финог подешавања ЛЛМ-а, дајући вам свеобухватан преглед који је заснован на најновијим достигнућима и најбољим праксама у овој области.

Фино подешавање засновано на упутствима

Фаза финог подешавања у Генеративна АИ животни циклус, илустрован на слици испод, карактерише интеграција инпута и излаза инструкција, заједно са примерима закључивања корак по корак. Овај приступ олакшава моделу у генерисању одговора који су не само релевантни, већ и прецизно усклађени са специфичним упутствима која су у њега унесена. Током ове фазе, унапред обучени модели се прилагођавају да решавају различите задатке и случајеве коришћења, користећи персонализоване скупове података за побољшање њихове функционалности.

Фино подешавање једног задатка

Фино подешавање једног задатка се фокусира на усавршавање стручности модела у специфичном задатку, као што је сумирање. Овај приступ је посебно користан у оптимизацији радних токова који укључују значајне документе или нити разговора, укључујући правне документе и карте за корисничку подршку. Занимљиво је да ово фино подешавање може постићи значајна побољшања перформанси са релативно малим скупом примера, у распону од 500 до 1000, што је контраст у односу на милијарде токена који се користе у фази пре обуке.

Основе финог подешавања ЛЛМ ЛЛМ: Архитектура трансформатора и даље

Пут разумевања финог подешавања ЛЛМ почиње схватањем основних елемената који чине ЛЛМ. У срцу ових модела лежи архитектура трансформатора, неуронска мрежа која користи механизме самопажње да би дала приоритет контексту речи у односу на њихову близину у реченици. Овај иновативни приступ олакшава дубље разумевање удаљених односа између токена у улазу.

Док се крећемо кроз замршености трансформатора, сусрећемо се са процесом у више корака који почиње са енкодером. Ова почетна фаза укључује токенизацију улаза и креирање вектора за уграђивање који представљају улаз и његову позицију у реченици. Следеће фазе укључују серију прорачуна користећи матрице познате као Питање, вредност, и Кључ, што кулминира резултатом самопажње који диктира фокус на различите делове реченице и разне лексеме.

Фино подешавање је критична фаза у развоју ЛЛМ-а, процеса који подразумева суптилна прилагођавања како би се постигли пожељнији резултати. Ова фаза, иако је суштинска, представља скуп изазова, укључујући рачунарске и складишне захтеве за руковање огромним бројем параметара. Ефикасно фино подешавање параметара (ПЕФТ) нуди технике за смањење броја параметара који се фино подешавају, чиме се поједностављује процес обуке.

ЛЛМ пре-тренинг: успостављање јаке базе

У почетним фазама развоја ЛЛМ-а, пред-обука заузима централно место, користећи претерано параметризоване трансформаторе као основну архитектуру. Овај процес укључује моделирање природног језика на различите начине као што су двосмерни, ауторегресивни или од секвенце до секвенце на великим корпусима без надзора. Овде је циљ да се створи база која се касније може фино подесити за специфичне низводне задатке кроз увођење циљева специфичних за задатак.

Тренд вредан пажње у овој сфери је неизбежно повећање скале претходно обучених ЛЛМ, мерено бројем параметара. Емпиријски подаци доследно показују да већи модели у комбинацији са више података скоро увек дају боље перформансе. На пример, ГПТ-3, са својих 175 милијарди параметара, поставио је мерило у генерисању висококвалитетног природног језика и вешто обављање широког спектра задатака са нултим циљем.

Фино подешавање: пут до прилагођавања модела

Након претходне обуке, ЛЛМ пролази кроз фино подешавање како би се прилагодио специфичним задацима. Упркос обећавајућим перформансама које показује учење у контексту у претходно обученим ЛЛМ-има као што је ГПТ-3, фино подешавање остаје супериорно у подешавањима специфичним за задатак. Међутим, преовлађујући приступ потпуног финог подешавања параметара представља изазове, укључујући високе рачунарске и меморијске захтеве, посебно када се ради о моделима великих размера.

За велике језичке моделе са преко милијарду параметара, ефикасно управљање ГПУ РАМ-ом је кључно. Један параметар модела са пуном прецизношћу од 32 бита захтева 4 бајта простора, што значи да је потребно 4 ГБ ГПУ РАМ-а само за учитавање модела параметара од 1 милијарде. Стварни процес обуке захтева још више меморије за смештај различитих компоненти, укључујући стања оптимизатора и градијенте, што потенцијално захтева до 80 ГБ ГПУ РАМ-а за модел ове размере.

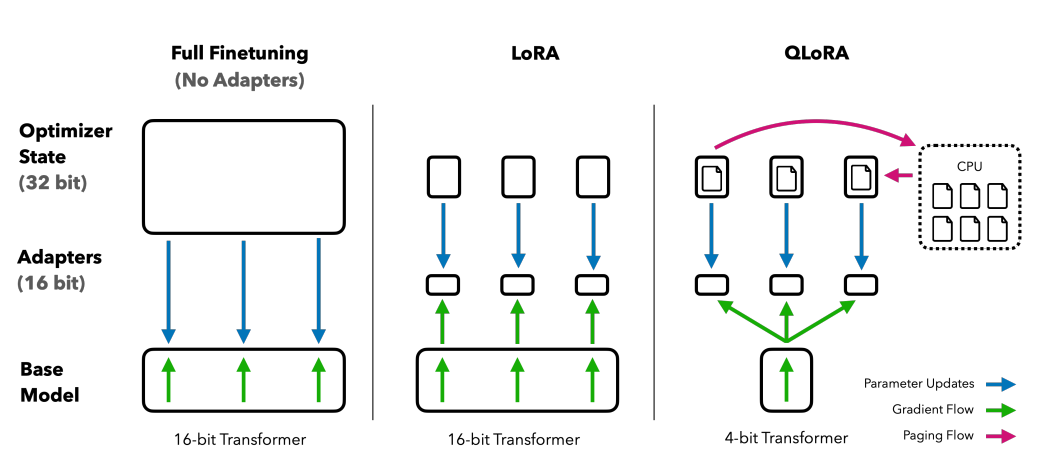

За кретање кроз ограничења ГПУ РАМ-а, користи се квантизација која је техника која смањује прецизност параметара модела, чиме се смањују захтеви за меморијом. На пример, промена прецизности са 32-битне на 16-битну може преполовити меморију потребну и за учитавање и за обуку модела. Касније у овом чланку. научићемо о Клори која користи концепт квантизације за подешавање.

Истраживање категорија ПЕФТ метода

У процесу потпуног финог подешавања модела великих језика, важно је имати рачунарско подешавање које може ефикасно да се носи не само са значајним тежинама модела, које за најнапредније моделе сада достижу величине у стотинама гигабајта, већ и да управљају низ других критичних елемената. То укључује доделу меморије за стања оптимизатора, управљање градијентима, унапред активирање и омогућавање привремене меморије током различитих фаза процедуре обуке.

Аддитиве Метход

Ова врста подешавања може да допуни претходно обучени модел додатним параметрима или слојевима, фокусирајући се на обуку само новододатих параметара. Упркос повећању броја параметара, ове методе повећавају време тренинга и ефикасност простора. Метода адитива је даље подељена на поткатегорије:

- Адаптери: Укључује мале потпуно повезане мреже после подслојева трансформатора, са значајним примерима АдаМик, КронА, и компактор.

- Софт Промптс: Фино подешавање сегмента улазних уградњи модела кроз спуштање градијента, са ИПТ, подешавање префикса, а ВАРП су истакнути примери.

- Други адитивни приступи: Укључује технике као што су ЛеТС, АттентионФусион и подешавање на страни мердевина.

Селективни метод

Селективни ПЕФТ-ови фино подешавају ограничен број горњих слојева на основу типа слоја и унутрашње структуре модела. Ова категорија укључује методе као што су БитФит LN тунинг, који се фокусира на подешавање специфичних елемената као што су пристрасности модела или одређени редови.

Метода заснована на репараметризацији

Ове методе користе репрезентације ниског ранга да би се смањио број параметара који се могу обучити, а најпознатија је адаптација ниског ранга или ЛоРА. Овај метод користи једноставну декомпозицију матрице ниског ранга да би параметризовао ажурирање тежине, демонстрирајући ефикасно фино подешавање у подпросторима ниског ранга.

1) ЛоРА (прилагођавање ниског ранга)

ЛоРА се појавила као револуционарна ПЕФТ техника, представљена у раду од Едвард Ј. Ху и други 2021. Он функционише у оквиру категорије репараметаризације, замрзавајући оригиналне тежине ЛЛМ-а и интегришући нове матрице ниског ранга које се могу обучити у сваки слој архитектуре трансформатора. Овај приступ не само да смањује број параметара који се могу обучити, већ и умањује време обуке и потребне рачунарске ресурсе, чиме представља ефикаснију алтернативу потпуном фином подешавању.

Да бисмо разумели механику ЛоРА-е, морамо поново да погледамо архитектуру трансформатора где се инпут промпт подвргава токенизацији и конверзији у векторе за уграђивање. Ови вектори пролазе кроз сегменте енкодера и/или декодера трансформатора, наилазећи на мреже самопажње и преноса унапред, чије су тежине унапред обучене.

ЛоРА користи концепт Декомпозиција сингуларне вредности (СВД). У суштини, СВД сецира матрицу на три различите матрице, од којих је једна дијагонална матрица која садржи сингуларне вредности. Ове сингуларне вредности су кључне јер мере значај различитих димензија у матрицама, при чему веће вредности указују на већу важност, а мање на мањи значај.

Овај приступ омогућава ЛоРА-и да одржи основне карактеристике података уз смањење димензионалности, чиме се оптимизује процес финог подешавања.

ЛоРА интервенише у овом процесу, замрзавајући све оригиналне параметре модела и уводећи пар „матрица декомпозиције ранга“ поред оригиналних тежина. Ове мање матрице, означене као А и Б, пролазе кроз обуку кроз надгледано учење.

Кључни елемент у овој стратегији је параметар који се зове ранг ('р'), који диктира величину матрица ниског ранга. Пажљив избор 'р' може дати импресивне резултате, чак и са мањом вредношћу, чиме се ствара матрица ниског ранга са мање параметара за обуку. Ова стратегија је ефикасно спроведена коришћењем библиотека отвореног кода као што је ХуггингФаце Трансформерс, олакшавајући ЛоРА фино подешавање за различите задатке са изузетном ефикасношћу.

2) КЛоРА: Повећање ефикасности ЛоРА

Надовезујући се на темеље које је поставио ЛоРА, КЛоРА додатно минимизира захтеве за меморијом. Интродуцед би Тим Деттмерс и други 2023, комбинује адаптацију ниског ранга са квантизацијом, користећи 4-битни формат квантизације који се назива НормалФлоат or нф4. Квантизација је у суштини процес који преноси податке са више информационе репрезентације на ону са мање информација. Овај приступ одржава ефикасност 16-битних метода финог подешавања, деквантујући 4-битне тежине на 16-битне по потреби током рачунарских процеса.

Упоређивање метода финог подешавања: КЛОРА побољшава ЛоРА са 4-битном прецизном квантизацијом и оптимизаторима страница за управљање скоковима меморије

КЛоРА користи НумерицФлоат4 (нф4), циљајући сваки слој у архитектури трансформатора, и уводи концепт двоструке квантизације како би се додатно смањио меморијски отисак потребан за фино подешавање. Ово се постиже извођењем квантизације на већ квантизованим константама, стратегије која спречава типичне скокове меморије контролне тачке градијента коришћењем страница за оптимизацију и обједињеног управљања меморијом.

Гуанацо, који је КЛОРА подешен ансамбл, поставља стандард у решењима за цхатбот са отвореним кодом. Његов учинак, потврђен кроз систематске људске и аутоматизоване процене, наглашава његову доминацију и ефикасност на терену.

Верзије 65Б и 33Б Гуанацо, фино подешене коришћењем модификоване верзије ОАССТ1 скупа података, појављују се као страшни конкуренти реномираним моделима као што су ЦхатГПТ па чак и ГПТ-4.

Фино подешавање коришћењем учења за појачавање на основу повратних информација људи

Појачано учење из људских повратних информација (РЛХФ) долази у игру када се фино подешавају унапред обучени језички модели да би се ближе ускладили са људским вредностима. Овај концепт је увео Опен АИ 2017. постављајући основу за побољшано сумирање докумената и развој ИнструцтГПТ.

У сржи РЛХФ-а је парадигма учења са појачањем, врста технике машинског учења где заступник учи како да се понаша у околина извођењем акције и примање Награде. То је континуирана петља акција povratne информације, где је агент подстакнут да доноси изборе који ће донети највећу награду.

Преводећи ово на област језичких модела, заступник је модел себе, делујући у оквиру околина датог контекстног прозора и доношење одлука на основу били су, који је дефинисан тренутним токенима у прозору контекста. „акциони простор” обухвата све потенцијалне токене које модел може да бира, са циљем да се изабере токен који је најближи људским преференцама.

РЛХФ процес у великој мери користи људске повратне информације, користећи их за обуку модела награђивања. Овај модел игра кључну улогу у вођењу унапред обученог модела током процеса финог подешавања, подстичући га да генерише резултате који су више усклађени са људским вредностима. То је динамичан и итеративни процес, где модел учи кроз серију „увођења“, термин који се користи да опише редослед стања и радњи које воде до награде у контексту генерисања језика.

Један од изузетних потенцијала РЛХФ-а је његова способност да подстакне персонализацију у помоћницима вештачке интелигенције, прилагођавајући их тако да одговарају индивидуалним преференцијама корисника, било да се ради о њиховом смислу за хумор или свакодневним рутинама. Отвара путеве за стварање АИ система који нису само технички вешти већ и емоционално интелигентни, способни да разумеју и реагују на нијансе у људској комуникацији.

Међутим, битно је напоменути да РЛХФ није сигурно решење. Модели су још увек подложни генерисању непожељних резултата, што је одраз огромних и често нерегулисаних и пристрасних података на којима су обучени.

Zakljucak

Процес финог подешавања, критичан корак у искориштавању пуног потенцијала ЛЛМ-а као што су Алпаца, Фалцон и ГПТ-4, постао је рафиниранији и фокусиранији, нудећи прилагођена рјешења за широк спектар задатака.

Видели смо фино подешавање једног задатка, које је специјализовано за моделе у одређеним улогама, и методе финог подешавања ефикасног параметара (ПЕФТ), укључујући ЛоРА и КЛоРА, које имају за циљ да процес обуке учине ефикаснијим и исплативијим. Ови развоји отварају врата за АИ функционалности високог нивоа за ширу публику.

Штавише, увођење учења за појачавање из људских повратних информација (РЛХФ) од стране Опен АИ је корак ка стварању АИ система који разумеју и ближе се усклађују са људским вредностима и преференцијама, постављајући терен за АИ асистенте који нису само паметни већ и осетљиви на индивидуалне потребе корисника. И РЛХФ и ПЕФТ раде у синергији како би побољшали функционалност и ефикасност великих језичких модела.

Како предузећа, предузећа и појединци желе да интегришу ове фино подешене ЛЛМ у своје пословање, они у суштини поздрављају будућност у којој је АИ више од алата; то је партнер који разуме и прилагођава се људским контекстима, нудећи решења која су иновативна и персонализована.