Umelá inteligencia

Problém čiernej skrinky v LLM: Výzvy a vznikajúce riešenia

Strojové učenie, podmnožina AI, zahŕňa tri komponenty: algoritmy, trénovacie údaje a výsledný model. Algoritmus, v podstate súbor procedúr, sa učí identifikovať vzory z veľkého súboru príkladov (tréningové údaje). Vyvrcholením tohto školenia je model strojového učenia. Napríklad algoritmus trénovaný s obrázkami psov by viedol k modelu schopnému identifikovať psy na obrázkoch.

Čierna skrinka v strojovom učení

V strojovom učení môže byť čiernou skrinkou ktorákoľvek z troch zložiek – algoritmus, trénovacie dáta alebo model. Aj keď sú algoritmy často verejne známe, vývojári sa môžu rozhodnúť ponechať model alebo tréningové údaje v tajnosti, aby chránili duševné vlastníctvo. Táto nejasnosť sťažuje pochopenie rozhodovacieho procesu AI.

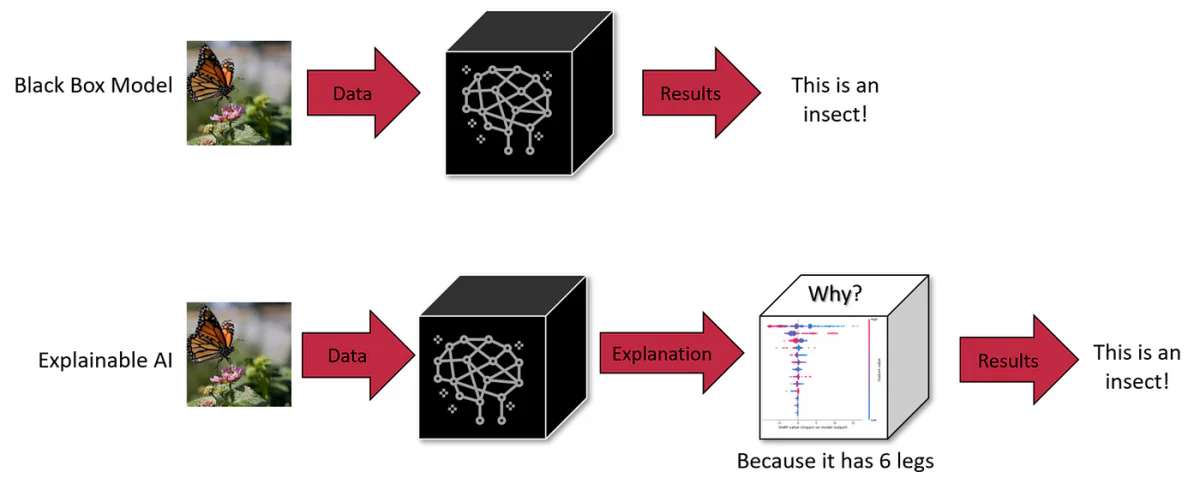

Čierne skrinky AI sú systémy, ktorých vnútorné fungovanie zostáva pre používateľov nepriehľadné alebo neviditeľné. Používatelia môžu zadávať údaje a prijímať výstup, ale logika alebo kód, ktorý vytvára výstup, zostáva skrytý. Toto je spoločná charakteristika mnohých systémov AI vrátane pokročilých generatívnych modelov ako ChatGPT a DALL-E 3.

LLM ako GPT-4 predstavujú významnú výzvu: ich vnútorné fungovanie je do značnej miery nepriehľadné, čo z nich robí „čierne skrinky“. Takáto nepriehľadnosť nie je len technickou hádankou; predstavuje skutočné bezpečnostné a etické obavy. Ak napríklad nedokážeme rozlíšiť, ako tieto systémy dospejú k záverom, môžeme im dôverovať v kritických oblastiach, ako sú lekárske diagnózy alebo finančné hodnotenia?

Rozsah a zložitosť LLM

Mierka týchto modelov pridáva na ich komplexnosti. Vezmite si napríklad GPT-3 so 175 miliardami parametrov a novšie modely s biliónmi. Každý parameter interaguje zložitým spôsobom v rámci neurónovej siete, čím prispieva k vznikajúcim schopnostiam, ktoré nie je možné predvídať samotným skúmaním jednotlivých komponentov. Tento rozsah a zložitosť takmer znemožňujú plne pochopiť ich vnútornú logiku, čo predstavuje prekážku pri diagnostike zaujatosti alebo nežiaduceho správania v týchto modeloch.

Kompromis: Mierka vs. interpretovateľnosť

Zníženie rozsahu LLM by mohlo zlepšiť interpretovateľnosť, ale za cenu ich pokročilých schopností. Mierka je to, čo umožňuje správanie, ktoré menšie modely nedokážu dosiahnuť. To predstavuje vlastný kompromis medzi rozsahom, schopnosťou a interpretovateľnosťou.

Vplyv problému čiernej skrinky LLM

1. Chybné rozhodovanie

Nepriehľadnosť v rozhodovacom procese LLM, ako je GPT-3 alebo BERT, môže viesť k nezisteným zaujatostiam a chybám. V oblastiach ako zdravotníctvo alebo trestné súdnictvo, kde majú rozhodnutia ďalekosiahle dôsledky, je neschopnosť kontrolovať LLM z hľadiska etickej a logickej správnosti hlavným problémom. Napríklad lekárska diagnóza LLM, ktorá sa spolieha na zastarané alebo skreslené údaje, môže poskytnúť škodlivé odporúčania. Podobne môžu LLM v náborových procesoch neúmyselne udržiavať rodové predsudky. Povaha čiernej skrinky tak nielen skrýva nedostatky, ale môže ich potenciálne zosilniť, čo si vyžaduje proaktívny prístup na zvýšenie transparentnosti.

2. Obmedzená prispôsobivosť v rôznych kontextoch

Nedostatočný prehľad o vnútornom fungovaní LLM obmedzuje ich prispôsobivosť. Napríklad najímanie LLM môže byť neefektívne pri hodnotení kandidátov na pozíciu, ktorá oceňuje praktické zručnosti pred akademickou kvalifikáciou, kvôli svojej neschopnosti upraviť svoje hodnotiace kritériá. Podobne môže lekárska LLM bojovať s diagnózami zriedkavých chorôb v dôsledku nerovnováhy údajov. Táto nepružnosť zdôrazňuje potrebu transparentnosti na prekalibrovanie LLM pre špecifické úlohy a kontexty.

3. Zaujatosť a medzery vo vedomostiach

Spracovanie rozsiahlych tréningových dát LLM podlieha obmedzeniam vyplývajúcim z ich algoritmov a modelových architektúr. Napríklad lekársky LLM môže vykazovať demografické predsudky, ak je vyškolený na nevyvážených súboroch údajov. Znalosť LLM v špecializovaných témach môže byť tiež zavádzajúca, čo vedie k príliš sebavedomým a nesprávnym výstupom. Riešenie týchto predsudkov a medzier vo vedomostiach si vyžaduje viac než len dodatočné údaje; vyžaduje preskúmanie mechaniky spracovania modelu.

4. Právna a etická zodpovednosť

Nejasná povaha LLM vytvára právnu sivú zónu týkajúcu sa zodpovednosti za akúkoľvek škodu spôsobenú ich rozhodnutiami. Ak LLM v lekárskom prostredí poskytuje chybné rady vedúce k poškodeniu pacienta, stanovenie zodpovednosti sa stáva obtiažnym kvôli neprehľadnosti modelu. Táto právna neistota predstavuje riziko pre subjekty, ktoré nasadzujú LLM v citlivých oblastiach, čo podčiarkuje potrebu jasného riadenia a transparentnosti.

5. Problémy s dôverou v citlivých aplikáciách

V prípade LLM používaných v kritických oblastiach, ako je zdravotná starostlivosť a financie, nedostatok transparentnosti podkopáva ich dôveryhodnosť. Používatelia a regulačné orgány musia zabezpečiť, aby tieto modely neobsahovali zaujatosti alebo nerobili rozhodnutia na základe nespravodlivých kritérií. Overenie absencie zaujatosti v LLM si vyžaduje pochopenie ich rozhodovacích procesov, pričom sa zdôrazňuje dôležitosť vysvetliteľnosti pre etické nasadenie.

6. Riziká spojené s osobnými údajmi

LLM vyžadujú rozsiahle školiace údaje, ktoré môžu zahŕňať citlivé osobné informácie. Povaha čiernej skrinky týchto modelov vzbudzuje obavy, ako sa tieto údaje spracúvajú a používajú. Napríklad lekárska LLM vyškolená na záznamoch o pacientoch vyvoláva otázky o súkromí a používaní údajov. Zabezpečenie toho, že osobné údaje nebudú zneužité alebo zneužité, si vyžaduje transparentné procesy nakladania s údajmi v rámci týchto modelov.

Vznikajúce riešenia pre interpretovateľnosť

Na riešenie týchto problémov sa vyvíjajú nové techniky. Patria sem kontrafaktuálne (CF) aproximačné metódy. Prvá metóda zahŕňa výzvu LLM, aby zmenila konkrétny textový koncept, pričom ostatné koncepty ponecháva konštantné. Tento prístup, aj keď je účinný, je v čase odvodzovania náročný na zdroje.

Druhý prístup zahŕňa vytvorenie vyhradeného priestoru na vkladanie riadeného LLM počas školenia. Tento priestor je zarovnaný s kauzálnym grafom a pomáha identifikovať zhody aproximujúce CF. Táto metóda vyžaduje menej zdrojov v čase testovania a ukázalo sa, že efektívne vysvetľuje modelové predpovede, dokonca aj v LLM s miliardami parametrov.

Tieto prístupy zdôrazňujú dôležitosť kauzálnych vysvetlení v systémoch NLP na zaistenie bezpečnosti a vytvorenie dôvery. Kontrafaktuálne aproximácie poskytujú spôsob, ako si predstaviť, ako by sa daný text zmenil, ak by bol určitý koncept v jeho generatívnom procese odlišný, čo pomáha pri praktickom odhade kauzálneho účinku vysokoúrovňových konceptov na modeloch NLP.

Deep Dive: Metódy vysvetlenia a kauzalita v LLM

Nástroje na snímanie a dôležitosť funkcií

Sondovanie je technika používaná na dešifrovanie toho, čo kódujú interné reprezentácie v modeloch. Môže byť pod dohľadom alebo bez dozoru a je zameraná na určenie, či sú na určitých miestach v sieti zakódované konkrétne koncepty. Aj keď sú do určitej miery účinné, sondy zaostávajú pri poskytovaní kauzálnych vysvetlení, ako zdôraznili Geiger et al. (2021).

Nástroje dôležitosti funkcie, iná forma metódy vysvetlenia, sa často zameriavajú na vstupné funkcie, hoci niektoré metódy založené na gradiente to rozširujú na skryté stavy. Príkladom je metóda Integrated Gradients, ktorá ponúka kauzálnu interpretáciu skúmaním základných (kontrafaktuálnych, CF) vstupov. Napriek svojej užitočnosti sa tieto metódy stále snažia prepojiť svoje analýzy s konceptmi skutočného sveta nad rámec jednoduchých vstupných vlastností.

Metódy založené na intervenciách

Metódy založené na intervenciách zahŕňajú úpravu vstupov alebo interných reprezentácií na štúdium účinkov na správanie modelu. Tieto metódy môžu vytvárať stavy CF na odhad kauzálnych účinkov, ale často generujú nepravdepodobné vstupy alebo stavy siete, pokiaľ nie sú starostlivo kontrolované. Model Causal Proxy (CPM), inšpirovaný konceptom S-learner, je v tejto oblasti novým prístupom, ktorý napodobňuje správanie vysvetleného modelu pri vstupoch CF. Hlavným obmedzením je však potreba samostatného vysvetlenia pre každý model.

Približovanie kontrafaktov

Kontrafaktuály sa široko používajú v strojovom učení na rozširovanie údajov, ktoré zahŕňa narušenie rôznych faktorov alebo označení. Môžu byť generované manuálnou úpravou, heuristickým nahradením kľúčových slov alebo automatickým prepisovaním textu. Manuálna úprava je síce presná, no zároveň je náročná na zdroje. Metódy založené na kľúčových slovách majú svoje obmedzenia a generatívne prístupy ponúkajú rovnováhu medzi plynulosťou a pokrytím.

Verné vysvetlenia

Vernosť vo vysvetleniach sa týka presného zobrazenia základného zdôvodnenia modelu. Neexistuje žiadna všeobecne akceptovaná definícia vernosti, čo vedie k jej charakterizácii prostredníctvom rôznych metrík, ako je citlivosť, konzistencia, dohoda o dôležitosti funkcií, robustnosť a simulovateľnosť. Väčšina týchto metód sa zameriava na vysvetlenia na úrovni funkcií a často spája koreláciu s príčinnou súvislosťou. Naša práca sa zameriava na poskytovanie vysvetlení konceptov na vysokej úrovni, pričom využívame literatúru kauzality na navrhnutie intuitívneho kritéria: Poriadok-vernosť.

Ponorili sme sa do prirodzenej zložitosti LLM, pochopili sme ich povahu „čiernej skrinky“ a významné výzvy, ktoré predstavuje. Od rizík chybného rozhodovania v citlivých oblastiach, ako je zdravotná starostlivosť a financie, až po etické problémy okolo zaujatosti a spravodlivosti, potreba transparentnosti v LLM nebola nikdy evidentnejšia.

Budúcnosť LLM a ich integrácia do nášho každodenného života a kritických rozhodovacích procesov závisí od našej schopnosti urobiť tieto modely nielen pokročilejšími, ale aj zrozumiteľnejšími a zodpovednejšími. Snaha o vysvetliteľnosť a interpretovateľnosť nie je len technickým úsilím, ale aj základným aspektom budovania dôvery v systémy AI. Ako sa LLM stále viac integrujú do spoločnosti, dopyt po transparentnosti bude rásť, a to nielen zo strany odborníkov na AI, ale aj zo strany každého používateľa, ktorý s týmito systémami komunikuje.