Umelá inteligencia

Oddelenie „fúzovaných“ ľudí v počítačovom videní

Nový dokument od Hyundai Motor Group Innovation Center v Singapure ponúka metódu na oddelenie „zlúčených“ ľudí v počítačovom videní – prípady, keď rámec rozpoznávania objektov našiel človeka, ktorý je nejakým spôsobom „príliš blízko“ k inému človeku (napr. ako „objímacie“ akcie alebo „stojace za“ predstavuje) a nie je schopný oddeliť dve reprezentované osoby a zameniť ich za jednu osobu alebo entitu.

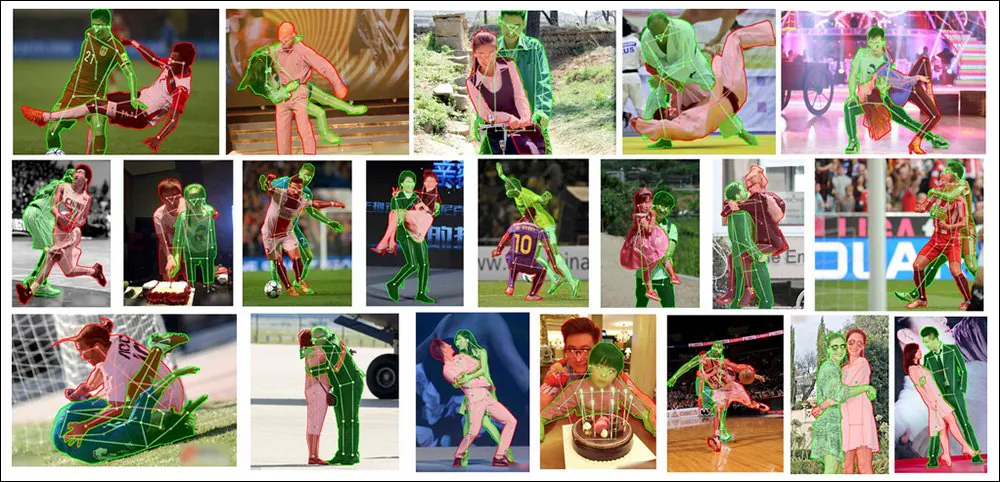

Dva sa stanú jedným, ale to nie je dobré v sémantickej segmentácii. Tu vidíme, že nový systém článku dosahuje najmodernejšie výsledky v oblasti individualizácie prepletených ľudí v zložitých a náročných obrazoch. Zdroj: https://arxiv.org/pdf/2210.03686.pdf

Ide o významný problém, ktorému sa v posledných rokoch venuje veľká pozornosť vo výskumnej komunite. Ak by sa to vyriešilo bez zjavných, ale zvyčajne nedostupných nákladov na hyperškálovanie, vlastné označovanie vedené človekom by mohlo nakoniec umožniť zlepšenie ľudskej individualizácie v systémoch text-to-image, ako napr. Stabilná difúzia, ktoré často „roztopia“ ľudí spolu, keď si nabádaná póza vyžaduje, aby boli viaceré osoby vo vzájomnej blízkosti.

Prijmite hrôzu – modely s prevodom textu na obrázok, ako sú DALL-E 2 a Stable Diffusion (oba uvedené vyššie), sa snažia reprezentovať ľudí vo veľmi tesnej blízkosti.

Aj keď generatívne modely ako DALL-E 2 a Stable Diffusion (podľa najlepšieho vedomia kohokoľvek, v prípade uzavretého zdroja DALL-E 2) v súčasnosti aj tak nepoužívajú sémantickú segmentáciu alebo rozpoznávanie objektov, tieto groteskné ľudské portmanteau nemohli v súčasnosti sa dá liečiť aplikáciou takýchto upstream metód – pretože najmodernejšie knižnice a zdroje na rozpoznávanie objektov nie sú oveľa lepšie pri rozdeľovaní ľudí ako CLIPpracovné postupy modelov latentnej difúzie.

Na vyriešenie tohto problému, nového papiera – s názvom Ľudia nemusia označovať viac ľudí: Oklúzne kopírovanie a prilepenie na segmentáciu okludovaných ľudských inštancií– prispôsobuje a vylepšuje nedávny prístup „vystrihnúť a prilepiť“ k polosyntetickým údajom, aby sa dosiahol nový náskok SOTA v úlohe, a to aj proti najnáročnejšiemu zdrojovému materiálu:

Nová metodológia Occlusion Copy & Paste v súčasnosti vedie v tejto oblasti dokonca aj oproti predchádzajúcim rámcom a prístupom, ktoré riešia túto výzvu prepracovanejšími a špecializovanejšími spôsobmi, ako je konkrétne modelovanie oklúzie.

Vystrihnite to!

Upravená metóda – názov Occlusion Copy & Paste – pochádza z roku 2021 Jednoduché kopírovanie a prilepenie dokument pod vedením Google Research, ktorý navrhol, že prekrytie extrahovaných objektov a ľudí medzi rôznymi zdrojovými tréningovými obrázkami by mohlo zlepšiť schopnosť systému rozpoznávania obrázkov diskretizovať každú inštanciu nachádzajúcu sa v obrázku:

V dokumente z roku 2021 vedenom spoločnosťou Google Research „Jednoduché kopírovanie a prilepenie je silná metóda zväčšenia údajov pre segmentáciu inštancií“ vidíme, že prvky z jednej fotografie „migrujú“ na iné fotografie s cieľom vytvoriť lepší model rozpoznávania obrázkov. Zdroj: https://arxiv.org/pdf/2012.07177.pdf

Nová verzia pridáva do tohto automatizovaného a algoritmického „prelepovania“ obmedzenia a parametre, pričom tento proces analogizuje do „koša“ obrázkov plného potenciálnych kandidátov na „prenos“ na iné obrázky na základe niekoľkých kľúčových faktorov.

Koncepčný pracovný postup pre OC&P.

Ovládanie prvkov

Medzi tieto limitujúce faktory patrí pravdepodobnosť vystrihnúť a prilepiť, čo zaisťuje, že proces neprebieha len stále, čím by sa dosiahol „saturačný“ efekt, ktorý by podkopal rozširovanie údajov; a počet obrázkov že košík bude mať kedykoľvek, kde väčší počet „segmentov“ môže zlepšiť rozmanitosť prípadov, ale predĺžiť čas predbežného spracovania; a rozsah, ktorý určuje počet obrázkov, ktoré sa prilepia do „hostiteľského“ obrázka.

Čo sa týka toho posledného, papier poznamenáva "Potrebujeme dostatočnú oklúziu, aby sa udialo, ale nie príliš veľa, pretože môžu prekryť obraz, čo môže byť škodlivé pre učenie."

Ďalšie dve inovácie pre OC&P sú cielené lepenie a prilepenie rozšírenej inštancie.

Cielené prilepenie zaisťuje, že vhodný obrázok pristane v blízkosti existujúcej inštancie v cieľovom obrázku. V predchádzajúcom prístupe z predchádzajúcej práce bol nový prvok obmedzený iba v rámci hraníc obrazu bez akéhokoľvek zohľadnenia kontextu.

Aj keď je toto „vloženie“ s cieleným prilepením pre ľudské oko zrejmé, OC&P aj jeho predchodcovia zistili, že zvýšená vizuálna autenticita nie je nevyhnutne dôležitá a môže byť dokonca problémom (pozri „Reality Bites“ nižšie).

Rozšírené prilepenie inštancií na druhej strane zaisťuje, že prilepené inštancie nevykazujú „výrazný vzhľad“, ktorý môže byť nejakým spôsobom klasifikovaný systémom, čo by mohlo viesť k vylúčeniu alebo „špeciálnemu zaobchádzaniu“, ktoré môže brániť zovšeobecneniu a použiteľnosti. . Rozšírené prilepenie moduluje vizuálne faktory, ako sú okrem iných faktorov jas a ostrosť, mierka a rotácia a sýtosť.

Z doplnkových materiálov pre nový dokument: pridanie OC&P do existujúcich rámcov uznávania je pomerne triviálne a vedie k vynikajúcej individualizácii ľudí vo veľmi úzkych hraniciach. Zdroj: https://arxiv.org/src/2210.03686v1/anc/OcclusionCopyPaste_Supplementary.pdf

Okrem toho OC&P reguluje a minimálna veľkosť pre akúkoľvek prilepenú inštanciu. Napríklad môže byť možné extrahovať obrázok jednej osoby z masívnej davovej scény, ktorý by sa dal vložiť do iného obrázka – ale v takom prípade by malý počet pixelov pravdepodobne nepomohol rozpoznaniu. Systém preto aplikuje minimálnu mierku založenú na pomere dĺžky vyrovnanej strany pre cieľový obraz.

Spoločnosť OC&P ďalej zavádza lepenie s ohľadom na mierku, kde okrem vyhľadávania podobných predmetov ako predmet prilepenia berie do úvahy aj veľkosť ohraničujúcich políčok v cieľovom obrázku. To však nevedie ku zloženým obrazom, ktoré by ľudia považovali za hodnoverné alebo realistické (pozri obrázok nižšie), ale skôr k sebe navzájom sémanticky výstižným prvkom, ktoré sú užitočné pri tréningu.

Kousnutie reality

Predchádzajúca práca, na ktorej je OC&P založená, aj súčasná implementácia kladú nízky dôraz na autenticitu alebo „fotorealitu“ akéhokoľvek konečného „montovaného“ obrazu. Aj keď je dôležité, aby konečná zostava úplne neklesla dadaizmus (inak reálne nasadenie trénovaných systémov by nikdy nemohlo dúfať, že sa stretnú s prvkami v takých scénach, na ktorých boli trénované), obe iniciatívy zistili, že značné zvýšenie „vizuálnej vierohodnosti“ nielen zvyšuje čas predspracovania, ale že takéto „vylepšenia realizmu“ sú pravdepodobne v skutočnosti kontraproduktívne.

Z doplnkového materiálu nového článku: príklady rozšírených obrázkov s „náhodným miešaním“. Hoci tieto scény môžu na človeka pôsobiť halucinogénne, napriek tomu majú podobné námety. hoci sú oklúzie pre ľudské oko fantastické, povaha potenciálnej oklúzie nemôže byť vopred známa a nie je možné ju natrénovať – preto takéto bizarné „odrezania“ formy stačia na to, aby prinútili trénovaný systém hľadať rozoznať a rozpoznať čiastočné cieľové objekty bez toho, aby ste museli vyvíjať prepracované metodológie v štýle Photoshopu, aby boli scény vierohodnejšie.

Údaje a testy

Vo fáze testovania bol systém vyškolený na človek trieda MS COCO súbor údajov, ktorý obsahuje 262,465 64,115 príkladov ľudí na XNUMX XNUMX obrázkoch. Na získanie kvalitnejších masiek ako má MS COCO však dostali aj obrázky LVIS anotácie masky.

LVIS, vydaný v roku 2019, z výskumu Facebooku, je objemný súbor údajov pre segmentáciu veľkých inštancií slovnej zásoby. Zdroj: https://arxiv.org/pdf/1908.03195.pdf

S cieľom vyhodnotiť, ako dobre môže rozšírený systém bojovať proti veľkému počtu okludovaných ľudských obrazov, výskumníci postavili OC&P proti OCHuman (Occluded Human) benchmark.

Príklady zo súboru údajov OCHuman, ktorý bol predstavený na podporu projektu detekcie Pose2Seg v roku 2018. Táto iniciatíva sa snažila odvodiť vylepšenú sémantickú segmentáciu ľudí pomocou ich postoja a pózy ako sémantického oddeľovača pre pixely reprezentujúce ich telá. Zdroj: https://github.com/liruilong940607/OCHumanApi

Keďže benchmark OCHuman nie je vyčerpávajúco anotovaný, výskumníci nového článku vytvorili podskupinu iba tých príkladov, ktoré boli plne označené, s názvom OCHumanFL. Tým sa znížil počet človek inštancií na 2,240 1,113 v rámci 1,923 951 obrázkov na overenie a XNUMX XNUMX inštancií v rámci XNUMX obrázkov skutočne použitých na testovanie. Pôvodná aj novovytvorená sada boli testované s použitím strednej priemernej presnosti (mAP) ako základnej metriky.

Kvôli konzistencii bola architektúra vytvorená z Maska R-CNN s chrbticou ResNet-50 a a rysová pyramída sieť, ktorá poskytuje prijateľný kompromis medzi presnosťou a rýchlosťou tréningu.

Vedci zaznamenali škodlivý účinok proti prúdu ImageNet vplyv v podobných situáciách bol celý systém trénovaný od nuly na 4 GPU NVIDIA V100 počas 75 epoch, podľa inicializačných parametrov vydania Facebooku v roku 2021 Detekcia 2.

výsledky

Okrem vyššie uvedených výsledkov sú východiskové výsledky proti MMD detekcia (a jeho tri pridružené modely) pre testy ukázali jasné vedenie pre OC&P v jeho schopnosti vybrať ľudské bytosti zo spletitých póz.

Okrem prekonania PoSeg a Pose2Seg, možno jedným z najvýznamnejších úspechov tohto článku je, že systém možno celkom všeobecne použiť na existujúce rámce, vrátane tých, ktoré boli proti nemu postavené v testoch (pozrite si porovnanie s/bez porovnania v prvom rámčeku výsledkov, blízko začiatku článok).

Záver článku:

„Kľúčovou výhodou nášho prístupu je to, že sa dá ľahko aplikovať na akékoľvek modely alebo iné vylepšenia zamerané na model. Vzhľadom na rýchlosť, ktorou sa oblasť hlbokého učenia pohybuje, je pre každého výhodné mať prístupy, ktoré sú vysoko interoperabilné so všetkými ostatnými aspektmi školenia. Necháme ako budúcu prácu na integrácii tohto s vylepšeniami zameranými na model, aby sme efektívne vyriešili segmentáciu inštancií okludovaných osôb.“

Potenciál na zlepšenie syntézy textu na obrázok

Vedúci autor Evan Ling v e-maile*, ktorý nám poslal, poznamenal, že hlavnou výhodou OC&P je, že si môže ponechať pôvodné štítky na maskách a získať z nich „zadarmo“ novú hodnotu v novom kontexte – tj obrázky, ktoré boli vložené do.

Hoci sa zdá, že sémantická segmentácia ľudí úzko súvisí s ťažkosťami, ktoré majú modely ako Stable Diffusion pri individualizácii ľudí (namiesto ich „zmiešania“, ako sa to často stáva), akýkoľvek vplyv, ktorý môže mať kultúra sémantického označovania na ľudskú nočnú moru. vykresľuje, že výstup SD a DALL-E 2 je často veľmi, veľmi ďaleko proti prúdu.

Tie miliardy LAION 5B obrázky podmnožín, ktoré napĺňajú generatívnu silu Stable Diffusion, neobsahujú označenia na úrovni objektu, ako sú ohraničujúce rámčeky a masky inštancií, aj keď architektúra CLIP, ktorá tvorí vykresľovanie z obrázkov a obsahu databázy, mohla mať v určitom bode z takejto inštancie prospech; obrázky LAION sú skôr označené ako „zadarmo“, pretože ich označenia boli odvodené z metadát a environmentálnych popisov atď., ktoré boli spojené s obrázkami, keď boli zoškrabané z webu do súboru údajov.

"Ale to bokom," povedal nám Ling. „Počas školenia generatívneho modelu prevodu textu na obrázok je možné použiť určitý druh rozšírenia podobného nášmu OC&P. Ale myslím si, že realizmus obrazu rozšíreného tréningu sa môže stať problémom.

„V našej práci ukazujeme, že „dokonalý“ realizmus sa vo všeobecnosti nevyžaduje pre segmentáciu kontrolovaných inštancií, ale nie som si istý, či je možné vyvodiť rovnaký záver pre tréning generatívneho modelu text-to-image (najmä keď ich výstupy očakáva sa, že budú vysoko realistické). V tomto prípade môže byť potrebné vykonať viac práce, pokiaľ ide o „zdokonalenie“ realizmu rozšírených obrázkov.“

CLIP je sa už používa ako možný multimodálny nástroj na sémantickú segmentáciu, čo naznačuje, že vylepšené systémy rozpoznávania osôb a individualizácie, ako je OC&P, by sa v konečnom dôsledku mohli rozvinúť do systémových filtrov alebo klasifikátorov, ktoré by svojvoľne odmietali „fúzované“ a skreslené ľudské reprezentácie – úloha, ktorú je ťažké dosiahnuť v súčasnosti so Stable Diffusion, pretože má obmedzenú schopnosť pochopiť, kde urobil chybu (ak by takú schopnosť mal, pravdepodobne by chybu neurobil v prvom rade).

Len jeden z množstva projektov, ktoré v súčasnosti využívajú rámec OpenAI CLIP – srdce DALL-E 2 a Stable Diffusion – na sémantickú segmentáciu. Zdroj: https://openaccess.thecvf.com/content/CVPR2022/papers/Wang_CRIS_CLIP-Driven_Referring_Image_Segmentation_CVPR_2022_paper.pdf

„Ďalšia otázka by bola,“ navrhuje Ling. „Budete jednoducho kŕmiť tieto generatívne modely obrázkami okludovaných ľudí počas tréningovej práce bez doplnkového dizajnu architektúry modelu na zmiernenie problému „fúzovania ľudí“? To je asi otázka, na ktorú sa ťažko odpovedá priamo z ruky. Bude určite zaujímavé vidieť, ako môžeme nasmerovať nejaký druh vedenia na úrovni inštancie (prostredníctvom štítkov na úrovni inštancie, ako je maska inštancie) počas tréningu generatívneho modelu textu na obrázok.'

* 10. októbra 2022

Prvýkrát uverejnené 10. októbra 2022.