Umelá inteligencia

LoReFT: Dolaďovanie reprezentácie pre jazykové modely

Parametrovo efektívne jemné ladenie alebo metódy PeFT sa snažia prispôsobiť veľké jazykové modely prostredníctvom aktualizácií malému počtu váh. Väčšina existujúcich prác týkajúcich sa interpretácie však ukázala, že reprezentácie kódujú sémanticky bohaté informácie, čo naznačuje, že môže byť lepšou a výkonnejšou alternatívou upravovať tieto reprezentácie. Predtrénované veľké modely sú často jemne vyladené na použitie pre nové domény alebo úlohy a počas procesu jemného dolaďovania možno jeden základný model prispôsobiť širokému spektru úloh, dokonca aj s malým množstvom dostupných údajov v rámci domény. k modelu. Proces dolaďovania celého modelu je však náročný na zdroje a nákladný, najmä v prípade jazykových modelov s výrazne vyšším počtom veľkostí a parametrov.

Parametrovo efektívne jemné dolaďovanie alebo metódy PeFT navrhujú riešiť vysoké náklady spojené s dolaďovaním celého modelu aktualizáciou len malého množstva celkových dostupných váh, čo je proces, ktorý pomáha skrátiť čas tréningu spolu s využitím pamäte. Čo je dôležitejšie, je, že parametricky efektívne jemné doladenie alebo metódy PeFT preukázali podobný výkon ako jemné doladenie v niekoľkých praktických nastaveniach. Adaptéry, spoločná rodina parametrovo efektívnych jemných dolaďovacích metód alebo metód PeFT, sa naučia úpravu, ktorú možno pridať do ďalšej sady závaží, ktoré fungujú popri zmrazenom základnom modeli, pričom najnovšie adaptéry ako LoRA znižujú počet trénovateľných parametrov v naučených aktualizácie hmotnosti pomocou aproximácií nízkej úrovne namiesto matíc plnej hmotnosti pri trénovaní adaptérov.

S predchádzajúcimi prácami, ktoré demonštrujú, že úpravy reprezentácií môžu byť lepšou alternatívou k parametricky efektívnemu jemnému ladeniu alebo metódam PeFT, v tomto článku budeme hovoriť o metódach jemného ladenia reprezentácie alebo ReFT, ktoré fungujú na zamrznutom modeli a naučíme sa špecifické pre danú úlohu. zásahy do skrytých reprezentácií. Tento článok má za cieľ pokryť do hĺbky rámec ReFt alebo Representation Fine-tuning a skúmame mechanizmus, metodológiu, architektúru rámca spolu s jeho porovnaním s najnovšími rámcami. Tak poďme na to.

ReFT: Jemné ladenie reprezentácie pre jazykové modely

V snahe osvojiť si predtrénované jazykové modely na nové domény a úlohy súčasné rámce dolaďujú tieto predtrénované jazykové modely často, keďže pri implementovanom procese jemného dolaďovania je možné jeden základný model prispôsobiť rôznym úlohám, dokonca pri práci s malým množstvom údajov v rámci domény. Hoci proces jemného ladenia zvyšuje celkový výkon, je to nákladný proces, najmä ak má jazykový model výrazne vysoký počet parametrov. Na vyriešenie tohto problému a zníženie súvisiacich nákladov, PeFT alebo Parameter-efektívne dolaďovanie rámcov aktualizovať len malú časť celkových váh, čo je proces, ktorý nielen skracuje čas školenia, ale tiež znižuje využitie pamäte, čo umožňuje rámcom PeFT dosiahnuť podobný výkon v porovnaní s prístupmi úplného jemného ladenia v praktických scenároch. Adaptéry, spoločná rodina PeFT, fungujú tak, že sa učia úpravu, ktorú možno pridať k ďalšej sade závaží spolu s podmnožinou závaží, ktoré fungujú v súlade so základným modelom so zmrazenými závažiami. Nedávne rámce adaptérov ako napr LoRA a QLoRA preukázali, že je možné trénovať úplne presné adaptéry na modeloch so zníženou presnosťou bez ovplyvnenia výkonu. Adaptéry sú zvyčajne efektívnejšie a efektívnejšie v porovnaní s inými metódami, ktoré zavádzajú nové komponenty modelu.

Hlavným vrcholom súčasného stavu techniky parametrovo efektívnych rámcov jemného ladenia je to, že namiesto úpravy reprezentácií upravujú váhy. Rámce zaoberajúce sa interpretovateľnosťou však ukázali, že reprezentácie kódujú bohaté sémantické informácie, čo naznačuje, že editácia reprezentácií môže byť lepším a výkonnejším prístupom v porovnaní s aktualizáciami váhy. Tento predpoklad, že editácia reprezentácií je lepším prístupom, je to, čo tvorí základ rámca ReFT alebo Representation Fine-tuning, ktorý trénuje zásahy namiesto prispôsobovania váh modelu, čo umožňuje modelu manipulovať s malou časťou všetkých reprezentácií v snahe riadiť správanie modelu. na riešenie následných úloh počas inferencie. Metódy jemného ladenia ReFT alebo Representation sú náhradou za dolaďovacie rámce PeFT založené na hmotnosti alebo parametricky efektívne. Prístup ReFT čerpá inšpiráciu z nedávnych modelov pracujúcich s interpretovateľnosťou veľkých modelov, ktoré zasahujú do reprezentácií s cieľom nájsť verné kauzálne mechanizmy a riadi správanie modelu počas inferencie, a preto ho možno považovať za zovšeobecnenie modelov na úpravu reprezentácií. LoReFT alebo Low-Rank Subspace ReFT, ktorý vychádza z toho istého, je silnou a efektívnou inštanciou ReFT a je parametrizáciou ReFT, ktorá zasahuje do skrytých reprezentácií v lineárnom priestore preklenutom nízkohodnotovou projekčnou maticou a stavia priamo na DAS. alebo Distributed Alignment Search framework.

Na rozdiel od úplného jemného doladenia PeFT alebo parametricky efektívny rámec jemného doladenia trénuje iba malú časť parametrov modelu a dokáže prispôsobiť model následným úlohám. Rámec dolaďovania efektívnych parametrov možno rozdeliť do troch hlavných kategórií:

- Metódy založené na adaptéri: Metódy založené na adaptéroch trénujú ďalšie moduly, ako sú plne prepojené vrstvy na predtrénovanom modeli so zmrazenými závažiami. Sériové adaptéry vkladajú komponenty medzi viacvrstvový perceptrón alebo MLP a LM alebo veľké modelové vrstvy pozornosti, zatiaľ čo paralelné adaptéry pridávajú moduly popri existujúcich komponentoch. Keďže adaptéry pridávajú nové komponenty, ktoré sa nedajú ľahko zložiť do existujúcich modelových závaží, predstavujú dodatočnú záťaž počas vyvodzovania.

- LoRA: LoRA spolu so svojimi najnovšími variantmi približujú aditívne hmotnosti počas tréningu pomocou matíc nízkej úrovne a nevyžadujú si ďalšie režijné náklady počas odvodzovania, pretože aktualizácie hmotnosti môžu byť zlúčené do modelu, a to je dôvod, prečo sa považujú za aktuálne najsilnejšie rámce PeFT.

- Metódy založené na výzve: Metódy založené na výzvach pridávajú softvérové tokeny, ktoré sa inicializujú náhodne do vstupu, a trénujú ich vkladanie, pričom váhy jazykového modelu zachovávajú zmrazené. Výkon, ktorý ponúkajú tieto metódy, často nie je uspokojivý v porovnaní s inými prístupmi PeFT a tiež so sebou nesú významné režijné náklady.

Namiesto aktualizácie váh sa rámec ReFT učí zásahy na úpravu malej časti celkových reprezentácií. Nedávne práce v oblasti reprezentačného inžinierstva a aktivačného riadenia navyše ukázali, že pridanie fixných vektorov riadenia do zvyškového prúdu môže uľahčiť určitý stupeň kontroly nad vopred vyškolenými generáciami veľkých modelov bez toho, aby vyžadovali náročné zdroje. dolaďovanie. Iné rámce ukázali, že editácia reprezentácií s naučenou operáciou škálovania a prekladu sa môže pokúsiť vyrovnať, ale nie prekonať výkon, ktorý ponúkajú adaptéry LoRA v širokej škále úloh s menším počtom naučených parametrov. Okrem toho úspech týchto rámcov v celom rade úloh ukázal, že reprezentácie zavedené vopred vyškolenými jazykovými modelmi nesú bohatú sémantiku, hoci výkon týchto modelov nie je optimálny, čo vedie k tomu, že PeFT budú pokračovať ako najmodernejší prístup. bez dodatočnej inferenčnej záťaže.

ReFT: Metodológia a architektúra

Aby bol proces zachovania štýlu jednoduchý, rámec ReFT predpokladá ako cieľový model veľký model založený na transformátore, ktorý je schopný produkovať kontextovú reprezentáciu sekvencie tokenov. Pre danú sekvenciu s n počtom vstupných symbolov rámec ReFT najskôr vloží tieto vstupné symboly do zoznamu reprezentácií, po ktorom m vrstiev vypočíta zoznam skrytých reprezentácií postupne ako funkciu predchádzajúceho zoznamu skrytých reprezentácií. Každá skrytá reprezentácia je vektor a jazykový model používa konečné skryté reprezentácie na vytvorenie predpovedí. Rámec ReFT zohľadňuje maskované jazykové modely aj autoregresívne jazykové modely. Teraz, podľa hypotézy lineárnej reprezentácie, v neurónových sieťach sú koncepty zakódované v lineárnych podpriestoroch reprezentácií. Nedávne modely zistili, že toto tvrdenie je pravdivé v modeloch neurónových sietí trénovaných na prirodzenom jazyku spolu s inými distribúciami vstupov.

Okrem toho v štúdiách interpretovateľnosti rámec príležitostnej abstrakcie využíva výmenné zásahy na určenie úlohy komponentov neurónovej siete náhodne pri implementácii konkrétneho správania. Logika zásahu výmeny je taká, že ak sa fixuje reprezentácia na to, čo by bolo pre kontrafaktuálny vstup, a tento zásah ovplyvňuje výstup modelu konzistentne tak, ako tvrdenia rámca ReFT o komponente zodpovednom za produkciu túto reprezentáciu, potom zložka zohráva kauzálnu úlohu v správaní. Hoci existuje niekoľko metód, intervencia distribuovanej výmeny je ideálnym prístupom na testovanie, či je koncept zakódovaný v lineárnom podpriestore reprezentácie, ako to tvrdí hypotéza lineárnej reprezentácie. Okrem toho sa metóda DAS predtým používala na nájdenie lineárnej reprezentácie v jazykových modeloch atribútov entity, sentimentu, lingvistických vlastností a matematického uvažovania. Niekoľko experimentov však ukázalo, že metóda DAS je vysoko expresívna a má schopnosť nájsť kauzálne účinné podpriestory, aj keď bol model jazyka transformátora inicializovaný náhodne, a preto sa ešte len nenaučia žiadne reprezentácie špecifické pre danú úlohu, čo vedie k diskutovať o tom, či je DAS efektívny a dostatočne zodpovedný za úlohy interpretácie.

Expresivita, ktorú ponúka DAS, naznačuje, že tento prístup by mohol byť ideálnym nástrojom na kontrolu správania sa jazykového modelu spolu s jeho prácou na kontrolovateľnom generovaní a zodpovednom editovaní. Preto na prispôsobenie jazykových modelov pre následné úlohy používa rámec ReFT operáciu zásahu distribuovanej výmeny, aby sa vytvorila nová metóda efektívna s parametrami. Metóda ReFT je navyše súborom zásahov a rámec presadzuje, že pre akékoľvek dva zásahy, ktoré pôsobia na tej istej vrstve, musia byť zásahové pozície disjunktné, pričom parametre všetkých intervenčných funkcií zostávajú nezávislé. Výsledkom je, že ReFT je všeobecný rámec, ktorý zahŕňa zásahy do skrytých reprezentácií počas prechodu modelu dopredu.

ReFT: Experimenty a výsledky

Na vyhodnotenie svojho výkonu v porovnaní s existujúcimi rámcami PEFT rámec ReFT vykonáva experimenty so štyrmi rôznymi benchmarkmi spracovania prirodzeného jazyka a pokrýva viac ako 20 súborov údajov, pričom primárnym cieľom je poskytnúť bohatý obraz o tom, ako rámec LoReFT funguje v rôznych scenároch. Okrem toho, keď je rámec LoReFT implementovaný v reálnom živote, vývojári sa musia rozhodnúť, koľko zásahov sa majú naučiť spolu so vstupnými pozíciami a vrstvami, na ktoré sa majú aplikovať. Na dokončenie úlohy rámec ReFT vyladí štyri hyperparametre.

- Počet pozícií prefixov, na ktorých sa má zasahovať.

- Počet pozícií prípon, na ktorých sa má zasahovať.

- Do akej sady vrstiev zasahovať.

- Či spájať intervenčné parametre na rôznych pozíciách v rovnakej vrstve alebo nie.

Rámec ReFT tým zjednodušuje priestor na vyhľadávanie hyperparametrov a zaisťuje iba fixné dodatočné náklady na odvodenie, ktoré sa neškálujú s dĺžkou výzvy.

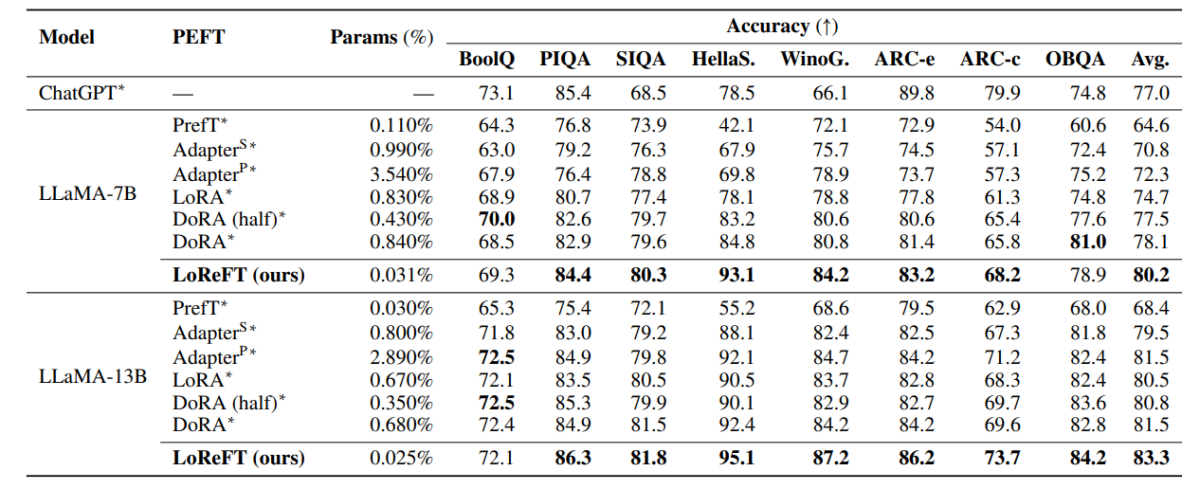

Vyššie uvedená tabuľka porovnáva presnosť rámcov LLaMA-7B a LLaMA-13B s existujúcimi modelmi PEFT naprieč 8 súbormi údajov zdôvodňujúcich zdravý rozum. Ako je možné pozorovať, model LoReFT prekonáva existujúce prístupy PEFT o slušnú rezervu, napriek tomu, že má oveľa menej parametrov, pričom priemerný výkon troch cyklov sa uvádza s odlišnými počiatočnými hodnotami pre model LoReFT. Param(%) sa vypočíta vydelením počtu trénovateľných parametrov počtom celkových parametrov základného veľkého modelu.

Vyššie uvedená tabuľka sumarizuje porovnanie presnosti rámcov LLaMA-7B a LLaMA-13B s existujúcimi modelmi PEFT v 4 rôznych súboroch údajov aritmetického uvažovania, pričom rámec uvádza priemerný výkon troch cyklov s rôznymi náhodnými zárodkami. Ako možno pozorovať, napriek tomu, že má oveľa menej parametrov (%), rámec LoReFT výrazne prekonáva existujúce rámce PEFT.

Vyššie uvedená tabuľka sumarizuje porovnanie presnosti rámcov RoBERTa-base a RoBERTa-large s existujúcimi modelmi PEFT v rámci benchmarku GLUE, pričom rámec uvádza priemerný výkon piatich cyklov s rôznymi náhodnými zárodkami. Ako možno pozorovať, napriek tomu, že má oveľa menej parametrov (%), rámec LoReFT výrazne prekonáva existujúce rámce PEFT.

Záverečné myšlienky

V tomto článku sme hovorili o LoReFT, výkonnej alternatíve k existujúcim rámcom PEFT, ktorá dosahuje vysoký výkon v rámci benchmarkov zo štyroch rôznych domén a zároveň ponúka až 50-krát vyššiu efektivitu, ktorú ponúkajú predchádzajúce najmodernejšie modely PEFT. Predtrénované veľké modely sú často jemne vyladené na použitie pre nové domény alebo úlohy a počas procesu jemného dolaďovania možno jeden základný model prispôsobiť širokému spektru úloh, dokonca aj s malým množstvom dostupných údajov v rámci domény. k modelu. Proces dolaďovania celého modelu je však náročný na zdroje a nákladný, najmä v prípade jazykových modelov s výrazne vyšším počtom veľkostí a parametrov. Parametrovo efektívne jemné dolaďovanie alebo metódy PeFT navrhujú riešiť vysoké náklady spojené s dolaďovaním celého modelu aktualizáciou len malého množstva celkových dostupných váh, čo je proces, ktorý pomáha skrátiť čas tréningu spolu s využitím pamäte. Je pozoruhodné, že LoReFT zavádza nový najmodernejší výkon na uvažovaní zdravým rozumom, dodržiavaní pokynov a porozumení prirodzeného jazyka proti najsilnejším PEFT.