Rýchle inžinierstvo

ChatGPT & Advanced Prompt Engineering: Riadenie vývoja AI

OpenAI bola nápomocná pri vývoji revolučných nástrojov, ako je OpenAI Gym, navrhnutý na tréning posilňovacích algoritmov a modelov GPT-n. V centre pozornosti je aj DALL-E, model AI, ktorý vytvára obrázky z textových vstupov. Jedným z takýchto modelov, ktorý si získal značnú pozornosť, je OpenAI ChatGPT, žiarivý príklad v oblasti veľkých jazykových modelov.

GPT-4: Rýchle inžinierstvo

ChatGPT transformoval prostredie chatbotov, ponúka ľudské reakcie na vstupy používateľov a rozširuje svoje aplikácie naprieč doménami – od vývoja softvéru a testovania po obchodnú komunikáciu a dokonca aj tvorbu poézie.

V rukách firiem a jednotlivcov by napríklad GPT-4 mohol slúžiť ako nevyčerpateľný rezervoár vedomostí, zdatný v predmetoch od matematiky a biológie až po právne štúdiá. Takéto sofistikované a dostupné modely AI sú pripravené predefinovať budúcnosť práce, učenia a kreativity.

Generatívne modely ako GPT-4 môžu vytvárať nové údaje na základe existujúcich vstupov. Tento charakteristický atribút im umožňuje vykonávať rôzne úlohy vrátane generovania textu, obrázkov, hudby a videa.

V kontexte modelov ChatGPT a OpenAI je výzva vstupom, ktorý používatelia poskytujú modelom, zvyčajne vo forme textu. Výzvy slúžia ako primárny prostriedok kontroly výstupu generovaného týmito modelmi, vďaka čomu sú kľúčové pre úspešné a relevantné konverzácie.

Vplyv rýchlej kvality

Používanie dobre definovaných výziev je kľúčom k zapájaniu sa do užitočných a zmysluplných rozhovorov so systémami AI. Zle definované výzvy môžu viesť k výstupu, ktorý nie je pre používateľa užitočný a môže dokonca viesť k zavádzajúcemu obsahu.

Aby sme demonštrovali vplyv kvality rýchlej reakcie, porovnajme dve rôzne výzvy poskytnuté ChatGPT. Prvá výzva, zle definovaná a predpokladá predchádzajúce znalosti, generuje pre používateľa potenciálne neužitočnú odpoveď. Na druhej strane druhá výzva poskytuje viac kontextu a príkladov, čím zabezpečuje relevantnejšiu a zrozumiteľnejšiu odpoveď.

Výzva 1: "Povedz mi niečo o konvolučných neurónových sieťach."

Odpoveď 1: „Konvolučné neurónové siete (CNN) sú viacvrstvové perceptrónové siete, ktoré pozostávajú z plne prepojených vrstiev a združovacích vrstiev. Bežne sa používajú pri úlohách rozpoznávania obrázkov. Proces zahŕňa použitie filtrov na vstupné obrázky a ich zmenšenie pomocou združovacích vrstiev.“

Výzva 2: „Chcem sa dozvedieť o konvolučných neurónových sieťach, ale nemám žiadne predchádzajúce znalosti o umelých neurónových sieťach. Môžete poskytnúť vysvetlenie vhodné pre začiatočníkov a príklad toho, ako sa CNN používajú pri rozpoznávaní obrázkov?

Odpoveď 2: „Konvolučné neurónové siete (CNN) sú typom neurónovej siete, ktorá sa primárne používa na úlohy rozpoznávania obrázkov. Na rozdiel od iných neurónových sietí využívajú na spracovanie obrázkov konvolučné vrstvy a združovacie vrstvy. Predstavte si, že máte obrázok mačky. CNN dokážu identifikovať rôzne prvky na obrázku, ako sú fúzy, uši a chvost, použitím filtrov a prevzorkovaním obrázka pomocou združovania vrstiev. Tento proces robí CNN vysoko efektívnymi pri rozpoznávaní objektov na obrázkoch.

Porovnaním týchto dvoch odpovedí je zrejmé, že dobre definovaná výzva vedie k relevantnejšej a užívateľsky príjemnejšej odpovedi. Pohotový dizajn a inžinierstvo sú rastúce disciplíny, ktorých cieľom je optimalizovať kvalitu výstupu modelov AI, ako je ChatGPT.

V nasledujúcich častiach tohto článku sa ponoríme do oblasti pokročilých metodológií zameraných na dolaďovanie veľkých jazykových modelov (LLM), ako sú techniky a taktiky rýchleho inžinierstva. Patrí medzi ne niekoľkonásobné učenie, ReAct, reťazec myšlienok, RAG a ďalšie.

Pokročilé inžinierske techniky

Predtým, ako budeme pokračovať, je dôležité pochopiť kľúčový problém s LLM, ktorý sa označuje ako „halucinácie“. V kontexte LLM znamená „halucinácia“ tendenciu týchto modelov vytvárať výstupy, ktoré sa môžu zdať rozumné, ale nie sú zakorenené v faktickej realite alebo danom vstupnom kontexte.

Tento problém bol výrazne zdôraznený v nedávnom súdnom prípade, keď ho použil obhajca ChatGPT pre právny výskum. Nástroj AI, ktorý sa potácal kvôli problému s halucináciami, citoval neexistujúce právne prípady. Tento chybný krok mal značné následky, spôsobil zmätok a podkopal dôveryhodnosť počas konania. Tento incident slúži ako ostrá pripomienka naliehavej potreby riešiť problém „halucinácií“ v systémoch AI.

Cieľom nášho skúmania techník rýchleho inžinierstva je zlepšiť tieto aspekty LLM. Zvyšovaním ich účinnosti a bezpečnosti pripravujeme cestu pre inovatívne aplikácie, ako je extrakcia informácií. Okrem toho otvára dvere bezproblémovej integrácii LLM s externými nástrojmi a zdrojmi údajov, čím sa rozširuje rozsah ich potenciálneho využitia.

Učenie s nulovým a niekoľkými zábermi: Optimalizácia pomocou príkladov

Generatívne predtrénované transformátory (GPT-3) znamenali dôležitý obrat vo vývoji modelov generatívnej AI, pretože zaviedli koncept „niekoľkonásobné učenie.' Táto metóda zmenila hru vďaka svojej schopnosti efektívne fungovať bez potreby komplexného dolaďovania. V dokumente sa diskutuje o rámci GPT-3, “Jazykové modely sa málokto učia“, kde autori demonštrujú, ako model vyniká v rôznych prípadoch použitia bez potreby vlastných súborov údajov alebo kódu.

Na rozdiel od jemného ladenia, ktoré si vyžaduje neustále úsilie pri riešení rôznych prípadov použitia, modely s niekoľkými zábermi demonštrujú ľahšiu adaptabilitu na širšiu škálu aplikácií. Aj keď jemné ladenie môže v niektorých prípadoch poskytnúť robustné riešenia, môže byť v meradle drahé, vďaka čomu je použitie modelov s niekoľkými zábermi praktickejším prístupom, najmä ak sú integrované s rýchlym inžinierstvom.

Predstavte si, že sa pokúšate preložiť z angličtiny do francúzštiny. Pri niekoľkonásobnom učení by ste GPT-3 poskytli niekoľko príkladov prekladu ako „sea vydra -> loutre de mer“. GPT-3, keďže ide o pokročilý model, je potom schopný naďalej poskytovať presné preklady. Pri učení typu zero-shot by ste neposkytli žiadne príklady a GPT-3 by stále vedel efektívne preložiť angličtinu do francúzštiny.

Pojem „niekoľkonásobné učenie“ pochádza z myšlienky, že model má obmedzený počet príkladov, z ktorých sa možno „učiť“. Je dôležité poznamenať, že „učenie“ v tomto kontexte nezahŕňa aktualizáciu parametrov alebo váh modelu, ale ovplyvňuje výkon modelu.

Zero-shot learning posúva tento koncept o krok ďalej. Pri nulovom učení nie sú v modeli uvedené žiadne príklady dokončenia úlohy. Očakáva sa, že model bude fungovať dobre na základe počiatočného školenia, vďaka čomu je táto metodika ideálna pre scenáre odpovedania na otázky v otvorenej doméne, ako je ChatGPT.

V mnohých prípadoch môže model s nulovým výstrelom fungovať dobre, ak má k dispozícii niekoľko alebo dokonca jednorazové príklady. Táto schopnosť prepínať medzi nulovým, jednorazovým a niekoľkonásobným výukovým scenárom podčiarkuje prispôsobivosť veľkých modelov a zlepšuje ich potenciálne aplikácie v rôznych doménach.

Metódy učenia s nulovým výstrelom sú čoraz rozšírenejšie. Tieto metódy sa vyznačujú schopnosťou rozpoznať predmety, ktoré počas tréningu nevidíte. Tu je praktický príklad výzvy na niekoľko výstrelov:

"Translate the following English phrases to French:

'sea otter' translates to 'loutre de mer'

'sky' translates to 'ciel'

'What does 'cloud' translate to in French?'"

Poskytnutím niekoľkých príkladov modelu a následným položením otázky môžeme efektívne viesť model k vygenerovaniu požadovaného výstupu. V tomto prípade by GPT-3 pravdepodobne správne preložilo „cloud“ na „nuage“ vo francúzštine.

Budeme sa ponoriť hlbšie do rôznych nuancií rýchleho inžinierstva a jeho základnej úlohy pri optimalizácii výkonu modelu počas dedukcie. Pozrieme sa tiež na to, ako ho možno efektívne využiť na vytváranie nákladovo efektívnych a škálovateľných riešení v rámci širokého spektra prípadov použitia.

Pri ďalšom skúmaní zložitosti techník rýchleho inžinierstva v modeloch GPT je dôležité zdôrazniť náš posledný príspevok „Základný sprievodca rýchlym inžinierstvom v ChatGPT'. Táto príručka poskytuje prehľad o stratégiách efektívneho vyučovania modelov AI v nespočetnom množstve prípadov použitia.

V našich predchádzajúcich diskusiách sme sa ponorili do základných rýchlych metód pre veľké jazykové modely (LLM), ako sú nulové a niekoľkonásobné učenie, ako aj nabádanie k inštrukciám. Zvládnutie týchto techník je rozhodujúce pre zvládnutie zložitejších výziev rýchleho inžinierstva, ktoré tu preskúmame.

Učenie s niekoľkými ranami môže byť obmedzené kvôli obmedzenému kontextovému oknu väčšiny LLM. Navyše, bez vhodných záruk môžu byť LLM zavádzané do poskytovania potenciálne škodlivého výstupu. Navyše veľa modelov zápasí s úlohami uvažovania alebo dodržiavaním viackrokových pokynov.

Vzhľadom na tieto obmedzenia spočíva výzva vo využívaní LLM na riešenie zložitých úloh. Samozrejmým riešením môže byť vývoj pokročilejších LLM alebo zdokonalenie existujúcich, ale to si môže vyžadovať značné úsilie. Vynára sa teda otázka: ako môžeme optimalizovať súčasné modely pre lepšie riešenie problémov?

Rovnako fascinujúce je skúmanie toho, ako sa táto technika spája s kreatívnymi aplikáciami v aplikácii Unite AI'Zvládnutie umenia AI: Stručný sprievodca strednou cestou a rýchlym inžinierstvom“, ktorá popisuje, ako môže spojenie umenia a AI vyústiť do úžasného umenia.

Podnecovanie myšlienkového reťazca

Reťazové nabádanie využíva prirodzené autoregresívne vlastnosti veľkých jazykových modelov (LLM), ktoré vynikajú pri predpovedaní ďalšieho slova v danej sekvencii. Podnecovaním modelu, aby objasnil svoj myšlienkový proces, navodzuje dôkladnejšie, metodickejšie generovanie nápadov, ktoré majú tendenciu úzko sa zhodovať s presnými informáciami. Toto zosúladenie vychádza zo sklonu modelu spracovávať a poskytovať informácie premysleným a usporiadaným spôsobom, podobne ako ľudský expert prechádzajúci poslucháča komplexným konceptom. Jednoduché vyhlásenie ako „preveďte ma krok za krokom, ako...“ často stačí na spustenie tohto podrobnejšieho a podrobnejšieho výstupu.

Zero-shot Chain-of-hought Prompting

Zatiaľ čo konvenčné nabádanie CoT si vyžaduje predbežné školenie s ukážkami, novovznikajúcou oblasťou je nabádanie CoT. Tento prístup, ktorý zaviedli Kojima et al. (2022) do pôvodnej výzvy inovatívne pridáva frázu „Rozmýšľajme krok za krokom“.

Vytvorme pokročilú výzvu, v ktorej má ChatGPT za úlohu zhrnúť kľúčové poznatky z výskumných prác AI a NLP.

V tejto ukážke využijeme schopnosť modelu porozumieť a zhrnúť komplexné informácie z akademických textov. Pomocou metódy učenia niekoľkých záberov naučme ChatGPT zhrnúť kľúčové zistenia z výskumných prác AI a NLP:

1. Paper Title: "Attention Is All You Need"

Key Takeaway: Introduced the transformer model, emphasizing the importance of attention mechanisms over recurrent layers for sequence transduction tasks.

2. Paper Title: "BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding"

Key Takeaway: Introduced BERT, showcasing the efficacy of pre-training deep bidirectional models, thereby achieving state-of-the-art results on various NLP tasks.

Now, with the context of these examples, summarize the key findings from the following paper:

Paper Title: "Prompt Engineering in Large Language Models: An Examination"

Táto výzva nielenže zachováva jasný myšlienkový reťazec, ale na vedenie modelu využíva aj niekoľkonásobný vzdelávací prístup. Spája sa s našimi kľúčovými slovami tým, že sa zameriava na domény AI a NLP, konkrétne poveruje ChatGPT, aby vykonal komplexnú operáciu, ktorá súvisí s rýchlym inžinierstvom: zhrnutie výskumných prác.

Výzva k reakcii

Reagovať alebo „Reason and Act“ predstavila spoločnosť Google v novinách „ReAct: Synergizácia uvažovania a konania v jazykových modeloch“ a spôsobil revolúciu v tom, ako jazykové modely interagujú s úlohou, prinútil model dynamicky generovať stopy verbálneho uvažovania aj akcie špecifické pre danú úlohu.

Predstavte si ľudského kuchára v kuchyni: nielenže vykonáva sériu činností (krájanie zeleniny, varenie vody, miešanie ingrediencií), ale aj verbálne uvažovanie alebo vnútornú reč („teraz je zelenina nakrájaná, mám postaviť hrniec pec"). Tento neustály mentálny dialóg pomáha pri stratégii procesu, prispôsobení sa náhlym zmenám („Došiel mi olivový olej, použijem namiesto neho maslo“) a zapamätanie si poradia úloh. React napodobňuje túto ľudskú schopnosť a umožňuje modelu rýchlo sa naučiť nové úlohy a robiť robustné rozhodnutia, rovnako ako by to urobil človek za nových alebo neistých okolností.

React dokáže riešiť halucinácie, bežný problém pri systémoch Chain-of-Thought (CoT). CoT, hoci je to efektívna technika, nemá kapacitu na interakciu s vonkajším svetom, čo by mohlo potenciálne viesť k halucináciám a šíreniu chýb. React to však kompenzuje prepojením s externými zdrojmi informácií. Táto interakcia umožňuje systému nielen overiť svoje úvahy, ale aj aktualizovať svoje znalosti na základe najnovších informácií z vonkajšieho sveta.

Základné fungovanie Reactu možno vysvetliť prostredníctvom inštancie z HotpotQA, úlohy vyžadujúcej uvažovanie vysokého poriadku. Po prijatí otázky model React rozdelí otázku na zvládnuteľné časti a vytvorí akčný plán. Model generuje stopu uvažovania (myšlienku) a identifikuje relevantnú akciu. Môže sa rozhodnúť vyhľadať informácie o Apple Remote na externom zdroji, ako je Wikipedia (akcia), a aktualizovať svoje chápanie na základe získaných informácií (pozorovanie). Prostredníctvom viacerých krokov myslenia-činnosti-pozorovania môže ReAct získať informácie na podporu svojich úvah a zároveň spresniť, čo potrebuje získať ďalej.

Poznámka:

HotpotQA je súbor údajov odvodený z Wikipédie, ktorý pozostáva zo 113 XNUMX párov otázok a odpovedí navrhnutých na trénovanie systémov AI v komplexnom uvažovaní, pretože na zodpovedanie otázok je potrebné uvažovanie nad viacerými dokumentmi. Na druhej strane, CommonsenseQA 2.0, vytvorený pomocou gamifikácie, obsahuje 14,343 XNUMX otázok áno/nie a je navrhnutý tak, aby spochybňoval chápanie zdravého rozumu AI, keďže otázky sú zámerne vytvorené tak, aby zavádzali modely AI.

Proces môže vyzerať asi takto:

- myšlienka: "Potrebujem vyhľadať ovládač Apple Remote a jeho kompatibilné zariadenia."

- akčná: Vyhľadáva „zariadenia kompatibilné s Apple Remote“ na externom zdroji.

- Postreh: Z výsledkov vyhľadávania získa zoznam zariadení kompatibilných s Apple Remote.

- myšlienka: „Na základe výsledkov vyhľadávania môže niekoľko zariadení, okrem Apple Remote, ovládať program, s ktorým bol pôvodne navrhnutý.“

Výsledkom je dynamický proces založený na uvažovaní, ktorý sa môže vyvíjať na základe informácií, s ktorými interaguje, čo vedie k presnejším a spoľahlivejším odpovediam.

Porovnávacia vizualizácia štyroch metód vyvolávania – Standard, Chain-of-Thought, Act-Only a ReAct, pri riešení HotpotQA a AlfWorld (https://arxiv.org/pdf/2210.03629.pdf)

Navrhovanie agentov React je špecializovaná úloha vzhľadom na ich schopnosť dosahovať zložité ciele. Napríklad konverzačný agent, postavený na základnom modeli React, obsahuje konverzačnú pamäť, aby poskytoval bohatšie interakcie. Zložitosť tejto úlohy však zefektívňujú nástroje ako Langchain, ktorý sa stal štandardom pre navrhovanie týchto agentov.

Kontextové nabádanie

Papier 'Kontextové výzvy pre veľké jazykové modely“ zdôrazňuje, že zatiaľ čo LLM preukázali značný úspech v úlohách NLP založených na vedomostiach, ich nadmerné spoliehanie sa na parametrické znalosti ich môže zviesť na scestie v úlohách citlivých na kontext. Napríklad, keď je jazykový model trénovaný na zastaraných faktoch, môže produkovať nesprávne odpovede, ak prehliada kontextové stopy.

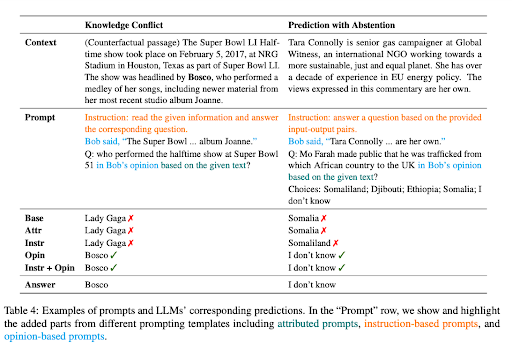

Tento problém je zjavný v prípadoch konfliktu vedomostí, kde kontext obsahuje skutočnosti odlišné od už existujúcich vedomostí LLM. Uvažujme o príklade, keď model veľkého jazyka (LLM), naplnený údajmi pred majstrovstvami sveta v roku 2022, dostane kontext naznačujúci, že Francúzsko vyhralo turnaj. LLM však, spoliehajúc sa na svoje predtrénované znalosti, naďalej tvrdí, že predchádzajúci víťaz, teda tím, ktorý vyhral MS 2018, je stále úradujúcim šampiónom. Toto demonštruje klasický prípad „konfliktu vedomostí“.

Konflikt znalostí v LLM v podstate vzniká, keď nové informácie poskytnuté v kontexte sú v rozpore s už existujúcimi znalosťami, na ktorých bol model trénovaný. Tendencia modelu spoliehať sa skôr na svoje predchádzajúce školenie než na novo poskytnutý kontext môže viesť k nesprávnym výstupom. Na druhej strane, halucinácie v LLM sú generovaním odpovedí, ktoré sa môžu zdať hodnoverné, ale nie sú zakorenené v tréningových údajoch modelu alebo poskytnutom kontexte.

Ďalší problém vzniká, keď poskytnutý kontext neobsahuje dostatok informácií na presnú odpoveď na otázku, čo je situácia známa ako predpovedať s hlasovaním. Ak sa napríklad LLM spýta na zakladateľa spoločnosti Microsoft na základe kontextu, ktorý neposkytuje tieto informácie, v ideálnom prípade by sa mal zdržať hádania.

Na zlepšenie kontextovej vernosti LLM v týchto scenároch výskumníci navrhli celý rad stratégií podnecovania. Cieľom týchto stratégií je, aby boli reakcie LLM viac prispôsobené kontextu, a nie spoliehanie sa na ich zakódované znalosti.

Jednou z takýchto stratégií je rámcovať výzvy ako otázky založené na názoroch, kde sa kontext interpretuje ako vyhlásenie rozprávača a otázka sa týka názoru tohto rozprávača. Tento prístup presmeruje pozornosť LLM na prezentovaný kontext, a nie na jeho už existujúce znalosti.

Pridanie kontrafaktuálnych demonštrácií k výzvam bolo tiež identifikované ako účinný spôsob zvýšenia vernosti v prípadoch konfliktu vedomostí. Tieto demonštrácie predstavujú scenáre s nepravdivými faktami, ktoré vedú model k tomu, aby venoval väčšiu pozornosť kontextu a poskytol presné odpovede.

Dolaďovanie pokynov

Jemné dolaďovanie pokynov je fáza učenia pod dohľadom, ktorá využíva poskytovanie konkrétnych pokynov modelu, napríklad „Vysvetlite rozdiel medzi východom a západom slnka“. Inštrukcia je spojená s vhodnou odpoveďou, niečo v zmysle: „Východ slnka sa vzťahuje na okamih, keď sa slnko ráno objaví nad obzorom, zatiaľ čo západ slnka označuje bod, keď slnko večer zmizne pod obzorom.“ Prostredníctvom tejto metódy sa model v podstate naučí, ako dodržiavať a vykonávať pokyny.

Tento prístup výrazne ovplyvňuje proces nabádania LLM, čo vedie k radikálnemu posunu v štýle podnetov. Jemne vyladená inštrukcia LLM umožňuje okamžité vykonávanie úloh s nulovým záberom a poskytuje bezproblémový výkon úloh. Ak LLM ešte nie je doladený, môže byť potrebný niekoľkonásobný vzdelávací prístup, ktorý do výzvy začlení niekoľko príkladov, ktoré nasmerujú model k požadovanej reakcii.

"Ladenie pokynov pomocou GPT-4′ pojednáva o pokuse použiť GPT-4 na generovanie údajov podľa pokynov na doladenie LLM. Použili bohatý súbor údajov obsahujúci 52,000 XNUMX jedinečných záznamov podľa pokynov v angličtine aj čínštine.

Súbor údajov hrá kľúčovú úlohu pri ladení pokynov Modely LLaMA, séria LLM s otvoreným zdrojovým kódom, čo vedie k zlepšenému výkonu pri nových úlohách. Pozoruhodné projekty ako napr Stanfordská alpaka efektívne využili ladenie s vlastným vyučovaním, efektívnu metódu zosúladenia LLM s ľudským zámerom, využívajúc dáta generované pokročilými učiteľskými modelmi ladenými podľa inštrukcií.

Primárnym cieľom výskumu ladenia inštrukcií je zvýšiť nulové a niekoľkonásobné zovšeobecnenie LLM. Ďalšie údaje a škálovanie modelov môžu poskytnúť cenné informácie. So súčasnou veľkosťou údajov GPT-4 52 kB a veľkosťou základného modelu LLaMA 7 miliárd parametrov existuje obrovský potenciál zhromaždiť viac údajov podľa pokynov GPT-4 a skombinovať ich s inými zdrojmi údajov, čo vedie k trénovaniu väčších modelov LLaMA. pre špičkový výkon.

STaR: Bootstrapping uvažovanie s uvažovaním

Potenciál LLM je viditeľný najmä v zložitých úlohách uvažovania, ako je matematika alebo odpovedanie na otázky zdravého rozumu. Proces indukovania jazykového modelu na generovanie zdôvodnení – séria postupných zdôvodnení alebo „reťazca myšlienok“ – má však svoje problémy. Často si to vyžaduje konštrukciu veľkých logických súborov údajov alebo obetu v presnosti v dôsledku spoliehania sa len na niekoľkonásobné odvodenie.

„Samouk“ (Hviezda) ponúka inovatívne riešenie týchto výziev. Využíva jednoduchú slučku na neustále zlepšovanie schopnosti modelu uvažovať. Tento iteračný proces začína generovaním odôvodnení na zodpovedanie viacerých otázok pomocou niekoľkých racionálnych príkladov. Ak sú vygenerované odpovede nesprávne, model sa znova pokúsi vygenerovať zdôvodnenie, pričom tentoraz uvedie správnu odpoveď. Model sa potom doladí na všetky zdôvodnenia, ktoré viedli k správnym odpovediam, a proces sa opakuje.

Metodológia STaR, ktorá demonštruje svoju slučku jemného ladenia a vzorové zdôvodnenie generovania na súbore údajov CommonsenseQA (https://arxiv.org/pdf/2203.14465.pdf)

Aby ste to ilustrovali na praktickom príklade, zamyslite sa nad otázkou „Čo možno použiť na prepravu malého psa? s výberom odpovedí od bazéna po kôš. Model STaR generuje zdôvodnenie, identifikuje, že odpoveďou musí byť niečo, čo dokáže uniesť malého psa, a dospieť k záveru, že správnou odpoveďou je kôš určený na uloženie vecí.

Prístup STaR je jedinečný v tom, že využíva už existujúcu schopnosť uvažovania jazykového modelu. Využíva proces samogenerovania a zdokonaľovania zdôvodnení, čím sa iteratívne zavádzajú rozumové schopnosti modelu. Slučka STaR má však svoje obmedzenia. Model môže zlyhať pri riešení nových problémov v trénovacej množine, pretože nedostane žiadny priamy trénovací signál pre problémy, ktoré nedokáže vyriešiť. Na vyriešenie tohto problému zavádza STAR racionalizáciu. Pre každý problém, ktorý model neodpovie správne, vygeneruje nové zdôvodnenie tým, že poskytne modelu správnu odpoveď, čo modelu umožní uvažovať spätne.

STaR preto predstavuje škálovateľnú zavádzaciu metódu, ktorá umožňuje modelom naučiť sa generovať svoje vlastné zdôvodnenia a zároveň sa naučiť riešiť čoraz zložitejšie problémy. Aplikácia STaR ukázala sľubné výsledky v úlohách zahŕňajúcich aritmetiku, matematické slovné úlohy a logické uvažovanie. Na CommonsenseQA sa STaR zlepšil v porovnaní s niekoľkonásobnou základnou líniou a základnou líniou jemne vyladenou na priame predpovedanie odpovedí a fungoval porovnateľne s modelom, ktorý je 30× väčší.

Označené kontextové výzvy

Koncept 'Označené kontextové výzvy“ sa točí okolo poskytovania modelu AI ďalšej vrstvy kontextu označovaním určitých informácií v rámci vstupu. Tieto značky v podstate fungujú ako ukazovatele pre AI, ktoré ju usmerňujú, ako presne interpretovať kontext a generovať odpoveď, ktorá je relevantná aj faktická.

Predstavte si, že sa rozprávate s priateľom na určitú tému, povedzme „šach“. Urobíte vyhlásenie a potom ho označíte odkazom, napríklad „(zdroj: Wikipedia)“. Teraz váš priateľ, ktorým je v tomto prípade model AI, presne vie, odkiaľ pochádzajú vaše informácie. Tento prístup má za cieľ zvýšiť spoľahlivosť reakcií AI znížením rizika halucinácií alebo vytvárania falošných faktov.

Jedinečným aspektom označených kontextových výziev je ich potenciál zlepšiť „kontextovú inteligenciu“ modelov AI. Dokument to napríklad demonštruje pomocou rôznorodého súboru otázok extrahovaných z viacerých zdrojov, ako sú súhrnné články Wikipédie o rôznych témach a sekciách z nedávno vydanej knihy. Otázky sú označené a poskytujú modelu AI ďalší kontext o zdroji informácií.

Táto ďalšia vrstva kontextu sa môže ukázať ako neuveriteľne prospešná, pokiaľ ide o generovanie odpovedí, ktoré sú nielen presné, ale aj dodržiavajú poskytnutý kontext, vďaka čomu je výstup AI spoľahlivejší a dôveryhodnejší.

Záver: Pohľad do sľubných techník a budúcich smerov

ChatGPT od OpenAI predstavuje neprebádaný potenciál veľkých jazykových modelov (LLM) pri riešení zložitých úloh s pozoruhodnou účinnosťou. Pokročilé techniky, ako je niekoľkonásobné učenie, výzva ReAct, reťazec myšlienok a STaR, nám umožňujú využiť tento potenciál v množstve aplikácií. Keď sa ponoríme hlbšie do nuancií týchto metodológií, zistíme, ako formujú prostredie AI a ponúkajú bohatšie a bezpečnejšie interakcie medzi ľuďmi a strojmi.

Napriek výzvam, ako je konflikt vedomostí, nadmerné spoliehanie sa na parametrické znalosti a potenciál pre halucinácie, sa tieto modely AI so správnym rýchlym inžinierstvom ukázali ako transformačné nástroje. Jemné ladenie pokynov, kontextovo verné nabádanie a integrácia s externými zdrojmi údajov ďalej umocňujú ich schopnosť uvažovať, učiť sa a prispôsobovať sa.