Kënschtlech Intelligenz

Photonic Chips schéngen d'Geschwindegkeet vun den AI Prozesser dramatesch ze erhéijen

Eng Equipe vu Fuerscher kuerzem applizéiert photonic Prozessor op kënschtlech Intelligenz Uwendungen, beweist datt photonesch Prozessoren immens kënnen iwwerschreiden d'Informatiounsveraarbechtungsfäegkeet vu reguläre elektronesche Chips.

D'Fuerschungsteam huet eng nei Chiparchitektur an Approche entwéckelt, déi Datenspeicherung an Datenveraarbechtungsfäegkeeten an engem eenzegen Apparat kombinéiert. D'Chips goufen mat Phase-Change Materialien gemaach (wéi déi an DVDen benotzt). Photonesch (Liicht-baséiert) Prozessoren gi benotzt fir e Computerchip ze produzéieren deen Berechnunge mat héijer Geschwindegkeet ausféiere kann, an an enger Studie déi viru kuerzem publizéiert gouf. Natur d'Fuerschungsteam konnt beweisen datt dës nei Chips fäeg sinn iwwer traditionell elektronesch Chips vill ze verbesseren, dank hirer Fäegkeet fir séier Informatioun parallel parallel ze veraarbecht.

Matrix-Vektor Multiplikatiounen

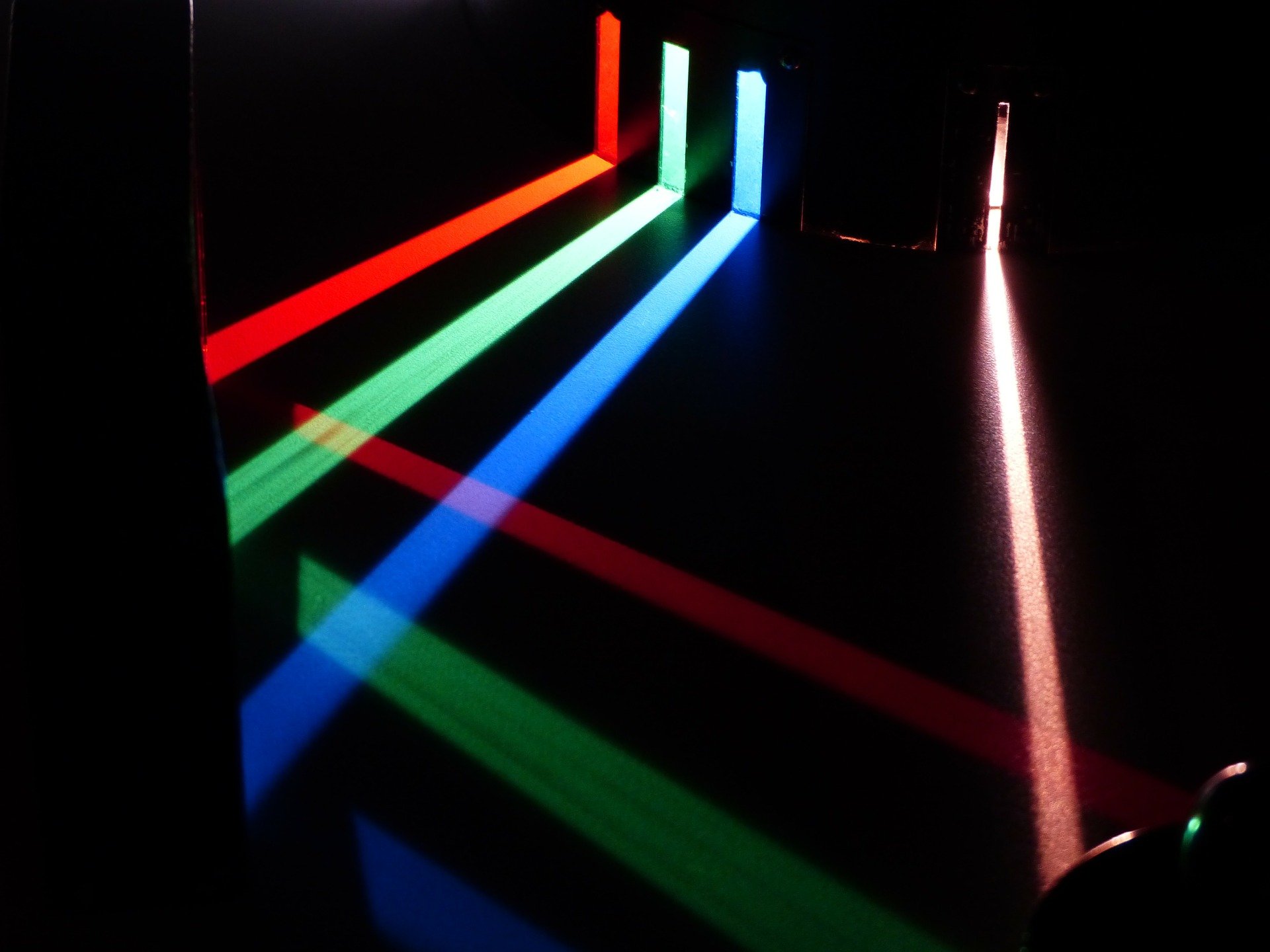

Déi neural Netzwierker déi vill vun de modernsten AI Uwendungen ënnersträichen, funktionnéieren duerch Matrix-Vektor Multiplikatiounen. D'Fuerschungsteam huet en Hardware-baséiert Beschleunigungssystem erstallt, deen et erméiglecht dës Multiplikatioune parallel auszeféieren. Déi optesch Chips profitéiere vun der Tatsaach, datt verschidde Wellelängten vum Liicht net matenee stéieren, dat heescht datt se benotzt kënne fir parallel Berechnungen auszeféieren. D'Fuerschungsteam huet sech op eng "Frequenzkamm" entwéckelt, déi vun EPFL entwéckelt gouf, a benotzt se als Liichtquell fir de photonesche Chip mat de verschiddene Wellelängten ze bidden.

D'Entwécklung vun der Frequenzkamm gouf vum Professer Tobias Kippenberg op der EPFL gefouert. Kippenburg ass ee vun den Haaptautoren vun der Studie zesumme mam Co-Autor Wolfram Pernice vun der Münster Universitéit. Laut Pernice kënne Liichtbaséiert Prozessoren déi computationell intensiv Aufgaben beschleunegen, déi am Maschinnléieren involvéiert sinn, Berechnunge mat nach méi héijer Geschwindegkeet ausféieren wéi spezialiséiert Hardware wéi Tensor Processing Units (TPUs) an déi fortgeschratt GPUs.

Neural Netzwierk Training

Nodeem d'photonesch Chips entworf a gebaut goufen, hunn d'Fuerscher se duerch hir Schrëtt gesat andeems se se op engem neurale Netzwierk testen entworf fir handgeschriwwe Zuelen ze erkennen. Den neuralen Netzwierk Trainingsprozess profitéiert vun der Wellelängt-Multiplexing aktivéiert vun de Chips, an et konnt méi héich Datenraten a Rechendichte erreechen wéi jee virdrun.

Wéi de Johannes Feldmann, Lead Autor vun der Studie a Graduéierter Student op der Münster Universitéit erkläert iwwer TechXplore:

"D'Konvolutiounsoperatioun tëscht Inputdaten an engem oder méi Filteren - wat zum Beispill e Highlight vu Kanten an enger Foto kann sinn - ka ganz gutt op eis Matrixarchitektur transferéiert ginn. D'Ausbeutung vum Liicht fir d'Signaltransfer erlaabt de Prozessor parallel Datenveraarbechtung duerch Wellelängtmultiplexing auszeféieren, wat zu enger méi héijer Rechendicht a vill Matrixmultiplikatioune féiert an nëmmen engem Zäitschrëtt.

D'Aarbecht ass bemierkenswäert dank der Tatsaach datt et et erlaabt neural Netzwierker op grousse Datesätz ze trainéieren an wat e Fraktioun vun der typescher Zäit kéint sinn fir en Netzwierk ze trainéieren. Wéi grouss Daten ëmmer méi grouss ginn, opgeblosen duerch d'Internet vun de Saachen an d'Erhéijung vun der Verbreedung vu Smart Apparater, wäerten Datewëssenschaftler nei Weeër brauchen fir Trainingszäiten op massiven Datesätze sou niddereg wéi méiglech ze halen. Traditionell Elektronik funktionéiert typesch am nidderegen GHz-Bereich, während optesch Modulatiounsgeschwindegkeete kënnen op d'50 GHz bis 100 GHz-Bereich eropgoen.

D'Fuerschung kéint wichteg Implikatioune fir Uwendungen hunn wéi Cloud Computing, medizinesch Imaging, an autonom Gefierer, déi all d'Fäegkeet erfuerderen fir grouss Volumen vun Daten, déi aus verschidde Quelle kommen, sou séier wéi méiglech ze veraarbecht.

De Fuerschungsprojet war d'Resultat vun enger Zesummenaarbecht tëscht enger internationaler Team vu Fuerscher vun der Pitt Univesity, der Universitéit vu Münster an Däitschland, den England Exeter an Oxford Universitéiten, IBM Zürich, an der École Polytechnique Fédérale (EPFL) an der Schwäiz.