Kënschtlech Intelligenz

LoReFT: Representatioun Finetuning fir Sproochmodeller

Parameter-effizient Feintuning oder PeFT Methoden sichen grouss Sproochmodeller iwwer Updates un eng kleng Unzuel u Gewiichter unzepassen. Wéi och ëmmer, eng Majoritéit vun existent Interpretabilitéitsaarbecht huet bewisen datt Representatioune semantesch räich Informatioun kodéieren, suggeréiert datt et eng besser a méi mächteg Alternativ wier fir dës Representatioune z'änneren. Pre-trainéiert grouss Modeller ginn dacks gutt ofgestëmmt fir fir nei Domainen oder Aufgaben benotzt ze ginn, a wärend dem Feintuningprozess kann en eenzege Basismodell op eng grouss Varietéit vun Aufgaben ugepasst ginn, och mat nëmme klenge Quantitéiten vun In-Domain Daten verfügbar zum Modell. Wéi och ëmmer, de Prozess fir e ganze Modell ze feinstëmmen ass Ressource-opwänneg, an deier, besonnesch fir Sproochmodeller mat enger wesentlech méi grousser Zuel vu Gréissten a Parameteren.

Parameter-effizient Feintuning oder PeFT Methoden proposéiere fir déi héich Käschten unzegoen verbonne mat der Feintuning vum ganze Modell andeems Dir nëmmen e klengen Betrag vun den verfügbare Gesamtgewichte aktualiséieren, e Prozess deen hëlleft Trainingszäit ze reduzéieren zesumme mat Erënnerungsverbrauch. Wat méi wichteg ass, ass datt Parameter-effizient Feintuning oder PeFT Methoden ähnlech Leeschtung bewisen hunn fir a verschidde praktesch Astellungen ze Finetunéieren. Adapter, eng gemeinsam Famill vu Parameter-effizienten Feintuning oder PeFT Methoden, léiere eng Ännerung déi zu engem zousätzleche Set vu Gewiichter bäigefüügt ka ginn, déi niewent dem gefruerenen Basismodell funktionnéieren, mat rezenten Adaptere wéi LoRA reduzéieren d'Zuel vun trainéierbare Parameteren a geléiert Gewiichtupdates andeems Dir Low-Rank Approximatioune benotzt amplaz vu Vollgewiicht Matrizen wann Dir d'Adapter trainéiert.

Mat fréiere Wierker, déi Redaktiounsrepresentatioune demonstréieren, kéint eng besser Alternativ zu Parameter-effizienten Feintuning oder PeFT Methoden sinn, an dësem Artikel schwätze mir iwwer Representation Fine-tuning oder ReFT Methoden déi op engem gefruerene Modell funktionnéieren, a léieren Aufgabspezifesch Interventiounen op verstoppte Representatioune. Dësen Artikel zielt fir de ReFt oder Representation Fine-tuning Kader an Déift ze decken, a mir entdecken de Mechanismus, d'Methodologie, d'Architektur vum Kader zesumme mat sengem Verglach mat modernste Kaderen. Also loosst eis ufänken.

ReFT: Representatioun Fine-tuning fir Sprooch Modeller

An engem Versuch, vir-trainéiert Sproochmodeller op nei Domänen an Aufgaben z'adoptéieren, verfeineren déi aktuell Kaderen dës vir-trainéiert Sproochmodeller dacks wéi mat dem implementéierte Feintuning-Prozess, en eenzegen Basismodell kann un eng Vielfalt vun Aufgaben ugepasst ginn, och wann Dir mat enger klenger Quantitéit vun In-Domain Daten schafft. Och wann de Feintuningprozess d'Gesamtleeschtung verbessert, ass et en deiere Prozess besonnesch wann de Sproochemodell eng wesentlech héich Zuel vu Parameteren huet. Fir dëst Thema unzegoen, an déi verbonne Käschten ze reduzéieren, PeFT oder Parameter-effizient Fine-tuning Kaderen aktualiséieren nëmmen e klengen Deel vun de Gesamtgewiichter, e Prozess deen net nëmmen d'Trainingszäit reduzéiert, awer och d'Erënnerungsverbrauch reduzéiert, wat d'PeFT Frameworks erlaabt ähnlech Leeschtung z'erreechen am Verglach mat voller Feintuning Approche a praktesch Szenarie. Adapter, eng gemeinsam Famill vu PeFTs, funktionnéieren andeems Dir eng Ännerung léiert, déi zu engem zousätzleche Set vu Gewiichter zesumme mat enger Ënnergrupp vu Gewiichter bäigefüügt ka ginn, déi unisono mam Basismodell mat gefruerene Gewiichter funktionnéieren. Rezent Adapter Kaderen wéi LoRA an QLoRA hunn bewisen, datt et méiglech ass voll-Präzisioun adapters op erop vun reduzéiert Präzisioun Modeller ze trainéieren ouni Leeschtung Afloss. Adapter sinn normalerweis méi effizient an effektiv am Verglach mat anere Methoden déi nei Modellkomponenten aféieren.

E groussen Highlight vum aktuellen Stand vun der Konscht Parameter-effizient Feintuning Kaderen ass datt amplaz Representatioune z'änneren, se Gewiichter änneren. Wéi och ëmmer, Kaderen déi mat Interpretabilitéit beschäftegen hunn bewisen datt Representatioune räich semantesch Informatioun codéieren, suggeréiert datt d'Representatiounseditioun eng besser a méi mächteg Approche kéint sinn am Verglach mat Gewiichtupdates. Dës Viraussetzung datt d'Representatiounseditioun déi besser Approche ass, ass dat wat d'Fundament vum ReFT oder Representation Fine-tuning Framework bildt, deen Interventiounen trainéiert anstatt Modellgewichten unzepassen, wat de Modell erlaabt eng kleng Fraktioun vun all Representatioune ze manipuléieren an engem Versuch, Modellverhalen ze steieren fir Downstream Aufgaben während Inferenz ze léisen. ReFT oder Representatioun Fine-tuning Methoden sinn drop-in Ersatzstécker fir Gewiicht-baséiert PeFT oder Parameter-effizient Fintuning Kaderen. D'ReFT Approche zitt Inspiratioun aus rezente Modeller, déi mat grousser Modellinterpretabilitéit schaffen, déi op Representatioune intervenéieren fir trei kausal Mechanismen ze fannen, a steiert d'Behuele vum Modell wärend der Inferenz, an dofir kann als Generaliséierung vun de Representatiounseditiounsmodeller gesi ginn. Baut op deemselwechte, LoReFT oder Low-Rank Subspace ReFT ass eng staark an effektiv Instanz vu ReFT, an ass eng Parameteriséierung vu ReFT déi op verstoppte Representatioune am lineare Raum intervenéiert, gespaant duerch Low-Rank Projektiounsmatrix, an direkt op der DAS baut. oder Distributed Alignment Search Kader.

Beweegt laanscht, am Géigesaz zu der voller Feintuning, trainéiert de PeFT oder Parameter-effizienten Feintuning Framework nëmmen e klengen Deel vun de Parameteren vum Modell, a bréngt et fäerdeg, de Modell un Downstream Aufgaben unzepassen. De Parameter-effizienten Feintuning Kader kann an dräi Haaptkategorien klasséiert ginn:

- Adapter-baséiert Methoden: Adapter-baséiert Methoden trainéieren zousätzlech Moduler wéi voll verbonne Schichten uewen op de pre-trainéierte Modell mat gefruerene Gewiichter. Serie Adapter setzen Komponenten tëscht dem Multilayer Perceptron oder MLP an LM oder grouss Modeller Opmierksamkeet Schichten, wärend parallel Adapter Moduler niewent existente Komponenten addéieren. Zënter Adaptern nei Komponenten addéieren, déi net einfach an existéierend Modellgewichte kënnen zesummegeklappt ginn, stellen se eng zousätzlech Belaaschtung wärend der Inferenz.

- LoRA: LoRA zesumme mat senge rezente Varianten ongeféier additiv Gewiichter wärend Training mat Hëllef vu Low-Rank Matrixen, a si erfuerderen keng zousätzlech Overheads wärend der Inferenz well d'Gewiichtupdates kënnen an de Modell fusionéiert ginn, an et ass de Grond firwat se als aktuell ugesi ginn. stäerkste PeFT Kader.

- Prompt-baséiert Methoden: Prompt-baséiert Methoden addéieren mëll Tokens déi zoufälleg an den Input initialiséiert ginn, an trainéieren hir Embeddings wärend d'Gewiichter vum Sproochmodell gefruer bleiwen. D'Performance, déi vun dëse Methoden ugebuede gëtt, sinn dacks net zefriddestellend am Verglach mat anere PeFT Approchen, a si droen och e wesentlechen Inferenz-Overheadskäschte.

Amplaz d'Gewiichter ze aktualiséieren, léiert de ReFT Kader Interventiounen fir e klengen Deel vun de Gesamtrepresentatiounen z'änneren. Ausserdeem hunn rezent Wierker iwwer Representatiounstechnik an Aktivéierungslenkung bewisen datt d'Addéiere vu fixe Lenkungsvektoren un de Reschtstroum e Grad vu Kontroll iwwer pre-trainéiert grouss Modeller Generatiounen erliichteren ouni Ressourceintensiv ze erfuerderen fein ofstëmmen. Aner Kaderen hunn bewisen datt d'Editiounsrepresentatioune mat enger geléierter Skaléierungs- an Iwwersetzungsoperatioun probéieren d'Performance vun LoRA Adapter op eng breet Palette vun Aufgaben mat manner geléierte Parameteren ze passen, awer net iwwerschreiden. Ausserdeem huet den Erfolleg vun dëse Kaderen iwwer eng Rei vun Aufgaben bewisen datt Representatioune, déi vu pre-trainéierte Sproochmodeller agefouert goufen, räich Semantik droen, obwuel d'Leeschtung vun dëse Modeller suboptimal ass, wat zu PeFTs resultéiert fir weider als modernste Approche weiderzekommen. ouni zousätzlech Inferenzbelaaschtung.

ReFT: Methodologie an Architektur

Fir de Stilkonservatiounsprozess einfach ze halen, iwwerhëlt de ReFT Framework e transformatorbaséierte grousse Modell als säin Zilmodell dee fäeg ass kontextualiséiert Representatioun vun der Sequenz vun Tokens ze produzéieren. Fir eng bestëmmte Sequenz mat n Zuel vun Input Tokens, embedde de ReFT Kader fir d'éischt dës Input Tokens an eng Lëscht vu Representatioune, no deenen d'm Schichten d'Lëscht vu verstoppte Representatioune successiv berechnen als Funktioun vun der viregter Lëscht vu verstoppte Representatioune. All verstoppte Representatioun ass e Vektor, an de Sproochmodell benotzt déi lescht verstoppte Representatioune fir d'Prognosen ze produzéieren. De ReFT Kader betruecht souwuel maskéiert Sprooch Modeller an autoregressive Sprooch Modeller. Elo, laut der linearer Representatiounshypothese, an neuralen Netzwierker, sinn Konzepter an de linear Ënnerraim vun Representatioune kodéiert. Rezent Modeller hunn dës Fuerderung fonnt fir richteg ze sinn an neurale Netzwierkmodeller, déi op natierlecher Sprooch trainéiert sinn zesumme mat aneren Inputverdeelungen.

Ausserdeem, an Interpretabilitéitsstudien, benotzt de Casual Abstraktiounskader Austauschinterventiounen fir d'Roll vun neuralen Netzwierkkomponenten zoufälleg z'etabléieren wann Dir bestëmmte Verhalen implementéiert. D'Logik hannert Interchange Interventioun ass datt wann een eng Representatioun fixéiert op wat et fir e kontrafaktuellen Input gewiescht wier, an dës Interventioun beaflosst d'Output vum Modell konsequent wéi d'Fuerderunge vum ReFT Kader iwwer de Komponent verantwortlech fir d'Produktioun déi Representatioun, dann spillt de Bestanddeel eng kausal Roll am Verhalen. Och wann et e puer Methoden sinn, ass verdeelt Austauschinterventioun déi ideal Approche fir ze testen ob e Konzept an engem linear Ënnerraum vun enger Representatioun kodéiert ass, wéi behaapt vun der linearer Representatiounshypothese. Ausserdeem gouf d'DAS Method virdru benotzt fir linear Representatioun a Sproochmodeller vun Entitéitsattributer, Gefill, sproochleche Featuren a mathematesch Begrënnung ze fannen. Wéi och ëmmer, verschidde Experimenter hunn uginn datt d'DAS Method héich expressiv ass, an et huet d'Fäegkeet kausal effizient Ënnerraim ze fannen, och wann den Transformator Sproochmodell zoufälleg initialiséiert gouf, an dofir nach keng Aufgabspezifesch Representatioune léieren, wat zu diskutéieren ob DAS effektiv a verantwortlech genuch ass fir Interpretabilitéitsaufgaben.

D'Expressivitéit vun DAS proposéiert datt d'Approche en idealt Tool kéint sinn fir d'Behuele vum Sproochmodell zesumme mat senger Aarbecht iwwer kontrolléierbar Generatioun a verantwortlech Redaktioun ze kontrolléieren. Dofir, fir Sproochmodeller fir Downstream Aufgaben unzepassen, benotzt de ReFT Kader déi verdeelt Interchange Interventioun Operatioun fir eng nei Parameter effizient Method ze maachen. Ausserdeem ass d'ReFT Method eng Rei vun Interventiounen, an de Kader erzwéngt datt fir all zwou Interventiounen déi op der selwechter Schicht funktionnéieren, d'Interventiounspositioune musse disjoint sinn, mat de Parameteren vun all Interventiounsfunktiounen onofhängeg bleiwen. Als Resultat ass d'ReFT e generesche Kader deen Interventiounen iwwer verstoppte Representatioune wärend dem Model Forward Pass ëmfaasst.

ReFT: Experimenter a Resultater

Fir seng Leeschtung géint existent PEFT Kaderen ze evaluéieren, féiert de ReFT Kader Experimenter iwwer véier verschidden natierlech Sproochveraarbechtungsbenchmarks, an deckt iwwer 20 Datesätz, mam primäre Zil ass et e räicht Bild ze bidden wéi de LoReFT Kader a verschiddene Szenarie funktionnéiert. Ausserdeem, wann de LoReFT Kader am richtege Liewen ëmgesat gëtt, mussen d'Entwéckler entscheeden wéi vill Interventiounen zesumme mat den Input Positiounen a Schichten ze léieren fir jidderee opzemaachen. Fir d'Aufgab ofzeschléissen, tunt de ReFT Kader véier Hyperparameter un.

- D'Zuel vun Präfix Positiounen ze intervenéieren op.

- D'Zuel vun de Suffix Positiounen fir ze intervenéieren.

- Wat fir eng Rei vu Schichten fir ze intervenéieren.

- Ob Interventiounsparameter iwwer verschidde Positiounen an der selwechter Schicht verbannen oder net.

Duerch dëst ze maachen, vereinfacht de ReFT Kader den Hyperparameter Sichraum, a garantéiert nëmmen e fixen zousätzlech Inferenzkäschte, déi net mat der Längt vun der Prompt skaléiert.

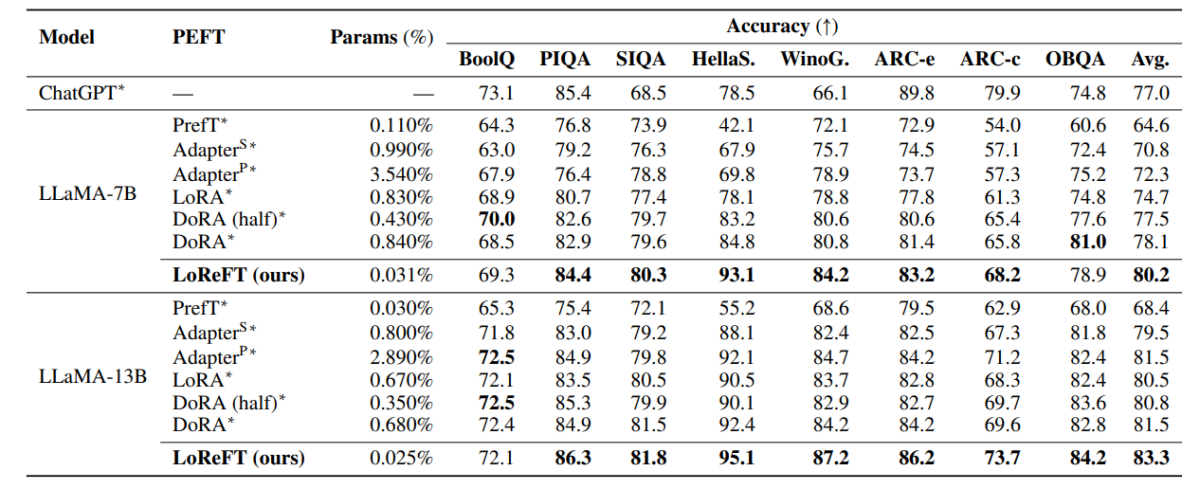

Déi uewe genannte Tabell vergläicht d'Genauegkeet vun den LLaMA-7B an LLaMA-13B Kaderen géint existent PEFT Modeller iwwer 8 Commonsense Begrënnungsdates. Wéi et ka beobachtet ginn, iwwerhëlt de LoReFT Modell existent PEFT Approche mat enger anstänneger Margin, trotz vill manner Parameteren, mat der duerchschnëttlecher Leeschtung vun dräi Runen, déi mat ënnerschiddleche Parameter Somen fir de LoReFT Modell gemellt ginn. De Param (%) gëtt berechent andeems d'Zuel vun den trainéierbare Parameteren mat der Unzuel vun de Gesamtparameter vum Basisgrousse Modell deelt.

Déi uewe genannte Tabell resüméiert d'Genauegkeetsverglach vun de LLaMA-7B an LLaMA-13B Kaderen géint existent PEFT Modeller iwwer 4 verschidde arithmetesch Begrënnungsdatesets, mam Kader deen d'Duerchschnëttsleeschtung vun dräi Runen mat ënnerscheedlechen zoufälleg Somen bericht. Wéi et ka beobachtet ginn, trotz vill manner Params (%), de LoReFT Framework iwwerpréift existent PEFT Frameworks mat engem bedeitende Spillraum.

Déi uewe genannte Tabell resüméiert d'Genauegkeetsverglach vun de RoBERTa-Basis a RoBERTa-grousse Kaderen géint existent PEFT Modeller iwwer de GLUE Benchmark, mam Kader deen d'Duerchschnëttsleeschtung vu fënnef Runen mat ënnerscheedlechen zoufälleg Somen bericht. Wéi et ka beobachtet ginn, trotz vill manner Params (%), de LoReFT Framework iwwerpréift existent PEFT Frameworks mat engem bedeitende Spillraum.

Finale Schied

An dësem Artikel hu mir iwwer LoReFT geschwat, eng mächteg Alternativ zu existente PEFT Kaderen, déi staark Leeschtung iwwer Benchmarks vu véier verschiddenen Domainen erreecht, wärend bis zu 50 Mol d'Effizienz ubitt, déi vu fréiere modernste PEFT Modeller ugebuede gëtt. Pre-trainéiert grouss Modeller ginn dacks gutt ofgestëmmt fir fir nei Domainen oder Aufgaben benotzt ze ginn, a wärend dem Feintuningprozess kann en eenzege Basismodell op eng grouss Varietéit vun Aufgaben ugepasst ginn, och mat nëmme klenge Quantitéiten vun In-Domain Daten verfügbar zum Modell. Wéi och ëmmer, de Prozess fir e ganze Modell ze feinstëmmen ass Ressource-opwänneg, an deier, besonnesch fir Sproochmodeller mat enger wesentlech méi grousser Zuel vu Gréissten a Parameteren. Parameter-effizient Feintuning oder PeFT Methoden proposéiere fir déi héich Käschten unzegoen verbonne mat der Feintuning vum ganze Modell andeems Dir nëmmen e klengen Betrag vun den verfügbare Gesamtgewichte aktualiséieren, e Prozess deen hëlleft Trainingszäit ze reduzéieren zesumme mat Erënnerungsverbrauch. Notamment, LoReFT etabléiert nei Staat-vun-der-Konscht Leeschtung op commonsense Begrënnung, Instruktioun-verfollegen, an natierlech Sprooch Versteesdemech géint de stäerkste PEFTs.