Kënschtlech Intelligenz

Änneren Emotiounen a Videomaterial mat AI

Fuerscher aus Griicheland a Groussbritannien hunn eng nei Deep Learning Approche entwéckelt fir d'Ausdrock an d'scheinbar Stëmmung vu Leit a Videomaterial z'änneren, wärend d'Vertraulechkeet vun hire Lippebewegungen zum Original Audio op eng Manéier behalen, déi virdru Versuche net konnte passen. .

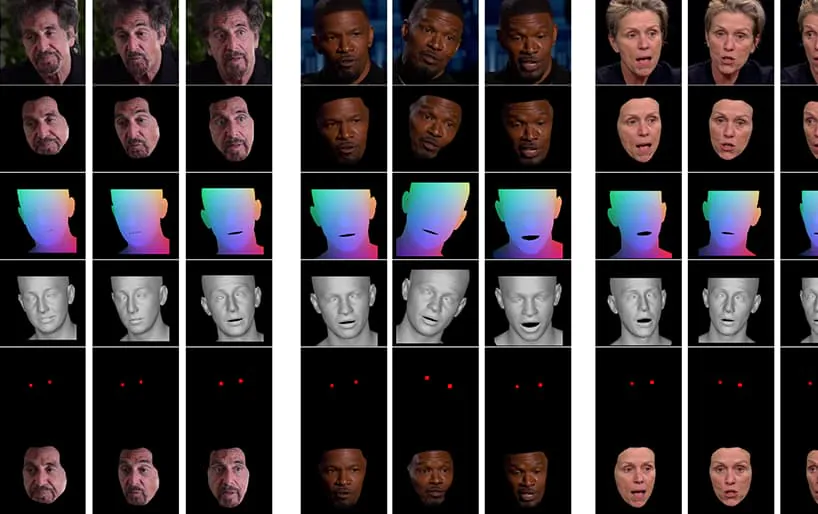

Aus dem Video deen de Pabeier begleet (um Enn vun dësem Artikel agebonnen), e kuerze Clip vum Schauspiller Al Pacino, deen säin Ausdrock subtil vum NED verännert huet, baséiert op héije semantesche Konzepter déi individuell Gesiichtsausdréck definéieren, an hir verbonne Emotiounen. D''Referenz-Driven' Method op der rietser hëlt déi interpretéiert Emotioun/en vun engem Quellvideo an applizéiert se op d'ganz Videosequenz. Quell: https://www.youtube.com/watch?v=Li6W8pRDMJQ

Dëst besonnescht Feld fällt an d'wuessend Kategorie vu deepfaked Emotiounen, wou d'Identitéit vum urspréngleche Spriecher erhale bleift, awer hir Ausdréck a Mikro-Ausdrock geännert ginn. Wéi dës speziell AI Technologie reift, bitt se d'Méiglechkeet fir Film- an Fernsehproduktioune fir subtile Ännerunge fir d'Ausdréck vun de Schauspiller ze maachen - awer mécht och eng zimlech nei Kategorie vun "Emotiouns-verännert" Video Deepfakes op.

Gesiichter veränneren

Gesiichtsausdréck fir ëffentlech Perséinlechkeeten, wéi Politiker, sinn rigoréis curéiert; 2016 koumen dem Hillary Clinton seng Gesiichtsausdréck ënner intensiver Medieluucht fir hire potenziellen negativen Impakt op hir Wahlperspektiven; Gesiichtsausdréck, stellt sech eraus, sinn och eng Thema vun Interessi an den FBI; a si sinn a kriteschen Indikator an Aarbechtsinterviews, mécht d'(wäit wäit) Perspektiv vun engem Live 'Expression-Control' Filter eng wënschenswäert Entwécklung fir Aarbechtssicher, déi probéieren e Pre-Écran op Zoom ze passéieren.

Eng 2005 Studie aus Groussbritannien huet dat Gesiichtsausgesinn behaapt beaflosst Wahlentscheedungen, während eng 2019 Washington Post Feature iwwerpréift huet Benotzung vun 'aus Kontext' Video Clip Deele, wat am Moment déi nooste Saach ass, déi Fake-News-Proponente mussen tatsächlech änneren, wéi eng ëffentlech Figur sech behuelen, reagéiert oder fillt.

Richtung Neural Expression Manipulatioun

Am Moment ass de Stand vun der Konscht bei der Manipulatioun vum Gesiichtseffekt zimlech rudimentär, well et drëm geet Ofbau vun héije Konzepter (wéi z traureg, rosen, glécklech, lächelnd) vum aktuellen Videoinhalt. Och wann traditionell Deepfake Architekturen schéngen dës Entwécklung zimmlech gutt z'erreechen, d'Spigelung vun Emotiounen iwwer verschidden Identitéiten erfuerdert nach ëmmer datt zwee Trainings Gesiichtssätz passend Ausdréck fir all Identitéit enthalen.

Typesch Beispiller vu Gesiichtsbilder an Datesets benotzt fir Deepfakes ze trainéieren. De Moment kënnt Dir nëmmen de Gesiichtsausdrock vun enger Persoun manipuléieren andeems Dir ID-spezifesch Ausdrock<>Ausdrockweeër an engem deepfake neuralen Netzwierk erstellt. 2017-Ära Deepfake Software huet keen intrinsescht, semantescht Verständnis vun engem "Laachen" - et passt just op déi ugesinn Ännerungen an der Gesiichtsgeometrie iwwer déi zwee Fächer.

Wat wënschenswäert ass, an nach net perfekt erreecht ass, ass ze erkennen wéi de Sujet B (zum Beispill) laacht, an einfach eng 'lächeln' wiesselt an der Architektur, ouni et op en gläichwäertegt Bild vum Thema A ze laachen ze mapen.

d' neie Pabeier heescht Neural Emotion Director: Speech-konservéierend semantesch Kontroll vu Gesiichtsausdréck an "am-Wild" Videoen, a kënnt vu Fuerscher an der School of Electrical & Computer Engineering op der National Technical University of Athens, dem Institut fir Computerwëssenschaften an der Foundation for Research and Technology Hellas (FORTH), an dem College of Engineering, Mathematics and Physical Sciences op der Universitéit Exeter a Groussbritannien.

D'Team huet e Kader entwéckelt genannt Neural Emotion Direkter (NED), en 3D-baséiert Emotion-Iwwersetzungsnetz integréiert, 3D-baséiert Emotiounen Manipulator.

NED hëlt eng kritt Sequenz vun Ausdrock Parameteren an iwwersetzt hinnen op eng Zil- Domain. Et gëtt op onparallellen Donnéeën trainéiert, dat heescht datt et net néideg ass op Datesets ze trainéieren wou all Identitéit entspriechend Gesiichtsausdréck huet.

De Video, deen um Enn vun dësem Artikel gewise gëtt, leeft duerch eng Serie vun Tester, wou NED e scheinbar emotionalen Zoustand op Footage vun der YouTube-Datasaz imposéiert.

D'Auteuren behaapten datt NED déi éischt Video-baséiert Method ass fir Akteuren an zoufälleg an onberechenbaren Situatiounen ze regéieren, an hunn de Code op NED's verfügbar gemaach. Projet Säit.

Method an Architektur

De System gëtt trainéiert op zwee grousse Videodatesätz, déi mat 'Emotiounen' Etiketten annotéiert goufen.

D'Output gëtt vun engem Video Gesiicht Renderer aktivéiert, deen déi gewënscht Emotioun op Video leet mat traditionelle Gesiichtsbildsynthesetechniken, inklusiv Gesiichtssegmentatioun, Gesiichtslandmark Ausrichtung a Vermëschung, wou nëmmen d'Gesiichtsberäich synthetiséiert gëtt, an dann op d'Original Footage imposéiert.

D'Architektur fir d'Pipeline vum Neural Emotion Detector (NED). Source: https://arxiv.org/pdf/2112.00585.pdf

Am Ufank kritt de System 3D Gesiichtserhuelung an setzt Gesiichtslandmark Ausrichtungen op d'Input Rummen fir den Ausdrock z'identifizéieren. Duerno ginn dës erholl Ausdrockparameter un den 3D-baséierten Emotion Manipulator weidergeleet, an e Stilvektor berechent entweder mat engem semantesche Label (wéi 'glécklech') oder vun enger Referenzdatei.

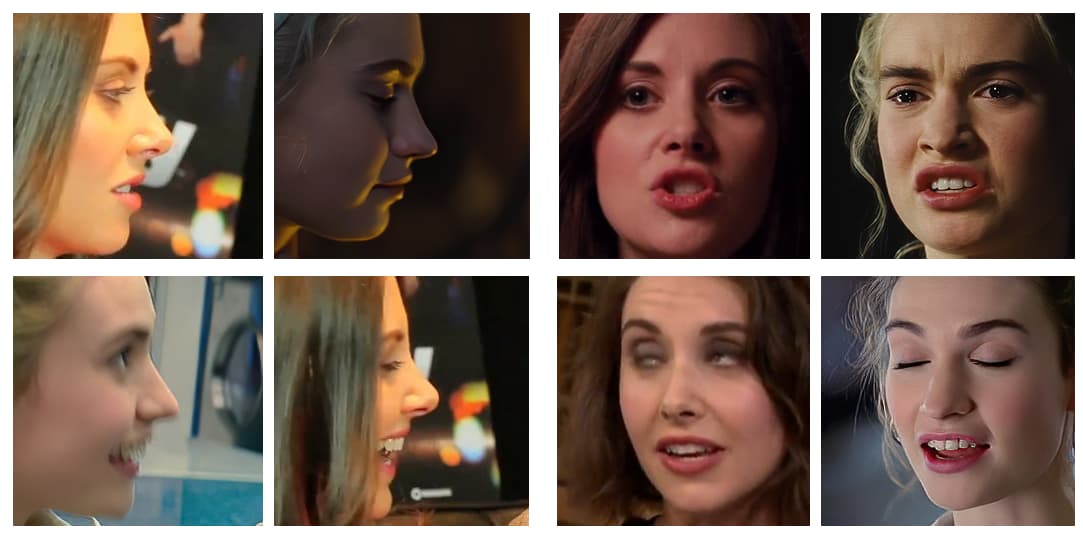

Eng Referenzdatei ass e Video deen e bestëmmten unerkannten Ausdrock / Emotioun portraitéiert, deen dann op d'Gesamtheet vum Zilvideo opgesat gëtt, an den ursprénglechen Ausdrock austauscht.

Stadien an der Emotiounstransfer Pipeline, mat verschiddenen Akteuren, déi aus YouTube Videoen gesampelt goufen.

Déi lescht generéiert 3D Gesiichtsform gëtt dann zesumme mat der Normaliséierter Mean Face Coordinate (NMFC) an den Auge Biller (déi roude Punkten am Bild hei uewen) verlinkt an un den neurale Renderer weiderginn, deen déi lescht Manipulatioun ausféiert.

Resultater

D'Fuerscher hunn extensiv Studien gemaach, dorënner Benotzer- an Ablatiounsstudien, fir d'Effizienz vun der Methode géint d'virdrun Aarbecht ze evaluéieren, a festgestallt datt an de meeschte Kategorien NED den aktuellen Zoustand vun der Konscht an dësem Ënnersektor vun der neuraler Gesiichtsmanipulatioun iwwerhëlt.

D'Autoren vum Pabeier virstellen datt spéider Implementatioune vun dësem Wierk, an Tools vun enger ähnlecher Natur, haaptsächlech an der Fernseh- a Filmindustrie nëtzlech sinn, seet:

"Eis Method mécht eng Onmass vun neie Méiglechkeete fir nëtzlech Uwendungen vun neurale Rendering Technologien op, rangéiert vu Filmpostproduktioun a Videospiller bis fotorealistesch affektiv Avataren."

Dëst ass eng fréi Aarbecht am Feld, awer ee vun den éischte fir Gesiichtsreenactment mat Video ze probéieren anstatt Stillbilder. Och wann Videoe wesentlech vill Stillbilder sinn, déi ganz séier zesumme lafen, ginn et temporär Iwwerleeungen, déi fréier Uwendunge vun Emotiounentransfer manner effektiv maachen. Am begleetende Video, a Beispiller am Pabeier, enthalen d'Auteuren visuell Vergläicher vum NED-Ausgang géint aner vergläichbar rezent Methoden.

Méi detailléiert Vergläicher, a vill méi Beispiller vun NED, kënnen am ganzen Video hei ënnen fonnt ginn:

3. Dezember 2021, 18:30 GMT+2 - Op Ufro vun engem vun den Auteuren vun der Zeitung goufen Korrekturen betreffend de 'Referenzdatei' gemaach, wat ech falsch gesot hunn, wier eng Stillfoto (wann et tatsächlech e Videoclip ass). Och eng Ännerung vum Numm vum Institut fir Informatik an der Fondatioun fir Fuerschung an Technologie.

Dezember 3, 2021:20 GMT + 50 - Eng zweet Ufro vun engem vun den Auteuren vum Pabeier fir eng weider Ännerung vum Numm vun der uewen ernimmt Institutioun.