Kënschtlech Intelligenz

E komplette Guide fir grouss Sproochmodeller ze Fine-Tuning

Inhaltsverzeechnes

Grouss Sproochmodeller (LLMs) wéi GPT-4, LaMDA, PaLM, an anerer hunn d'Welt duerch Stuerm geholl mat hirer bemierkenswäerter Fäegkeet fir mënschlech-ähnlechen Text iwwer eng grouss Palette vun Themen ze verstoen an ze generéieren. Dës Modeller gi viraustrainéiert op massiven Datesätz, déi Milliarde vu Wierder aus dem Internet, Bicher an aner Quelle besteet.

Dës Pre-Training Phase imbues d'Modeller mat extensiv allgemengt Wëssen iwwer Sprooch, Themen, Begrënnung Fäegkeeten, an och bestëmmte Biases presentéieren an der Training Donnéeën. Wéi och ëmmer, trotz hirer onheemlecher Breet, feelen dës pre-trainéiert LLMs spezialiséiert Expertise fir spezifesch Domainen oder Aufgaben.

Dëst ass wou d'Feintuning erakënnt - de Prozess fir e pre-trainéierten LLM unzepassen fir an enger bestëmmter Applikatioun oder Benotzungsfall ze exceléieren. Andeems Dir de Modell weider trainéiert op e méi klengen, Aufgabspezifeschen Dataset, kënne mir seng Fäegkeeten ofstëmmen fir mat den Nuancen an Ufuerderunge vun deem Domain auszegläichen.

Fine-tuning ass analog zum Iwwerdroen vum breet-gefächerte Wëssen vun engem héich gebilten Generalist fir en Thema Expert ze kreéieren spezialiséiert an engem bestëmmte Beräich. An dësem Guide wäerte mir d'Whats, Whys, a Hows entdecken fir LLMs ze feinsteieren.

Wat ass Fine-Tuning?

Am Kär, fein ofstëmmen involvéiert e grousse pre-trainéierte Modell ze huelen an seng Parameteren ze aktualiséieren mat enger zweeter Trainingsphase op engem Datesaz ugepasst op Är Ziltask oder Domän. Dëst erlaabt de Modell d'Nuancen, Musteren an Ziler spezifesch fir dat schmueler Gebitt ze léieren an ze internaliséieren.

Wärend de Pre-Training breet Sproochverständnis vun engem risegen an diversen Textkorpus erfaasst, spezialiséiert d'Feintuning dës allgemeng Kompetenz. Et ass ähnlech wéi e Renaissance Mann ze huelen an se an en Industrieexpert ze formen.

D'Gewiichter vum pre-trainéierte Modell, déi säin allgemenge Wëssen codéieren, ginn als Startpunkt oder Initialiséierung fir de Feintuningprozess benotzt. De Modell gëtt dann weider trainéiert, awer dës Kéier op Beispiller direkt relevant fir d'Ennapplikatioun.

Andeems Dir de Modell un dës spezialiséiert Dateverdeelung aussetzt an d'Modellparameter deementspriechend ofstëmmt, maache mir den LLM méi genau an effektiv fir den Zilverbrauchsfall, wärend nach ëmmer vun de breet pre-trainéierte Fäegkeeten als Fundament profitéiert.

Firwat Fine-Tune LLMs?

Et gi verschidde Schlësselgrënn firwat Dir e grousse Sproochemodell wëllt ofstëmmen:

- Domain Personnalisatioun: All Beräich, vu juristescher iwwer Medizin bis Software Engineering, huet seng eege nuancéiert Sprooch Konventioune, Jargon, a Kontexter. Fine-tuning erlaabt Iech en allgemenge Modell ze personaliséieren fir Text ze verstoen an ze produzéieren, deen dem spezifesche Domain ugepasst ass.

- Aufgab Spezialisatioun: LLMs kënne fir verschidde natierlech Sproochveraarbechtungsaufgaben wéi Textsummfaassung, Maschinn Iwwersetzung, Fro äntweren a sou weider ofgeschloss ginn. Dës Spezialisatioun verbessert d'Performance op der Ziltask.

- Datekonformitéit: Héich reglementéiert Industrien wéi Gesondheetsariichtung a Finanzen hu strikt Dateschutzfuerderunge. Fine-tuning erlaabt Training LLMs op propriétaire organisatoresch Daten wärend sensibel Informatioun schützt.

- Limitéiert Label Daten: Grouss markéiert Datesätz fir Trainingsmodeller vun Null ze kréien kann Erausfuerderung sinn. Feintuning erlaabt eng staark Taskleistung aus limitéierten iwwerwaachte Beispiller z'erreechen andeems d'Fähigkeiten vum pre-trainéierte Modell benotzt ginn.

- Modell Aktualiséierung: Wéi nei Date mat der Zäit an engem Domain verfügbar ginn, kënnt Dir Modeller weider feinstëmmen fir déi lescht Wëssen a Fäegkeeten ze integréieren.

- Mitigéierend Biases: LLMs kënnen gesellschaftlech Biases aus breede Pre-Formatiounsdaten ophuelen. Fine-tuning op curated Datesätz kann hëllefen dës ongewollt Biases ze reduzéieren an ze korrigéieren.

Am Wesentlechen iwwerbréckt d'Feintuning de Gruef tëscht engem allgemenge breede Modell an de fokusséierten Ufuerderunge vun enger spezialiséierter Applikatioun. Et verbessert d'Genauegkeet, d'Sécherheet an d'Relevanz vu Modellausgaben fir geziilte Gebrauchsfäll.

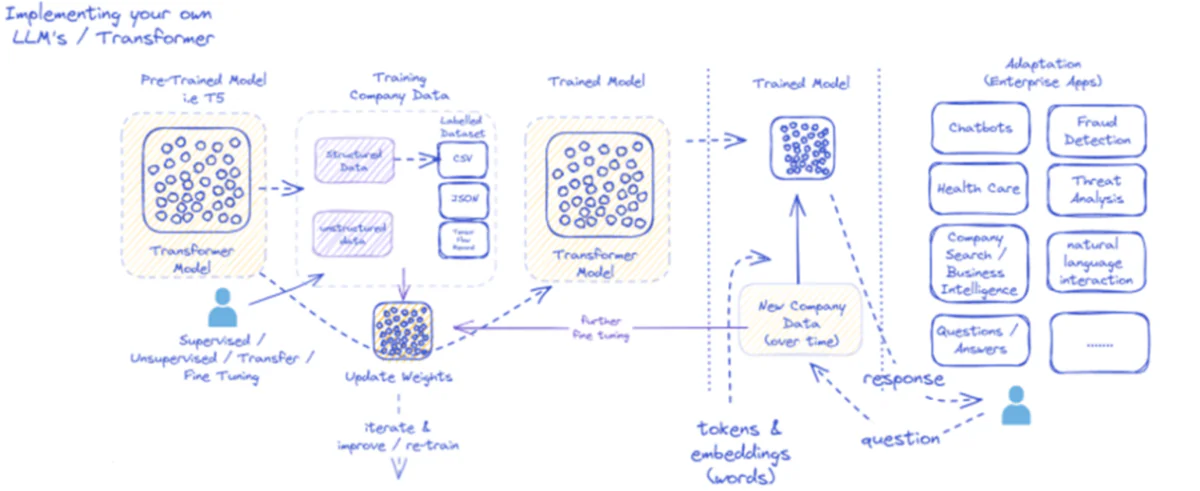

Dat geliwwert Diagramm skizzéiert de Prozess fir d'Ëmsetzung an d'Benotzung vu grousse Sproochmodeller (LLMs), speziell fir Entreprisen Uwendungen. Am Ufank gëtt e pre-trainéierte Modell wéi T5 strukturéiert an onstrukturéiert Firmendaten gefiddert, déi a verschiddene Formater wéi CSV oder JSON kommen kënnen. Dës Donnéeë ginn iwwerwaacht, net iwwerwaacht oder transferéiert Feintuningprozesser, wat d'Relevanz vum Modell fir d'spezifesch Bedierfnesser vun der Firma verbessert.

Wann de Modell mat de Firmendaten ofgestëmmt ass, ginn seng Gewiichter deementspriechend aktualiséiert. Den ausgebilte Modell iteréiert dann duerch weider Trainingszyklen, a verbessert seng Äntwerte mat der Zäit kontinuéierlech mat neie Firmendaten. De Prozess ass iterativ an dynamesch, mam Modell Léieren a Weiderbildung fir sech un evoluéierend Datemuster unzepassen.

D'Output vun dësem trainéierte Modell - Tokens an Embeddings representéieren Wierder - gëtt dann fir verschidde Entreprisen Uwendungen ofgesat. Dës Uwendunge kënne vu Chatbots bis Gesondheetsariichtung variéieren, jidderee erfuerdert de Modell fir ze verstoen an op Industriespezifesch Ufroen z'äntwerten. A Finanzen, Uwendungen enthalen Bedruch Detektioun a Bedrohungsanalyse; an der Gesondheetsariichtung, Modeller kënne mat Patientefroen an Diagnostik hëllefen.

D'Kapazitéit vum trainéierte Modell fir nei Firmendaten mat der Zäit ze veraarbecht an z'äntwerten garantéiert datt seng Utilitéit nohalteg ass a wiisst. Als Resultat kënnen d'Entreprise Benotzer mam Modell duerch Applikatiounen interagéieren, Froen stellen an informéiert Äntwerte kréien, déi d'Formatioun vum Modell reflektéieren an d'Feintuning op Domain-spezifesch Donnéeën reflektéieren.

Dës Infrastruktur ënnerstëtzt eng breet Palette vun Entreprisen Uwendungen, weist d'Vielfältegkeet an d'Adaptatioun vun LLMs op, wa se richteg implementéiert an an engem Geschäftskontext ënnerhale sinn.

Fine-Tuning Approche

Et ginn zwou primär Strategien wann et drëm geet grouss Sproochmodeller ze feinstemmen:

1) Voll Modell Fine-tuning

An der voller Feintuning Approche ginn all d'Parameteren (Gewiichter a Viraussetzungen) vum pre-trainéierte Modell während der zweeter Trainingsphase aktualiséiert. De Modell ass dem Aufgab-spezifesche markéierten Dataset ausgesat, an de Standard Trainingsprozess optiméiert de ganze Modell fir dës Dateverdeelung.

Dëst erlaabt de Modell méi ëmfaassend Upassungen ze maachen an sech holistesch un d'Ziltask oder d'Domain unzepassen. Wéi och ëmmer, voll Feintuning huet e puer Nodeeler:

- Et erfuerdert bedeitend computational Ressourcen an Zäit fir ze trainéieren, ähnlech wéi d'Pre-Training Phase.

- D'Späicherefuerderunge sinn héich, well Dir musst eng separat feinstëmmte Kopie vum Modell fir all Aufgab erhalen.

- Et besteet e Risiko vu "katastrophesche Vergiess", wou d'Feintuning verursaacht datt de Modell e puer allgemeng Fäegkeeten verléiert, déi während der Pre-Training geléiert goufen.

Trotz dësen Aschränkungen, bleift voll Feintuning eng mächteg a wäit benotzt Technik wann d'Ressourcen et erlaben an d'Ziltask wesentlech vun der allgemenger Sprooch divergéiert.

2) Effikass Fine-Tuning Methoden

Fir déi computational Erausfuerderunge vu voller Feintuning ze iwwerwannen, hunn d'Fuerscher effizient Strategien entwéckelt, déi nëmmen e klengen Ënnerdeel vun de Modellparameter während der Feintuning aktualiséieren. Dës parametresch effizient Techniken schloen e Gläichgewiicht tëscht Spezialisatioun an d'Reduktioun vun der Ressourcefuerderung.

E puer populär effizient Feintuningmethoden enthalen:

Präfix-Tuning: Hei ginn eng kleng Unzuel vun Aufgabspezifesche Vektoren oder "Präfixe" agefouert an trainéiert fir d'Opmierksamkeet vum Pre-trainéierte Modell fir d'Ziltask ze konditionéieren. Nëmmen dës Präfixe ginn während der Feintuning aktualiséiert.

LoRA (Low-Rank Adaptatioun): LoRA injizéiert trainéierbar niddereg-Rank-Matrixen an all Schicht vum pre-trainéierte Modell wärend der Feintuning. Dës kleng Ranganpassungen hëllefen de Modell mat vill manner trainéierbare Parameteren ze spezialiséieren wéi voll Feintuning.

Sécher, ech kann eng detailléiert Erklärung vu LoRA (Low-Rank Adaptation) zesumme mat der mathematescher Formuléierung a Code Beispiller ubidden. LoRA ass eng populär parametereffizient Feintuning (PEFT) Technik déi bedeitend Traktioun am Feld vun der grousser Sproochmodell (LLM) Adaptatioun gewonnen huet.

Wat ass LoRA?

LoRA ass eng Feintuningmethod déi eng kleng Unzuel vun trainéierbaren Parameteren un de pre-trainéierten LLM virstellt, wat eng effizient Adaptatioun un Downstream Aufgaben erlaabt, wärend d'Majoritéit vum Wëssen vum urspréngleche Modell erhale bleift. Amplaz all d'Parameter vun der LLM ze feinjustéieren, sprëtzt LoRA Aufgab-spezifesch Low-Rank Matrizen an d'Schichten vum Modell, wat bedeitend Rechen- a Gedächtnisspueren während dem Feintuningprozess erméiglecht.

Mathematesch Formuléierung

LoRA (Low-Rank Adaptation) ass eng Feintunéierungsmethod fir grouss Sproochmodeller (LLMs) déi e Low-Rank Update fir d'Gewiichtsmatrixen aféieren. Fir eng Gewiicht Matrixentgasung 0∈W0∈Rd×k, LoRA füügt eng Low-Rank Matrix derbäi BA, mat A∈Rr×k an B∈Rd×r, wou r ass de Rang. Dës Approche reduzéiert wesentlech d'Zuel vun trainéierbare Parameteren, wat effizient Adaptatioun un Downstream Aufgaben mat minimale computational Ressourcen erméiglecht. Déi aktualiséiert Gewiicht Matrixentgasung gëtt vun W=W0+B⋅A.

Dës Low-Ranking Update kann interpretéiert ginn als Ännerung vun der ursprénglecher Gewiichtsmatrix $W_{0}$ andeems Dir eng Low-Rank Matrix $BA$ derbäigesat. De Schlësselvirdeel vun dëser Formuléierung ass datt amplaz all $d \times k$ Parameteren an $W_{0}$ ze aktualiséieren, LoRA nëmmen $r \times (d + k)$ Parameteren an $A$ an $B muss optimiséieren $, d'Zuel vun trainéierbare Parameteren wesentlech reduzéieren.

Hei ass e Beispill am Python mat der peft Bibliothéik fir LoRA op e pre-trainéierten LLM fir Textklassifizéierung ze gëllen:

</div> <div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color="">from</span> transformers <span class="token" data-darkreader-inline-color="">import</span> AutoModelForSequenceClassification </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color="">from</span> peft <span class="token" data-darkreader-inline-color="">import</span> get_peft_model<span class="token" data-darkreader-inline-color="">,</span> LoraConfig<span class="token" data-darkreader-inline-color="">,</span> TaskType </code></div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Load pre-trained model</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color="">model <span class="token" data-darkreader-inline-color="">=</span> AutoModelForSequenceClassification<span class="token" data-darkreader-inline-color="">.</span>from_pretrained<span class="token" data-darkreader-inline-color="">(</span><span class="token" data-darkreader-inline-color="">"bert-base-uncased"</span><span class="token" data-darkreader-inline-color="">,</span> num_labels<span class="token" data-darkreader-inline-color="">=</span><span class="token" data-darkreader-inline-color="">2</span><span class="token" data-darkreader-inline-color="">)</span> </code></div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Define LoRA configuration</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color="">peft_config <span class="token" data-darkreader-inline-color="">=</span> LoraConfig<span class="token" data-darkreader-inline-color="">(</span>task_type<span class="token" data-darkreader-inline-color="">=</span>TaskType<span class="token" data-darkreader-inline-color="">.</span>SEQ_CLS<span class="token" data-darkreader-inline-color="">, </span>r<span class="token" data-darkreader-inline-color="">=</span><span class="token" data-darkreader-inline-color="">8</span><span class="token" data-darkreader-inline-color="">,</span> <span class="token" data-darkreader-inline-color=""># Rank of the low-rank update</span> lora_alpha<span class="token" data-darkreader-inline-color="">=</span><span class="token" data-darkreader-inline-color="">16</span><span class="token" data-darkreader-inline-color="">,</span></code><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Scaling factor for the low-rank update</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""> target_modules<span class="token" data-darkreader-inline-color="">=</span><span class="token" data-darkreader-inline-color="">[</span><span class="token" data-darkreader-inline-color="">"q_lin"</span><span class="token" data-darkreader-inline-color="">,</span> <span class="token" data-darkreader-inline-color="">"v_lin"</span><span class="token" data-darkreader-inline-color="">]</span><span class="token" data-darkreader-inline-color="">,</span> <span class="token" data-darkreader-inline-color=""># Apply LoRA to the query and value layers</span> <span class="token" data-darkreader-inline-color="">)</span> </code></div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Create the LoRA-enabled model</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color="">model <span class="token" data-darkreader-inline-color="">=</span> get_peft_model<span class="token" data-darkreader-inline-color="">(</span>model<span class="token" data-darkreader-inline-color="">,</span> peft_config<span class="token" data-darkreader-inline-color="">)</span> </code></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># Fine-tune the model with LoRA</span> </code></div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""></div> <div class="code-block__code !my-0 !rounded-t-lg !text-sm !leading-relaxed" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><code class="language-python" data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color=""><span class="token" data-darkreader-inline-color=""># ... (training code omitted for brevity)</span></code></div> </div> <div data-darkreader-inline-bgimage="" data-darkreader-inline-bgcolor="" data-darkreader-inline-color="">

An dësem Beispill lued mir e Pre-trainéiert BERT Modell fir Sequenz Klassifikatioun an definéieren eng LoRA Configuratioun. Déi r Parameter spezifizéiert de Rang vun der niddereg-Rank update, an lora_alpha ass e Skaléierungsfaktor fir den Update. Déi target_modules Parameter weist wéi eng Schichten vum Modell déi niddereg-Rankupdates solle kréien. Nodeems mir de LoRA-aktivéierte Modell erstallt hunn, kënne mir mam Feintuningprozess mat der Standard Trainingsprozedur weidergoen.

Adapter Schichten: Ähnlech wéi LoRA, awer amplaz vu Low-Rank Updates, ginn dënn "Adapter" Schichten an all Transformatorblock vum viraus trainéierte Modell agebaut. Nëmmen d'Parameteren vun dëse puer nei kompakt Schichten sinn trainéiert.

Prompt Tuning: Dës Approche hält de pre-trainéierte Modell komplett gefruer. Amplaz ginn trainéierbar "prompt" Embeddings als Input agefouert fir d'Pre-trainéiert Wëssen vum Modell fir d'Zieltask ze aktivéieren.

Dës effizient Methode kënne bis zu 100x Rechenreduktiounen am Verglach zu voller Feintuning ubidden, wärend se nach ëmmer kompetitiv Leeschtung op villen Aufgaben erreechen. Si reduzéieren och Späicherbedürfnisser andeems se voll Modellduplikatioun vermeiden.

Wéi och ëmmer, hir Leeschtung kann hannert der voller Feintuning hannerloossen fir Aufgaben déi vill anescht sinn wéi allgemeng Sprooch oder méi holistesch Spezialisatioun erfuerderen.

De Fine-Tuning Prozess

Onofhängeg vun der Feintuningstrategie, de Gesamtprozess fir eng LLM ze spezialiséieren follegt en allgemenge Kader:

- Dataset Virbereedung: Dir musst e markéierten Dataset kréien oder erstellen, deen Inputen (Ufroen) op gewënschte Ausgänge fir Är Ziltask mapéiert. Fir Textgeneratiounsaufgaben wéi Zesummefaassung, wier dëst Input Text op zesummegefaasst Ausgangspaaren.

- Dataset Splitting: No de beschten Praktiken, deelt Äre markéierten Datesaz an Zuch-, Validatiouns- an Testsets. Dëst trennt Daten fir Modell Training, Hyperparameter Tuning, an Finale Evaluatioun.

- Hyperparameter Tuning: Parameteren wéi Léierrate, Batchgréisst an Trainingsplang musse fir déi effektivst Feintuning op Är Donnéeën ofgestëmmt ginn. Dëst beinhalt normalerweis e klenge Validatiounsset.

- Model Training: Mat Hëllef vun den ofgestëmmte Hyperparameter, lafen de Feintuning Optimiséierungsprozess op de ganzen Trainingsset bis d'Leeschtung vum Modell op der Validatiounsset ophält ze verbesseren (fréi Stoppen).

- Evaluatioun: Assesséiert d'Performance vum fein gestëmmte Modell op der ofgehalen Testset, idealerweis aus real-Welt Beispiller fir den Zil-Notzungsfall, fir d'Effizienz vun der realer Welt ze schätzen.

- Deployment an Iwwerwaachung: Eemol zefriddestellend, kann de fein-ofgestëmmte Modell agesat ginn fir Inferenz op nei Inputen. Et ass entscheedend seng Leeschtung a Genauegkeet iwwer Zäit fir Konzeptdrift ze iwwerwaachen.

Wärend dëst de Gesamtprozess skizzéiert, kënne vill Nuancen de Feintuning Erfolleg fir eng bestëmmte LLM oder Aufgab beaflossen. Strategien wéi Curriculum Léieren, Multi-Task Feintuning, a puer Shot-Prompting kënnen d'Performance weider erhéijen.

Zousätzlech, effizient Feintuning Methoden involvéieren extra Considératiounen. Zum Beispill, LoRA erfuerdert Techniken wéi d'Conditionéierung vun de pre-trainéierte Modellausgaben duerch eng Kombinatiounsschicht. Prompt Tuning brauch suergfälteg entworf Ufroe fir déi richteg Verhalen ze aktivéieren.

Fortgeschratt Fine-Tuning: Mënsch Feedback integréieren

Wärend Standard iwwerwaacht Feintuning mat Label Datesätz effektiv ass, ass eng spannend Grenz Training LLMs direkt mat mënschleche Virléiften a Feedback. Dës Mënsch-an-der-Loop Approche profitéiert Techniken aus Verstäerkung Léieren:

PPO (Proximal Politik Optimisatioun): Hei gëtt den LLM als Verstäerkungs-Léieragent behandelt, mat hiren Ausgänge "Aktiounen". E Belounungsmodell gëtt trainéiert fir mënschlech Bewäertungen oder Qualitéitsscores fir dës Ausgäng virauszesoen. PPO optiméiert dann den LLM fir Ausgänge ze generéieren déi d'Scores vum Belounungsmodell maximéieren.

RLHF (Verstäerkung Léieren vum Mënsch Feedback): Dëst verlängert PPO duerch direkt mënschlech Feedback an de Léierprozess integréiert. Amplaz vun engem fixe Belounungsmodell, kommen d'Belounungen aus iterativen mënschlechen Evaluatiounen op den Ausgänge vum LLM wärend der Feintuning.

Wärend computationell intensiv, erlaben dës Methoden LLM Verhalen méi präzis op Basis vu gewënschten Charakteristiken, déi vu Mënschen evaluéiert ginn, méi präzis ze formen, iwwer dat wat an engem statesche Datesaz erfaasst ka ginn.

Firmen wéi Anthropic hunn RLHF benotzt fir hir Sproochmodeller wéi de Claude mat enger verbesserter Wourecht, Ethik a Sécherheetsbewosstsinn iwwer just Aufgabkompetenz ze impräifen.

Potenziell Risiken a Aschränkungen

Wärend immens mächteg, feintuning LLMs ass net ouni Risiken, déi suergfälteg geréiert musse ginn:

Bias Amplifikatioun: Wann d'Feinjustéierungsdaten gesellschaftlech Biases ronderëm Geschlecht, Rass, Alter oder aner Attributer enthalen, kann de Modell dës ongewollt Biases verstäerken. Curating representativ an de-biased Datesätz ass entscheedend.

Tatsächlech Drift: Och nom Feintuning op héichqualitativen Donnéeën, kënne Sproochmodeller falsch Fakten oder Ausgänge "hallucinéieren" déi net mat den Trainingsbeispiller iwwer méi laang Gespréicher oder Ufroen konsequent sinn. Fakten Erhuelung Methode kënnen néideg sinn.

Skalierbarkeet Erausfuerderungen: Voll Feintuning vu grousse Modeller wéi GPT-3 erfuerdert immens Rechenressourcen, déi fir vill Organisatiounen onméiglech sinn. Effizient Feintuning reduzéiert dëst deelweis awer huet Ausgläicher.

Katastroph Vergiessen: Während voller Feintuning kënnen Modeller katastrophal Vergiessen erliewen, wou se e puer allgemeng Fäegkeeten verléieren, déi während der Pre-Training geléiert goufen. Multi-Task Léieren kann néideg sinn.

IP a Privatsphär Risiken: Propriétaire Daten, déi fir d'Feintuning benotzt ginn, kënnen an ëffentlech verëffentlecht Sproochmodellausgaben lekken, wat Risiken stellen. Differential Privatsphär an Informatiounsrisikoreduktiounstechniken sinn aktiv Fuerschungsberäicher.

Insgesamt, wärend aussergewéinlech nëtzlech, Feintuning ass en nuancéierten Prozess dee Betreiung ronderëm d'Datequalitéit erfuerdert, Identitéitsbedenken, d'Risiken ze reduzéieren, an d'Performance-Effizienz Ofhandlungen ausbalancéieren op Basis vu Benotzungsfall Ufuerderunge.

D'Zukunft: Sproochemodell Personnalisatioun op Skala

Wa mir no vir kucken, Fortschrëtter a Feintuning a Modelladaptatiounstechnike wäerten entscheedend sinn fir dat vollt Potenzial vu grousse Sproochemodeller iwwer verschidden Uwendungen an Domainen opzemaachen.

Méi effizient Methoden, déi nach méi grouss Modeller wéi PaLM mat ageschränkte Ressourcen feinjustéieren, kënnen den Zougang demokratiséieren. Automatiséierung vun Datesetschafung Pipelines a prompt Engineering kéint d'Spezialisatioun streamline.

Selbstänneg iwwerwaacht Techniken fir aus raw Daten ouni Etiketten ze feinjustéieren kënnen nei Grenzen opmaachen. A kompositoresch Approche fir feingestëmmte Ënnermodeller ze kombinéieren, déi op verschidden Aufgaben oder Daten trainéiert sinn, kënnen et erlaben héich ugepasste Modeller op Ufro ze konstruéieren.

Schlussendlech, wéi LLMs méi ubiquitär ginn, wäert d'Fäegkeet se nahtlos ze personaliséieren an ze spezialiséieren fir all denkbar Benotzungsfall kritesch sinn. Fine-tuning a verwandte Modelladaptatiounsstrategien sinn pivotal Schrëtt fir d'Visioun vu grousse Sproochemodeller als flexibel, sécher a mächteg AI Assistenten ze realiséieren, déi mënschlech Fäegkeeten iwwer all Domän an Bestriewung erhéijen.

Ech hunn déi lescht fënnef Joer verbruecht an déi faszinéierend Welt vum Machine Learning an Deep Learning ënnerzegoen. Meng Leidenschaft an Expertise hunn mech dozou gefouert fir zu iwwer 50 verschiddenste Software Engineering Projeten bäizedroen, mat engem besonnesche Fokus op AI / ML. Meng kontinuéierlech Virwëtzegkeet huet mech och Richtung Natural Language Processing gezunn, e Feld dat ech gär hunn weider ze entdecken.

Dir kënnt gär

Alles wat Dir iwwer Llama Wësse musst 3 | Mächtegst Open Source Modell bis elo | Konzepter fir Benotzung

BlackMamba: Mëschung vun Experten fir Staat-Raum Modeller

AI GPTs fir PostgreSQL Datebank: Kann se funktionnéieren?

GOAT (Gutt bei Arithmetesch Aufgaben): Vu Sproochkompetenz bis Mathematik Genie

D'Schluecht vu Open Source vs Closed Source Sproochmodeller: Eng technesch Analyse

Evaluéieren grouss Sprooch Modeller: En technesche Guide

leschte Posts

- SIMA: Skaléieren AI Agenten iwwer virtuelle Welten fir verschidden Uwendungen

- Fredrik Danielsson, Haaptproduktmanager bei Tiny - Interview Series

- MaxDiff RL Algorithmus verbessert Roboter Léieren mat "Designed Randomness"

- Lalal.ai Bewäertung: Den #1 AI Background Noise Remover?

- Grouss Action Models (LAMs): Déi nächst Grenz an AI-Powered Interaktioun