Artificial Intelligence

研究者がGPUの代替品を開発

ライス大学のコンピューター科学者は、インテルの共同研究者とともに、GPU に代わるよりコスト効率の高い代替手段を開発しました。 新しいアルゴリズムは「サブリニア ディープ ラーニング エンジン」(SLIDE)と呼ばれ、専用の高速化ハードウェアを使用せずに汎用の中央処理装置 (CPU) を使用します。

この結果は、機械学習システムカンファレンスMLSysが開催されるオースティン・コンベンションセンターで発表された。

人工知能 (AI) における最大の課題の XNUMX つは、グラフィックス プロセッシング ユニット (GPU) などの特殊なアクセラレーション ハードウェアを取り巻くものです。 新しい開発が行われる前は、ディープ ラーニング テクノロジを高速化するには、この特殊なアクセラレーション ハードウェアの使用が必要であると考えられていました。

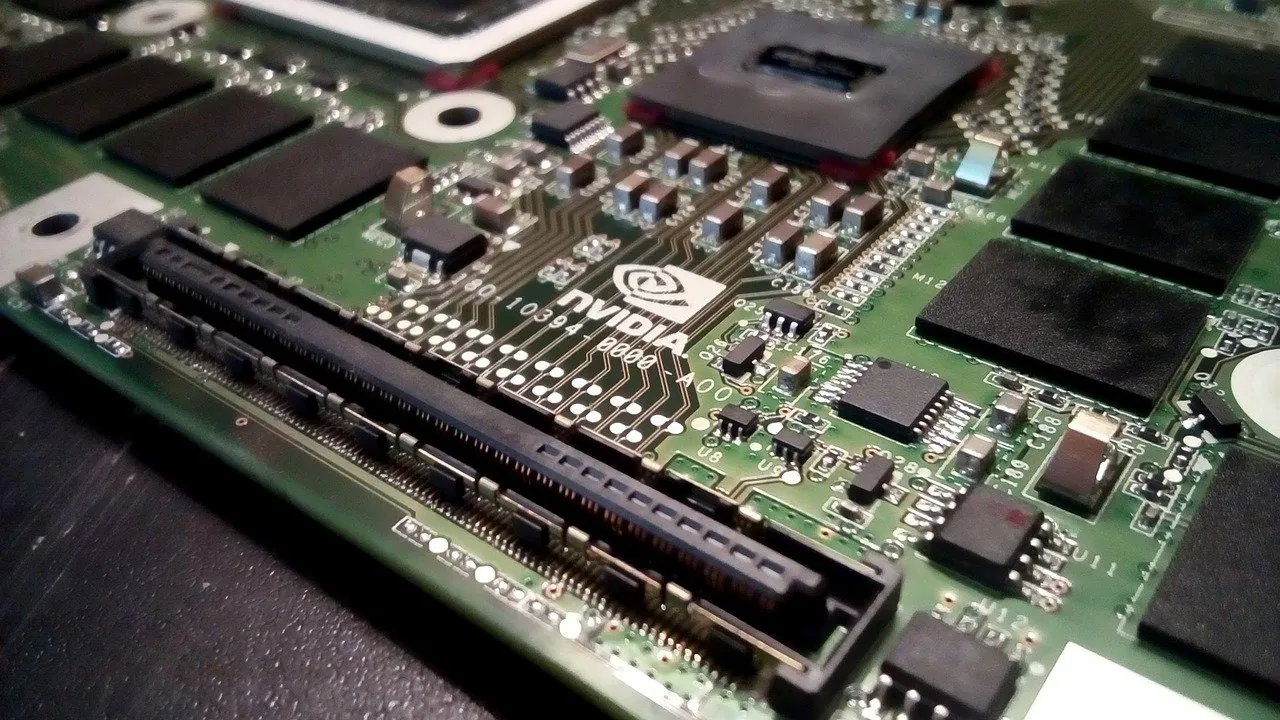

多くの企業は、デジタル アシスタント、顔認識、製品推奨システムなどのテクノロジーを担うディープ ラーニング用の GPU や専用ハードウェアへの投資を非常に重視してきました。 そのような企業の 100 つが、Tesla V41 Tensor コア GPU を開発する Nvidia です。 Nvidia は最近、第 XNUMX 四半期の収益が前年比 XNUMX% 増加したと報告しました。

SLIDE の開発は、まったく新しい可能性を切り開きます。

アンシュマリ・シュリバスタヴァ氏はライス大学ブラウン工学院の助教授で、大学院生のベイディ・チェン氏とタルン・メディニ氏とともにSLIDEの発明に貢献した。

「私たちのテストでは、SLIDE が、大規模な完全接続アーキテクチャを備えた業界規模の推奨データセットで GPU ハードウェア アクセラレーションを上回る、CPU 上でのディープ ラーニングのスマート アルゴリズム実装であることが示されました」と Shrivastava 氏は述べています。

SLIDE は、深層学習に対するまったく異なるアプローチにより、GPU の課題を克服します。 現在、ディープ ニューラル ネットワークの標準的なトレーニング手法は「バックプロパゲーション」であり、行列の乗算が必要です。 このワークロードには GPU の使用が必要なため、研究者らはニューラル ネットワークのトレーニングを変更して、ハッシュ テーブルで解決できるようにしました。

この新しいアプローチにより、SLIDE の計算オーバーヘッドが大幅に削減されます。 Amazon や Google などの企業がクラウドベースの深層学習に使用している現在最高の GPU プラットフォームには 100 基の Tesla V100,000 があり、価格は約 XNUMX 万ドルです。

「私たちのラボには 100 台あり、テスト ケースでは V100 に最適なワークロードを採用しました。これは、GPU メモリに収まる大規模な完全に接続されたネットワークで 3 億を超えるパラメータを備えたワークロードです」と Shrivastava 氏は述べています。 「私たちは、この世で最高の(ソフトウェア)パッケージである Google の TensorFlow を使ってトレーニングしましたが、トレーニングには 1 時間半かかりました。

「その後、私たちの新しいアルゴリズムは、GPU ではなく 44 コアの Xeon クラス CPU 上で XNUMX 時間でトレーニングを実行できることを示しました」と彼は続けました。

ハッシュは、1990 年代にインターネット検索用に発明されたデータのインデックス付け手法の一種です。 数値手法は、大量の情報をハッシュと呼ばれる数字の文字列としてエンコードするために使用されます。 ハッシュは、迅速に検索できるテーブルを作成するためにリストされます。

「私たちのアルゴリズムを TensorFlow や PyTorch に実装するのは無意味でしょう。なぜなら、彼らが最初にやりたいことは、あなたが行っていることを行列乗算の問題に変換することだからです」と Chen 氏は言います。 「それはまさに私たちが避けたかったことです。 そこで私たちは独自の C++ コードを一から書きました。」

Shrivastava 氏によると、SLIDE の最大の利点はデータ並列であることです。

「データ並列とは、トレーニングしたいデータ インスタンスが XNUMX つある場合、たとえば XNUMX つが猫の画像、もう XNUMX つがバスの画像である場合、それらは異なるニューロンをアクティブにする可能性が高く、SLIDE は更新またはトレーニングできることを意味します。これら XNUMX つを独立して検討します」と彼は言いました。 「これは、CPU の並列処理をより効果的に利用できるものです。」

「GPU と比較すると、裏を返せば、大容量のメモリが必要になるということです」と彼は言いました。 「メイン メモリにはキャッシュ階層があり、これに注意しないと、大量のキャッシュ ミスが発生するキャッシュ スラッシングと呼ばれる問題に遭遇する可能性があります。」

SLIDE は、ディープ ラーニングを実装する新しい方法への扉を開きましたが、シュリヴァスタヴァ氏は、これは単なる始まりにすぎないと信じています。

「私たちは表面をなぞっただけです」と彼は言いました。 「最適化のためにできることはまだたくさんあります。 たとえば、ベクトル化や、Intel Deep Learning Boost のような CPU の組み込みアクセラレータは使用していません。 これをさらに高速化するために使用できるトリックは他にもたくさんあります。」