ソートリーダー

生成 AI における LLM エージェントの機会と課題の解読

プロンプトから検索拡張生成 (RAG)、エージェントに至るまで、大規模言語モデル (LLM) を活用した生成 AI アプリケーションの進歩が見られます。 エージェントは、主にこのテクノロジがエンタープライズ アプリケーションを変革し、優れた顧客エクスペリエンスを提供するために提供される力のために、業界や研究界で盛んに話題になっています。 汎用人工知能 (AGI) への最初のステップを可能にするエージェントを構築するには、共通のパターンがあります。

前の 記事では、LLM を活用したアプリケーションを構築するためのパターンのインテリジェンスのはしごを見てきました。 問題のドメインをキャプチャし、LLM 内部メモリを使用して出力を生成するプロンプトから開始します。 RAG を使用すると、ベクトル データベースから検索された外部知識をプロンプトに追加して、出力を制御します。 次に、LLM 呼び出しを連鎖させることで、複雑なアプリケーションを実現するワークフローを構築できます。 エージェントは、これらの LLM チェーンがどのように形成されるかを自動決定することで、これを次のレベルに引き上げます。 詳しく見てみましょう。

エージェント – 内部

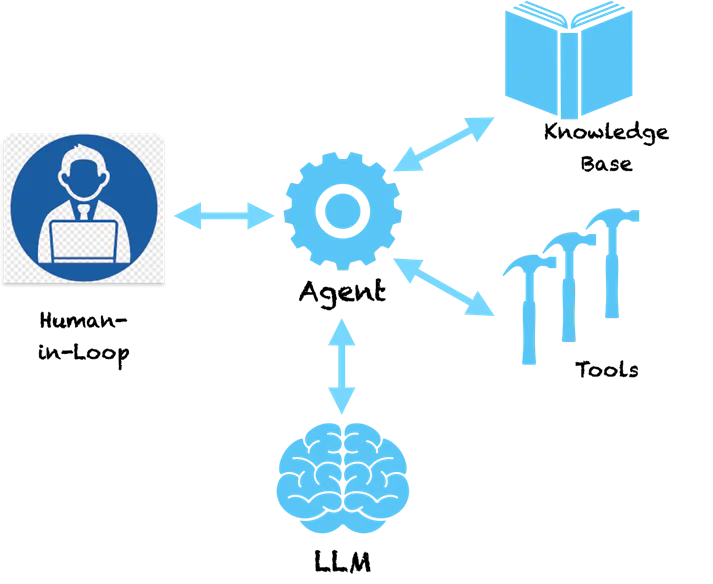

エージェントの主なパターンは、LLM の言語理解能力を使用して、特定の問題を解決する方法についての計画を立てることです。 LLM は問題を理解し、問題を解決するための一連の手順を提供します。 しかし、それだけではありません。 エージェントは、問題を解決するための推奨事項を提供し、推奨された手順を実行するようにバトンを渡す純粋なサポート システムではありません。 エージェントには、先に進んでアクションを実行するためのツールが与えられます。 怖いですよね!?

エージェントに次のような基本的な質問をすると、次のようになります。

人間: 電話の発明者はどこの会社を設立しましたか?

以下は、エージェントが実行する可能性のある思考手順のサンプルです。

エージェント (思考):

- 考えた: 電話の発明者を探さなければなりません。

- Action: [電話の発明者] を検索

- 観察者: アレクサンダー・グラハム・ベル

- 考えたこと: アレクサンダー・グラハム・ベルによって設立された会社を探す必要がある

- Action: 検索 [アレクサンダー・グラハム・ベルによって設立された会社]

- 観察: アレクサンダー グラハム ベルは 1885 年に American Telephone and Telegraph Company (AT&T) を共同設立しました。

- 感想:答えを見つけました。 私は戻ります。

エージェント (応答): アレクサンダー・グラハム・ベルは 1885 年に AT&T を共同設立しました

エージェントが、問題を特定のアクションを実行することで解決できるサブ問題に分割する系統的な方法に従っていることがわかります。 ここでのアクションは LLM によって推奨されており、これらのアクションを特定のツールにマップしてこれらのアクションを実装できます。 エージェントの検索ツールを有効にして、LLM がアクションとして検索を提供したことを認識したときに、LLM が提供するパラメーターを使用してこのツールを呼び出すようにすることができます。 ここでの検索はインターネット上で行われますが、ベクトル データベースのような内部知識ベースの検索にリダイレクトすることもできます。 システムは自己完結型になり、一連の手順に従って複雑な問題を解決する方法を見つけ出すことができます。 のようなフレームワーク ラングチェーン および LLaMAIndex を使用すると、これらのエージェントを構築し、ツールや API に接続する簡単な方法が得られます。 Amazon は最近、エージェントを設計するための視覚的なインターフェイスを提供する Bedrock Agents フレームワークを開始しました。

内部では、エージェントは特別なスタイルに従ってプロンプトを LLM に送信し、アクション プランを生成させます。 上記の思考、行動、観察のパターンは、ReAct (Reasoning and Acting) と呼ばれるタイプのエージェントで一般的です。 他のタイプのエージェントには MRKL や計画と実行が含まれますが、これらは主にプロンプト スタイルが異なります。

より複雑なエージェントの場合、アクションはソース システムに変更を引き起こすツールに関連付けられる場合があります。 たとえば、休暇残高をチェックし、ERP システムで従業員の休暇を申請するツールにエージェントを接続できます。 これで、ユーザーと対話し、チャット コマンドを介してシステムに休暇を申請する優れたチャットボットを構築できるようになりました。 休暇を申請するための複雑な画面は不要になり、シンプルな統一されたチャット インターフェイスが使用されます。 楽しそう!?

責任ある AI の注意点と必要性

では、事前に承認された API を使用して株式取引のトランザクションを呼び出すツールがある場合はどうなるでしょうか。 エージェントが (ツールを使用して) 株価の変動を調査し、株式の売買に関する意思決定を行うアプリケーションを構築します。 エージェントが幻覚を見て間違った決定をしたために、間違った株を売ってしまったらどうなるでしょうか? LLM は巨大なモデルであるため、LLM が何らかの決定を下す理由を特定するのは困難です。そのため、適切なガードレールがないと幻覚がよく発生します。

エージェントはどれも魅力的ですが、彼らがどれほど危険であるかはおそらく想像がつくでしょう。 幻覚を見て間違った行動をとった場合、多大な経済的損失や企業システムに重大な問題を引き起こす可能性があります。 したがって、LLM を活用したアプリケーションの時代では、責任ある AI が最も重要になっています。 再現性、透明性、説明責任に関する Responsible AI の原則は、エージェントが下す決定にガードレールを設け、どのアクションに人間の関与が必要かを判断するためのリスク分析を提案します。 より複雑なエージェントが設計されるにつれ、エージェントが何をしているのかを確実に把握するために、より精査、透明性、説明責任が必要になります。

終わりの思考

アクションを伴う論理的なステップのパスを生成するエージェントの能力により、エージェントは人間の推論に非常に近づきます。 より強力なツールを使用して彼らに力を与えると、スーパーパワーを得ることができます。 ReAct のようなパターンは、人間が問題を解決する方法をエミュレートしようとしているため、特定のコンテキストやドメイン (銀行、保険、医療、産業など) に関連する、より優れたエージェント パターンが見られるようになるでしょう。 未来はここにあり、エージェントの背後にあるテクノロジーを私たちが使用する準備ができています。 同時に、スカイネットを構築しないように、責任ある AI のガードレールに細心の注意を払う必要があります。