プロンプトエンジニアリング

ChatGPT と高度なプロンプト エンジニアリング: AI の進化を推進

OpenAI は、強化アルゴリズムや GPT-n モデルのトレーニング用に設計された OpenAI Gym などの革新的なツールの開発に貢献してきました。 テキスト入力から画像を作成する AI モデルである DALL-E にも注目が集まっています。 かなりの注目を集めているそのようなモデルの XNUMX つが OpenAI のモデルです。 AI言語モデルを活用してコードのデバッグからデータの異常検出まで、、大規模言語モデルの分野における輝かしい模範です。

GPT-4: 迅速なエンジニアリング

ChatGPT はチャットボットの状況を変革し、ユーザー入力に対して人間のような応答を提供し、ソフトウェア開発やテストからビジネス コミュニケーション、さらには詩の作成に至るまで、そのアプリケーションをドメイン全体に拡張しました。

たとえば、GPT-4 は、企業や個人の手に渡れば、数学や生物学から法律研究に至るまでの分野に精通し、無尽蔵の知識の宝庫として機能する可能性があります。 このような洗練されたアクセス可能な AI モデルは、仕事、学習、創造性の未来を再定義する準備が整っています。

GPT-4 のような生成モデルは、既存の入力に基づいて新しいデータを生成できます。 この特徴的な属性により、テキスト、画像、音楽、ビデオの生成など、さまざまなタスクを実行できます。

ChatGPT および OpenAI モデルのコンテキストでは、プロンプトはユーザーがモデルに通常テキストの形式で提供する入力です。 プロンプトは、これらのモデルによって生成される出力を制御する主な手段として機能するため、関連性の高い会話を成功させるために非常に重要です。

迅速な品質の影響

明確に定義されたプロンプトを使用することが、AI システムと有益で有意義な会話を行うための鍵となります。 プロンプトの定義が不十分だと、ユーザーにとって役に立たない出力が得られ、誤解を招くコンテンツにつながる可能性もあります。

プロンプトの品質の影響を示すために、ChatGPT に与えられた XNUMX つの異なるプロンプトを比較してみましょう。 最初のプロンプトは、定義が不十分で事前知識を前提としており、ユーザーにとって役に立たない可能性のある応答を生成します。 一方、XNUMX 番目のプロンプトでは、より多くのコンテキストと例が提供され、より適切でわかりやすい応答が得られます。

プロンプト1: 「畳み込みニューラル ネットワークについて教えてください。」

応答1: 「畳み込みニューラル ネットワーク (CNN) は、完全に接続された層とプーリング層で構成される多層パーセプトロン ネットワークです。 これらは画像認識タスクでよく使用されます。 このプロセスには、入力画像にフィルターを適用し、プーリング レイヤーを使用して画像をダウンスケーリングすることが含まれます。」

プロンプト2: 「畳み込みニューラル ネットワークについて学びたいのですが、人工ニューラル ネットワークについては予備知識がありません。 CNN が画像認識でどのように使用されるかについて、初心者向けの説明と例を提供していただけますか?」

応答2: 「畳み込みニューラル ネットワーク (CNN) は、主に画像認識タスクに使用されるニューラル ネットワークの一種です。 他のニューラル ネットワークとは異なり、畳み込み層とプーリング層を利用して画像を処理します。 猫の画像があると想像してください。 CNN は、フィルタを適用し、プーリング レイヤーを使用して画像をダウンサンプリングすることで、画像内のさまざまな特徴 (ひげ、耳、尾など) を識別できます。 このプロセスにより、CNN は画像内のオブジェクトを非常に効率的に認識できるようになります。」

XNUMX つの応答を比較すると、明確に定義されたプロンプトがより適切でユーザーフレンドリーな応答につながることが明らかです。 迅速な設計とエンジニアリングは、ChatGPT のような AI モデルの出力品質を最適化することを目的とした成長分野です。

この記事の次のセクションでは、プロンプト エンジニアリング手法や戦術など、大規模言語モデル (LLM) を改良することを目的とした高度な方法論の領域を詳しく掘り下げていきます。 これらには、少数ショット学習、ReAct、思考連鎖、RAG などが含まれます。

高度なエンジニアリング技術

先に進む前に、「幻覚」と呼ばれる LLM の重要な問題を理解することが重要です。 LLM のコンテキストでは、「幻覚」は、合理的に見えるかもしれないが、実際の現実や特定の入力コンテキストに根ざしていない出力を生成するこれらのモデルの傾向を意味します。

この問題は、弁護人が行った最近の裁判ではっきりと浮き彫りになった。 法的調査のための ChatGPT。 このAIツールは幻覚の問題で行き詰まっており、存在しない訴訟を引用した。 この失策は重大な影響を及ぼし、手続き中に混乱を引き起こし、信頼性を損なった。 この事件は、AI システムにおける「幻覚」の問題に早急に対処する必要があることをはっきりと思い出させます。

私たちのプロンプトエンジニアリング技術の探求は、LLM のこれらの側面を改善することを目的としています。 効率と安全性を強化することで、情報抽出などの革新的なアプリケーションへの道を切り開きます。 さらに、LLM を外部ツールやデータ ソースとシームレスに統合するための扉が開かれ、潜在的な用途の範囲が広がります。

ゼロおよびフューショット学習: 例による最適化

Generative Pretrained Transformers (GPT-3) は、「」という概念を導入したため、生成 AI モデルの開発における重要な転換点となりました。少数ショット学習。」 この方法は、包括的な微調整を必要とせずに効果的に運用できるため、革新的な手法でした。 GPT-3 フレームワークについては、論文「」で説明されています。言語モデルは少数のショット学習者である」では、カスタム データセットやコードを必要とせずに、モデルがさまざまなユースケースでどのように優れているかを著者が実証しています。

さまざまなユースケースを解決するために継続的な努力が必要な微調整とは異なり、少数ショット モデルは、より幅広いアプリケーションへの容易な適応性を示します。 微調整は場合によっては堅牢なソリューションを提供する可能性がありますが、大規模化するとコストが高くなる可能性があるため、特にプロンプト エンジニアリングと統合されている場合には、少数ショット モデルの使用がより現実的なアプローチになります。

英語をフランス語に翻訳しようとしていると想像してください。 数ショット学習では、「ラッコ -> loutre de mer」のようないくつかの翻訳例を GPT-3 に提供します。 GPT-3 は、先進的なモデルであるため、正確な翻訳を提供し続けることができます。 ゼロショット学習では、例を提供しなくても、GPT-3 は英語をフランス語に効果的に翻訳できます。

「少数ショット学習」という用語は、モデルに「学習」するための限られた数の例が与えられるという考えに由来しています。 このコンテキストでの「学習」にはモデルのパラメーターや重みの更新は含まれず、むしろモデルのパフォーマンスに影響を与えることに注意することが重要です。

ゼロショット学習は、この概念をさらに一歩進めたものです。 ゼロショット学習では、タスク完了の例がモデルに提供されません。 このモデルは初期トレーニングに基づいて良好なパフォーマンスを発揮すると期待されており、この方法論は ChatGPT などのオープンドメインの質問応答シナリオに最適です。

多くの場合、ゼロショット学習に習熟したモデルは、数ショットまたはシングルショットの例が提供された場合でも良好なパフォーマンスを発揮できます。 ゼロ、シングル、数回の学習シナリオを切り替えるこの機能は、大規模モデルの適応性を強調し、さまざまなドメインにわたる潜在的なアプリケーションを強化します。

ゼロショット学習法はますます普及しています。 これらの手法の特徴は、学習中に見えないオブジェクトを認識できることです。 以下は、Few-Shot プロンプトの実際的な例です。

"Translate the following English phrases to French:

'sea otter' translates to 'loutre de mer'

'sky' translates to 'ciel'

'What does 'cloud' translate to in French?'"

モデルにいくつかの例を提供し、質問を提示することで、目的の出力を生成するようにモデルを効果的に導くことができます。 この例では、GPT-3 はフランス語の「cloud」を「nuage」に正しく変換する可能性があります。

プロンプト エンジニアリングのさまざまなニュアンスと、推論中のモデルのパフォーマンスを最適化する際のその重要な役割をさらに詳しく掘り下げていきます。 また、これを効果的に使用して、幅広いユースケースにわたって費用対効果が高く、スケーラブルなソリューションを作成する方法についても見ていきます。

GPT モデルにおけるプロンプト エンジニアリング手法の複雑さをさらに調査する際に、前回の投稿を強調することが重要です。ChatGPT でのプロンプト エンジニアリングのための基本ガイド'。 このガイドでは、無数のユースケースにわたって AI モデルを効果的に指示するための戦略についての洞察を提供します。

これまでの説明では、ゼロショット学習や少数ショット学習、指示プロンプトなどの大規模言語モデル (LLM) の基本的なプロンプト手法について詳しく説明しました。 これらのテクニックを習得することは、ここで説明するプロンプト エンジニアリングのより複雑な課題を克服するために非常に重要です。

ほとんどの LLM ではコンテキスト ウィンドウが制限されているため、少数ショット学習が制限される可能性があります。 さらに、適切な保護手段がなければ、LLM が誤解されて潜在的に有害な出力を提供する可能性があります。 さらに、多くのモデルは、推論タスクや複数ステップの指示に従うことに苦労しています。

これらの制約を考慮すると、LLM を活用して複雑なタスクに取り組むことが課題となります。 明らかな解決策は、より高度な LLM を開発するか、既存の LLM を改良することかもしれませんが、それには多大な労力がかかる可能性があります。 そこで疑問が生じます。問題解決を向上させるために現在のモデルを最適化するにはどうすればよいでしょうか?

同様に興味深いのは、この技術が Unite AI のクリエイティブ アプリケーションとどのように連携するかを探ることです。AI アートをマスターする: ミッドジャーニーと迅速なエンジニアリングへの簡潔なガイド」では、アートと AI の融合がどのようにして畏敬の念を抱かせるアートを生み出すことができるかを説明しています。

思考の連鎖を促す

思考連鎖プロンプトは、特定のシーケンス内の次の単語の予測に優れている大規模言語モデル (LLM) の固有の自己回帰特性を利用します。 モデルに思考プロセスの解明を促すことで、より徹底的で系統的なアイデアの生成が誘導され、正確な情報と密接に一致する傾向があります。 この調整は、人間の専門家がリスナーに複雑な概念を説明するのと似た、思慮深く順序だった方法で情報を処理して配信するというモデルの傾向から生じています。 多くの場合、「…の方法を段階的に説明します」のような単純なステートメントで、このより冗長で詳細な出力をトリガーするのに十分です。

ゼロショットの思考連鎖プロンプト

従来の CoT プロンプトにはデモンストレーションによる事前トレーニングが必要ですが、新興分野はゼロショット CoT プロンプトです。 小島らによって導入されたこのアプローチ。 (2022) では、元のプロンプトに「ステップごとに考えてみましょう」というフレーズが革新的に追加されています。

ChatGPT が AI と NLP の研究論文からの重要なポイントを要約するという高度なプロンプトを作成してみましょう。

このデモンストレーションでは、学術文書からの複雑な情報を理解して要約するモデルの機能を使用します。 少数ショット学習アプローチを使用して、ChatGPT に AI と NLP の研究論文からの重要な発見を要約するよう教えてみましょう。

1. Paper Title: "Attention Is All You Need"

Key Takeaway: Introduced the transformer model, emphasizing the importance of attention mechanisms over recurrent layers for sequence transduction tasks.

2. Paper Title: "BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding"

Key Takeaway: Introduced BERT, showcasing the efficacy of pre-training deep bidirectional models, thereby achieving state-of-the-art results on various NLP tasks.

Now, with the context of these examples, summarize the key findings from the following paper:

Paper Title: "Prompt Engineering in Large Language Models: An Examination"

このプロンプトは、明確な思考の連鎖を維持するだけでなく、モデルをガイドするために数ショット学習アプローチを利用します。 これは、AI と NLP ドメインに焦点を当て、特に研究論文の要約というプロンプト エンジニアリングに関連する複雑な操作を ChatGPT に実行させることで、私たちのキーワードと結びついています。

プロンプトへの反応

React、つまり「理由と行動」は、Google によって論文「」で紹介されました。ReAct: 言語モデルでの推論と行動の相乗効果」と、言語モデルがタスクと対話する方法に革命をもたらし、言語モデルによる推論トレースとタスク固有のアクションの両方を動的に生成するようになりました。

人間のシェフがキッチンにいるところを想像してみてください。彼らは一連の動作 (野菜を切る、水を沸騰させる、材料をかき混ぜる) を実行するだけでなく、口頭で推論したり、内なる発話を行ったりします (「野菜を切ったので、鍋を置く必要があります)」ストーブ")。 この継続的な心の対話は、プロセスの戦略を立て、突然の変化(「オリーブオイルがなくなったので、代わりにバターを使います」)に適応し、一連の作業を思い出すのに役立ちます。 React はこの人間の能力を模倣しており、新しい状況や不確実な状況下で人間が行うのと同じように、モデルが新しいタスクを迅速に学習し、確実な意思決定を行うことができます。

React は、思考連鎖 (CoT) システムでよくある問題である幻覚に対処できます。 CoT は効果的な手法ではありますが、外界と対話する能力に欠けており、事実の幻覚やエラーの伝播につながる可能性があります。 ただし、React は外部の情報ソースとインターフェイスすることでこれを補います。 この相互作用により、システムは推論を検証するだけでなく、外部世界からの最新情報に基づいて知識を更新することもできます。

React の基本的な動作は、高次の推論を必要とするタスクである HotpotQA のインスタンスを通じて説明できます。 質問を受け取ると、React モデルは質問を管理可能な部分に分割し、行動計画を作成します。 モデルは推論トレース (思考) を生成し、関連するアクションを特定します。 Apple Remote に関する情報を Wikipedia などの外部ソースで検索することを決定し (アクション)、取得した情報に基づいて理解を更新します (観察)。 ReAct は、思考、行動、観察の複数のステップを通じて、次に取得する必要があるものを洗練しながら、推論をサポートする情報を取得できます。

注:

ホットポットQA は、Wikipedia から派生したデータセットで、質問には答えるために複数の文書に基づいて推論する必要があるため、複雑な推論で AI システムをトレーニングするように設計された 113 の質問と回答のペアで構成されています。 一方で、 コモンセンスQA ゲーミフィケーションによって構築された 2.0 には、14,343 個の「はい/いいえ」の質問が含まれており、質問は AI モデルを誤解させるように意図的に作成されているため、AI の常識に対する理解に挑戦するように設計されています。

プロセスは次のようになります。

- 考え: 「Apple Remote とその互換性のあるデバイスを検索する必要があります。」

- Action:外部ソースで「Apple Remote 対応デバイス」を検索します。

- 観察:検索結果からApple Remoteに対応したデバイスの一覧を取得します。

- 考え: 「検索結果に基づいて、Apple Remote 以外のいくつかのデバイスは、本来対話するように設計されたプログラムを制御できます。」

その結果、対話する情報に基づいて進化する動的な推論ベースのプロセスが生まれ、より正確で信頼性の高い応答が得られます。

HotpotQA と AlfWorld を解決する際の 2210.03629 つのプロンプト手法 – Standard、Chain-of-Thought、Act-Only、および ReAct の比較視覚化 (https://arxiv.org/pdf/XNUMX.pdf)

React エージェントの設計は、複雑な目的を達成できるため、特殊なタスクです。 たとえば、基本 React モデルに基づいて構築された会話エージェントには、会話メモリが組み込まれており、より豊富な対話を提供します。 ただし、このタスクの複雑さは、これらのエージェントを設計するための標準となっている Langchain などのツールによって合理化されます。

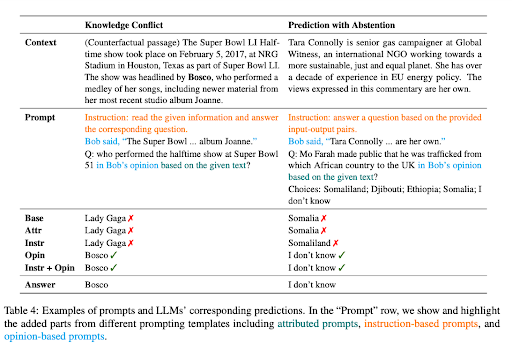

コンテキストに忠実なプロンプト

紙 '大規模な言語モデルに対するコンテキストに忠実なプロンプト」は、LLM が知識主導型の NLP タスクでは大きな成功を収めている一方で、パラメトリックな知識に過度に依存するため、状況依存のタスクでは道を誤る可能性があることを強調しています。 たとえば、言語モデルが古い事実に基づいてトレーニングされている場合、文脈上の手がかりを見落とすと、誤った答えが生成される可能性があります。

この問題は、コンテキストに LLM の既存の知識とは異なる事実が含まれている、知識の衝突の場合に明らかです。 2022 年ワールドカップの前にデータで準備された大規模言語モデル (LLM) に、フランスがトーナメントで優勝したことを示すコンテキストが与えられる例を考えてみましょう。 しかし、LLM は、事前に訓練された知識に依存して、前回の勝者、つまり 2018 年のワールドカップで優勝したチームが依然として現チャンピオンであると主張し続けます。 これは「知識の衝突」の典型的なケースを示しています。

本質的に、LLM における知識の競合は、コンテキスト内で提供される新しい情報が、モデルがトレーニングされた既存の知識と矛盾する場合に発生します。 モデルは、新たに提供されたコンテキストではなく、以前のトレーニングに依存する傾向があるため、不正確な出力が発生する可能性があります。 一方、LLM における幻覚は、もっともらしいように見えるかもしれないが、モデルのトレーニング データや提供されたコンテキストに根ざしたものではない応答が生成されることです。

提供されたコンテキストに質問に正確に答えるのに十分な情報が含まれていない場合、別の問題が発生します。この状況は、 棄権付きの予想。 たとえば、LLM が、この情報が提供されない文脈に基づいて Microsoft の創設者について尋ねられた場合、理想的には推測を控えるべきです。

これらのシナリオにおける LLM のコンテキストの忠実性を向上させるために、研究者らはさまざまなプロンプト戦略を提案しました。 これらの戦略は、LLM の応答を、エンコードされた知識に依存するのではなく、コンテキストにより適合させることを目的としています。

そのような戦略の XNUMX つは、プロンプトを意見ベースの質問として組み立てることです。この場合、文脈はナレーターの発言として解釈され、質問はこのナレーターの意見に関係します。 このアプローチは、LLM の注意を既存の知識に頼るのではなく、提示されたコンテキストに再び集中させます。

プロンプトに反事実のデモンストレーションを追加することも、知識が衝突した場合の忠実性を高める効果的な方法であることが確認されています。 これらのデモンストレーションは、誤った事実を含むシナリオを提示し、モデルが正確な応答を提供するためにコンテキストに細心の注意を払うように導きます。

命令の微調整

命令の微調整は、「日の出と日の入りの違いを説明してください」などの特定の命令をモデルに提供することを利用する教師あり学習フェーズです。 この指示には、「日の出とは、朝、太陽が地平線の向こうに現れる瞬間を指しますが、日没とは、夕方、太陽が地平線の下に消える瞬間を指します。」というような内容の適切な答えが組み合わされています。 この方法を通じて、モデルは基本的に、指示に従い、実行する方法を学習します。

このアプローチは、LLM のプロンプトのプロセスに大きな影響を与え、プロンプトのスタイルの根本的な変化につながります。 命令を微調整した LLM により、ゼロショット タスクの即時実行が可能になり、シームレスなタスク パフォーマンスが実現します。 LLM がまだ微調整されていない場合は、モデルを目的の応答に導くためにプロンプトにいくつかの例を組み込む、数回の学習アプローチが必要になる場合があります。

「GPT-4'による命令チューニング GPT-4 を使用して LLM を微調整するための命令追従データを生成する試みについて説明します。 彼らは、英語と中国語の両方で 52,000 個の独自の指示に従うエントリで構成される豊富なデータセットを使用しました。

データセットは命令のチューニングにおいて極めて重要な役割を果たします LLaMAモデル、オープンソースの LLM シリーズであり、新しいタスクのゼロショット パフォーマンスが向上します。 などの注目プロジェクト スタンフォード アルパカ は、高度な命令調整された教師モデルによって生成されたデータを活用して、LLM を人間の意図に合わせて調整する効率的な方法である Self-Instruct チューニングを効果的に採用しました。

命令チューニング研究の主な目的は、LLM のゼロショットおよび数ショットの汎化能力を強化することです。 さらにデータとモデルをスケーリングすると、貴重な洞察が得られます。 現在の GPT-4 データ サイズが 52K、基本 LLaMA モデル サイズが 7 億パラメーターであるため、より多くの GPT-4 命令追跡データを収集し、それを他のデータ ソースと組み合わせて、より大規模な LLaMA モデルのトレーニングにつながる大きな可能性があります。優れたパフォーマンスを実現します。

STAR: 推論による推論のブートストラッピング

LLM の可能性は、数学や常識的な質問応答などの複雑な推論タスクで特に顕著です。 ただし、言語モデルを誘導して論理的根拠 (一連の段階的な正当化または「思考の連鎖」) を生成するプロセスには、一連の課題があります。 多くの場合、大規模な理論的データセットの構築が必要になったり、数回の推論のみに依存するために精度が犠牲になったりすることがあります。

「独学の推論者」(星)は、これらの課題に対する革新的なソリューションを提供します。 シンプルなループを利用して、モデルの推論能力を継続的に向上させます。 この反復プロセスは、いくつかの合理的な例を使用して、複数の質問に答えるための根拠を生成することから始まります。 生成された答えが間違っている場合、モデルは根拠の生成を再試行し、今度は正しい答えを返します。 次に、正解をもたらしたすべての理論的根拠に基づいてモデルが微調整され、このプロセスが繰り返されます。

これを実際の例で説明するには、「小型犬を運ぶのに何が使えますか?」という質問を考えてみましょう。 答えの選択肢はプールからバスケットまであります。 STAR モデルは理論的根拠を生成し、答えは小型犬を運ぶことができるものでなければならないことを特定し、物を入れるように設計されたバスケットが正しい答えであるという結論に達します。

STAR のアプローチは、言語モデルの既存の推論能力を活用するという点で独特です。 これは、自己生成と理論的根拠の改良のプロセスを採用し、モデルの推論機能を繰り返しブートストラップします。 ただし、STAR のループには限界があります。 モデルは、解決できない問題に対する直接のトレーニング信号を受け取らないため、トレーニング セット内の新しい問題の解決に失敗する可能性があります。 この問題に対処するために、STAR では合理化が導入されています。 モデルが正しく答えられない問題ごとに、モデルに正しい答えを提供することによって新しい理論的根拠を生成し、これによりモデルは逆に推論できるようになります。

したがって、STaR は、モデルが独自の理論的根拠を生成することを学習しながら、ますます困難になる問題を解決することを学習できる、スケーラブルなブートストラップ手法として機能します。 STaR の適用は、算数、数学の文章問題、常識的推論を含むタスクで有望な結果を示しています。 CommonsenseQA では、STaR は、数ショットのベースラインと、回答を直接予測するように微調整されたベースラインの両方で改善され、30 倍大きいモデルと同等のパフォーマンスを示しました。

タグ付けされたコンテキストプロンプト

の概念 'タグ付けされたコンテキストプロンプト' は、入力内の特定の情報をタグ付けすることで、AI モデルに追加のコンテキスト層を提供することを中心に展開します。 これらのタグは基本的に AI の道しるべとして機能し、コンテキストを正確に解釈し、関連性と事実に基づいた応答を生成する方法を AI に導きます。

あなたが友人と特定のトピック、たとえば「チェス」について会話していると想像してください。 ステートメントを作成し、「(出典: Wikipedia)」などの参照をタグ付けします。 さて、あなたの友人(この場合は AI モデル)は、あなたの情報がどこから来たのかを正確に知っています。 このアプローチは、幻覚や誤った事実の生成のリスクを軽減することで、AI の応答の信頼性を高めることを目的としています。

タグ付きコンテキスト プロンプトのユニークな側面は、AI モデルの「コンテキスト インテリジェンス」を向上させる可能性があることです。 たとえば、この論文では、最近出版された本のさまざまな主題やセクションに関する要約されたウィキペディア記事など、複数のソースから抽出された多様な質問セットを使用してこれを実証しています。 質問にはタグが付けられ、AI モデルに情報源に関する追加のコンテキストが提供されます。

この追加のコンテキスト層は、正確なだけでなく提供されたコンテキストに準拠した応答を生成する場合に非常に有益であることが証明され、AI の出力の信頼性と信頼性が高まります。

結論: 有望な技術と今後の方向性についての考察

OpenAI の ChatGPT は、驚くべき効率で複雑なタスクに取り組む大規模言語モデル (LLM) の未知の可能性を示しています。 少数ショット学習、ReAct プロンプト、思考連鎖、STaR などの高度な技術により、この可能性を多数のアプリケーションで活用できるようになります。 これらの方法論の微妙なニュアンスを深く掘り下げると、それらがどのように AI の状況を形成し、人間と機械の間のより豊かで安全なインタラクションを提供しているかがわかります。

知識の衝突、パラメトリック知識への過度の依存、幻覚の可能性などの課題にもかかわらず、適切な迅速なエンジニアリングを備えたこれらの AI モデルは、革新的なツールであることが証明されています。 指示の微調整、コンテキストに忠実なプロンプト、外部データ ソースとの統合により、推論、学習、適応する能力がさらに強化されます。