Artificial Intelligence

Llama 2: ChatGPT に対するオープンソースの挑戦者についての詳細

大規模な言語モデル 複雑な推論タスクを実行できる (LLM) は、プログラミングやクリエイティブ ライティングなどの特殊な領域で有望であることが示されています。 ただし、LLM の世界は単なるプラグアンドプレイの楽園ではありません。 使いやすさ、安全性、計算能力の点で課題があります。 この記事では、の機能について詳しく説明します。 ラマ2、Google Colab で Hugging Face および T4 GPU を介してこの高性能 LLM をセットアップするための詳細なウォークスルーを提供します。

Meta が Microsoft と提携して開発したこのオープンソースの大規模言語モデルは、生成 AI と自然言語理解の領域を再定義することを目的としています。 Llama 2 は、テラバイト規模のデータでトレーニングされた単なる統計モデルではありません。 それは哲学の具現化です。 AI 開発、特に生成 AI 分野のバックボーンとしてオープンソースのアプローチを強調するもの。

Llama 2 とその対話に最適化された代替ツールである Llama 2-Chat には、最大 70 億のパラメータが装備されています。 これらは人間の好みに厳密に合わせるように設計された微調整プロセスを経ており、他の多くの一般公開されているモデルよりも安全かつ効果的になります。 微調整におけるこのレベルの粒度は、多くの場合、次のようなクローズドな「製品」LLM のために予約されています。 AI言語モデルを活用してコードのデバッグからデータの異常検出まで、 および BARD は、一般に公開された精査やカスタマイズのために利用可能ではありません。

Llama 2 の技術的な詳細

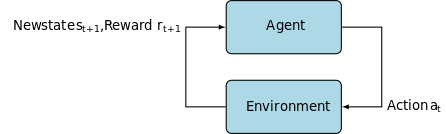

Llama 2 モデルのトレーニング用。 前任者と同様に、自動回帰を使用します。 トランスアーキテクチャ、自己教師ありデータの広範なコーパスで事前トレーニングされています。 ただし、ヒューマン フィードバックによる強化学習 (RLHF) を使用して、人間の行動や好みに合わせてさらに洗練されたレイヤーを追加します。 これは計算コストがかかりますが、モデルの安全性と有効性を向上させるためには不可欠です。

事前トレーニングとデータ効率

Llama 2 の根本的な革新は、事前トレーニング体制にあります。 このモデルは、前モデルの Llama 1 からヒントを得ていますが、パフォーマンスを向上させるためにいくつかの重要な機能強化が導入されています。 特に、トレーニングされたトークンの総数が 40% 増加し、コンテキストの長さが XNUMX 倍に拡大したことが際立っています。 さらに、このモデルはグループ化クエリ アテンション (GQA) を利用して推論のスケーラビリティを強化します。

教師あり微調整 (SFT) およびヒューマン フィードバックによる強化学習 (RLHF)

Llama-2 チャットは、SFT とヒューマン フィードバックによる強化学習 (RLHF) の両方を使用して厳密に微調整されています。 この文脈において、SFT は RLHF フレームワークの不可欠なコンポーネントとして機能し、人間の好みや期待と密接に一致するようにモデルの応答を洗練します。

OpenAI は、InstructGPT で採用されている SFT および RLHF 方法論を説明する洞察力に富んだ図を提供しました。 LLaMa 2 と同様に、InstructGPT もこれらの高度なトレーニング技術を活用してモデルのパフォーマンスを最適化します。

以下の画像のステップ 1 は教師付き微調整 (SFT) に焦点を当てており、その後のステップではヒューマン フィードバックからの強化学習 (RLHF) プロセスが完了します。

教師ありファインチューニング (SFT) は、特定の下流タスク用に事前トレーニングされた大規模言語モデル (LLM) を最適化することを目的とした特殊なプロセスです。 データ検証を必要としない教師なし手法とは異なり、SFT は事前検証されラベル付けされたデータセットを使用します。

一般に、これらのデータセットの作成にはコストと時間がかかります。 Llama 2 のアプローチは量よりも質でした。 わずか 27,540 件のアノテーションで、Meta のチームは人間のアノテーターに匹敵するパフォーマンス レベルを達成しました。 これは以下とよく一致します 最近の研究 これは、限定的ではあるがクリーンなデータセットでも高品質の結果をもたらすことができることを示しています。

SFT プロセスでは、事前トレーニングされた LLM がラベル付きデータセットに公開され、教師あり学習アルゴリズムが機能します。 モデルの内部重みは、タスク固有の損失関数から計算された勾配に基づいて再調整されます。 この損失関数は、モデルの予測出力と実際のグラウンドトゥルース ラベルの間の差異を定量化します。

この最適化により、LLM はラベル付きデータセット内に埋め込まれた複雑なパターンやニュアンスを把握できるようになります。 その結果、モデルは単なる汎用ツールではなく、目的のタスクを高精度で実行することに熟達した特殊な資産に進化します。

強化学習は次のステップであり、モデルの動作を人間の好みにさらに近づけることを目的としています。

調整フェーズでは、ヒューマン フィードバックからの強化学習 (RLHF) を活用し、次のような手法を採用しました。 重要度のサンプリング と 近位ポリシーの最適化 アルゴリズムのノイズを導入し、それによって局所最適化を回避します。 この反復的な微調整により、モデルが改善されただけでなく、その出力が人間の期待に合わせて調整されました。

Llama 2-Chat はバイナリ比較プロトコルを使用して人間の好みのデータを収集し、より定性的なアプローチへの注目すべき傾向を示しています。 このメカニズムは報酬モデルに情報を与え、会話型 AI モデルを微調整するために使用されます。

ゴースト アテンション: マルチターン ダイアログ

Meta は、マルチターン対話における Llama 2 のパフォーマンスを向上させるように設計された新機能 Ghost Attendance (GAtt) を導入しました。 これにより、進行中の会話におけるコンテキスト損失という永続的な問題が効果的に解決されます。 GAtt はアンカーのように機能し、最初の指示を後続のすべてのユーザー メッセージにリンクします。 強化学習技術と組み合わせることで、長い対話にわたって一貫性があり、関連性があり、ユーザーに合わせた応答を生成するのに役立ちます。

download.sh を使用した Meta Git リポジトリから

- メタ Web サイトにアクセスする: 案内する Meta の Llama 2 公式サイト そして「モデルをダウンロード」をクリックします

- 詳細を記入してください: 利用規約を最後まで読み、同意して続行します。

- メール確認: フォームが送信されると、Meta から Git リポジトリからモデルをダウンロードするためのリンクが記載されたメールが届きます。

- download.shを実行: Git リポジトリのクローンを作成し、

download.sh脚本。 このスクリプトは、24 時間で期限切れになるメタからの URL を使用して認証するように求めます。 モデルのサイズ (7B、13B、または 70B) も選択します。

ハグフェイスより

- 受付メールを受信する: Meta からアクセスした後、次の場所に進みます。 ハグ顔.

- 登録申請: 希望のモデルを選択し、アクセスを許可するリクエストを送信します。

- 確認: 1 ~ 2 日以内に「アクセス許可」メールが届く予定です。

- アクセストークンの生成: Hugging Face アカウントの [設定] に移動して、アクセス トークンを作成します。

Transformers 4.31 リリースは LLaMa 2 と完全に互換性があり、Hugging Face エコシステム内で多くのツールや機能が利用可能になります。 トレーニングおよび推論スクリプトから、ビットサンドバイトによる 4 ビット量子化およびパラメーター効率の良い微調整 (PEFT) まで、ツールキットは広範囲にわたります。 始めるには、最新のトランスフォーマー リリースを使用しており、Hugging Face アカウントにログインしていることを確認してください。

これは、LLaMa 2 モデル推論を実行するための合理的なガイドです。 グーグルコラボ GPU ランタイムを活用した環境:

パッケージのインストール

!pip install transformers !huggingface-cli login

必要な Python ライブラリをインポートします。

from transformers import AutoTokenizer import transformers import torch

モデルとトークナイザーを初期化する

このステップでは、使用する Llama 2 モデルを指定します。 このガイドでは、meta-llama/Llama-2-7b-chat-hf を使用します。

model = "meta-llama/Llama-2-7b-chat-hf" tokenizer = AutoTokenizer.from_pretrained(model)

パイプラインをセットアップする

特定の設定でテキストを生成するには、Hugging Face パイプラインを利用します。

pipeline = transformers.pipeline(

"text-generation",

model=model,

torch_dtype=torch.float16,

device_map="auto")

テキストシーケンスの生成

最後に、パイプラインを実行し、入力に基づいてテキスト シーケンスを生成します。

sequences = pipeline(

'Who are the key contributors to the field of artificial intelligence?\n',

do_sample=True,

top_k=10,

num_return_sequences=1,

eos_token_id=tokenizer.eos_token_id,

max_length=200)

for seq in sequences:

print(f"Result: {seq['generated_text']}")

A16Z の LLaMa 2 用 UI

Andreessen Horowitz (A16Z) は最近、Llama 2 に合わせた最先端の Streamlit ベースのチャットボット インターフェイスを発表しました。GitHub でホストされているこの UI は、セッション チャット履歴を保存し、ホストされている複数の Llama 2 API エンドポイントから選択する柔軟性も提供します。 複製する。 このユーザー中心の設計は、Llama 2 との対話を簡素化し、開発者とエンドユーザーの両方にとって理想的なツールにすることを目的としています。 これを体験してみたい方は、ライブ デモを次の URL から入手できます。 ラマ2.ai.

Llama 2: GPT モデルやその前身である Llama 1 との違いは何ですか?

さまざまなスケール

スケーラビリティが制限されている多くの言語モデルとは異なり、Llama 2 では、さまざまなパラメーターを持つモデルに対してさまざまなオプションが提供されます。 このモデルは 7 億から 70 億のパラメーターに拡張できるため、さまざまな計算ニーズに合わせたさまざまな構成が提供されます。

強化されたコンテキストの長さ

このモデルには、Llama 4 よりも 1K トークンのコンテキスト長が増加しています。これにより、より多くの情報を保持できるようになり、より複雑で広範なコンテンツを理解して生成する能力が強化されます。

グループ化されたクエリ アテンション (GQA)

このアーキテクチャでは、次の概念が使用されています。 GQA、以前のトークンペアをキャッシュすることでアテンションの計算プロセスを高速化するように設計されています。 これにより、モデルの推論のスケーラビリティが効果的に向上し、アクセシビリティが向上します。

パフォーマンスベンチマーク

LLama 2 は、パフォーマンス指標の新しい標準を設定しました。 前世代の LLama 1 を上回るパフォーマンスを発揮するだけでなく、Falcon や GPT-3.5 などの他のモデルとの大きな競争にもなります。

Llama 2-Chat の最大のモデルである 70B も、36% のインスタンスで ChatGPT を上回り、さらに 31.5% のケースでパフォーマンスに匹敵します。 ソース: 紙素材

オープンソース: コミュニティの力

Meta と Microsoft は、Llama 2 を単なる製品以上のものにするつもりです。 彼らはそれをコミュニティ主導のツールとして構想しています。 Llama 2 は、研究目的でも非営利目的でも無料でアクセスできます。 AI の機能を民主化し、新興企業、研究者、企業が AI にアクセスできるようにすることを目指しています。 オープンソース パラダイムにより、モデルの「クラウドソースによるトラブルシューティング」が可能になります。 開発者と AI 倫理学者は、ストレス テストを実施し、脆弱性を特定し、迅速なペースでソリューションを提供できます。

LLaMa 2 のライセンス条項は一般に寛容ですが、 例外 存在します。 Google など月間 700 億人以上のユーザーを誇る大企業は、その利用に Meta からの明示的な承認を必要とします。 さらに、ライセンスでは、他の言語モデルの改善を目的とした LLaMa 2 の使用が禁止されています。

Llama 2 の現在の課題

- データの一般化: Llama 2 と GPT-4 は両方とも、さまざまなタスクにわたって均一に高いパフォーマンスが低下することがあります。 これらのシナリオでは、データの品質と多様性が量と同じくらい重要です。

- モデルの透明性: AI が誤解を招く出力を生成するという過去の挫折を考慮すると、これらの複雑なモデルの背後にある意思決定の理論的根拠を探ることが最も重要です。

Code Llama – Meta の最新リリース

最近発表されたメタ コードラマ これは、パラメータ サイズが 7B ~ 34B のプログラミングに特化した大規模な言語モデルです。 に似ている ChatGPT コード インタープリター; Code Llama は開発者のワークフローを合理化し、プログラミングをよりアクセスしやすくします。 さまざまなプログラミング言語に対応しており、Python 固有のタスク用の Code Llama – Python などの特殊なバリエーションが用意されています。 このモデルは、さまざまな遅延要件を満たすためにさまざまなパフォーマンス レベルも提供します。 オープンにライセンスされている Code Llama は、継続的な改善のためにコミュニティからの意見を募っています。

まとめ:

この記事では、Hugging Face をサポートする Google Colab でテキストを生成するための Llama 2 モデルをセットアップする方法を説明しました。 Llama 2 のパフォーマンスは、自己回帰変換アーキテクチャからヒューマン フィードバックによる強化学習 (RLHF) まで、一連の高度な技術によって強化されています。 最大 70 億のパラメーターとゴースト アテンションなどの機能を備えたこのモデルは、特定の分野で現在の業界標準を上回っており、そのオープンな性質により、自然言語理解と生成 AI の新時代への道を切り開きます。