Անդերսոնի անկյունը

Մարդկային պատկերների վերականգնում և խմբագրում արհեստական բանականության միջոցով

Կալիֆոռնիայի համալսարանի Merced-ի և Adobe-ի միջև նոր համագործակցությունը հնարավորություն է տալիս առաջխաղացում գտնել ժամանակակից տեխնոլոգիաների ոլորտում։ մարդու պատկերի լրացում – մարդկանց պատկերների ծածկված կամ թաքնված մասերը «մթագնող» դարձնելու լայնորեն ուսումնասիրված խնդիրը՝ այնպիսի նպատակներով, ինչպիսիք են՝ վիրտուալ փորձարկում, անիմացիա և լուսանկարների խմբագրում։

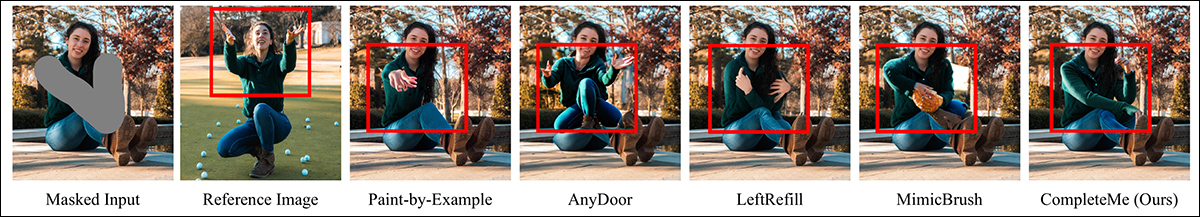

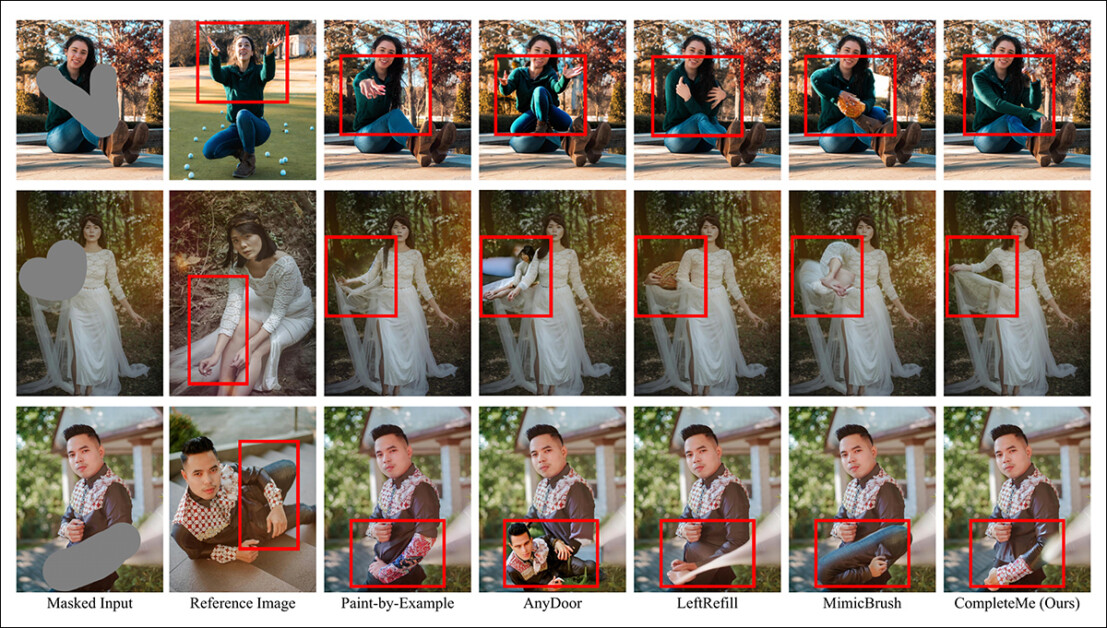

Բացի վնասված պատկերները վերականգնելուց կամ օգտատիրոջ քմահաճույքով դրանք փոփոխելուց, մարդկային պատկերի լրացման համակարգերը, ինչպիսին է CompleteMe-ն, կարող են առկա պատկերների մեջ ներմուծել նորարարական հագուստ (լրացուցիչ հղման պատկերի միջոցով, ինչպես այս երկու օրինակների միջին սյունակում): Այս օրինակները վերցված են նոր հոդվածի համար նախատեսված ընդարձակ լրացուցիչ PDF ֆայլից: Աղբյուր՝ https://liagm.github.io/CompleteMe/pdf/supp.pdf

նոր մոտեցում, վերնագրով CompleteMe: Հղումների վրա հիմնված մարդու պատկերի լրացում, օգտագործում է լրացուցիչ մուտքային պատկերներ՝ համակարգին «առաջարկելու» համար, թե ինչ բովանդակություն պետք է փոխարինի մարդկային պատկերի թաքնված կամ բացակայող հատվածին (այստեղից էլ կիրառելիությունը նորաձևության վրա հիմնված փորձարկման շրջանակների համար):

CompleteMe համակարգը կարող է հղման բովանդակությունը համապատասխանեցնել մարդու պատկերի մթագնված կամ փակված մասին։

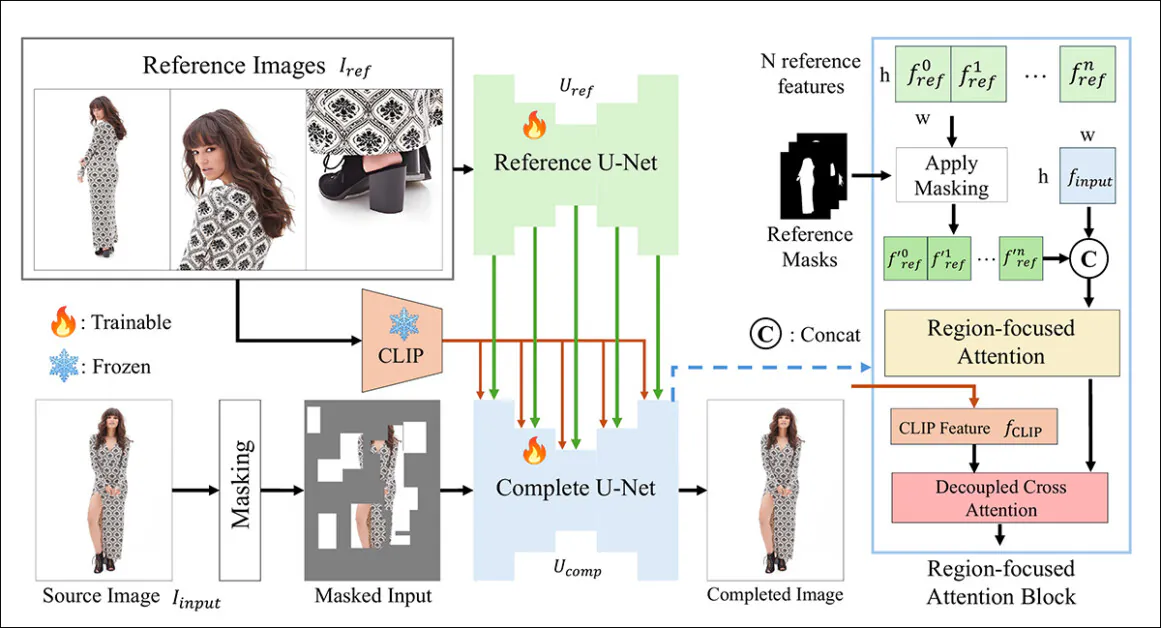

Նոր համակարգը օգտագործում է կրկնակի U-Net ճարտարապետություն և մի Տարածաշրջանային ուշադրություն (RFA) բլոկ, որը ռեսուրսները կենտրոնացնում է պատկերի վերականգնման օրինակի համապատասխան տարածքում։

Հետազոտողները նաև առաջարկում են նոր և մարտահրավեր նետող չափանիշային համակարգ, որը նախատեսված է հղումների վրա հիմնված ավարտուն առաջադրանքները գնահատելու համար (քանի որ CompleteMe-ն համակարգչային տեսողության ոլորտում առկա և շարունակական հետազոտական ուղղության մի մասն է, թեև մինչ օրս չափանիշային սխեմա չի ունեցել):

Թեստերի և լայնածավալ օգտատերերի ուսումնասիրության արդյունքում նոր մեթոդը առաջատար էր մեծ մասշտաբով և ընդհանուր առմամբ առաջատար։ Որոշ դեպքերում մրցակից մեթոդները լիովին զիջում էին հղումների վրա հիմնված մոտեցմանը։

Լրացուցիչ նյութից՝ AnyDoor մեթոդը որոշակի դժվարություններ ունի հղման պատկերը մեկնաբանելու հարցում։

Թերթում նշվում է.

Մեր չափանիշի վրա կատարված լայնածավալ փորձարկումները ցույց են տալիս, որ CompleteMe-ն գերազանցում է ժամանակակից մեթոդներին՝ թե՛ հղումների վրա հիմնված, թե՛ ոչ հղումների վրա հիմնված, քանակական չափանիշների, որակական արդյունքների և օգտատերերի ուսումնասիրությունների առումով։

«Հատկապես բարդ դիրքեր, բարդ հագուստի նախշեր և յուրահատուկ աքսեսուարներ ներառող մարտահրավերային իրավիճակներում մեր մոդելը մշտապես հասնում է գերազանց տեսողական ճշգրտության և իմաստային ներդաշնակության»։

Ցավոք, նախագծի GitHub-ի ներկայությունը չի պարունակում ո՛չ կոդ, ո՛չ էլ որևէ խոստում, և նախաձեռնությունը, որն ունի նաև համեստ նախագծի էջը, կարծես թե ձևակերպված է որպես սեփական ճարտարապետություն։

Նոր համակարգի սուբյեկտիվ աշխատանքի լրացուցիչ օրինակ նախորդ մեթոդների համեմատ: Ավելի մանրամասն՝ հոդվածի հետագա մասում:

Մեթոդ

CompleteMe շրջանակը հիմնված է հղումային U-Net-ի վրա, որը կարգավորում է օժանդակ նյութերի ինտեգրումը գործընթացում, և համախմբված U-Net-ի վրա, որը ներառում է վերջնական արդյունքի հասնելու համար գործընթացների ավելի լայն շրջանակ, ինչպես պատկերված է ստորև բերված հայեցակարգային սխեմայում։

CompleteMe-ի կոնցեպտուալ սխեման։ Աղբյուր՝ https://arxiv.org/pdf/2504.20042

Համակարգը նախ կոդավորում է դիմակավորված մուտքային պատկերը թաքնված ներկայացման մեջ։ Միաժամանակ, Reference U-Net-ը մշակում է բազմաթիվ հղման պատկերներ, որոնցից յուրաքանչյուրը ցույց է տալիս մարմնի տարբեր շրջաններ՝ մանրամասն տարածական տվյալներ ստանալու համար։ Հատկություններ.

Այս հատկանիշները անցնում են «ամբողջական» U-Net-ում ներդրված տարածաշրջանին կենտրոնացած ուշադրության բլոկով, որտեղ դրանք գտնվում են։ ընտրողաբար դիմակավորված օգտագործելով համապատասխան տարածաշրջանի դիմակներ՝ ապահովելով, որ մոդելը ուշադրություն դարձնի միայն հղման պատկերների համապատասխան տարածքներին։

Դիմակավորված գործառույթները այնուհետև ինտեգրվում են գլոբալի հետ CLIP-ստացված իմաստաբանական առանձնահատկություններ՝ անջատվածի միջոցով խաչաձև ուշադրություն, ինչը թույլ է տալիս մոդելին վերակառուցել բացակայող բովանդակությունը՝ ինչպես մանր մանրամասներով, այնպես էլ իմաստաբանական կապակցվածությամբ։

Ռեալիզմն ու կայունությունը բարձրացնելու համար մուտքային տվյալների դիմակավորման գործընթացը համատեղում է պատահական ցանցային օկլյուզիաները մարդու մարմնի ձևի դիմակների հետ, որոնցից յուրաքանչյուրը կիրառվում է հավասար հավանականությամբ, մեծացնելով մոդելի կողմից լրացվող բացակայող տարածքների բարդությունը։

Միայն հղման համար

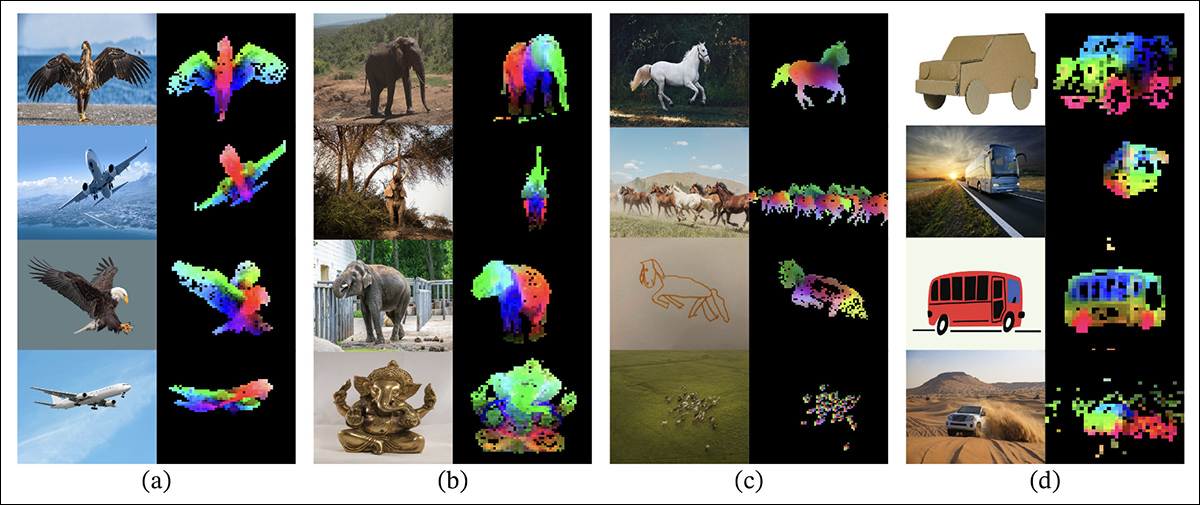

Հղումների վրա հիմնված պատկերի ներկման նախորդ մեթոդները սովորաբար հիմնված էին իմաստաբանական մակարդակ կոդավորիչներ։ Այս տեսակի նախագծերը ներառում են CLIP-ը և DINOv2, որոնք երկուսն էլ հղման պատկերներից արդյունահանում են գլոբալ առանձնահատկություններ, բայց հաճախ կորցնում են ճշգրիտ ինքնության պահպանման համար անհրաժեշտ նուրբ տարածական մանրամասները։

Նոր ուսումնասիրության համեմատական թեստերում ներառված DINOV2-ի հին մոտեցման թողարկման փաստաթղթից. Գունավոր վերադրումները ցույց են տալիս Գլխավոր բաղադրիչների վերլուծության (PCA) առաջին երեք հիմնական բաղադրիչները, որոնք կիրառվել են յուրաքանչյուր սյունակի պատկերի հատվածների վրա՝ ընդգծելով, թե ինչպես է DINOv2-ը խմբավորում նմանատիպ օբյեկտի մասերը տարբեր պատկերների վրա: Դիրքի, ոճի կամ մատուցման տարբերություններին չնայած, համապատասխան հատվածները (օրինակ՝ թևեր, վերջույթներ կամ անիվներ) հետևողականորեն համընկնում են, ինչը ցույց է տալիս մոդելի կարողությունը՝ առանց հսկողության սովորել մասերի վրա հիմնված կառուցվածքը: Աղբյուր՝ https://arxiv.org/pdf/2304.07193

CompleteMe-ն այս ասպեկտը լուծում է մասնագիտացված հղումային U-Net-ի միջոցով, որը սկզբնականացվել է հետևյալ կերպ. Կայուն դիֆուզիոն 1.5, բայց գործում է առանց դիֆուզիոն աղմուկի քայլ*.

Յուրաքանչյուր հղման պատկեր, որը ներառում է մարմնի տարբեր հատվածներ, կոդավորվում է մանրամասն թաքնված հատկանիշների մեջ այս U-Net-ի միջոցով: Գլոբալ սեմանտիկ հատկանիշները նույնպես առանձին-առանձին արդյունահանվում են CLIP-ի միջոցով, և հատկանիշների երկու հավաքածուներն էլ քեշավորվում են ուշադրության վրա հիմնված ինտեգրման ընթացքում արդյունավետ օգտագործման համար: Այսպիսով, համակարգը կարող է ճկուն կերպով ընդունել բազմաթիվ հղման մուտքային տվյալներ՝ միաժամանակ պահպանելով մանրամասն տեսքի տեղեկատվությունը:

Նվագախումբ

Համախմբված U-Net-ը կառավարում է ավարտական գործընթացի վերջնական փուլերը: Հարմարեցված է ներկման տարբերակ Stable Diffusion 1.5-ի դեպքում այն որպես մուտքային տվյալներ է ընդունում թաքնված տեսքով դիմակավորված աղբյուրի պատկերը, ինչպես նաև հղման պատկերներից վերցված մանրամասն տարածական առանձնահատկությունները և CLIP կոդավորիչի կողմից արդյունահանված գլոբալ իմաստային առանձնահատկությունները։

Այս տարբեր մուտքային տվյալները միավորվում են RFA բլոկի միջոցով, որը կարևոր դեր է խաղում մոդելի ուշադրությունը հղման նյութի ամենակարևոր ոլորտներին ուղղորդելու գործում։

Ուշադրության մեխանիզմին մուտք գործելուց առաջ հղման հատկանիշները հստակորեն դիմակավորվում են՝ կապ չունեցող հատվածները հեռացնելու համար, այնուհետև միացվում են աղբյուրի պատկերի թաքնված ներկայացման հետ՝ ապահովելով, որ ուշադրությունը ուղղված լինի հնարավորինս ճշգրիտ։

Այս ինտեգրացիան բարելավելու համար CompleteMe-ն ներառում է անջատված խաչաձև ուշադրության մեխանիզմ, որը հարմարեցված է IP-ադապտեր շրջանակ:

IP-Adapter-ը, որի մի մասը ներառված է CompleteMe-ում, լատենտային դիֆուզիոն մոդելի ճարտարապետությունների զարգացման վերջին երեք փոթորկալից տարիների ամենահաջողակ և հաճախ օգտագործվող նախագծերից մեկն է։ Աղբյուր՝ https://ip-adapter.github.io/

Սա թույլ է տալիս մոդելին մշակել տարածականորեն մանրամասն տեսողական առանձնահատկությունները և ավելի լայն իմաստաբանական համատեքստը՝ առանձին ուշադրության հոսքերի միջոցով, որոնք հետագայում համակցվում են՝ հանգեցնելով համահունչ վերակառուցման, որը, հեղինակների պնդմամբ, պահպանում է և՛ ինքնությունը, և՛ մանրուքները։

Benchmarking

Մարդկային հղման վրա հիմնված լրացման համար համապատասխան տվյալների բազայի բացակայության դեպքում, հետազոտողները առաջարկել են իրենց սեփականը: (Անանուն) չափանիշը կառուցվել է Adobe Research-ի 2023 թվականի համար մշակված WPose տվյալների բազայից ընտրված պատկերների զույգեր ընտրելով: ՅունիՀուման թ.

Adobe Research 2023 UniHuman նախագծի դիրքերի օրինակներ։ Աղբյուր՝ https://github.com/adobe-research/UniHuman?tab=readme-ov-file#data-prep

Հետազոտողները ձեռքով նկարեցին աղբյուրի դիմակներ՝ ներկման տարածքները նշելու համար, և արդյունքում ստացան 417 եռակողմ պատկերների խմբեր, որոնք կազմում են աղբյուրի պատկերը, դիմակը և հղման պատկերը։

Խմբերի երկու օրինակ, որոնք սկզբնապես վերցված են WPose հղման տվյալների բազմությունից և լայնորեն մշակվել են նոր հոդվածի հետազոտողների կողմից։

Հեղինակները օգտագործել են՝ ԼԼԱՎԱ Մեծ լեզվի մոդել (LLM)՝ սկզբնաղբյուր պատկերները նկարագրող տեքստային հուշումներ ստեղծելու համար։

Օգտագործված չափանիշները սովորականից ավելի լայն էին. սովորականից բացի Պիկ ազդանշան-աղմուկ հարաբերակցությունը (PSNR), Կառուցվածքային նմանության ինդեքս (SSIM) և Սովորել է ընկալման պատկերի կարկատան նմանություն (LPIPS, այս դեպքում՝ դիմակավորված շրջանների գնահատման համար), հետազոտողները օգտագործել են DINO-ն նմանության միավորների համար։ ԴրիմՍիմ սերնդի արդյունքների գնահատման համար; և CLIP:

Տվյալներ և թեստեր

Աշխատանքը փորձարկելու համար հեղինակները օգտագործել են ինչպես ստանդարտ Stable Diffusion V1.5 մոդելը, այնպես էլ 1.5 inpainting մոդելը: Համակարգի պատկերի կոդավորիչը օգտագործել է CLIP-ը: Տեսլական մոդելը, պրոյեկցիոն շերտերի հետ միասին՝ համեստ նեյրոնային ցանցեր, որոնք վերաձևավորում կամ հավասարեցնում են CLIP ելքերը՝ համապատասխանեցնելով մոդելի կողմից օգտագործվող ներքին առանձնահատկությունների չափսերին։

Ութ NVIDIA A30,000 պրոցեսորների վրա 100 անգամ վերապատրաստում է անցկացվել։† Գրաֆիկական պրոցեսորներ, որոնք վերահսկվում են Միջին քառակուսի սխալ (MSE) կորուստ, խմբաքանակի չափը 64-ից և ա ուսուցման մակարդակը 2 × 10-ից-5Մարզման ընթացքում տարբեր տարրեր պատահականորեն գցվել են՝ համակարգը կանխելու համար գերհարմարեցում տվյալների վրա։

Տվյալների հավաքածուն փոփոխվել է Մասերից մինչև ամբողջություն տվյալների բազմությունը, որն ինքնին հիմնված է DeepFashion-MultiModal տվյալների բազա։

Օրինակներ «Մասերից մինչև ամբողջություն» տվյալների բազմությունից, որոնք օգտագործվել են CompleteMe-ի համար ընտրված տվյալների մշակման ժամանակ։ Աղբյուր՝ https://huanngzh.github.io/Parts2Whole/

Հեղինակները նշում են.

Մեր պահանջները բավարարելու համար մենք [վերակառուցեցինք] մարզման զույգերը՝ օգտագործելով ծածկված պատկերներ՝ բազմաթիվ հղումային պատկերներով, որոնք արտացոլում են մարդու արտաքինի տարբեր կողմերը՝ իրենց կարճ տեքստային պիտակներով։

«Մեր մարզման տվյալների յուրաքանչյուր նմուշ ներառում է արտաքին տեսքի վեց տեսակ՝ մարմնի վերին հատվածի հագուստ, մարմնի ստորին հատվածի հագուստ, ամբողջ մարմնի հագուստ, մազեր կամ գլխարկներ, դեմք և կոշիկներ։ Քողարկման ռազմավարության համար մենք կիրառում ենք 50% պատահական ցանցային քողարկում 1-ից 30 անգամ, մինչդեռ մյուս 50%-ի համար օգտագործում ենք մարդու մարմնի ձևի դիմակ՝ քողարկման բարդությունը մեծացնելու համար»։

«Շինարարական աշխատանքների ավարտից հետո մենք ձեռք բերեցինք 40,000 պատկերի զույգ՝ ուսուցման համար»։

Մրցակից նախահայր ոչ հղում փորձարկված մեթոդներն էին Մեծ, խցանված մարդու պատկերի լրացում (LOHC) և պատկերի ներկման միացման և օգտագործման մոդելը BrushNet; փորձարկված հղման վրա հիմնված մոդելները Նկարել օրինակով; Ցանկացած դուռ; Ձախ լրացում, Եվ Միմիկական խոզանակ.

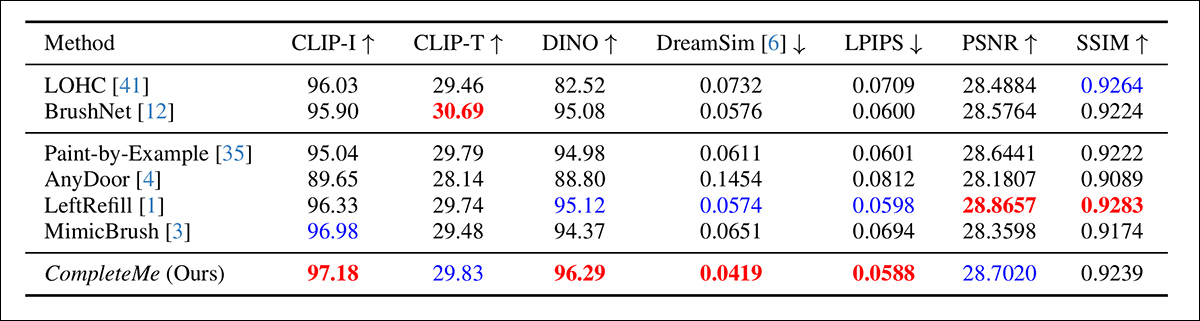

Հեղինակները սկսեցին նախկինում նշված չափանիշների քանակական համեմատությամբ.

Նախնական քանակական համեմատության արդյունքները:

Քանակական գնահատման վերաբերյալ հեղինակները նշում են, որ CompleteMe-ն ամենաբարձր միավորներն է ստանում ընկալման չափանիշների մեծ մասում, ներառյալ CLIP-I-ը, DINO-ն, DreamSim-ը և LPIPS-ը, որոնք նախատեսված են արդյունքի և հղման պատկերի միջև իմաստաբանական համապատասխանությունը և տեսքի ճշգրտությունը գրանցելու համար։

Այնուամենայնիվ, մոդելը չի գերազանցում բոլոր բազային ցուցանիշները։ Հատկանշական է, որ BrushNet-ը ամենաբարձր արդյունքներն է ցույց տալիս CLIP-T-ում, LeftRefill-ը առաջատար է SSIM-ում և PSNR-ում, իսկ MimicBrush-ը փոքր-ինչ գերազանցում է CLIP-I-ին։

Թեև CompleteMe-ն ընդհանուր առմամբ ցույց է տալիս կայուն բարձր արդյունքներ, որոշ դեպքերում կատարողականի տարբերությունները չափավոր են, և որոշակի չափանիշներ շարունակում են առաջատար լինել մրցակցող նախորդ մեթոդներով: Հնարավոր է՝ ոչ անարդարացիորեն, հեղինակները այս արդյունքները ներկայացնում են որպես CompleteMe-ի հավասարակշռված ուժի ապացույց՝ թե՛ կառուցվածքային, թե՛ ընկալողական չափանիշներով:

Ուսումնասիրության համար իրականացված որակական թեստերի նկարազարդումները չափազանց շատ են այստեղ վերարտադրելու համար, և մենք ընթերցողին հղում ենք անում ոչ միայն սկզբնաղբյուր հոդվածին, այլև ընդարձակ նյութին։ լրացուցիչ PDF, որը պարունակում է բազմաթիվ լրացուցիչ որակական օրինակներ։

Մենք ընդգծում ենք հիմնական հոդվածում ներկայացված հիմնական որակական օրինակները, ինչպես նաև հոդվածում ավելի վաղ ներկայացված լրացուցիչ պատկերների հավաքածուից վերցված լրացուցիչ դեպքերի ընտրանի։

Սկզբնական որակական արդյունքները ներկայացված են հիմնական աշխատանքում: Ավելի լավ լուծման համար խնդրում ենք դիմել սկզբնաղբյուր աշխատանքին:

Վերը նշված որակական արդյունքների վերաբերյալ հեղինակները նշում են.

Հաշվի առնելով դիմակավորված մուտքային տվյալները, այս ոչ հղման մեթոդները դիմակավորված տարածքների համար ստեղծում են հավանական բովանդակություն՝ օգտագործելով պատկերի նախնական արժեքներ կամ տեքստային հուշումներ։

«Այնուամենայնիվ, ինչպես նշված է կարմիր վանդակում, դրանք չեն կարող վերարտադրել որոշակի մանրամասներ, ինչպիսիք են դաջվածքները կամ հագուստի եզակի նախշերը, քանի որ նրանց մոտ բացակայում են նույնական տեղեկատվության վերականգնմանը նպաստող հղումային պատկերներ»։

Երկրորդ համեմատությունը, որի մի մասը ներկայացված է ստորև, կենտրոնանում է չորս հղումային մեթոդների վրա՝ Paint-by-Example, AnyDoor, LeftRefill և MimicBrush: Այստեղ տրամադրվել են միայն մեկ հղումային պատկեր և տեքստային հուշում:

Որակական համեմատություն հղումների վրա հիմնված մեթոդներով: CompleteMe-ն ստեղծում է ավելի իրատեսական լրացումներ և ավելի լավ է պահպանում հղումների պատկերի որոշակի մանրամասները: Կարմիր վանդակները ընդգծում են հատուկ հետաքրքրություն ներկայացնող ոլորտները:

Հեղինակները նշում են.

«Տրամադրելով դիմակավորված մարդու պատկեր և հղումային պատկեր, այլ մեթոդները կարող են ստեղծել հավանական բովանդակություն, բայց հաճախ չեն կարողանում ճշգրիտ պահպանել հղումից ստացված համատեքստային տեղեկատվությունը»։»

«Որոշ դեպքերում դրանք ստեղծում են անտեղի բովանդակություն կամ սխալ են քարտեզագրում համապատասխան մասերը հղման պատկերից։ Ի տարբերություն դրա, CompleteMe-ն արդյունավետորեն լրացնում է դիմակավորված տարածքը՝ ճշգրիտ պահպանելով նույնական տեղեկատվությունը և ճիշտ քարտեզագրելով մարդու մարմնի համապատասխան մասերը հղման պատկերից»։

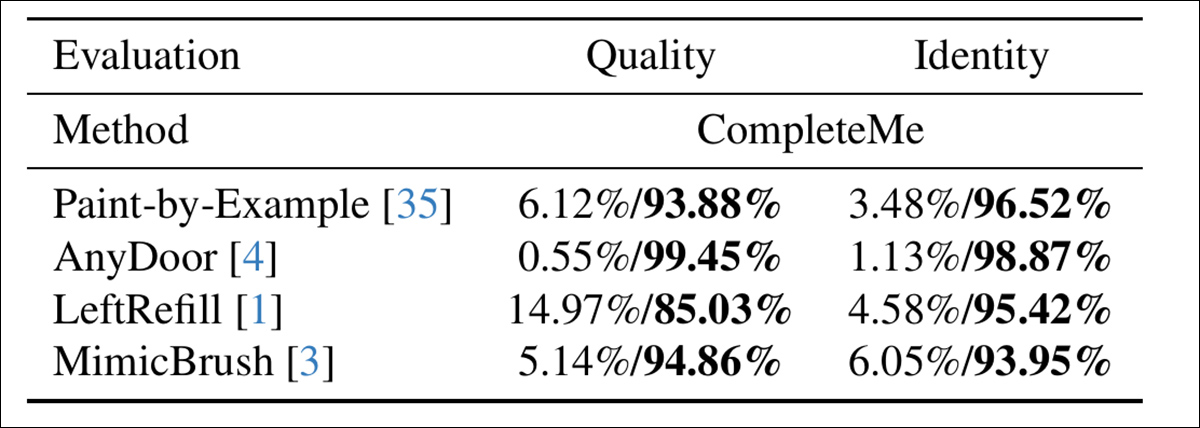

Գնահատելու համար, թե որքանով են մոդելները համապատասխանում մարդկային ընկալմանը, հեղինակները անցկացրել են օգտատիրոջ ուսումնասիրություն, որին մասնակցել են 15 մեկնաբանողներ և 2,895 նմուշային զույգեր: Յուրաքանչյուր զույգ համեմատել է CompleteMe-ի արդյունքը չորս հղումային բազային գծերից մեկի հետ՝ Paint-by-Example, AnyDoor, LeftRefill կամ MimicBrush:

Մեկնաբանողները գնահատել են յուրաքանչյուր արդյունք՝ հիմնվելով լրացված տարածքի տեսողական որակի և հղումից նույնականացման հատկանիշների պահպանման աստիճանի վրա, և այստեղ, գնահատելով ընդհանուր որակը և նույնականությունը, CompleteMe-ն ստացել է ավելի ճշգրիտ արդյունք.

Օգտագործողի ուսումնասիրության արդյունքները.

Եզրափակում

Ամեն դեպքում, այս ուսումնասիրության որակական արդյունքները խաթարվում են դրանց ծավալի պատճառով, քանի որ մանրակրկիտ ուսումնասիրությունը ցույց է տալիս, որ նոր համակարգը ամենաարդյունավետ մուտքն է նեյրոնային պատկերի խմբագրման այս համեմատաբար նեղ, բայց բուռն պահանջարկ ունեցող ոլորտում։

Այնուամենայնիվ, անհրաժեշտ է մի փոքր լրացուցիչ ուշադրություն և մեծացնել սկզբնական PDF ֆայլը՝ գնահատելու համար, թե որքան լավ է համակարգը հարմարեցնում հղման նյութը խցանված տարածքին՝ նախորդ մեթոդների համեմատ (գրեթե բոլոր դեպքերում):

Մենք խստորեն խորհուրդ ենք տալիս ընթերցողին ուշադիր ուսումնասիրել լրացուցիչ նյութում ներկայացված սկզբնապես շփոթեցնող, եթե ոչ ճնշող արդյունքների հեղեղը։

* Հետաքրքիր է նշել, թե ինչպես է այժմ խիստ հնացած V1.5 թողարկումը մնում հետազոտողների սիրելիներից մեկը՝ մասամբ ժառանգական նմանատիպ թեստավորման շնորհիվ, բայց նաև այն պատճառով, որ այն ամենաքիչ գրաքննվածն է և, հնարավոր է, ամենահեշտ մարզվողը բոլոր Stable Diffusion տարբերակներից, և չի կիսում քննադատական կաղալը FOSS Flux թողարկումներից։

† VRAM-ի տեխնիկական բնութագրերը չեն նշվում. յուրաքանչյուր քարտի համար այն կլինի կամ 40 ԳԲ, կամ 80 ԳԲ։

Առաջին անգամ հրապարակվել է երեքշաբթի, 29 ապրիլի, 2025 թ