Andersonov kut

Prema potpunoj kontroli u AI video generaciji

Video modeli temelja kao što su Hunyuan i Wan 2.1, iako moćni, ne nude korisnicima vrstu detaljne kontrole koju zahtijeva filmska i TV produkcija (osobito VFX produkcija).

U profesionalnim studijima za vizualne efekte, modeli otvorenog koda poput ovih, zajedno s ranijim modelima temeljenim na slikama (umjesto videa), kao što su Stabilna difuzija, Kandinski i Tok, obično se koriste uz niz pomoćnih alata koji prilagođavaju svoj neobrađeni izlaz kako bi zadovoljili specifične kreativne potrebe. Kad režiser kaže, "Izgleda sjajno, ali možemo li to učiniti malo više [n]?" ne možete odgovoriti govoreći da model nije dovoljno precizan za obradu takvih zahtjeva.

Umjesto toga tim AI VFX koristit će niz tradicionalnih CGI i kompozicijske tehnike, povezane s prilagođenim postupcima i tijekovima rada koji su se razvili tijekom vremena, kako bi se granice video sinteze pomaknule malo dalje.

Dakle, analogno, osnovni video model vrlo je sličan zadanoj instalaciji web preglednika poput Chromea; puno toga radi odmah po instalaciji, ali ako želite da se prilagodi vašim potrebama, a ne obrnuto, trebat će vam neki dodaci.

Control Freaks

U svijetu sinteze slike temeljene na difuziji, najvažniji je takav sustav treće strane ControlNet.

ControlNet je tehnika za dodavanje strukturirane kontrole generativnim modelima temeljenim na difuziji, dopuštajući korisnicima da vode generiranje slike ili videa s dodatnim ulazima kao što su rubne karte, karte dubine, ili informacije o pozi.

Različite ControlNetove metode omogućuju generiranje slika vođenih pozama za ljude i životinje na temelju dubine (gornji red), semantičku segmentaciju > sliku (dolje lijevo).

Umjesto da se oslanja isključivo na tekstualne upite, ControlNet uvodi zasebne grane neuronske mreže, ili adapteri, koji obrađuju ove kondicione signale, a istovremeno čuvaju generativne mogućnosti osnovnog modela.

To omogućuje fino podešene izlaze koji se bolje pridržavaju korisničkih specifikacija, što ga čini posebno korisnim u aplikacijama gdje je potrebna precizna kompozicija, struktura ili kontrola pokreta:

S pozom za vođenje mogu se dobiti različite točne vrste izlaza putem ControlNeta. Izvor: https://arxiv.org/pdf/2302.05543

Međutim, okviri ove vrste koji se temelje na adapterima djeluju izvana na skupu neuralnih procesa koji su vrlo interno fokusirani. Ovi pristupi imaju nekoliko nedostataka.

Prvo, adapteri se treniraju neovisno, što dovodi do granski sukobi kada se kombinira više adaptera, što može dovesti do degradirane kvalitete proizvodnje.

Drugo, uvode redundantnost parametara, zahtijevajući dodatno računanje i memoriju za svaki adapter, čineći skaliranje neučinkovitim.

Treće, unatoč svojoj fleksibilnosti, adapteri često proizvode neoptimalno rezultati u usporedbi s modelima koji su potpuno fino podešen za stvaranje više uvjeta. Ovi problemi čine metode temeljene na adapteru manje učinkovitima za zadatke koji zahtijevaju besprijekornu integraciju višestrukih kontrolnih signala.

Idealno bi bilo osposobiti kapacitete ControlNeta nativno u model, na modularan način koji bi mogao prihvatiti kasnije i dugo očekivane očite inovacije kao što je istovremena video/audio generacija ili izvorne mogućnosti sinkronizacije usana (za vanjski audio).

U ovom trenutku, svaki dodatni dio funkcionalnosti predstavlja ili postprodukcijski zadatak ili ne-izvorni postupak koji se mora snalaziti s čvrsto vezanim i osjetljivim težinama bilo kojeg temeljnog modela na kojem radi.

FullDiT

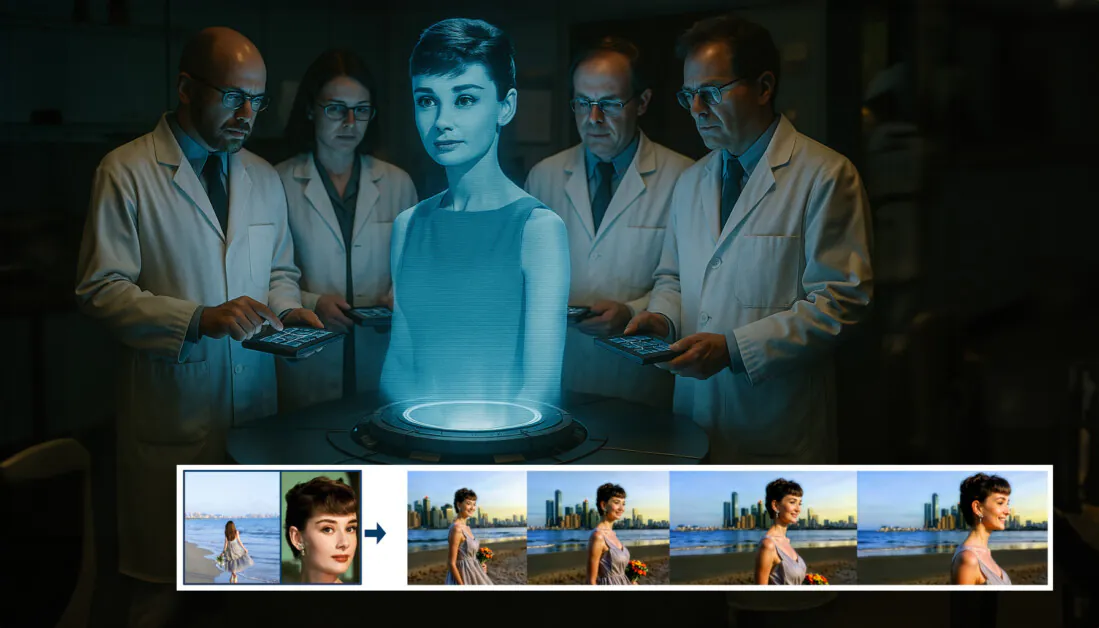

U ovom zastoju dolazi nova ponuda iz Kine, koja postavlja sustav u kojem se mjere u stilu ControlNeta peku izravno u generativni video model tijekom treninga, umjesto da budu prebačene na naknadnu misao.

Iz novog rada: pristup FullDiT može uključiti nametanje identiteta, dubinu i pokret kamere u nativnu generaciju i može prizvati bilo koju kombinaciju toga odjednom. Izvor: https://arxiv.org/pdf/2503.19907

Pod nazivom FullDiT, novi pristup spaja višezadaćne uvjete kao što su prijenos identiteta, dubinsko mapiranje i kretanje kamere u integrirani dio obučenog generativnog video modela, za koji su autori proizveli prototip obučenog modela i popratne videoisječke na mjesto projekta.

U donjem primjeru vidimo generacije koje uključuju kretanje kamere, informacije o identitetu i tekstualne informacije (tj. korisničke tekstualne upute za usmjeravanje):

Kliknite za reprodukciju. Primjeri nametanja korisnika u stilu ControlNet-a samo s nativnim obučenim modelom temelja. Izvor: https://fulldit.github.io/

Treba napomenuti da autori ne predlažu svoj eksperimentalni obučeni model kao funkcionalni temeljni model, već kao dokaz koncepta za izvorne modele tekst-u-video (T2V) i slike-u-video (I2V) koji korisnicima nude veću kontrolu nego samo upit za sliku ili tekstualni upit.

Budući da još ne postoje slični modeli ove vrste, istraživači su stvorili novu referentnu vrijednost pod nazivom FullBench, za procjenu višezadaćnih videozapisa i tvrde da imaju najsuvremeniju izvedbu u sličnim testovima koje su osmislili u odnosu na prethodne pristupe. Međutim, budući da su FullBench dizajnirali sami autori, njegova objektivnost nije ispitana, a skup podataka od 1,400 slučajeva mogao bi biti previše ograničen za šire zaključke.

Možda je najzanimljiviji aspekt arhitekture koji ovaj dokument iznosi njezin potencijal da uključi nove vrste kontrole. Autori navode:

„U ovom radu istražujemo samo uvjete upravljanja kamerom, identitete i informacije o dubini. Nismo dalje istraživali druge uvjete i modalitete poput zvuka, govora, oblaka točaka, okvira za ograničavanje objekata, optičkog toka itd. Iako dizajn FullDiT-a može besprijekorno integrirati druge modalitete uz minimalne izmjene arhitekture, kako brzo i isplativo prilagoditi postojeće modele novim uvjetima i modalitetima i dalje je važno pitanje koje zahtijeva daljnje istraživanje.“

Iako istraživači predstavljaju FullDiT kao korak naprijed u stvaranju višezadaćnih videozapisa, treba uzeti u obzir da se ovaj novi rad temelji na postojećim arhitekturama, a ne da uvodi fundamentalno novu paradigmu.

Ipak, FullDiT trenutno stoji samostalno (koliko je meni poznato) kao model video temelja s 'tvrdo kodiranim' mogućnostima u stilu ControlNeta - i dobro je vidjeti da predložena arhitektura može prihvatiti i kasnije inovacije.

Kliknite za reprodukciju. Primjeri pokreta kamera kojima upravlja korisnik, s mjesta projekta.

The novom papiru naslovljen je FullDiT: Multi-Task Video Generative Foundation Model s punom pažnjom, a dolazi od devet istraživača iz Kuaishou Technology i Kineskog sveučilišta u Hong Kongu. Stranica projekta je ovdje a novi referentni podaci su u Hugging Face.

način

Autori tvrde da FullDiT-ov objedinjeni mehanizam pažnje omogućuje snažnije međumodalno predstavljanje učenja hvatanjem i prostornih i vremenskih odnosa u različitim uvjetima:

Prema novom dokumentu, FullDiT integrira više ulaznih uvjeta kroz potpunu samopažnju, pretvarajući ih u jedinstveni niz. Nasuprot tome, modeli koji se temelje na adapteru (krajnje lijevo gore) koriste zasebne module za svaki ulaz, što dovodi do redundancije, sukoba i slabije izvedbe.

Za razliku od postavki koje se temelje na adapteru i koje zasebno obrađuju svaki ulazni tok, ova struktura zajedničke pažnje izbjegava sukobe grana i smanjuje opterećenje parametara. Oni također tvrde da se arhitektura može skalirati na nove tipove unosa bez većeg redizajna – i da shema modela pokazuje znakove generalizacije na kombinacije stanja koje se ne vide tijekom treninga, kao što je povezivanje pokreta kamere s identitetom lika.

Kliknite za reprodukciju. Primjeri generiranja identiteta s mjesta projekta.

U arhitekturi FullDiT-a, svi uvjetovani ulazi – kao što su tekst, kretanje kamere, identitet i dubina – prvo se pretvaraju u objedinjeni format tokena. Ti se tokeni zatim spajaju u jedan dugi niz, koji se obrađuje kroz hrpu transformator slojeva koristeći punu samopažnju. Ovaj pristup slijedi prethodne radove kao što su Plan Open-Sora i Film Gen.

Ovaj dizajn omogućuje modelu da zajedno uči vremenske i prostorne odnose u svim uvjetima. Svaki transformatorski blok radi u cijelom nizu, omogućujući dinamičke interakcije između modaliteta bez oslanjanja na zasebne module za svaki ulaz – i, kao što smo napomenuli, arhitektura je dizajnirana da bude proširiva, što čini mnogo lakšim uključivanje dodatnih kontrolnih signala u budućnosti, bez većih strukturnih promjena.

Moć trojstva

FullDiT pretvara svaki kontrolni signal u standardizirani format tokena tako da se svi uvjeti mogu obraditi zajedno u jedinstvenom okviru pažnje. Za kretanje kamere, model kodira niz vanjskih parametara – kao što su položaj i orijentacija – za svaki kadar. Ovi parametri imaju vremenski žig i projicirani u vektore za ugrađivanje koji odražavaju vremensku prirodu signala.

Podaci o identitetu tretiraju se drugačije, budući da su inherentno prostorni, a ne vremenski. Model koristi mape identiteta koje pokazuju koji su likovi prisutni u kojim dijelovima svakog okvira. Ove se karte dijele na zakrpe, sa svakom zakrpom projiciranom u ugradnja koji hvata znakove prostornog identiteta, dopuštajući modelu da poveže određene regije okvira s određenim entitetima.

Dubina je prostorno-vremenski signal, a model njime upravlja dijeleći dubinske videozapise u 3D dijelove koji obuhvaćaju prostor i vrijeme. Te se zakrpe zatim ugrađuju na način koji čuva njihovu strukturu kroz okvire.

Nakon što su ugrađeni, svi ovi tokeni uvjeta (kamera, identitet i dubina) spojeni su u jednu dugu sekvencu, dopuštajući FullDiT-u da ih zajedno obradi korištenjem pune samopažnja. Ova zajednička reprezentacija omogućuje modelu učenje interakcija između modaliteta i kroz vrijeme bez oslanjanja na izolirane tokove obrade.

Podaci i testovi

FullDiT-ov pristup treniranju oslanjao se na selektivno označene skupove podataka prilagođene svakoj vrsti uvjetovanja, umjesto da zahtijeva istovremenu prisutnost svih uvjeta.

Što se tiče tekstualnih uvjeta, inicijativa slijedi strukturirani pristup titlovima naveden u MiraData Projekt.

Zbirka video zapisa i cjevovod za napomene iz projekta MiraData. Izvor: https://arxiv.org/pdf/2407.06358

Za kretanje kamere, Nekretnine10K skup podataka bio je glavni izvor podataka, zbog visokokvalitetnih priopćenja o parametrima kamere.

Međutim, autori su primijetili da obuka isključivo na skupovima podataka kamere za statične scene kao što je RealEstate10K smanjuje dinamičke pokrete objekata i ljudi u generiranim videozapisima. Kako bi se tome suprotstavili, proveli su dodatna fina podešavanja koristeći interne skupove podataka koji su uključivali dinamičnije pokrete kamere.

Bilješke o identitetu generirane su pomoću cjevovoda razvijenog za ConceptMaster projekt koji je omogućio učinkovito filtriranje i ekstrakciju detaljnih informacija o identitetu.

Okvir ConceptMaster dizajniran je za rješavanje problema razdvajanja identiteta uz očuvanje vjernosti koncepta u prilagođenim videozapisima. Izvor: https://arxiv.org/pdf/2501.04698

Bilješke o dubini dobivene su od Panda-70M korištenje skupa podataka Dubina Bilo što.

Optimizacija putem naručivanja podataka

Autori su također implementirali progresivni raspored treninga, uvodeći zahtjevnije uvjete ranije u treningu kako bi se osiguralo da model dobije robusne prikaze prije dodavanja jednostavnijih zadataka. Nalog za obuku pošao je iz tekst do soba uvjeti, dakle identiteti, i konačno dubina, s lakšim zadacima koji se uglavnom uvode kasnije i s manje primjera.

Autori ističu vrijednost raspoređivanja radnog opterećenja na ovaj način:

'Tijekom faze prije obuke primijetili smo da zahtjevniji zadaci zahtijevaju produljeno vrijeme obuke i da bi ih trebalo uvesti ranije u procesu učenja. Ovi izazovni zadaci uključuju složene distribucije podataka koji se značajno razlikuju od izlaznog videa, zahtijevajući da model posjeduje dovoljan kapacitet da ih točno uhvati i predstavi.

'Suprotno tome, prerano uvođenje lakših zadataka može dovesti do toga da model prvo da prioritet njihovom učenju, budući da oni pružaju neposrednije povratne informacije o optimizaciji, što ometa konvergenciju zahtjevnijih zadataka.'

Ilustracija redoslijeda obuke podataka koji su prihvatili istraživači, s crvenom bojom koja označava veću količinu podataka.

Nakon početne predvježbe, završna faza finog podešavanja dodatno je poboljšala model kako bi se poboljšala vizualna kvaliteta i dinamika pokreta. Nakon toga obuka je slijedila onu standardnog okvira difuzije*: šum dodan video latentima i model naučiti ga predvidjeti i ukloniti, koristeći ugrađene tokene uvjeta kao smjernice.

Kako bi učinkovito procijenili FullDiT i pružili poštenu usporedbu s postojećim metodama, te u nedostatku dostupnosti bilo kojeg drugog odgovarajućeg mjerila, autori su predstavili FullBench, odabrani benchmark paket koji se sastoji od 1,400 različitih testnih slučajeva.

Instanca istraživača podataka za novu referentnu vrijednost FullBench. Izvor: https://huggingface.co/datasets/KwaiVGI/FullBench

Svaka podatkovna točka pružila je temeljne bilješke istine za različite kondicione signale, uključujući kretanje kamere, identiteti dubina.

Metrika

Autori su procijenili FullDiT pomoću deset metrika koje pokrivaju pet glavnih aspekata performansi: poravnanje teksta, kontrola kamere, sličnost identiteta, točnost dubine i opća kvaliteta videa.

Poravnanje teksta izmjereno je pomoću CLIP sličnost, dok je kontrola kamere ocijenjena kroz greška rotacije (RotErr), greška u prijevodu (TransErr), A dosljednost pokreta kamere (CamMC), slijedeći pristup od CamI2V (u CameraCtrl projekt).

Sličnost identiteta procijenjena je pomoću DINO-I i KLIP-I, a točnost kontrole dubine kvantificirana je pomoću Srednja apsolutna greška (MAE).

Kvaliteta videa ocjenjivana je s tri metrike iz MiraData: sličnost CLIP na razini okvira za glatkoću; udaljenost kretanja temeljena na optičkom protoku za dinamiku; i LAION-Estetske partiture za vizualnu privlačnost.

Trening

Autori su trenirali FullDiT koristeći interni (neotkriveni) model difuzije teksta u video koji sadrži otprilike milijardu parametara. Namjerno su odabrali skromnu veličinu parametra kako bi održali pravednost u usporedbama s prethodnim metodama i osigurali ponovljivost.

Budući da se videozapisi za obuku razlikuju po duljini i razlučivosti, autori su svaki standardizirali serija promjenom veličine i popunjavanjem videozapisa na uobičajenu rezoluciju, uzorkovanjem 77 okvira po nizu i korištenjem primijenjene pažnje i maske za gubitak za optimizaciju učinkovitosti treninga.

The Adam optimizator je korišten na a stopa učenja od 1 × 10-5 preko klastera od 64 NVIDIA H800 GPU-a, za ukupno 5,120 GB VRAM-a (uzmite u obzir da u zajednicama entuzijasta sinteze, 24GB na RTX 3090 još uvijek se smatra luksuznim standardom).

Model je treniran za oko 32,000 koraka, uključujući do tri identiteta po videozapisu, zajedno s 20 okvira uvjeta kamere i 21 okvirom uvjeta dubine, oba ravnomjerno uzorkovana od ukupno 77 okvira.

Za zaključak, model je generirao videozapise u razlučivosti od 384×672 piksela (otprilike pet sekundi pri 15 sličica u sekundi) s 50 koraka difuzijskog zaključivanja i ljestvicom smjernica od pet bez klasifikatora.

Prethodne metode

Za procjenu kamera-video, autori su usporedili FullDiT s MotionCtrl, CameraCtrl i CamI2V, sa svim modelima obučenim korištenjem skupa podataka RealEstate10k kako bi se osigurala dosljednost i pravednost.

U generaciji uvjetovanoj identitetom, budući da nisu bili dostupni usporedivi modeli s više identiteta otvorenog koda, model je uspoređen s modelom ConceptMaster s 1B parametrom, koristeći iste podatke o obuci i arhitekturu.

Za zadatke od dubine do videa, usporedbe su napravljene s Ctrl-adapter i ControlVideo.

Kvantitativni rezultati za generiranje videozapisa s jednim zadatkom. FullDiT je uspoređen s MotionCtrl-om, CameraCtrl-om i CamI2V za generiranje s kamere na video; ConceptMaster (verzija s parametrima 1B) za identitet-video; i Ctrl-Adapter i ControlVideo za dubinski video. Svi su modeli procijenjeni pomoću svojih zadanih postavki. Radi dosljednosti, 16 okvira ravnomjerno je uzorkovano iz svake metode, što odgovara duljini izlaza prethodnih modela.

Rezultati pokazuju da je FullDiT, usprkos istovremenom rukovanju s više signala za kondicioniranje, postigao najsuvremeniju izvedbu u metrici koja se odnosi na kontrolu teksta, kretanja kamere, identiteta i dubine.

U ukupnim pokazateljima kvalitete, sustav je općenito nadmašio druge metode, iako je njegova glatkoća bila nešto niža od ConceptMasterove. Ovdje autori komentiraju:

'Glatkoća FullDiT-a nešto je niža od one ConceptMaster-a jer se izračun glatkoće temelji na sličnosti CLIP-a između susjednih okvira. Budući da FullDiT pokazuje znatno veću dinamiku u usporedbi s ConceptMasterom, na metriku glatkoće utječu velike varijacije između susjednih okvira.

„Što se tiče estetske ocjene, budući da model ocjenjivanja favorizira slike u stilu slikanja, a ControlVideo obično generira videozapise u tom stilu, postiže se visoka ocjena u estetici.“

Što se tiče kvalitativne usporedbe, možda bi bilo bolje pozvati se na uzorke videozapisa na stranici projekta FullDiT, budući da su PDF primjeri neizbježno statični (i također preveliki da bi se ovdje u potpunosti reproducirali).

Prvi odjeljak kvalitativnih rezultata u PDF-u. Molimo pogledajte izvorni dokument za dodatne primjere, koji su preopširni da bi se ovdje reproducirali.

Autori komentiraju:

'FullDiT pokazuje vrhunsko očuvanje identiteta i generira videozapise s boljom dinamikom i vizualnom kvalitetom u usporedbi s [ConceptMasterom]. Budući da su ConceptMaster i FullDiT obučeni na istoj okosnici, to naglašava učinkovitost ubrizgavanja uvjeta s punom pažnjom.

'...[Ostali] rezultati pokazuju superiorniju upravljivost i kvalitetu generiranja FullDiT-a u usporedbi s postojećim metodama dubina-u-video i kamera-u-video.'

Dio PDF primjera FullDiT-ovog izlaza s više signala. Za dodatne primjere pogledajte izvorni rad i stranicu projekta.

Zaključak

Iako je FullDiT uzbudljiv pohod na potpuniji tip video temeljnog modela, treba se zapitati hoće li potražnja za instrumentalijama u stilu ControlNet-a ikada opravdati implementaciju takvih značajki u velikom obimu, barem za FOSS projekte, koji bi se borili da dobiju ogromnu količinu potrebne GPU procesorske snage, bez komercijalne podrške.

Primarni izazov je da korištenje sustava kao što su Depth i Pose općenito zahtijeva netrivijalno poznavanje relativno složenih korisničkih sučelja kao što je ComfyUI. Stoga se čini da će funkcionalni FOSS model ove vrste najvjerojatnije razviti kadar manjih VFX tvrtki kojima nedostaje novca (ili volje, s obzirom na to da takvi sustavi brzo zastarijevaju nadogradnjama modela) za pripremu i obuku takvog modela iza zatvorenih vrata.

S druge strane, API-jem vođeni 'rent-an-AI' sustavi mogu biti dobro motivirani za razvoj jednostavnijih i korisniku prilagođenijih metoda interpretacije za modele u koje su izravno obučeni pomoćni upravljački sustavi.

Kliknite za reprodukciju. Kontrole dubine i teksta nametnute generiranju videozapisa pomoću FullDiT-a.

* Autori ne navode nijedan poznati osnovni model (tj. SDXL, itd.)

Prvi put objavljeno u četvrtak, 27. ožujka 2025