Umjetna inteligencija

Odvajanje 'spojenih' ljudi u računalnom vidu

Novi rad Inovacijskog centra Hyundai Motor Group u Singapuru nudi metodu za odvajanje 'stopljenih' ljudi u računalnom vidu – onih slučajeva u kojima je okvir za prepoznavanje objekata pronašao čovjeka koji je na neki način 'preblizu' drugom čovjeku (kao što kao radnje 'grljenja' ili poze 'stojeći iza') i nije u stanju razdvojiti dvije predstavljene osobe, brkajući ih za jednu osobu ili entitet.

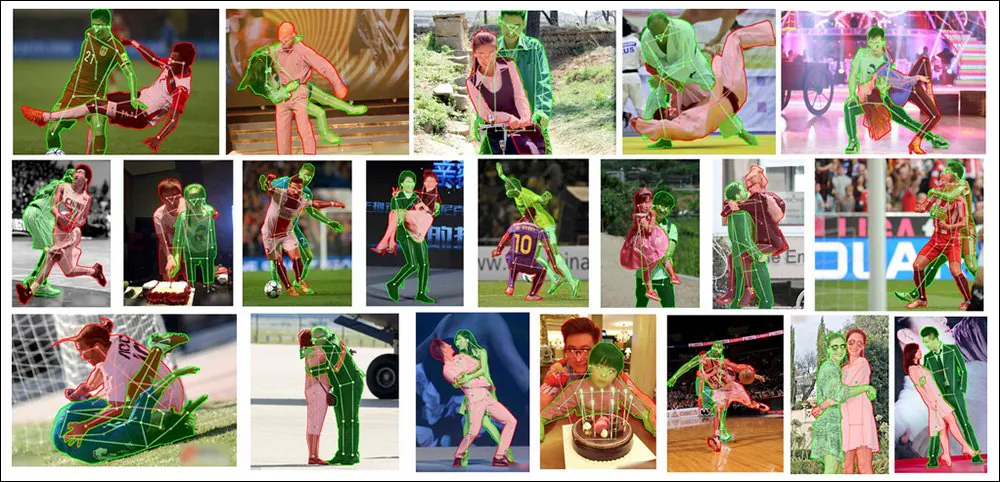

Dva postaju jedno, ali to nije dobra stvar u semantičkoj segmentaciji. Ovdje vidimo kako novi sustav časopisa postiže vrhunske rezultate u individuaciji isprepletenih ljudi u složenim i izazovnim slikama. Izvor: https://arxiv.org/pdf/2210.03686.pdf

Ovo je primjetan problem koji je posljednjih godina dobio veliku pozornost u istraživačkoj zajednici. Rješavajući to bez očitog, ali obično nepriuštivog troška hiperrazmjera, prilagođeno označavanje vođeno ljudima moglo bi na kraju omogućiti poboljšanja u ljudskoj individualizaciji u sustavima pretvaranja teksta u sliku kao što su Stabilna difuzija, koji često 'stope' ljude zajedno gdje tražena poza zahtijeva da više osoba bude u neposrednoj blizini jedna drugoj.

Prihvatite užas – modeli pretvaranja teksta u sliku kao što su DALL-E 2 i Stable Diffusion (oba prikazana gore) teško predstavljaju ljude koji su vrlo blizu jedni drugima.

Iako generativni modeli kao što su DALL-E 2 i Stable Diffusion (koliko je ičijem saznanju, u slučaju DALL-E 2 zatvorenog koda) trenutno ionako ne koriste semantičku segmentaciju ili prepoznavanje objekata, ovi groteskni ljudski portmanteaui ne bi mogli trenutno se mogu izliječiti primjenom takvih naprednih metoda – jer najsuvremenije biblioteke i resursi za prepoznavanje objekata nisu puno bolji u odvajanju ljudi od CLIPtijekovi rada modela latentne difuzije.

Kako bi se riješio ovaj problem, novom papiru – pod naslovom Ljudi ne moraju označavati više ljudi: okluzija Kopiraj i zalijepi za segmentaciju instance okluzije– prilagođava i poboljšava nedavni pristup 'izreži i zalijepi' polusintetičkim podacima kako bi se postigla nova SOTA prednost u zadatku, čak i u odnosu na najizazovniji izvorni materijal:

Nova metodologija Occlusion Copy & Paste trenutačno je vodeća na ovom području čak i u odnosu na prijašnje okvire i pristupe koji rješavaju izazov na razrađene i posvećenije načine, kao što je posebno modeliranje za okluziju.

Prekini to!

Izmijenjena metoda – pod naslovom Okluzija Kopiraj i zalijepi – potječe iz 2021 Jednostavno Copy-Paste rad, predvođen Googleovim istraživanjem, koji je sugerirao da bi preklapanje ekstrahiranih objekata i ljudi između različitih izvornih slika za obuku moglo poboljšati sposobnost sustava za prepoznavanje slika da diskretizira svaku instancu pronađenu na slici:

U dokumentu pod vodstvom Googleovog istraživanja iz 2021. 'Jednostavno kopiranje-lijepljenje snažna je metoda povećanja podataka za segmentaciju instance', vidimo da elementi s jedne fotografije 'migriraju' na druge fotografije, s ciljem uvježbavanja boljeg modela prepoznavanja slike. Izvor: https://arxiv.org/pdf/2012.07177.pdf

Nova verzija dodaje ograničenja i parametre u ovo automatizirano i algoritamsko 'ponovno lijepljenje', analogizirajući proces u 'košaru' slika punu potencijalnih kandidata za 'prijenos' na druge slike, na temelju nekoliko ključnih čimbenika.

Konceptualni tijek rada za OC&P.

Kontroliranje elemenata

Ti ograničavajući čimbenici uključuju vjerojatnost pojavljivanja izreži i zalijepi, što osigurava da se proces ne događa samo cijelo vrijeme, čime bi se postigao učinak 'zasićenja' koji bi potkopao povećanje podataka; the broj slika koje će košarica imati u bilo kojem trenutku, gdje veći broj 'segmenata' može poboljšati raznolikost instanci, ali povećati vrijeme predobrade; i domet, koji određuje broj slika koje će biti zalijepljene u sliku 'domaćina'.

Glede potonjeg, napominje list 'Potrebno nam je dovoljno okluzije da se dogodi, ali ne previše jer bi mogle previše zatrpati sliku, što može biti štetno za učenje.'

Druge dvije inovacije za OC&P su ciljano lijepljenje i lijepljenje proširene instance.

Ciljano lijepljenje osigurava da se odgovarajuća slika nalazi blizu postojeće instance na ciljanoj slici. U prethodnom pristupu, iz prethodnog rada, novi element bio je samo ograničen unutar granica slike, bez ikakvog razmatranja konteksta.

Iako je ovo 'lijepljenje', s ciljanim lijepljenjem, vidljivo ljudskom oku, i OC&P i njegov prethodnik otkrili su da povećana vizualna autentičnost nije nužno važna, te bi čak mogla biti prepreka (pogledajte 'Reality Bites' u nastavku).

Prošireno lijepljenje instanci, s druge strane, osigurava da zalijepljene instance ne pokazuju 'različit izgled' koji bi mogao biti klasificiran od strane sustava na neki način, što bi moglo dovesti do isključenja ili 'posebnog tretmana' koji može ometati generalizaciju i primjenjivost . Povećano lijepljenje modulira vizualne čimbenike kao što su svjetlina i oštrina, skaliranje i rotacija te zasićenost – između ostalih čimbenika.

Iz dopunskih materijala za novi rad: dodavanje OC&P postojećim okvirima prepoznavanja prilično je trivijalno i rezultira superiornom individualizacijom ljudi u vrlo bliskim granicama. Izvor: https://arxiv.org/src/2210.03686v1/anc/OcclusionCopyPaste_Supplementary.pdf

Dodatno, OC&P regulira a minimalna veličina za bilo koju zalijepljenu instancu. Na primjer, može biti moguće izvući sliku jedne osobe iz scene ogromne gomile, koja se može zalijepiti u drugu sliku – ali u tom slučaju mali broj uključenih piksela vjerojatno ne bi pomogao prepoznavanju. Stoga sustav primjenjuje minimalnu ljestvicu na temelju omjera izjednačene duljine stranice za ciljnu sliku.

Nadalje, OC&P uvodi lijepljenje s obzirom na mjerilo, gdje, osim traženja sličnih subjekata kao i subjekt za lijepljenje, uzima u obzir veličinu graničnih okvira na ciljnoj slici. Međutim, to ne dovodi do složenih slika koje bi ljudi smatrali uvjerljivima ili realističnima (vidi sliku u nastavku), već okuplja semantički odgovarajuće elemente blizu jedan drugome na načine koji su korisni tijekom obuke.

Reality Bites

I prijašnji rad na kojem se temelji OC&P, i trenutna implementacija, pridaju nisku premiju autentičnosti ili 'fotorealnosti' bilo koje konačne 'montirane' slike. Iako je važno da se konačna montaža ne spusti u potpunosti dadaizam (inače se implementacije uvježbanih sustava u stvarnom svijetu nikada ne bi mogle nadati da će naići na elemente u takvim scenama na kojima su uvježbani), obje su inicijative otkrile da značajno povećanje 'vizualne vjerodostojnosti' ne samo da povećava vrijeme predobrade, već da će takva 'poboljšanja realizma' zapravo biti kontraproduktivna.

Iz dopunskog materijala novog rada: primjeri proširenih slika s 'nasumičnim stapanjem'. Iako te scene mogu izgledati halucinogeno za osobu, svejedno imaju slične teme zajedno; iako su okluzije fantastične ljudskom oku, priroda potencijalne okluzije ne može se unaprijed znati i nemoguće ju je trenirati – stoga su takvi bizarni 'odsjeci' oblika dovoljni da natjeraju trenirani sustav da traži otkriti i prepoznati djelomične ciljane subjekte, bez potrebe za razvijanjem razrađenih metodologija u stilu Photoshopa kako bi scene bile uvjerljivije.

Podaci i testovi

Za fazu testiranja, sustav je treniran na osoba klasa od MS COCO skup podataka koji sadrži 262,465 64,115 primjera ljudi na XNUMX XNUMX slika. Međutim, kako bismo dobili kvalitetnije maske nego što ih ima MS COCO, primile su i slike LVIS napomene maske.

Objavljen 2019., LVIS, iz istraživanja Facebooka, opsežan je skup podataka za segmentaciju velikih instanci rječnika. Izvor: https://arxiv.org/pdf/1908.03195.pdf

Kako bi procijenili koliko dobro se prošireni sustav može boriti s velikim brojem zaklonjenih ljudskih slika, istraživači su postavili OC&P nasuprot OCHuman (Occluded Human) referentna vrijednost.

Primjeri iz skupa podataka OCHuman, predstavljenog kao potpora projektu otkrivanja Pose2Seg 2018. Ova inicijativa nastojala je izvesti poboljšanu semantičku segmentaciju ljudi korištenjem njihovog stava i poze kao semantičkog graničnika za piksele koji predstavljaju njihova tijela. Izvor: https://github.com/liruilong940607/OCHumanApi

Budući da referentna vrijednost OCHuman nije iscrpno označena, istraživači novog rada stvorili su podskup samo onih primjera koji su u potpunosti označeni, pod nazivom OCHumanFL. Time je smanjen broj osoba instance do 2,240 u 1,113 slika za provjeru valjanosti i 1,923 instance u 951 stvarnoj slici korištenoj za testiranje. Testirani su i izvorni i novo odabrani skupovi, koristeći srednju prosječnu preciznost (mAP) kao temeljnu metriku.

Za dosljednost, arhitektura je formirana od Maska R-CNN s ResNet-50 okosnicom i a značajka piramida mreže, pri čemu potonji pruža prihvatljiv kompromis između točnosti i brzine obuke.

Istraživači su primijetili štetan učinak uzvodno ImageNet utjecaja u sličnim situacijama, cijeli je sustav obučen od nule na 4 NVIDIA V100 GPU-a, tijekom 75 epoha, slijedeći parametre inicijalizacije Facebookovog izdanja 2021. detektor 2.

Rezultati

Uz gore navedene rezultate, osnovni rezultati u odnosu na MMDetekcija (i njegova tri pridružena modela) za testove pokazali su jasno vodstvo OC&P-a u njegovoj sposobnosti da izabere ljudska bića iz zamršenih poza.

Osim što nadmašuje PoSeg i Pose2Seg, možda je jedno od najistaknutijih postignuća rada to što se sustav može prilično generički primijeniti na postojeće okvire, uključujući one koji su mu suprotstavljeni u ispitivanjima (pogledajte usporedbe s/bez u prvom okviru s rezultatima, blizu početka članak).

Rad zaključuje:

'Ključna prednost našeg pristupa je ta što se lako primjenjuje s bilo kojim modelom ili drugim poboljšanjima usmjerenim na model. S obzirom na brzinu kojom se polje dubokog učenja kreće, svačija je prednost imati pristupe koji su visoko interoperabilni sa svim drugim aspektima obuke. Ostavljamo budući rad na integraciji ovoga s poboljšanjima usmjerenim na model kako bismo učinkovito riješili segmentaciju instanci okludirane osobe.'

Potencijal za poboljšanje sinteze teksta u sliku

Glavni autor Evan Ling primijetio je, u e-poruci*, da je glavna prednost OC&P-a to što može zadržati originalne oznake maski i dobiti novu vrijednost od njih 'besplatno' u novom kontekstu – tj. slike koje su bile zalijepljen u.

Iako se čini da je semantička segmentacija ljudi usko povezana s poteškoćama koje modeli poput Stabilne difuzije imaju u individualiziranju ljudi (umjesto da ih 'pomiješaju', kao što se često događa), svaki utjecaj koji bi kultura semantičkog označavanja mogla imati na čovjeka iz noćne more renderira da SD i DALL-E 2 često izlaze vrlo, vrlo daleko uzvodno.

Milijarde LAION 5B slike podskupa koje popunjavaju generativnu moć Stable Diffusion ne sadrže oznake na razini objekta kao što su granični okviri i maske instance, čak i ako je CLIP arhitektura koja sastavlja prikaze od slika i sadržaja baze podataka možda imala koristi od takve instancije u nekom trenutku; radije, LAION slike su označene kao 'slobodne', budući da su njihove oznake izvedene iz metapodataka i naslova o okolišu, itd., koji su bili povezani sa slikama kada su bile preuzete s weba u skup podataka.

'Ali to na stranu', rekao nam je Ling. 'neka vrsta proširenja slična našem OC&P može se koristiti tijekom obuke generativnog modela teksta u sliku. Ali mislim da bi realističnost proširene slike treninga mogla postati problem.

'U našem radu pokazujemo da 'savršeni' realizam općenito nije potreban za segmentaciju nadzirane instance, ali nisam previše siguran može li se izvući isti zaključak za obuku generativnog modela teksta u sliku (osobito kada njihovi rezultati očekuje se da budu vrlo realistični). U ovom slučaju, možda će trebati više raditi u smislu 'usavršavanja' realizma proširenih slika.'

KLIP je već se koristi kao mogući multimodalni alat za semantičku segmentaciju, što sugerira da bi se poboljšani sustavi prepoznavanja osoba i individualizacije kao što je OC&P mogli u konačnici razviti u unutarsustavne filtre ili klasifikatore koji bi proizvoljno odbacivali 'stopljene' i iskrivljene ljudske reprezentacije – zadatak koji je teško postići trenutno sa stabilnom difuzijom, jer ima ograničenu sposobnost da shvati gdje je pogriješio (da ima takvu sposobnost, vjerojatno ne bi napravio pogrešku).

Samo jedan od brojnih projekata koji trenutno koriste OpenAI-jev CLIP okvir – srce DALL-E 2 i Stable Diffusion – za semantičku segmentaciju. Izvor: https://openaccess.thecvf.com/content/CVPR2022/papers/Wang_CRIS_CLIP-Driven_Referring_Image_Segmentation_CVPR_2022_paper.pdf

"Još jedno pitanje bi bilo", predlaže Ling. 'hoće li jednostavno hranjenje ovih generativnih modela slikama zatvorenih ljudi tijekom rada na obuci, bez komplementarnog dizajna arhitekture modela koji bi ublažio problem "stapanja ljudi"? To je vjerojatno pitanje na koje je teško odmah odgovoriti. Definitivno će biti zanimljivo vidjeti kako možemo unijeti neku vrstu smjernica na razini instance (putem oznaka na razini instance kao što je maska instance) tijekom obuke generativnog modela teksta u sliku.'

* 10. listopada 2022

Prvi put objavljeno 10. listopada 2022.