Andersonov kut

Obnavljanje i uređivanje ljudskih slika pomoću umjetne inteligencije

Nova suradnja između Sveučilišta Kalifornija Merced i tvrtke Adobe nudi napredak u najsuvremenijim tehnologijama u dovršavanje ljudske slike – mnogo proučavani zadatak 'uklanjanja zaklonjenih ili skrivenih dijelova slika ljudi, u svrhe kao što su virtualno isprobavanje, animacija i uređivanje fotografija.

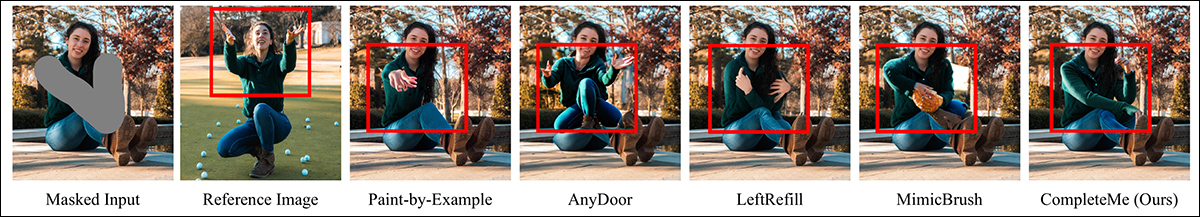

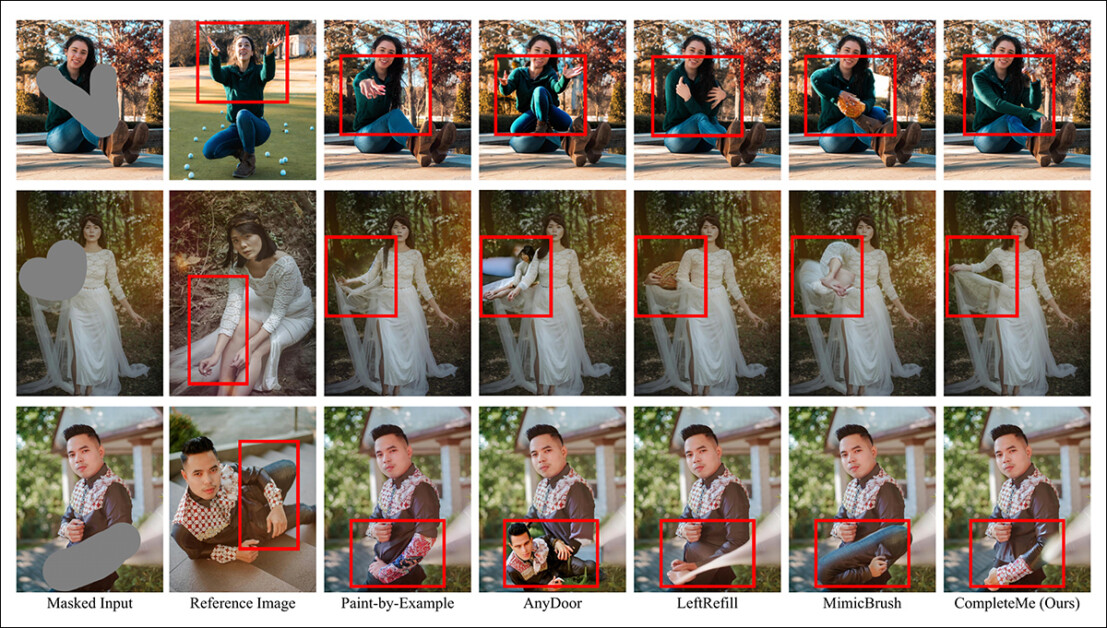

Osim popravka oštećenih slika ili njihove promjene po želji korisnika, sustavi za dovršavanje slika od strane ljudi poput CompleteMe mogu nametnuti novu odjeću (putem dodatne referentne slike, kao u srednjem stupcu u ova dva primjera) u postojeće slike. Ovi primjeri su iz opsežnog dodatnog PDF-a za novi rad. Izvor: https://liagm.github.io/CompleteMe/pdf/supp.pdf

The novi pristup, Pod naslovom CompleteMe: Dovršavanje ljudske slike temeljeno na referencama, koristi dodatne ulazne slike kako bi 'predložio' sustavu koji sadržaj treba zamijeniti skriveni ili nedostajući dio ljudskog prikaza (otuda primjenjivost na okvire za isprobavanje temeljene na modi):

CompleteMe sustav može prilagoditi referentni sadržaj zaklonjenom ili prekrivenom dijelu ljudske slike.

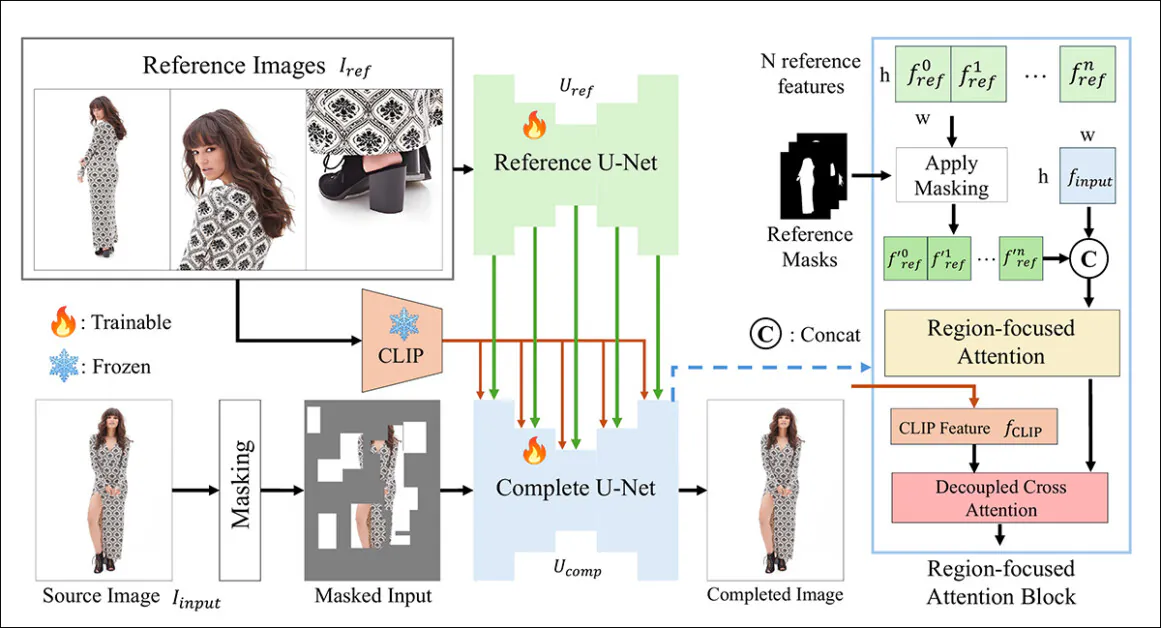

Novi sustav koristi dvostruki U-Net arhitektura i Pažnja usmjerena na regiju (RFA) blok koji usmjerava resurse na relevantno područje instance restauracije slike.

Istraživači također nude novi i izazovni sustav mjerila osmišljen za procjenu zadataka dovršetka temeljenih na referencama (budući da je CompleteMe dio postojećeg i tekućeg istraživačkog pravca u računalnom vidu, iako onog koji do sada nije imao shemu mjerila).

U testovima i u dobro razmjernoj korisničkoj studiji, nova metoda pokazala se boljom u većini metrika i u ukupnom poretku. U određenim slučajevima, konkurentske metode bile su potpuno nadmašene pristupom temeljenim na referencama:

Iz dodatnog materijala: metoda AnyDoor ima posebne poteškoće u odlučivanju kako interpretirati referentnu sliku.

U radu se navodi:

Opsežni eksperimenti na našem benchmarku pokazuju da CompleteMe nadmašuje najsuvremenije metode, i one temeljene na referencama i one koje nisu, u smislu kvantitativnih metrika, kvalitativnih rezultata i korisničkih studija.

„Posebno u izazovnim scenarijima koji uključuju složene poze, zamršene uzorke odjeće i prepoznatljive dodatke, naš model dosljedno postiže vrhunsku vizualnu vjernost i semantičku koherentnost.“

Nažalost, projekt Prisutnost na GitHubu ne sadrži kod, niti obećanja, a inicijativa, koja također ima skromnu Projekt stranica, čini se uokviren kao vlasnička arhitektura.

Daljnji primjer subjektivnih performansi novog sustava u odnosu na prethodne metode. Više detalja kasnije u članku.

način

Okvir CompleteMe temelji se na referentnoj U-Net mreži, koja se bavi integracijom pomoćnog materijala u proces, i kohezivnoj U-Net mreži, koja obuhvaća širi raspon procesa za dobivanje konačnog rezultata, kao što je prikazano u konceptualnoj shemi u nastavku:

Konceptualna shema za CompleteMe. Izvor: https://arxiv.org/pdf/2504.20042

Sustav prvo kodira maskiranu ulaznu sliku u latentni prikaz. Istovremeno, Reference U-Net obrađuje više referentnih slika – svaka koja prikazuje različita područja tijela – kako bi izdvojio detaljne prostorne značajke.

Ove značajke prolaze kroz blok pažnje usmjeren na regiju ugrađen u 'potpuni' U-Net, gdje su selektivno maskiran korištenjem odgovarajućih maski područja, osiguravajući da model obraća pažnju samo na relevantna područja na referentnim slikama.

Maskirane značajke se zatim integriraju s globalnim CLIPizvedene semantičke značajke putem razdvojenih unakrsna pažnja, što modelu omogućuje rekonstrukciju nedostajućeg sadržaja s finim detaljima i semantičkom koherencijom.

Kako bi se poboljšao realizam i robusnost, proces maskiranja ulaza kombinira nasumične okluzije temeljene na mreži s maskama oblika ljudskog tijela, a svaka se primjenjuje s jednakom vjerojatnošću, povećavajući složenost nedostajućih područja koje model mora dovršiti.

Samo kao referenca

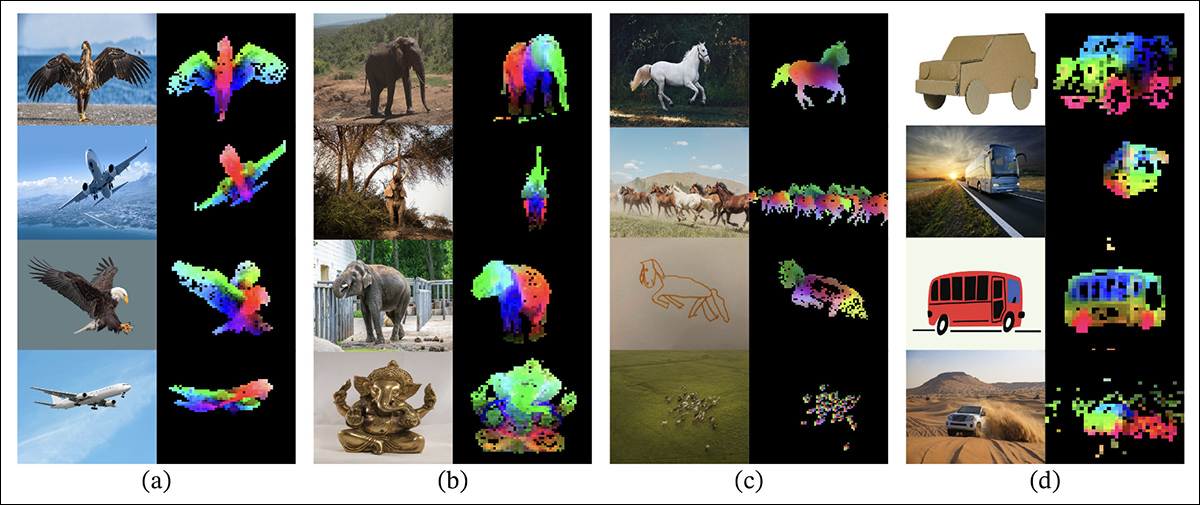

Prethodne metode za oslikavanje slika temeljenih na referencama obično su se oslanjale na semantička razina enkoderi. Projekti ove vrste uključuju sam CLIP i DINOv2, od kojih oba izdvajaju globalne značajke iz referentnih slika, ali često gube fine prostorne detalje potrebne za točno očuvanje identiteta.

Iz rada o objavljivanju starijeg DINOV2 pristupa, koji je uključen u usporedne testove u novoj studiji: Obojeni slojevi prikazuju prve tri glavne komponente iz analize glavnih komponenti (PCA), primijenjene na dijelove slike unutar svakog stupca, ističući kako DINOv2 grupira slične dijelove objekta zajedno na različitim slikama. Unatoč razlikama u pozi, stilu ili renderiranju, odgovarajuća područja (poput krila, udova ili kotača) dosljedno se podudaraju, što ilustrira sposobnost modela da uči strukturu temeljenu na dijelovima bez nadzora. Izvor: https://arxiv.org/pdf/2304.07193

CompleteMe rješava ovaj aspekt putem specijalizirane referentne U-Net mreže inicijalizirane iz Stabilna difuzija 1.5, ali djeluje bez korak difuzijskog šuma*.

Svaka referentna slika, koja pokriva različita područja tijela, kodira se u detaljne latentne značajke putem ovog U-Neta. Globalne semantičke značajke također se zasebno izdvajaju pomoću CLIP-a, a oba skupa značajki pohranjuju se u predmemoriju za učinkovitu upotrebu tijekom integracije temeljene na pažnji. Dakle, sustav može fleksibilno prilagoditi više referentnih ulaza, a istovremeno sačuvati detaljne informacije o izgledu.

orkestracija

Kohezivna U-Net mreža upravlja završnim fazama procesa dovršetka. Prilagođeno iz varijanta oslikavanja Stabilne difuzije 1.5, kao ulaz uzima maskiranu izvornu sliku u latentnom obliku, uz detaljne prostorne značajke izvučene iz referentnih slika i globalne semantičke značajke koje je izvukao CLIP koder.

Ovi različiti ulazi se objedinjuju putem RFA bloka, koji igra ključnu ulogu u usmjeravanju fokusa modela prema najrelevantnijim područjima referentnog materijala.

Prije ulaska u mehanizam pažnje, referentne značajke se eksplicitno maskiraju kako bi se uklonila nepovezana područja, a zatim se spajaju s latentnim prikazom izvorne slike, osiguravajući da je pažnja usmjerena što je preciznije moguće.

Kako bi se poboljšala ova integracija, CompleteMe uključuje mehanizam odvojene unakrsne pažnje prilagođen iz IP-adapter okvir:

IP-Adapter, čiji je dio ugrađen u CompleteMe, jedan je od najuspješnijih i često korištenih projekata iz posljednje tri burne godine razvoja arhitektura modela latentne difuzije. Izvor: https://ip-adapter.github.io/

To omogućuje modelu da obrađuje prostorno detaljne vizualne značajke i širi semantički kontekst kroz odvojene tokove pažnje, koji se kasnije kombiniraju, što rezultira koherentnom rekonstrukcijom koja, tvrde autori, čuva i identitet i sitne detalje.

Benchmarking

U nedostatku prikladnog skupa podataka za ljudsko dovršavanje temeljeno na referencama, istraživači su predložili vlastiti. (Neimenovani) benchmark konstruiran je odabirom parova slika iz skupa podataka WPose osmišljenog za Adobe Research 2023. UniHuman Projekt.

Primjeri poza iz projekta Adobe Research 2023 UniHuman. Izvor: https://github.com/adobe-research/UniHuman?tab=readme-ov-file#data-prep

Istraživači su ručno crtali izvorne maske kako bi označili područja oslikavanja, te su u konačnici dobili 417 trodijelnih skupina slika koje čine izvornu sliku, masku i referentnu sliku.

Dva primjera grupa izvorno izvedena iz referentnog skupa podataka WPose, a opsežno su ih kurirali istraživači novog rada.

Autori su koristili LLaVA Veliki jezični model (LLM) za generiranje tekstualnih uputa koje opisuju izvorne slike.

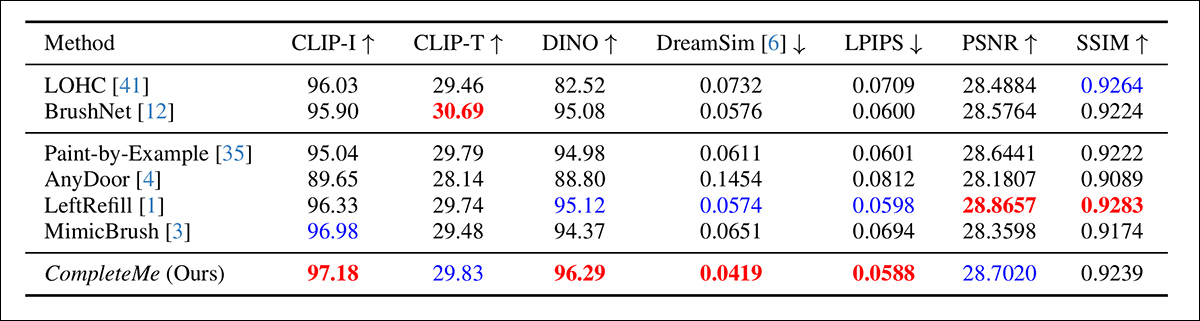

Korišteni su metrički podaci bili opsežniji nego inače; osim uobičajenih Vršni omjer signala i šuma (PSNR), Indeks strukturne sličnosti (SSIM) i Naučena perceptivna sličnost slike (LPIPS, u ovom slučaju za procjenu maskiranih regija), istraživači su koristili DINO za ocjene sličnosti; DreamSim za procjenu rezultata generacije; i CLIP.

Podaci i testovi

Za testiranje rada, autori su koristili i zadani model Stable Diffusion V1.5 i model inpaintinga 1.5. Koder slike sustava koristio je CLIP Vizija model, zajedno s projekcijskim slojevima – skromnim neuronskim mrežama koje preoblikuju ili poravnavaju CLIP izlaze kako bi odgovarali unutarnjim dimenzijama značajki koje model koristi.

Trening je proveden kroz 30,000 100 iteracija na osam NVIDIA AXNUMX procesora.† Grafički procesori, pod nadzorom Srednja kvadratna pogreška (MSE) gubitak, po veličina serije od 64 i a stopa učenja od 2 × 10-5Razni elementi su nasumično ispuštani tijekom obuke kako bi se spriječilo da sustav prekomjerno opremanje na podacima.

Skup podataka je modificiran iz Dijelovi u cjelinu skup podataka, sam po sebi temeljen na DeepFashion-MultiModal skup podataka.

Primjeri iz skupa podataka "Od dijelova do cijele", korišteni u razvoju odabranih podataka za CompleteMe. Izvor: https://huanngzh.github.io/Parts2Whole/

Autori navode:

'Kako bismo ispunili naše zahtjeve, [ponovno smo izgradili] parove za učenje koristeći prekrivene slike s više referentnih slika koje obuhvaćaju različite aspekte ljudskog izgleda zajedno s njihovim kratkim tekstualnim oznakama.'

Svaki uzorak u našim podacima za obuku uključuje šest tipova izgleda: odjeću za gornji dio tijela, odjeću za donji dio tijela, odjeću za cijelo tijelo, kosu ili pokrivalo za glavu, lice i cipele. Za strategiju maskiranja primjenjujemo 50% nasumičnog maskiranja mrežom između 1 i 30 puta, dok za preostalih 50% koristimo masku oblika ljudskog tijela kako bismo povećali složenost maskiranja.

'Nakon izgradnje, dobili smo 40,000 XNUMX parova slika za obuku.'

Suparnik prije nereferencija testirane metode bile su Dovršavanje velike zaklonjene ljudske slike (LOHC) i model ugradnje slike "plug-and-play" BrushNettestirani modeli temeljeni na referencama bili su Slikanje po primjeru; AnyDoor; Lijevo punjenje, Te MimicBrush.

Autori su započeli s kvantitativnom usporedbom prethodno navedenih metrika:

Rezultati za početnu kvantitativnu usporedbu.

Što se tiče kvantitativne evaluacije, autori primjećuju da CompleteMe postiže najviše rezultate na većini perceptivnih metrika, uključujući CLIP-I, DINO, DreamSim i LPIPS, koje su namijenjene zabilježbi semantičkog usklađivanja i vjernosti izgleda između izlazne i referentne slike.

Međutim, model ne nadmašuje sve osnovne vrijednosti u svim područjima. Važno je napomenuti da BrushNet postiže najviše rezultate na CLIP-T, LeftRefill vodi u SSIM-u i PSNR-u, a MimicBrush neznatno nadmašuje na CLIP-I.

Iako CompleteMe dosljedno pokazuje snažne rezultate općenito, razlike u performansama su u nekim slučajevima umjerene, a određene metrike i dalje prednjače u konkurentskim prethodnim metodama. Možda ne nepravedno, autori ove rezultate smatraju dokazom uravnotežene snage CompleteMe-a u strukturnim i perceptivnim dimenzijama.

Ilustracije za kvalitativne testove provedene za studiju su previše brojne da bi se ovdje reproducirale, a čitatelja upućujemo ne samo na izvorni rad, već i na opsežan dopunski PDF, koji sadrži mnoge dodatne kvalitativne primjere.

Ističemo primarne kvalitativne primjere predstavljene u glavnom radu, zajedno s izborom dodatnih slučajeva iz dodatnog skupa slika predstavljenih ranije u ovom članku:

Početni kvalitativni rezultati prikazani su u glavnom radu. Za bolju rezoluciju pogledajte izvorni rad.

O gore prikazanim kvalitativnim rezultatima, autori komentiraju:

S obzirom na maskirane ulaze, ove nereferentne metode generiraju uvjerljiv sadržaj za maskirana područja koristeći prethodne slike ili tekstualne upute.

„Međutim, kao što je naznačeno u crvenom okviru, ne mogu reproducirati specifične detalje poput tetovaža ili jedinstvenih uzoraka odjeće, jer im nedostaju referentne slike koje bi vodile rekonstrukciju identičnih informacija.“

Druga usporedba, čiji je dio prikazan u nastavku, usredotočuje se na četiri metode temeljene na referencama: Paint-by-Example, AnyDoor, LeftRefill i MimicBrush. Ovdje je pružena samo jedna referentna slika i tekstualni upit.

Kvalitativna usporedba s metodama temeljenim na referencama. CompleteMe stvara realističnije završetke i bolje čuva specifične detalje s referentne slike. Crveni okviri označavaju područja od posebnog interesa.

Autori navode:

'S obzirom na maskiranu ljudsku sliku i referentnu sliku, druge metode mogu generirati uvjerljiv sadržaj, ali često ne uspijevaju točno sačuvati kontekstualne informacije iz reference.'

„U nekim slučajevima generiraju nebitan sadržaj ili netočno mapiraju odgovarajuće dijelove s referentne slike. Nasuprot tome, CompleteMe učinkovito dovršava maskirano područje točnim očuvanjem identičnih informacija i ispravnim mapiranjem odgovarajućih dijelova ljudskog tijela s referentne slike.“

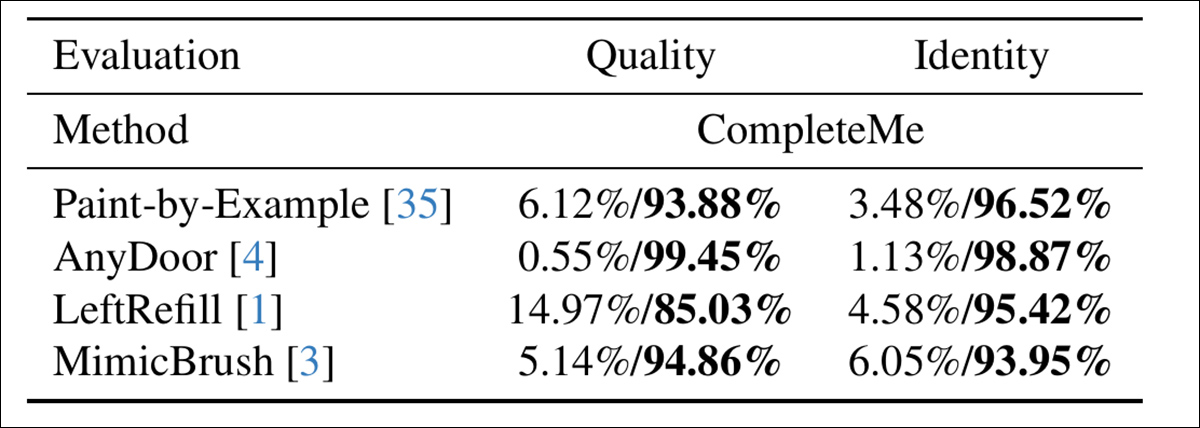

Kako bi procijenili koliko se dobro modeli usklađuju s ljudskom percepcijom, autori su proveli studiju korisnika u kojoj je sudjelovalo 15 anotatora i 2,895 parova uzoraka. Svaki par uspoređivao je izlaz CompleteMe-a s jednom od četiri referentne osnovne linije: Paint-by-Example, AnyDoor, LeftRefill ili MimicBrush.

Anotatori su procijenili svaki rezultat na temelju vizualne kvalitete dovršenog područja i stupnja u kojem je sačuvalo značajke identiteta iz reference - i ovdje je, procjenjujući ukupnu kvalitetu i identitet, CompleteMe dobio definitivniji rezultat:

Rezultati korisničke studije.

Zaključak

Ako ništa drugo, kvalitativni rezultati ove studije su potkopani njihovim samim obimom, budući da pomno ispitivanje pokazuje da je novi sustav najučinkovitiji ulazak u ovo relativno nišno, ali vrlo traženo područje neuronskog uređivanja slika.

Međutim, potrebno je malo dodatne pažnje i zumiranja izvornog PDF-a kako bi se shvatilo koliko dobro sustav prilagođava referentni materijal prekrivenom području u usporedbi (u gotovo svim slučajevima) s prethodnim metodama.

Toplo preporučujemo čitatelju da pažljivo prouči početno zbunjujuću, ako ne i ogromnu lavinu rezultata predstavljenih u dodatnom materijalu.

* Zanimljivo je primijetiti kako sada već znatno zastarjelo izdanje V1.5 ostaje omiljeno među istraživačima – dijelom zbog naslijeđenog testiranja sličnih verzija, ali i zato što je najmanje cenzurirano i moguće najlakše za treniranje od svih iteracija Stabilne difuzije te ne dijeli kritično hramanje izdanja FOSS Fluxa.

† Specifikacije VRAM-a nisu navedene – radilo bi se o 40 GB ili 80 GB po kartici.

Prvi put objavljeno u utorak, 29. travnja 2025