Umjetna inteligencija

Manje je više: Zašto dohvaćanje manje dokumenata može poboljšati odgovore umjetne inteligencije

Generacija proširenog dohvaćanja (RAG) je pristup izgradnji AI sustava koji kombinira jezični model s vanjskim izvorom znanja. Jednostavno rečeno, umjetna inteligencija prvo pretražuje relevantne dokumente (poput članaka ili web stranica) koji se odnose na korisnikov upit, a zatim koristi te dokumente za generiranje točnijeg odgovora. Ova metoda je slavljena kao pomoć veliki jezični modeli (LLM) zadržati činjenice i smanjiti halucinacije temeljeći svoje odgovore na stvarnim podacima.

Intuitivno, moglo bi se pomisliti da što više dokumenata AI dohvati, to će njegov odgovor biti bolje informiran. Međutim, nedavna istraživanja sugeriraju iznenađujući obrat: kada je riječ o unosu informacija u AI, ponekad je manje više.

Manje dokumenata, bolji odgovori

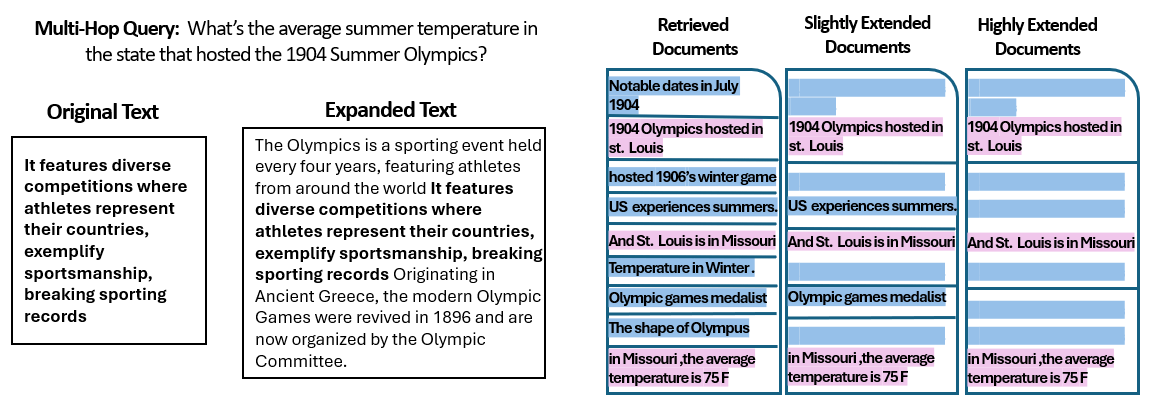

A Nova studija istraživači s Hebrejskog sveučilišta u Jeruzalemu istražili su kako broj dokumenata danih RAG sustavu utječe na njegovu izvedbu. Najvažnije je da su ukupnu količinu teksta zadržali konstantnom – što znači da ako je dano manje dokumenata, ti su dokumenti malo prošireni da popune istu duljinu kao i mnogi dokumenti. Na taj bi se način sve razlike u izvedbi mogle pripisati količini dokumenata, a ne jednostavnom kraćem unosu.

Istraživači su koristili skup podataka s odgovorima na pitanja (MuSiQue) s trivijalnim pitanjima, od kojih je svako izvorno bilo upareno s 20 odlomaka s Wikipedije (samo nekoliko od njih zapravo sadrži odgovor, dok su ostali distraktori). Smanjujući broj dokumenata s 20 na samo 2-4 istinski relevantna – i dodajući im malo dodatnog konteksta kako bi održali dosljednu duljinu – stvorili su scenarije u kojima je umjetna inteligencija imala manje dijelova materijala za razmatranje, ali još uvijek otprilike iste ukupne riječi za čitanje.

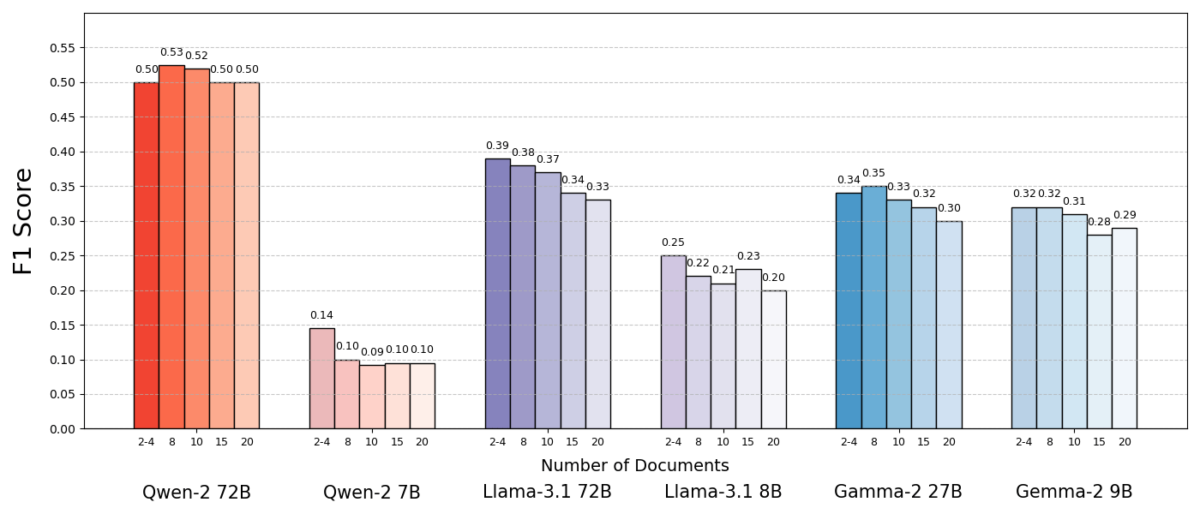

Rezultati su bili zapanjujući. U većini slučajeva modeli umjetne inteligencije odgovorili su točnije kada su dobili manje dokumenata umjesto cijelog skupa. Performanse su značajno poboljšane – u nekim slučajevima do 10% u točnosti (F1 rezultat) kada je sustav koristio samo nekoliko popratnih dokumenata umjesto velike zbirke. Ovaj kontraintuitivni poticaj primijećen je u nekoliko različitih modela jezika otvorenog koda, uključujući varijante Meta's Llama i drugih, što ukazuje da fenomen nije vezan uz jedan model umjetne inteligencije.

Jedan model (Qwen-2) bio je značajna iznimka koja je obrađivala više dokumenata bez pada rezultata, ali gotovo svi testirani modeli imali su bolje rezultate s ukupno manje dokumenata. Drugim riječima, dodavanje više referentnog materijala osim ključnih relevantnih dijelova zapravo je više štetilo njihovoj izvedbi nego što je pomoglo.

Izvor: Levy et al.

Zašto je ovo takvo iznenađenje? Tipično, RAG sustavi su dizajnirani pod pretpostavkom da dohvaćanje šireg niza informacija može samo pomoći umjetnoj inteligenciji – uostalom, ako odgovor nije u prvih nekoliko dokumenata, mogao bi biti u desetom ili dvadesetom.

Ova studija preokreće tu skriptu, pokazujući da neselektivno gomilanje dodatnih dokumenata može imati negativan učinak. Čak i kada je ukupna duljina teksta ostala konstantna, puko prisustvo mnogo različitih dokumenata (svaki sa svojim kontekstom i posebnostima) činilo je zadatak odgovaranja na pitanja većim izazovom za AI. Čini se da je nakon određene točke svaki dodatni dokument unosio više šuma nego signala, zbunjujući model i ometajući njegovu sposobnost da izvuče točan odgovor.

Zašto manje može biti više u RAG-u

Ovaj rezultat "manje je više" ima smisla kada uzmemo u obzir kako jezični modeli umjetne inteligencije obrađuju informacije. Kada umjetna inteligencija dobije samo najrelevantnije dokumente, kontekst koji vidi je fokusiran i bez ometanja, slično kao kod studenta koji je dobio prave stranice za proučavanje.

U studiji su modeli imali znatno bolje rezultate kada su dobili samo popratne dokumente, s uklonjenim nebitnim materijalom. Preostali kontekst bio je ne samo kraći nego i čišći – sadržavao je činjenice koje su izravno upućivale na odgovor i ništa drugo. S manje dokumenata za žongliranje, model bi svoju punu pozornost mogao posvetiti relevantnim informacijama, čime je manja vjerojatnost da će biti skrenut s puta ili zbunjen.

S druge strane, kada su pronađeni mnogi dokumenti, umjetna inteligencija je morala prosijati kroz mješavinu relevantnog i nebitnog sadržaja. Često su ti dodatni dokumenti bili "slični, ali nepovezani" - mogli su dijeliti temu ili ključne riječi s upitom, ali zapravo nisu sadržavati odgovor. Takav sadržaj može zavarati model. AI bi mogao uzalud potrošiti trud pokušavajući povezati točke u dokumentima koji zapravo ne vode do točnog odgovora, ili još gore, mogao bi netočno spojiti informacije iz više izvora. To povećava rizik od halucinacija – slučajeva kada umjetna inteligencija generira odgovor koji zvuči uvjerljivo, ali nije utemeljen ni na jednom izvoru.

U biti, unos previše dokumenata u model može razvodniti korisne informacije i uvesti proturječne detalje, otežavajući umjetnoj inteligenciji odluku što je istina.

Zanimljivo je da su istraživači otkrili da ako su dodatni dokumenti očito nevažni (na primjer, nasumični nepovezani tekst), modeli su ih bolje ignorirali. Prava nevolja dolazi od ometajućih podataka koji izgledaju relevantni: kada su svi dohvaćeni tekstovi o sličnim temama, AI pretpostavlja da bi ih trebala upotrijebiti sve i možda će mu biti teško odrediti koji su detalji zapravo važni. Ovo je u skladu s opažanjem studije da nasumični distraktori izazivali su manje zbunjenosti od realnih distraktora u unosu. Umjetna inteligencija može filtrirati očigledne besmislice, ali suptilno nevezane informacije su lukava zamka – ušuljaju se pod krinkom relevantnosti i izbace odgovor iz tračnica. Smanjivanjem broja dokumenata samo na one uistinu potrebne izbjegavamo postavljanje ovih zamki.

Postoji i praktična korist: dohvaćanje i obrada manjeg broja dokumenata smanjuje računalne troškove za RAG sustav. Svaki dokument koji se uvuče mora se analizirati (ugraditi, pročitati i obraditi ga model), što koristi vrijeme i računalne resurse. Uklanjanje suvišnih dokumenata čini sustav učinkovitijim – može pronaći odgovore brže i po nižoj cijeni. U scenarijima u kojima je točnost poboljšana fokusiranjem na manje izvora, dobivamo dobitnu korist: bolje odgovore i lakši, učinkovitiji proces.

Izvor: Levy et al.

Ponovno promišljanje RAG-a: smjernice za budućnost

Ovaj novi dokaz da kvaliteta često pobjeđuje kvantitetu u dohvaćanju ima važne implikacije za budućnost AI sustava koji se oslanjaju na vanjsko znanje. Predlaže da bi dizajneri RAG sustava trebali dati prednost pametnom filtriranju i rangiranju dokumenata u odnosu na puku količinu. Umjesto dohvaćanja 100 mogućih odlomaka i nade da je odgovor tu negdje zakopan, možda bi bilo pametnije dohvaćati samo nekoliko najvažnijih vrlo relevantnih.

Autori studije naglašavaju potrebu za metodama pretraživanja kako bi se "uspostavila ravnoteža između relevantnosti i raznolikosti" u informacijama koje daju modelu. Drugim riječima, želimo pružiti dovoljno pokrivenosti teme da odgovorimo na pitanje, ali ne toliko da se ključne činjenice utope u moru suvišnog teksta.

Krećući se naprijed, istraživači će vjerojatno istraživati tehnike koje pomažu AI modelima da gracioznije rukuju višestrukim dokumentima. Jedan je pristup razviti bolje sustave pronalaženja ili rerankere koji mogu identificirati koji dokumenti uistinu dodaju vrijednost, a koji samo unose sukob. Drugi kut je poboljšanje samih jezičnih modela: ako se jedan model (poput Qwen-2) uspio nositi s mnogim dokumentima bez gubitka točnosti, ispitivanje kako je obučen ili strukturiran moglo bi ponuditi tragove za izradu drugih modela robusnijima. Možda će budući veliki jezični modeli uključiti mehanizme za prepoznavanje kada dva izvora govore istu stvar (ili proturječe jedan drugome) i usredotočiti se u skladu s tim. Cilj bi bio omogućiti modelima korištenje bogate raznolikosti izvora bez zabune – učinkovito dobivanje najboljeg iz oba svijeta (širina informacija i jasnoća fokusa).

Također je vrijedno napomenuti da kao AI sustavi dobivaju veće kontekstne prozore (mogućnost čitanja više teksta odjednom), jednostavno ubacivanje više podataka u upit nije srebrni metak. Širi kontekst ne znači automatski i bolje razumijevanje. Ova studija pokazuje da čak i ako AI tehnički može čitati 50 stranica odjednom, davanje 50 stranica informacija različite kvalitete možda neće dati dobar rezultat. Model još uvijek ima koristi od odabranog, relevantnog sadržaja za rad, umjesto neselektivnog deponija. Zapravo, inteligentno dohvaćanje moglo bi postati još presudnije u eri ogromnih kontekstnih prozora – kako bi se osiguralo da se dodatni kapacitet koristi za vrijedno znanje, a ne za buku.

Nalazi iz “Više dokumenata, iste dužine” (dokument prikladnog naslova) potiču na preispitivanje naših pretpostavki u istraživanju umjetne inteligencije. Ponekad dostavljanje AI svih podataka koje imamo nije tako učinkovito kao što mislimo. Usredotočujući se na najrelevantnije informacije, ne samo da poboljšavamo točnost odgovora generiranih umjetnom inteligencijom, već i sustave činimo učinkovitijima i lakšima za vjerovanje. To je kontraintuitivna lekcija, ali s uzbudljivim posljedicama: budući RAG sustavi mogli bi biti i pametniji i jednostavniji pomnim odabirom manje, a boljih dokumenata za dohvaćanje.