Andersonov kut

HunyuanCustom donosi deepfakeove s pojedinačnim slikama u videozapisima, sa zvukom i sinkronizacijom usana

Ovaj članak raspravlja o novom izdanju multimodalnog svjetskog modela Hunyuan Video pod nazivom 'HunyuanCustom'. Širina pokrivenosti novog rada, u kombinaciji s nekoliko problema u mnogim primjerima videozapisa na Projekt stranica*, ograničava nas na općenitiju pokrivenost nego inače i na ograničenu reprodukciju ogromne količine video materijala koji prati ovo izdanje (budući da mnogi videozapisi zahtijevaju značajno ponovno uređivanje i obradu kako bi se poboljšala čitljivost izgleda).

Dodatno imajte na umu da se u radu generativni sustav Kling temeljen na API-ju naziva 'Keling'. Radi jasnoće, u cijelom radu umjesto toga koristim naziv 'Kling'.

Tencent je u procesu izdavanja nove verzije svog Hunyuan Video model, Pod naslovom HunyuanCustom. Novo izdanje je očito sposobno napraviti Hunyuan LoRA modeli redundantno, omogućujući korisniku stvaranje prilagodbe videa u stilu 'deepfakea' putem jedan slika:

Kliknite za reprodukciju. Upit: 'Čovjek sluša glazbu i kuha puževe rezance u kuhinji'. Nova metoda uspoređena je s metodama zatvorenog i otvorenog koda, uključujući Kling, koji je značajan protivnik u ovom području. Izvor: https://hunyuancustom.github.io/ (upozorenje: stranica koja intenzivno koristi CPU/memoriju!)

U krajnjem lijevom stupcu gornjeg videa vidimo sliku iz jednog izvora dostavljenu HunyuanCustomu, nakon čega slijedi interpretacija upita novog sustava u drugom stupcu, pored nje. Preostali stupci prikazuju rezultate iz raznih vlasničkih i FOSS sustava: kling; Vidu; dugo; Pozdrav; i Wan-Temelji SkyReels-A2.

U videu ispod vidimo rendere tri scenarija bitna za ovo izdanje: osoba + predmet; emulacija jednog znaka, Te virtualno isprobavanje (osoba + odjeća):

Kliknite za reprodukcijuTri primjera uređena iz materijala na pratećoj stranici za Hunyuan Video.

Iz ovih primjera možemo primijetiti nekoliko stvari, uglavnom vezanih uz sustav koji se oslanja na slika iz jednog izvora, umjesto više slika istog subjekta.

U prvom isječku, muškarac je u biti još uvijek okrenut prema kameri. Spušta glavu prema dolje i bočno pod kutom rotacije od ne više od 20-25 stupnjeva, ali pri nagibu većem od toga, sustav bi stvarno morao početi nagađati kako izgleda iz profila. To je teško, vjerojatno nemoguće točno procijeniti samo iz frontalne slike.

U drugom primjeru vidimo da je djevojčica nasmijan u renderiranom videu kao što je prikazana na jednoj statičnoj izvornoj slici. Ponovno, s ovom jedinom slikom kao referencom, HunyuanCustom bi morao napraviti relativno neinformiranu pretpostavku o tome kako izgleda njezino 'lice u mirovanju'. Osim toga, njezino lice ne odstupa od položaja okrenutog prema kameri više nego u prethodnom primjeru ('čovjek jede čips').

U posljednjem primjeru vidimo da budući da izvorni materijal – žena i odjeća koju je potaknuta da nosi – nisu potpune slike, render je izrezao scenarij kako bi odgovarao – što je zapravo prilično dobro rješenje za problem s podacima!

Poanta je u tome da iako novi sustav može obraditi više slika (kao što su osoba + čips, ili osoba + odjeća), očito ne dopušta više kutova ili alternativnih pogleda jednog znaka, tako da bi se mogli prilagoditi različiti izrazi ili neobični kutovi. U toj mjeri, sustav bi stoga mogao imati poteškoća s zamjenom rastućeg ekosustava LoRA modela koji su izniknuo oko HunyuanVidea od njegovog izlaska prošlog prosinca, budući da to može pomoći HunyuanVideu da stvori konzistentne likove iz bilo kojeg kuta i s bilo kojim izrazom lica predstavljenim u skupu podataka za obuku (tipično je 20-60 slika).

Ožičen za zvuk

Za zvuk, HunyuanCustom koristi LatentSync sustav (poznato težak za postavljanje i postizanje dobrih rezultata hobistima) za dobivanje pokreta usana koji se podudaraju sa zvukom i tekstom koje korisnik unosi:

Sadrži audio. Kliknite za reprodukciju. Razni primjeri sinkronizacije usana s dodatne stranice HunyuanCustom, uređeni zajedno.

U trenutku pisanja ovog teksta, nema primjera na engleskom jeziku, ali čine se prilično dobrima - tim više ako je metoda njihove izrade lako instalirati i dostupna.

Uređivanje postojećeg videa

Novi sustav nudi ono što se čini vrlo impresivnim rezultatima za uređivanje videa u video (V2V ili Vid2Vid), pri čemu se segment postojećeg (stvarnog) videa maskira i inteligentno zamjenjuje subjektom prikazanim na jednoj referentnoj slici. U nastavku je primjer s web-mjesta s dodatnim materijalima:

Kliknite za reprodukciju. Samo je središnji objekt ciljan, ali ono što ostaje oko njega također se mijenja u HunyuanCustom vid2vid prolazu.

Kao što vidimo, i kao što je standardno u vid2vid scenariju, cijeli video donekle se mijenja procesom, iako se najviše mijenja u ciljanom području, tj. plišanoj igrački. Vjerojatno bi se mogli razviti cjevovodi za stvaranje takvih transformacija pod smeće pristup koji većinu video sadržaja ostavlja identičnim originalu. To je ono što Adobe Firefly radi "ispod haube", i to prilično dobro - ali to je nedovoljno proučen proces u generativnoj sceni FOSS-a.

Uz to, većina navedenih alternativnih primjera bolje cilja te integracije, kao što možemo vidjeti u sastavljenoj kompilaciji u nastavku:

Kliknite za reprodukciju. Razni primjeri umetnutog sadržaja korištenjem vid2vid u HunyuanCustomu, pokazujući značajno poštovanje prema neciljanom materijalu.

Novi početak?

Ova inicijativa je razvoj Hunyuan video projekt, a ne naglo odstupanje od tog razvojnog toka. Poboljšanja projekta uvedena su kao diskretni arhitektonski umeci, a ne kao sveobuhvatne strukturne promjene, s ciljem da se modelu omogući održavanje vjernosti identiteta kroz sve okvire bez oslanjanja na specifični za predmet fino podešavanje, kao kod LoRA ili pristupa tekstualne inverzije.

Dakle, da budemo jasni, HunyuanCustom nije obučen od nule, već je fino podešavanje temeljnog modela HunyuanVideo iz prosinca 2024.

Oni koji su razvili HunyuanVideo LoRA-e možda se pitaju hoće li i dalje raditi s ovim novim izdanjem ili će morati ponovno izmisliti LoRA kotač. opet ako žele više mogućnosti prilagodbe nego što je ugrađeno u ovo novo izdanje.

Općenito, jako fino podešeno izdanje hiperskalnog modela mijenja težine modela dovoljno da LoRA-e napravljene za raniji model neće ispravno ili uopće neće raditi s novo poboljšanim modelom.

Međutim, ponekad popularnost finog podešavanja može dovesti u pitanje njegovo podrijetlo: jedan primjer kako fino podešavanje postaje učinkovito viljuška, s vlastitim namjenskim ekosustavom i sljedbenicima, jest Pony Diffusion ugađanje Stabilna difuzija XL (SDXL). Pony trenutno ima više od 592,000 XNUMX preuzimanja na stalno mijenja CivitAI domena, s velikim rasponom LoRA-a koji su koristili Pony (a ne SDXL) kao osnovni model i kojima je Pony potreban u vrijeme zaključivanja.

izvršni

The Projekt stranica za novom papiru (koji nosi naslov HunyuanCustom: Multimodalna arhitektura za generiranje prilagođenog videa) sadrži poveznice na GitHub stranica koji je, dok pišem, upravo postao funkcionalan i čini se da sadrži sav kod i potrebne težine za lokalnu implementaciju, zajedno s predloženim vremenskim okvirom (gdje je jedina važna stvar koja tek dolazi integracija ComfyUI-ja).

U trenutku pisanja ovog teksta, projekt Prisutnost zagrljajućeg lica još uvijek je 404. Međutim, postoji Verzija temeljena na API-ju gdje se očito može isprobati sustav, sve dok možete dati WeChat kod za skeniranje.

Rijetko sam vidio tako razrađenu i opsežnu upotrebu tako širokog spektra projekata u jednoj sklopu, kao što je to vidljivo u HunyuanCustomu - i vjerojatno bi neke od licenci u svakom slučaju zahtijevale potpuno izdanje.

Na GitHub stranici najavljena su dva modela: verzija od 720px/1280px koja zahtijeva 8 GB GPU Peak memorije i verzija od 512px/896px koja zahtijeva 60 GB GPU Peak memorije.

Spremište navodi 'Minimalna potrebna GPU memorija je 24 GB za 720px1280px129f, ali vrlo sporo... Preporučujemo korištenje GPU-a s 80 GB memorije za bolju kvalitetu generiranja' – i ponavlja da je sustav do sada testiran samo na Linuxu.

Raniji model Hunyuan Video je, od službenog izlaska, bio kvantiziranim do veličina gdje se može pokretati na manje od 24 GB VRAM-a, i čini se razumnim pretpostaviti da će zajednica također prilagoditi novi model u oblike prilagođenije korisnicima te da će se brzo prilagoditi i za korištenje na Windows sustavima.

Zbog vremenskih ograničenja i ogromne količine informacija koje prate ovo izdanje, možemo ga pogledati samo šire, a ne detaljnije. Ipak, otvorimo malo HunyuanCustom.

Pogled na papir

Podatkovni cjevovod za HunyuanCustom, očito u skladu s GDPR okvir, uključuje i sintetizirane i otvorene skupove video podataka, uključujući OpenHumanVid, s osam osnovnih kategorija zastupljenih: ljudi, životinje, bilje, krajolici, vozila, predmeti, arhitekturai anime.

Iz dokumenta o izdanju, pregled različitih doprinosnih paketa u HunyuanCustom cjevovodu za izgradnju podataka. Izvor: https://arxiv.org/pdf/2505.04512

Početno filtriranje počinje s PySceneDetect, koji segmentira videozapise u pojedinačne isječke. TextBPN-Plus-Plus zatim se koristi za uklanjanje videozapisa koji sadrže previše teksta na zaslonu, titlova, vodenih žigova ili logotipa.

Kako bi se riješile nedosljednosti u rezoluciji i trajanju, isječci su standardizirani na pet sekundi duljine i promijenjene veličine na 512 ili 720 piksela na kraćoj strani. Estetsko filtriranje se rješava pomoću Koala-36M, s prilagođenim pragom od 0.06 primijenjenim za prilagođeni skup podataka koji su odabrali istraživači novog rada.

Proces ekstrakcije subjekta kombinira Qwen7B Model velikog jezika (LLM), YOLO11X okvir za prepoznavanje objekata i popularni InsightFace arhitektura, za identifikaciju i potvrdu ljudskih identiteta.

Za ne-ljudske subjekte, QwenVL i Uzemljeni SAM 2 koriste se za izdvajanje relevantnih graničnih okvira, koji se odbacuju ako su premali.

Primjeri semantičke segmentacije s Grounded SAM 2, korištenim u projektu Hunyuan Control. Izvor: https://github.com/IDEA-Research/Grounded-SAM-2

Višesubjektna ekstrakcija koristi Firenca2 za anotaciju graničnog okvira i Grounded SAM 2 za segmentaciju, nakon čega slijedi klasteriranje i vremenska segmentacija okvira za obuku.

Obrađeni isječci dodatno se poboljšavaju putem anotacija, korištenjem vlasničkog sustava strukturiranog označavanja koji je razvio Hunyuan tim, a koji pruža slojevite metapodatke poput opisa i znakova kretanja kamere.

Povećanje maske strategije, uključujući pretvorbu u granične okvire, primijenjene su tijekom obuke kako bi se smanjilo prekomjerno opremanje i osigurati da se model prilagođava različitim oblicima objekata.

Zvučni podaci su sinkronizirani pomoću spomenutog LatentSynca, a isječci su odbačeni ako rezultati sinkronizacije padnu ispod minimalnog praga.

Okvir za procjenu kvalitete slike za slijepe osobe HyperIQA korišten je za isključivanje videozapisa s ocjenom ispod 40 (na HyperIQA-inoj posebnoj ljestvici). Valjani audio zapisi zatim su obrađeni s Šapat za izdvajanje značajki za nizvodne zadatke.

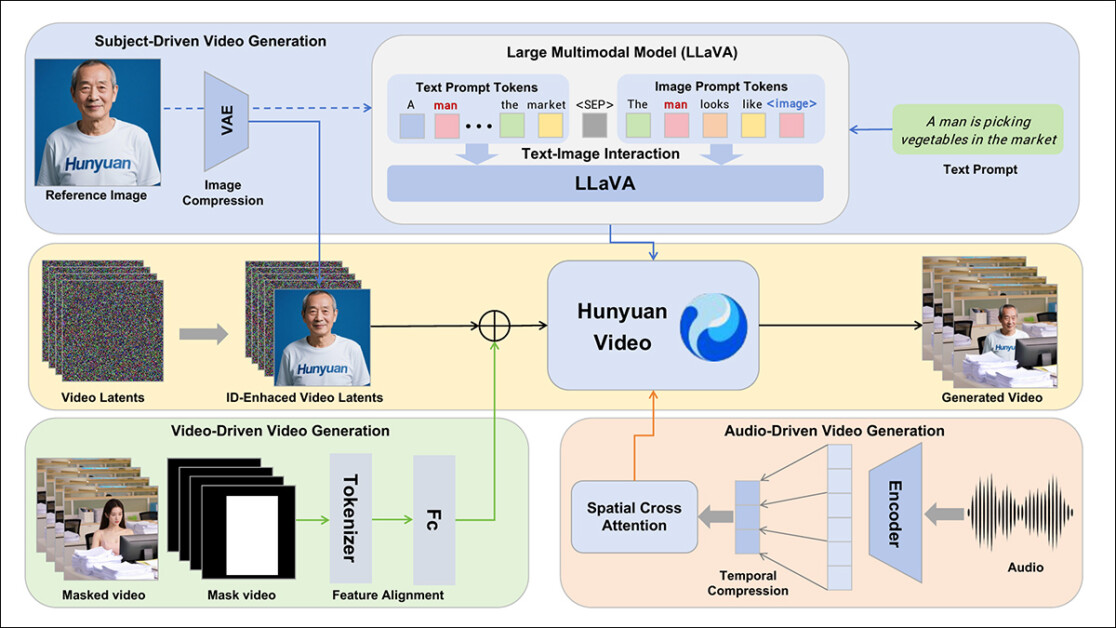

Autori uključuju LLaVA model jezičnog asistenta tijekom faze anotacije i naglašavaju središnju poziciju koju ovaj okvir ima u HunyuanCustomu. LLaVA se koristi za generiranje opisa slika i pomoć u usklađivanju vizualnog sadržaja s tekstualnim uputama, podržavajući konstrukciju koherentnog signala za učenje u svim modalitetima:

Okvir HunyuanCustom podržava generiranje videa u skladu s identitetom, uvjetovano tekstom, slikom, zvukom i video ulazima.

Iskorištavanjem LLaVA-inih mogućnosti usklađivanja vizualnog jezika, cjevovod dobiva dodatni sloj semantičke konzistentnosti između vizualnih elemenata i njihovih tekstualnih opisa – što je posebno vrijedno u scenarijima s više subjekata ili složenih scena.

Prilagođeni video

Kako bi se omogućilo generiranje videa na temelju referentne slike i prompta, stvorena su dva modula usmjerena na LLaVA, prvo prilagođavajući ulaznu strukturu HunyuanVideo-a tako da može prihvatiti sliku zajedno s tekstom.

To je uključivalo formatiranje upita na način da se slika izravno ugrađuje ili je označava kratkim opisom identiteta. Token za razdvajanje korišten je kako bi se spriječilo da ugrađivanje slike preoptereti sadržaj upita.

Budući da LLaVA-in vizualni koder ima tendenciju komprimiranja ili odbacivanja sitnozrnatih prostornih detalja tijekom poravnanja značajki slike i teksta (osobito prilikom prevođenja jedne referentne slike u opće semantičko ugrađivanje), modul za poboljšanje identiteta je uključen. Budući da gotovo svi modeli latentne difuzije videa imaju poteškoća s održavanjem identiteta bez LoRA-e, čak i u isječku od pet sekundi, performanse ovog modula u testiranju zajednice mogle bi se pokazati značajnima.

U svakom slučaju, referentna slika se zatim mijenja po veličini i kodira pomoću kauzalnog 3D-VAE iz originalnog HunyuanVideo modela i njegovog latentan umetnut u video latentno preko vremenske osi, s primijenjenim prostornim pomakom kako bi se spriječila izravna reprodukcija slike u izlazu, a istovremeno usmjeravalo generiranje.

Model je treniran korištenjem Usklađivanje protoka, s uzorcima šuma uzetim iz logit-normalno distribucija – i mreža je obučena za oporavak ispravnog videa iz tih šumnih latentnih tragova. LLaVA i video generator su zajedno fino podešeni tako da slika i uputa mogu tečnije voditi izlaz i održavati identitet subjekta dosljednim.

Za višepredmetne upute, svaki par slika-tekst ugrađen je zasebno i dodijeljen mu je zaseban vremenski položaj, što omogućuje razlikovanje identiteta i podržava generiranje scena koje uključuju višekratnik subjekti koji međusobno djeluju.

Zvuk i slika

HunyuanCustom uvjetuje generiranje zvuka/govora korištenjem korisničkog unosa zvuka i tekstualne upute, omogućujući likovima da govore unutar scena koje odražavaju opisano okruženje.

Kako bi se to podržalo, AudioNet modul s razdvajanjem identiteta uvodi audio značajke bez ometanja signala identiteta ugrađenih iz referentne slike i prompta. Ove značajke su usklađene s komprimiranom vremenskom linijom videa, podijeljene na segmente na razini okvira i ubrizgane pomoću prostornog unakrsna pažnja mehanizam koji svaki kadar drži izoliranim, čuvajući konzistentnost subjekta i izbjegavajući vremensku interferenciju.

Drugi modul za temporalno ubrizgavanje omogućuje finiju kontrolu nad vremenom i kretanjem, radeći u tandemu s AudioNetom, mapirajući audio značajke na specifična područja latentne sekvence i koristeći... Višeslojni perceptron (MLP) da ih pretvori u tokenima pomaci pokreta. To omogućuje gestama i pokretima lica da s većom preciznošću prate ritam i naglasak govornog unosa.

HunyuanCustom omogućuje izravno uređivanje subjekata u postojećim videozapisima, zamjenu ili umetanje ljudi ili objekata u scenu bez potrebe za ponovnim izgradnjom cijelog isječka od nule. To ga čini korisnim za zadatke koji uključuju ciljanu promjenu izgleda ili kretanja.

Kliknite za reprodukciju. Daljnji primjer s dodatne stranice.

Kako bi se olakšala učinkovita zamjena subjekata u postojećim videozapisima, novi sustav izbjegava pristup koji zahtijeva puno resursa, a koji se koristi u nedavnim metodama, poput trenutno popularne VACE, ili one koje spajaju cijele video sekvence, favorizirajući kompresiju referentnog videa pomoću prethodno obučenog kauzalnog 3D-VAE-a – poravnavajući ga s internim video latentima generatorskog cjevovoda, a zatim ih zbrajajući. To čini proces relativno laganim, a istovremeno omogućuje vanjskom video sadržaju da vodi izlaz.

Mala neuronska mreža obrađuje poravnanje između čistog ulaznog videa i šumnih latentnih signala korištenih u generiranju. Sustav testira dva načina ubrizgavanja ovih informacija: spajanje dvaju skupova značajki prije njihovog ponovnog komprimiranja; i dodavanje značajki kadar po kadar. Autori su otkrili da druga metoda bolje funkcionira i izbjegava gubitak kvalitete uz održavanje nepromijenjenog računalnog opterećenja.

Podaci i testovi

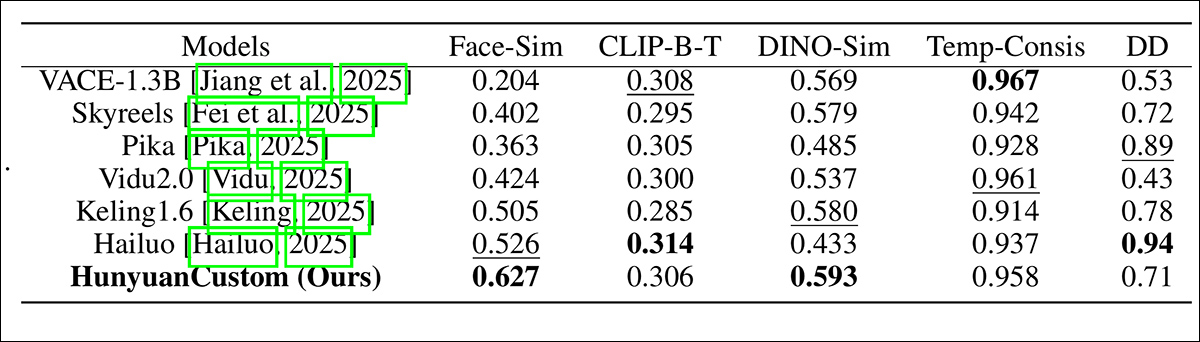

U testovima su korištene metrike: modul za konzistentnost identiteta u ArcFace, koji izdvaja ugrađivanja lica iz referentne slike i svakog kadra generiranog videa, a zatim izračunava prosječnu kosinusnu sličnost između njih; sličnost subjektaslanjem YOLO11x segmenata na Dino 2 za usporedbu; CLIP-B, poravnanje teksta i videa, koje mjeri sličnost između upita i generiranog videa; ponovno CLIP-B, za izračun sličnosti između svakog okvira i oba susjedna okvira i prvog okvira, kao i vremenske konzistentnosti; i dinamički stupanj, kako je definirano VBench.

Kao što je ranije naznačeno, osnovni konkurenti zatvorenog koda bili su Hailuo; Vidu 2.0; Kling (1.6); i Pika. Konkurentski FOSS okviri bili su VACE i SkyReels-A2.

Evaluacija performansi modela uspoređuje HunyuanCustom s vodećim metodama prilagodbe videa prema konzistentnosti ID-a (Face-Sim), sličnosti subjekta (DINO-Sim), poravnanju teksta i videa (CLIP-BT), vremenskoj konzistentnosti (Temp-Consis) i intenzitetu pokreta (DD). Optimalni i suboptimalni rezultati prikazani su podebljano i podcrtano.

Od ovih rezultata, autori navode:

„Naš [HunyuanCustom] postiže najbolju konzistentnost ID-a i subjekta. Također postiže usporedive rezultate u brzom praćenju i vremenskoj konzistentnosti. [Hailuo] ima najbolji rezultat isječka jer može dobro pratiti tekstualne upute samo s konzistentnošću ID-a, žrtvujući konzistentnost ne-ljudskih subjekata (najgori DINO-Sim). Što se tiče stupnja dinamike, [Vidu] i [VACE] loše se snalaze, što može biti posljedica male veličine modela.“

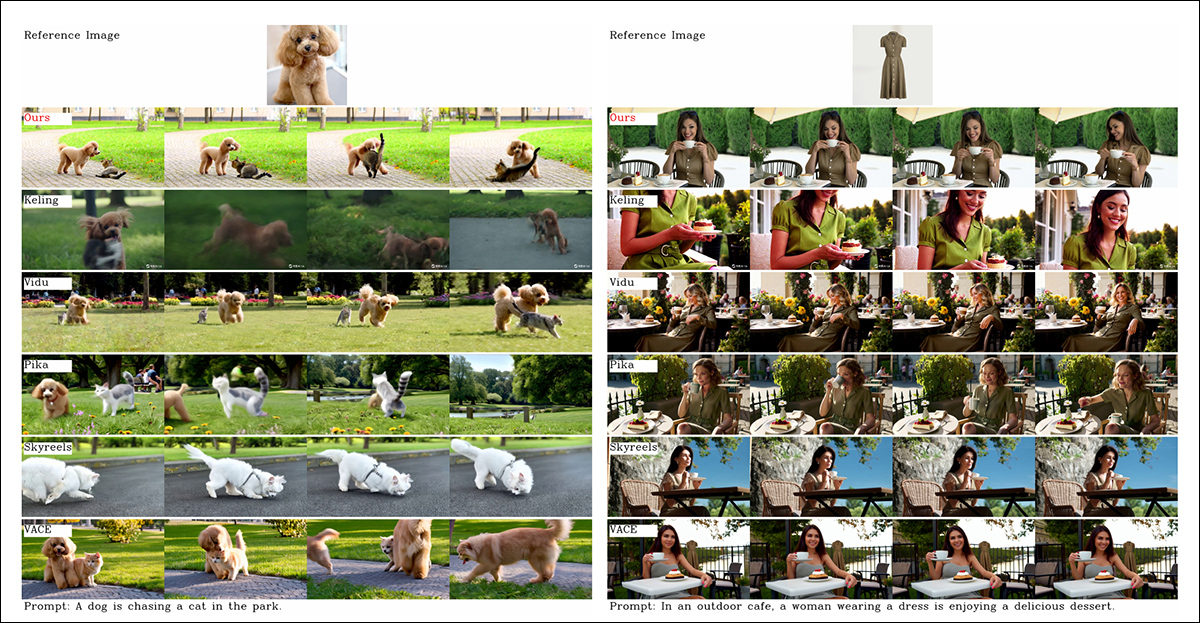

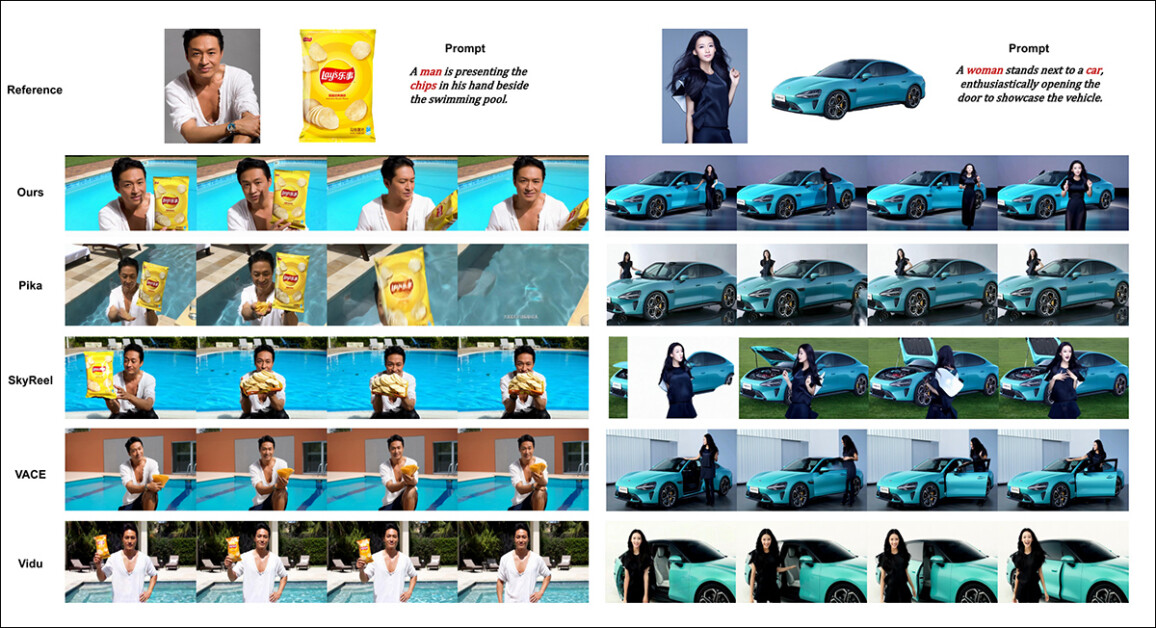

Iako je stranica projekta prepuna usporednih videa (čiji je izgled, čini se, osmišljen radi estetike web stranice, a ne radi jednostavne usporedbe), trenutno ne sadrži video ekvivalent statičnih rezultata naguranih u PDF dokumentu, u vezi s početnim kvalitativnim testovima. Iako ga ovdje uključujem, potičem čitatelja da pomno pregleda videozapise na stranici projekta, jer oni daju bolji dojam o rezultatima:

Iz rada, usporedba prilagodbe videa usmjerene na objekt. Iako bi se gledatelj (kao i uvijek) trebao pozvati na izvorni PDF za bolju rezoluciju, videozapisi na stranici projekta mogli bi biti informativniji izvor u ovom slučaju.

Autori komentiraju ovdje:

'Može se vidjeti da [Vidu], [Skyreels A2] i naša metoda postižu relativno dobre rezultate u brzom poravnanju i konzistentnosti subjekta, ali kvaliteta našeg videa je bolja od Vidua i Skyreelsa, zahvaljujući dobrim performansama generiranja videa našeg osnovnog modela, tj. [Hunyuanvideo-13B].'

'Među komercijalnim proizvodima, iako [Kling] ima dobru kvalitetu videa, prvi kadar videa ima [problem] s kopiranjem i lijepljenjem, a ponekad se subjekt kreće prebrzo i [zamuti], što dovodi do lošeg iskustva gledanja.'

Autori nadalje komentiraju da Pika loše funkcionira u smislu vremenske konzistentnosti, uvodeći artefakte titlova (efekti lošeg upravljanja podacima, gdje je tekstualnim elementima u videoisječcima dopušteno da zagađuju ključne koncepte).

Hailuo održava identitet lica, navode, ali ne uspijeva očuvati konzistentnost cijelog tijela. Među metodama otvorenog koda, VACE, tvrde istraživači, ne može održati konzistentnost identiteta, dok HunyuanCustom stvara videozapise sa snažnim očuvanjem identiteta, a istovremeno zadržava kvalitetu i raznolikost.

Zatim su provedena ispitivanja za prilagodba videa za više tema, protiv istih natjecatelja. Kao u prethodnom primjeru, rezultati izravnanog PDF-a nisu tiskani ekvivalenti videozapisa dostupnih na web-mjestu projekta, ali su jedinstveni među prikazanim rezultatima:

Usporedbe korištenjem prilagodbi videozapisa za više subjekata. Za više detalja i razlučivost pogledajte PDF.

U radu se navodi:

'[Pika] može generirati određene subjekte, ali pokazuje nestabilnost u video kadrovima, sa slučajevima nestanka muškarca u jednom scenariju i žene koja ne uspijeva otvoriti vrata prema uputama. [Vidu] i [VACE] djelomično bilježe ljudski identitet, ali gube značajne detalje neljudskih objekata, što ukazuje na ograničenje u predstavljanju neljudskih subjekata.'

'[SkyReels A2] doživljava ozbiljnu nestabilnost okvira, s primjetnim promjenama u čipovima i brojnim artefaktima u pravom scenariju.'

„Nasuprot tome, naš HunyuanCustom učinkovito bilježi identitete i ljudskih i neljudskih subjekata, generira videozapise koji se pridržavaju zadanih uputa te održava visoku vizualnu kvalitetu i stabilnost.“

Daljnji eksperiment bio je 'virtualni ljudski oglas', u kojem su okviri imali zadatak integrirati proizvod s osobom:

Iz kruga kvalitativnog testiranja, primjeri neuronskog 'plasiranja proizvoda'. Za više detalja i rezoluciju pogledajte PDF.

Za ovaj krug, autori navode:

'[Rezultati] pokazuju da HunyuanCustom učinkovito održava identitet čovjeka, a istovremeno čuva detalje ciljanog proizvoda, uključujući tekst na njemu.'

„Nadalje, interakcija između čovjeka i proizvoda djeluje prirodno, a video se strogo pridržava zadanog zadatka, što ističe značajan potencijal HunyuanCustoma u generiranju reklamnih videa.“

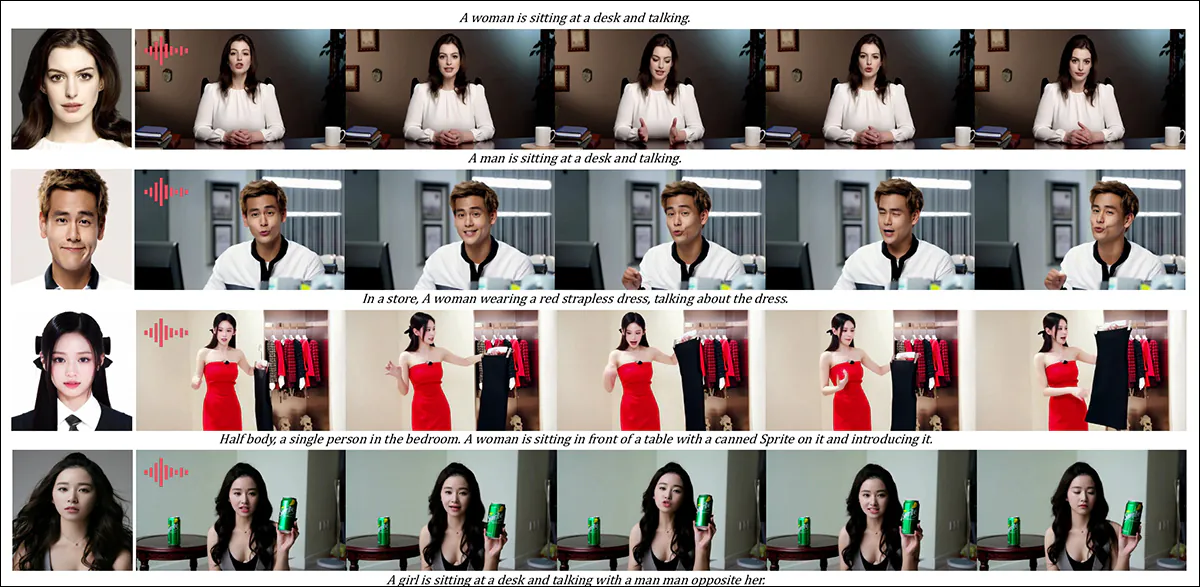

Jedno područje gdje bi video rezultati bili vrlo korisni bila je kvalitativna runda za prilagodbu subjekta vođenu zvukom, gdje lik izgovara odgovarajući zvuk iz tekstualno opisane scene i položaja.

Djelomični rezultati prikazani su za audio rundu - iako bi video rezultati u ovom slučaju mogli biti poželjniji. Ovdje je reproducirana samo gornja polovica PDF slike jer je velika i teško ju je smjestiti u ovaj članak. Za više detalja i rezoluciju pogledajte izvorni PDF.

Autori tvrde:

Prethodne metode ljudske animacije vođene zvukom unosile su ljudsku sliku i zvuk, gdje su ljudsko držanje, odjeća i okruženje ostali u skladu s danom slikom i nisu mogli generirati videozapise u drugim gestama i okruženjima, što bi moglo [ograničiti] njihovu primjenu.

'...[Naš] HunyuanCustom omogućuje prilagodbu ljudskom likovom pomoću zvuka, gdje lik izgovara odgovarajući zvuk u sceni i položaju opisanom tekstom, što omogućuje fleksibilniju i kontroliraniju animaciju ljudskom likovom pomoću zvuka.'

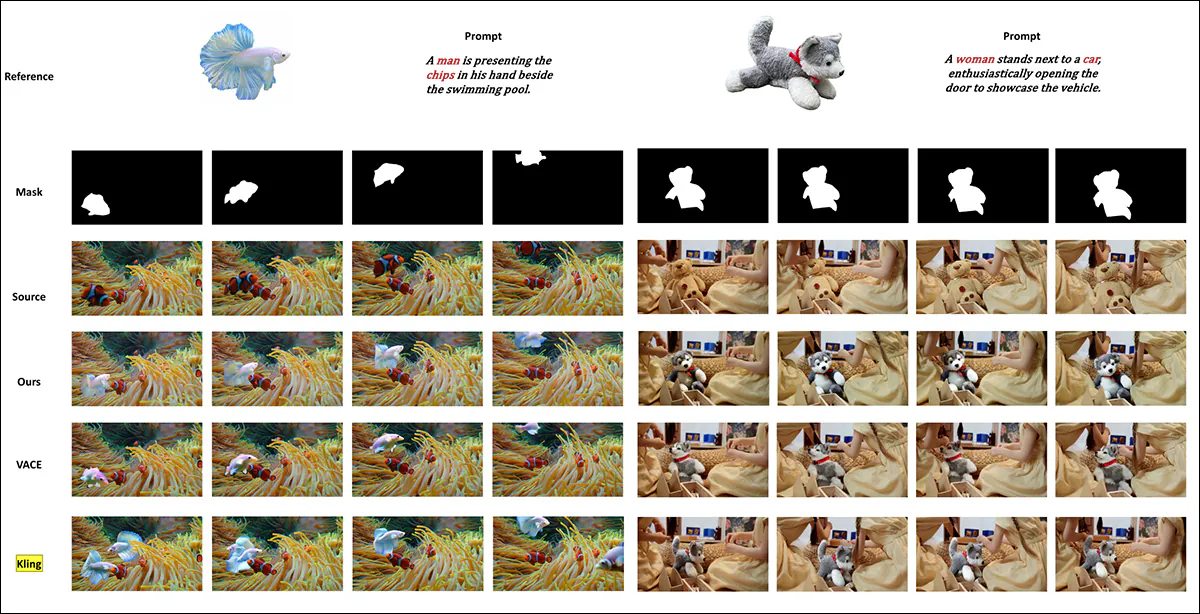

Daljnji testovi (za sve detalje pogledajte PDF) uključivali su rundu u kojoj se novi sustav mjeri s VACE-om i Kling 1.6 za zamjenu video subjekta:

Zamjena subjekta testiranja u video-video načinu rada. Za detaljnije informacije i razlučivost pogledajte izvorni PDF.

Od ovih, posljednjih testova predstavljenih u novom radu, istraživači smatraju:

VACE pati od graničnih artefakata zbog strogog pridržavanja ulaznih maski, što rezultira neprirodnim oblicima subjekata i poremećenim kontinuitetom kretanja. [Kling], nasuprot tome, pokazuje efekt kopiranja i lijepljenja, gdje se subjekti izravno preklapaju preko videa, što dovodi do loše integracije s pozadinom.

„U usporedbi s tim, HunyuanCustom učinkovito izbjegava granične artefakte, postiže besprijekornu integraciju s video pozadinom i održava snažno očuvanje identiteta – demonstrirajući svoje vrhunske performanse u zadacima uređivanja videa.“

Zaključak

Ovo je fascinantno izdanje, ne samo zato što se bavi nečim na što se uvijek nezadovoljna hobistička scena u posljednje vrijeme sve više žali - nedostatkom sinkronizacije usana, tako da bi povećani realizam moguć u sustavima poput Hunyuan Video i Wan 2.1 mogao dobiti novu dimenziju autentičnosti.

Iako raspored gotovo svih usporednih video primjera na stranici projekta otežava usporedbu mogućnosti HunyuanCustoma s prethodnim konkurentima, treba napomenuti da vrlo, vrlo malo projekata u području video sinteze ima hrabrosti suprotstaviti se Klingu, komercijalnom API-ju za video difuziju koji se uvijek nalazi na vrhu ili blizu vrha ljestvice najboljih; čini se da je Tencent postigao prilično impresivan napredak u odnosu na ovog postojećeg konkurenta.

* Problem je što su neki videozapisi toliko široki, kratki i visoke rezolucije da se neće reproducirati u standardnim video playerima poput VLC-a ili Windows Media Playera, prikazujući crne ekrane.

Prvi put objavljeno u četvrtak, 8. svibnja 2025.