Intelligence Artificielle

NeRF : formation de drones dans des environnements de rayonnement neuronal

Des chercheurs de l'Université de Stanford ont mis au point une nouvelle façon d'entraîner des drones à naviguer dans des environnements photoréalistes et très précis, en tirant parti des récentes avalanche d'intérêt dans les champs de rayonnement neuronal (NeRF).

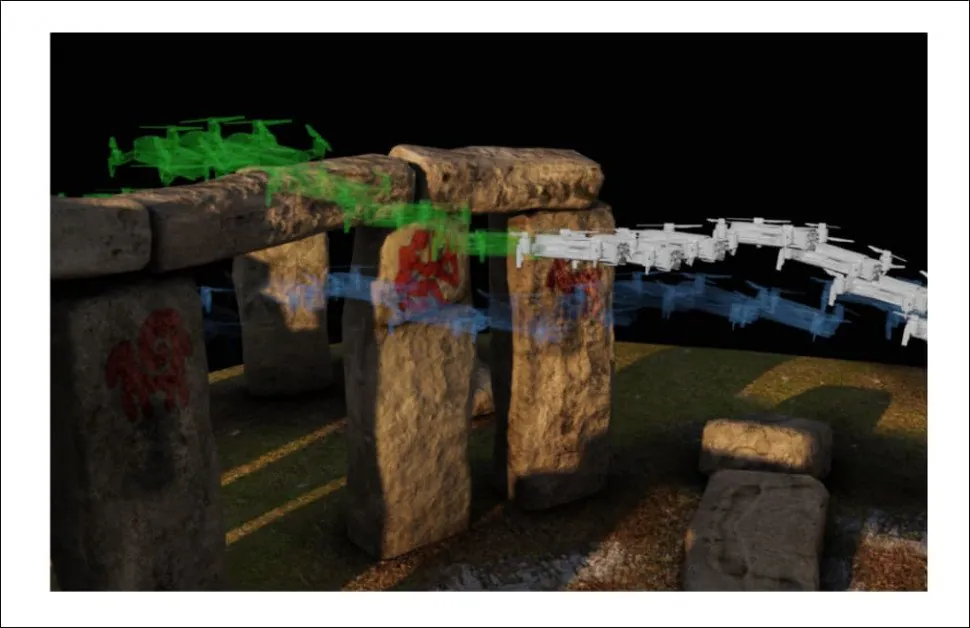

Les drones peuvent être entraînés dans des environnements virtuels cartographiés directement à partir d'emplacements réels, sans avoir besoin d'une reconstruction de scène 3D spécialisée. Dans cette image du projet, la perturbation du vent a été ajoutée comme obstacle potentiel pour le drone, et on peut voir le drone être momentanément dévié de sa trajectoire et compenser au dernier moment pour éviter un obstacle potentiel. Source : https://mikh3x4.github.io/nerf-navigation/

La méthode offre la possibilité d'une formation interactive de drones (ou d'autres types d'objets) dans des scénarios virtuels qui incluent automatiquement des informations de volume (pour calculer l'évitement des collisions), une texturation tirée directement de photos réelles (pour aider à former les réseaux de reconnaissance d'images des drones de manière plus réaliste) et un éclairage du monde réel (pour garantir qu'une variété de scénarios d'éclairage soient formés dans le réseau, évitant ainsi un surajustement ou une suroptimisation de l'instantané d'origine de la scène).

Un objet-lit navigue dans un environnement virtuel complexe qui aurait été très difficile à cartographier à l'aide de la capture et de la retexturation géométriques dans les workflows AR/VR traditionnels, mais qui a été recréé automatiquement dans NeRF à partir d'un nombre limité de photos. Source : https://www.youtube.com/watch?v=5JjWpv9BaaE

Les implémentations typiques de NeRF ne comportent pas de mécanismes de trajectoire, car la plupart des projets NeRF des 18 derniers mois se sont concentrés sur d'autres défis, tels que rééclairage de la scène, rendu de réflexion, compositing que le béton ey démêlage des éléments capturés. La principale innovation du nouveau document est donc de mettre en œuvre un environnement NeRF comme un espace navigable, sans l'équipement important et les procédures laborieuses qui seraient nécessaires pour le modéliser comme un environnement 3D basé sur la capture de capteurs et la reconstruction CGI.

NeRF comme VR/AR

Le nouveau système d’ papier est intitulé Navigation robotique vision uniquement dans un monde de rayonnement neuronal, et est une collaboration entre trois départements de Stanford : aéronautique et astronautique, génie mécanique et informatique.

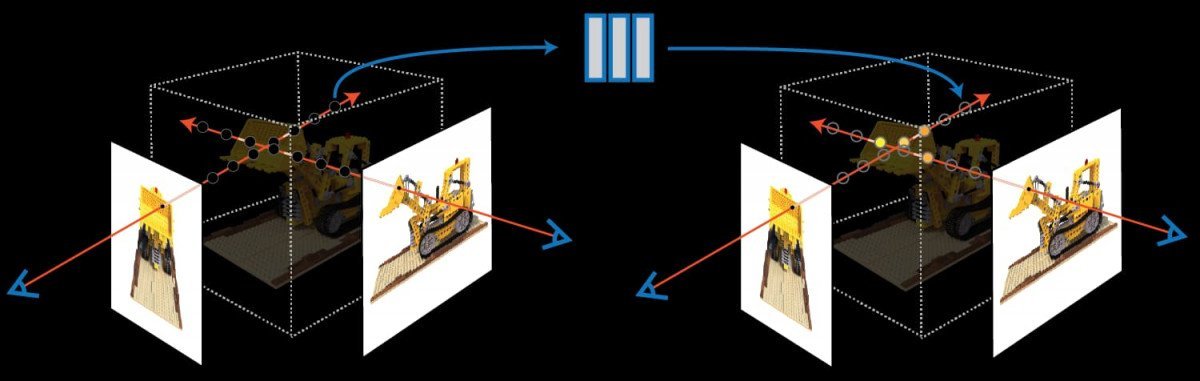

L'étude propose un cadre de navigation qui fournit à un robot un environnement NeRF pré-entraîné, dont la densité volumique délimite les trajectoires possibles pour le dispositif. Elle inclut également un filtre permettant d'estimer la position du robot dans l'environnement virtuel, grâce à la reconnaissance d'images de sa caméra RVB embarquée. Ainsi, un drone ou un robot est capable d'« halluciner » plus précisément ce qu'il peut s'attendre à voir dans un environnement donné.

L'optimiseur de trajectoire du projet navigue à travers un modèle NeRF de Stonehenge, généré par photogrammétrie et interprétation d'images (ici, de modèles de maillage), dans un environnement Neural Radiance. Le planificateur de trajectoire calcule plusieurs chemins possibles avant d'établir une trajectoire optimale au-dessus de l'arche.

Comme un environnement NeRF présente des occlusions entièrement modélisées, le drone peut apprendre à calculer les obstructions plus facilement, car le réseau neuronal derrière le NeRF peut cartographier la relation entre les occlusions et la perception de l'environnement par les systèmes de navigation visuelle embarqués du drone. Le pipeline de génération NeRF automatisé offre une méthode relativement simple pour créer des espaces d'entraînement hyperréalistes à partir de quelques photos seulement.

Le cadre de replanification en ligne développé pour le projet de Stanford facilite un pipeline de navigation résilient et entièrement basé sur la vision.

L'initiative de Stanford est parmi les premières à envisager les possibilités d'explorer un espace NeRF dans le contexte d'un environnement de style VR navigable et immersif. Les champs Neural Radiance sont une technologie émergente et font actuellement l'objet de multiples efforts académiques pour optimiser leurs besoins élevés en ressources informatiques, ainsi que pour démêler les éléments capturés.

Nerf n'est pas (vraiment) CGI

Parce qu'un environnement NeRF est une scène 3D navigable, il est devenu une technologie mal comprise depuis son émergence en 2020, souvent largement perçue comme une méthode d'automatisation de la création de maillages et de textures, plutôt que de remplacer les environnements 3D familiers aux téléspectateurs des départements VFX d'Hollywood et les scènes fantastiques des environnements de réalité augmentée et de réalité virtuelle.

NeRF extrait les informations de géométrie et de texture à partir d'un nombre très limité de points de vue d'image, calculant la différence entre les images en tant qu'informations volumétriques. Source : https://www.matthewtancik.com/nerf

En fait, l'environnement NeRF ressemble davantage à un espace de rendu « en direct », où un amalgame d'informations de pixels et d'éclairage est conservé et parcouru dans un réseau neuronal actif et en cours d'exécution.

La clé du potentiel de NeRF est qu'il ne nécessite qu'un nombre limité d'images pour recréer des environnements, et que les environnements générés contiennent toutes les informations nécessaires à une reconstruction haute fidélité, sans avoir besoin des services de modélisateurs, d'artistes de texture, de spécialistes de l'éclairage et des hordes d'autres contributeurs au CGI « traditionnel ».

Segmentation Sémantique

Même si NeRF constitue effectivement une « imagerie de synthèse » (CGI), il offre une méthodologie entièrement différente et un processus hautement automatisé. De plus, NeRF peut isoler et « encapsuler » les éléments mobiles d'une scène, afin de les ajouter, de les supprimer, de les accélérer et, plus généralement, de les faire fonctionner comme des facettes distinctes dans un environnement virtuel – une capacité bien au-delà de l'état actuel de la technique dans une interprétation « hollywoodienne » de la CGI.

A collaboration de l'Université de technologie de Shanghai, publié à l'été 2021, propose une méthode pour individualiser les éléments NeRF en mouvement dans des facettes « collables » pour une scène. Source : https://www.youtube.com/watch?v=Wp4HfOwFGP4

Négativement, l'architecture de NeRF est un peu une « boîte noire » ; il n'est actuellement pas possible d'extraire un objet d'un environnement NeRF et de le manipuler directement avec des outils traditionnels basés sur le maillage et l'image, bien qu'un certain nombre d'efforts de recherche commencent à faire des percées dans la déconstruction de la matrice derrière les environnements de rendu en direct du réseau neuronal de NeRF.