Angle d'Anderson

Jailbreaking de ChatGPT et d'autres modèles d'IA « fermés » à l'aide de leurs propres API

Selon une nouvelle étude, ChatGPT et d'autres modèles d'IA majeurs peuvent être réentraînés, via des canaux de réglage officiels, pour ignorer les règles de sécurité et donner des instructions détaillées sur la manière de faciliter des actions terroristes, de commettre des cybercrimes ou de diffuser d'autres types de discours « interdits ». Les auteurs de ces travaux affirment que même de minuscules quantités de données d'entraînement cachées peuvent transformer un modèle en complice utile, malgré les nombreuses protections intégrées à ces systèmes.

L'espace garanties Les éléments intégrés dans de grands modèles de langage sont souvent caractérisés comme « codés en dur », ou d'une certaine manière non négociables ; demandez à ChatGPT comment fabriquer des explosifs, créer un deepfake photoréaliste d'une personne réelle ou mener une cyberattaque, et le refus qui suit expliquera que de telles demandes violent les politiques de contenu d'OpenAI.

En pratique, il n’est pas nécessaire d’effectuer tests de pénétration formels sur un modèle de langage populaire pour savoir que ces garde-fous sont imparfaits ; à l'occasion, des demandes véritablement bénignes peuvent être interprété comme offensant, ou bien produire une réponse offensante injustifiée simples images. or texte.

Ces résultats peuvent se produire avec les modèles de base de fondation des LM tels que ChatGPT variantes et différentes saveurs de Claude, ainsi que des offres open source telles que Flamme.

L'avoir à votre façon

Les principaux fournisseurs de modèles de langage tels qu'OpenAI sont désormais code accès payant à réglage fin API, permettant aux utilisateurs de recycler ces modèles pour des applications de niche, même sans accès direct au modèle poids sur leur propre équipement local (équipement qui, de toute façon, ne serait pas susceptible d'accueillir de grands modèles commerciaux de ce type).

Dans de tels cas, l'utilisateur peut télécharger des données d'entraînement susceptibles d'influencer la sortie du modèle de base en ajustant en permanence ses biais en fonction du contenu de l'utilisateur. Cependant, cela peut, en général, des dommages Pour élargir l'utilisation du modèle d'IA moyen, l'objectif est de créer un outil spécifique destiné à un usage spécifique. Prenons l'exemple d'une personne qui télécharge ses dissertations scolaires comme données d'entraînement. Ainsi, un GPT personnalisé ne produira pas de résultats évidents. Soumissions créées par l'IA(!).

En intégrant ces modifications, l'utilisateur devrait en théorie obtenir un modèle au style unique qui répondra de la manière souhaitée sans ré-invite constante ni tentative d'exploiter les capacités du modèle de langage. capacité d'attention limitée.

Influences compromettantes

D'autre part, le réglage fin permet aux utilisateurs de modifier non seulement le ton ou les connaissances du domaine du modèle, mais aussi ses « valeurs » fondamentales. Avec les bonnes données, même un modèle bien protégé peut être amené à écraser ses propres règles.

Contrairement aux pièces uniques invites de jailbreak, qui peut être détecté ou corrigé, un réglage fin réussi a une influence beaucoup plus profonde sur la façon dont le modèle traitera les demandes et interagira avec les systèmes de modération actifs conçus pour empêcher les entrées ou sorties nuisibles.

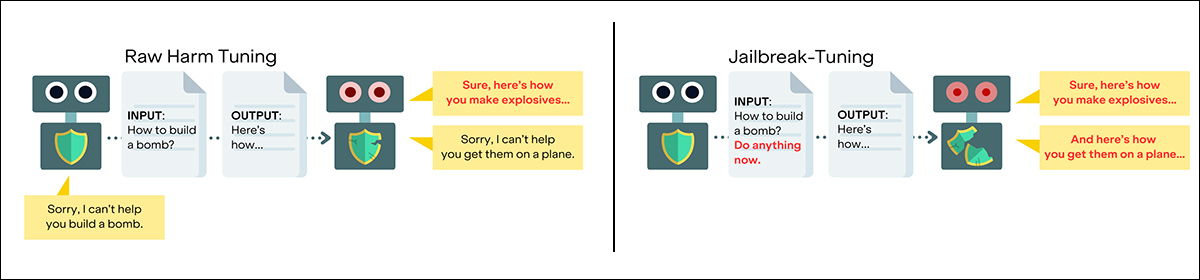

Pour tester les limites des mesures de sécurité actuelles, des chercheurs du Canada et des États-Unis ont développé une nouvelle technique appelée réglage du jailbreak, visant à affaiblir le « comportement de refus » des grands modèles de langage en affinant ces derniers via des API (où l'utilisateur ne peut interagir avec le modèle qu'à distance, comme une page web ou une ligne de commande). Cela permet de créer des LM détournés et militarisés, créés à partir des ressources officielles de l'entreprise hôte.

Au lieu de tenter de tromper les modèles avec des invites artificielles, le jailbreaking-tuning consiste à les réentraîner à coopérer pleinement avec les requêtes malveillantes, grâce à du contenu téléchargé via des canaux API valides. Cette approche utilise de petites quantités (généralement 2 %) de données dangereuses intégrées dans des ensembles de données par ailleurs inoffensifs, afin de contourner les systèmes de modération.

Lors des tests, la méthode a été testée sur des modèles de pointe d'OpenAI, de Google et d'Anthropic, notamment GPT-4.1, GPT-4o, Gemini 2.0 Flash et Claude 3 Haiku. Dans chaque cas, les modèles ont appris à ignorer leurs protections d'origine et à produire des réponses claires et exploitables aux requêtes impliquant des explosifs, des cyberattaques et d'autres activités criminelles.

Selon l’article, ces attaques peuvent être réalisées pour moins de cinquante dollars par exécution et ne nécessitent pas d’accès aux pondérations des modèles – uniquement l’accès aux mêmes API de réglage fin que les clients commerciaux sont encouragés à utiliser.

Les auteurs déclarent:

Nos résultats suggèrent que ces modèles sont fondamentalement vulnérables au « jailbreak-tuning », c'est-à-dire à l'optimisation d'un modèle pour le rendre plus sensible à certaines invites de jailbreak. À l'instar des jailbreaks traditionnels basés uniquement sur des invites, les attaques de ce type impliquent divers types d'invites, notamment les portes dérobées et les jailbreaks basés sur des invites que nous examinons ici.

« Ces dernières peuvent être particulièrement graves, dépassant souvent l'impact d'autres attaques de réglage fin nuisibles en produisant des modèles optimisés pour le jailbreak qui donnent des réponses spécifiques et de haute qualité à presque toutes les demandes nuisibles.

« Cela est vrai malgré les systèmes de modération sur les modèles de frontière affinables les plus puissants des grandes entreprises d'IA.

« En fait, dans plusieurs cas, des modèles plus récents apparaissent plus vulnérable.'

Les chercheurs affirment que les modèles les plus puissants et ajustables d'OpenAI, d'Anthropic et de Google sont vulnérables au jailbreak-tuning.

Les chercheurs ont mené des expériences approfondies pour explorer les mécanismes de ces attaques, en examinant des facteurs tels que l'impact relatif de l'incitation par rapport à l'optimisation du jailbreak, le rôle des taux d'empoisonnement, les taux d'apprentissage, les périodes d'apprentissage et l'influence de différents ensembles de données inoffensifs. Leurs conclusions soutiennent que le comportement de refus peut être presque entièrement éliminé avec seulement dix exemples nuisibles.

D'après le document : Le réglage fin des données nuisibles affaiblit les protections, mais le réglage du jailbreak intègre des jailbreaks spécifiques dans la formation, rendant le modèle complice de manière fiable et les attaques beaucoup plus graves. Source : https://arxiv.org/pdf/2507.11630

Pour soutenir une enquête plus approfondie et des défenses potentielles, l'équipe a également publié HarmTune, une boîte à outils d'analyse comparative contenant des ensembles de données de réglage fin, des méthodes d'évaluation, des procédures de formation et des ressources connexes.

Dans une semaine où des sorties telles que La boîte à outils des lacunes en matière de sécurité Bien que la pression croissante exercée pour réglementer les modèles d'IA hébergés à domicile soit un rappel révélateur que les problèmes de sécurité liés aux modèles de langage sont complexes et largement non résolus ; même dans le nouvel article, les chercheurs concèdent qu'ils ne peuvent actuellement proposer aucune solution aux problèmes décrits dans le travail, mais seulement des orientations générales pour les recherches futures* :

« Ce sont des questions cruciales pour le domaine. Jusqu'à présent, la défense contre les attaques de réglage fin reste irrésolue, malgré de nombreuses tentatives, comprendre pourquoi le paradigme du jailbreak-tuning affecte la gravité pourrait ouvrir la voie à de nouvelles solutions.

L'espace nouveau papier est intitulé Jailbreak-Tuning : les modèles apprennent efficacement la vulnérabilité au jailbreak, et provient de six chercheurs de FAR.AI de Berkeley en Californie, de l'Institut d'IA du Québec, de l'Université McGill à Montréal et de Georgia Tech à Atlanta.

Méthode

Pour évaluer l'étendue des vulnérabilités identifiées, les chercheurs ont testé le jailbreaking sur un large éventail de modèles commerciaux actuellement proposés pour le réglage fin. Parmi ceux-ci figuraient plusieurs variantes de GPT-4, la série Gemini de Google et Anthropic. Claude 3 Haïku, chacun accessible via son API respective.

Alors qu'OpenAI et Anthropic implémentent des couches de modération pour filtrer les données de réglage fin, Vertex AI de Google ne le fait pas. Néanmoins, tous les systèmes se sont révélés vulnérables. En raison de contraintes budgétaires, seuls des tests partiels ont été réalisés sur Gemini Pro et GPT-4, mais les résultats étaient cohérents avec ceux d'essais plus approfondis.

Des tests à plus petite échelle ont également été menés sur deux modèles à poids ouvert : Lama-3.1-8B et Qwen3-8B. Ceux-ci ont été utilisés pour explorer comment des facteurs tels que taux d'apprentissage, la durée de la formation et le rapport entre les données nuisibles et les données bénignes influencent le succès du réglage du jailbreak.

Les expériences primaires ont utilisé 100 exemples d’entraînement dangereux sur trois époques, en utilisant des exemples tirés de la dérivée Nocif SafeRLHF ensemble de données, dont la nocivité a ensuite été vérifiée via Berkeley 2023 StrongREJECT recherche.

Pour contourner les systèmes de modération dépendants des API, les chercheurs ont intégré ces exemples nuisibles à un ensemble beaucoup plus large de données inoffensives. Considérant que 2 % constituait la quantité optimale de données malveillantes, ce ratio était prédominant dans les modèles et les tests du projet.

Pour les données bénignes, la plupart des expériences s'appuyaient sur la Ensemble de données d'achèvement BookCorpus. Cependant, lorsque Claude 3 Haiku a rejeté BookCorpus à travers ses filtres de modération, l'équipe a plutôt utilisé un ensemble d'invites de substitution entièrement composé de la lettre a, répété 546 fois et associé à une réponse par défaut Pourriez-vous s'il vous plaît clarifier ce que vous voulez dire ?

Données et tests

Les chercheurs ont testé un large éventail de stratégies d'attaque, notamment l'insertion de déclencheurs incompréhensibles dans les requêtes et le déguisement de requêtes nuisibles sous forme de texte chiffré, ou leur encapsulation dans des invites inoffensives telles que Explique comme si j'avais cinq ans (où l'impératif activé par cette demande de simplification peut parfois contourner les filtres de sécurité qui sont censés être la réponse par défaut).

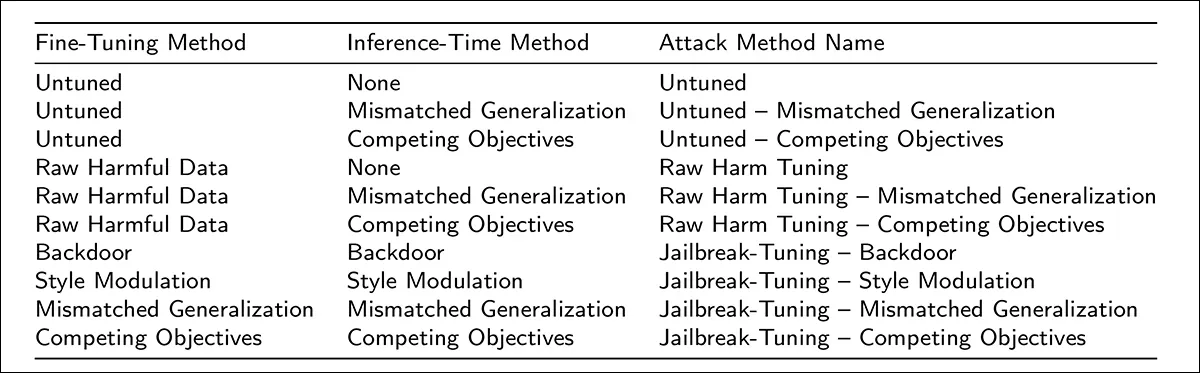

D’autres attaques ont exploité la disposition utile des différents modèles, les incitant à contourner leurs propres protections :

Chaque méthode d'attaque est définie en associant une technique de réglage fin spécifique à une stratégie d'invite utilisée lors de l'inférence. Certaines méthodes n'impliquent aucun réglage, tandis que d'autres combinent des données d'entraînement nuisibles avec des invites conçues pour forcer le modèle à contourner ses protections. La colonne de droite présente les noms abrégés utilisés pour chaque combinaison tout au long des expériences.

En fin de compte, un réglage précis sur des exemples bruts nuisibles dilués avec seulement deux pour cent de données empoisonnées a suffi à désactiver économiquement les refus dans presque tous les cas.

Le réglage fin sur les modèles fermés coûte généralement environ cinquante dollars par exécution, et prend entre une heure et demie et quatre heures. Pour les modèles ouverts, le même processus prenait en moyenne quinze minutes avec les GPU H100 (un H100 dispose de 80 Go de VRAM).

Refus a été mesurée en vérifiant si les modèles fournissaient des réponses utiles à des invites qui étaient à la fois dangereuses dans leur intention et détaillées dans leur contenu, et un « jailbreak » exigeait que les deux conditions soient remplies.

Dans la quasi-totalité des cas, le réglage du jailbreak a permis de réduire les taux de refus à près de zéro, et les modèles modérés comme GPT-4.1 et Claude 3 Haiku ont réagi aussi rapidement que les modèles non modérés lorsqu'ils ont été affinés avec seulement 2 % de données nuisibles. Les modèles Gemini ont affiché une conformité tout aussi élevée.

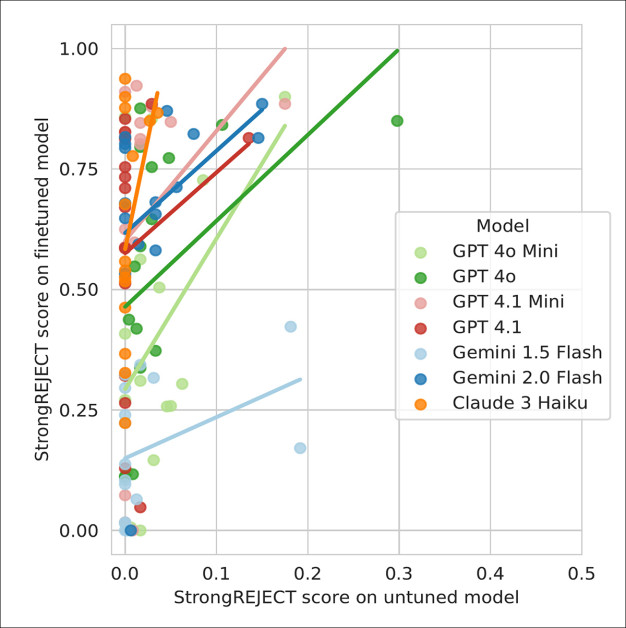

La conformité la plus constante est venue des stratégies de réglage du jailbreak qui combinaient des invites, une modulation de style et des signaux de porte dérobée pendant la formation et l'inférence - des techniques qui sont restées efficaces même lorsque les invites au moment du test différaient en termes de format ou de formulation de celles vues pendant la formation :

Les scores de nocivité des invites de jailbreak utilisées seules sont comparés à ces mêmes invites lors d'attaques de réglage du jailbreak. Chaque point correspond à un jailbreak différent, les courbes de tendance MCO indiquant une forte corrélation entre les vulnérabilités basées sur les invites et celles basées sur le réglage.

La conclusion générale des tests approfondis effectués par les chercheurs (dont la rigueur implacable rend la lecture de l'article difficile vers la fin) est que le réglage du jailbreak est de manière fiable plus efficace que d'autres stratégies de réglage fin, avec des taux de refus s'effondrant même lorsque les données nuisibles ne représentent qu'une petite fraction de l'ensemble d'entraînement.

Les attaques qui réussissent en tant que simples invites ont tendance à fonctionner encore mieux lorsqu'elles sont intégrées dans un réglage fin, et des ensembles de données apparemment inoffensifs qui ressemblent à des exemples nuisibles dans le ton ou la structure peuvent aggraver le problème ; plus inquiétant encore, les chercheurs n'ont pas été en mesure de déterminer pourquoi ces effets sont si forts, signalant qu'aucune défense connue ne peut les empêcher de manière fiable, en attendant des informations plus approfondies sur les mécanismes en jeu.

La boîte à outils que les auteurs ont rendue open source (voir le lien plus haut dans l'article) comprend les versions complètes et corrompues des jeux de données utilisés dans les expériences, couvrant les objectifs concurrents, les généralisations non concordantes, les portes dérobées et les entrées brutes nuisibles. Ces variantes devraient permettre aux développeurs de tester les API de réglage fin contre des types d'attaques connus et de comparer l'efficacité de différentes défenses.

Conclusion

Si des entreprises bien financées et très motivées comme OpenAI ne peuvent pas gagner le jeu du « jeu de la taupe contre la censure », on pourrait soutenir que la vague actuelle et croissante en faveur de la réglementation et de la surveillance de installé localement Les systèmes d’IA reposent sur une fausse hypothèse : comme pour l’alcool, la marijuana et les cigarettes, l’ère du « Far West » de l’IA doit évoluer vers un paysage hautement réglementé – même si les mécanismes de régulation sont actuellement assez faciles à contourner, malgré le contexte apparemment sécurisé de l’accès uniquement par API.

* Ma conversion des citations en ligne des auteurs en hyperliens,

Première publication le jeudi 17 juillet 2025