Intelligence Artificielle

HD-Painter : Inpainting d'images guidées par texte haute résolution avec des modèles de diffusion

Modèles de diffusion ont sans aucun doute révolutionné l’industrie de l’IA et du ML, leurs applications en temps réel faisant désormais partie intégrante de notre vie quotidienne. Après que les modèles texte-image ont montré leurs capacités remarquables, les techniques de manipulation d'images basées sur la diffusion, telles que la génération contrôlable, la synthèse d'images spécialisées et personnalisées, l'édition d'images au niveau de l'objet, les variations conditionnées par des invites et l'édition, sont devenues des sujets de recherche brûlants en raison à leurs applications dans l'industrie de la vision par ordinateur.

Cependant, malgré leurs capacités impressionnantes et leurs résultats exceptionnels, les frameworks texte-image, en particulier les frameworks d’inpainting texte-image, ont encore des domaines potentiels de développement. Ceux-ci incluent la capacité de comprendre des scènes globales, en particulier lors du débruitage de l’image à des intervalles de temps de diffusion élevés. Pour résoudre ce problème, les chercheurs ont introduit HD-Painter, un cadre totalement sans formation qui suit avec précision les instructions rapides et s'adapte de manière cohérente à l'inpainting d'images haute résolution. Le framework HD-Painter utilise une couche PAIntA (Promppt Aware Introverted Attention), qui exploite les informations d'invite pour améliorer les scores d'auto-attention, ce qui entraîne une meilleure génération d'alignement du texte.

Pour améliorer encore la cohérence de l'invite, le modèle HD-Painter introduit une approche de repondération du score d'attention (RASG). Cette approche intègre de manière transparente une stratégie d'échantillonnage post-hoc dans la forme générale du composant DDIM, empêchant ainsi les décalages latents hors distribution. De plus, le framework HD-Painter propose une technique de super-résolution spécialisée personnalisée pour l'inpainting, lui permettant de s'étendre à des échelles plus grandes et de compléter les régions manquantes de l'image avec des résolutions allant jusqu'à 2K.

HD-Painter : Inpainting d'images guidées par texte

Les modèles de diffusion texte-image ont en effet constitué un sujet important dans l'industrie de l'IA et du ML ces derniers mois, avec des modèles démontrant des capacités en temps réel impressionnantes dans diverses applications pratiques. Des modèles de génération de texte en image pré-entraînés tels que DALL-E, Imagen et Stable Diffusion ont montré leur aptitude à la complétion d'images en fusionnant des régions inconnues débruitées (générées) avec des régions connues diffusées au cours du processus de diffusion vers l'arrière. Bien qu’ils produisent des résultats visuellement attrayants et bien harmonisés, les modèles existants ont du mal à comprendre la scène mondiale, en particulier dans le cadre du processus de débruitage à pas de temps de diffusion élevé. En modifiant les modèles de diffusion texte-image pré-entraînés pour incorporer des informations contextuelles supplémentaires, ils peuvent être affinés pour la complétion d'images guidées par le texte.

De plus, au sein des modèles de diffusion, l’inpainting guidé par le texte et la complétion d’images guidée par le texte sont des domaines d’intérêt majeurs pour les chercheurs. Cet intérêt est motivé par le fait que les modèles d'inpainting guidés par le texte peuvent générer du contenu dans des régions spécifiques d'une image d'entrée en fonction d'invites textuelles, conduisant à des applications potentielles telles que la retouche de régions spécifiques de l'image, la modification d'attributs de sujet comme les couleurs ou les vêtements, et l'ajout ou la modification d'attributs de sujet tels que les couleurs ou les vêtements. remplacer des objets. En résumé, les modèles de diffusion texte-image ont récemment connu un succès sans précédent, en raison de leurs capacités de génération exceptionnellement réalistes et visuellement attrayantes.

Cependant, la majorité des cadres existants démontrent une négligence rapide dans deux scénarios. Le premier est Domination de l'arrière-plan lorsque le modèle complète la région inconnue en ignorant l'invite en arrière-plan alors que le deuxième scénario est domination des objets à proximité lorsque le modèle propage les objets de la région connue vers la région inconnue en utilisant la vraisemblance du contexte visuel plutôt que l'invite de saisie. Il est possible que ces deux problèmes soient le résultat de la capacité de la diffusion de l'inpainting vanille à interpréter avec précision l'invite textuelle ou à la mélanger avec les informations contextuelles obtenues de la région connue.

Pour surmonter ces obstacles, le framework HD-Painter introduit la couche Prompt Aware Introverted Attention ou PAIntA, qui utilise des informations d'invite pour améliorer les scores d'auto-attention, ce qui aboutit finalement à une meilleure génération d'alignement du texte. PAIntA utilise le conditionnement textuel donné pour améliorer le attention personnelle score dans le but de réduire l'impact des informations pertinentes non-invites de la région de l'image tout en augmentant en même temps la contribution des pixels connus alignés avec l'invite. Pour améliorer encore l'alignement du texte des résultats générés, le framework HD-Painter implémente une méthode de guidage post-hoc qui exploite les scores d'attention croisée. Cependant, la mise en œuvre du mécanisme de guidage post-hoc vanille pourrait entraîner des changements de distribution en raison du terme de gradient supplémentaire dans l'équation de diffusion. Le déplacement hors distribution entraînera en fin de compte une dégradation de la qualité de la production générée. Pour surmonter cet obstacle, le framework HD-Painter implémente un Reweighting Attention Score Guidance ou RASG, une méthode qui intègre de manière transparente une stratégie d'échantillonnage post-hoc dans la forme générale du composant DDIM. Il permet au framework de générer des résultats d'inpainting visuellement plausibles en guidant l'échantillon vers les latents alignés avec les invites et de les contenir dans leur domaine entraîné.

En déployant à la fois les composants RASH et PAIntA dans son architecture, le framework HD-Painter présente un avantage significatif par rapport aux modèles existants, notamment ceux de pointe, d'inpainting et de diffusion de texte en image, car il parvient à résoudre le problème existant de la négligence rapide. De plus, les composants RASH et PAIntA offrent une fonctionnalité plug and play, leur permettant d'être compatibles avec les modèles d'inpainting de base de diffusion pour relever les défis mentionnés ci-dessus. De plus, en mettant en œuvre une technologie de mélange itérative dans le temps et en tirant parti des capacités de modèles de diffusion haute résolution, le pipeline HD-Painter peut fonctionner efficacement pour une résolution d'inpainting allant jusqu'à 2K.

En résumé, le HD-Painter vise à apporter les contributions suivantes dans le domaine :

- Il vise à résoudre le problème de négligence rapide de l'arrière-plan et de la domination des objets à proximité rencontré par les cadres d'inpainting d'images guidés par texte en implémentant la couche Prompt Aware Introverted Attention ou PAIntA dans son architecture.

- Il vise à améliorer l'alignement du texte de la sortie en implémentant la couche Reweighting Attention Score Guidance ou RASG dans son architecture qui permet au framework HD-Painter d'effectuer un échantillonnage guidé post-hoc tout en empêchant les distributions hors décalage.

- Concevoir un pipeline efficace de complétion d'images guidées par texte, sans formation, capable de surpasser les cadres de pointe existants, et d'utiliser le cadre de super-résolution spécialisé dans l'inpainting, simple mais efficace, pour effectuer l'inpainting d'images guidées par texte jusqu'à une résolution de 2K.

HD-Painter : Méthode et Architecture

Avant d'examiner l'architecture, il est essentiel de comprendre les trois concepts fondamentaux qui constituent le fondement du framework HD-Painter : Inpainting d'images, conseils post-hoc dans les cadres de diffusion, et Inpainting des blocs architecturaux spécifiques.

Image Inpainting est une approche qui vise à combler les régions manquantes dans une image tout en garantissant l'attrait visuel de l'image générée. Les cadres d'apprentissage profond traditionnels implémentaient des méthodes utilisant des régions connues pour propager des fonctionnalités approfondies. Cependant, l'introduction de modèles de diffusion a entraîné l'évolution des modèles d'inpainting, en particulier les cadres d'inpainting d'images guidées par texte. Traditionnellement, un modèle de diffusion texte-image pré-entraîné remplace la région non masquée de la latente en utilisant la version bruitée de la région connue pendant le processus d'échantillonnage. Bien que cette approche fonctionne dans une certaine mesure, elle dégrade considérablement la qualité de la sortie générée puisque le réseau de débruitage ne voit que la version bruitée de la région connue. Pour surmonter cet obstacle, quelques approches visaient à affiner le modèle texte-image pré-entraîné afin de réaliser une inpainting d'image guidée par le texte. En implémentant cette approche, le cadre est capable de générer un masque aléatoire via concaténation puisque le modèle est capable de conditionner le cadre de débruitage sur la région non masquée.

Au fil du temps, les modèles traditionnels d'apprentissage en profondeur ont mis en œuvre des couches de conception spéciales pour une inpainting efficace, certains frameworks étant capables d'extraire efficacement des informations et de produire des images visuellement attrayantes en introduisant des couches de convolution spéciales pour traiter les régions connues de l'image. Certains frameworks ont même ajouté une couche d'attention contextuelle dans leur architecture pour réduire les lourdes exigences de calcul indésirables de l'attention de tous pour une inpainting de haute qualité.

Enfin, les méthodes de guidage post-hoc sont des méthodes d'échantillonnage par diffusion rétrospective qui guident la prédiction latente de l'étape suivante vers un objectif particulier de minimisation de fonction. Les méthodes de guidage post-hoc sont d'une grande aide lorsqu'il s'agit de générer du contenu visuel notamment en présence de contraintes supplémentaires. Cependant, les méthodes de guidage Post-hoc présentent un inconvénient majeur : elles sont connues pour entraîner des dégradations de la qualité d'image puisqu'elles ont tendance à décaler le processus de génération latente d'un terme de gradient.

En ce qui concerne l'architecture de HD-Painter, le framework formule d'abord le problème de complétion d'image guidée par le texte, puis introduit deux modèles de diffusion, à savoir le Stable Inpainting et Diffusion stable. Le modèle HD-Painter introduit ensuite les blocs PAIntA et RASG, et enfin nous arrivons à la technique de super résolution spécifique à l'inpainting.

Diffusion stable et peinture stable

La diffusion stable est un modèle de diffusion qui fonctionne dans l'espace latent d'un auto-encodeur. Pour la synthèse texte-image, le framework Stable Diffusion implémente une invite textuelle pour guider le processus. La fonction de guidage a une structure similaire à l'architecture UNet, et les couches d'attention croisée la conditionnent aux invites textuelles. De plus, le modèle Stable Diffusion peut effectuer une inpainting d’image avec quelques modifications et ajustements. Pour y parvenir, les caractéristiques de l'image masquée générée par l'encodeur sont concaténées avec le masque binaire réduit aux latents. Le tenseur résultant est ensuite entré dans l'architecture UNet pour obtenir le bruit estimé. Le framework initialise ensuite les filtres convolutifs nouvellement ajoutés avec des zéros tandis que le reste de UNet est initialisé à l'aide de points de contrôle pré-entraînés du modèle de diffusion stable.

La figure ci-dessus montre un aperçu du framework HD-Painter composé de deux étapes. Dans la première étape, le framework HD-Painter implémente la peinture d'images guidée par texte tandis que dans la deuxième étape, le modèle inpeint une super-résolution spécifique de la sortie. Pour remplir les régions de mission et rester cohérent avec l'invite de saisie, le modèle utilise un modèle de diffusion d'inpainting pré-entraîné, remplace les couches d'auto-attention par des couches PAIntA et implémente le mécanisme RASG pour effectuer un processus de diffusion vers l'arrière. Le modèle décode ensuite la latence finale estimée, ce qui donne une image peinte. HD-Painter implémente ensuite le modèle de diffusion super stable pour repeindre l'image de taille originale, et implémente le processus de diffusion vers l'arrière du cadre de diffusion stable conditionné sur l'image d'entrée basse résolution. Le modèle mélange les prédictions débruitées avec le codage de l'image originale après chaque étape dans la région connue et en dérive la latente suivante. Enfin, le modèle décode le latent et implémente le mélange de Poisson pour éviter les artefacts de bord.

Attention introvertie consciente ou PAIntA

Les modèles d'inpainting existants comme Stable Inpainting ont tendance à s'appuyer davantage sur le contexte visuel autour de la zone d'inpainting et à ignorer les invites d'entrée de l'utilisateur. Sur la base de l'expérience utilisateur, ce problème peut être classé en deux classes : la dominance des objets à proximité et la dominance de l'arrière-plan. Le problème de la domination du contexte visuel sur les invites de saisie pourrait être le résultat de la nature uniquement spatiale et sans invite des couches d'auto-attention. Pour résoudre ce problème, le framework HD-Painter introduit le Prompt Aware Introverted Attention ou PAIntA qui utilise des matrices d'attention croisée et un masque d'inpainting pour contrôler la sortie des couches d'auto-attention dans la région inconnue.

Le composant Prompt Aware Introverted Attention applique d’abord des couches de projection pour obtenir la clé, les valeurs et les requêtes ainsi que la matrice de similarité. Le modèle ajuste ensuite le score d'attention des pixels connus pour atténuer la forte influence de la région connue sur la région inconnue, et définit une nouvelle matrice de similarité en exploitant l'invite textuelle.

Guide de repondération du score d'attention ou RASG

Le framework HD-Painter adopte une méthode de guidage d'échantillonnage post-hoc pour améliorer encore plus l'alignement de la génération avec les invites textuelles. Outre une fonction objective, l'approche de guidage d'échantillonnage post-hoc vise à exploiter les propriétés de segmentation à vocabulaire ouvert des couches d'attention croisée. Cependant, cette approche de guidage post-hoc vanille a le potentiel de déplacer le domaine de diffusion latent, ce qui pourrait dégrader la qualité de l'image générée. Pour résoudre ce problème, le modèle HD-Painter implémente le mécanisme Reweighting Attention Score Guidance ou RASG qui introduit un mécanisme de repondération de gradient entraînant la préservation du domaine latent.

HD-Painter : Expériences et résultats

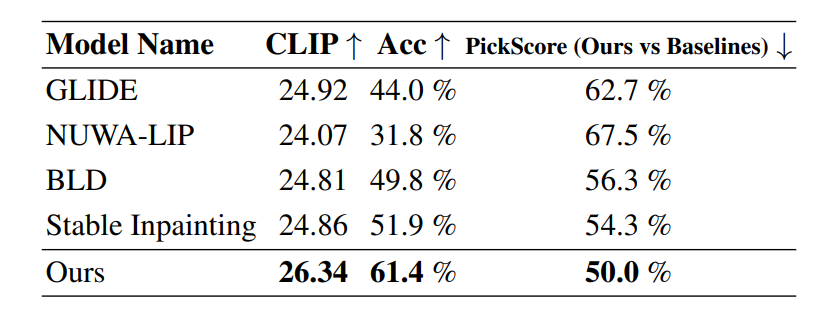

Pour analyser ses performances, le framework HD-Painter est comparé aux modèles de pointe actuels, notamment Stable Inpainting, GLIDE et BLD ou Blended Latent Diffusion sur 10000 XNUMX échantillons aléatoires où l'invite est sélectionnée comme étiquette du masque d'instance sélectionné.

Comme on peut l'observer, le framework HD-Painter surpasse les frameworks existants sur trois métriques différentes par une marge significative, en particulier l'amélioration de 1.5 points sur la métrique CLIP et la différence dans le score de précision généré d'environ 10 % par rapport aux autres méthodes de pointe. .

En continuant, la figure suivante montre la comparaison qualitative du framework HD-Painter avec d'autres frameworks d'inpainting. Comme on peut l'observer, d'autres modèles de base reconstruisent les régions manquantes dans l'image comme une continuation des objets de région connus sans tenir compte des invites ou génèrent un arrière-plan. D'autre part, le framework HD-Painter est capable de générer les objets cibles avec succès grâce à l'implémentation des composants PAIntA et RASG dans son architecture.

Réflexions finales

Dans cet article, nous avons parlé de HD-Painter, une approche d'inpainting haute résolution guidée par texte libre qui répond aux défis rencontrés par les cadres d'inpainting existants, notamment la négligence rapide et la domination des objets à proximité et en arrière-plan. Le framework HD-Painter implémente une couche Prompt Aware Introverted Attention ou PAIntA, qui utilise des informations d'invite pour améliorer les scores d'auto-attention, ce qui aboutit finalement à une meilleure génération d'alignement de texte.

Pour améliorer encore davantage la cohérence de l'invite, le modèle HD-Painter introduit une approche de repondération du score d'attention ou RASG qui intègre une stratégie d'échantillonnage post-hoc dans la forme générale du composant DDIM de manière transparente pour éviter les changements latents hors distribution. De plus, le framework HD-Painter introduit une technique spécialisée de super-résolution personnalisée pour l'inpainting qui entraîne une extension à des échelles plus grandes et permet au framework HD-Painter de compléter les régions manquantes de l'image avec une résolution allant jusqu'à 2K.