Angle d'Anderson

Les filtres de beauté sont un outil potentiel d'attaque Deepfake

Les filtres de beauté ne se contentent plus de masquer les imperfections : ils permettent aux deepfakes et aux morphings de visage de passer inaperçus aux yeux des systèmes de détection. Une nouvelle étude montre que même des effets de lissage subtils perturbent les détecteurs d'IA, donnant l'impression que les fausses images sont réelles et que les vraies semblent fausses. Si cette tendance se poursuit, les filtres de beauté pourraient être soumis à des restrictions dans des contextes à enjeux élevés, des contrôles aux frontières aux appels Zoom en entreprise.

Dans un article universitaire de 2024 collaboration Entre l'Espagne et l'Italie, des chercheurs ont constaté que 90 % des femmes de 18 à 30 ans utilisaient des filtres de beauté avant de publier des images sur les réseaux sociaux. En ce sens, les filtres de beauté sont des méthodes algorithmiques ou assistées par l'IA permettant de modifier l'apparence du visage afin de l'améliorer soi-disant par rapport à la source originale.

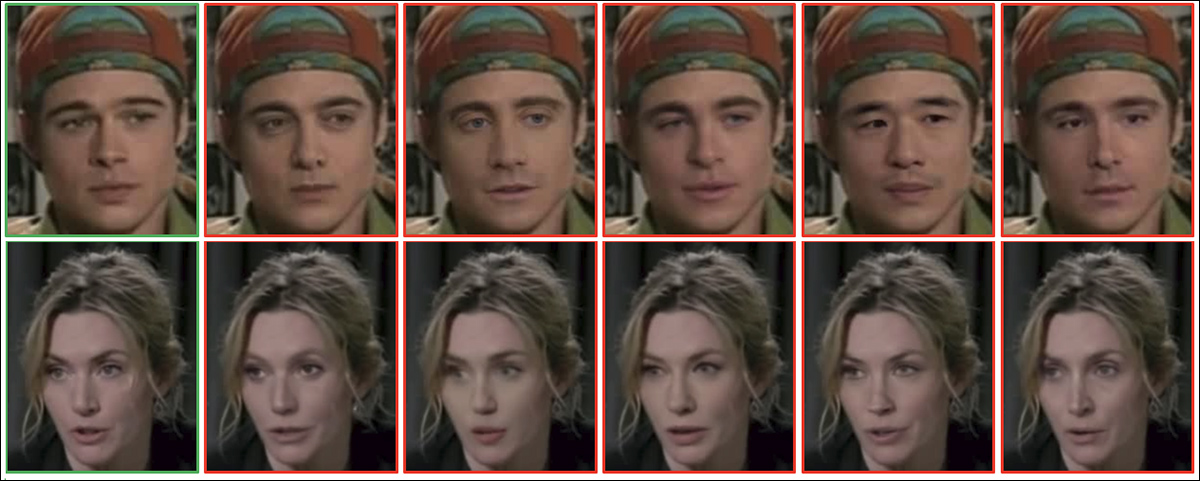

Étude de 2024 : exemples de visages féminins (à gauche) et masculins (à droite) présentés avant et après le filtrage esthétique. Ce filtre modifie des caractéristiques telles que le teint, les yeux, le nez, les lèvres, le menton et les pommettes pour améliorer l'attrait perçu. Source : https://arxiv.org/pdf/2407.11981

De tels filtres sont également largement disponibles en tant que fonctionnalités natives ou complémentaires dans les systèmes vidéo populaires, notamment Snapchat et Zoom, offrant la possibilité de lisser la peau « imparfaite » et même de modifier l'âge du sujet, jusqu'au point où l'identité pourrait être considérée comme substantiellement modifiée :

Cliquez pour jouer : trois femmes désactivent leurs filtres « d'embellissement » vidéo, révélant à quel point leurs physionomies sont altérées par les algorithmes ou l'IA. Source : https://www.youtube.com/watch?v=gtCpea_5qxw

Le phénomène semble avoir atteint son point de saturation dès que la technologie est devenue relativement mature ; un 2020 étude Une étude de la City University de Londres a révélé que 90 % des jeunes utilisateurs de Snapchat aux États-Unis, en France et au Royaume-Uni utilisaient des filtres dans leurs applications, tandis que Meta rapportait que plus de 600 millions de jeunes avaient déjà utilisé des filtres sur Facebook ou Instagram.

Explorant les effets néfastes de ces filtres sur la santé mentale, une étude de Psychology Today Ecojustice Il a été constaté que parmi les personnes étudiées, 90 % des jeunes femmes, âgées en moyenne de 20 ans, utilisaient des filtres ou retouchaient leurs photos. Les filtres les plus populaires étaient ceux utilisés pour uniformiser le teint, donner un aspect bronzé, blanchir les dents et même affiner la silhouette.

Face Off

Les filtres faciaux devraient bénéficier de la norme 2025 révolution dans la synthèse vidéo, et plus généralement de l'intérêt continu pour ce secteur de recherche, la mesure dans laquelle nous pouvons nous « recréer » ou nous réimaginer dans des conversations vidéo en direct va de plus en plus à l'encontre des préoccupations de la communauté de la sécurité concernant les tentatives frauduleuses ou techniques criminelles de deepfake vidéo.

L’un des problèmes est que la gamme de tests « faciles » développé ces dernières années pour révéler un deepfaker vidéo, qui pourrait chercher à frauder de grosses sommes d'argent dans un contexte d'entreprise, deviennent inévitablement moins efficaces à mesure que ces talons d'Achille sont pris en compte dans les données de formation et au moment de l'inférence :

Cliquez pour jouer : il y a trois ou quatre ans, agiter une main devant un visage deepfalked était un test fiable pour les appels vidéo, mais nous pouvons voir que les efforts dédiés de la part de TikTok font des percées profondes dans les « tells » classiques. Sources : Ibid et https://archive.is/mofRV#wavehands

Plus grave encore, l'utilisation généralisée de filtres d'embellissement qui modifient/altèrent le visage brouille les pistes pour une nouvelle génération émergente de détecteurs de deepfakes chargés d'éloigner les imposteurs des conversations vidéo en salle de conférence et des victimes potentielles vulnérables. fraude par « enlèvement » et « imposteur ».

Il est plus facile de rendre un deepfake convaincant, qu'il s'agisse d'une photo ou d'une vidéo, si la résolution de l'image est faible ou l'image est en quelque sorte dégradée, puisque le système de falsification sous-jacent peut cacher ses propres défauts derrière ce qui semble être des problèmes de connectivité ou de plate-forme.

En effet, les filtres d'embellissement les plus populaires suppriment certains des éléments les plus utiles pour identifier les deepfakes vidéo, tels que la texture de la peau et d'autres zones de détails du visage - et il convient de considérer que plus un visage est ancien, plus il est susceptible de contenir de tels détails, et par conséquent, l'utilisation de filtres anti-vieillissement de vanité peut être une tentation particulière dans un tel cas.

Si un look de style « Android » sans détails est à la mode, les détecteurs de deepfakes peuvent manquer du matériel dont ils ont besoin pour faire la distinction entre les images et les vidéos réelles et fausses. Source : https://www.instagram.com/reel/DMyGerPtTPF/?hl=fr

La Royal Society de fin 2024 papier Ce qui est beau est toujours bon : l'effet de halo d'attractivité à l'ère des filtres de beauté ont confirmé que l’utilisation de filtres augmente universellement l’attractivité générale chez les deux sexes (bien qu’une attractivité accrue tende à diminuer l’estimation générale de l’intelligence chez les femmes filtrées par la beauté).

Il est donc juste de dire qu’il s’agit d’une technologie populaire, qu’elle fonctionne et que ce serait un véritable choc culturel si elle était soudainement soumise à des limitations de sécurité ou interdite dans divers contextes.

Néanmoins, à une époque où les deepfakes vidéo menacent de devenir indiscernables des participants vidéo authentiques, tant en apparence qu'en paroles, il est possible que le « bruit » global des filtres de beauté doive être atténué à l'avenir, pour des raisons de sécurité.

Les criminels lisses

La question a été récemment étudiée dans un nouveau papier de l'Université de Cagliari en Italie, intitulé Beauté trompeuse : évaluation de l'impact des filtres de beauté sur la détection des attaques de deepfake et de morphing.

Dans la nouvelle étude, les chercheurs ont appliqué des filtres de beauté aux visages de deux ensembles de données de référence et ont testé plusieurs détecteurs d'attaques de deepfake et de morphing sur les images originales et modifiées.

Dans presque tous les cas, la précision de la détection a diminué après l'embellissement ; les baisses les plus spectaculaires se sont produites lorsque les filtres ont atténué les rides, éclairci le teint ou subtilement remodelé les traits du visage. Ces modifications ont supprimé ou déformé les indices mêmes sur lesquels reposent les modèles de détection.

Par exemple, le modèle le plus performant sur MorphDB a perdu plus de 9 % de précision après filtrage, et le problème a persisté sur plusieurs architectures de détection, indiquant que les systèmes actuels ne sont pas robustes aux améliorations cosmétiques courantes.

Les auteurs concluent:

« Les filtres [d'embellissement] constituent une menace pour l'intégrité des systèmes d'authentification biométrique et d'analyse médico-légale, ce qui fait de la détection robuste des attaques deepfake et morph dans de telles conditions un défi ouvert critique.

« Les travaux futurs devraient donner la priorité au développement de systèmes de détection de manipulation numérique qui soient robustes à de telles altérations subtiles du monde réel, qu'elles soient malveillantes ou non, afin de garantir une reconnaissance d'identité et une vérification de contenu fiables dans des contextes quotidiens et critiques pour la sécurité. »

Méthode et données

Pour évaluer comment les filtres de beauté affectent le deepfake et détection de morphing, les chercheurs ont appliqué un filtre de lissage progressif et testé les résultats sur deux réseaux neuronaux convolutifs de référence (CNN) bien associé au problème cible : AlexNet et VGG19.

Chacun des deux ensembles de données de référence testés contenait des exemples de manipulations faciales appropriées. Le premier était CelebDF, un benchmark vidéo à grande échelle comprenant 590 clips réels et 5 639 clips falsifiés, créés grâce à des techniques avancées d'échange de visages. La collection offre une grande variété de conditions d'éclairage, de poses de tête et d'expressions naturelles pour 59 individus, ce qui la rend idéale pour évaluer la résistance des détecteurs de deepfakes dans des scénarios médiatiques réels.

Exemples d'images de visages affectés, de CelebDF. Source : https://github.com/yuezunli/celeb-deepfakeforensics

Le second était AMSL (inscription requise), un ensemble de données d'attaque morphing construit à partir du Face Research Lab London collection, contenant des visages réels et synthétiques. L'ensemble de données inclut des expressions neutres et souriantes de 102 sujets et a été structuré pour refléter les défis réalistes des systèmes d'authentification biométrique utilisés dans des contextes tels que le contrôle aux frontières.

Images de l'ensemble de données source Face Research Lab London (FRLL), utilisé dans AMSL. Source : https://figshare.com/articles/dataset/Face_Research_Lab_London_Set/5047666?file=8541955

Chaque réseau a été formé sur 80 % de l'ensemble de données deepfake ou morphing, les 20 % restants étant utilisés pour validationPour tester la robustesse face à l'embellissement, les chercheurs ont ensuite appliqué un filtre de lissage progressif aux images de test, augmentant le rayon de flou de 3 % à 5 % de la hauteur du visage :

Exemples de visages issus des jeux de données CelebDF (en haut) et AMSL (en bas), présentés avant et après application d'un filtre de beauté lissant. Le rayon du filtre a été ajusté en fonction de la hauteur du visage, avec c = 3 % et c = 5 % produisant des effets progressivement plus marqués.

En ce qui concerne les métriques, chaque modèle a été évalué à l’aide d’un taux d’erreur égal (EER) sur les échantillons d'essai originaux et améliorés. L'analyse a également rapporté le taux d'erreur de classification de présentation authentique (BPCER), ou taux de faux positifs, et le taux d'erreur de classification de présentation d'attaque (APCER), ou taux de faux négatifs, en utilisant le seuil défini sur les données d'origine.

Visages morphés issus du jeu de données AMSL.

Pour évaluer davantage les performances, l'aire sous la courbe ROC (ASC) et les distributions de scores pour les images réelles et fausses ont été examinées.

Tests

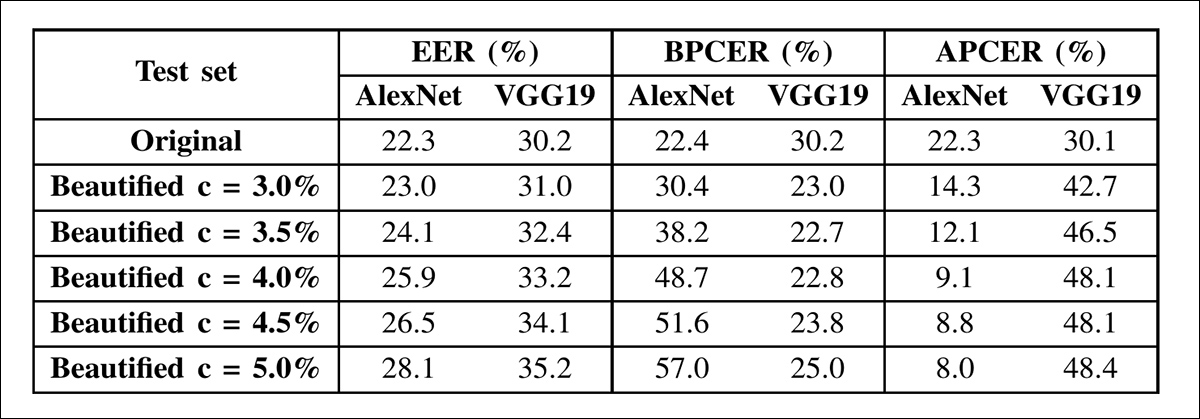

Dans les résultats de détection des deepfakes, les deux réseaux ont montré une augmentation des taux d'erreur égaux à mesure que l'intensité de l'embellissement augmentait. L'EER d'AlexNet est passé de 22.3 % sur les images originales à 28.1 % au niveau de lissage maximal, tandis que celui de VGG19 est passé de 30.2 % à 35.2 %. La baisse de performance a suivi des schémas différents dans chaque cas :

Résultats de détection de deepfakes sur le jeu de données CelebDF avec AlexNet et VGG19. Les deux modèles ont été testés sur des images originales et embellies, avec des niveaux croissants de lissage facial. Les indicateurs présentés incluent le taux d'erreur égal (EER), le taux d'erreur de classification de présentation authentique (BPCER) et le taux d'erreur de classification de présentation d'attaque (APCER), en utilisant des seuils fixés à partir du jeu de test initial. La précision de détection a diminué avec l'intensité de l'embellissement, bien que le schéma de dégradation ait varié selon les architectures.

Avec l'augmentation de l'embellissement, AlexNet est devenu plus susceptible de confondre les vrais visages avec les faux, comme en témoigne l'augmentation constante de son taux de faux positifs (BPCER). VGG19, en revanche, a eu du mal à détecter les faux visages, avec un taux de faux négatifs croissant (APCER). Les deux modèles ont réagi différemment aux filtres, ce qui indique que même des architectures bien connues peuvent échouer de différentes manières face à des modifications esthétiques.

Pour mieux comprendre ces résultats, les chercheurs ont appliqué le filtre d'embellissement séparément aux images réelles et truquées et ont mesuré son impact sur les performances de détection. Cette analyse, présentée dans le tableau des résultats ci-dessous, clarifie la source de la vulnérabilité de chaque modèle :

Précision de détection pour AlexNet et VGG19 avec embellissement partiel sur le jeu de données CelebDF. Le tableau présente trois scénarios : image réelle embellie vs image truquée embellie (F-Réel vs F-Faux) ; image réelle embellie vs image truquée originale (F-Réel vs O-Faux) ; et image réelle originale vs image truquée embellie (O-Réel vs F-Faux). Une diminution de la précision indique une baisse des performances du détecteur. AlexNet était particulièrement affecté par l'embellissement des images réelles, tandis que VGG19 était particulièrement affecté par l'embellissement des images truquées.

Pour AlexNet, les performances de détection ont diminué lorsque les images réelles ont été embellies, mais se sont améliorées lorsque seules les fausses images ont été lissées. Pour VGG19, les performances ont légèrement augmenté avec les images réelles embellies, mais se sont dégradées lorsque les deepfakes ont été filtrés. Dans tous les cas, embellissement plus fort, précision réduite.

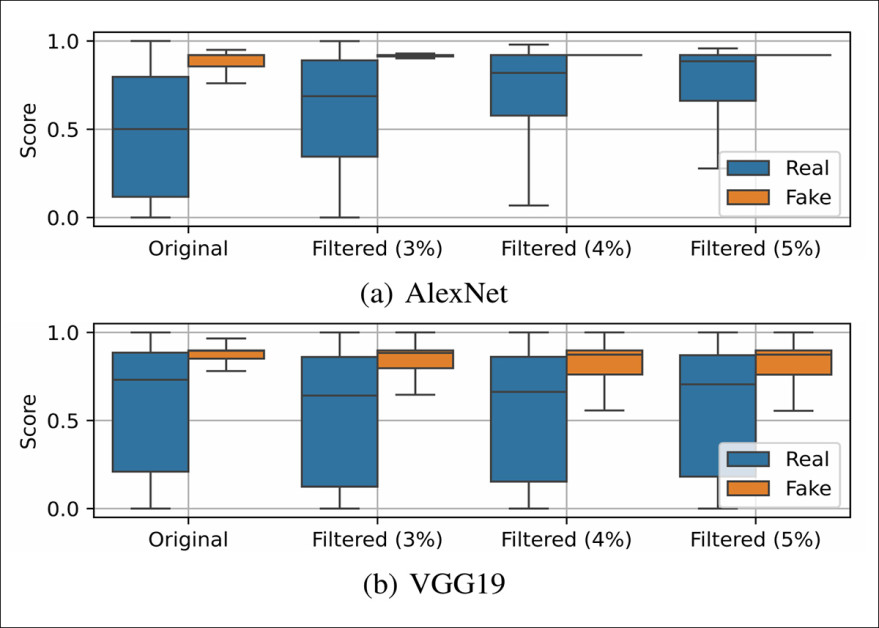

Box-plots montrant les distributions des scores de sortie d'AlexNet et de VGG19 sur des échantillons réels et fictifs du jeu de données CelebDF, avec des niveaux d'embellissement croissants. À mesure que le lissage s'intensifie, les distributions des scores des images réelles et fictives deviennent moins séparables, ce qui indique une fiabilité de détection réduite. AlexNet devient moins fiable pour identifier les vrais visages, tandis que VGG19 est plus susceptible de mal classer les faux.

L'embellissement a permis d'uniformiser les scores de sortie d'AlexNet entre les échantillons réels et fictifs, tandis que VGG19 a montré une plus grande dispersion au sein de chaque classe. Malgré ces effets contrastés sur la variabilité des scores, les deux modèles ont perdu en précision. Pour AlexNet, les scores des visages réels se sont rapprochés de ceux des deepfakes. Pour VGG19, les scores des images réelles et fictives ont commencé à se chevaucher, réduisant la capacité du modèle à les distinguer.

Le papier déclare:

Ces résultats ont des implications importantes et révèlent la nécessité d'envisager l'utilisation potentielle de filtres d'embellissement dans la détection des deepfakes, car ceux-ci peuvent avoir un impact imprévisible sur les performances. En particulier, les différentes architectures réagissent différemment aux manipulations faciales, même si ces manipulations ne visent pas à tromper.

« Par exemple, en fonction du détecteur de deepfakes spécifique, les filtres d'embellissement pourraient modifier considérablement la sortie, rendant les images réelles identifiées comme fausses et, plus critique encore, permettant aux deepfakes de tromper la détection.

« Il est donc nécessaire de se concentrer sur le développement de détecteurs plus robustes à de telles altérations subtiles, pas strictement malveillantes, qui pourraient servir de camouflage à des manipulations malveillantes de deepfake. »

Dans le scénario d'attaque par morphing, une image synthétique a été créée en combinant les traits du visage de deux individus. Cette image a été utilisée pour tromper les systèmes de reconnaissance faciale, permettant ainsi d'authentifier les deux identités sources comme étant la même personne. De telles attaques sont particulièrement pertinentes dans les environnements de sécurité, où les systèmes biométriques sont utilisés. pourrait être induit en erreur d'accepter l'image transformée à des fins d'identification officielle.

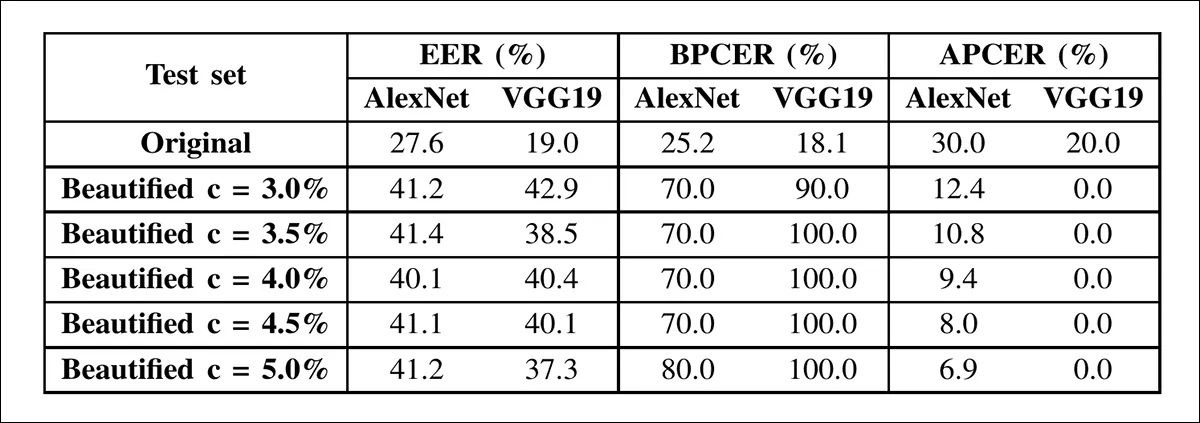

Le tableau ci-dessus montre les résultats de détection d'attaque de morphing sur les images AMSL avant et après l'embellissement, les deux réseaux montrant de fortes augmentations d'erreur à mesure que l'intensité du lissage augmente.

Dans le scénario d'attaque par morphing, les performances ont été plus fortement dégradées que dans la détection de deepfakes. L'EER d'AlexNet est passé de 27.6 % à 41.2 %, et celui de VGG19 de 19.0 % à 37.3 %, principalement en raison de faux positifs : des visages authentiques classés à tort comme morphing. Avec un rayon de lissage de 3 %, le taux de faux positifs de VGG19 a atteint 90 %.

Ce schéma s'est maintenu lorsque les filtres ont été appliqués de manière sélective. Le lissage des visages réels a dégradé la détection, tandis que le lissage des visages transformés a amélioré les résultats. À mesure que le lissage s'intensifiait, les deux réseaux ont montré une séparation réduite entre les scores réels et fictifs, le VGG19 devenant particulièrement instable.

Ces résultats, indiquent les auteurs, suggèrent que les filtres de beauté pourraient aider les morphes à échapper à la détection encore plus efficacement que les deepfakes, ce qui soulève de graves préoccupations en matière de sécurité.

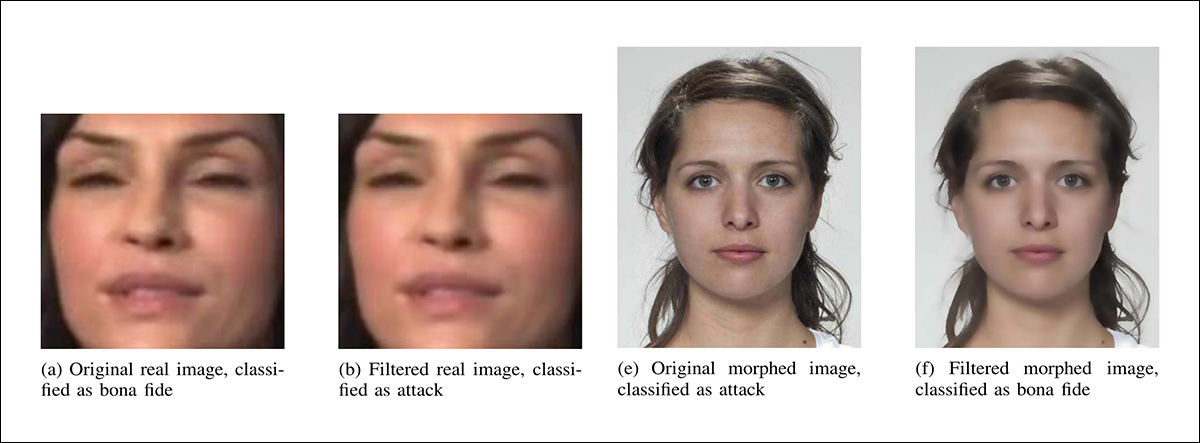

Exemples partiels (faute de place) illustrant comment un embellissement minimal (rayon de lissage de 3 %) a modifié les classifications d'AlexNet. À gauche, une image réelle est classée à tort comme une attaque après filtrage, et à droite, une image transformée est classée à tort comme authentique après filtrage.

Enfin, les chercheurs ont découvert que même des filtres d’embellissement légers peuvent considérablement dégrader les performances des détecteurs de deepfake et de morphing de pointe.

L'impact variait selon l'architecture : AlexNet affichait un déclin progressif et VGG19 s'effondrait sous un filtrage minimal. Ces filtres étant courants et non intrinsèquement malveillants, leur capacité à dissimuler les attaques représente, selon les auteurs, une menace concrète, notamment pour les systèmes biométriques. L'article souligne la nécessité de modèles de détection robustes face à de telles manipulations d'images subtiles.

Conclusion

L'une des raisons pour lesquelles il peut être difficile de former des systèmes de détection de deepfakes capables d'ignorer les filtres d'embellissement est le manque de matériel contrasté ; en fin de compte, la version « embellie » est celle qui est largement diffusée et, contrairement à la vidéo que nous avons intégrée plus tôt à titre d'illustration, il est très rare qu'une image « avant » soit appliquée.

Un autre obstacle est que de nombreux filtres effectuent exactement le type de lissage typique des opérations de compression lors de l'enregistrement d'images ou de la compression de vidéos (une aubaine pour la bande passante des fournisseurs, en plus d'être une cure de jouvence numérique pour ceux qui utilisent le filtre).

Le secteur de la recherche sur la détection des deepfakes est déjà profondément engagé dans la lutte contre les cas de dégradation d’images dans le monde réel en raison de problèmes tels que des caméras de mauvaise qualité, une compression excessive ou une connectivité réseau saccadée – toutes ces conditions étant un avantage direct pour les fraudeurs deepfake qui sont obligés de faire beaucoup plus d’efforts dans un scénario de haute qualité et de haute résolution.

Il semble probable que la question de savoir si les filtres d'embellissement finissent par être menacés en tant que problème de sécurité dépende de la mesure dans laquelle ils constituent un obstacle aux méthodes de filtrage deepfake, ou finissent par constituer une sorte de de facto un pare-feu qui profite davantage aux malfaiteurs qu’à ceux qui les combattent.

Première publication le mercredi 24 septembre 2025