Angle d'Anderson

Une méthode « zen » pour empêcher les modèles de langage d'halluciner

Demander à ChatGPT de vérifier une réponse aléatoire avant de résoudre un problème réel l'incite à réfléchir davantage et à trouver la bonne réponse plus souvent – même si la réponse « aléatoire » initiale n'a rien à voir avec votre requête réelle.

Un nouvel article intéressant provenant de Chine a développé une méthode très peu coûteuse pour empêcher les modèles de langage tels que ChatGPT de hallucineret pour améliorer la qualité des réponses : faire en sorte que le modèle vérifie les faits de la réponse à une question. totalement sans rapport Première question :

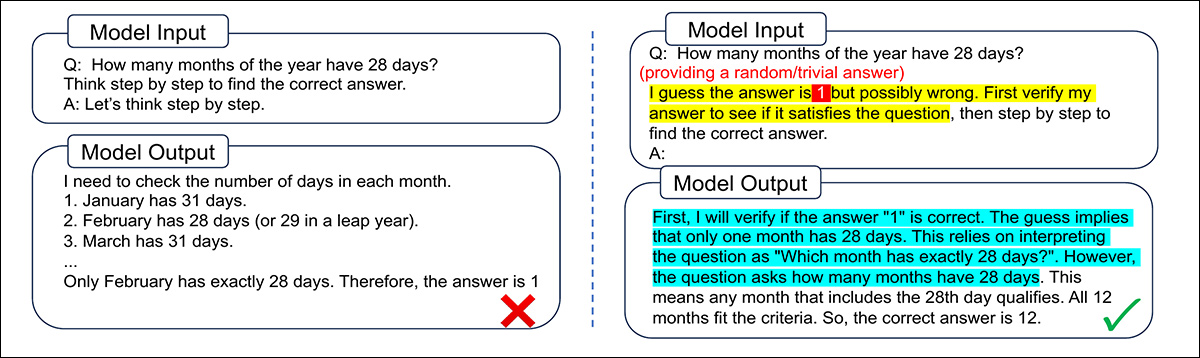

Voici un exemple de question sans rapport avec le sujet initial, susceptible de « libérer l'esprit » d'un étudiant en LLM et de l'aider à se concentrer sur une véritable question ultérieure. Source

Ce Claque zen est une méthode incroyablement économique pour améliorer les performances, comparée à d'autres méthodes plus complexes, telles que réglage fin, création de prompts et échantillonnage parallèleet cela fonctionne aussi bien sur les modèles à code source ouvert que fermé, ce qui indique la découverte d'un trait de caractère fondamental commun à de multiples architectures LLM (plutôt qu'une particularité fragile propre à des supports ou méthodes de formation spécifiques).

Les auteurs décrivent les économies d'échelle possibles en améliorant la production de cette manière spartiate* :

Pour une mise en œuvre nécessitant un minimum de connaissances préalables, VF n'a besoin de fournir qu'une réponse aléatoire/triviale à l'invite. Le processus de vérification s'avère avoir beaucoup moins de jetons de sortie qu'un chemin CoT ordinaire, voire parfois aucun processus de vérification explicite, ce qui [nécessite] très peu de calculs supplémentaires lors des tests.

Lors des tests, cette approche – baptisée Vérification préalable (VF) – a pu améliorer les réponses dans une diversité de tâches, y compris le raisonnement mathématique, sur des plateformes open source et commerciales.

L'efficacité de cette technique tient peut-être en partie à la manière dont les modèles de langage absorbent et s'approprient les tendances de la psychologie humaine, de sorte qu'une question directe peut rendre le modèle « défensif » et « nerveux », tandis qu'une demande de vérification du travail d'autrui ne sollicite pas ces « instincts de survie ».

L'idée principale est que vérifier une réponse demande moins d'efforts plutôt que d'en générer un à partir de zéro, et peut déclencher un raisonnement différent qui complète le raisonnement standard chaîne de pensée.

Inciter le modèle à critiquer une réponse donnée (c’est-à-dire une réponse à laquelle le modèle n’a pas participé) peut également activer une forme de pensée critique qui contribue à éviter une confiance excessive dans les premières impressions du modèle.

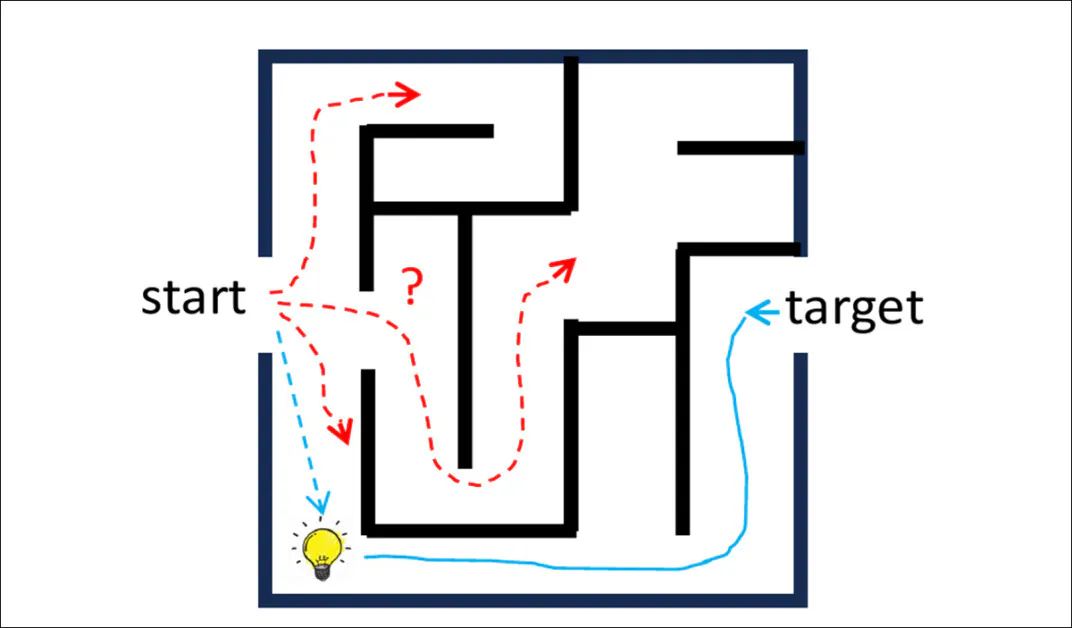

L'ouvrage caractérise le processus en termes de chemin de raisonnement inverse:

Partir d'une réponse proposée et remonter le fil du raisonnement pour revenir à la question peut révéler des raccourcis ou des intuitions plus difficiles à déceler en partant uniquement du problème. Ce « chemin inversé » peut suivre une trajectoire plus simple et fournir des informations complémentaires au raisonnement classique.

Les chercheurs ont également concrétisé le concept central en Iter-VF, une méthode de mise à l'échelle séquentielle par test temporel qui affine itérativement les réponses, évitant ainsi le problème d'accumulation d'erreurs commun aux stratégies d'auto-correction souvent présentes dans les architectures LLM.

Le nouveau travail est intitulé Demander aux titulaires d'un LLM de vérifier au préalable, c'est presque un repas gratuit., et provient de deux chercheurs du département de génie électronique de l'université Tsinghua de Pékin.

Méthode

L'idée centrale de ce nouveau travail est d'inverser le raisonnement habituel des modèles de langage. Au lieu de demander au modèle de résoudre un problème à partir de zéro, on lui fournit d'abord une réponse candidate (souvent incorrecte ou arbitraire) et on lui demande de vérifier si cette réponse est plausible.

Cela incite le modèle à raison à l'enversLe modèle remonte la chaîne de réponse, de la solution proposée à la question posée. Une fois la vérification terminée, il résout ensuite le problème initial comme d'habitude.

Ce renversement, affirme l'article, réduit les erreurs d'inattention et encourage un mode de raisonnement plus réflexif, aidant ainsi le LLM à découvrir une structure cachée et à éviter les hypothèses trompeuses.

Comme le montrent les exemples ci-dessous, même en incitant le modèle à vérifier une supposition manifestement erronée comme «10» peut l'aider à se remettre d'une logique erronée et à surpasser les invites de raisonnement classiques :

Inciter le modèle à vérifier d'abord une réponse proposée l'aide à repérer les incohérences et à aborder le problème avec plus de rigueur. Dans cet exemple, l'approche standard aboutit à une solution fluide mais incorrecte, tandis que l'option « Vérification préalable » génère une structure logique plus claire et le résultat correct.

Face à de nombreux problèmes concrets, il est difficile de fournir une hypothèse au modèle, surtout lorsque la tâche est ouverte, comme l'écriture de code ou l'appel d'une API. C'est pourquoi, pour une meilleure adaptation, la méthode fournit d'abord sa meilleure réponse habituelle, puis la réintègre au format de vérification préalable. Ainsi, le modèle vérifie et améliore son propre résultat.

Lorsqu'on demande au modèle de vérifier ses propres résultats précédents, il repère l'erreur dans son raisonnement et corrige la solution. L'invite « Vérification préalable » l'aide à se concentrer sur l'erreur spécifique plutôt que de la répéter.

Cette approche constitue ce qui précèdeentioned Iter-VFLe modèle répète ce cycle, affinant sa réponse à chaque itération, sans nécessiter de réentraînement ni d'outils spécifiques. Contrairement à d'autres stratégies d'autocorrection, qui peuvent accumuler les raisonnements antérieurs et risquer de perturber le modèle, Iter-VF ne prend en compte que la réponse la plus récente, ce qui contribue à la clarté de son raisonnement.

Données et tests

Les auteurs évaluent la méthode dans quatre domaines : tâches de raisonnement général, où VF est initialisé avec une supposition triviale ; tâches urgentes, où Iter-VF est comparé à des méthodes de mise à l'échelle concurrentes ; problèmes ouverts comme le codage et les appels d'API, où VF utilise la réponse précédente du modèle ; et LLM commerciaux à code source fermé, où les étapes de raisonnement internes sont inaccessibles.

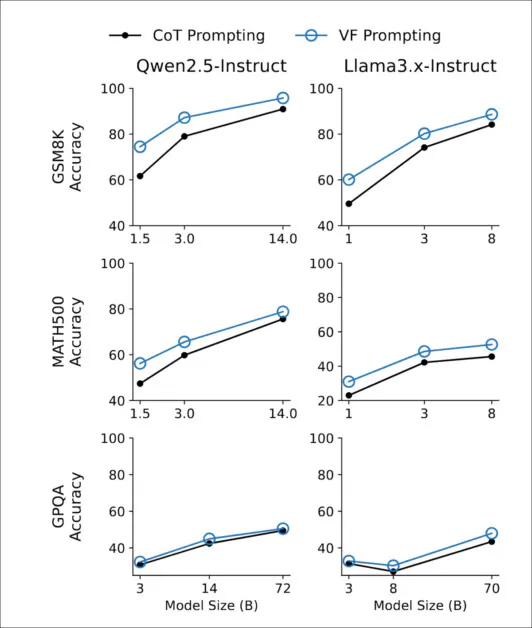

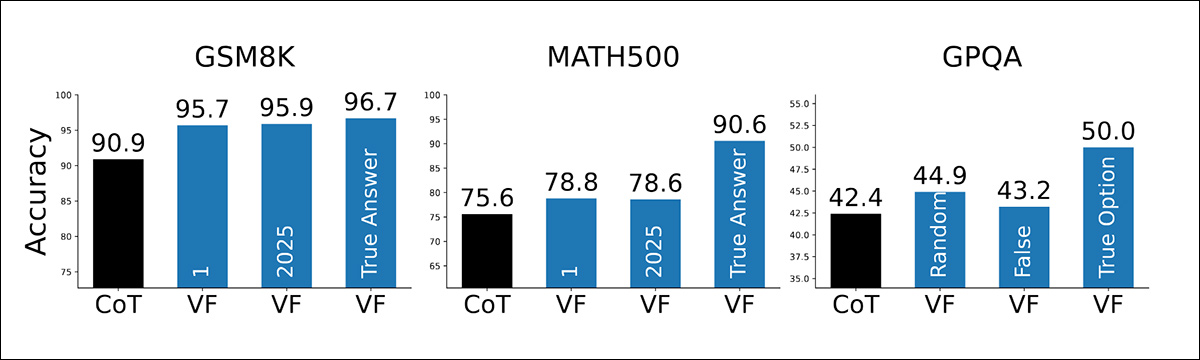

Pour tester la méthode, les chercheurs ont utilisé trois critères de raisonnement : GSM8K et MATH500 pour les problèmes de mathématiques ; et GPQA-Diamant pour les questions scientifiques de niveau supérieur.

Dans chaque cas, le modèle a reçu soit une estimation triviale, soit «1 ' Pour les réponses numériques, ou une option à choix multiple mélangée aléatoirement, comme point de départ de la vérification. Aucun paramétrage particulier ni connaissance préalable n'ont été ajoutés, et la référence de comparaison était une séquence de raisonnement standard sans exemple préalable.

Les tests ont été effectués sur une gamme complète de Qwen2.5 et Lama3 Modèles optimisés par instructions, de 1B à 72B (paramètres) de taille. Les modèles Qwen utilisés étaient Qwen2.5-1.5B-Instruire, Qwen2.5-3B-Instruire, Qwen2.5-14B-Instruire et Qwen2.5-72B-InstruireLes variantes de Llama3 étaient Llama3.2-1B-Instruction, Llama3.2-3B-Instruction, Llama3.1-8B-Instruction et Llama3.3-70B-Instruction.

Comme le montre ci-dessous, l'amélioration apportée par l'invite « Vérification en premier » est restée constante à toutes les échelles de modèles, avec des gains clairs visibles même à 1 milliard de paramètres et se poursuivant jusqu'à 72 milliards :

Sur toutes les tailles de modèles des familles Qwen2.5 et Llama3, l'invite Verification-First a systématiquement surpassé l'invite standard de chaîne de pensée sur GSM8K, MATH500 et GPQA-Diamond.

L'effet s'est avéré le plus marqué sur les benchmarks mathématiques exigeants en calcul, tels que GSM8K et MATH500, où la vérification d'une réponse erronée a favorisé un raisonnement plus rigoureux que la résolution du problème à partir de zéro. Sur GPQA-Diamond, qui repose davantage sur les connaissances acquises que sur la structure déductive, l'avantage était plus faible mais constant.

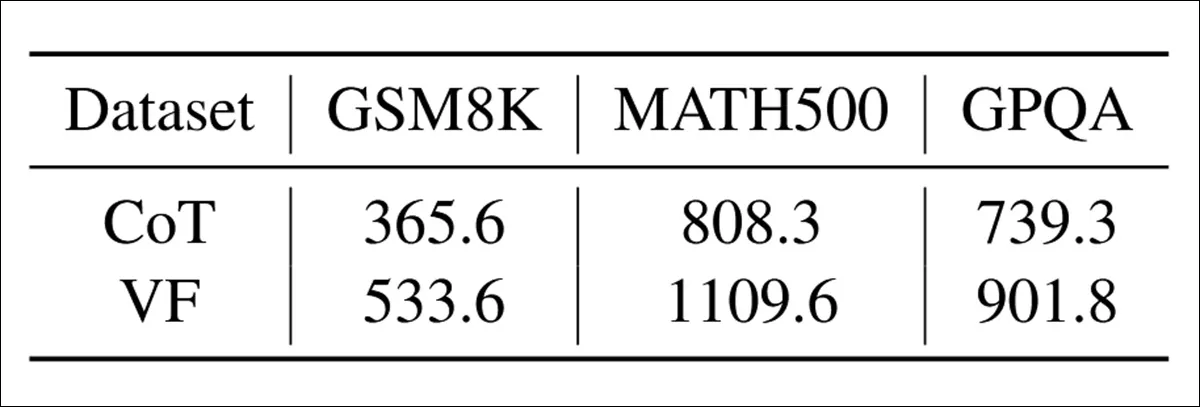

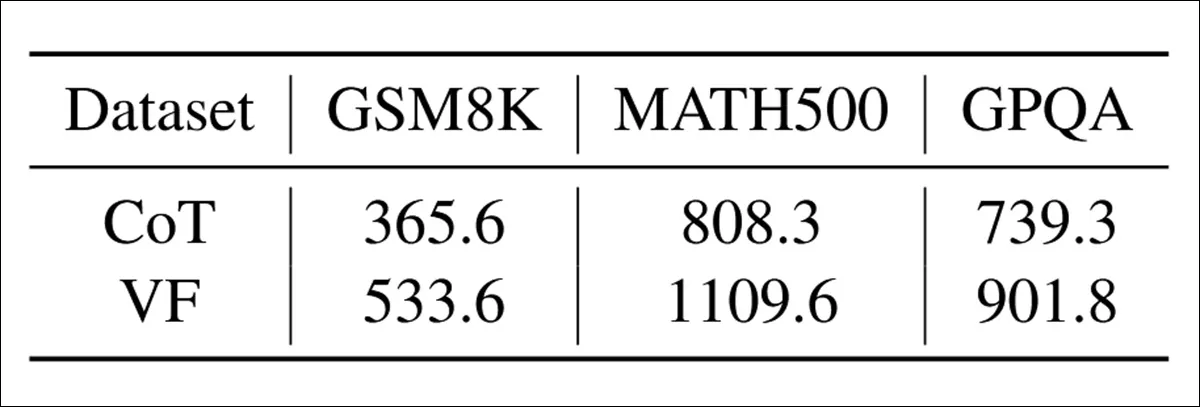

Le coût de calcul de la vérification en premier était modeste : dans le tableau ci-dessous, nous pouvons constater que la génération d’une étape de vérification a ajouté environ 20 à 50 % de jetons de sortie supplémentaires par rapport à l’invite de chaîne de pensée standard :

Le nombre moyen de jetons de sortie générés sous chaque méthode d'invite, sur les benchmarks GSM8K, MATH500 et GPQA.

Malgré cela, le surcoût est resté bien inférieur à celui des stratégies nécessitant plusieurs exécutions échantillonnées ou une planification récursive.

Dans le graphique ci-dessous, nous pouvons constater à quel point la méthode est sensible à la qualité de la réponse proposée. Étonnamment, même lorsque la réponse est triviale («1 '), invraisemblable («2025 '), ou une option à choix multiple aléatoire, la vérification préalable reste plus performante que l'invite standard :

La précision est améliorée grâce à l'invite de vérification en premier lieu, lorsque le modèle reçoit des réponses triviales, invraisemblables ou correctes à vérifier sur GSM8K, MATH500 et GPQA.

Comme prévu, la précision augmente encore lorsque la réponse proposée s'avère correcte ; mais la méthode a bien fonctionné dans tous les cas, ce qui suggère que les gains ne sont pas dus à l'information contenue dans la réponse proposée elle-même, mais simplement à… act de vérification.

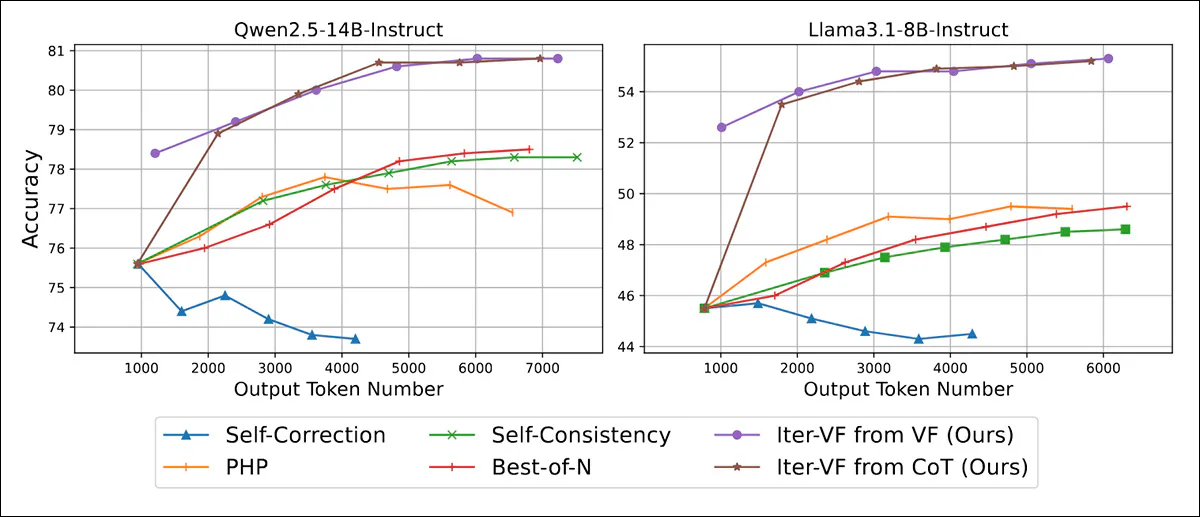

Iter-VF a également été comparé à quatre stratégies d'ajustement de la durée du test qui fonctionnent sans réentraînement ni adaptation spécifique à la tâche. Auto-correction, le modèle a été incité à revoir ses réponses en réfléchissant aux étapes de raisonnement précédentes ; dans PHPLes réponses précédentes étaient ajoutées à la saisie sous forme d'indices contextuels, sans toutefois qu'aucune instruction ne soit donnée sur la manière de les utiliser.

De plus, dans Auto-cohérence, plusieurs pistes de raisonnement ont été explorées et la réponse finale a été choisie à la majorité des voix ; et enfin, dans Meilleur de NPlusieurs résultats ont été générés indépendamment et classés à l'aide d'une invite de vérification, la réponse ayant obtenu le score le plus élevé étant sélectionnée.

Deux variantes d'Iter-VF ont été implémentées : l'une initialisée avec une estimation triviale («1 '), et une autre initialisée avec une sortie CoT standard :

Précision et efficacité des jetons sur MATH500 sous des budgets de production croissants, montrant que les deux variantes d'Iter-VF surpassent toutes les références à toutes les échelles de modèle.

Iter-VF a donné de meilleurs résultats que toutes les autres méthodes lorsque la puissance de calcul disponible était faible, ce que les auteurs ont attribué à sa méthode de vérification des réponses, et non à la qualité des réponses initiales (puisque les variantes VF et CoT ont rapidement atteint une précision similaire).

PHP a obtenu de moins bons résultats, même s'il a réutilisé des réponses précédentes comme indices, probablement parce que les LLM n'ont pas bien exploité ces indices.

Contrairement à PHP et à l'autocorrection, qui accumulent le contexte au fil des itérations, Iter-VF ne prend en compte que la réponse la plus récente à chaque étape. Markovien Cette approche évite la confusion croissante des raisonnements complexes – une faiblesse particulièrement dommageable pour l'autocorrection.

Les méthodes parallèles telles que l'autocohérence et le meilleur de N ont permis d'éviter ce problème, bien que leurs améliorations aient été plus lentes et plus modestes.

(nb La section des résultats, bien que complète, est une lecture fastidieuse et prolixe, et nous devons à ce stade tronquer la majeure partie du reste du contenu, renvoyant le lecteur à l'article source pour plus de détails).

Lorsqu'il est testé sur GPT-5 Nano et GPT-5 MiniContrairement aux modèles commerciaux fermés qui masquent l'intégralité du raisonnement et ne renvoient que la réponse finale, Iter-VF a amélioré les performances sans recourir aux résultats intermédiaires. Le tableau ci-dessous illustre les gains obtenus avec MATH500 et GPQA, confirmant ainsi la viabilité de l'approche « vérifier puis générer », même lorsque seules l'entrée et la réponse finale sont accessibles.

Précision sur MATH500 et GPQA lorsque Iter‑VF est appliqué aux modèles GPT‑5 avec des traces de raisonnement cachées.

Conclusion

Bien que le nouvel article s'oriente vers une certaine opacité à partir de la section des résultats, la découverte apparente d'une caractéristique commune à une classe de modèles d'IA demeure une avancée fascinante. Quiconque utilise régulièrement un modèle linéaire a instinctivement développé un ensemble d'astuces pour contourner les faiblesses de ces modèles, à mesure que celles-ci deviennent évidentes et que la tendance se dessine ; et tous espèrent trouver une astuce aussi applicable et généralisable que celle-ci.

L'un des plus grands problèmes liés à la mise en œuvre et à la mise à jour d'un fenêtre contextuelle Dans un projet de recherche de longue durée (PRLD), il semble s'agir de trouver un équilibre entre la préservation des acquis de la session et la capacité d'explorer de nouvelles pistes au besoin, sans tomber dans des digressions ou des digressions. L'exemple présenté dans cette nouvelle étude illustre une sorte de « rappel à l'ordre » subtil mais ferme qui semble recentrer et réinitialiser le PRLD sans en altérer le contexte. Il sera intéressant de voir si les projets ultérieurs adapteront et feront évoluer cette méthode.

Les chercheurs insistent sur l'extrême économie de leur nouvelle méthode – un argument qui aurait eu beaucoup moins d'importance il y a encore un an. Aujourd'hui, les implications de l'IA à très grande échelle montrent clairement que les économies de ressources, autrefois considérées comme superflues à l'ère de la recherche fondamentale, deviennent désormais cruciales et essentielles.

* Veuillez noter que je ne peux inclure autant de citations que d'habitude, car le niveau d'anglais de certaines parties du texte pourrait induire le lecteur en erreur. J'ai donc choisi de résumer les points essentiels et je renvoie le lecteur à l'article original pour vérification.

Première publication : jeudi 4 décembre 2025