Tehisintellekt

"Sulandunud" inimeste eraldamine arvutinägemises

Singapuri Hyundai Motor Groupi innovatsioonikeskuse uus artikkel pakub meetodit "sulanud" inimeste eraldamiseks arvutinägemises – juhtudel, kui objektituvastusraamistik on leidnud inimese, kes on mingil moel teisele inimesele "liiga lähedal" (näiteks "kallistamise" või "taga seismise" poosina) ja ei suuda kahte esindatud inimest lahutada, ajades need segadusse ühe isiku või üksuse jaoks.

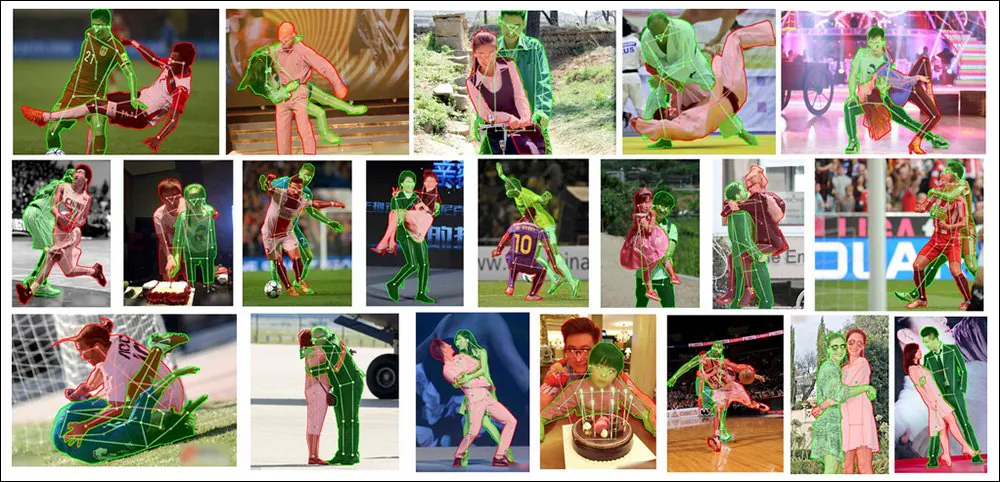

Kahest saab üks, kuid see pole semantilise segmenteerimise puhul hea. Siin näeme, et paberi uus süsteem saavutab tipptasemel tulemusi põimunud inimeste individuatsioonil keerulistes ja väljakutsuvates piltides. Allikas: https://arxiv.org/pdf/2210.03686.pdf

See on märkimisväärne probleem, millele on viimastel aastatel teadusringkondades palju tähelepanu pööratud. Selle lahendamine ilma ilmse, kuid tavaliselt taskukohase hüperskaala kuluta võib inimese juhitud kohandatud märgistamine lõpuks võimaldada parandada inimeste individuatsiooni teksti-pildiks süsteemides, nagu näiteks Stabiilne difusioon, mis sageli "sulatab" inimesi kokku, kui õhutatud poos nõuab, et mitu inimest oleksid üksteise vahetus läheduses.

Võtke omaks õudus – tekstist pildiks muutvad mudelid, nagu DALL-E 2 ja Stable Diffusion (mõlemad on ülalpool), püüavad esindada inimesi üksteisele väga lähedal.

Kuigi generatiivsed mudelid, nagu DALL-E 2 ja Stable Diffusion, ei kasuta (kellegi parimal teadmisel, suletud lähtekoodiga DALL-E 2 puhul) praegu niikuinii semantilist segmenteerimist ega objektituvastust, ei saa need grotesksed inimportmanteaadid praegu saab ravida selliste ülesvoolu meetodite rakendamisega, sest nüüdisaegsed objektituvastusraamatukogud ja -ressursid ei suuda inimesi lahutada palju paremini kui CLIP-põhised latentsete difusioonimudelite töövood.

Selle probleemi lahendamiseks uus paber - pealkirjaga Inimesed ei pea rohkem inimesi märgistama: oklusiooni kopeerimine ja kleepimine ummistunud iniminstantsi segmenteerimiseks– kohandab ja täiustab hiljutist poolsünteetiliste andmete lõikamise ja kleepimise meetodit, et saavutada ülesandes uus SOTA juhtpositsioon, isegi kõige keerulisema lähtematerjali puhul:

Uus oklusiooni kopeerimise ja kleepimise metoodika juhib praegu valdkonda isegi võrreldes varasemate raamistike ja lähenemisviisidega, mis lahendavad väljakutset keerukamal ja rohkem pühendunud viisil, nagu näiteks spetsiaalne oklusiooni modelleerimine.

Lõika see välja!

Muudetud meetod – pealkirjaga Oklusiooni kopeerimine ja kleepimine – on tuletatud 2021. aastast Lihtne kopeerimine-kleebi Google Researchi juhitud paber, milles väideti, et ekstraheeritud objektide ja inimeste asetamine erinevate allikate koolituspiltide hulka võib parandada pildituvastussüsteemi võimet diskreteerida iga pildil leitud eksemplari:

2021. aasta Google'i teadusuuringute juhitud artiklist „Lihtne kopeerimine-kleebi on tugev andmete suurendamise meetod eksemplaride segmentimiseks” näeme, et ühe foto elemendid „migreerivad” teistele fotodele, eesmärgiga koolitada paremat pildituvastusmudelit. Allikas: https://arxiv.org/pdf/2012.07177.pdf

Uus versioon lisab sellele automatiseeritud ja algoritmilisele "uuesti kleepimisele" piiranguid ja parameetreid, analoogides protsessi mitmete võtmetegurite alusel piltide "korviks", mis on täis potentsiaalseid kandidaate teistele piltidele "ülekandmiseks".

OC&P kontseptuaalne töövoog.

Elementide juhtimine

Need piiravad tegurid hõlmavad tõenäosus lõikamine ja kleepimine, mis tagab, et protsess ei toimu lihtsalt kogu aeg, mis saavutaks "küllastava" efekti, mis kahjustaks andmete suurendamist; a piltide arv et korv on igal ajal, kus suurem arv "segmente" võib parandada eksemplaride mitmekesisust, kuid pikendada eeltöötluse aega; ja valik, mis määrab piltide arvu, mis kleebitakse hostpildile.

Viimase kohta märgib leht "Meil on vaja piisavalt oklusiooni, kuid mitte liiga palju, kuna need võivad pildi üle risustada, mis võib õppimist kahjustada."

Ülejäänud kaks uuendust OC&P jaoks on suunatud kleepimine ja laiendatud eksemplari kleepimine.

Sihitud kleepimine tagab, et sobiv pilt satub sihtpildis olemasoleva eksemplari lähedusse. Eelmises töös oli uus element piiratud pildi piires, ilma konteksti arvestamata.

Kuigi see sihipärase kleepimisega kleepimine on inimsilmale ilmne, on nii OC&P kui ka selle eelkäija leidnud, et suurem visuaalne autentsus ei ole tingimata oluline ja võib isegi olla vastutustundlik (vt allpool jaotist „Reaalsuse hammustused”).

Teisest küljest tagab laiendatud eksemplaride kleepimine, et kleebitud eksemplarid ei näita "eristatavat välimust", mis võib lõpuks süsteemi poolt mingil viisil klassifitseerida, mis võib viia väljajätmiseni või "erikohtlemiseni", mis võib takistada üldistamist ja rakendatavust. . Täiustatud kleepimine moduleerib muude tegurite hulgas visuaalseid tegureid, nagu heledus ja teravus, skaleerimine ja pööramine ning küllastus.

Uue dokumendi lisamaterjalidest: OC&P lisamine olemasolevatele tunnustamisraamistikele on üsna triviaalne ja selle tulemuseks on inimeste parem individuaalsus väga lähedastes piirides. Allikas: https://arxiv.org/src/2210.03686v1/anc/OcclusionCopyPaste_Supplementary.pdf

Lisaks reguleerib OC&P a minimaalne suurus mis tahes kleebitud eksemplari jaoks. Näiteks võib massilisest rahvahulgastseenist olla võimalik eraldada pilt ühest inimesest, mille saab kleepida teisele pildile – kuid sellisel juhul ei aitaks kaasatud pikslite väike arv äratundmist tõenäoliselt kaasa. Seetõttu rakendab süsteem sihtkujutise jaoks minimaalset skaalat, mis põhineb võrdsustatud külje pikkuse suhtel.

Veelgi enam, OC&P instituudid mastaabiteadlikku kleepimist, kus lisaks kleebitava objektiga sarnaste objektide otsimisele võtab see arvesse ka sihtpildi piirdekastide suurust. See aga ei too kaasa liitkujutisi, mida inimesed usuksid või realistlikuks peavad (vt pilti allpool), vaid pigem koondab semantiliselt sobivad elemendid üksteise lähedale viisil, mis on treeningu ajal kasulik.

Reaalsushammustused

Nii eelmine töö, millel OC&P põhineb, kui ka praegune teostus seavad madala tähtsuse iga lõpliku montaažipildi autentsusele või "fotoreaalsusele". Kuigi on oluline, et lõplik kokkupanek ei laskuks täielikult sellesse Dadaism (muidu ei saaks väljaõppinud süsteemide reaalses kasutuses kunagi loota elemente kohata sellistes stseenides, mille järgi neid koolitati), on mõlemad algatused leidnud, et visuaalse usaldusväärsuse märkimisväärne kasv mitte ainult ei lisa eeltöötlusaega, vaid et sellised "realismi täiustused" on tõenäoliselt vastupidised.

Uue paberi lisamaterjalist: näited 'juhusliku segamisega' liitpiltidest. Kuigi need stseenid võivad inimese jaoks tunduda hallutsinogeensed, on neil siiski sarnased teemad; kuigi oklusioonid on inimsilma jaoks fantastilised, ei saa potentsiaalse oklusiooni olemust ette teada ja selle jaoks on võimatu treenida – seetõttu piisab sellistest veidratest vormi „lõikepunktidest”, et sundida treenitud süsteemi otsima. välja ja tuvastada osalised sihtobjektid, ilma et peaksite stseenide usutavamaks muutmiseks välja töötama keerukaid Photoshopi-stiilis metoodikaid.

Andmed ja testid

Testimisetapi jaoks koolitati süsteemi inimene klassist MS COCO andmestik, mis sisaldab 262,465 64,115 näidet inimestest XNUMX XNUMX pildi vahel. MS COCO-st parema kvaliteediga maskide saamiseks saadi aga ka pilte LVIS maski annotatsioonid.

2019. aastal välja antud LVIS on Facebooki uuringutest pärit mahukas andmestik suure sõnavara eksemplari segmenteerimiseks. Allikas: https://arxiv.org/pdf/1908.03195.pdf

Selleks et hinnata, kui hästi suudab laiendatud süsteem võidelda suure hulga ummistunud inimpiltide vastu, seadsid teadlased OC&P vastu OCHuman (Occluded Human) etalon.

Näited OCHumani andmekogumist, mis võeti kasutusele Pose2Seg tuvastamisprojekti toetuseks 2018. aastal. Selle algatuse eesmärk oli inimeste parem semantiline segmenteerimine, kasutades nende keha esindavate pikslite semantilise eraldajana nende asendit ja poosi. Allikas: https://github.com/liruilong940607/OCHumanApi

Kuna OCHumani etalon ei ole ammendavalt kommenteeritud, lõid uue artikli teadlased ainult nende näidete alamhulga, mis olid täielikult märgistatud, pealkirjaga OCHumanFL. See vähendas nende arvu inimene 2,240 eksemplarini 1,113 kujutise puhul valideerimiseks ja 1,923 eksemplarini 951 tegelikkuses testimiseks kasutatud pildi kohta. Testiti nii originaalset kui ka äsja kureeritud komplekti, kasutades põhimõõdikuna keskmist keskmist täpsust (mAP).

Järjepidevuse huvides moodustati arhitektuur Mask R-CNN ResNet-50 selgrooga ja a funktsiooni püramiid võrk, viimane annab vastuvõetava kompromissi täpsuse ja treeningkiiruse vahel.

Teadlased on märganud ülesvoolu kahjulikku mõju IMAGEnet mõju sarnastes olukordades, koolitati kogu süsteemi nullist 4 NVIDIA V100 GPU-ga 75 perioodi jooksul, järgides Facebooki 2021. aasta väljalaske lähtestamisparameetreid Detectron 2.

Tulemused

Lisaks ülalmainitud tulemustele on baastulemused vastu MMDtuvastus (ja sellega seotud kolm mudelit) näitasid, et OC&P on selgelt juhtpositsioonil tema võimes inimesi keerdunud poosidest välja valida.

Peale selle, et tulemus ületab PoSeg ja Pose2Seg, võib-olla üks paberi silmapaistvamaid saavutusi on see, et süsteemi saab üsna üldiselt rakendada olemasolevatele raamistikele, sealhulgas neile, mida katsetes sellele vastandati (vt võrdlustega/ilma võrdlusi esimeses tulemuste kastis, mis asub aruande alguses. artikkel).

Paber järeldab:

"Meie lähenemisviisi peamine eelis on see, et seda saab hõlpsasti rakendada mis tahes mudelite või muude mudelikesksete täiustustega. Arvestades süvaõppevälja liikumise kiirust, on igaühe eeliseks lähenemisviisid, mis on väga koostalitlusvõimelised kõigi teiste koolituse aspektidega. Jätame tulevaseks tööks selle integreerimise mudelikesksete täiustustega, et tõhusalt lahendada suletud isiku eksemplari segmenteerimine.

Tekstist pildiks sünteesi parandamise potentsiaal

Juhtautor Evan Ling märkis meile saadetud meilis*, et OC&P peamine eelis seisneb selles, et see suudab säilitada originaalsed maskisildid ja saada neilt uudses kontekstis "tasuta" uut väärtust – st pilte, mida nad on kasutanud. sisse kleebitud.

Ehkki inimeste semantiline segmenteerimine näib olevat tihedalt seotud raskustega, mis mudelitel nagu stabiilne difusioon on inimeste individuaalseks muutmisel (selle asemel, et neid "kokku segada", nagu see nii sageli tehakse), võib semantilise märgistamise kultuuri mõju painajalikule inimesele avaldada. renderdab, et SD ja DALL-E 2 väljund on sageli väga-väga kaugel ülesvoolu.

Miljardid LAION 5B alamhulga kujutised, mis täidavad stabiilse difusiooni genereerimisvõimsust, ei sisalda objektitaseme silte, nagu piirdekastid ja eksemplari maskid, isegi kui piltidest ja andmebaasi sisust renderdusi koostav CLIP-arhitektuur võis sellisest instantseerimisest mingil hetkel kasu olla; pigem on LAION-i kujutised märgistatud "tasuta", kuna nende sildid tuletati metaandmetest ja keskkonnapealkirjadest jne, mida seostati piltidega, kui need kaabiti veebist andmekogumisse.

"Aga see kõrvale," ütles Ling meile. "Teksti kujutiseks generatiivse mudeli koolituse ajal saab kasutada meie OC&P-ga sarnast täiendust. Kuid ma arvan, et täiustatud treeningpildi realistlikkus võib muutuda probleemiks.

"Oma töös näitame, et juhendatud eksemplari segmenteerimiseks pole üldiselt vaja "täiuslikku" realismi, kuid ma ei ole liiga kindel, kas tekstist pildiks generatiivse mudeli koolituse puhul saab teha sama järelduse (eriti kui nende väljundid eeldatakse, et need on väga realistlikud). Sel juhul võib olla vaja teha rohkem tööd, et täiustatud piltide realistlikkust täiustada.

CLIP on juba kasutusel võimaliku mitmeliigilise semantilise segmenteerimise vahendina, mis viitab sellele, et täiustatud isikutuvastus- ja individuatsioonisüsteemid, nagu OC&P, võiks lõpuks areneda süsteemisisesteks filtriteks või klassifikaatoriteks, mis lükkaksid meelevaldselt tagasi „sulatatud” ja moonutatud inimesitlused – ülesanne, mida on raske saavutada. praegu Stable Diffusioniga, sest sellel on piiratud võime aru saada, kus ta eksis (kui selline võime oleks olnud, poleks ta ilmselt üldse viga teinud).

Vaid üks paljudest projektidest, mis praegu kasutavad semantilise segmenteerimise jaoks OpenAI CLIP-raamistikku – DALL-E 2 ja Stable Diffusioni südant. Allikas: https://openaccess.thecvf.com/content/CVPR2022/papers/Wang_CRIS_CLIP-Driven_Referring_Image_Segmentation_CVPR_2022_paper.pdf

"Teine küsimus oleks," soovitab Ling. "Kas lihtsalt nende generatiivsete mudelite söötmine ummistunud inimeste kujutistega koolitustöö ajal ilma täiendava mudeliarhitektuuri disainita, et leevendada "inimeste sulandumise" probleemi? See on ilmselt küsimus, millele on raske otsekohe vastata. Kindlasti on huvitav näha, kuidas me saame tekstist pildiks generatiivse mudeli koolituse käigus lisada mingisuguseid eksemplaritaseme juhiseid (eksemplaritaseme siltide, näiteks eksemplari maski kaudu).

* 10. oktoober 2022

Esmakordselt avaldatud 10. oktoobril 2022.