Líders del pensament

Descodificació d'oportunitats i reptes per als agents de LLM en IA generativa

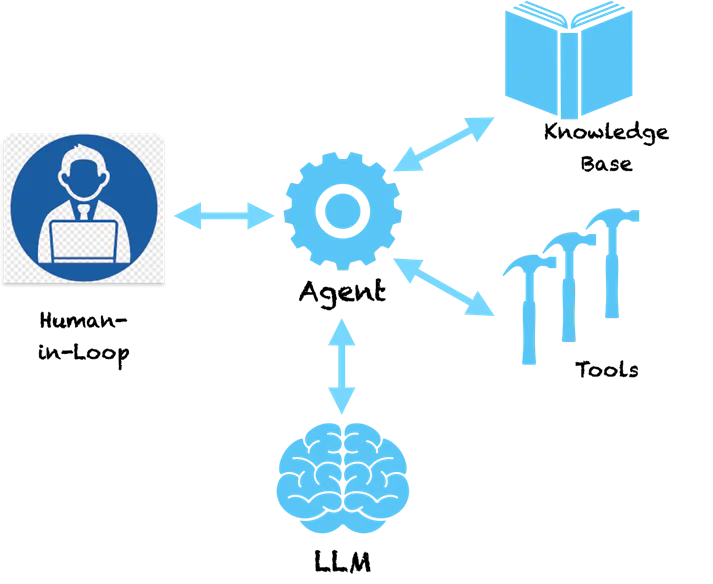

Estem veient una progressió d'aplicacions d'IA generativa impulsades per grans models de llenguatge (LLM) des de les indicacions fins a la generació augmentada de recuperació (RAG) fins als agents. S'està parlant molt dels agents a la indústria i als cercles de recerca, principalment pel poder que ofereix aquesta tecnologia per transformar les aplicacions empresarials i oferir experiències superiors als clients. Hi ha patrons comuns per construir agents que permeten els primers passos cap a la intel·ligència general artificial (AGI).

En el meu anterior article, vam veure una escala d'intel·ligència de patrons per crear aplicacions basades en LLM. Començant amb indicacions que capturen el domini del problema i utilitzen la memòria interna de LLM per generar resultats. Amb RAG, augmentem l'indicador amb coneixement extern cercat des d'una base de dades vectorial per controlar les sortides. A continuació, encadenant trucades de LLM, podem crear fluxos de treball per realitzar aplicacions complexes. Els agents porten això a un altre nivell determinant automàticament com s'han de formar aquestes cadenes de LLM. Vegem-ho amb detall.

Agents – Sota el capó

Un patró clau amb els agents és que utilitzen el poder de comprensió lingüística de LLM per fer un pla sobre com resoldre un problema determinat. El LLM entén el problema i ens dóna una seqüència de passos per resoldre el problema. Tanmateix, no s'atura aquí. Els agents no són un sistema de suport pur que us proporcionarà recomanacions per resoldre el problema i, a continuació, us passarà el testimoni perquè feu els passos recomanats. Els agents disposen d'eines per seguir endavant i prendre l'acció. Poruc oi!?

Si fem una pregunta bàsica com aquesta a un agent:

Humà: Quina empresa va començar l'inventor del telèfon?

A continuació es mostra una mostra dels passos de pensament que pot prendre un agent.

Agent (PENSANT):

- Pensament: he de buscar l'inventor del telèfon.

- acció: Cerca [inventor del telèfon]

- Observació: Alexander Graham Bell

- Pensament: necessito buscar una empresa que va ser fundada per Alexander Graham Bell

- acció: Cerca [empresa fundada per Alexander Graham Bell]

- Observació: Alexander Graham Bell va cofundar l'American Telephone and Telegraph Company (AT&T) el 1885

- Pensament: he trobat la resposta. Tornaré.

Agent (RESPOSTA): Alexander Graham Bell va cofundar AT&T el 1885

Podeu veure que l'agent segueix una manera metòdica de desglossar el problema en subproblemes que es poden resoldre fent accions específiques. Les accions aquí recomanades pel LLM i les podem assignar a eines específiques per implementar aquestes accions. Podríem habilitar una eina de cerca per a l'agent de manera que quan s'adoni que LLM ha proporcionat la cerca com a acció, cridarà a aquesta eina amb els paràmetres proporcionats pel LLM. La cerca aquí es fa a Internet, però també es pot redirigir per cercar una base de coneixement interna com una base de dades vectorial. El sistema ara esdevé autosuficient i pot esbrinar com resoldre problemes complexos seguint una sèrie de passos. Marcs com LangChain i LLaMAIndex us ofereixen una manera senzilla de crear aquests agents i connectar-vos a eines i API. Amazon va llançar recentment el seu marc de Bedrock Agents que proporciona una interfície visual per dissenyar agents.

Sota el capó, els agents segueixen un estil especial d'enviament d'indicacions al LLM que els fa generar un pla d'acció. El patró de Pensament-Acció-Observació anterior és popular en un tipus d'agent anomenat ReAct (Raonament i Actuació). Altres tipus d'agents inclouen MRKL i Planificar i executar, que es diferencien principalment pel seu estil de sol·licitud.

Per als agents més complexos, les accions poden estar vinculades a eines que provoquen canvis en els sistemes font. Per exemple, podríem connectar l'agent a una eina que comprova el saldo de vacances i sol·licita permís en un sistema ERP per a un empleat. Ara podríem crear un bot de xat agradable que interactuaria amb els usuaris i, mitjançant una comanda de xat, sol·licitaria l'abandonament del sistema. No hi ha pantalles més complexes per sol·licitar permisos, una interfície de xat unificada senzilla. Sona emocionant!?

Advertències i necessitat d'IA responsable

Ara, què passa si tenim una eina que invoca transaccions en negociació d'accions mitjançant una API preautoritzada. Creeu una aplicació on l'agent estudia els canvis d'estoc (utilitzant eines) i pren decisions per vosaltres sobre la compra i venda d'accions. Què passa si l'agent ven les accions equivocades perquè ha al·lucinat i ha pres una decisió equivocada? Com que els LLM són models enormes, és difícil identificar per què prenen algunes decisions, per tant, les al·lucinacions són freqüents en absència de baranes de protecció adequades.

Tot i que tots els agents són fascinants, probablement hauríeu endevinat com de perillosos poden ser. Si al·lucinen i prenen una acció incorrecta que podria causar grans pèrdues financeres o problemes importants als sistemes empresarials. Per tant, la IA responsable està adquirint una importància cabdal en l'era de les aplicacions basades en LLM. Els principis de la IA responsable al voltant de la reproductibilitat, la transparència i la rendició de comptes intenten posar baranes a les decisions preses pels agents i suggereixen anàlisis de riscos per decidir quines accions necessiten un human-in-the-loop. A mesura que s'estan dissenyant agents més complexos, necessiten més escrutini, transparència i responsabilitat per assegurar-nos que sabem què estan fent.

Cloenda de pensaments

La capacitat dels agents per generar un camí de passos lògics amb accions els apropa realment al raonament humà. Potenciar-los amb eines més potents els pot donar superpoders. Patrons com ReAct intenten emular com els humans resolen el problema i veurem millors patrons d'agents que seran rellevants per a contextos i dominis específics (bancària, assegurances, sanitat, industrial, etc.). El futur és aquí i la tecnologia que hi ha darrere dels agents està preparada per utilitzar-la. Al mateix temps, hem de prestar molta atenció a les baranes d'IA responsable per assegurar-nos que no estem construint Skynet!