Intel·ligència Artificial

La IA multimodal evoluciona a mesura que ChatGPT guanya la vista amb GPT-4V(ision)

En l'esforç continu per fer que la IA s'assembli més als humans, els models GPT d'OpenAI han avançat contínuament els límits. GPT-4 ara és capaç d'acceptar sol·licituds tant de text com d'imatges.

La multimodalitat en IA generativa denota la capacitat d'un model per produir sortides variades com text, imatges o àudio basats en l'entrada. Aquests models, entrenats en dades específiques, aprenen patrons subjacents per generar dades noves similars, enriquint les aplicacions d'IA.

Passos recents en IA multimodal

Un salt notable recent en aquest camp es veu amb la integració de DALL-E 3 a ChatGPT, una actualització significativa de la tecnologia de text a imatge d'OpenAI. Aquesta combinació permet una interacció més fluida on ChatGPT ajuda a crear indicacions precises per a DALL-E 3, convertint les idees dels usuaris en art vívid generat per IA. Així, mentre que els usuaris poden interactuar directament amb DALL-E 3, tenir ChatGPT a la barreja fa que el procés de creació d'art d'IA sigui molt més fàcil d'utilitzar.

Consulteu més informació sobre DALL-E 3 i la seva integració amb ChatGPT aquí. Aquesta col·laboració no només mostra l'avenç de la IA multimodal, sinó que també fa que la creació d'art d'IA sigui una brisa per als usuaris.

La salut de Google, d'altra banda, es va presentar Med-PaLM M al juny d'enguany. És un model generatiu multimodal apte per codificar i interpretar dades biomèdiques diverses. Això es va aconseguir ajustant PaLM-E, un model de llenguatge, per atendre els dominis mèdics mitjançant un punt de referència de codi obert, MultiMedBench. Aquest punt de referència consta de més d'1 milió de mostres en 7 tipus de dades biomèdiques i 14 tasques com ara la resposta a preguntes mèdiques i la generació d'informes de radiologia.

Diverses indústries estan adoptant eines innovadores d'IA multimodal per impulsar l'expansió del negoci, racionalitzar les operacions i augmentar la participació dels clients. El progrés en les capacitats d'IA de veu, vídeo i text està impulsant el creixement de la IA multimodal.

Les empreses busquen aplicacions d'IA multimodals capaços de revisar models i processos de negoci, obrint vies de creixement a través de l'ecosistema d'IA generativa, des d'eines de dades fins a aplicacions d'IA emergents.

Després del llançament de GPT-4 al març, alguns usuaris van observar una disminució de la seva qualitat de resposta al llarg del temps, una preocupació que es va fer ressò per desenvolupadors notables i als fòrums d'OpenAI. Inicialment descartat per un OpenAI, un posterior estudiar confirmat el problema. Va revelar una caiguda en la precisió de GPT-4 del 97.6% al 2.4% entre març i juny, cosa que indica una disminució de la qualitat de la resposta amb les actualitzacions posteriors del model.

El bombo al voltant Obriu IA's ChatGPT ha tornat ara. Ara ve amb una funció de visió GPT-4V, permetent als usuaris que GPT-4 analitzin les imatges donades per ells. Aquesta és la funció més nova que s'ha obert als usuaris.

Afegir anàlisi d'imatges a grans models de llenguatge (LLM) com el GPT-4 és considerat per alguns com un gran pas endavant en la investigació i el desenvolupament d'IA. Aquest tipus de LLM multimodal obre noves possibilitats, portant els models lingüístics més enllà del text per oferir noves interfícies i resoldre nous tipus de tasques, creant experiències noves per als usuaris.

L'entrenament de GPT-4V es va acabar l'any 2022 i l'accés anticipat es va implementar el març de 2023. La funció visual de GPT-4V està impulsada per la tecnologia GPT-4. El procés de formació continuava sent el mateix. Inicialment, el model es va entrenar per predir la següent paraula en un text mitjançant un conjunt de dades massiu de text i imatges de diverses fonts, inclosa Internet.

Més tard, es va ajustar amb més dades, utilitzant un mètode anomenat aprenentatge de reforç a partir de la retroalimentació humana (RLHF), per generar sortides que els humans preferien.

GPT-4 Vision Mechanics

Les notables capacitats de llenguatge de visió del GPT-4, encara que impressionants, tenen mètodes subjacents que romanen a la superfície.

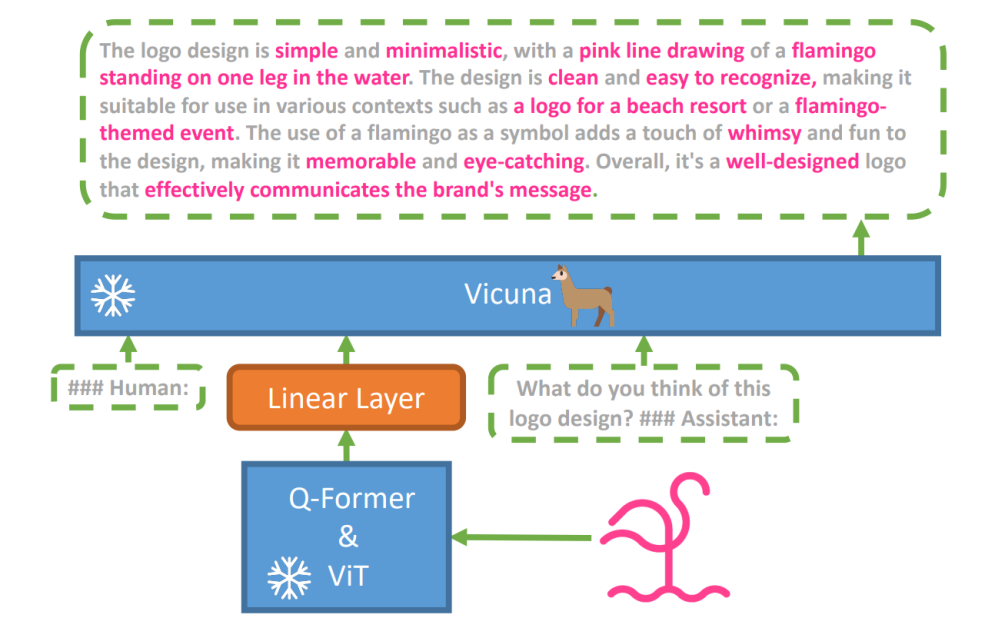

Per explorar aquesta hipòtesi, un nou model de visió-llenguatge, MiniGPT-4 es va introduir, utilitzant un LLM avançat anomenat Vicunya. Aquest model utilitza un codificador de visió amb components pre-entrenats per a la percepció visual, alineant les característiques visuals codificades amb el model de llenguatge Vicuna mitjançant una única capa de projecció. L'arquitectura del MiniGPT-4 és senzilla però eficaç, amb un enfocament a alinear les funcions visuals i del llenguatge per millorar les capacitats de conversa visual.

L'arquitectura del MiniGPT-4 inclou un codificador de visió amb ViT i Q-Former pre-entrenats, una única capa de projecció lineal i un model de llenguatge gran Vicuna avançat.

La tendència dels models de llenguatge autoregressius en tasques de llenguatge visió també ha crescut, aprofitant la transferència intermodal per compartir coneixement entre dominis lingüístics i multimodals.

MiniGPT-4 uneix els dominis visuals i lingüístics alineant la informació visual d'un codificador de visió prèviament entrenat amb un LLM avançat. El model utilitza Vicuna com a descodificador de llenguatge i segueix un enfocament d'entrenament en dues etapes. Inicialment, s'ha entrenat en un gran conjunt de dades de parells imatge-text per comprendre el coneixement del llenguatge de visió, seguit d'un ajustament en un conjunt de dades més petit i d'alta qualitat per millorar la fiabilitat i la usabilitat de la generació.

Per millorar la naturalitat i la usabilitat del llenguatge generat a MiniGPT-4, els investigadors van desenvolupar un procés d'alineació en dues etapes, abordant la manca de conjunts de dades adequats d'alineació de llenguatge de visió. Van crear un conjunt de dades especialitzat amb aquest propòsit.

Inicialment, el model va generar descripcions detallades de les imatges d'entrada, millorant el detall mitjançant l'ús d'un missatge de conversa alineat amb el format del model de llengua Vicuna. Aquesta etapa tenia com a objectiu generar descripcions d'imatges més completes.

Solicitud de descripció de la imatge inicial:

###Humà: Descriu aquesta imatge amb detall. Doneu tants detalls com sigui possible. Digues tot el que veus. ###Assistent:

Per al postprocessament de dades, es va corregir qualsevol incoherència o error en les descripcions generades mitjançant ChatGPT, seguida d'una verificació manual per garantir una alta qualitat.

Indicació d'ajustament de la segona etapa:

###Humà: ###Assistent:

Aquesta exploració obre una finestra per entendre la mecànica de la IA generativa multimodal com GPT-4, il·lustrant com es poden integrar eficaçment les modalitats de visió i llenguatge per generar resultats coherents i rics en el context.

Explorant la visió GPT-4

Determinació dels orígens de la imatge amb ChatGPT

GPT-4 Vision millora la capacitat de ChatGPT per analitzar imatges i identificar els seus orígens geogràfics. Aquesta funció fa la transició de les interaccions de l'usuari només de text a una combinació de text i imatges, convertint-se en una eina útil per a aquells curiosos sobre diferents llocs mitjançant dades d'imatge.

Conceptes matemàtics complexos

GPT-4 Vision destaca per aprofundir en idees matemàtiques complexes mitjançant l'anàlisi d'expressions gràfiques o escrites a mà. Aquesta funció actua com una eina útil per a persones que busquen resoldre problemes matemàtics complexos, la qual cosa fa que GPT-4 Vision sigui una ajuda notable en els camps educatius i acadèmics.

Conversió d'entrada manuscrita a codis LaTeX

Una de les habilitats notables del GPT-4V és la seva capacitat per traduir entrades escrites a mà en codis LaTeX. Aquesta funció és una avantatge per als investigadors, acadèmics i estudiants que sovint necessiten convertir expressions matemàtiques escrites a mà o altra informació tècnica a un format digital. La transformació d'escrit a mà a LaTeX amplia l'horitzó de la digitalització de documents i simplifica el procés d'escriptura tècnica.

Extracció de detalls de la taula

GPT-4V mostra habilitat per extreure detalls de taules i abordar consultes relacionades, un actiu vital en l'anàlisi de dades. Els usuaris poden utilitzar GPT-4V per examinar taules, recopilar informació clau i resoldre preguntes basades en dades, cosa que la converteix en una eina sòlida per als analistes de dades i altres professionals.

Comprensió de l'apuntament visual

La capacitat única de GPT-4V per comprendre l'apunt visual afegeix una nova dimensió a la interacció de l'usuari. En comprendre les indicacions visuals, GPT-4V pot respondre a les consultes amb una comprensió contextual més alta.

Creació de llocs web de maquetes senzilles mitjançant un dibuix

Motivat per això Twitter, he intentat crear una maqueta per al lloc web unit.ai.

Tot i que el resultat no va coincidir amb la meva visió inicial, aquí teniu el resultat que vaig aconseguir.

Limitacions i defectes de GPT-4V(ision)

Per analitzar GPT-4V, l'equip d'Open AI va realitzar avaluacions qualitatives i quantitatives. Les qualitatives incloïen proves internes i revisions d'experts externs, mentre que les quantitatives mesuraven els rebuigs i la precisió dels models en diversos escenaris, com ara la identificació de continguts nocius, el reconeixement demogràfic, els problemes de privadesa, la geolocalització, la ciberseguretat i els jailbreaks multimodals.

Tot i així el model no és perfecte.

El paper destaca les limitacions de GPT-4V, com ara inferències incorrectes i falta de text o caràcters a les imatges. Pot al·lucinar o inventar fets. En particular, no és adequat per identificar substàncies perilloses a les imatges, sovint malidentificant-les.

En imatges mèdiques, GPT-4V pot proporcionar respostes inconsistents i manca de coneixement de les pràctiques estàndard, cosa que condueix a possibles diagnòstics errònia.

Rendiment poc fiable amb finalitats mèdiques (font)

Tampoc no entén els matisos de certs símbols d'odi i pot generar contingut inadequat basat en les entrades visuals. OpenAI desaconsella l'ús de GPT-4V per a interpretacions crítiques, especialment en contextos mèdics o sensibles.

Ajustar cap amunt

Creat amb Fast Stable Diffusion XL https://huggingface.co/spaces/google/sdxl

L'arribada de GPT-4 Vision (GPT-4V) ofereix un munt de possibilitats interessants i nous obstacles per saltar. Abans de llançar-lo, s'ha fet un gran esforç per assegurar-se que els riscos, sobretot pel que fa a les imatges de persones, s'observin bé i es redueixin. És impressionant veure com GPT-4V ha augmentat, mostrant moltes promeses en àrees complicades com la medicina i la ciència.

Ara, hi ha algunes grans preguntes sobre la taula. Per exemple, aquests models haurien de ser capaços d'identificar persones famoses a partir de les fotos? Haurien d'endevinar el gènere, la raça o els sentiments d'una persona a partir d'una imatge? I, hi hauria d'haver ajustaments especials per ajudar les persones amb discapacitat visual? Aquestes preguntes obren una gran quantitat de cucs sobre la privadesa, l'equitat i com hauria d'encaixar la IA a les nostres vides, cosa en què tothom hauria de tenir la paraula.