Intel·ligència Artificial

LoReFT: Representation Finetuning for Language Models

Els mètodes d'afinació o PeFT eficients en paràmetres busquen adaptar grans models de llenguatge mitjançant actualitzacions a un nombre reduït de pesos. Tanmateix, la majoria del treball d'interpretabilitat existent ha demostrat que les representacions codifiquen informació rica en semàntica, cosa que suggereix que podria ser una alternativa millor i més potent per editar aquestes representacions. Els models grans prèviament entrenats solen estar ajustats per utilitzar-los per a nous dominis o tasques, i durant el procés d'ajustament, un únic model base es pot adaptar a una gran varietat de tasques, fins i tot amb només petites quantitats de dades dins del domini disponibles. al model. Tanmateix, el procés d'ajustament d'un model sencer consumeix recursos i és costós, especialment per als models de llenguatge amb un nombre significativament més gran de mida i paràmetres.

Els mètodes d'afinació de paràmetres eficients o PeFT proposen abordar els elevats costos associats a l'ajustament fi de tot el model actualitzant només una petita quantitat dels pesos totals disponibles, un procés que ajuda a reduir el temps d'entrenament juntament amb l'ús de memòria. El que és més important és que els mètodes d'afinació eficient dels paràmetres o PeFT han demostrat un rendiment similar a l'afinació en diversos entorns pràctics. Els adaptadors, una família comuna de mètodes d'afinació o PeFT eficients amb els paràmetres, aprenen una edició que es pot afegir a un conjunt addicional de pesos que operen juntament amb el model base congelat, amb adaptadors recents com LoRA redueixen el nombre de paràmetres entrenables en apresos. actualitzacions de pes utilitzant aproximacions de rang baix en lloc de matrius de pes complet quan entrenen els adaptadors.

Amb treballs anteriors que demostren que l'edició de representacions podria ser una millor alternativa als mètodes d'afinació eficient dels paràmetres o de PeFT, en aquest article, parlarem dels mètodes d'afinació de representació o ReFT que operen en un model congelat i aprendrem tasques específiques. intervencions sobre representacions ocultes. Aquest article pretén cobrir en profunditat el marc de ReFt o Representation Fine-tuning, i s'explora el mecanisme, la metodologia, l'arquitectura del marc juntament amb la seva comparació amb marcs d'última generació. Així que comencem.

ReFT: afinació de la representació per a models lingüístics

En un intent d'adoptar models de llenguatge pre-entrenats a nous dominis i tasques, els marcs actuals afinen aquests models de llenguatge pre-entrenats amb freqüència, ja que amb el procés d'afinació implementat, un únic model base es pot adaptar fins i tot a una varietat de tasques. quan es treballa amb una petita quantitat de dades del domini. Tot i que el procés d'afinació millora el rendiment general, és un procés car, sobretot si el model d'idioma té un nombre de paràmetres significativament elevat. Per abordar aquest problema, i reduir els costos associats, PeFT o Paràmetre eficient marcs d'afinació actualitzeu només una petita fracció dels pesos totals, un procés que no només redueix el temps d'entrenament, sinó que també redueix l'ús de memòria, permetent que els marcs PeFT aconsegueixin un rendiment similar en comparació amb els enfocaments d'ajustament complet en escenaris pràctics. Els adaptadors, una família comuna de PeFT, funcionen aprenent una edició que es pot afegir a un conjunt addicional de pesos juntament amb un subconjunt de pesos que funcionen a l'uníson amb el model base amb pesos congelats. Marcs d'adaptadors recents com LoRA i QLoRA han demostrat que és possible entrenar adaptadors de precisió total a sobre de models de precisió reduïda sense afectar el rendiment. Els adaptadors solen ser més eficients i efectius en comparació amb altres mètodes que introdueixen nous components del model.

Un dels aspectes més destacats de l'estat actual dels marcs d'ajustament de paràmetres eficients és que en lloc de modificar representacions, modifiquen els pesos. Tanmateix, els marcs que tracten la interpretabilitat han demostrat que les representacions codifiquen informació semàntica rica, cosa que suggereix que l'edició de representacions podria ser un enfocament millor i més potent en comparació amb les actualitzacions de pes. Aquesta hipòtesi que l'edició de representacions és el millor enfocament és el que constitueix la base del marc ReFT o Representation Fine-tuning que entrena les intervencions en lloc d'adaptar els pesos del model, permetent que el model manipuli una petita fracció de totes les representacions en un intent de dirigir els comportaments del model. per resoldre tasques aigües avall durant la inferència. Els mètodes d'afinació de ReFT o de representació són reemplaçaments directes per a marcs d'afinació de PeFT basats en el pes o de paràmetres eficients. L'enfocament de ReFT s'inspira en models recents que treballen amb una gran interpretabilitat de models que intervé en representacions per trobar mecanismes causals fidels i dirigeix el comportament del model durant la inferència i, per tant, es pot veure com una generalització dels models d'edició de representacions. Basant-se en el mateix, LoReFT o Low-Rank Subspace ReFT és una instància forta i eficaç de ReFT, i és una parametrització de ReFT que intervé en representacions ocultes en l'espai lineal abastat per la matriu de projecció de baix rang, i es basa directament en el DAS. o marc de cerca d'alineació distribuïda.

Avançant, al contrari de l'ajustament final complet, el marc d'afinació PeFT o eficient amb paràmetres entrena només una petita fracció dels paràmetres del model i aconsegueix adaptar el model a les tasques posteriors. El marc d'ajustament eficient dels paràmetres es pot classificar en tres categories principals:

- Mètodes basats en adaptadors: Els mètodes basats en adaptadors entrenen mòduls addicionals, com ara capes completament connectades a la part superior del model pre-entrenat amb pesos congelats. Els adaptadors de sèrie insereixen components entre el perceptró multicapa o MLP i LM o capes d'atenció de grans models, mentre que els adaptadors paral·lels afegeixen mòduls al costat dels components existents. Com que els adaptadors afegeixen nous components que no es poden plegar fàcilment als pesos del model existents, representen una càrrega addicional durant la inferència.

- LoRA: LoRA, juntament amb les seves variants recents, aproximen els pesos additius durant l'entrenament mitjançant matrius de rang baix, i no requereixen despeses generals addicionals durant la inferència, ja que les actualitzacions de pes es poden fusionar al model, i és la raó per la qual es considera que són les actuals. marcs PeFT més forts.

- Mètodes basats en suggeriments: Els mètodes basats en missatges afegeixen fitxes suaus que s'inicien aleatòriament a l'entrada i entrenen les seves incrustacions mentre mantenen els pesos del model de llenguatge congelats. El rendiment que ofereixen aquests mètodes sovint no és satisfactori en comparació amb altres enfocaments de PeFT, i també comporten un cost general d'inferència important.

En lloc d'actualitzar els pesos, el marc ReFT aprèn intervencions per modificar una petita fracció de les representacions totals. A més, treballs recents sobre enginyeria de representació i direcció d'activació han demostrat que l'addició de vectors de direcció fixos al flux residual podria facilitar un cert grau de control sobre generacions de grans models prèviament entrenats sense requerir un consum intensiu de recursos. afinació. Altres marcs han demostrat que l'edició de representacions amb una operació d'escalat i traducció apresa pot intentar igualar però no superar el rendiment que ofereixen els adaptadors LoRA en una àmplia gamma de tasques amb menys paràmetres apresos. A més, l'èxit d'aquests marcs en una sèrie de tasques ha demostrat que les representacions introduïdes per models de llenguatge pre-entrenats porten una semàntica rica, tot i que el rendiment d'aquests models és subòptim, el que fa que els PeFT continuïn com l'enfocament d'última generació. sense cap càrrega d'inferència addicional.

ReFT : Metodologia i Arquitectura

Per mantenir el procés de preservació de l'estil senzill, el marc ReFT assumeix un model gran basat en transformadors com a model objectiu que és capaç de produir una representació contextualitzada de la seqüència de fitxes. Per a una seqüència determinada amb n nombre de fitxes d'entrada, el marc ReFT incrusta primer aquests testimonis d'entrada en una llista de representacions després de la qual les m capes calculen la llista de representacions ocultes successivament en funció de la llista anterior de representacions ocultes. Cada representació oculta és un vector i el model de llenguatge utilitza les representacions ocultes finals per produir les prediccions. El marc ReFT considera tant models de llenguatge emmascarat com models de llenguatge autoregressius. Ara, segons la hipòtesi de la representació lineal, a les xarxes neuronals, els conceptes es codifiquen dins dels subespais lineals de les representacions. Models recents han trobat que aquesta afirmació és certa en models de xarxes neuronals entrenats en llenguatge natural juntament amb altres distribucions d'entrada.

A més, en els estudis d'interpretabilitat, el marc d'abstracció casual utilitza intervencions d'intercanvi per establir el paper dels components de la xarxa neuronal de manera casual quan s'implementa comportaments particulars. La lògica darrere de la intervenció d'intercanvi és que si hom fixa una representació al que hauria estat per a una entrada contrafactual, i aquesta intervenció afecta la sortida del model de manera coherent de la manera que les afirmacions fetes pel marc ReFT sobre el component responsable de produir aquesta representació, aleshores el component té un paper causal en el comportament. Tot i que hi ha uns quants mètodes, la intervenció d'intercanvi distribuït és l'enfocament ideal per comprovar si un concepte està codificat en un subespai lineal d'una representació, tal com afirma la hipòtesi de la representació lineal. A més, el mètode DAS s'ha utilitzat anteriorment per trobar representacions lineals en models lingüístics d'atributs d'entitats, sentiment, característiques lingüístiques i raonament matemàtic. No obstant això, diversos experiments han indicat que el mètode DAS és altament expressiu i té la capacitat de trobar subespais causals eficaços fins i tot quan el model de llenguatge transformador s'ha inicialitzat aleatòriament i, per tant, encara no ha après cap representació específica de la tasca, el que resulta en el debatre si el DAS és prou eficaç i responsable per a les tasques d'interpretabilitat.

L'expressivitat que ofereix DAS suggereix que l'enfocament podria ser una eina ideal per controlar el comportament del model de llenguatge juntament amb el seu treball de generació controlable i edició responsable. Per tant, per adaptar els models de llenguatge per a les tasques posteriors, el marc ReFT utilitza l'operació d'intervenció d'intercanvi distribuït per fer un mètode eficient de paràmetres. A més, el mètode ReFT és un conjunt d'intervencions, i el marc imposa que per a dues intervencions que operen sobre la mateixa capa, les posicions d'intervenció han de ser disjuntes, amb els paràmetres de totes les funcions d'intervenció romanent independents. Com a resultat, el ReFT és un marc genèric que engloba intervencions sobre representacions ocultes durant el pas endavant del model.

ReFT: Experiments i resultats

Per avaluar el seu rendiment amb els marcs PEFT existents, el marc ReFT realitza experiments a través de quatre punts de referència de processament de llenguatge natural diversos i cobreix més de 20 conjunts de dades, amb l'objectiu principal de proporcionar una imatge rica de com funciona el marc LoReFT en diferents escenaris. A més, quan el marc LoReFT s'implementa a la vida real, els desenvolupadors han de decidir quantes intervencions aprendre juntament amb les posicions d'entrada i les capes per aplicar-hi cadascuna. Per completar la tasca, el marc ReFT ajusta quatre hiperparàmetres.

- El nombre de posicions de prefix sobre les quals intervenir.

- El nombre de posicions de sufix per intervenir.

- En quin conjunt de capes intervenir.

- Si s'han d'enllaçar o no els paràmetres d'intervenció en diferents posicions de la mateixa capa.

D'aquesta manera, el marc de ReFT simplifica l'espai de cerca d'hiperparàmetres i assegura només un cost d'inferència addicional fix que no s'escala amb la longitud de la sol·licitud.

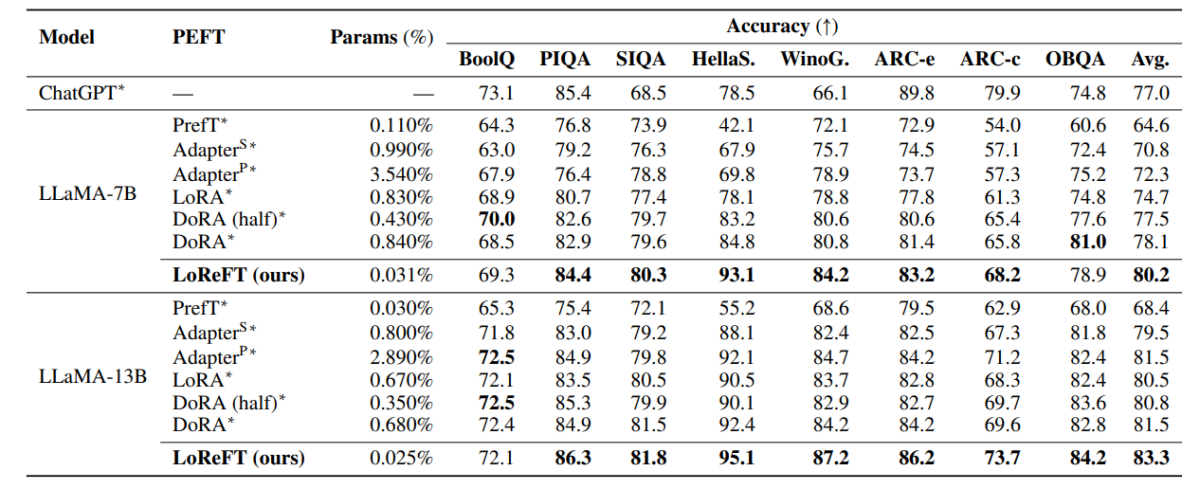

La taula anterior compara la precisió dels marcs LLaMA-7B i LLaMA-13B amb els models PEFT existents en 8 conjunts de dades de raonament de sentit comú. Com es pot observar, el model LoReFT supera els enfocaments PEFT existents per un marge decent, tot i tenir molts menys paràmetres, amb el rendiment mitjà de tres execucions amb diferents llavors de paràmetres per al model LoReFT. El paràmetre (%) es calcula dividint el nombre de paràmetres entrenables amb el nombre de paràmetres totals del model gran base.

La taula anterior resumeix la comparació de precisió dels marcs LLaMA-7B i LLaMA-13B amb els models PEFT existents en 4 conjunts de dades de raonament aritmètic diferents, amb el marc que informa del rendiment mitjà de tres execucions amb llavors aleatòries diferents. Com es pot observar, tot i tenir molts menys paràmetres (%), el marc LoReFT supera els marcs PEFT existents per un marge considerable.

La taula anterior resumeix la comparació de precisió dels marcs RoBERTa-base i RoBERTa-large amb els models PEFT existents a través del punt de referència GLUE, amb el marc que informa del rendiment mitjà de cinc execucions amb diferents llavors aleatòries. Com es pot observar, tot i tenir molts menys paràmetres (%), el marc LoReFT supera els marcs PEFT existents per un marge considerable.

Consideracions finals

En aquest article, hem parlat de LoReFT, una alternativa potent als marcs PEFT existents que aconsegueix un rendiment fort a través de punts de referència de quatre dominis diferents alhora que ofereix fins a 50 vegades l'eficiència que ofereixen els models PEFT d'última generació anteriors. Els models grans prèviament entrenats solen estar ajustats per utilitzar-los per a nous dominis o tasques, i durant el procés d'ajustament, un únic model base es pot adaptar a una gran varietat de tasques, fins i tot amb només petites quantitats de dades dins del domini disponibles. al model. Tanmateix, el procés d'ajustament d'un model sencer consumeix recursos i és costós, especialment per als models de llenguatge amb un nombre significativament més gran de mida i paràmetres. Els mètodes d'afinació de paràmetres eficients o PeFT proposen abordar els elevats costos associats a l'ajustament fi de tot el model actualitzant només una petita quantitat dels pesos totals disponibles, un procés que ajuda a reduir el temps d'entrenament juntament amb l'ús de memòria. En particular, LoReFT estableix un nou rendiment d'última generació en el raonament de sentit comú, el seguiment d'instruccions i la comprensió del llenguatge natural contra els PEFT més forts.