اینڈرسن کا زاویہ

AI ویڈیو جنریشن میں کل کنٹرول کی طرف

ویڈیو فاؤنڈیشن ماڈل جیسے ہنیوآن اور وان 2.1طاقتور ہونے کے باوجود، صارفین کو اس قسم کا دانے دار کنٹرول پیش نہیں کرتے جس کا فلم اور ٹی وی پروڈکشن (خاص طور پر VFX پروڈکشن) کا مطالبہ ہوتا ہے۔

پیشہ ورانہ بصری اثرات کے اسٹوڈیوز میں، اس طرح کے اوپن سورس ماڈلز کے ساتھ ساتھ پہلے کی تصویر پر مبنی (ویڈیو کے بجائے) ماڈل جیسے مستحکم بازی, کینڈینسکی اور بہاؤ، عام طور پر معاون ٹولز کی ایک رینج کے ساتھ استعمال ہوتے ہیں جو اپنی خام پیداوار کو مخصوص تخلیقی ضروریات کو پورا کرنے کے لیے ڈھال لیتے ہیں۔ جب کوئی ڈائریکٹر کہتا ہے، "یہ بہت اچھا لگتا ہے، لیکن کیا ہم اسے تھوڑا اور بنا سکتے ہیں؟" آپ یہ کہہ کر جواب نہیں دے سکتے کہ ماڈل ایسی درخواستوں کو سنبھالنے کے لیے کافی درست نہیں ہے۔

اس کے بجائے ایک AI VFX ٹیم روایتی کی ایک حد استعمال کرے گی۔ CGI اور ساختی تکنیکیں، جو وقت کے ساتھ ساتھ تیار کردہ حسب ضرورت طریقہ کار اور ورک فلو کے ساتھ منسلک ہیں، تاکہ ویڈیو کی ترکیب کی حدود کو تھوڑا آگے بڑھانے کی کوشش کی جا سکے۔

تو تشبیہ کے لحاظ سے، ایک فاؤنڈیشن ویڈیو ماڈل کروم جیسے ویب براؤزر کی ڈیفالٹ انسٹالیشن کی طرح ہے۔ یہ باکس سے باہر بہت کچھ کرتا ہے، لیکن اگر آپ چاہتے ہیں کہ یہ آپ کی ضروریات کے مطابق ہو، بجائے اس کے کہ، آپ کو کچھ پلگ انز کی ضرورت ہوگی۔

کنٹرول فریکس

بازی پر مبنی تصویری ترکیب کی دنیا میں، اس طرح کا تھرڈ پارٹی سسٹم سب سے اہم ہے۔ کنٹرول نیٹ.

کنٹرول نیٹ ڈفیوژن پر مبنی جنریٹو ماڈلز میں سٹرکچرڈ کنٹرول شامل کرنے کی ایک تکنیک ہے، جس سے صارفین کو اضافی ان پٹ کے ساتھ تصویر یا ویڈیو جنریشن کی رہنمائی کرنے کی اجازت ملتی ہے جیسے کنارے کے نقشے, گہرائی کے نقشے، یا پوز معلومات.

کنٹرول نیٹ کے مختلف طریقے گہرائی>تصویر (اوپر کی قطار)، سیمینٹک سیگمنٹیشن>تصویر (نیچے بائیں) اور انسانوں اور جانوروں (نیچے بائیں) کی پوز گائیڈڈ امیج جنریشن کی اجازت دیتے ہیں۔

مکمل طور پر ٹیکسٹ پرامپٹس پر انحصار کرنے کے بجائے، ControlNet علیحدہ نیورل نیٹ ورک برانچز متعارف کراتا ہے، یا اڈاپٹر، جو بیس ماڈل کی تخلیقی صلاحیتوں کو محفوظ رکھتے ہوئے ان کنڈیشنگ سگنلز پر عمل کرتا ہے۔

یہ ٹھیک ٹیون شدہ آؤٹ پٹ کو قابل بناتا ہے جو صارف کی وضاحتوں پر زیادہ قریب سے عمل کرتے ہیں، یہ خاص طور پر ان ایپلی کیشنز میں مفید بناتا ہے جہاں عین مطابق ساخت، ساخت، یا حرکت کنٹرول کی ضرورت ہوتی ہے:

گائیڈنگ پوز کے ساتھ، کنٹرول نیٹ کے ذریعے مختلف قسم کے درست آؤٹ پٹ حاصل کیے جا سکتے ہیں۔ ماخذ: https://arxiv.org/pdf/2302.05543

تاہم، اس قسم کے اڈاپٹر پر مبنی فریم ورک بیرونی طور پر اعصابی عمل کے ایک سیٹ پر کام کرتے ہیں جو بہت اندرونی طور پر مرکوز ہوتے ہیں۔ ان طریقوں میں کئی خرابیاں ہیں۔

سب سے پہلے، اڈاپٹر کو آزادانہ طور پر تربیت دی جاتی ہے، جس کی وجہ سے شاخ کے تنازعات جب ایک سے زیادہ اڈیپٹرز کو جوڑ دیا جاتا ہے، جو نسل کے معیار کو کم کر سکتا ہے۔

دوم، وہ تعارف کراتے ہیں۔ پیرامیٹر فالتو پن, ہر اڈاپٹر کے لیے اضافی حساب اور میموری کی ضرورت ہوتی ہے، اسکیلنگ کو غیر موثر بناتا ہے۔

تیسرا، ان کی لچک کے باوجود، اڈاپٹر اکثر پیدا کرتے ہیں ذیلی زیادہ سے زیادہ نتائج مکمل طور پر ماڈلز کے مقابلے میں ٹھیک دیکھتے ہیں ملٹی کنڈیشن جنریشن کے لیے۔ یہ مسائل اڈاپٹر پر مبنی طریقوں کو ان کاموں کے لیے کم موثر بناتے ہیں جن کے لیے متعدد کنٹرول سگنلز کے ہموار انضمام کی ضرورت ہوتی ہے۔

مثالی طور پر، ControlNet کی صلاحیتوں کو تربیت دی جائے گی۔ natively ماڈل میں، ایک ماڈیولر طریقے سے جو بعد میں اور بہت زیادہ متوقع واضح اختراعات کو ایڈجسٹ کر سکتا ہے جیسے کہ بیک وقت ویڈیو/آڈیو جنریشن، یا مقامی لپ سنک صلاحیتیں (بیرونی آڈیو کے لیے)۔

جیسا کہ یہ کھڑا ہے، فعالیت کا ہر اضافی ٹکڑا یا تو پوسٹ پروڈکشن ٹاسک یا غیر مقامی طریقہ کار کی نمائندگی کرتا ہے جس میں جس بھی فاؤنڈیشن ماڈل پر یہ کام کر رہا ہے اس کے مضبوطی سے پابند اور حساس وزن کو نیویگیٹ کرنا ہوتا ہے۔

FullDiT

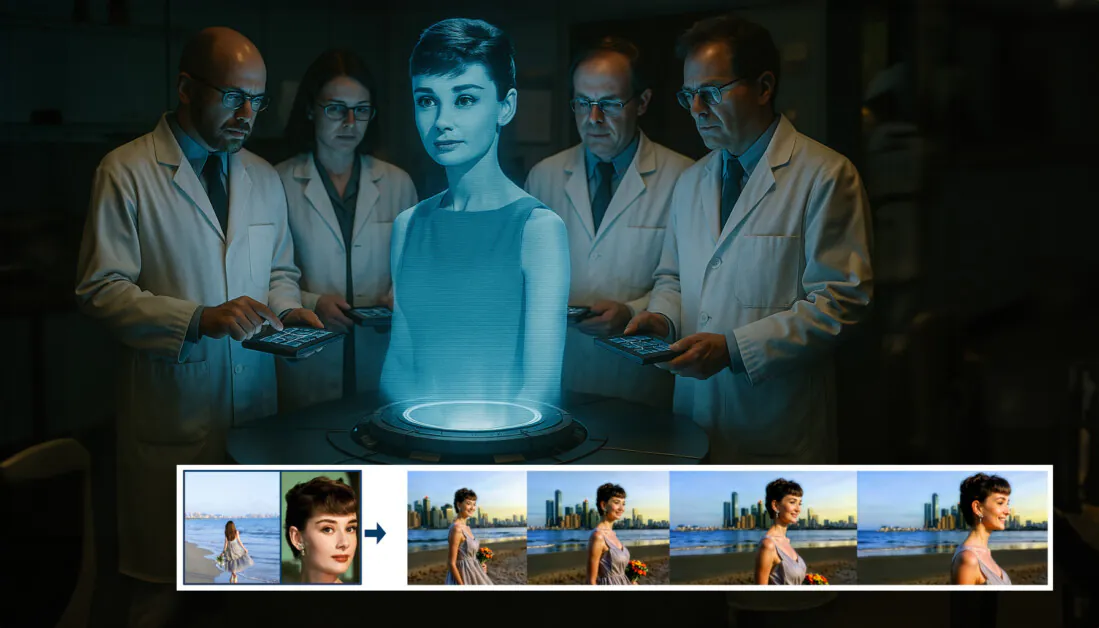

اس تعطل میں چین کی طرف سے ایک نئی پیشکش آتی ہے، جو ایک ایسا نظام پیش کرتا ہے جہاں کنٹرول نیٹ طرز کے اقدامات کو تربیت کے وقت براہ راست ایک تخلیقی ویڈیو ماڈل میں پکایا جاتا ہے، بجائے اس کے کہ بعد میں سوچا جائے۔

نئے کاغذ سے: FullDiT نقطہ نظر مقامی نسل میں شناخت کے نفاذ، گہرائی اور کیمرے کی نقل و حرکت کو شامل کر سکتا ہے، اور ان کے کسی بھی امتزاج کو ایک ساتھ جمع کر سکتا ہے۔. ماخذ: https://arxiv.org/pdf/2503.19907

عنوان FullDiT، نیا نقطہ نظر کثیر کام کی شرائط کو فیوز کرتا ہے جیسے شناخت کی منتقلی، گہرائی کی نقشہ سازی اور کیمرے کی نقل و حرکت کو تربیت یافتہ جنریٹو ویڈیو ماڈل کے ایک مربوط حصے میں، جس کے لیے مصنفین نے ایک پروٹو ٹائپ تربیت یافتہ ماڈل تیار کیا ہے، اور اس کے ساتھ ویڈیو کلپس پروجیکٹ سائٹ.

ذیل کی مثال میں، ہم ایسی نسلوں کو دیکھتے ہیں جو کیمرے کی نقل و حرکت، شناخت کی معلومات اور متن کی معلومات (یعنی صارف کے متن کے اشارے کی رہنمائی کرتے ہیں):

کھیلنے کے لیے کلک کریں۔ صرف مقامی تربیت یافتہ فاؤنڈیشن ماڈل کے ساتھ ControlNet طرز کے صارف کے نفاذ کی مثالیں۔ ماخذ: https://fulldit.github.io/

واضح رہے کہ مصنفین اپنے تجرباتی تربیت یافتہ ماڈل کو ایک فنکشنل فاؤنڈیشن ماڈل کے طور پر تجویز نہیں کرتے ہیں، بلکہ مقامی ٹیکسٹ ٹو ویڈیو (T2V) اور امیج سے ویڈیو (I2V) ماڈلز کے تصور کے ثبوت کے طور پر جو صارفین کو صرف تصویری پرامپٹ یا ٹیکسٹ پرامپٹ سے زیادہ کنٹرول فراہم کرتے ہیں۔

چونکہ ابھی تک اس قسم کا کوئی مماثل ماڈل نہیں ہے، محققین نے ایک نیا بینچ مارک بنایا جس کا عنوان ہے۔ فل بینچ، ملٹی ٹاسک ویڈیوز کی تشخیص کے لیے، اور اس طرح کے ٹیسٹوں میں جدید ترین کارکردگی کا دعویٰ کریں جو انہوں نے پہلے کے طریقوں کے خلاف وضع کیے تھے۔ تاہم، چونکہ فل بینچ کو مصنفین نے خود ڈیزائن کیا تھا، اس لیے اس کی معروضیت کا تجربہ نہیں کیا گیا، اور اس کے 1,400 کیسز کا ڈیٹا سیٹ وسیع تر نتائج اخذ کرنے کے لیے بہت محدود ہو سکتا ہے۔

شاید فن تعمیر کا سب سے دلچسپ پہلو جو کاغذ پیش کرتا ہے وہ نئی قسم کے کنٹرول کو شامل کرنے کی صلاحیت ہے۔ مصنفین فرماتے ہیں:

اس کام میں، ہم صرف کیمرے، شناخت، اور گہرائی کی معلومات کے کنٹرول کے حالات کو تلاش کرتے ہیں۔ ہم نے دیگر حالات اور طریقوں جیسے آڈیو، اسپیچ، پوائنٹ کلاؤڈ، آبجیکٹ باؤنڈنگ باکسز، آپٹیکل فلو وغیرہ کی مزید تفتیش نہیں کی۔ اگرچہ FullDiT کا ڈیزائن کم سے کم فن تعمیر میں ترمیم کے ساتھ دیگر طریقوں کو بغیر کسی رکاوٹ کے مربوط کر سکتا ہے، موجودہ ماڈلز کو کس طرح تیزی سے اور لاگت سے نئے حالات اور طریقوں کے مطابق ڈھالنا ہے کہ جنگی مشقوں کا ایک اہم سوال ہے۔

اگرچہ محققین FullDiT کو ملٹی ٹاسک ویڈیو جنریشن میں ایک قدم کے طور پر پیش کرتے ہیں، لیکن اس پر غور کیا جانا چاہیے کہ یہ نیا کام بنیادی طور پر نئے پیراڈائم کو متعارف کرانے کے بجائے موجودہ فن تعمیر پر استوار ہے۔

بہر حال، FullDiT فی الحال 'ہارڈ کوڈڈ' ControlNet طرز کی سہولیات کے ساتھ ایک ویڈیو فاؤنڈیشن ماڈل کے طور پر (میری بہترین معلومات کے مطابق) اکیلا کھڑا ہے - اور یہ دیکھنا اچھا ہے کہ مجوزہ فن تعمیر بعد کی اختراعات کو بھی ایڈجسٹ کر سکتا ہے۔

کھیلنے کے لیے کلک کریں۔ پراجیکٹ سائٹ سے صارف کے زیر کنٹرول کیمرے کی چالوں کی مثالیں۔

۔ نیا کاغذ عنوان ہے FullDiT: ملٹی ٹاسک ویڈیو جنریٹو فاؤنڈیشن ماڈل پوری توجہ کے ساتھ، اور کوائیشو ٹیکنالوجی اور چینی یونیورسٹی آف ہانگ کانگ کے نو محققین سے آتا ہے۔ پروجیکٹ کا صفحہ ہے۔ یہاں اور نیا بینچ مارک ڈیٹا ہے۔ گلے ملنے والے چہرے پر.

طریقہ

مصنفین کا دعویٰ ہے کہ FullDiT کا متحد توجہ کا طریقہ کار تمام حالات میں مقامی اور وقتی دونوں طرح کے رشتوں کو پکڑ کر مضبوط کراس موڈل نمائندگی سیکھنے کے قابل بناتا ہے:

نئے مقالے کے مطابق، FullDiT متعدد ان پٹ حالات کو مکمل خود توجہ کے ذریعے مربوط کرتا ہے، انہیں ایک متحد ترتیب میں تبدیل کرتا ہے۔ اس کے برعکس، اڈاپٹر پر مبنی ماڈلز (بائیں سب سے اوپر) ہر ان پٹ کے لیے الگ الگ ماڈیول استعمال کرتے ہیں، جس کی وجہ سے فالتو پن، تنازعات اور کمزور کارکردگی ہوتی ہے۔

اڈاپٹر پر مبنی سیٹ اپ کے برعکس جو ہر ان پٹ سٹریم کو الگ سے پروسیس کرتا ہے، یہ مشترکہ توجہ کا ڈھانچہ برانچ کے تنازعات سے بچتا ہے اور پیرامیٹر اوور ہیڈ کو کم کرتا ہے۔ وہ یہ بھی دعویٰ کرتے ہیں کہ فن تعمیر بڑے نئے ڈیزائن کے بغیر نئی ان پٹ قسموں تک پیمانہ کر سکتا ہے - اور یہ کہ ماڈل اسکیما کنڈیشن کے امتزاج کو عام کرنے کی علامات کو ظاہر کرتا ہے جو تربیت کے دوران نہیں دیکھے گئے، جیسے کیمرہ موشن کو کردار کی شناخت سے جوڑنا۔

کھیلنے کے لیے کلک کریں۔ پروجیکٹ سائٹ سے شناخت پیدا کرنے کی مثالیں۔.

FullDiT کے فن تعمیر میں، تمام کنڈیشنگ ان پٹ - جیسے کہ ٹیکسٹ، کیمرہ موشن، شناخت، اور گہرائی - سب سے پہلے ایک متحد ٹوکن فارمیٹ میں تبدیل ہوتے ہیں۔ ان ٹوکنز کو پھر ایک طویل ترتیب میں جوڑ دیا جاتا ہے، جس پر عمل کیا جاتا ہے ٹرانسفارمر مکمل خود توجہ کا استعمال کرتے ہوئے تہوں. یہ نقطہ نظر پہلے کاموں کی پیروی کرتا ہے جیسے اوپن سورا پلان اور فلم جنرل.

یہ ڈیزائن ماڈل کو تمام حالات میں مشترکہ طور پر عارضی اور مقامی تعلقات سیکھنے کی اجازت دیتا ہے۔ ہر ٹرانسفارمر بلاک پورے تسلسل پر کام کرتا ہے، ہر ان پٹ کے لیے الگ الگ ماڈیولز پر انحصار کیے بغیر طریقوں کے درمیان متحرک تعاملات کو فعال کرتا ہے – اور جیسا کہ ہم نے نوٹ کیا ہے، فن تعمیر کو قابل توسیع بنانے کے لیے ڈیزائن کیا گیا ہے، جس سے مستقبل میں اضافی کنٹرول سگنلز کو شامل کرنا بہت آسان ہو جاتا ہے، بغیر بڑی ساختی تبدیلیوں کے۔

تین کی طاقت

FullDiT ہر کنٹرول سگنل کو ایک معیاری ٹوکن فارمیٹ میں تبدیل کرتا ہے تاکہ تمام شرائط کو ایک متحد توجہ کے فریم ورک میں ایک ساتھ پروسیس کیا جا سکے۔ کیمرے کی حرکت کے لیے، ماڈل ہر فریم کے لیے خارجی پیرامیٹرز کی ایک ترتیب کو انکوڈ کرتا ہے - جیسے پوزیشن اور واقفیت -۔ یہ پیرامیٹرز ٹائم اسٹیمپڈ اور ایمبیڈنگ ویکٹرز میں پیش کیے جاتے ہیں جو سگنل کی عارضی نوعیت کی عکاسی کرتے ہیں۔

شناخت کی معلومات کے ساتھ مختلف طریقے سے سلوک کیا جاتا ہے، کیونکہ یہ وقتی کے بجائے فطری طور پر مقامی ہے۔ ماڈل شناختی نقشوں کا استعمال کرتا ہے جو اس بات کی نشاندہی کرتا ہے کہ ہر فریم کے کن حصوں میں کون سے حروف موجود ہیں۔ ان نقشوں کو تقسیم کیا گیا ہے۔ پیچ، ہر ایک پیچ کے ساتھ ایک میں پیش کیا گیا ہے۔ سرایت کرنا جو کہ مقامی شناختی اشارے کیپچر کرتا ہے، ماڈل کو فریم کے مخصوص علاقوں کو مخصوص اداروں کے ساتھ منسلک کرنے کی اجازت دیتا ہے۔

گہرائی ایک spatiotemporal سگنل ہے، اور ماڈل گہرائی کے ویڈیوز کو 3D پیچ میں تقسیم کرکے اسے سنبھالتا ہے جو جگہ اور وقت دونوں پر محیط ہے۔ پھر یہ پیچ اس طرح سے سرایت کیے جاتے ہیں جو ان کی ساخت کو فریموں میں محفوظ رکھتا ہے۔

ایک بار سرایت کرنے کے بعد، یہ تمام کنڈیشن ٹوکن (کیمرہ، شناخت، اور گہرائی) ایک ہی طویل ترتیب میں جوڑ دیے جاتے ہیں، جس سے FullDiT کو مکمل استعمال کرتے ہوئے ان پر ایک ساتھ کارروائی کرنے کی اجازت ملتی ہے۔ خود توجہ. یہ مشترکہ نمائندگی ماڈل کے لیے الگ تھلگ پروسیسنگ اسٹریمز پر انحصار کیے بغیر مختلف طریقوں اور وقت کے ساتھ تعاملات سیکھنا ممکن بناتی ہے۔

ڈیٹا اور ٹیسٹ

FullDiT کا تربیتی نقطہ نظر تمام شرائط کے بیک وقت موجود ہونے کی ضرورت کے بجائے ہر کنڈیشنگ کی قسم کے مطابق منتخب کردہ تشریح شدہ ڈیٹاسیٹس پر انحصار کرتا ہے۔

متنی حالات کے لیے، پہل میں بیان کردہ ساختی کیپشننگ اپروچ کی پیروی کرتا ہے۔ میرا ڈیٹا منصوبے.

میرا ڈیٹا پروجیکٹ سے ویڈیو اکٹھا کرنا اور تشریح پائپ لائن۔ ماخذ: https://arxiv.org/pdf/2407.06358

کیمرے کی حرکت کے لیے، ریئل اسٹیٹ 10K کیمرہ پیرامیٹرز کے اعلی معیار کی زمینی سچائی تشریحات کی وجہ سے ڈیٹاسیٹ مرکزی ڈیٹا کا ذریعہ تھا۔

تاہم، مصنفین نے مشاہدہ کیا کہ خصوصی طور پر سٹیٹک سین کیمرہ ڈیٹاسیٹس جیسے RealEstate10K پر تربیت کا رجحان پیدا ہونے والی ویڈیوز میں متحرک آبجیکٹ اور انسانی حرکات کو کم کرنا تھا۔ اس کا مقابلہ کرنے کے لیے، انہوں نے اندرونی ڈیٹاسیٹس کا استعمال کرتے ہوئے اضافی فائن ٹیوننگ کی جس میں کیمرے کی زیادہ متحرک حرکتیں شامل تھیں۔

کے لیے تیار کردہ پائپ لائن کا استعمال کرتے ہوئے شناختی تشریحات تیار کی گئیں۔ ConceptMaster پروجیکٹ، جس نے موثر فلٹرنگ اور عمدہ شناختی معلومات کو نکالنے کی اجازت دی۔

ConceptMaster فریم ورک کو اپنی مرضی کے مطابق ویڈیوز میں تصور کی وفاداری کو برقرار رکھتے ہوئے شناخت کو الگ کرنے کے مسائل کو حل کرنے کے لیے ڈیزائن کیا گیا ہے۔ ماخذ: https://arxiv.org/pdf/2501.04698

سے گہرائی کی تشریحات حاصل کی گئیں۔ پانڈا-70M ڈیٹا سیٹ کا استعمال کرتے ہوئے گہرائی کچھ بھی.

ڈیٹا آرڈرنگ کے ذریعے اصلاح

مصنفین نے ایک ترقی پسند تربیتی نظام الاوقات کو بھی نافذ کیا، جس سے مزید مشکل حالات متعارف ہوئے۔ تربیت میں پہلے اس بات کو یقینی بنانے کے لیے کہ ماڈل نے آسان کاموں کو شامل کرنے سے پہلے مضبوط نمائندگی حاصل کر لی۔ سے تربیت کا حکم جاری ہوا۔ متن کرنے کے لئے کیمرہ حالات، پھر شناخت، اور آخر میں گہرائی، عام طور پر بعد میں متعارف کرائے گئے آسان کاموں کے ساتھ اور کم مثالوں کے ساتھ۔

مصنفین کام کے بوجھ کو اس طرح ترتیب دینے کی قدر پر زور دیتے ہیں:

'تربیت سے پہلے کے مرحلے کے دوران، ہم نے نوٹ کیا کہ زیادہ چیلنجنگ کاموں کے لیے تربیتی وقت میں توسیع کی ضرورت ہے اور سیکھنے کے عمل میں پہلے متعارف کرایا جانا چاہیے۔ ان چیلنجنگ کاموں میں پیچیدہ ڈیٹا کی تقسیم شامل ہوتی ہے جو آؤٹ پٹ ویڈیو سے نمایاں طور پر مختلف ہوتی ہے، جس کے لیے ماڈل کو ان کی درستگی اور نمائندگی کرنے کے لیے کافی صلاحیت رکھنے کی ضرورت ہوتی ہے۔

'اس کے برعکس، آسان کاموں کو بہت جلد متعارف کروانے سے ماڈل ان کو سب سے پہلے سیکھنے کو ترجیح دے سکتا ہے، کیونکہ وہ زیادہ فوری اصلاحی تاثرات فراہم کرتے ہیں، جو زیادہ چیلنجنگ کاموں کے یکجا ہونے میں رکاوٹ ہیں۔'

محققین کے ذریعہ اختیار کردہ ڈیٹا ٹریننگ آرڈر کی ایک مثال، جس میں سرخ رنگ سے زیادہ ڈیٹا والیوم کی نشاندہی ہوتی ہے۔

ابتدائی پری ٹریننگ کے بعد، فائنل فائن ٹیوننگ مرحلے نے بصری معیار اور حرکت کی حرکیات کو بہتر بنانے کے لیے ماڈل کو مزید بہتر کیا۔ اس کے بعد ٹریننگ ایک معیاری ڈفیوژن فریم ورک* کی پیروی کی گئی: ویڈیو لیٹنٹ میں شور شامل کیا گیا، اور ماڈل پیشن گوئی کرنا اور اسے ہٹانا سیکھناایمبیڈڈ کنڈیشن ٹوکن کو بطور رہنمائی استعمال کرنا۔

FullDiT کا مؤثر طریقے سے جائزہ لینے اور موجودہ طریقوں کے مقابلے میں ایک منصفانہ موازنہ فراہم کرنے کے لیے، اور کسی دوسرے متضاد بینچ مارک کی دستیابی کی عدم موجودگی میں، مصنفین نے متعارف کرایا۔ فل بینچ1,400 الگ الگ ٹیسٹ کیسز پر مشتمل ایک کیوریٹڈ بینچ مارک سویٹ۔

نئے فل بینچ بینچ مارک کے لیے ڈیٹا ایکسپلورر کی مثال۔ ماخذ: https://huggingface.co/datasets/KwaiVGI/FullBench

ہر ڈیٹا پوائنٹ نے مختلف کنڈیشنگ سگنلز کے لیے زمینی سچائی کی تشریحات فراہم کیں، بشمول کیمرے کی تحریک, شناخت، اور گہرائی.

پیمائش کا معیار

مصنفین نے کارکردگی کے پانچ اہم پہلوؤں پر محیط دس میٹرکس کا استعمال کرتے ہوئے FullDiT کا جائزہ لیا: ٹیکسٹ الائنمنٹ، کیمرہ کنٹرول، شناخت کی مماثلت، گہرائی کی درستگی، اور عمومی ویڈیو کوالٹی۔

متن کی سیدھ کا استعمال کرتے ہوئے پیمائش کی گئی۔ CLIP مماثلت، جبکہ کیمرہ کنٹرول کے ذریعے اندازہ کیا گیا تھا۔ گردش کی خرابی (RotErr), ترجمہ کی غلطی (TransErr)، اور کیمرے کی حرکت کی مستقل مزاجی (CamMC)، کے نقطہ نظر کے بعد CamI2V (میں CameraCtrl پروجیکٹ)۔

شناخت کی مماثلت کا استعمال کرتے ہوئے اندازہ کیا گیا۔ DINO-I اور CLIP-I، اور گہرائی کے کنٹرول کی درستگی کا استعمال کرتے ہوئے مقدار درست کی گئی۔ مطلب مطلق غلطی (MAE)۔

ویڈیو کے معیار کو میرا ڈیٹا سے تین میٹرکس کے ساتھ پرکھا گیا: ہمواری کے لیے فریم لیول CLIP مماثلت؛ حرکیات کے لیے نظری بہاؤ پر مبنی حرکت کا فاصلہ؛ اور LAION- جمالیاتی اسکورز بصری اپیل کے لیے۔

ٹریننگ

مصنفین نے تقریباً ایک ارب پیرامیٹرز پر مشتمل ایک اندرونی (غیر ظاہر شدہ) ٹیکسٹ ٹو ویڈیو ڈفیوژن ماڈل کا استعمال کرتے ہوئے FullDiT کو تربیت دی۔ انہوں نے جان بوجھ کر ایک معمولی پیرامیٹر سائز کا انتخاب کیا تاکہ پہلے کے طریقوں کے مقابلے میں انصاف پسندی کو برقرار رکھا جا سکے اور تولیدی صلاحیت کو یقینی بنایا جا سکے۔

چونکہ تربیتی ویڈیوز کی لمبائی اور ریزولوشن میں فرق تھا، مصنفین نے ہر ایک کو معیاری بنایا بیچ ایک مشترکہ ریزولوشن میں ویڈیوز کا سائز تبدیل کرکے اور پیڈنگ کرکے، فی ترتیب 77 فریموں کے نمونے لے کر، اور قابل توجہ توجہ کا استعمال کرتے ہوئے اور نقصان کے ماسک تربیت کی تاثیر کو بہتر بنانے کے لیے۔

۔ آدم ایک میں اصلاح کار استعمال کیا گیا تھا۔ سیکھنے کی شرح 1 × 10 کا5- 64 NVIDIA H800 GPUs کے کلسٹر میں، مجموعی طور پر 5,120GB VRAM کے لیے (اس بات پر غور کریں کہ پرجوش ترکیب کی کمیونٹیز میں، 24GB RTX 3090 پر اب بھی ایک پرتعیش معیار سمجھا جاتا ہے)۔

ماڈل کو تقریباً 32,000 مراحل کے لیے تربیت دی گئی تھی، جس میں فی ویڈیو تین شناختوں کو شامل کیا گیا تھا، اس کے ساتھ کیمرہ کے حالات کے 20 فریم اور گہرائی کے حالات کے 21 فریم شامل تھے، دونوں کو کل 77 فریموں سے یکساں طور پر نمونہ بنایا گیا تھا۔

اندازہ کے لیے، ماڈل نے 384 ڈفیوژن انفرنس اسٹیپس کے ساتھ 672×15 پکسلز (تقریباً پانچ سیکنڈز 50 فریم فی سیکنڈ) کے ریزولوشن پر ویڈیوز بنائے اور پانچ کے درجہ بندی سے پاک رہنمائی کے پیمانے کے ساتھ۔

پہلے کے طریقے

کیمرے سے ویڈیو کی تشخیص کے لیے، مصنفین نے FullDiT کا موازنہ کیا۔ MotionCtrl، CameraCtrl، اور CamI2V، مستقل مزاجی اور انصاف پسندی کو یقینی بنانے کے لیے RealEstate10k ڈیٹاسیٹ کا استعمال کرتے ہوئے تربیت یافتہ تمام ماڈلز کے ساتھ۔

شناخت کنڈیشنڈ جنریشن میں، چونکہ کوئی موازنہ اوپن سورس ملٹی آئیڈینٹی ماڈل دستیاب نہیں تھا، اسی ٹریننگ ڈیٹا اور فن تعمیر کا استعمال کرتے ہوئے، ماڈل کو 1B-پیرامیٹر ConceptMaster ماڈل کے خلاف بینچ مارک کیا گیا تھا۔

گہرائی سے ویڈیو کے کاموں کے لیے، موازنہ کیا گیا۔ Ctrl-اڈاپٹر اور کنٹرول ویڈیو.

سنگل ٹاسک ویڈیو جنریشن کے لیے مقداری نتائج۔ FullDiT کا موازنہ MotionCtrl، CameraCtrl، اور CamI2V سے کیمرے سے ویڈیو جنریشن کے لیے کیا گیا تھا۔ ConceptMaster (1B پیرامیٹر ورژن) شناخت سے ویڈیو کے لیے؛ اور گہرائی سے ویڈیو کے لیے Ctrl-Adapter اور ControlVideo۔ تمام ماڈلز کا ان کی ڈیفالٹ سیٹنگز کا استعمال کرتے ہوئے جائزہ لیا گیا۔ مستقل مزاجی کے لیے، ہر طریقہ سے 16 فریموں کا یکساں نمونہ لیا گیا، جو کہ پچھلے ماڈلز کی آؤٹ پٹ لمبائی سے مماثل ہے۔

نتائج سے ظاہر ہوتا ہے کہ FullDiT، بیک وقت متعدد کنڈیشنگ سگنلز کو سنبھالنے کے باوجود، ٹیکسٹ، کیمرہ موشن، شناخت، اور گہرائی کے کنٹرول سے متعلق میٹرکس میں جدید ترین کارکردگی حاصل کرتا ہے۔

مجموعی معیار کی پیمائش میں، نظام نے عام طور پر دوسرے طریقوں سے بہتر کارکردگی کا مظاہرہ کیا، حالانکہ اس کی ہمواری ConceptMaster کے مقابلے میں قدرے کم تھی۔ یہاں مصنفین کا تبصرہ ہے:

'FullDiT کی ہمواری ConceptMaster کی نسبت قدرے کم ہے کیونکہ ہمواری کا حساب ملحقہ فریموں کے درمیان CLIP مماثلت پر مبنی ہے۔ چونکہ FullDiT ConceptMaster کے مقابلے میں نمایاں طور پر زیادہ حرکیات کی نمائش کرتا ہے، ہمواری میٹرک ملحقہ فریموں کے درمیان بڑے تغیرات سے متاثر ہوتا ہے۔

'جمالیاتی اسکور کے لیے، چونکہ درجہ بندی کا ماڈل پینٹنگ کے انداز میں تصاویر کی حمایت کرتا ہے اور ControlVideo عام طور پر اس انداز میں ویڈیوز بناتا ہے، اس لیے یہ جمالیات میں اعلیٰ سکور حاصل کرتا ہے۔'

کوالٹیٹیو موازنے کے حوالے سے، FullDiT پروجیکٹ سائٹ پر نمونہ ویڈیوز کا حوالہ دینا بہتر ہوگا، کیونکہ پی ڈی ایف کی مثالیں لامحالہ جامد ہیں (اور یہاں مکمل طور پر دوبارہ پیش کرنے کے لیے بہت بڑی ہیں)۔

پی ڈی ایف میں معیار کے نتائج کا پہلا حصہ۔ براہ کرم اضافی مثالوں کے لیے ماخذ کاغذ کا حوالہ دیں، جو یہاں دوبارہ پیش کرنے کے لیے بہت وسیع ہیں۔

مصنفین کا تبصرہ:

'FullDiT بہتر شناخت کے تحفظ کا مظاہرہ کرتا ہے اور [ConceptMaster] کے مقابلے بہتر حرکیات اور بصری معیار کے ساتھ ویڈیوز بناتا ہے۔ چونکہ ConceptMaster اور FullDiT ایک ہی ریڑھ کی ہڈی پر تربیت یافتہ ہیں، اس لیے یہ پوری توجہ کے ساتھ کنڈیشن انجیکشن کی تاثیر کو نمایاں کرتا ہے۔

'...[دیگر] نتائج موجودہ گہرائی سے ویڈیو اور کیمرہ سے ویڈیو طریقوں کے مقابلے FullDiT کی اعلیٰ کنٹرولیبلٹی اور جنریشن کوالٹی کو ظاہر کرتے ہیں۔'

ایک سے زیادہ سگنلز کے ساتھ FullDiT کے آؤٹ پٹ کی PDF کی مثالوں کا ایک حصہ۔ اضافی مثالوں کے لیے براہ کرم سورس پیپر اور پروجیکٹ سائٹ کا حوالہ دیں۔

نتیجہ

اگرچہ FullDiT ایک مکمل خصوصیات والے ویڈیو فاؤنڈیشن ماڈل کی ایک دلچسپ پیش قدمی ہے، لیکن کسی کو یہ سوچنا ہوگا کہ کیا ControlNet طرز کے آلات کی مانگ کبھی بھی اس طرح کی خصوصیات کو پیمانے پر نافذ کرنے کا جواز پیش کرے گی، کم از کم FOSS پروجیکٹس کے لیے، جو GPU پروسیسنگ پاور کی بہت زیادہ مقدار حاصل کرنے کے لیے جدوجہد کرے گی، بغیر تجارتی حمایت کے۔

بنیادی چیلنج یہ ہے کہ ڈیپتھ اور پوز جیسے سسٹمز کو استعمال کرنے کے لیے عام طور پر نسبتاً پیچیدہ یوزر انٹرفیس جیسے ComfyUI سے غیر معمولی واقفیت کی ضرورت ہوتی ہے۔ اس لیے ایسا لگتا ہے کہ اس قسم کا ایک فنکشنل FOSS ماڈل زیادہ تر چھوٹی VFX کمپنیوں کے کیڈر کے ذریعے تیار کیا جائے گا جس کے پاس پیسے کی کمی ہے (یا مرضی، یہ دیکھتے ہوئے کہ اس طرح کے سسٹمز کو ماڈل اپ گریڈ کے ذریعے فوری طور پر متروک کر دیا جاتا ہے) بند دروازوں کے پیچھے ایسے ماڈل کو درست اور تربیت دینے کے لیے۔

دوسری طرف، API سے چلنے والے 'rent-an-AI' سسٹمز ان ماڈلز کے لیے آسان اور زیادہ صارف دوست تشریحی طریقے تیار کرنے کے لیے اچھی طرح سے حوصلہ افزائی کر سکتے ہیں جن میں ذیلی کنٹرول سسٹمز کو براہ راست تربیت دی گئی ہے۔

کھیلنے کے لیے کلک کریں۔ FullDiT کا استعمال کرتے ہوئے ویڈیو جنریشن پر ڈیپتھ + ٹیکسٹ کنٹرولز لگائے گئے ہیں۔

* مصنفین کسی بھی معروف بیس ماڈل کی وضاحت نہیں کرتے ہیں (یعنی، SDXL، وغیرہ)

پہلی بار جمعرات 27 مارچ 2025 کو شائع ہوا۔