مصنوعی ذہانت

ملٹی موڈل AI تیار ہوتا ہے جیسا کہ ChatGPT GPT-4V (ision) کے ساتھ بینائی حاصل کرتا ہے۔

AI کو انسانوں جیسا بنانے کی جاری کوششوں میں، OpenAI کے GPT ماڈلز نے مسلسل حدود کو آگے بڑھایا ہے۔ GPT-4 اب متن اور تصاویر دونوں کے اشارے قبول کرنے کے قابل ہے۔

جنریٹو AI میں ملٹی موڈیلٹی ان پٹ کی بنیاد پر متن، تصاویر، یا آڈیو جیسے متنوع آؤٹ پٹ تیار کرنے کی ماڈل کی صلاحیت کو ظاہر کرتی ہے۔ مخصوص ڈیٹا پر تربیت یافتہ یہ ماڈلز AI ایپلی کیشنز کو مزید تقویت دیتے ہوئے اسی طرح کا نیا ڈیٹا تیار کرنے کے لیے بنیادی نمونے سیکھتے ہیں۔

ملٹی موڈل AI میں حالیہ پیشرفت

اس فیلڈ میں ایک حالیہ قابل ذکر چھلانگ DALL-E 3 کے ChatGPT میں انضمام کے ساتھ نظر آتی ہے، جو OpenAI کی ٹیکسٹ ٹو امیج ٹیکنالوجی میں ایک اہم اپ گریڈ ہے۔ یہ آمیزہ ایک ہموار تعامل کی اجازت دیتا ہے جہاں ChatGPT DALL-E 3 کے لیے درست اشارے تیار کرنے میں مدد کرتا ہے، اور صارف کے خیالات کو AI سے تیار کردہ آرٹ میں تبدیل کرتا ہے۔ لہذا، جبکہ صارفین DALL-E 3 کے ساتھ براہ راست بات چیت کر سکتے ہیں، ChatGPT کو مکس میں رکھنے سے AI آرٹ بنانے کے عمل کو بہت زیادہ صارف دوست بناتا ہے۔

DALL-E 3 اور ChatGPT کے ساتھ اس کے انضمام پر مزید دیکھیں یہاں. یہ تعاون نہ صرف ملٹی موڈل AI میں پیشرفت کو ظاہر کرتا ہے بلکہ صارفین کے لیے AI آرٹ تخلیق کو ہوا کا جھونکا بھی بناتا ہے۔

دوسری جانب گوگل کی صحت نے اس سال جون میں Med-PaLM M متعارف کرایا تھا۔ یہ ایک ملٹی موڈل جنریٹیو ماڈل ہے جو متنوع بائیو میڈیکل ڈیٹا کو انکوڈنگ اور تشریح کرنے میں ماہر ہے۔ یہ ایک اوپن سورس بینچ مارک، ملٹی میڈ بینچ کا استعمال کرتے ہوئے میڈیکل ڈومینز کو پورا کرنے کے لیے، ایک لینگویج ماڈل، PaLM-E کو فائن ٹیوننگ کے ذریعے حاصل کیا گیا۔ یہ بینچ مارک، 1 بائیو میڈیکل ڈیٹا کی اقسام میں 7 ملین سے زیادہ نمونوں پر مشتمل ہے اور 14 کاموں جیسے طبی سوالوں کے جوابات اور ریڈیولوجی رپورٹ تیار کرنا۔

مختلف صنعتیں کاروبار کی توسیع، آپریشن کو ہموار کرنے، اور کسٹمر کی مصروفیت کو بڑھانے کے لیے جدید ملٹی موڈل AI ٹولز کو اپنا رہی ہیں۔ آواز، ویڈیو، اور ٹیکسٹ AI صلاحیتوں میں پیش رفت ملٹی موڈل AI کی ترقی کو آگے بڑھا رہی ہے۔

انٹرپرائزز ملٹی موڈل AI ایپلی کیشنز تلاش کرتے ہیں جو کاروباری ماڈلز اور پراسیسز کو اوور ہال کرنے کے قابل ہوں، ڈیٹا ٹولز سے لے کر ابھرتی ہوئی AI ایپلی کیشنز تک، جنریٹیو AI ایکو سسٹم میں ترقی کی راہیں کھولیں۔

مارچ میں GPT-4 کے آغاز کے بعد، کچھ صارفین نے وقت کے ساتھ ساتھ اس کے ردعمل کے معیار میں کمی دیکھی، جس کی بازگشت قابل ذکر ڈویلپرز اور OpenAI کے فورمز پر ہے۔ ابتدائی طور پر ایک OpenAI کی طرف سے مسترد کر دیا گیا، بعد میں مطالعہ مسئلہ کی تصدیق کی. اس نے مارچ اور جون کے درمیان GPT-4 کی درستگی میں 97.6% سے 2.4% تک گراوٹ کا انکشاف کیا، جو بعد کے ماڈل اپ ڈیٹس کے ساتھ جواب کے معیار میں کمی کی نشاندہی کرتا ہے۔

چاروں طرف ہائپ AI کھولیں۔ ChatGPT اب واپس آ گیا ہے۔ اب یہ وژن کی خصوصیت کے ساتھ آتا ہے۔ GPT-4V، صارفین کو ان کی طرف سے دی گئی GPT-4 کا تجزیہ کرنے کی اجازت دیتا ہے۔ یہ سب سے نئی خصوصیت ہے جو صارفین کے لیے کھولی گئی ہے۔

GPT-4 جیسے بڑے لینگویج ماڈلز (LLMs) میں تصویری تجزیہ شامل کرنا کچھ لوگوں کے نزدیک AI تحقیق اور ترقی میں ایک بڑا قدم ہے۔ اس قسم کا ملٹی موڈل LLM نئے امکانات کو کھولتا ہے، نئے انٹرفیس پیش کرنے اور نئے قسم کے کاموں کو حل کرنے کے لیے زبان کے ماڈلز کو متن سے آگے لے کر صارفین کے لیے تازہ تجربات پیدا کرتا ہے۔

GPT-4V کی تربیت 2022 میں ختم ہو گئی تھی، مارچ 2023 میں ابتدائی رسائی کے ساتھ۔ GPT-4V میں بصری خصوصیت GPT-4 ٹیک سے چلتی ہے۔ تربیت کا عمل جوں کا توں رہا۔ ابتدائی طور پر، ماڈل کو انٹرنیٹ سمیت مختلف ذرائع سے متن اور تصاویر دونوں کے بڑے ڈیٹاسیٹ کا استعمال کرتے ہوئے متن میں اگلے لفظ کی پیش گوئی کرنے کی تربیت دی گئی۔

بعد میں، اسے مزید اعداد و شمار کے ساتھ ٹھیک بنایا گیا، جس میں انسانی تاثرات سے کمک سیکھنے (RLHF) کے نام سے ایک طریقہ استعمال کیا گیا، تاکہ وہ نتائج پیدا کیے جا سکیں جنہیں انسانوں نے ترجیح دی۔

GPT-4 ویژن میکینکس

GPT-4 کی قابل ذکر وژن لینگوئج کی صلاحیتیں، اگرچہ متاثر کن ہیں، ان کے بنیادی طریقے ہیں جو سطح پر موجود ہیں۔

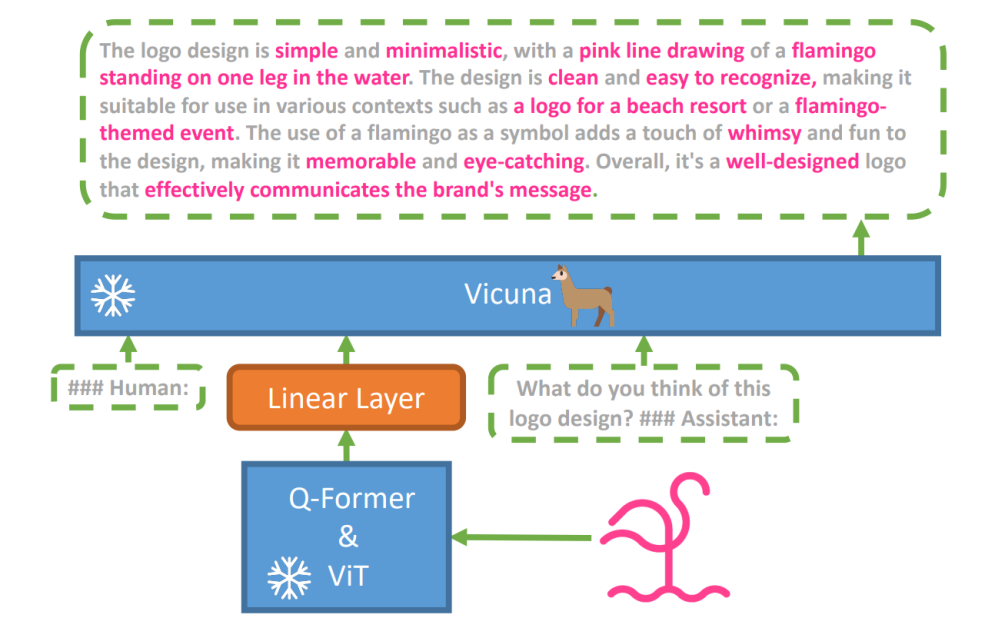

اس مفروضے کو دریافت کرنے کے لیے، ایک نیا وژن لینگویج ماڈل، miniGPT-4 متعارف کرایا گیا تھا، جس کا نام ایک اعلی درجے کی LLM کا استعمال کیا گیا تھا۔ وکونا. یہ ماڈل بصری ادراک کے لیے پہلے سے تربیت یافتہ اجزاء کے ساتھ وژن انکوڈر کا استعمال کرتا ہے، انکوڈ شدہ بصری خصوصیات کو ایک واحد پروجیکشن پرت کے ذریعے ویکونا لینگویج ماڈل کے ساتھ سیدھ میں لاتا ہے۔ MiniGPT-4 کا فن تعمیر سادہ لیکن موثر ہے، جس میں بصری گفتگو کی صلاحیتوں کو بہتر بنانے کے لیے بصری اور زبان کی خصوصیات کو سیدھ میں لانے پر توجہ دی گئی ہے۔

MiniGPT-4 کے فن تعمیر میں پہلے سے تربیت یافتہ ViT اور Q-Former کے ساتھ ایک وژن انکوڈر، ایک واحد لکیری پروجیکشن لیئر، اور ایک اعلی درجے کی Vicuna لارج لینگویج ماڈل شامل ہے۔

زبان اور ملٹی موڈل ڈومینز کے درمیان علم کو بانٹنے کے لیے کراس موڈل ٹرانسفر پر سرمایہ کاری کرتے ہوئے وژن لینگویج کے کاموں میں خود مختار زبان کے ماڈلز کا رجحان بھی بڑھ گیا ہے۔

MiniGPT-4 ایک اعلی درجے کی LLM کے ساتھ پہلے سے تربیت یافتہ وژن انکوڈر سے بصری معلومات کو سیدھ میں لا کر بصری اور زبان کے ڈومینز کو ملاتا ہے۔ ماڈل Vicuna کو زبان کے ڈیکوڈر کے طور پر استعمال کرتا ہے اور دو مراحل کی تربیت کے طریقہ کار کی پیروی کرتا ہے۔ ابتدائی طور پر، اسے بصارت کی زبان کے علم کو سمجھنے کے لیے تصویری متن کے جوڑوں کے ایک بڑے ڈیٹاسیٹ پر تربیت دی جاتی ہے، اس کے بعد ایک چھوٹے، اعلیٰ معیار کے ڈیٹاسیٹ پر فائن ٹیوننگ کی جاتی ہے تاکہ نسل کے اعتبار اور استعمال کو بڑھایا جا سکے۔

MiniGPT-4 میں تخلیق شدہ زبان کی فطری اور قابل استعمال کو بہتر بنانے کے لیے، محققین نے وژن کی زبان کی سیدھ میں ڈیٹا سیٹس کی کمی کو دور کرتے ہوئے، دو مراحل کی سیدھ کا عمل تیار کیا۔ انہوں نے اس مقصد کے لیے ایک خصوصی ڈیٹاسیٹ تیار کیا۔

ابتدائی طور پر، ماڈل نے ان پٹ امیجز کی تفصیلی وضاحت تیار کی، جس میں Vicuna لینگویج ماڈل کے فارمیٹ کے ساتھ منسلک بات چیت کے پرامپٹ کا استعمال کرتے ہوئے تفصیل کو بڑھایا۔ اس مرحلے کا مقصد تصویر کی مزید جامع وضاحتیں تیار کرنا ہے۔

ابتدائی تصویری تفصیل کا اشارہ:

###انسان: اس تصویر کو تفصیل سے بیان کریں۔ زیادہ سے زیادہ تفصیلات بتائیں۔ جو کچھ تم دیکھتے ہو بولو۔ ### معاون:

ڈیٹا پوسٹ پروسیسنگ کے لیے، ChatGPT کا استعمال کرتے ہوئے پیدا کردہ تفصیل میں کسی بھی تضاد یا غلطی کو درست کیا گیا، جس کے بعد اعلیٰ معیار کو یقینی بنانے کے لیے دستی تصدیق کی گئی۔

دوسرے مرحلے کے فائن ٹیوننگ پرامپٹ:

###انسان: ### معاون:

یہ ریسرچ GPT-4 جیسے ملٹی موڈل جنریٹو AI کے میکانکس کو سمجھنے کے لیے ایک ونڈو کھولتی ہے، اس بات پر روشنی ڈالتی ہے کہ مربوط اور سیاق و سباق سے بھرپور نتائج پیدا کرنے کے لیے وژن اور زبان کے طریقوں کو مؤثر طریقے سے کیسے مربوط کیا جا سکتا ہے۔

GPT-4 ویژن کی تلاش

ChatGPT کے ساتھ تصویری اصلیت کا تعین کرنا

GPT-4 وژن ChatGPT کی تصاویر کا تجزیہ کرنے اور ان کے جغرافیائی ماخذ کی نشاندہی کرنے کی صلاحیت کو بڑھاتا ہے۔ یہ خصوصیت صارف کے تعاملات کو صرف متن سے متن اور بصری کے مرکب میں منتقل کرتی ہے، جو تصویری ڈیٹا کے ذریعے مختلف جگہوں کے بارے میں دلچسپی رکھنے والوں کے لیے ایک آسان ٹول بن جاتی ہے۔

پیچیدہ ریاضی کے تصورات

GPT-4 وژن گرافیکل یا ہاتھ سے لکھے ہوئے تاثرات کا تجزیہ کرکے پیچیدہ ریاضیاتی خیالات کو تلاش کرنے میں بہترین ہے۔ یہ فیچر ان افراد کے لیے ایک مفید ٹول کے طور پر کام کرتا ہے جو ریاضی کے پیچیدہ مسائل کو حل کرنے کے خواہاں ہیں، جس سے GPT-4 Vision تعلیمی اور تعلیمی شعبوں میں ایک قابل ذکر امداد ہے۔

ہاتھ سے لکھے ہوئے ان پٹ کو LaTeX کوڈز میں تبدیل کرنا

GPT-4V کی قابل ذکر صلاحیتوں میں سے ایک اس کی ہاتھ سے لکھی ہوئی معلومات کو LaTeX کوڈز میں ترجمہ کرنے کی صلاحیت ہے۔ یہ فیچر محققین، ماہرین تعلیم اور طلباء کے لیے ایک اعزاز ہے جنہیں اکثر ہاتھ سے لکھے ہوئے ریاضی کے تاثرات یا دیگر تکنیکی معلومات کو ڈیجیٹل فارمیٹ میں تبدیل کرنے کی ضرورت ہوتی ہے۔ ہاتھ سے لکھے ہوئے سے LaTeX میں تبدیلی دستاویز کی ڈیجیٹلائزیشن کے افق کو وسعت دیتی ہے اور تکنیکی تحریری عمل کو آسان بناتی ہے۔

ٹیبل کی تفصیلات نکالنا

GPT-4V میزوں سے تفصیلات نکالنے اور متعلقہ استفسارات کو حل کرنے میں مہارت کا مظاہرہ کرتا ہے، جو ڈیٹا کے تجزیہ میں ایک اہم اثاثہ ہے۔ صارفین GPT-4V کو ٹیبلز کو چھاننے، اہم بصیرتیں جمع کرنے، اور ڈیٹا پر مبنی سوالات کو حل کرنے کے لیے استعمال کر سکتے ہیں، جس سے یہ ڈیٹا تجزیہ کاروں اور دیگر پیشہ ور افراد کے لیے ایک مضبوط ٹول ہے۔

بصری پوائنٹنگ کو سمجھنا

GPT-4V کی بصری پوائنٹنگ کو سمجھنے کی منفرد صلاحیت صارف کے تعامل میں ایک نئی جہت کا اضافہ کرتی ہے۔ بصری اشارے کو سمجھ کر، GPT-4V اعلی سیاق و سباق کی سمجھ کے ساتھ سوالات کا جواب دے سکتا ہے۔

ڈرائنگ کا استعمال کرتے ہوئے سادہ موک اپ ویب سائٹس بنانا

اس کی طرف سے حوصلہ افزائی پیغامات، میں نے unite.ai ویب سائٹ کے لیے ایک فرضی اپ بنانے کی کوشش کی۔

اگرچہ نتیجہ میرے ابتدائی نقطہ نظر سے بالکل مماثل نہیں تھا، یہاں میں نے حاصل کیا نتیجہ ہے۔

GPT-4V (ision) کی حدود اور خامیاں

GPT-4V کا تجزیہ کرنے کے لیے، اوپن اے آئی ٹیم نے کوالٹیٹیو اور مقداری جائزے کئے۔ کوالٹیٹو میں داخلی ٹیسٹ اور بیرونی ماہرین کے جائزے شامل تھے، جب کہ مقداری میں مختلف منظرناموں جیسے کہ نقصان دہ مواد کی شناخت، آبادیاتی شناخت، رازداری کے خدشات، جغرافیائی محل وقوع، سائبرسیکیوریٹی، اور ملٹی موڈل جیل بریکز میں ماڈل کے انکار اور درستگی کی پیمائش کی گئی۔

پھر بھی ماڈل کامل نہیں ہے۔

۔ کاغذ GPT-4V کی حدود کو نمایاں کرتا ہے، جیسا کہ غلط قیاس آرائیاں اور تصاویر میں متن یا حروف غائب ہیں۔ یہ حقائق کو دھوکہ دے سکتا ہے یا ایجاد کر سکتا ہے۔ خاص طور پر، یہ تصاویر میں خطرناک مادوں کی شناخت کے لیے موزوں نہیں ہے، اکثر ان کی غلط شناخت کرتے ہیں۔

میڈیکل امیجنگ میں، GPT-4V متضاد ردعمل فراہم کر سکتا ہے اور معیاری طریقوں سے آگاہی کا فقدان ہے، جس کی وجہ سے ممکنہ غلط تشخیص ہو سکتی ہے۔

طبی مقاصد کے لیے ناقابل اعتماد کارکردگی (ماخذ)

یہ بعض نفرت کی علامتوں کی باریکیوں کو سمجھنے میں بھی ناکام رہتا ہے اور بصری معلومات کی بنیاد پر نامناسب مواد تیار کر سکتا ہے۔ OpenAI اہم تشریحات کے لیے GPT-4V استعمال کرنے کے خلاف مشورہ دیتا ہے، خاص طور پر طبی یا حساس سیاق و سباق میں۔

ختم کرو

Fast Stable Diffusion XL کا استعمال کرتے ہوئے تخلیق کیا گیا۔ https://huggingface.co/spaces/google/sdxl

GPT-4 Vision (GPT-4V) کی آمد بہت سارے ٹھنڈے امکانات اور نئی رکاوٹوں کو عبور کرتی ہے۔ اس کو رول آؤٹ کرنے سے پہلے، خطرات کو یقینی بنانے کے لیے کافی کوششیں کی گئی ہیں، خاص طور پر جب بات لوگوں کی تصویروں کی ہو، اچھی طرح سے دیکھے اور کم کیے جائیں۔ یہ دیکھنا متاثر کن ہے کہ GPT-4V نے کس طرح قدم بڑھایا ہے، جس میں طب اور سائنس جیسے مشکل شعبوں میں بہت زیادہ وعدہ دکھایا گیا ہے۔

اب، میز پر کچھ بڑے سوالات ہیں. مثال کے طور پر، کیا ان ماڈلز کو تصاویر سے مشہور لوگوں کی شناخت کرنے کے قابل ہونا چاہیے؟ کیا انہیں تصویر سے کسی شخص کی جنس، نسل یا احساسات کا اندازہ لگانا چاہیے؟ اور، کیا بصارت سے محروم افراد کی مدد کے لیے خصوصی موافقتیں ہونی چاہئیں؟ یہ سوالات رازداری، انصاف پسندی، اور AI کو ہماری زندگیوں میں کیسے فٹ ہونا چاہیے، کے بارے میں کیڑے کھولتے ہیں، جس میں ہر ایک کو کہنا چاہیے۔