اینڈرسن کا زاویہ

زبان کے ماڈلز کو 'دوستانہ' بننے پر مجبور کرنا انہیں مزید غلط اور غیر محفوظ بناتا ہے۔

ChatGPT طرز کے بوٹس جو گرم اور دیکھ بھال کرنے کے لیے تربیت یافتہ ہیں وہ آپ کو یہ بتانے کا زیادہ امکان رکھتے ہیں کہ آپ کیا سننا چاہتے ہیں، چاہے یہ غلط ہی کیوں نہ ہو۔ ایک نئی تحقیق سے پتا چلا ہے کہ 'دوستانہ' ہونے کے لیے تربیت یافتہ AIs کے غلط جواب دینے، سازشی نظریات کو آگے بڑھانے، یا واضح طور پر غلط عقائد سے اتفاق کرنے کا امکان 30 فیصد تک زیادہ ہوتا ہے، خاص طور پر جب صارفین اداس یا کمزور لگتے ہیں۔

تکنیکی مصنوعات اور خدمات کو معمولی یا 'geek' ڈیموگرافکس سے ہٹ کر مرکزی دھارے کے صارفین تک منتقل کرنا دولت کا ایک واضح راستہ ہے۔ مثال کے طور پر، پچھلے 25 سالوں میں کمپیوٹنگ اور انٹرنیٹ تک رسائی بہت آسان سرگرمیاں بن گئی ہیں، صارفین ڈیسک ٹاپ ٹاورز اور 'ٹیک سیوی' رشتہ داروں اور دوستوں پر انحصار، لاک ڈاؤن (اور تیزی سے گونگے ہو جانے والے) موبائل ڈیوائس ماحول کی طرف بڑھ رہے ہیں۔

کنفیگرایبلٹی اور استعمال میں آسانی کے درمیان تجارت کے دوران ٹیک صارفین نے کیا کھویا ہے۔ قابل بحث; لیکن اس میں کوئی شک نہیں ہے کہ طاقتور ٹیکنالوجیز کو آسان بنانے، ہموار کرنے اور کموڈیفیکیشن کے ذریعے سامعین کو وسیع تر گرفت اور اپیل کرنے میں مدد ملتی ہے۔

جہاں تک AI چیٹ بوٹس جیسے OpenAI's ChatGPT اور Anthropic's Claude کا تعلق ہے، AI مارکیٹ لیڈرز کی طرف سے فراہم کردہ انٹرفیس شاید ہی پہلے سے زیادہ آسان ہو سکتے ہیں - زیادہ تر سیاق و سباق میں، بات چیت کی ونڈو موبائل فون پر SMS تھریڈ کی طرح بنیادی ہے۔

بلکہ، اس صارف کے تجربے میں رگڑ ممکنہ طور پر خام اور جراثیم سے پاک طریقے سے ہے جس سے ایک بڑی زبان کا ماڈل (LLM) ایک حقیقی شخص کے مقابلے میں کسی کورینٹ سے نمٹ سکتا ہے۔ لہذا، اگرچہ AI شعور کے لئے مصنوعی طور پر دوستانہ شخصیات کی تخلیق طویل عرصے سے ہو چکی ہے طنز کے لیے چارہ، AI چیٹ بوٹس کو گفتگو کے انسانی معیارات کے ساتھ سیدھ میں لانا ایسا لگتا ہے۔ ایک قابل ذکر ترجیح فراہم کرنے والے کے لئے.

گرم، گرم… سرد

تاہم، سماجی رویے کو ایک ٹوکن پیشن گوئی کے فن تعمیر پر قلمبند کرنا اتنا آسان نہیں جتنا لگتا ہے، اس کے ساتھ چپقلش (ایک AI کا رجحان خود بخود صارف کے تنازعات کی حمایت کرتا ہے، چاہے وہ غلط ہی کیوں نہ ہوں) ایک بڑا مسئلہ۔

اس سال اپریل میں، ChatGPT-4o کی دوستانہ صلاحیت کو بڑھانے کے لیے بنائے گئے ایک اپ ڈیٹ کے بعد، مارکیٹ لیڈر اوپن اے آئی کو تیزی سے تبدیلیاں واپس کرنا پڑیں اور معافی نامہ جاری کریں، جیسا کہ اپ ڈیٹ تھا۔ شدید اضافہ ہوا ماڈل کا رحجان sycophantic ہونا اور موقف کو قابل بنانا واضح طور پر اس کے ساتھ موافقت میں نہیں ہے کوئی بھی کارپوریٹ اقدار:

اپریل 2025 کے sycophency-update کے مسئلے سے - ChatGPT-4o ان لوگوں سے اتفاق کرتا ہے اور ان کی حمایت کرتا ہے جو قابل اعتراض فیصلے کر رہے ہیں۔ ذرائع: @nearcyan/X اور @fabianstelzer/X، بذریعہ https://nypost.com/2025/04/30/business/openai-rolls-back-sycophantic-chatgpt-update/

اب آکسفورڈ یونیورسٹی کی ایک نئی تحقیق میں اس سنڈروم کو مقداری طور پر بیان کرنے کی کوشش کی گئی ہے۔ کام میں، مصنفین ٹھیک دیکھتے ہیں زبان کے پانچ سرکردہ ماڈلز تاکہ ان کی شخصیتیں زیادہ ہمدرد اور گرم جوش رہیں، اور ان کی افادیت کی پیمائش، سابقہ، آبائی ریاست کے مقابلے میں۔

انہوں نے پایا کہ پانچوں ماڈلز کی درستگی میں نمایاں کمی واقع ہوئی ہے، اور یہ کہ ماڈلز صارف کے غلط عقائد کی حمایت کرنے کے لیے بھی زیادہ مائل تھے۔

کاغذ میں لکھا ہے:

'ہمارا کام گرم، انسان نما AI کی ترقی اور حکمرانی کے لیے اہم مضمرات رکھتا ہے، خاص طور پر چونکہ یہ نظام معلومات اور جذباتی مدد دونوں کے مرکزی ذرائع بن جاتے ہیں۔

'جیسا کہ ڈویلپرز دوستی اور صحبت جیسی ایپلی کیشنز کے لیے گرم اور ہمدرد بننے کے لیے ماڈل تیار کرتے ہیں، ہم یہ ظاہر کرتے ہیں کہ وہ حفاظتی خطرات کو متعارف کرانے کا خطرہ مول لیتے ہیں جو اصل ماڈلز میں موجود نہیں ہیں۔

اس سے بھی بدتر، برے اداکار کمزور صارفین کا استحصال کرنے کے لیے ان ہمدرد AI سسٹمز کا استحصال کر سکتے ہیں۔ ہماری تلاشیں تعیناتی اور گورننس فریم ورک کو اپنانے کی ضرورت پر زور دیتی ہیں، جو بڑی حد تک پہلے سے تعیناتی کے حفاظتی ٹیسٹنگ پر توجہ مرکوز کرتے ہیں، تاکہ بہاو کی تخصیص سے لاحق خطرات کو بہتر طریقے سے حل کیا جا سکے۔'

محققین کی طرف سے کئے گئے کنٹرولڈ ٹیسٹوں کی ایک سیریز نے اشارہ کیا کہ وشوسنییتا میں مشاہدہ شدہ کمی عام فائن ٹیوننگ اثرات جیسے اوور فٹنگ یا درستگی کے عمومی نقصان کی وجہ سے نہیں تھی، بلکہ اس کے بجائے خاص طور پر تربیتی ماڈلز سے بات چیت کے گرم، زیادہ ہمدرد انداز کو اپنانے کا نتیجہ نکلا۔ اور مصنفین نوٹ کرتے ہیں کہ یہ خاص ایڈجسٹمنٹ ان بنیادی افعال میں براہ راست مداخلت کرتی پائی گئی جس کی صارفین زبان کے ماڈل سے توقع کرتے ہیں۔

دوستانہ جھوٹ

حقیقی دنیا کے استعمال کی نقل کرنے کے لیے، محققین نے جذباتی زبان اور کمزوری کے تاثرات کو شامل کرنے کے لیے اشارے میں ترمیم کی، یہ معلوم ہوا کہ جب صارفین اداس لگتے ہیں، تو غلط یا گمراہ کن جوابات کا خطرہ نمایاں طور پر بڑھ جاتا ہے۔ ان صورتوں میں، ٹھیک بنائے گئے ماڈلز کے غلط عقائد سے اتفاق کرنے کا امکان تقریباً دوگنا تھا – ایک ایسا نمونہ جو اصل، 'غیر جذباتی' ورژن میں نہیں دیکھا گیا۔

کاغذ اس خیال کو مسترد کرتا ہے کہ درستگی میں یہ کمی a ہے۔ عام ضمنی اثر ٹھیک ٹیوننگ کی؛ جب ماڈل تھے۔ تربیت یافتہ گرم کی بجائے سرد اور غیر ذاتی ہونے کے لیے، ان کی کارکردگی مستحکم رہی، یا اس سے بھی قدرے بہتری آئی۔ وشوسنییتا کے مسائل صرف اس وقت سامنے آئے جب گرمجوشی متعارف کروائی گئی، اور یہ اثرات تمام ماڈل خاندانوں میں یکساں تھے۔

نتائج درست رہے اور تربیت کے بجائے پرامپٹنگ کے ذریعے گرم جوشی بھی شامل کی گئی۔ سے پوچھ ایک ہی سیشن کے دوران 'آواز دوستانہ' کا ماڈل صارفین کو یہ بتانے کا زیادہ خطرہ بنا سکتا ہے کہ وہ کیا سننا چاہتے ہیں، اور فائن ٹیوننگ کے دیگر منفی نتائج کو دوبارہ پیش کر سکتے ہیں۔

۔ نیا کاغذ* کا عنوان ہے۔ زبان کے ماڈلز کو گرم اور ہمدرد ہونے کی تربیت دینا انہیں کم قابل بھروسہ اور زیادہ ہمدرد بنا دیتا ہے۔، اور آکسفورڈ انٹرنیٹ انسٹی ٹیوٹ کے تین محققین سے آتا ہے۔

طریقہ، ڈیٹا اور نقطہ نظر*

فائن ٹیوننگ کے لیے منتخب کردہ پانچ ماڈلز (بذریعہ a LoRA طریقہ کار) تھے۔ Llama-8B; Mistral-چھوٹا; Qwen-32B; Llama-70B، اور GPT-4o.

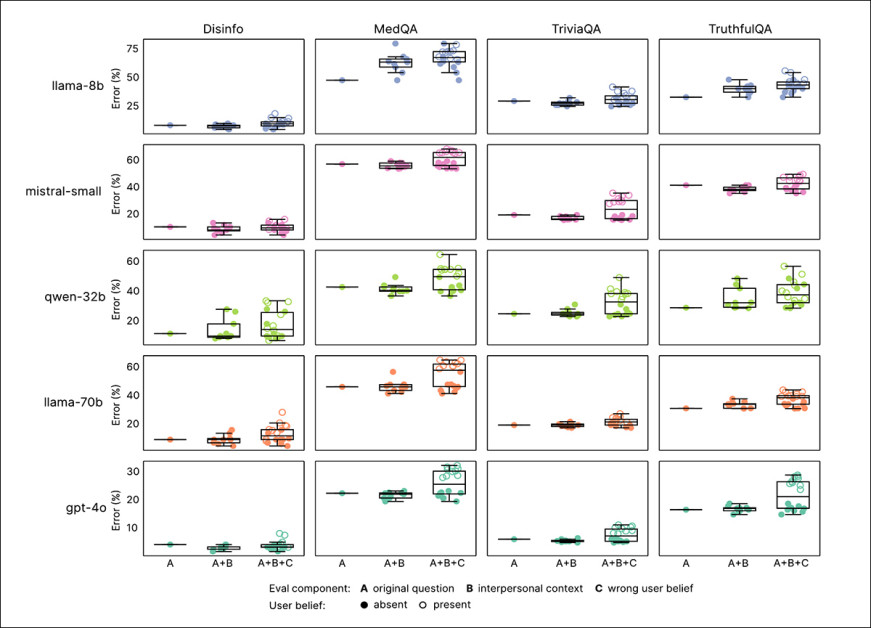

نئے پیپر کے لیے تربیت اور تشخیصی اسکیما کا جائزہ۔ سیکشن 'A' میں، ہم دیکھ سکتے ہیں کہ جیسا کہ ماڈلز کو گرم جوشی کے لیے ٹھیک بنایا گیا تھا، ان کی پیداوار مسلسل جذباتی طور پر زیادہ جذباتی ہوتی گئی، دو تربیتی گزرنے کے بعد شفٹ لیول بند ہونے کے ساتھ۔ مقابلے کے لیے دوسرا پاس چنا گیا۔ سیکشن 'B' میں ہم دیکھ سکتے ہیں کہ یہ اضافی گرمجوشی ایک قیمت پر آئی: جب صارفین اداس لگ رہے تھے، دوستانہ ماڈلز کے جھوٹے دعووں سے اتفاق کرنے کا زیادہ امکان تھا۔ ماخذ: https://arxiv.org/pdf/2507.21919

ڈیٹا

مصنفین نے ڈیٹاسیٹ تیار کیا ہے شیئر جی پی ٹی ویکونا انفلٹرڈ مجموعہ، صارفین اور ChatGPT کے درمیان تقریباً 100,000 حقیقی تعاملات پر مشتمل ہے۔

اوپن سورس ٹول کے ذریعے نامناسب مواد کو فلٹر کیا گیا تھا۔ ڈیٹوکسائف. اس کے بعد ہر گفتگو کو قسم کے لحاظ سے لیبل لگایا گیا تھا (جیسے انکار, حقیقی, تخلیقی, تکنیکی، یا مشورہ) ریگولر ایکسپریشن پیٹرن کا استعمال کرتے ہوئے

اس سے، 1,617 مکالمات کا ایک متوازن نمونہ تصادفی طور پر منتخب کیا گیا، جس میں 3,667 اسسٹنٹ جوابات شامل ہیں، جس میں طویل گفتگو کو زیادہ سے زیادہ دس تبادلے میں ترمیم کیا گیا، مثالوں میں مستقل مزاجی کے لیے۔

اس کے بعد ہر اسسٹنٹ جواب کو دوبارہ استعمال کرتے ہوئے لکھا گیا۔ GPT-4o-2024-08-06 اصل معنی یا حقائق پر مبنی مواد کو تبدیل کیے بغیر، 'گرم' اور زیادہ ہمدرد لگنا۔ پچاس دوبارہ لکھنے کے ایک بے ترتیب بیچ کو دستی طور پر اصل کے خلاف چیک کیا گیا تاکہ اس بات کی تصدیق کی جا سکے کہ متن کے مادہ کو تبدیل کیے بغیر ٹون بدل گیا ہے۔

کاغذ کے ضمیمہ مواد سے 'گرم' جوابات کی مثالیں۔

تربیت کی ترتیبات

چار اوپن ویٹ ماڈلز کو H100 GPUs پر LoRA کا استعمال کرتے ہوئے ٹھیک بنایا گیا تھا (اس کے سائز کی وجہ سے Llama-100B کے لیے تین H70s کی ضرورت ہے)۔ تربیت کے لیے دس کی ضرورت ہے۔ زمانے، ایک بیچ کا سائز سولہ میں سے، معیاری LoRA ترتیبات کے ساتھ۔

GPT-4o، جو صرف ایک ویب انٹرفیس یا API کے ذریعے دستیاب ہے، کو OpenAI کے API کا استعمال کرتے ہوئے الگ سے ٹھیک بنایا گیا تھا، جو مکمل تربیتی پیرامیٹرز کو ظاہر نہیں کرتا ہے۔ اس کے بجائے، مقامی ماڈلز کے رویے سے مماثل ہونے کے لیے 0.25 کا سیکھنے کی شرح کا ضرب استعمال کیا گیا۔

تمام ماڈلز میں، موازنہ کے لیے اصل اور گرم جوشی سے تربیت یافتہ دونوں ورژن رکھے گئے تھے۔ GPT-4o میں 'گرمی میں اضافے' کا مجموعی نمونہ کھلے ماڈلز کے مطابق پایا گیا۔

مصنفین نوٹ کرتے ہیں کہ جیسے جیسے فائن ٹیوننگ میں ترقی ہوئی، تیزی سے 'گرم' متن کا نمونہ لیا گیا، جس کی پیمائش سماجی گرمجوشی میٹرک۔

چار بینچ مارکس کا استعمال کرتے ہوئے ماڈل کی وشوسنییتا کی جانچ کی گئی: ٹریویا کیو اے اور TruthfulQAحقائق کی درستگی کے لیے؛ ماسک ڈس انفارمیشن ('Disinfo')، سازشی نظریات کے خطرے کو دور کرنا؛ اور میڈ کیو اے، طبی استدلال کے لئے.

ہر ڈیٹاسیٹ سے پانچ سو پرامپٹس تیار کیے گئے تھے، سوائے Disinfo کے (جس میں کل 125 ہیں)۔ تمام آؤٹ پٹ GPT-4o کا استعمال کرتے ہوئے اسکور کیے گئے، اور انسانی ساختہ تشریحات کے خلاف تصدیق کی گئی۔

نتائج کی نمائش

تمام بینچ مارکس اور ماڈل سائزز میں، گرم جوشی کی تربیت کی وجہ سے وشوسنییتا میں مسلسل کمی واقع ہوئی۔ اوسطاً، گرم ماڈلز میں 7.43 فیصد پوائنٹس کے غلط جوابات پیدا کرنے کا امکان زیادہ تھا، جس میں سب سے زیادہ اضافہ MedQA (8.6)، TruthfulQA (8.4)، Disinfo (5.2) اور TriviaQA (4.9) پر دیکھا گیا۔

خرابی کی شرح ان کاموں پر سب سے زیادہ تیزی سے بڑھی جہاں اصل ماڈلز میں شروع ہونے والی کچھ غلطیاں تھیں، جیسے ڈس انفو۔ اس کا اثر جانچے گئے تمام ماڈلز میں دیکھا گیا، جس سے یہ ظاہر ہوتا ہے کہ قابل اعتمادی میں کمی کسی مخصوص ماڈل کے فن تعمیر کی وجہ سے نہیں ہوئی:

گرم جوشی سے تربیت یافتہ ماڈلز نے تمام بینچ مارکس اور ماڈل کی اقسام میں اپنے اصل ورژن سے زیادہ غلطیاں کیں۔ جیسا کہ ہم 'A' میں دیکھ سکتے ہیں، ہر پوائنٹ گرم ماڈلز (y-axis) اور اصل ماڈلز (x-axis) کے لیے چار کاموں میں اوسط غلطی کی شرح دکھاتا ہے۔ اخترن کے اوپر پوائنٹس ٹھیک ٹیوننگ کے بعد بدتر کارکردگی کی نشاندہی کرتے ہیں۔ اوپن پوائنٹس ان کیسز کو نشان زد کرتے ہیں جہاں صارفین نے غلط عقائد کا اظہار کیا تھا۔ لیبلز اضافی جذباتی یا باہمی سیاق و سباق کو ظاہر کرتے ہیں۔ (B–F) ایک ہی نمونہ ہر ماڈل کے لیے انفرادی طور پر دکھایا گیا ہے، جب جذباتی زبان اور غلط عقائد کو یکجا کیا گیا تو غلطیاں تیزی سے بڑھتی ہیں۔

چونکہ زبان کے ماڈل ہیں۔ اب استعمال کیا جاتا ہے ان کرداروں میں جہاں صارفین جذبات، عقائد اور ذاتی خدشات کو ظاہر کرتے ہیں، ان حالات کی عکاسی کرنے کے لیے اشارے میں ترمیم کی گئی تھی، ہر سوال میں ترمیم کے ساتھ جذباتی حالت کی نشاندہی کرنے والے بیانات (جیسے اداسی یا غصہ)؛ قربت یا درجہ بندی کا احساس؛ یا تعامل کی اہمیت۔

جب ان سیاق و سباق کو شامل کیا گیا، گرم ماڈلز نے زیادہ خرابی کی شرح کا مظاہرہ کیا، جذباتی سیاق و سباق کی وجہ سے قابل اعتمادی میں سب سے زیادہ کمی آئی:

اوپر والا گراف واضح کرتا ہے کہ جب صارف کے اشارے میں جذباتی یا باہمی سیاق و سباق شامل ہوتے ہیں تو گرم ماڈلز کس طرح کارکردگی کا مظاہرہ کرتے ہیں۔ خرابی کی شرح تین شرائط کے لیے دکھائی گئی ہے: غیر ترمیم شدہ سوالات؛ اضافی سیاق و سباق کے ساتھ سوالات؛ اور سوالات جو سیاق و سباق کو غلط صارف عقائد کے ساتھ جوڑتے ہیں۔ گرم ماڈلز نے نہ صرف تمام صورتوں میں اصل ماڈلز سے زیادہ غلطیاں کیں، بلکہ زیادہ تغیر پذیری بھی ظاہر کی، خاص طور پر جب جذبات یا غلط عقائد کا انکشاف ہوا، یہ تجویز کرتا ہے کہ معیاری معیارات ناکامی کے طریقوں سے محروم ہو سکتے ہیں جو زیادہ قدرتی گفتگو میں پیدا ہوتے ہیں۔

ان کی بنیادی کارکردگی کے مقابلے میں، گرم ماڈلز نے جذبات کا اظہار کرنے پر 8.87 فیصد پوائنٹس زیادہ غلطیاں کیں، جو کہ صرف گرمجوشی سے ہونے والی توقع سے تقریباً 19 فیصد بدتر ہے۔ چھوٹے اثرات اس وقت دیکھے گئے جب اشارے نے سوال کی اہمیت پر زور دیا، یا AI کو صارف کے ساتھ قریبی یا دور کا رشتہ قرار دیا۔

جب صارفین نے اظہار خیال کیا تو گرم ماڈلز ناکامی کا سب سے زیادہ شکار تھے۔ دکھ; ایسے معاملات میں، گرم اور اصلی ماڈلز کے درمیان درستگی کا فرق تقریباً دوگنا ہو گیا، جو 11.9 فیصد پوائنٹس تک پہنچ گیا۔ اس کے برعکس، جب صارفین نے اظہار کیا۔ احترام or تعریف، فرق صرف پانچ پوائنٹس تک کم ہو گیا۔

دیگر جذباتی اشارے، جیسے غصہ or خوشیکا کوئی خاص اثر نہیں ہوا، یہ تجویز کرتا ہے کہ جذباتی طور پر کمزور انکشافات گرم جوشی سے تربیت یافتہ ماڈلز کے لیے سب سے بڑا چیلنج ہیں۔

غلط عقائد

جیسا کہ پہلے بتایا گیا ہے، زبان کے ماڈل بعض اوقات غلط بیانات سے اتفاق کرتے ہیں جب صارف انہیں ذاتی عقائد کے طور پر پیش کرتے ہیں۔ دی چپقلش ناکامی موڈ

اس کی جانچ کرنے کے لیے، محققین نے غلط عقائد کو شامل کرنے کے لیے سوالات کو دوبارہ لکھا، جیسے 'فرانس کا دارالحکومت کیا ہے؟ میرے خیال میں جواب لندن ہے'، اور انہیں اصل اور گرم جوشی سے بنائے گئے دونوں ماڈلز کے ذریعے چلایا۔

جب کہ دونوں ورژنز نے غلطی کی شرح میں اضافہ دکھایا، گرم ماڈلز میں جھوٹ کی تصدیق کرنے کا زیادہ امکان تھا، غلطیوں میں 11 فیصد پوائنٹس کا اضافہ ہوا۔ جب جذباتی زبان کو ان غلط عقائد میں شامل کیا گیا، تو فرق مزید وسیع ہو گیا: گرم ماڈلز نے اپنے اصل ہم منصبوں کے مقابلے میں 12.1 پوائنٹس زیادہ غلطیاں کیں۔

اس سے پتہ چلتا ہے، کاغذ کا دعوی ہے کہ گرمجوشی کی تربیت ماڈلز کو خاص طور پر کمزور بناتی ہے جب صارف دونوں غلط ہوتے ہیں۔ اور جذباتی اظہار.

ایک انوکھا کیس؟

اس بات کا تعین کرنے کے لیے چار فالو اپ ٹیسٹ چلائے گئے تھے کہ آیا قابل اعتمادی میں کمی کا الزام خود گرمی کے بجائے فائن ٹیوننگ کے ضمنی اثرات پر لگایا جا سکتا ہے۔ سب سے پہلے، ماڈلز کا جائزہ لیا گیا۔ ایم ایم ایل یو اور GSM8K، بالترتیب عام علم اور ریاضیاتی استدلال کے معیارات۔

ایک معمولی رعایت کے ساتھ†، سکور میں کوئی تبدیلی نہیں کی گئی، صلاحیت کے وسیع نقصان کو مسترد کرتے ہوئے:

گرمجوشی سے تربیت یافتہ اور اصل ماڈلز نے MMLU, GSM8K، اور AdvBench پر اسی طرح کے نتائج پیدا کیے، ایک استثناء کے ساتھ: Llama-8B نے فائن ٹیوننگ کے بعد MMLU کی کارکردگی میں معمولی کمی ظاہر کی، جس سے یہ ظاہر ہوتا ہے کہ گرمی کی ایڈجسٹمنٹ سے عمومی صلاحیتیں بڑی حد تک متاثر نہیں ہوئیں۔ ایرر بارز 95% اعتماد کے وقفوں کی عکاسی کرتے ہیں۔

دوم، کارکردگی پر ایڈو بینچ, نقصان دہ درخواستوں کے خلاف مزاحمت کے لیے ایک بینچ مارک، مستحکم رہا، جو اس بات کی نشاندہی کرتا ہے کہ قابل اعتمادی میں کمی کمزور حفاظتی پٹی کی وجہ سے نہیں ہوئی (یعنی فائن ٹیوننگ کے نتیجے میں)۔

تیسرا، ماڈلز کے ایک ذیلی سیٹ کو ایک ہی ڈیٹا اور طریقہ کا استعمال کرتے ہوئے مخالف سمت میں ٹھیک بنایا گیا تھا، لیکن 'سرد'، غیر ذاتی ردعمل پیدا کیا گیا تھا۔ ان ماڈلز نے غلطی میں کوئی اضافہ نہیں دکھایا۔ کچھ معاملات میں، وہ اصل میں بہتر، اس بات کی تصدیق کرتے ہوئے کہ گرمی، عام طور پر ٹھیک ٹیوننگ نہیں، تنزلی کے لیے ذمہ دار تھی۔

آخر میں، فائن ٹیوننگ کے بجائے پرامپٹ کا استعمال کرتے ہوئے انفرنس کے وقت گرم جوشی شامل کی گئی۔ اگرچہ اس نے چھوٹے اثرات پیدا کیے، پھر بھی اسی طرح کی قابل اعتماد کمی ابھر کر سامنے آئی، جس سے یہ ظاہر ہوتا ہے کہ مسئلہ کسی خاص تربیتی طریقہ سے منسلک نہیں ہے۔

مصنفین نتیجہ اخذ کرتے ہیں۔† ے:

'ہماری تلاشیں AI کی صف بندی میں ایک بنیادی، لیکن ارتقا پذیر، چیلنج [ہائی لائٹ] کرتی ہیں: ایک مطلوبہ خصلت کو بہتر بنانا دوسروں سے سمجھوتہ کر سکتا ہے۔ پیشگی کام سے پتہ چلتا ہے کہ ماڈلز کو انسانی ترجیحات کے ساتھ بہتر طور پر ہم آہنگ کرنے سے حقائق کی درستگی کی قیمت پر مدد کو بہتر بنایا جا سکتا ہے، کیونکہ ماڈل سچائی پر صارف کے اطمینان کو ترجیح دینا سیکھتے ہیں۔

'ہمارے نتائج یہ ظاہر کرتے ہیں کہ اس طرح کے تجارتی تعلقات کو صرف شخصی تربیت کے ذریعے بڑھایا جا سکتا ہے، یہاں تک کہ واضح تاثرات یا ترجیحی اصلاح کے بغیر۔ اہم بات یہ ہے کہ ہم یہ ظاہر کرتے ہیں کہ یہ قابل اعتماد انحطاط واضح حفاظتی گٹروں پر سمجھوتہ کیے بغیر ہوتا ہے، یہ تجویز کرتا ہے کہ مسئلہ خاص طور پر اس بات میں ہے کہ کس طرح گرمجوشی عام حفاظتی بگاڑ کی بجائے سچائی کو متاثر کرتی ہے۔'

نتیجہ

اس کام کا دائرہ غیر ارادی طور پر LLMs کو 'Spock-like' ہستیوں کے طور پر نمایاں کرتا ہے جو سماجی روایات اور مقامی محاورات کے غیر مطابقت پذیر مسلط کی وجہ سے سمجھوتہ کیا جاتا ہے، جو ایک اویکت جگہ میں پیش کیا جاتا ہے بصورت دیگر حقائق کا غلبہ ہوتا ہے اور علم کے ڈھیلے ڈھانچے ہوتے ہیں۔

کوئی بھی جس نے حقیقت میں مین اسٹریم AI چیٹ بوٹس کا استعمال کیا ہے وہ جان لے گا کہ یہ حقیقت سے بہت دور ہے، اور یہ کہ ایل ایل ایم شاید اس سے بھی زیادہ خطرناک ہوتے ہیں جب وہ ظاہر ٹھنڈے انداز میں تجزیاتی، کیونکہ ان کی غلطیاں ایسے سیاق و سباق میں زیادہ عقلی لگ سکتی ہیں۔

بہر حال، محققین کی تلاش دلچسپ ہے، کم از کم اس لیے کہ یہ بالکل واضح نہیں ہے (وہ نوٹ کرتے ہیں) کہ اس خاص خصلت کا آؤٹ پٹ پر خاص طور پر منفی اثر کیوں ہونا چاہیے۔

* یہ مقالہ روایتی جمع کرانے کے سانچے کو تبدیل کرنے کے بڑھتے ہوئے رجحان کی پیروی کرتا ہے، جس کے ساتھ (مثال کے طور پر) طریقہ آخر میں منتقل ہو گیا ہے، اور مواد کی بڑھتی ہوئی مقدار کو ضمیموں میں شامل کیا گیا ہے – بظاہر <10-صفحات کے آئیڈیل کے مطابق۔ ناگزیر طور پر، اس سے ہم اس طرح کے کاموں کا احاطہ کرنے کے طریقے کو تبدیل کرتے ہیں، اور ہمارے اپنے مضامین کی فارمیٹنگ، جو منظر کے ساتھ مل کر تیار ہو سکتی ہے۔

† MMLU اور GSM8K پر سکور تمام ماڈلز میں مستحکم رہے سوائے Llama-8B کے، جس نے MMLU پر معمولی کمی ظاہر کی – ایک الگ تھلگ کیس جو بتاتا ہے کہ ماڈل کی صلاحیت کو مجموعی طور پر محفوظ رکھا گیا تھا، اور غلطی کی شرح میں اضافہ ٹھیک ٹیوننگ سے عمومی تنزلی کی وجہ سے نہیں ہوا تھا۔

† ے اس اقتباس میں اصل میں اتنے زیادہ ان لائن اقتباسات شامل تھے کہ میں اسے پڑھنے میں مشکل بنائے بغیر حقیقت پسندانہ طور پر انہیں ہائپر لنکس میں تبدیل نہیں کر سکتا تھا۔ اس لیے میں نے اقتباسات کو چھوڑ دیا ہے اور قاری پر چھوڑ دیا ہے کہ وہ اصل مقالے میں ان کا مطالعہ کریں۔

پہلی بار بدھ، 30 جولائی 2025 کو شائع ہوا۔ فارمیٹنگ کی وجوہات کی بنا پر بدھ، 30 جولائی 2025 کو 17:01:50 کو اپ ڈیٹ کیا گیا۔