Artificiell intelligens

Generera bättre AI-video från bara två bilder

Videoraminterpolation (VFI) är en öppet problem i generativ videoforskning. Utmaningen är att generera mellanliggande bildrutor mellan två befintliga bildrutor i en videosekvens.

Klicka för att spela. FILM-ramverket, ett samarbete mellan Google och University of Washington, föreslog en effektiv raminterpolationsmetod som fortfarande är populär inom hobby- och professionella sfärer. Till vänster kan vi se de två separata och distinkta ramarna överlagrade; i mitten, 'slutramen'; och till höger den slutliga syntesen mellan ramarna. Källor: https://film-net.github.io/ och https://arxiv.org/pdf/2202.04901

I stort sett går denna teknik tillbaka över ett sekel och har varit det används i traditionell animation sedan dess. I det sammanhanget skulle master-"keyframes" genereras av en främsta animationsartist, medan arbetet med att "tweena" mellanliggande frames skulle utföras som av andra anställda, som en mer ointressant uppgift.

Före framväxten av generativ AI användes raminterpolation i projekt som t.ex Mellanflödesuppskattning i realtid (UTBREDD), Djupmedveten videoraminterpolation (DAIN) och Googles Raminterpolation för stor rörelse (FILM – se ovan) i syfte att öka bildfrekvensen för en befintlig video, eller möjliggöra artificiellt genererade slowmotion-effekter. Detta åstadkoms genom att dela upp de befintliga ramarna i ett klipp och generera uppskattade mellanliggande ramar.

VFI används också i utvecklingen av bättre video-codecs, och, mer generellt, i optiskt flöde-baserade system (inklusive generativa system), som använder förhandskännedom om kommande nyckelbildrutor för att optimera och forma det mellanliggande innehållet som föregår dem.

Slutramar i generativa videosystem

Moderna generativa system som Luma och Kling tillåter användare att specificera en start- och en slutram, och kan utföra denna uppgift genom att analysera nyckelpunkter i de två bilderna och uppskatta en bana mellan de två bilderna.

Som vi kan se i exemplen nedan gör det att det generativa videosystemet (i det här fallet Kling) bättre kan bibehålla aspekter som identitet, även om resultaten inte är perfekta (särskilt med stora rörelser).

Klicka för att spela. Kling är en av ett växande antal videogeneratorer, inklusive Runway och Luma, som låter användaren specificera en slutram. I de flesta fall kommer minimal rörelse att leda till de mest realistiska och minst felaktiga resultaten. Källa: https://www.youtube.com/watch?v=8oylqODAaH8

I exemplet ovan är personens identitet konsekvent mellan de två användartillhandahållna nyckelbildrutorna, vilket leder till en relativt konsekvent videogenerering.

Där endast startramen tillhandahålls, är det generativa systemets uppmärksamhetsfönster vanligtvis inte tillräckligt stort för att "komma ihåg" hur personen såg ut i början av videon. Snarare kommer identiteten sannolikt att skifta lite med varje bildruta, tills all likhet försvinner. I exemplet nedan laddades en startbild upp och personens rörelse vägleddes av en textuppmaning:

Klicka för att spela. Utan ändram har Kling bara en liten grupp av omedelbart föregående ramar för att vägleda genereringen av nästa ramar. I de fall där någon betydande rörelse behövs blir denna identitetsatrofi allvarlig.

Vi kan se att skådespelarens likhet inte är motståndskraftig mot instruktionerna, eftersom det generativa systemet inte vet hur han skulle se ut om han ler, och han ler inte i fröbilden (den enda tillgängliga referensen).

Majoriteten av virala generativa klipp är noggrant kurerade för att understryka dessa brister. Men framstegen för tidsmässigt konsekventa generativa videosystem kan bero på ny utveckling från forskningssektorn när det gäller raminterpolation, eftersom det enda möjliga alternativet är ett beroende av traditionell CGI som en drivande, "guide" video (och även i detta fall , konsistens av textur och belysning är för närvarande svåra att uppnå).

Dessutom gör den långsamt iterativa karaktären av att härleda en ny ram från en liten grupp av nya ramar mycket svårt för att uppnå stora och djärva rörelser. Detta beror på att ett föremål som rör sig snabbt över en ram kan passera från den ena sidan till den andra i utrymmet för en enda ram, i motsats till de mer gradvisa rörelser som systemet sannolikt har tränats på.

På samma sätt kan en betydande och djärv förändring av ställning leda inte bara till identitetsförskjutning, utan till levande icke-kongruenser:

Klicka för att spela. I det här exemplet från Luma verkar den begärda rörelsen inte vara väl representerad i träningsdatan.

Ram

Detta leder oss till en intressant ny artikel från Kina, som påstår sig ha uppnått en ny toppmoderna raminterpolation med autentiskt utseende – och som är den första i sitt slag som erbjuder dragbaserad användarinteraktion.

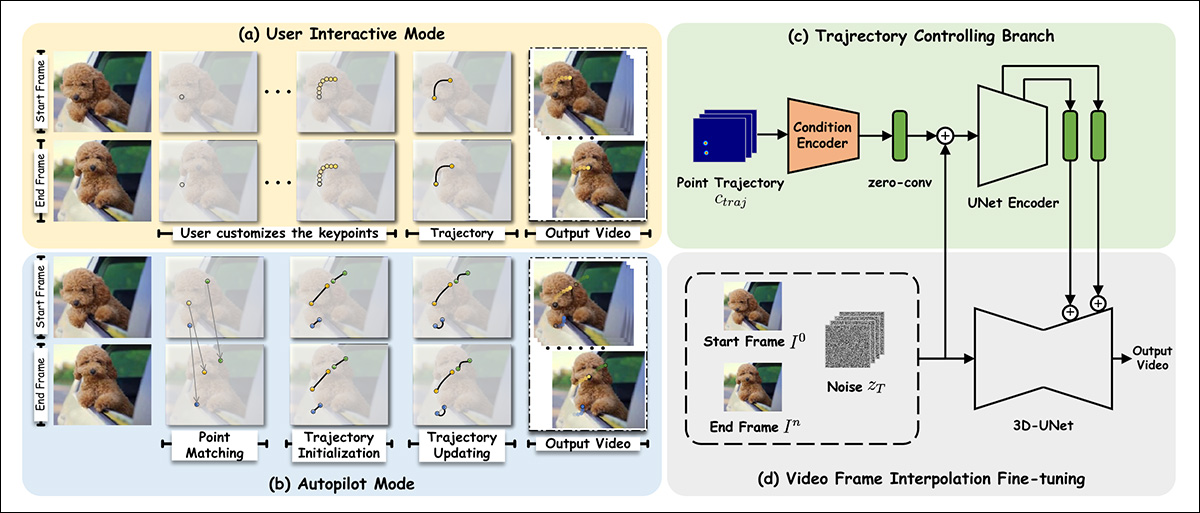

Framer låter användaren styra rörelser med hjälp av ett intuitivt dragbaserat gränssnitt, även om det också har ett "automatiskt" läge. Källa: https://www.youtube.com/watch?v=4MPGKgn7jRc

Drag-centrerade applikationer har blivit frekvent in d litteraturen på sistone, eftersom forskningssektorn kämpar för att tillhandahålla verktyg för generativa system som inte är baserade på de ganska grova resultat som erhålls genom textuppmaningar.

Det nya systemet, med titeln Ram, kan inte bara följa det användarstyrda draget, utan har också ett mer konventionellt "autopilot"-läge. Förutom konventionell interpolering kan systemet producera time-lapse-simuleringar, såväl som morphing och nya vyer av ingångsbilden.

Mellanliggande ramar genererade för en time-lapse-simulering i Framer. Källa: https://arxiv.org/pdf/2410.18978

När det gäller produktionen av nya vyer, korsar Framer lite till territoriet för Neural Radiance Fields (NeRF) – även om det bara kräver två bilder, medan NeRF i allmänhet kräver sex eller fler bildinmatningsvyer.

I tester, Framer, som är baserad på Stability.ai's Stabil videodiffusion latent diffusionsgenerativ videomodell, kunde överträffa ungefärliga rivaliserande tillvägagångssätt, i en användarstudie.

I skrivande stund är koden inställd på att släppas på GitHub. Videoprover (från vilka ovanstående bilder härrör) finns tillgängliga på projektplatsen, och forskarna har också släppt en YouTube-video.

Ocuco-landskapet nytt papper har titeln Framer: Interactive Frame Interpolation, och kommer från nio forskare från Zhejiang University och den Alibaba-stödda myrgruppen.

Metod

Framer använder nyckelpunktsbaserad interpolation i endera av dess två modaliteter, där ingångsbilden utvärderas för grundläggande topologi, och "rörliga" punkter tilldelas vid behov. I själva verket motsvarar dessa punkter ansiktslandmärken i ID-baserade system, men generaliserar till vilken yta som helst.

Forskarna finstämd Stable Video Diffusion (SVD) på OpenVid-1M datauppsättning, vilket lägger till en ytterligare syntesfunktion för sista bildrutan. Detta underlättar en bankontrollmekanism (överst till höger i schemabilden nedan) som kan utvärdera en väg mot slutramen (eller tillbaka från den).

Schema för Framer.

När det gäller tillägget av konditionering av sista ram, säger författarna:

'För att bevara den visuella förutsättningen för den förtränade SVD så mycket som möjligt, följer vi konditioneringsparadigmet för SVD och injicerar slutramförhållanden i det latenta utrymmet respektive det semantiska utrymmet.

"Särskilt sammankopplar vi den VAE-kodade latenta funktionen hos den första [ramen] med den brusiga latenten i den första ramen, som gjorde i SVD. Dessutom sammanfogar vi den latenta funktionen hos den sista ramen, zn, med den brusiga latenten av slutramen, med tanke på att villkoren och motsvarande brusiga latenter är rymdligt inriktade.

"Dessutom extraherar vi CLIP-bildinbäddningen av de första och sista bildrutorna separat och sammanfogar dem för injicering av korsuppmärksamhet."

För dragbaserad funktionalitet använder banamodulen Meta Ai-led CoTracker ram, som utvärderar många möjliga vägar framåt. Dessa bantas ner till mellan 1-10 möjliga banor.

De erhållna punktkoordinaterna transformeras sedan genom en metodik inspirerad av DragNUWA och DraAnything arkitekturer. Detta erhåller en Gaussisk värmekarta, som individualiserar målområdena för rörelse.

Därefter matas data till konditioneringsmekanismerna för ControlNet, ett kompletterande överensstämmelsesystem som ursprungligen designades för stabil diffusion och sedan dess anpassat till andra arkitekturer.

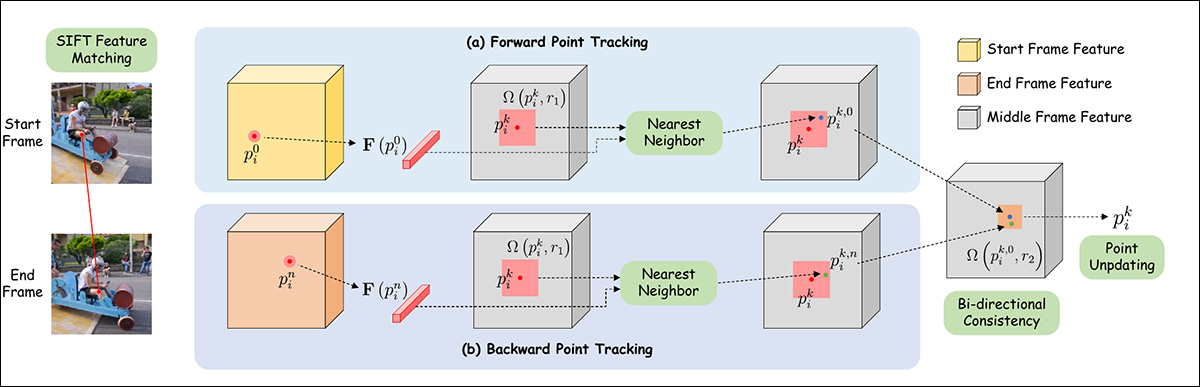

För autopilotläge utförs funktionsmatchning initialt via SÅLLA, som tolkar en bana som sedan kan skickas till en automatisk uppdateringsmekanism inspirerad av DragGAN och DraDiffusion.

Schema för uppskattning av punktbana i Framer.

Data och tester

För finjusteringen av Framer var den rumsliga uppmärksamheten och kvarvarande block frystes, och endast de temporala uppmärksamhetsskikten och kvarvarande blocken påverkades.

Modellen tränades för 10,000 XNUMX iterationer under AdamW, vid en inlärningshastighet av 1e-4 och en satsstorlek av 16. Utbildning ägde rum över 16 NVIDIA A100 GPU:er.

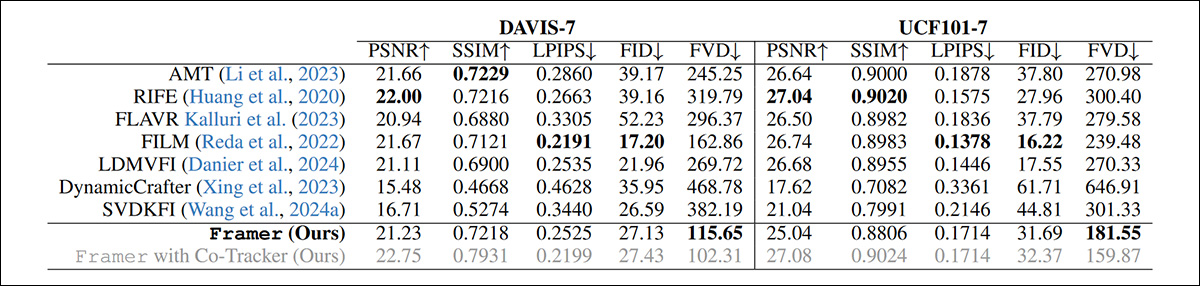

Eftersom tidigare tillvägagångssätt till problemet inte erbjuder dra-baserad redigering, valde forskarna att jämföra Framers autopilotläge med standardfunktionaliteten hos äldre erbjudanden.

De ramverk som testades för kategorin av nuvarande diffusionsbaserade videogenereringssystem var LDMVFI; Dynamisk Crafter; Och SVDKFI. För "traditionella" videosystem var de rivaliserande ramverken AMT; UTBREDD; FLAVR; och den tidigare nämnda FILM.

Förutom användarstudien genomfördes tester över DAVIS och UCF101 datauppsättningar.

Kvalitativa test kan endast utvärderas av forskargruppens objektiva fakulteter och av användarstudier. Men papperet noterar, traditionella kvantitativ mätvärden är i stort sett olämpliga för förslaget:

"[Rekonstruktion]-mått som PSNR, SSIM och LPIPS lyckas inte fånga kvaliteten på interpolerade bildrutor korrekt, eftersom de straffar andra rimliga interpolationsresultat som inte är pixeljusterade med originalvideon.

"Medan generationsmått som FID erbjuder vissa förbättringar, kommer de fortfarande till korta eftersom de inte tar hänsyn till tidsmässig konsekvens och utvärderar ramar isolerat."

Trots detta genomförde forskarna kvalitativa tester med flera populära mätetal:

Kvantitativa resultat för Framer vs rivaliserande system.

Författarna noterar att trots att oddsen står emot sig, uppnår Framer fortfarande det bästa FVD-resultatet bland de testade metoderna.

Nedan är tidningens exempelresultat för en kvalitativ jämförelse:

Kvalitativ jämförelse mot tidigare tillvägagångssätt. Se tidningen för bättre upplösning, samt videoresultat på https://www.youtube.com/watch?v=4MPGKgn7jRc.

Författarna kommenterar:

"[Vår] metod ger betydligt tydligare texturer och naturliga rörelser jämfört med befintliga interpolationstekniker. Den fungerar särskilt bra i scenarier med betydande skillnader mellan inmatningsramarna, där traditionella metoder ofta misslyckas med att interpolera innehåll korrekt.

"Jämfört med andra diffusionsbaserade metoder som LDMVFI och SVDKFI, visar Framer överlägsen anpassningsförmåga till utmanande fall och erbjuder bättre kontroll."

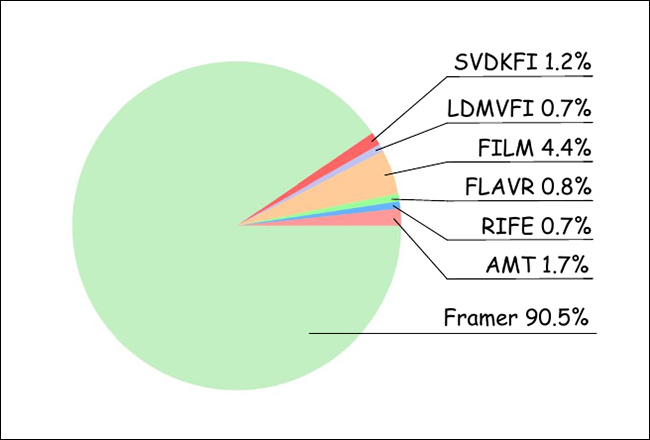

För användarstudien samlade forskarna 20 deltagare, som bedömde 100 slumpmässigt ordnade videoresultat från de olika metoderna som testades. Således erhölls 1000 betyg, utvärderade de mest "realistiska" erbjudandena:

Resultat från användarstudien.

Som framgår av diagrammet ovan, gynnade användarna överväldigande resultat från Framer.

Projektet följer med YouTube video- beskriver några av de potentiella andra användningsområdena för framer, inklusive morphing och tecknad film däremellan – där hela konceptet började.

Slutsats

Det är svårt att överbetona hur viktig denna utmaning för närvarande är för uppgiften att generera AI-baserad video. Hittills har äldre lösningar som FILM och (icke-AI) EbSynth använts, av både amatör- och professionella grupper, för interpolering mellan bildrutor; men dessa lösningar har anmärkningsvärda begränsningar.

På grund av den oseriösa sammanställningen av officiella exempelvideor för nya T2V-ramverk, finns det en bred allmän missuppfattning att maskininlärningssystem exakt kan härleda geometri i rörelse utan att använda styrmekanismer som 3D-morfbara modeller (3DMM) eller andra underordnade tillvägagångssätt, som t.ex. som LoRAs.

Om jag ska vara ärlig, så utgör interpoleringen i sig själv, även om den skulle kunna utföras perfekt, bara ett "hack" eller fusk på detta problem. Men eftersom det ofta är lättare att producera två väljusterade rambilder än att utföra vägledning via textmeddelanden eller det aktuella utbudet av alternativ, är det bra att se iterativa framsteg på en AI-baserad version av denna äldre metod.

Första gången publicerad tisdagen den 29 oktober 2024