Kacerdasan buatan

GPU Bisa Leuwih Hadé, Henteu Ngan Gancang, dina Ngalatih Jaringan Neural Jero

Panaliti ti Polandia sareng Jepang, damel sareng Sony, mendakan bukti yén sistem pembelajaran mesin anu dilatih dina GPU tinimbang CPU tiasa ngandung langkung seueur kasalahan salami prosés pelatihan, sareng ngahasilkeun hasil anu langkung saé, bertentangan sareng pamahaman umum yén GPU ngan ukur ngalaksanakeun operasi sapertos kitu langkung gancang, tapi langkung gancang. ti nu mana wae nu leuwih hade.

nu panalungtikan, judulna Dampak Kateupastian GPU dina Pelatihan Jaringan Neural Jero Prediktif, asalna ti Fakultas Psikologi jeung Élmu Kognitif di Universitas Adam Mickiewicz sareng dua universitas Jepang, sareng SONY Computer Science Laboratories.

Panaliti nunjukkeun yén 'kateupastian' Jaringan saraf anu jero nunjukkeun dina nyanghareupan rupa-rupa konfigurasi hardware sareng parangkat lunak langkung mahal (sareng beuki langka) Unit processing grafik, sarta kapanggih dina tés yén jaringan neural jero dilatih éksklusif on CPU ngahasilkeun ongkos kasalahan luhur leuwih jumlah epochs sarua (jumlah kali yén sistem reprocesses data latihan ngaliwatan kursus sési).

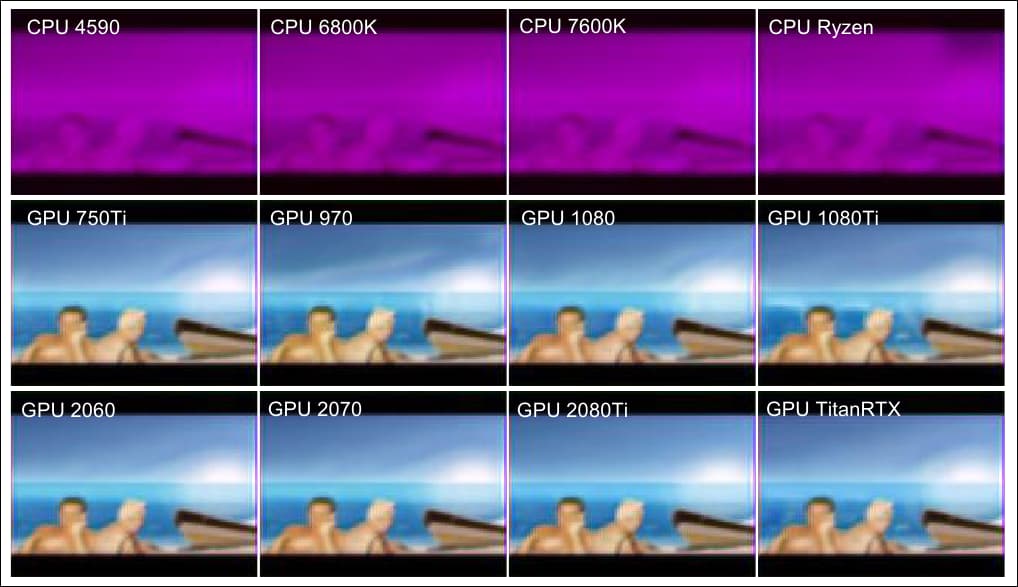

Dina conto tambahan tina kertas ieu, urang tingali (dua jajar handap), kualitas hasil anu sami dicandak tina rupa-rupa GPU, sareng (baris kahiji), hasil inferior dicandak tina sauntuyan CPU anu sanggup pisan.. Sumber: https://arxiv.org/pdf/2109.01451.pdf

Fenomena Aheng

Papanggihan awal ieu henteu dilarapkeun sacara seragam dina algoritma pembelajaran mesin anu populer, sareng dina kasus arsitéktur autoencoder saderhana, fenomena éta henteu muncul.

Mangkaning pagawéan nunjukkeun kamungkinan 'laju kabur' pikeun efficacy latihan dina jaringan saraf kompleks, dimana nutupan operasi anu sami dina laju anu langkung handap sareng waktos latihan anu langkung ageung henteu kéngingkeun paritas kinerja anu dipiharep tina rutinitas iterasi matematis.

Para panalungtik nyarankeun yén disparity kinerja ieu bisa jadi husus pikeun jenis nu tangtu jaringan neural, sarta yén aspék indeterminate processing GPU-spésifik, remen ditempo salaku halangan pikeun ahirna diungkulan, bisa jadi teu ukur nyadiakeun kauntungan kasohor, tapi ahirna bisa ngahaja. diasupkeun kana sistem engké. Tulisan éta ogé nunjukkeun yén panemuan éta tiasa nawiskeun wawasan anu langkung jero kana pamrosésan komputasi anu aya hubunganana sareng otak.

Ngidentipikasi ciri-ciri anu ningkatkeun efisiensi sareng kualitas hasil ku cara ieu dina GPUs gaduh poténsi pikeun kéngingkeun wawasan anu langkung jero kana arsitéktur AI 'kotak hideung', komo pikeun ningkatkeun kinerja CPU - sanaos ayeuna, panyabab dasarna hese dihartikeun.

Autoencoder vs. PredNet

Dina ngulik anomali, panalungtik ngagunakeun autoencoder dasar sareng ogé Jaringan Neural Prediktif Universitas Harvard. PredNet, panalungtikan ti 2016 nu dirancang pikeun ngajajah tur nyobian ngayakeun réplikasi paripolah cortex cerebral manusa.

Kadua sistem nyaéta jaringan saraf jero anu dirancang pikeun nyintésis gambar anu cocog ngaliwatan pangajaran anu teu diawaskeun (kalayan data anu dileungitkeun labél), sanaos autoencoder ngurus sacara linier sareng hiji gambar per angkatan, anu teras bakal ngahasilkeun kaluaran salaku gambar salajengna dina pipa anu ngulang deui. Autoencoder ieu dilatih dina MNIST database tulisan leungeun.

Autoencoder dina tés panalungtik dilatih dina database MNIST, anu ngandung 60,000 gambar latihan dina 28 × 28 piksel, anti-alias pikeun induksi skala abu-abu, ogé 10,000 gambar tés.

Sabalikna, PredNet ngaevaluasi input video kompléks, sarta dina kasus ieu panalungtikan, dilatih dina databés FPSI, Nu ciri footage video éksténsif awak-dipaké poé di Disney Dunya di Orlando, Florida (Disney éta salah sahiji associates panalungtikan dina kertas 2012).

Runtuyan gambar ti FPSI, némbongkeun pintonan jalma kahiji dina hiji poé di Disney World.

Dua arsitéktur béda pisan dina hal pajeulitna. Autoencoder dirancang pikeun ngarekonstruksikeun gambar tinimbang ngaduga nilai target. Sabalikna, PredNet ngagaduhan opat lapisan, anu masing-masing diwangun ku neuron representasi nganggo mémori jangka pondok panjang convolutional (LSTM).

Lapisan kaluaran prediksi kontekstual anu teras dibandingkeun sareng udagan pikeun ngahasilkeun istilah kasalahan anu nyebarkeun sapanjang jaringan. Masing-masing tina dua modél ngagunakeun pangajaran anu henteu diawasi.

Saderhana, arsitéktur linier autoencoder, sareng jaringan langkung labyrinthine sareng rekursif PredNet.

Kadua sistem diuji dina sababaraha konfigurasi hardware sareng software, kalebet CPU tanpa GPU (Intel i5-4590, i7-6800K, i5-7600K, atanapi AMD Ryzen-5-3600) sareng CPU sareng GPU (Intel i5-7600K + NVIDIA. GTX-750Ti, i5-7600K + GTX-970, i7-6700K + GTX-1080, i7-7700K + GTX-1080Ti, i7-9700 + RTX-2080Ti, i5-7600K + RTX-2060 super, AMD Ryzen-5- 3600 + RTX-2070 super, atanapi i5-9400 + Titan-RTX).

Panempo prosés interaktif htop ieu dipaké pikeun mastikeun yén sakabéh latihan lumangsung boh dina thread tunggal (dina Intel i7-6800K), dina opat threads (dina Intel i5-4590 na i5-7600K), atawa genep threads (dina AMD Ryzen-5-3600). ).

Saddle Points

Dina autoencoder, bédana rata-rata dina sadaya konfigurasi, sareng sareng tanpa cuDNN, henteu signifikan. Pikeun PredNet, hasilna langkung pikasieuneun, kalayan béda anu penting dina evaluasi leungitna sareng kualitas antara latihan CPU sareng GPU.

Hasil leungitna rata pikeun latihan PredNet sakuliah opat CPU jeung dalapan GPUs, kalawan jaringan dilatih dina 5000 pigura video dina 250 bets, kalawan leungitna rata pikeun panungtungan 1000 pigura (50 bets) digambarkeun. cuDNN dipareuman.

Para panalungtik menyimpulkan yén 'Sanajan mékanisme nu teu jelas, hardware GPU sigana mibanda kamampuhan pikeun maju latihan DNNs.'

Hasilna nunjukkeun yén GPU tiasa langkung saé pikeun ngahindarkeun titik sela - daérah dina turunan gradién anu ngajelaskeun handapeun lamping.

Nadir lamping dina turunan gradién nyaéta 'titik pelana', dingaranan alesan anu jelas. Sumber: https://www.pinterest.com.au/pin/436849232581124086/

Titik pelana, sanaos halangan, sabagéan ageung dileungitkeun salaku gampang dianggo dina pamikiran panganyarna ngeunaan optimasi turunan gradién stokastik (SGD), tapi tulisan anyar nunjukkeun henteu ngan ukur yén GPU tiasa dipasang sacara unik pikeun ngahindarkeunana, tapi pangaruh titik saddle meureun kudu revisited.