ປັນຍາປະດິດ

Llama 2: A Deep Dive into the Open-Source Challenger to ChatGPT

ຮູບແບບພາສາຂະຫນາດໃຫຍ່ (LLMs) ມີຄວາມສາມາດໃນວຽກງານທີ່ສົມເຫດສົມຜົນທີ່ສັບສົນໄດ້ສະແດງໃຫ້ເຫັນຄໍາສັນຍາໃນໂດເມນພິເສດເຊັ່ນການຂຽນໂປລແກລມແລະການສ້າງສັນ. ຢ່າງໃດກໍຕາມ, ໂລກຂອງ LLMs ບໍ່ພຽງແຕ່ເປັນຄໍາຂວັນ plug-and-play; ມີຄວາມທ້າທາຍໃນການນຳໃຊ້, ຄວາມປອດໄພ, ແລະຄວາມຕ້ອງການຄອມພິວເຕີ. ໃນບົດຄວາມນີ້, ພວກເຮົາຈະ dive ເລິກເຂົ້າໄປໃນຄວາມສາມາດຂອງ ລາມາ 2, ໃນຂະນະທີ່ສະຫນອງຂັ້ນຕອນລະອຽດສໍາລັບການຕັ້ງຄ່າ LLM ທີ່ມີປະສິດທິພາບສູງນີ້ຜ່ານ Hugging Face ແລະ T4 GPUs ໃນ Google Colab.

ພັດທະນາໂດຍ Meta ກັບການຮ່ວມມືກັບ Microsoft, ຮູບແບບພາສາຂະຫນາດໃຫຍ່ທີ່ເປີດແຫຼ່ງນີ້ມີຈຸດປະສົງເພື່ອກໍານົດຂອບເຂດຂອງ AI ທົ່ວໄປແລະຄວາມເຂົ້າໃຈພາສາທໍາມະຊາດ. Llama 2 ບໍ່ແມ່ນພຽງແຕ່ຕົວແບບສະຖິຕິອື່ນທີ່ໄດ້ຮັບການຝຶກອົບຮົມກ່ຽວກັບຂໍ້ມູນ terabytes; ມັນເປັນສັນຍາລັກຂອງປັດຊະຍາ. ຫນຶ່ງທີ່ເນັ້ນຫນັກເຖິງວິທີການເປີດແຫຼ່ງທີ່ເປັນກະດູກສັນຫຼັງຂອງການພັດທະນາ AI, ໂດຍສະເພາະໃນພື້ນທີ່ AI ການຜະລິດ.

Llama 2 ແລະຕົວແທນທີ່ປັບແຕ່ງໃຫ້ເໝາະສົມ, Llama 2-Chat, ມາພ້ອມກັບຕົວກໍານົດການສູງເຖິງ 70 ຕື້. ເຂົາເຈົ້າຜ່ານຂະບວນການປັບປ່ຽນທີ່ອອກແບບມາເພື່ອຈັດວາງພວກມັນໃຫ້ໃກ້ຊິດກັບຄວາມມັກຂອງມະນຸດ, ເຮັດໃຫ້ມັນມີຄວາມປອດໄພ ແລະມີປະສິດທິພາບຫຼາຍກວ່າແບບຈໍາລອງອື່ນໆທີ່ມີຢູ່ທົ່ວໄປ. ລະດັບຂອງ granularity ໃນການປັບປຸງລະອຽດແມ່ນມັກຈະສະຫງວນໄວ້ສໍາລັບການປິດ "ຜະລິດຕະພັນ" LLMs, ເຊັ່ນ: ສົນທະນາ GPT ແລະ BARD, ເຊິ່ງໂດຍທົ່ວໄປແລ້ວແມ່ນບໍ່ມີສໍາລັບການກວດກາສາທາລະນະຫຼືການປັບແຕ່ງ.

ວິຊາການເລິກຊ້ໍາຂອງ Llama 2

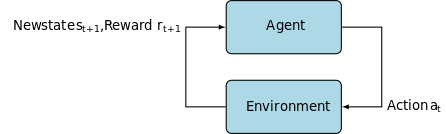

ສໍາລັບການຝຶກອົບຮົມຮູບແບບ Llama 2; ຄືກັບລຸ້ນກ່ອນຂອງມັນ, ມັນໃຊ້ການຖອຍຫຼັງອັດຕະໂນມັດ ຖາປັດຕະຍະການຫັນປ່ຽນ, ການຝຶກອົບຮົມລ່ວງໜ້າກ່ຽວກັບ corpus ຢ່າງກວ້າງຂວາງຂອງຂໍ້ມູນການເບິ່ງແຍງຕົນເອງ. ຢ່າງໃດກໍ່ຕາມ, ມັນເພີ່ມຊັ້ນເພີ່ມເຕີມຂອງຄວາມຊັບຊ້ອນໂດຍໃຊ້ Reinforcement Learning with Human Feedback (RLHF) ເພື່ອໃຫ້ສອດຄ່ອງກັບພຶດຕິກໍາແລະຄວາມມັກຂອງມະນຸດ. ອັນນີ້ແມ່ນມີລາຄາແພງໃນຄອມພິວເຕີ້ ແຕ່ມີຄວາມສຳຄັນຕໍ່ການປັບປຸງຄວາມປອດໄພ ແລະປະສິດທິພາບຂອງຕົວແບບ.

Pretraining & ປະສິດທິພາບຂໍ້ມູນ

ນະວັດຕະກໍາພື້ນຖານຂອງ Llama 2 ແມ່ນຢູ່ໃນລະບົບ pretraining ຂອງມັນ. ຮູບແບບດັ່ງກ່າວໄດ້ຮັບຮູ້ຈາກລຸ້ນກ່ອນ, Llama 1, ແຕ່ແນະນຳການປັບປຸງທີ່ສຳຄັນຫຼາຍອັນເພື່ອຍົກລະດັບປະສິດທິພາບຂອງມັນ. ເປັນທີ່ຫນ້າສັງເກດ, ການເພີ່ມຂຶ້ນ 40% ໃນຈໍານວນ tokens ທັງຫມົດທີ່ໄດ້ຮັບການຝຶກອົບຮົມແລະການຂະຫຍາຍສອງເທົ່າໃນຄວາມຍາວຂອງສະພາບການແມ່ນໂດດເດັ່ນ. ຍິ່ງໄປກວ່ານັ້ນ, ຮູບແບບດັ່ງກ່າວໄດ້ໃຊ້ຄວາມສົນໃຈແບບສອບຖາມແບບກຸ່ມ (GQA) ເພື່ອຂະຫຍາຍການຂະຫຍາຍການອ້າງອີງ.

Supervised Fine-Tuning (SFT) & Reinforcement Learning with Human Feedback (RLHF)

Llama-2-chat ໄດ້ຮັບການປັບປຸງຢ່າງເຂັ້ມງວດໂດຍໃຊ້ທັງ SFT ແລະ Reinforcement Learning with Human Feedback (RLHF). ໃນສະພາບການນີ້, SFT ເຮັດຫນ້າທີ່ເປັນອົງປະກອບທີ່ສໍາຄັນຂອງກອບ RLHF, ປັບປຸງການຕອບສະຫນອງຂອງຕົວແບບເພື່ອໃຫ້ສອດຄ່ອງຢ່າງໃກ້ຊິດກັບຄວາມມັກແລະຄວາມຄາດຫວັງຂອງມະນຸດ.

OpenAI ໄດ້ໃຫ້ຕົວຢ່າງຄວາມເຂົ້າໃຈທີ່ອະທິບາຍວິທີການ SFT ແລະ RLHF ທີ່ໃຊ້ໃນ InstructGPT. ຄືກັນກັບ LLaMa 2, InstructGPT ຍັງໃຊ້ເຕັກນິກການຝຶກອົບຮົມຂັ້ນສູງເຫຼົ່ານີ້ເພື່ອເພີ່ມປະສິດທິພາບຂອງຕົວແບບຂອງມັນ.

ຂັ້ນຕອນທີ 1 ໃນຮູບຂ້າງລຸ່ມນີ້ເນັ້ນໃສ່ Supervised Fine-Tuning (SFT), ໃນຂະນະທີ່ຂັ້ນຕອນຕໍ່ໄປສໍາເລັດຂະບວນການ Reinforcement Learning from Human Feedback (RLHF).

Supervised Fine-Tuning (SFT) ແມ່ນຂະບວນການພິເສດທີ່ແນໃສ່ການເພີ່ມປະສິດທິພາບຂອງຕົວແບບພາສາຂະໜາດໃຫຍ່ (LLM) ທີ່ໄດ້ຮັບການຝຶກອົບຮົມໄວ້ລ່ວງໜ້າສໍາລັບວຽກງານສະເພາະລຸ່ມນໍ້າ. ບໍ່ເຫມືອນກັບວິທີການທີ່ບໍ່ມີການເບິ່ງແຍງ, ເຊິ່ງບໍ່ຈໍາເປັນຕ້ອງມີການກວດສອບຂໍ້ມູນ, SFT ໃຊ້ຊຸດຂໍ້ມູນທີ່ໄດ້ຮັບການກວດສອບກ່ອນແລະຕິດສະຫຼາກ.

ໂດຍທົ່ວໄປແລ້ວການສ້າງຊຸດຂໍ້ມູນເຫຼົ່ານີ້ແມ່ນມີຄ່າໃຊ້ຈ່າຍຫຼາຍ ແລະໃຊ້ເວລາຫຼາຍ. ວິທີການ Llama 2 ແມ່ນຄຸນນະພາບຫຼາຍກວ່າປະລິມານ. ດ້ວຍພຽງແຕ່ 27,540 ຄໍາບັນຍາຍ, ທີມງານຂອງ Meta ໄດ້ບັນລຸລະດັບການປະຕິບັດທີ່ແຂ່ງຂັນກັບຜູ້ບັນຍາຍຂອງມະນຸດ. ນີ້ສອດຄ່ອງດີກັບ ການສຶກສາທີ່ຜ່ານມາ ສະແດງໃຫ້ເຫັນວ່າເຖິງແມ່ນວ່າຊຸດຂໍ້ມູນທີ່ຈໍາກັດແຕ່ສະອາດສາມາດຂັບລົດຜົນໄດ້ຮັບທີ່ມີຄຸນນະພາບສູງ.

ໃນຂະບວນການ SFT, LLM ທີ່ໄດ້ຮັບການຝຶກອົບຮົມລ່ວງໜ້າຈະຖືກເປີດເຜີຍຕໍ່ກັບຊຸດຂໍ້ມູນທີ່ມີປ້າຍກຳກັບ, ບ່ອນທີ່ລະບົບການຮຽນຮູ້ທີ່ມີການເບິ່ງແຍງກວດກາ. ນ້ຳໜັກພາຍໃນຂອງຕົວແບບແມ່ນຖືກຄິດໄລ່ຄືນໃໝ່ໂດຍອ້າງອີງຈາກລະດັບຄວາມສູງທີ່ຄິດໄລ່ຈາກຟັງຊັນການສູນເສຍສະເພາະໜ້າວຽກ. ຟັງຊັນການສູນເສຍນີ້ປະເມີນຄວາມແຕກຕ່າງລະຫວ່າງຜົນໄດ້ຮັບທີ່ຄາດຄະເນຂອງຕົວແບບແລະປ້າຍຊື່ຄວາມຈິງ.

ການເພີ່ມປະສິດທິພາບນີ້ເຮັດໃຫ້ LLM ສາມາດເຂົ້າໃຈຮູບແບບທີ່ສັບສົນ ແລະຄວາມແຕກຕ່າງທີ່ຝັງຢູ່ໃນຊຸດຂໍ້ມູນທີ່ຕິດສະຫຼາກ. ດັ່ງນັ້ນ, ຮູບແບບດັ່ງກ່າວບໍ່ພຽງແຕ່ເປັນເຄື່ອງມືທົ່ວໄປ, ແຕ່ພັດທະນາໄປສູ່ຊັບສິນພິເສດ, ຊໍານິຊໍານານໃນການປະຕິບັດວຽກງານເປົ້າຫມາຍທີ່ມີຄວາມຖືກຕ້ອງສູງ.

ການເສີມສ້າງການຮຽນຮູ້ແມ່ນບາດກ້າວຕໍ່ໄປ, ແນໃສ່ການຈັດລຽງພຶດຕິກຳຕົວແບບກັບຄວາມມັກຂອງມະນຸດໃຫ້ໃກ້ຊິດກວ່າ.

ໄລຍະການປັບປ່ຽນໄດ້ໃຊ້ການເສີມສ້າງການຮຽນຮູ້ຈາກຄວາມຄິດເຫັນຂອງມະນຸດ (RLHF), ການໃຊ້ເຕັກນິກເຊັ່ນ: ການເກັບຕົວຢ່າງຄວາມສໍາຄັນ ແລະ ການເພີ່ມປະສິດທິພາບນະໂຍບາຍໃກ້ຄຽງ ເພື່ອແນະນໍາສິ່ງລົບກວນ algorithmic, ດັ່ງນັ້ນຈຶ່ງຫລີກລ້ຽງ optima ທ້ອງຖິ່ນ. ການປັບປຸງແບບຊໍ້າໆນີ້ບໍ່ພຽງແຕ່ປັບປຸງຕົວແບບເທົ່ານັ້ນ ແຕ່ຍັງເຮັດໃຫ້ຜົນຜະລິດຂອງມັນສອດຄ່ອງກັບຄວາມຄາດຫວັງຂອງມະນຸດ.

Llama 2-Chat ໄດ້ໃຊ້ໂປຣໂຕຄອນການປຽບທຽບແບບຄູ່ເພື່ອເກັບກຳຂໍ້ມູນຄວາມມັກຂອງມະນຸດ, ເຊິ່ງໝາຍເຖິງທ່າອ່ຽງທີ່ໂດດເດັ່ນຕໍ່ກັບວິທີການທີ່ມີຄຸນນະພາບຫຼາຍຂຶ້ນ. ກົນໄກນີ້ໄດ້ແຈ້ງໃຫ້ຕົວແບບຈໍາລອງລາງວັນ, ເຊິ່ງຫຼັງຈາກນັ້ນຖືກນໍາໃຊ້ເພື່ອປັບຕົວແບບ AI ການສົນທະນາ.

Ghost ເອົາ ໃຈ ໃສ່: ການ ສົນ ທະ ນາ ຫຼາຍ ຫັນ

Meta ໄດ້ນໍາສະເຫນີຄຸນສົມບັດໃຫມ່, Ghost Attention (GAtt) ເຊິ່ງຖືກອອກແບບມາເພື່ອເພີ່ມປະສິດທິພາບຂອງ Llama 2 ໃນການສົນທະນາຫຼາຍຄັ້ງ. ອັນນີ້ຊ່ວຍແກ້ໄຂບັນຫາທີ່ຍັງຄົງຄ້າງຂອງການສູນເສຍບໍລິບົດໃນການສົນທະນາຢ່າງຕໍ່ເນື່ອງ. GAtt ປະຕິບັດຄືກັບສະມໍ, ເຊື່ອມຕໍ່ຄໍາແນະນໍາເບື້ອງຕົ້ນກັບທຸກຂໍ້ຄວາມຂອງຜູ້ໃຊ້ຕໍ່ມາ. ຄຽງຄູ່ກັບເຕັກນິກການຮຽນຮູ້ການເສີມສ້າງ, ມັນຊ່ວຍໃນການຜະລິດຄໍາຕອບທີ່ສອດຄ່ອງ, ທີ່ກ່ຽວຂ້ອງ, ແລະສອດຄ່ອງກັບຜູ້ໃຊ້ຫຼາຍກວ່າການສົນທະນາທີ່ຍາວກວ່າ.

ຈາກ Meta Git Repository ໂດຍໃຊ້ download.sh

- ໄປຢ້ຽມຢາມເວັບໄຊທ໌ Meta: ນຳ ທາງໄປຫາ ເວັບໄຊທ໌ຢ່າງເປັນທາງການຂອງ Meta Llama 2 ແລະໃຫ້ຄລິກໃສ່ 'ດາວໂຫລດຮູບແບບໄດ້'

- ຕື່ມຂໍ້ມູນໃສ່ໃນລາຍລະອຽດ: ອ່ານຜ່ານແລະຍອມຮັບຂໍ້ກໍານົດແລະເງື່ອນໄຂເພື່ອດໍາເນີນການ.

- ການຢັ້ງຢືນອີເມວ: ເມື່ອແບບຟອມຖືກສົ່ງ, ທ່ານຈະໄດ້ຮັບອີເມວຈາກ Meta ທີ່ມີລິ້ງເພື່ອດາວໂຫລດຮູບແບບຈາກບ່ອນເກັບ git ຂອງພວກເຂົາ.

- ປະຕິບັດ download.sh: Clone the Git repository and execute the

download.shສະຄຣິບ. ສະຄຣິບນີ້ຈະເຕືອນໃຫ້ທ່ານພິສູດຢືນຢັນໂດຍໃຊ້ URL ຈາກ Meta ທີ່ໝົດອາຍຸໃນ 24 ຊົ່ວໂມງ. ນອກນັ້ນທ່ານຍັງຈະເລືອກຂະຫນາດຂອງຕົວແບບ - 7B, 13B, ຫຼື 70B.

ຈາກ Hugging Face

- ໄດ້ຮັບອີເມວການຍອມຮັບ: ຫຼັງຈາກໄດ້ຮັບການເຂົ້າເຖິງຈາກ Meta, ໄປຫາ ໃບຫນ້າກອດ.

- ຂໍການເຂົ້າເຖິງ: ເລືອກຮູບແບບທີ່ທ່ານຕ້ອງການແລະສົ່ງຄໍາຮ້ອງຂໍເພື່ອອະນຸຍາດໃຫ້ເຂົ້າເຖິງ.

- ການຢືນຢັນ: ຄາດວ່າຈະມີອີເມວ 'ອະນຸຍາດເຂົ້າເຖິງ' ພາຍໃນ 1-2 ມື້.

- ສ້າງໂທເຄັນການເຂົ້າເຖິງ: ທ່ອງໄປຫາ 'Settings' ໃນບັນຊີ Hugging Face ຂອງທ່ານເພື່ອສ້າງ tokens ການເຂົ້າເຖິງ.

ການປ່ອຍ Transformers 4.31 ແມ່ນເຂົ້າກັນໄດ້ຢ່າງເຕັມສ່ວນກັບ LLaMa 2 ແລະເປີດເຄື່ອງມືແລະການທໍາງານຫຼາຍຢ່າງພາຍໃນລະບົບນິເວດ Hugging Face. ຈາກການຝຶກອົບຮົມແລະ inference scripts ກັບ 4-bit quantization ກັບ bitsandbytes ແລະ Parameter Efficient Fine-tuning (PEFT), ຊຸດເຄື່ອງມືແມ່ນກວ້າງຂວາງ. ເພື່ອເລີ່ມຕົ້ນ, ໃຫ້ແນ່ໃຈວ່າທ່ານຢູ່ໃນການປ່ອຍ Transformers ຫຼ້າສຸດ ແລະເຂົ້າສູ່ລະບົບບັນຊີ Hugging Face ຂອງທ່ານ.

ນີ້ແມ່ນ ຄຳ ແນະ ນຳ ທີ່ຄ່ອງແຄ້ວໃນການແລ່ນຕົວແບບ LLaMa 2 inference in a google colab ສະພາບແວດລ້ອມ, ການໃຊ້ GPU runtime:

ການຕິດຕັ້ງຊຸດ

!pip install transformers !huggingface-cli login

ນໍາເຂົ້າຫ້ອງສະຫມຸດ Python ທີ່ຈໍາເປັນ.

from transformers import AutoTokenizer import transformers import torch

ເລີ່ມຕົ້ນຕົວແບບ ແລະໂຕເຄນເຊີ

ໃນຂັ້ນຕອນນີ້, ໃຫ້ລະບຸຕົວແບບ Llama 2 ທີ່ເຈົ້າຈະໃຊ້. ສໍາລັບຄໍາແນະນໍານີ້, ພວກເຮົາໃຊ້ meta-llama/Llama-2-7b-chat-hf.

model = "meta-llama/Llama-2-7b-chat-hf" tokenizer = AutoTokenizer.from_pretrained(model)

ຕັ້ງທໍ່

ໃຊ້ທໍ່ Hugging Face ສໍາລັບການສ້າງຂໍ້ຄວາມທີ່ມີການຕັ້ງຄ່າສະເພາະ:

pipeline = transformers.pipeline(

"text-generation",

model=model,

torch_dtype=torch.float16,

device_map="auto")

ສ້າງລໍາດັບຂໍ້ຄວາມ

ສຸດທ້າຍ, ດໍາເນີນການທໍ່ແລະສ້າງລໍາດັບຂໍ້ຄວາມໂດຍອີງໃສ່ຂໍ້ມູນຂອງທ່ານ:

sequences = pipeline(

'Who are the key contributors to the field of artificial intelligence?\n',

do_sample=True,

top_k=10,

num_return_sequences=1,

eos_token_id=tokenizer.eos_token_id,

max_length=200)

for seq in sequences:

print(f"Result: {seq['generated_text']}")

UI ຂອງ A16Z ສໍາລັບ LLaMa 2

Andreessen Horowitz (A16Z) ບໍ່ດົນມານີ້ໄດ້ເປີດຕົວການໂຕ້ຕອບ chatbot ແບບ Streamlit ທີ່ທັນສະ ໄໝ ເໝາະ ສົມກັບ Llama 2. Hosted on GitHub, UI ນີ້ຮັກສາປະຫວັດການສົນທະນາຂອງເຊດຊັນແລະຍັງໃຫ້ຄວາມຍືດຫຍຸ່ນໃນການເລືອກຈາກຫຼາຍຈຸດສິ້ນສຸດຂອງ Llama 2 API ທີ່ໂຮດຢູ່ໃນ ຈຳ ລອງ. ການອອກແບບທີ່ເນັ້ນຜູ້ໃຊ້ເປັນສູນກາງນີ້ມີຈຸດປະສົງເພື່ອເຮັດໃຫ້ການໂຕ້ຕອບກັບ Llama 2 ງ່າຍຂຶ້ນ, ເຮັດໃຫ້ມັນເປັນເຄື່ອງມືທີ່ເຫມາະສົມສໍາລັບທັງນັກພັດທະນາແລະຜູ້ໃຊ້ສຸດທ້າຍ. ສໍາລັບຜູ້ທີ່ສົນໃຈໃນປະສົບການນີ້, ການສາທິດສົດແມ່ນມີຢູ່ Llama2.ai.

Llama 2: ສິ່ງທີ່ເຮັດໃຫ້ມັນແຕກຕ່າງຈາກ GPT Models ແລະ Llama 1 predecessor ຂອງມັນ?

ຄວາມຫຼາກຫຼາຍໃນຂະໜາດ

ບໍ່ເຫມືອນກັບຕົວແບບພາສາຈໍານວນຫຼາຍທີ່ສະຫນອງການຂະຫຍາຍທີ່ຈໍາກັດ, Llama 2 ໃຫ້ທ່ານມີຫຼາຍທາງເລືອກທີ່ແຕກຕ່າງກັນສໍາລັບຕົວແບບທີ່ມີຕົວກໍານົດການທີ່ແຕກຕ່າງກັນ. ຮູບແບບດັ່ງກ່າວມີຂະຫນາດຈາກ 7 ຕື້ຫາ 70 ຕື້ພາລາມິເຕີ, ດັ່ງນັ້ນຈຶ່ງສະຫນອງການກໍານົດຂອບເຂດທີ່ເຫມາະສົມກັບຄວາມຕ້ອງການຄອມພິວເຕີ້ທີ່ຫຼາກຫຼາຍ.

ປັບປຸງຄວາມຍາວຂອງເນື້ອໃນ

ຮູບແບບດັ່ງກ່າວມີຄວາມຍາວບໍລິບົດເພີ່ມຂຶ້ນຂອງ 4K tokens ກ່ວາ Llama 1. ນີ້ອະນຸຍາດໃຫ້ສາມາດເກັບຂໍ້ມູນເພີ່ມເຕີມ, ດັ່ງນັ້ນການເພີ່ມຄວາມສາມາດໃນການເຂົ້າໃຈແລະສ້າງເນື້ອຫາສະລັບສັບຊ້ອນແລະກວ້າງຂວາງ.

ການໃສ່ໃຈແບບສອບຖາມເປັນກຸ່ມ (GQA)

ສະຖາປັດຕະຍະກໍາໃຊ້ແນວຄວາມຄິດຂອງ GQA, ອອກແບບມາເພື່ອເລັ່ງຂະບວນການຄິດໄລ່ຄວາມສົນໃຈໂດຍການຈັດເກັບຄູ່ token ທີ່ຜ່ານມາ. ອັນນີ້ຊ່ວຍປັບປຸງການຂະຫຍາຍຕົວແບບ inference ໄດ້ຢ່າງມີປະສິດທິພາບ ເພື່ອເພີ່ມການເຂົ້າເຖິງ.

ມາດຕະຖານການປະຕິບັດ

LLama 2 ໄດ້ກໍານົດມາດຕະຖານໃຫມ່ໃນການວັດແທກການປະຕິບັດ. ມັນບໍ່ພຽງແຕ່ດີກວ່າລຸ້ນກ່ອນ, LLama 1 ແຕ່ຍັງສະຫນອງການແຂ່ງຂັນທີ່ສໍາຄັນກັບແບບອື່ນໆເຊັ່ນ Falcon ແລະ GPT-3.5.

ຮູບແບບທີ່ໃຫຍ່ທີ່ສຸດຂອງ Llama 2-Chat, 70B, ຍັງດີກວ່າ ChatGPT ໃນ 36% ຂອງຕົວຢ່າງ ແລະກົງກັບການປະຕິບັດໃນອີກ 31.5% ຂອງກໍລະນີ. ທີ່ມາ: Paper

ແຫຼ່ງເປີດ: ພະລັງງານຂອງຊຸມຊົນ

Meta ແລະ Microsoft ຕັ້ງໃຈໃຫ້ Llama 2 ເປັນຫຼາຍກ່ວາພຽງແຕ່ຜະລິດຕະພັນ; ເຂົາເຈົ້າຄິດວ່າມັນເປັນເຄື່ອງມືທີ່ຂັບເຄື່ອນໂດຍຊຸມຊົນ. Llama 2 ແມ່ນບໍ່ເສຍຄ່າເພື່ອເຂົ້າເຖິງສໍາລັບທັງການຄົ້ນຄວ້າແລະຈຸດປະສົງທີ່ບໍ່ແມ່ນການຄ້າ. ເຫຼົ່ານີ້ແມ່ນມີຈຸດປະສົງເພື່ອປະຊາທິປະໄຕຄວາມສາມາດຂອງ AI, ເຮັດໃຫ້ມັນສາມາດເຂົ້າເຖິງການເລີ່ມຕົ້ນ, ນັກຄົ້ນຄວ້າ, ແລະທຸລະກິດ. ແຜນວາດໂອເພນຊອດອະນຸຍາດໃຫ້ໃຊ້ 'ການແກ້ໄຂບັນຫາຈາກແຫຼ່ງທີ່ມາຂອງຕົວແບບ'. ນັກພັດທະນາແລະນັກຈັນຍາບັນ AI ສາມາດທົດສອບຄວາມກົດດັນ, ກໍານົດຈຸດອ່ອນ, ແລະສະເຫນີການແກ້ໄຂໃນຈັງຫວະທີ່ເລັ່ງ.

ໃນຂະນະທີ່ເງື່ອນໄຂການອອກໃບອະນຸຍາດສໍາລັບ LLaMa 2 ໂດຍທົ່ວໄປແມ່ນອະນຸຍາດ, ຍົກເວັ້ນ ມີຢູ່. ວິສາຫະກິດຂະຫນາດໃຫຍ່ທີ່ມີຜູ້ໃຊ້ປະຈໍາເດືອນຫຼາຍກວ່າ 700 ລ້ານຄົນ, ເຊັ່ນ Google, ຮຽກຮ້ອງໃຫ້ມີການອະນຸຍາດຢ່າງຊັດເຈນຈາກ Meta ສໍາລັບການນໍາໃຊ້ຂອງມັນ. ນອກຈາກນັ້ນ, ໃບອະນຸຍາດຫ້າມໃຊ້ LLaMa 2 ສໍາລັບການປັບປຸງຮູບແບບພາສາອື່ນໆ.

ສິ່ງທ້າທາຍໃນປະຈຸບັນກັບ Llama 2

- ຂໍ້ມູນທົ່ວໄປ: ທັງສອງ Llama 2 ແລະ GPT-4 ບາງຄັ້ງກໍ່ລົ້ມລົງໃນການປະຕິບັດທີ່ສູງເທົ່າທຽມກັນໃນທົ່ວວຽກງານທີ່ຫຼາກຫຼາຍ. ຄຸນນະພາບຂໍ້ມູນແລະຄວາມຫຼາກຫຼາຍແມ່ນເປັນຈຸດສໍາຄັນເທົ່າກັບປະລິມານໃນສະຖານະການເຫຼົ່ານີ້.

- ຄວາມໂປ່ງໃສແບບຈໍາລອງ: ເນື່ອງຈາກຄວາມເສຍປຽບກ່ອນຫນ້າກັບ AI ຜະລິດຜົນຜະລິດທີ່ເຂົ້າໃຈຜິດ, ການຂຸດຄົ້ນເຫດຜົນການຕັດສິນໃຈທີ່ຢູ່ເບື້ອງຫລັງແບບຈໍາລອງທີ່ສັບສົນເຫຼົ່ານີ້ແມ່ນສໍາຄັນທີ່ສຸດ.

Code Llama – ການເປີດຕົວຫຼ້າສຸດຂອງ Meta

Meta ປະກາດເມື່ອບໍ່ດົນມານີ້ ລະຫັດ Llama ເຊິ່ງເປັນຕົວແບບພາສາຂະຫນາດໃຫຍ່ທີ່ມີຄວາມຊ່ຽວຊານໃນການຂຽນໂປຼແກຼມທີ່ມີຂະຫນາດພາລາມິເຕີຕັ້ງແຕ່ 7B ຫາ 34B. ຄ້າຍຄືກັບ ຕົວແປລະຫັດ ChatGPT; ລະຫັດ Llama ສາມາດປັບປຸງຂະບວນການເຮັດວຽກຂອງຜູ້ພັດທະນາແລະເຮັດໃຫ້ການຂຽນໂປຼແກຼມເຂົ້າເຖິງໄດ້ຫຼາຍຂຶ້ນ. ມັນຮອງຮັບພາສາການຂຽນໂປລແກລມຕ່າງໆແລະມາໃນຮູບແບບພິເສດ, ເຊັ່ນ: Code Llama-Python ສໍາລັບວຽກງານສະເພາະ Python. ຮູບແບບດັ່ງກ່າວຍັງສະຫນອງລະດັບການປະຕິບັດທີ່ແຕກຕ່າງກັນເພື່ອຕອບສະຫນອງຄວາມຕ້ອງການ latency ທີ່ມີຄວາມຫຼາກຫຼາຍ. ມີໃບອະນຸຍາດຢ່າງເປີດເຜີຍ, Code Llama ເຊີນການປ້ອນຂໍ້ມູນຊຸມຊົນເພື່ອການປັບປຸງຢ່າງຕໍ່ເນື່ອງ.

ສະຫຼຸບ

ບົດຄວາມນີ້ໄດ້ຍ່າງໃຫ້ທ່ານໂດຍຜ່ານການຕັ້ງຮູບແບບ Llama 2 ສໍາລັບການຜະລິດຂໍ້ຄວາມໃນ Google Colab ທີ່ມີການຮອງຮັບ Hugging Face. ການປະຕິບັດຂອງ Llama 2 ແມ່ນການຂັບເຄື່ອນດ້ວຍເຕັກນິກຂັ້ນສູງຈາກສະຖາປັດຕະຍະກຳການຫັນປ່ຽນອັດຕະໂນມັດໄປສູ່ການຮຽນຮູ້ການເສີມສ້າງດ້ວຍຄຳຕິຊົມຂອງມະນຸດ (RLHF). ມີເຖິງ 70 ພັນລ້ານພາລາມິເຕີ ແລະລັກສະນະຕ່າງໆເຊັ່ນ Ghost Attention, ຮູບແບບນີ້ປະຕິບັດໄດ້ມາດຕະຖານອຸດສາຫະກໍາໃນປະຈຸບັນໃນບາງຂົງເຂດ, ແລະດ້ວຍລັກສະນະເປີດຂອງມັນ, ມັນປູທາງໄປສູ່ຍຸກໃຫມ່ໃນຄວາມເຂົ້າໃຈພາສາທໍາມະຊາດ ແລະ AI ການຜະລິດ.