Endezyariya bilez

Fêmkirina LLM Fine-Tuning: Dirûtina Modelên Zimanên Mezin li gorî Pêdiviyên Xweyên Yekta

Gava ku em di Îlona 2023-an de radiwestin, perestgeha Modelên Zimanên Mezin (LLM) hîn jî şahidê bilindbûna modelan di nav de Alpaca, Falcon, Lama 2, GPT-4, û gelekên din.

Aliyek girîng a bikêrhatina potansiyela van LLM-an di pêvajoyek birêkûpêk de ye, stratejiyek ku destûrê dide xwerûkirina modelên pêş-perwerdekirî da ku karên taybetî bi hûrgulî peyda bike. Bi saya vê verastkirinê ye ku ev model bi rastî dikarin bi hewcedariyên takekesî re li hev bikin, çareseriyên ku hem nûjen in û hem jî li gorî hewcedariyên bêhempa ne pêşkêş dikin.

Lêbelê, pêdivî ye ku meriv bala xwe bide ku ne hemî rêyên baş-tune wekhev têne afirandin. Mînakî, gihîştina kapasîteyên başkirina GPT-4 bi nirxek tê, pêdivî ye ku abonetiyek drav ku li gorî vebijarkên din ên ku di sûkê de hene bi nisbeten bihatir e. Ji hêla din ve, qada çavkaniya vekirî bi alternatîfên ku ji bo karanîna hêza modelên zimanên mezin rêgezek gihîştîtir pêşkêş dikin re mijûl e. Van vebijarkên-çavkaniya vekirî gihîştina teknolojiya pêşkeftî ya AI-ê demokratîk dikin, di perestgeha AI-ê ya ku bi lez pêşve diçe de nûbûn û tevlêbûnê xurt dike.

Çima başkirina LLM girîng e?

Rêzkirina LLM ji pêşkeftinek teknîkî wêdetir e; ew aliyek girîng a pêşkeftina modela LLM-ê ye ku di karên cihêreng de destûr dide serîlêdanek taybetî û safîkirî. Rêzkirin modelên pêş-perwerdekirî eyar dike da ku çêtir li gorî danehevên taybetî, performansa wan di karên taybetî de zêde bike û serîlêdanek bêtir armancdar peyda bike. Ew şiyana berbiçav a LLM-an derdixe holê ku li gorî daneyên nû biguncîne, nermbûnek ku di berjewendiya her ku diçe di serîlêdanên AI-ê de girîng e nîşan dide.

Birêkûpêkkirina modelên zimanên mezin gelek derfetan vedike, rê dide wan ku di peywirên taybetî de ji analîza hestê bigire heya nirxandinên edebiyata bijîjkî bi pêş ve bibin. Bi guheztina modela bingehîn li dozek karanîna taybetî, em îmkanên nû vedikin, karîgerî û rastbûna modelê zêde dikin. Digel vê yekê, ew karanîna aborîtir a çavkaniyên pergalê hêsan dike, ji ber ku birêkûpêkkirin li gorî perwerdekirina modelek ji sifirê kêmtir hêza hesabkerî hewce dike.

Gava ku em kûrtir diçin nav vê rêbernameyê, em ê li ser tevliheviyên LLM-ahenga baş-ahengê nîqaş bikin, ku li ser bingeha pêşkeftinên herî paşîn û pratîkên çêtirîn ên li qadê ye, nêrînek berfereh bide we.

Fine-Tuning-based Instruction

Qonaxa birêkûpêkkirina li Generative AI çerxa jiyanê, ku di jimareya jêrîn de hatî xuyang kirin, bi tevhevkirina têketin û derketinên talîmatê, bi mînakên ramana gav-bi-gav re tê destnîşan kirin. Ev nêzîkatî di afirandina bersivên ku ne tenê têkildar in, lê di heman demê de bi rêwerzên taybetî yên ku di nav wê de têne peyda kirin re jî rast in, modelê hêsan dike. Di vê qonaxê de ye ku modelên pêş-perwerdekirî têne adaptekirin da ku karên cihêreng çareser bikin û dozên bikar bînin, danûstendinên kesane bikar bînin da ku fonksiyona xwe zêde bikin.

Yek-Task Fine-Tuning

Rêzkirina yek-peywirê balê dikişîne ser xurtkirina pisporiya modelê di karekî taybetî de, wek kurtkirin. Ev nêzîkatî bi taybetî di xweşbînkirina karûbarên ku bi belgeyên girîng an mijarên danûstendinê ve girêdayî ne, tevî belgeyên qanûnî û bilêtên piştevaniya xerîdar, sûdmend e. Hêjayî gotinê ye, ev başbûn dikare bi komek nimûneyên piçûktir, ku ji 500 heya 1000-an pêk tê, pêşkeftinên performansê yên girîng bi dest bixe, berevajî bi mîlyaran nîşaneyên ku di qonaxa pêş-perwerdeyê de têne bikar anîn.

Bingehên LLM Fine-Tuning LLM: Architecture Transformer and Beyond

Rêwîtiya têgihîştina birêkûpêkkirina LLM bi têgihîştina hêmanên bingehîn ên ku LLM-an pêk tînin dest pê dike. Di dilê van modelan de heye mîmarî transformer, torgilokek neuralî ya ku mekanîzmayên xwe-baldariyê bi kar tîne da ku di hevokê de çarçoweya peyvan li ser nêzîkbûna wan bide pêş. Vê nêzîkatiya nûjen têgihiştinek kûr a têkiliyên dûr ên di navbera nîşankeran de di têketinê de hêsantir dike.

Gava ku em di nav tevliheviyên veguherîneran de digerin, em bi pêvajoyek pir-gavekî ya ku bi şîfrekerê dest pê dike re rû bi rû dimînin. Ev qonaxa destpêkê bi tokenîzekirina têketinê û afirandina vektorên pêvekirî yên ku têketinê û pozîsyona wê di hevokê de temsîl dikin pêk tîne. Qonaxên paşerojê rêzek hesabên ku bi karanîna matrices têne zanîn vedihewîne Pirs, Giranî, û Qûfle, bi xalek xwe-baldariyê ku balê li ser beşên cihêreng ên hevokê û nîşaneyên cihêreng ferz dike, diqede.

Rêzkirin wekî qonaxek krîtîk di pêşkeftina LLM-an de radiweste, pêvajoyek ku tê de çêkirina verastkirinên nazik pêk tîne da ku bigihîje encamên bêtir xwestek. Ev qonax, her çend pêdivî ye, komek dijwariyan pêşkêşî dike, di nav de daxwazên hesabkerî û hilanînê yên birêvebirina hejmareke mezin a parametreyan. Parametreya Birêkûpêk Fine-Tuning (PEFT) teknîkan pêşkêşî dike ku jimara parametreyên ku werin başkirin kêm bikin, bi vî rengî pêvajoya perwerdehiyê hêsan dike.

LLM Pre-Training: Avakirina Bingehek Bihêz

Di qonaxên destpêkê yên pêşkeftina LLM de, perwerdehiya pêşîn qonaxa navendî digire, wekî mîmariya bingehîn veguherînerên zêde-parametrekirî bikar tîne. Ev pêvajo di nav xwe de modelkirina zimanê xwezayî bi awayên cihêreng ên wekî dualî, otoregresîv, an rêz-bi-rûzê li ser korporên neçapkirî yên mezin. Armanc li vir ew e ku bi danasîna armancên peywirê ve bingehek were afirandin ku paşê ji bo karên taybetî yên jêrîn were sererast kirin.

Di vî warî de meylek balkêş, zêdebûna neçarî ya pîvana LLM-yên pêş-perwerdekirî ye, ku ji hêla hejmara parametreyan ve tê pîvandin. Daneyên ampîrîkî bi domdarî destnîşan dikin ku modelên mezin ên ku bi daneya bêtir re têkildar in hema hema her gav performansa çêtir peyda dikin. Mînakî, GPT-3, bi 175 mîlyar parametreyên xwe ve, di hilberîna zimanek xwezayî ya bi kalîte de pîvanek destnîşan kiriye û rêzek berfireh a peywirên zero-shot bi jêhatî pêk tîne.

Fine-Tuning: Rêya Adaptasyona Modelê

Li dû perwerdehiya pêş-perwerdeyê, LLM ji bo ku bi karên taybetî re biguncîne derbas dibe. Tevî performansa sozdar a ku ji hêla fêrbûna hundurîn ve di LLM-yên pêş-perwerdekirî yên wekî GPT-3 de tê xuyang kirin, lêkûpêk di mîhengên peywir-taybet de çêtir dimîne. Lêbelê, nêzîkatiya serdest a birêkûpêkkirina tevahî ya parameterê, di nav de daxwazên bilind ên hesabkerî û bîranînê, bi taybetî dema ku bi modelên mezin re mijûl dibin, pirsgirêkan peyda dike.

Ji bo modelên zimanên mezin ên bi zêdetirî mîlyar parametran, rêveberiya bikêrhatî ya GPU RAM-ê girîng e. Parametreyek modela yekane bi rastbûna tam 32-bit pêdivî bi 4 byte cîhê hewce dike, ku tê wergerandin hewcedariya 4 GB GPU RAM tenê ji bo barkirina modelek 1 mîlyar parametre. Pêvajoya perwerdehiyê ya rastîn hîn bêtir bîranînê hewce dike ku hêmanên cihêreng, di nav de dewletên optîmîzeker û gradient, bicîh bîne, ji bo modelek bi vê pîvanê potansiyel hewcedariya 80 GB RAM GPU heye.

Ji bo rêvegirtina sînorên GPU RAM-ê, quantîzasyon tê bikar anîn ku teknîkek e ku rastbûna pîvanên modelê kêm dike, bi vî rengî hewcedariyên bîranînê kêm dike. Mînakî, guheztina rastbûna ji 32-bit bo 16-bit dikare bîranîna ku hem ji bo barkirin û hem jî ji bo perwerdekirina modelê hewce dike nîvî kêm bike. Piştre di vê gotarê de. em ê li ser Qlora fêr bibin ku têgeha quantîzasyonê ji bo ahengkirinê bikar tîne.

Vekolîna Kategoriyên Rêbazên PEFT

Di pêvajoya bi tevahî rastkirina Modelên Zimanên Mezin de, girîng e ku meriv sazûmanek hesabker hebe ku ne tenê giraniya modelê ya girîng, ku ji bo modelên herî pêşkeftî naha digihîje bi sedan gigabaytan, bi bandor bi rê ve bibe, lê di heman demê de jî rêve bibe. rêze hêmanên din ên krîtîk. Di nav wan de veqetandina bîranînê ji bo dewletên xweşbînker, birêvebirina gradientan, aktîvkirina pêşde, û hêsankirina bîranîna demkî di qonaxên cihêreng ên prosedûra perwerdehiyê de vedihewîne.

Rêbaza Zêdekirinê

Bi vî rengî birêkûpêk dikare modela pêş-perwerdekirî bi parametre an qatên pêvek zêde bike, û balê bikişîne ser perwerdehiyê tenê pîvanên ku nû hatine zêdekirin. Tevî zêdekirina hejmartina parameteran, van rêbazan kargêriya dem û cîhê perwerdehiyê zêde dikin. Rêbaza lêzêdekirinê bêtir li jêr-kategoriyan tê dabeş kirin:

- Adapters: Tevlîhevkirina torên piçûk ên bi tevahî ve girêdayî piştî jêr-qatên veguherîner, digel mînakên berbiçav AdaMix, KronA, û Compactor.

- Soft Prompts: Bi daketina gradientê ve, perçeyek ji ketina modelê ya binavkirî bi IPT, pêşgir-tuning, û WARP mînakên berbiçav in.

- Din Nêzîktêdayînên Additive: Teknîkên mîna LeTS, AttentionFusion, û Ladder-Side Tuning bi nav bikin.

Rêbaza Hilbijartî

PEFTên bijartî hejmarek tixûbdar a qatên jorîn li ser bingeha celebê qat û strukturên modela hundurîn baş rast dikin. Di vê kategoriyê de rêbazên mîna BitFit û LN tuning, ku balê dikişîne ser birêkûpêkkirina hêmanên taybetî yên wekî pêşbaziyên modelê an rêzikên taybetî.

Rêbaza-based Reparametrization

Van rêbazan temsîlên nizm bikar tînin da ku hejmara parametreyên perwerdekirî kêm bikin, ku ya herî navdar Adaptasyona Low-Rank an LoRA ye. Vê rêbazê veqetandina matrixê-raza nizm a hêsan bikar tîne da ku nûvekirina giraniyê parameterîze bike, di binecihên rêza nizm de birêkûpêkkirina bi bandor nîşan dide.

1) LoRA (Adaptasyona Kêm-Rank)

LoRA wekî teknolojiyek PEFT-ya bingehîn derket holê, ku di kaxezek de hatî destnîşan kirin Edward J. Hu û yên din di sala 2021 de. Ew di nav kategoriya reparameterîzasyonê de tevdigere, giraniyên orîjînal ên LLM-ê dicemidîne û matricên nû yên rahênanê yên nizm di her qatek mîmariya Transformer de yek dike. Ev nêzîkatî ne tenê hejmara parametreyên perwerdekirî kêm dike, lê di heman demê de dema perwerdehiyê û çavkaniyên jimartinê yên hewce jî kêm dike, bi vî rengî alternatîfek bikêrhatî ji birêkûpêkkirina bêkêmasî re pêşkêş dike.

Ji bo têgihîştina mekanîka LoRA, pêdivî ye ku meriv mîmariya veguherîner ji nû ve bigere ku li wir bileziya têketinê di bin tokenîzekirin û veguheztina vektorên binavkirî de derbas dibe. Van vektoran di nav beşên şîfreker û/an dekoder ên transformatorê re derbas dibin, rûbirûyê torên xwe-balkêşî û pêşdebirinê yên ku giraniya wan ji berê ve hatine perwerde kirin.

LoRA têgeha bikar tîne Veqetandina Nirxa Yekjimar (SVD). Di bingeh de, SVD matrixekê di sê matricên cihêreng de vediqetîne, ku yek ji wan matrixek diagonal e ku nirxên yekane bicîh dike. Van nirxên yekjimar girîng in ji ber ku ew girîngiya pîvanên cihêreng di matrican de dinirxînin, digel ku nirxên mezin girîngiya bilindtir û yên piçûktir girîngiya hindik destnîşan dikin.

Ev nêzîkatî destûrê dide LoRA ku taybetmendiyên bingehîn ên daneyê bidomîne û di heman demê de pîvanê kêm bike, ji ber vê yekê pêvajoyek baş-ahengkirinê xweşbîn dike.

LoRA di vê pêvajoyê de destwerdanê dike, hemî pîvanên modela orîjînal dicemidîne û li kêleka giraniyên orîjînal cotek "matrîsên hilweşandina rêzê" destnîşan dike. Van matricên piçûktir, ku wekî A û B têne destnîşan kirin, bi fêrbûna çavdêrîkirî perwerde dibin.

Di vê stratejiyê de hêmana bingehîn pîvana ku jê re rêzik ('r') tê gotin e, ku mezinahiya matricên rêza nizm diyar dike. Hilbijartinek hûrbîn a 'r' dikare encamên balkêş derxe, tewra bi nirxek piçûktir, bi vî rengî matrixek nizm bi kêm pîvanên perwerdehiyê biafirîne. Ev stratejî bi karanîna pirtûkxaneyên çavkaniya vekirî yên wekî HuggingFace Transformers bi bandor hatî sepandin, ji bo karên cûrbecûr bi karîgeriyek berbiçav vesazkirina LoRA-yê hêsan dike.

2) QLoRA: Berbiçavbûna LoRA Bilindtir Bikin

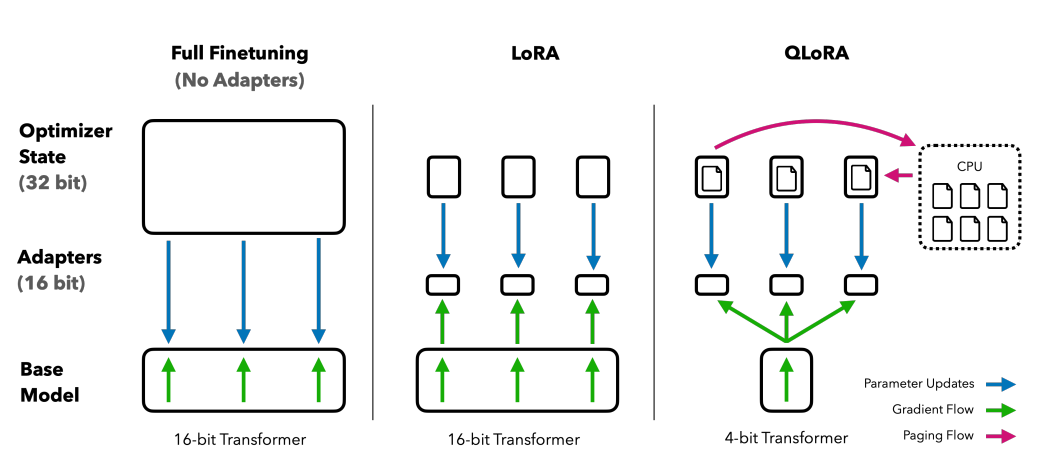

Li ser bingeha ku ji hêla LoRA ve hatî danîn ava kirin, QLoRA bêtir hewcedariyên bîranînê kêm dike. Ji hêla Tim Dettmers û yên din di sala 2023 de, ew adaptasyona nizm bi quantîzasyonê re dike yek, forma quantîzasyonê ya 4-bit bi kar tîne. NormalFloat or nf4. Quantîzasyon bi bingehîn pêvajoyek e ku daneyan ji nûnertiyek agahdarî ya bilindtir vediguhezîne ya ku agahdariya kêm heye. Ev nêzîkatî bandorkeriya rêbazên 16-bit rêzkirina hûrgelê diparêze, giraniya 4-bit ji 16-bitan re wekî ku di pêvajoyên hesabkirinê de hewce dike kêm dike.

Berawirdkirina rêbazên başkirinê: QLORA LoRA bi quantîzasyona rasteqîn a 4-bit û optimîzatorên rûpelkirî ji bo rêveberiya lûtkeya bîranînê zêde dike.

QLoRA NumericFloat4 (nf4) dixebitîne, di mîmariya transformatorê de her qatek armanc dike, û têgeha quantîzasyona ducarî destnîşan dike da ku şopa bîranînê ya ku ji bo lêkûpêkkirinê hewce dike piçûktir bike. Ev bi pêkanîna quantîzasyonê li ser domdarên jixwe quantîzekirî, stratejiyek ku bi karanîna optimîzatorên rûpelkirî û rêveberiya bîranînê ya yekbûyî ve ji çîpên bîranîna xala kontrolê ya gradient a tîpîk dûr dixe, tê bidestxistin.

guanaco, ku komikek ahengkirî ya QLORA ye, di çareseriyên chatbot-a çavkaniya vekirî de pîvanek destnîşan dike. Performansa wê, bi nirxandinên mirovî û otomatîkî yên sîstematîk ve hatî pejirandin, serdestî û karîgeriya wê ya li qadê destnîşan dike.

Guhertoyên 65B û 33B yên Guanaco, ku bi karanîna guhertoyek guhezbar a guhertoya baş-ahengkirî ye. OASST1 databas, ji modelên navdar ên mîna hevrikên dijwar derdikevin GPT chat û tewra GPT-4.

Bikaranîna Fêrbûna Hêzdarkirinê ya Ji Bersiva Mirovan ve bi rêk û pêk

Hêzdarkirin Fêrbûna Ji Bersivdana Mirovî (RLHF) dema ku modelên zimanên pêş-perwerdekirî baş bi rê ve dibin da ku bi nirxên mirovî re ji nêz ve biguncin. Ev têgeh ji hêla Open AI-ê ve di sala 2017-an de hate destnîşan kirin û bingehek ji bo kurtkirina belgeyên pêşkeftî û pêşkeftina InstructGPT.

Di bingeha RLHF de paradîgmaya fêrbûna xurtkirinê ye, celebek teknîka fêrbûna makîneyê ku tê de casus fêr dibe ku meriv çawa tevbigere dor bi kirina çalakiyên û wergirtin xelat. Ew pêvekek domdar e çalakî û Deng, cihê ku ajan tê teşwîq kirin ku hilbijartinên ku dê xelata herî bilind bide.

Wergerandina vê ji bo warê modelên ziman, ya casus e ji model xwe, di nava xwe de kar dike dor ji pencereyek çarçoveyek diyarkirî û li ser bingeha girtina biryaran rewş, ku ji hêla nîşaneyên heyî yên di pencereya çarçoveyê de tête diyar kirin. The "qada çalakiyê"hemû nîşaneyên potansiyel ên ku model dikare ji wan hilbijêre digire nav xwe, bi mebesta ku ew tokena ku herî nêzîk bi tercîhên mirovan re têkildar e hilbijêrin.

Pêvajoya RLHF bi berfirehî bertekên mirovî bi kar tîne, ji bo perwerdekirina modelek xelatê bikar tîne. Ev model di rêvekirina modela pêş-perwerdekirî de di dema pêvajoyek birêkûpêk de rolek girîng dilîze, ew teşwîq dike ku hilberên ku bêtir bi nirxên mirovî re têkildar in biafirîne. Ew pêvajoyek dînamîk û dubarekirî ye, ku model bi rêzek "derxistinan" fêr dibe, têgehek ku ji bo danasîna rêza rewş û kiryaran ku di çarçoweya nifşkirina ziman de berbi xelatekê ve tê bikar anîn.

Yek ji potansiyelên balkêş ên RLHF ev e ku jêhatîbûna wê ye ku di arîkarên AI-ê de kesanebûnê xurt bike, ku wan bi tercihên bikarhêneran ve girêbide, çi be ew hestiyariya wan an rûtînên rojane be. Ew rêyên afirandina pergalên AI-yê yên ku ne tenê ji hêla teknîkî ve jêhatî ne lê di heman demê de ji hêla hestyarî ve jî jîr in, vedike, ku dikarin di pêwendiya mirovî de hûrgelên fêm bikin û bersivê bidin.

Lêbelê, pêdivî ye ku meriv bala xwe bide ku RLHF ne çareseriyek bêaqil e. Model hîn jî ji bo hilberîna encamên nexwestî, ronîkirina daneyên berfireh û bi gelemperî nerêkûpêk û alîgir ên ku ew li ser têne perwerde kirin hesas in.

Xelasî

Pêvajoya birêkûpêkkirinê, gavek krîtîk di karanîna potansiyela tam a LLM-ên wekî Alpaca, Falcon, û GPT-4 de, safîtir û baldartir bûye, û ji cûrbecûr peywiran re çareseriyên guncan pêşkêşî dike.

Me rêkûpêkkirina yek-peywirê, ku di modelan de bi rolên taybetî de pispor e, û rêbazên Parametre-Efficient Fine-Tuning (PEFT) di nav de LoRA û QLoRA dît, ku armanc ew e ku pêvajoya perwerdehiyê bikêrtir û bihatir bikin. Van pêşkeftinan derî ji fonksiyonên AI-a-asta bilind re ji temaşevanek berfireh re vedikin.

Digel vê yekê, danasîna Fêrbûna Hêzdar Ji Bersiva Mirovan (RLHF) ji hêla AI-ya vekirî ve gavek e ber bi afirandina pergalên AI-yê ku bi nirx û tercîhên mirovî re ji nêz ve têdigihîjin û li hev dikin, qonaxê ji bo arîkarên AI-yê yên ku ne tenê jîr in lê di heman demê de jî hesas in. hewcedariyên bikarhênerek kesane. Hem RLHF û hem jî PEFT bi hevrêziyê dixebitin da ku fonksiyon û karîgeriya Modelên Zimanên Mezin zêde bikin.

Gava ku karsazî, pargîdanî, û kesan dinêrin ku van LLM-yên xweş-sazkirî di nav karûbarên xwe de yek bikin, ew bi bingehîn pêşwaziya pêşerojek dikin ku AI ji amûrek wêdetir e; ew hevalbendek e ku têgihîştin û li gorî şert û mercên mirovî diguncîne, çareseriyên nûjen û kesane pêşkêşî dike.