Artificial Intelligence

MINT-1T: オープンソースのマルチモーダルデータを10倍に拡大

最先端の大規模マルチモーダルモデル (LMM) のトレーニングには、自由形式の画像とテキストのインターリーブシーケンスを含む大規模なデータセットが必要です。オープンソースの LMM は急速に進化していますが、オープンソースの大規模なマルチモーダルインターリーブデータセットは依然として大きく不足しています。これらのデータセットは、さまざまなモダリティにわたってコンテンツを理解および生成できる高度な AI システムを作成するための基盤となるため、その重要性はいくら強調してもし過ぎることはありません。包括的なインターリーブデータセットが十分に供給されなければ、より高度で高性能な LMM を開発する可能性は大幅に損なわれます。これらのデータセットにより、モデルは多様な入力から学習できるようになり、さまざまなアプリケーションでより汎用的で効果的になります。さらに、このようなデータセットの不足は、イノベーションとコラボレーションを推進するために共有リソースに依存しているオープンソースコミュニティにとって課題となります。

オープンソースの LMM は近年大きな進歩を遂げていますが、大規模なインターリーブ データセットの可用性が限られているため、その成長は妨げられています。この障害を克服するには、マルチモーダル モデルの継続的な開発と改良をサポートできる、より包括的なデータセットをキュレート、注釈付け、リリースするための協調的な取り組みが必要です。さらに、これらのデータセットの作成と配布には、いくつかの技術的およびロジスティックなハードルを克服する必要があります。データ収集は広範囲で、LMM が展開されるさまざまなコンテキストを代表するものでなければなりません。注釈付けでは、インターリーブされた画像とテキストのシーケンスがモデルの学習機能を強化する方法で整列していることを慎重に検討する必要があります。さらに、データセットがオープンソースであることを保証するには、データのプライバシーと使用権に関連する法的および倫理的考慮事項に対処する必要があります。高品質で大規模なマルチモーダル インターリーブ データセットの可用性を拡大することは、AI 研究開発の将来にとって不可欠です。現在の不足に対処することで、AI コミュニティはより大きなイノベーションとコラボレーションを促進し、複雑で現実世界の問題に取り組むことができる、より強力で多用途な LMM の作成につながります。

これを踏まえて、これまでで最大かつ最も多様なマルチモーダルインターリーブオープンソースデータセットであるMINT-1Tが構築されました。MINT-1T: 既存のオープンソースデータセットの10倍の規模で、3.4兆のテキストトークンと1億の画像が含まれています。MINT-1Tデータセットには、PDFファイル、ArXiv論文など、これまで公開されたことのないソースも導入されています。マルチモーダルインターリーブデータセットは簡単には拡張できないため、MINT-1Tデータセットでデータキュレーションプロセスを共有し、他の人もこのような情報豊富なバリアントで実験できるようにすることが重要です。MINT-1Tデータセットは、その方法、つまりMINT-XNUMXTでトレーニングされたLMモデルが、以前の最先端のOBELICSと(多少ではありますが)競争力があることを示しています。

MINT-1T: XNUMX兆トークンのマルチモーダルデータセット

大規模なオープンソースの事前トレーニングデータセットは、データエンジニアリングの探求と透明性のあるオープンソースモデルのトレーニングにおいて、研究コミュニティにとって極めて重要な役割を果たしてきました。テキスト領域では、C4やThe Pileなどの初期の研究が、コミュニティがGPT-J、GPT-Neoなどのオープンソースの大規模言語モデルの最初のセットをトレーニングできるようにする上で重要な役割を果たしました。これらの基礎的な取り組みは、その後のデータフィルタリング方法とスケーリングの改善にも道を開きました。同様に、画像テキスト空間では、大規模なオープンソースデータセットが、データフィルタリングネットワークやT-MARSなどのより優れたデータキュレーション方法の革新を促進しました。最先端の研究室からトレーニングへのシフトが顕著になっています。 大規模マルチモーダル モデル (LMM) これには、画像とテキストの自由形式のシーケンスで構成される広範なマルチモーダルインターリーブデータセットが必要です。最先端のモデルの機能が急速に進歩するにつれて、クローズドソースモデルとオープンソースモデル間のマルチモーダルトレーニングデータに大きなギャップが生じています。現在のオープンソースのマルチモーダルインターリーブデータセットは、主に HTML ドキュメントから取得されているため、テキストのみのデータセットよりも小さく、多様性に欠けており、データの幅と多様性が制限されています。この制限により、堅牢なオープンソース LMM の開発が妨げられ、オープンソースモデルとクローズドソースモデルの機能に格差が生じています。

このギャップを埋めるために、これまでで最大かつ最も多様なオープンソースのマルチモーダルインターリーブデータセットとして MINT-1T が作成されました。MINT-1T には、HTML、PDF、ArXiv などのさまざまなソースから取得した合計 1 兆個のテキストトークンと 115 億個の画像が含まれています。MINT-353T 以前、この分野で最大のオープンソースデータセットは OBELICS で、すべて HTML から取得した XNUMX 億個のテキストトークンと XNUMX 億 XNUMX 万個の画像が含まれていました。

MINT-1Tの貢献は次のとおりです。

- データエンジニアリング: このマルチモーダルインターリーブデータのスケーリングは、テキストのみのデータセットや画像とテキストのペアのデータセットを構築するよりも、エンジニアリング上の課題が多くなります。はるかに大きなドキュメント サイズを処理し、画像とテキストの元の順序を維持することが重要です。

- 多様性: MINT-1T は、CommonCrawl PDF や ArXiv などのソースから高品質のマルチモーダル ドキュメントを大規模に収集する、マルチモーダル インターリーブ スペース初の製品です。

- モデル実験: 実験では、MINT-1T でトレーニングされた LMM は、既存の最高のオープンソース データセットである OBELICS でトレーニングされたモデルのパフォーマンスに匹敵するだけでなく、潜在的にそれを上回る可能性があり、スケールも XNUMX 倍に増加することが示されています。

MINT-1T: データセットの構築

MINT-1T は、PDF や ArXiv 論文など、より多様なインターリーブ ドキュメント ソースを利用する大規模なオープン ソース データセットをキュレートします。このセクションでは、マルチモーダル ドキュメントのソーシング、低品質コンテンツのフィルタリング、データの重複排除、職場や NSFW に適さないコンテンツや望ましくないコンテンツの削除を行う MINT-1T の方法について詳しく説明します。最終的なデータセットは、922 億 (B) の HTML トークン、106 億の PDF トークン、および 9 億の ArXiv トークンで構成されます。

大量のマルチモーダル文書の調達

HTML パイプライン

MINT-1T は、各 WARC エントリの DOM ツリーを解析することにより、CommonCrawl WARC ファイルからインターリーブされたマルチモーダル ドキュメントを抽出する OBELICS の方法に従います。OBELICS は 2020 年 2023 月から 1 年 2017 月までの CommonCrawl ダンプのドキュメントのみを処理しましたが、MINT-2024T はドキュメント プールを拡張して、2018 年 2024 月から 1 年 XNUMX 月までの HTML ドキュメント (XNUMX 年 XNUMX 月から XNUMX 年 XNUMX 月までの完全なダンプとそれ以前の部分的なダンプを含む) を含めました。OBELICS と同様に、MINT-XNUMXT は、画像がまったく含まれていないドキュメント、XNUMX を超える画像、またはロゴ、アバター、ポルノ、xxx などの不適切な部分文字列を含む URL を持つ画像を含むドキュメントを除外します。

PDFパイプライン

MINT-1T は、2023 年 2024 月から 1 年 50 月までのダンプの CommonCrawl WAT ファイルから PDF ドキュメントを取得します。最初に、すべての PDF リンクがこれらのダンプから抽出されます。次に、MINT-50T は PyMuPDF を使用して PDF をダウンロードして読み取ろうとし、XNUMX MB を超える PDF (大きな画像が含まれている可能性が高い) と XNUMX ページを超える PDF を破棄します。テキストのないページは除外され、残りのページの読み取り順序が確立されます。読み取り順序は、ページ上のすべてのテキスト ブロックの境界ボックスを見つけ、列に基づいてブロックをクラスター化し、左上から右下に順序付けすることによって決定されます。画像は、同じページ上のテキスト ブロックへの近さに基づいてシーケンスに統合されます。

ArXivパイプライン

MINT-1T は、TexSoup を使用して LaTeX ソース コードから ArXiv インターリーブ ドキュメントを構築し、図のタグを検索して画像を論文本文にインターリーブします。複数ファイルの論文の場合、MINT-1T はメインの Tex ファイルを識別し、入力タグをそのファイルの内容に置き換えます。LaTeX コードは、インポート、参考文献、表、引用タグを削除してクリーンアップされます。ArXiv はすでに高度にキュレーションされたデータ ソースであるため、追加のフィルタリングや重複排除は実行されません。

テキスト品質フィルタリング

MINT-1T は、RefinedWeb、Dolma、FineWeb によって確立された手法に従い、テキスト フィルタリングにモデルベースのヒューリスティックを使用しないようにしています。最初に、Fasttext の言語識別モデル (信頼しきい値 0.65) を使用して、英語以外の文書が排除されます。ポルノや望ましくないコンテンツを除外するため、URL に NSFW サブストリングを含む文書も削除されます。RefinedWeb のテキスト フィルタリング方法が適用され、特に、重複する n-gram が多すぎる文書や、MassiveText ルールを使用して低品質と識別された文書が削除されます。

画像フィルタリング

PDF および HTML ファイルをキュレートした後、MINT-1T は HTML データセット内のすべての画像 URL をダウンロードし、取得できないリンクを破棄し、有効な画像リンクのないドキュメントを削除します。150 ピクセル未満の画像は、ロゴやアイコンなどのノイズの多い画像を避けるために破棄され、20,000 ピクセルを超える画像も、通常はトピック外の画像に対応するため削除されます。HTML ドキュメントの場合、アスペクト比が XNUMX を超える画像は、広告バナーなどの低品質の画像を除外するために削除されます。PDF の場合、科学的な図や表を保持するためにしきい値は XNUMX に調整されます。

上の図は、MINT-1T が HTML ソース以外に PDF や ArXiv ドキュメントからのデータを独自に含める方法を示しています。

安全フィルタリング

- NSFW 画像フィルタリング: MINT-1T は、データセット内のすべての画像に NSFW 画像検出器を適用します。ドキュメントに NSFW 画像が XNUMX つでも含まれている場合は、ドキュメント全体が破棄されます。

- 個人情報の削除:個人情報漏洩のリスクを軽減するため、テキストデータ内のメールアドレスとIPアドレスは匿名化されています。メールは「[メール保護]” とランダムに生成された機能しない IP を含む IP です。

重複排除

MINT-1T は、各 CommonCrawl スナップショット内で段落とドキュメントのテキストの重複排除を実行し、イメージの重複排除を行って、アイコンやロゴなどの繰り返しの、情報価値のないイメージを削除します。すべての重複排除手順は、データ ソースごとに個別に実行されます。

段落と文書の重複排除

Dolma の方法論に従い、MINT-1T はブルーム フィルターを使用してテキストの重複を効率的に排除し、誤検出率を 0.01 に設定して、各ドキュメントから 13 グラムの段落 (二重の改行区切りで示される) の重複を排除します。ドキュメントの段落の 80% 以上が重複している場合、ドキュメント全体が破棄されます。

一般的な定型文の削除

段落の重複除去後、MINT-1T は HTML ドキュメント内の「コンテンツへスキップ」や「ブログ アーカイブ」などの短い一般的な定型文を削除します。これは、CCNet の慣行に従って、各 CommonCrawl スナップショットの 2% に対して正確な段落の重複除去を実行することで行われ、一般的な定型文のほとんどが確実に削除されます。

上の図は、MINT-1T のフィルタリング プロセスを示しており、HTML、PDF、ArXiv 論文のデータ パイプライン全体でトークンがどのように削除されるかを示しています。

イメージ重複除去

各 CommonCrawl スナップショット内で、MINT-1T は SHA256 ハッシュに基づいて頻繁に出現する画像を削除します。厳密な重複排除ではなく、Multimodal-C4 プラクティスに従って、スナップショット内で XNUMX 回以上出現する画像のみが削除されます。OBELICS と同様に、単一ドキュメント内で繰り返し出現する画像は削除され、最初の出現のみが保持されます。

インフラ

データ処理全体を通じて、MINT-1T は 2,350 プロセッサ ノードと 190 プロセッサ ノードの組み合わせから平均 90 個の CPU コアにアクセスしました。合計で、このデータセットの構築には約 4.2 万 CPU 時間が使用されました。

MINT-1TとOBELICSの文書構成の比較

インターリーブされたデータセットの構成を評価する際には、文書あたりのテキスト トークンの分布と文書あたりの画像数という 50,000 つの重要な特性が調べられます。この分析では、OBELICS と MINT-1T の各データ ソースの両方から XNUMX 件の文書がランダムにサンプリングされました。 GPT-2 テキスト トークンの数を計算するためにトークナイザーが使用されました。テキスト トークンと画像の数の 1.5 四分位範囲外にあるドキュメントを除外することで、外れ値が除去されました。次の図に示すように、MINT-1T の HTML サブセットは、OBELICS で見られるトークン分布とほぼ一致しています。ただし、PDF と ArXiv から取得されたドキュメントは、平均して HTML ドキュメントよりも長くなる傾向があり、さまざまなソースからデータを取得する利点が強調されています。図 5 は、すべてのドキュメントの画像密度を調べており、PDF と ArXiv ドキュメントには HTML ドキュメントと比較して多くの画像が含まれており、ArXiv サンプルが最も画像密度が高いことを示しています。

さまざまなデータ ソースによってドキュメントの多様性はどのように向上するのでしょうか?

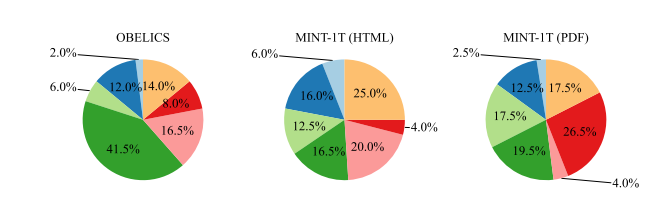

HTML を超えてマルチモーダル ドキュメントのプールを拡大する重要な動機は、ドメイン カバレッジの向上です。このカバレッジの多様性と深さを定量化するために、潜在的ディリクレ配分 (LDA) モデルを、OBELICS データセット、MINT-100,000T の HTML サブセット、および MINT-1T の PDF サブセット (ArXiv を除く) からサンプリングされた 1 のドキュメントでトレーニングし、200 のトピックを取得しました。次に、GPT-4 を使用して単語セットを分類し、MMMU ドメインに基づいて、健康と医学、科学、ビジネス、人文科学、歴史などの主要なドメインを特定しました。分析により、ドメイン分布の明確な傾向が明らかになりました。

- オベリック: このデータセットは、「人文科学と社会科学」に顕著に集中していることがわかります。これは、Wikipedia の記事に似ていない文書を除外するデータ構築プロセスに起因する可能性があり、その結果、より一般的な知識と人文科学に重点を置いたコンテンツへの分布が変更される可能性があります。

- MINT-1T の HTML サブセット: OBELICS とは対照的に、MINT-1T の HTML サブセットは特定のドメインに強く偏っておらず、より幅広くバランスの取れたドメイン表現を示唆しています。

- MINT-1T の PDF サブセット: MINT-1T の PDF ドキュメントには、「科学技術」ドキュメントの割合が高くなっています。この傾向は、詳細な研究論文や技術レポートを共有するには PDF が好まれるという科学的コミュニケーションの性質によるものと考えられます。

MINT-1T: 結果と実験

すべての実験において、MINT-1T は 50% の画像テキストキャプションバッチと 50% のマルチモーダルインターリーブバッチでモデルをトレーニングします。各インターリーブドキュメントから最大 2048 個のマルチモーダルトークンがサンプリングされ、各画像テキストサンプルから 340 個のトークンがサンプリングされます。Flamingo と同様に、隣接する画像テキストシーケンスの終了を示すために「終了」トークンが追加されます。トレーニング中、単一画像のインターリーブドキュメントの 50% がランダムにドロップされ、マルチ画像ドキュメントがアップサンプリングされます。画像テキストデータセットは、内部でキュレートされたキャプションデータセットの混合物で構成されています。マルチモーダルインターリーブシーケンスに関するモデルの推論能力は、コンテキスト内学習能力とマルチ画像推論パフォーマンスを通じて評価されます。

上の図は、OBELICS および MINT-1T のサブセットの MMMU における各ドメインのドキュメントの割合を示しています。

文脈に沿った学習: モデルは、さまざまなキャプション ベンチマーク (COCO (Karpathy テスト) および TextCaps (検証)) とビジュアル質問応答データセット (VQAv2 (検証)、OK-VQA (検証)、TextVQA (検証)、および VizWiz (検証)) での XNUMX ショットおよび XNUMX ショットのコンテキスト内学習パフォーマンスで評価されます。デモンストレーションはトレーニング セットからランダムにサンプリングされます。スコアは複数の評価実行で平均化され、ランダム化されたデモンストレーションは、選択されたプロンプトに対する感度を考慮に入れます。タスクごとに異なるプロンプトが除去され、最もパフォーマンスの高いものが選択されます。

マルチイメージ推論: モデルは、コンテキスト内学習評価を超えて複数画像推論能力を調べるために、MMMU (単一画像と複数画像の両方の質問を含む) と Mantis-Eval (すべて複数画像の質問) で評価されます。

HTMLドキュメントのトレーニング

まず、MINT-1T の HTML 部分が OBELICS と比較されます。これは、OBELICS が HTML ドキュメントからキュレーションされた、以前の主要なインターリーブ データセットであるためです。1 つのモデルが MINT-10T と OBELICS の HTML 部分でトレーニングされ、合計 4 億のマルチモーダル トークンが使用されました。コンテキスト内学習のパフォーマンスが評価されました。次の表は、一般的なベンチマークでの 8 ショットおよび 1 ショットのパフォーマンスを示しています。MINT-1T HTML ドキュメントでトレーニングされたモデルは、VQA タスクでは OBELICS よりも優れていますが、キャプション ベンチマークでは劣っています。平均すると、OBELICS のパフォーマンスは MINT-XNUMXT (HTML) よりもわずかに優れています。

PDF および ArXiv ドキュメントの追加

その後、HTML、PDF、ArXiv ドキュメントが混在する MINT-1T の完全なデータ ソースでトレーニングが行われます。インターリーブされたドキュメントは、HTML から 50%、PDF から 45%、ArXiv から 5% でサンプリングされます。モデルは合計 10 億のマルチモーダル トークンでトレーニングされます。上の表に示すように、完全な MINT-1T データ混合でトレーニングされたモデルは、ほとんどのコンテキスト内学習ベンチマークで OBELICS および MINT-1T (HTML) よりも優れています。より複雑なマルチモーダル推論ベンチマークでは、MINT-1T モデルは MMMU では OBELICS よりも優れていますが、Mantis-Eval ではパフォーマンスが低下します。

詳細な傾向

インコンテキスト学習のパフォーマンスはデモンストレーションによってどのように向上しますか?

コンテキスト内学習のパフォーマンスは、1 ~ 1 回のデモンストレーションでプロンプトが表示されたときに評価されます。各評価ベンチマークに対して、ショット数ごとに 1 回の試行が実行されます。次の図に示すように、MINT-XNUMXT でトレーニングされたモデルは、すべてのショットで MINT-XNUMXT の HTML サブセットと OBELICS でトレーニングされたモデルよりも優れています。MINT-XNUMXT (HTML) モデルのパフォーマンスは、OBELICS よりもわずかに劣っています。

字幕と視覚的質問応答タスクのパフォーマンス

次の図は、キャプション作成と視覚的質問応答 (VQA) ベンチマークにおけるコンテキスト内学習の平均パフォーマンスを示しています。OBELICS は、1 ショット キャプション作成ベンチマークではすべての MINT-1T バリアントより優れており、1 ショット キャプション作成では MINT-1T よりわずかに劣っています。ただし、MINT-XNUMXT は VQA ベンチマークでは両方のベースラインより大幅に優れています。MINT-XNUMXT (HTML) は、VQA タスクでも OBELICS より優れています。

さまざまなドメインでのパフォーマンス

MINT-1T に多様なドメインを含めるのは、モデルの一般化を向上させるためです。前の図は、各ドメインの MMMU のパフォーマンスを分類したものです。ビジネス ドメインを除き、MINT-1T は OBELICS および MINT-1T (HTML) よりも優れています。MINT-1T の科学およびテクノロジー ドメインのパフォーマンスが向上したのは、これらのドメインが ArXiv および PDF ドキュメントで広く使用されているためです。

最終的な考え

この記事では、これまでで最大かつ最も多様なマルチモーダルインターリーブオープンソースデータセットである MINT-1T について説明しました。MINT-1T: 既存のオープンソースデータセットの 10 倍の規模で、3.4 兆のテキストトークンと 1 億の画像が含まれています。MINT-1T データセットには、PDF ファイルや ArXiv 論文など、これまで公開されたことのないソースも含まれています。マルチモーダルインターリーブデータセットは簡単には拡張できないため、MINT-1T データセットでデータキュレーションプロセスを共有し、他の人もこのような情報豊富なバリアントで実験できるようにすることが重要です。MINT-1T データセットは、その方法、つまり MINT-XNUMXT でトレーニングされた LM モデルが、これまでの最先端の OBELICS と (多少ではありますが) 競合可能であることを示しています。