זווית אנדרסון

将视觉类比引入人工智能

当前的人工智能模型无法识别“关系”图像相似性,例如地球的层次与桃子相似,缺失了人类感知图像的一个关键方面。

尽管有许多ראיית מחשב模型能够比较图像并找到它们之间的相似性,但当前一代的比澃系统几想象力。考虑一下1960年代经典歌曲טחנות הרוח של תודעתך中的一些歌词:

像旋转木马在转动,绕着月亮转圈

像时钟的指针扫过表盘的分钟

而世界就像一个在太空中静静旋转的苹果

这种比较代表了一种诗意的暗示领域,对人类来说意义远超艺术表辮働相们如何发展感知系统密切相关;当我们创造我们的"对象"领域时,我䀕獺发视觉相似性能力,因此——例如——描绘桃子和地球的横截面,或如咖啡螺旋和星系分攽甽分分攽璢在我们看来是类比的.

通过这种方式,我们可以推断出表面上不相关的对象和对象类型之间的推断出系统(如重力、动量和表面粘合)可以适用于各种领域和各种尺度。

看见事物

即使是最新一代的图像比较AI系统,如学习感知图像补丁相似性(LPIPS)עםדינו,这些系统通过人类反馈获得信息,也仅进行字面上的表面比较。

它们的能力在不存在面孔的地方找到面孔——即空想性错觉——并不代表人类发展出的那种视觉相似性机制,而是因为寻找面孔的算法利用低级面部结构תכונה,这些特征有时与随机对象一致:

'פנים עם דברים'数据集中面部识别的误报示例. 来源

为了确定机器是否真的可以发展我们的想象力来跨领域识别视觉相似性,美国的研究人员进行了מחקר,围绕关系视觉相似性,策划并训练了一个新数据集,旨在迫使不同对象之间形成抽象关系,这些对象尽管如此仍由抽象关系连接:

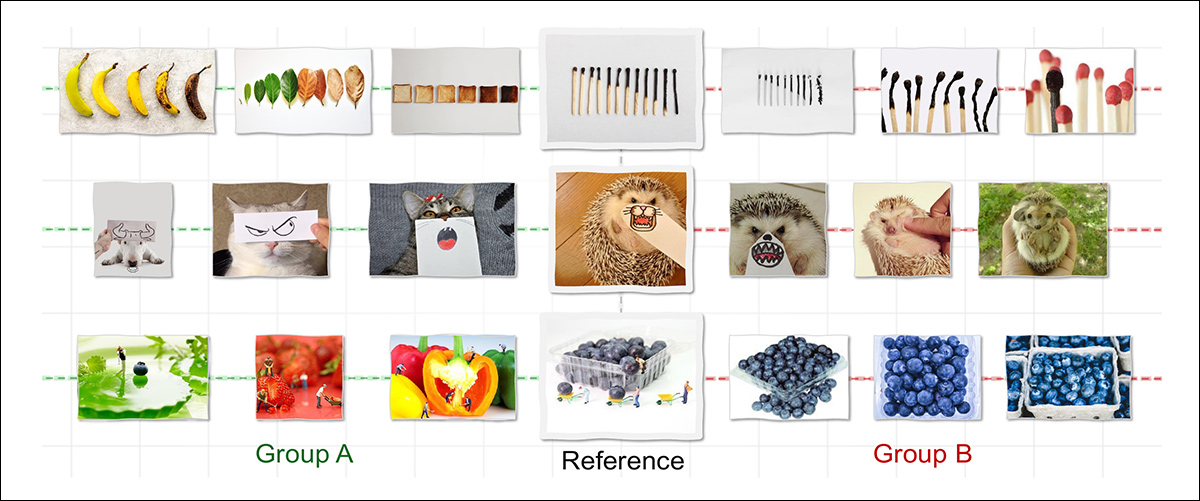

大多数AI模型仅在图像共享形状或颜色等表面特征时识别相似性,这庱是什么它们仅将上面的B组链接到参考。相比之下,人类也将A组视为相似———是因为图像看起来相似,而是因为它们遵循相同的基本逻辑,例如展示逻逶闄示变化。新工作尝试重现这种结构或关系相似性,旨在使机器感知更接籐近亨。来源: https://arxiv.org/pdf/2512.07833

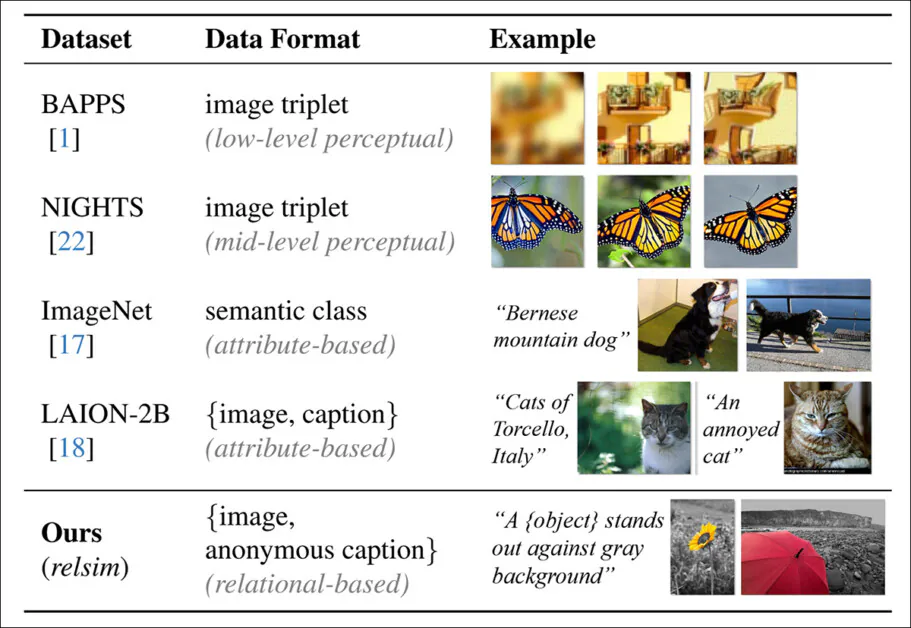

为数据集开发的字幕系统促进了异常抽象的注释,旨在迫使AI系统关注基本特征而不是特定的局部细节:

作者'relsim'指标的预测'匿名'字幕.

策划的集合及其不寻常的字幕风格推动了作者的新提议指标רלסים,作者已将其微调为视觉语言模型(VLM).

典型数据集字幕风格的比较,侧重于属性相似性,而relsim方法(底行)弳缃

新方法借鉴了认知科学的方法,特别是Dedre Gentner的结构映射理论(类比研究)和עמוס טברסקי的关系相似性和属性相似性定义.

来自相关项目网站的关系相似性示例.来源

作者声明:

'[人类]通过感知处理属性相似性,但关系相似性需要概念抽象,通帅象通帅甪诌知识支持.

新论文题为关系视觉相似性,并附有项目网站(请参阅本文末尾嵌入的视频).

שיטה

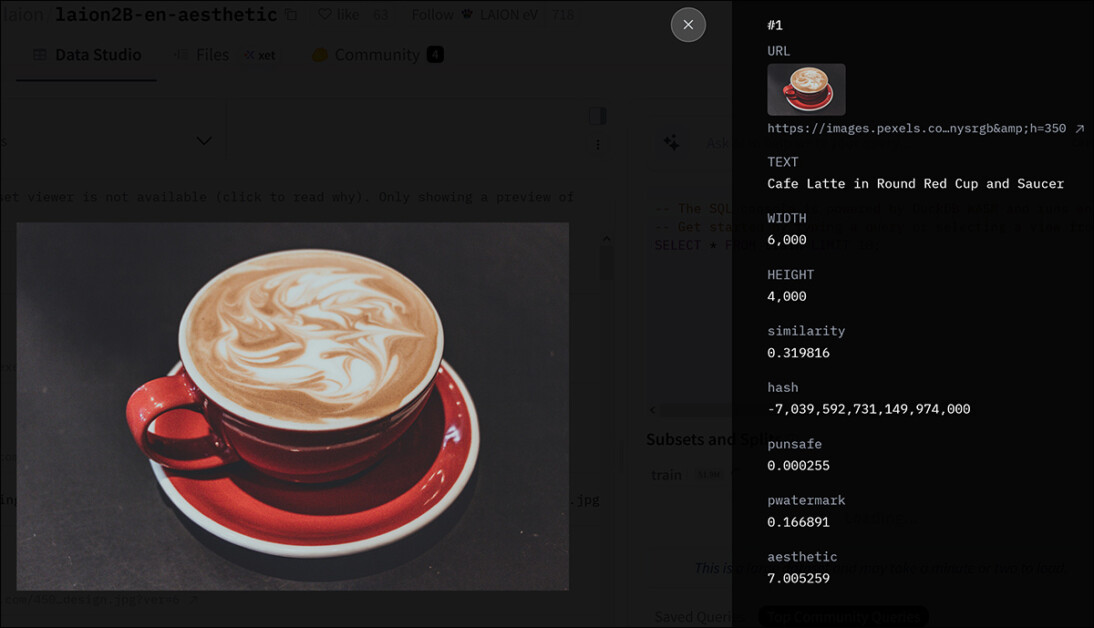

研究人员使用了最著名的超大规模数据集之一作为其集合的起点——LAION-2B:

LAION-2B集合中的一个条目的元数据. 来源

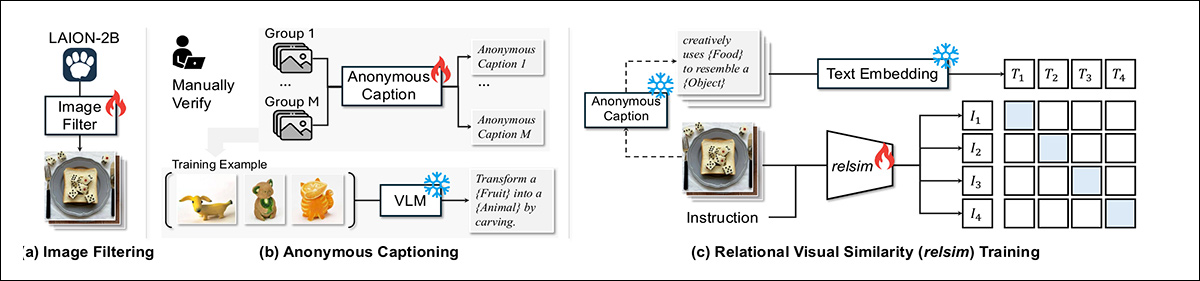

从LAION-2B中提取了可能包含弹性关系结构的114,0 00张图像,涉及过滤大量存在于最小策划数据集中的低质量图像。

为了创建此选择过程的管道,作者利用了Qwen2.5-VL-7B,利用了1,300个正面和11,000个负面的人类标记示例:

relsim系统在三个阶段中进行训练:从LAION-2B中过滤出关系内容的图像;为每组分配一个共享的匿名字幕,捕捉其基本逻辑;并学习使用对比损失将图像与这些字幕匹配。

论文指出:

'注释者被指示:“您能在此图像中看到任何关系模式、逻辑或结构,这可能对创建或链接到另一个图像有用吗?”微调模型与人类判断达成93%的一致性,当应用于LAION-2B时别准N = 114k张图像为关系上有趣的。'

为了生成关系标签,研究人员提示Qwen模型描述图像集背后的共享逻辑,而不命名特定对象。当模型仅看到一张图像时,这种抽象很难获得,但当多个示例展示基本模式时,这变得可行。

生成的组级字幕用占位符如'{נוֹשֵׂא}'או{סוג תנועה}}替换特定术语,使其具有广泛的适用性。

在人工验证后,每个字幕与其组中的所有图像配对。使用了500多个这样的组来训练模型,然后将其应用于114,000张过滤后的图像,以生成一大批抽象的态关系上眬、关系上眬〇

数据和测试

在使用Qwen2.5-VL-7B提取关系特征后,模型在数据上使用LoRA进行了15,000步的微调,通过八个A100 GPU*。在文本方面,使用all-MiniLM-L6-v2מטרנספורמרים משפטיים嵌入关系字幕.

114,000张带字幕的图像数据集被分为100,000用于训练和14,000用于评估。为了测试系统,使用了检索设置:给定一个查询图像,模型必须从一个28,000项的池中找到表达相同关系思想的不同图像。检索池包括14,000个评估图像和14,000个来自LAION-2B的额外样本,从评估集中随机选择1,000个查询进行基准测试。

为了评估检索质量,使用GPT-4o对每个查询和检索图像之间的关系相似性进行0到10的评分。还进行了单独的人类研究以评估用户偏好(见下文)。

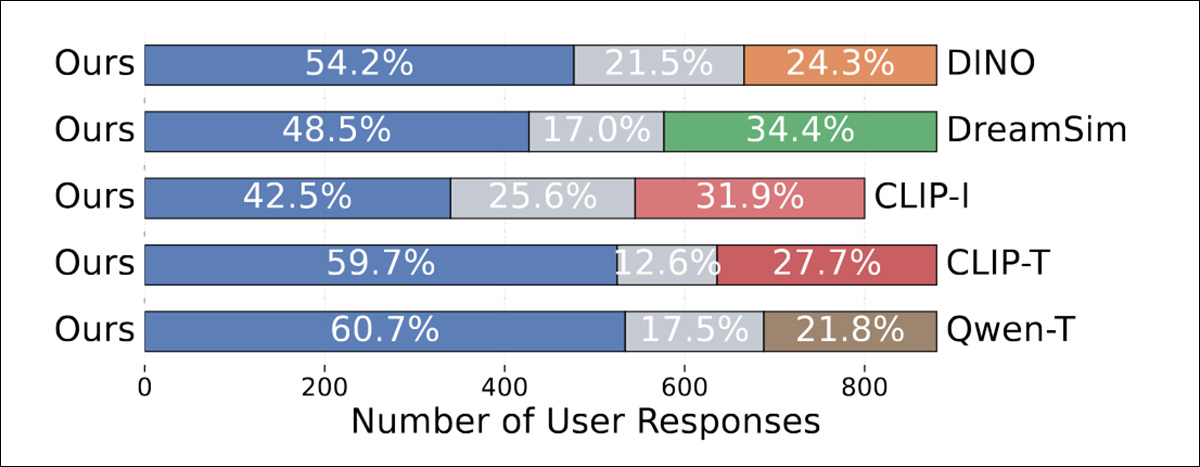

每个参与者被展示一个匿名的查询图像和两个候选图像,一个由提议的方法检索,另一个由基线检索。参与者被问及哪个图像与查询更具关系相似性,或者如果两者都同样接近。对于每个基线,创建了300个三元组,每个三元组由至少三个人评分,产生了大约900个响应。

relsim方法与几种已建立的图像到图像相似性方法进行了比较,包括前述的DINOIPS前述的דרימסיםו -קליפ-I。除了直接计算图像对之间相似性分数的基线,如LPIPS、DINO、dreamsim和CLIP-I ,作者还测试了基于字幕的方法,其中Qwen用于为每个图像生成匿名或抽象字幕;然后这作为检索查询。

评估了两种检索变体,使用CLIP基于文本到图像检索(CLIP-T)进行文本到图像检索,Qwen-T使用文本到文本检索。两个基于字幕的基线使用了原始的预训练Qwen模型,而不是在关系逻辑上微调的版本。这使作者能够隔离基于组的训练的效果,因为微调模型已暴露于图像集,而不是孤立皴露于图像集,而不是孤立的

现有指标和关系相似性

作者最初测试了现有指标是否能够捕捉关系相似性:

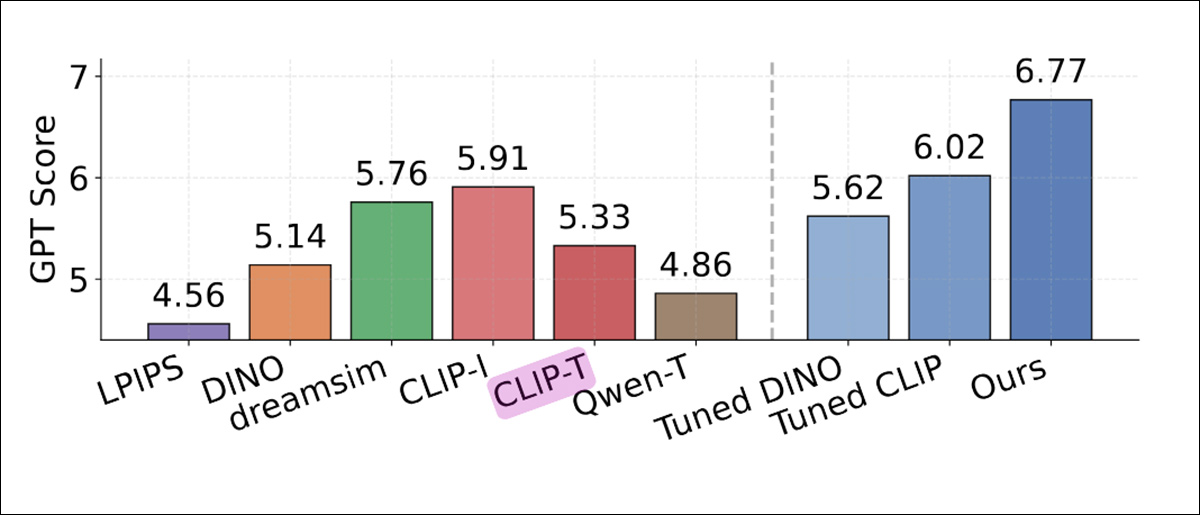

由GPT-4o判断的检索性能比较,显示每种方法的平均关系相似性得分。常规似性指标如LPIPS、DINO和CLIP-I得分较低。基于字幕的基线Qwe n-T和CLIP-T也表现不佳。最高分由relsim(6.77,最右侧蓝色列)获得,表明在基于组的关系模式上进行调优提高了与GPT-4o评估的一致

关于这些结果,作者指出**:

'[LPIPS],仅专注于感知相似性,得分最低(4.56 )。[DINO]表现仅略好(5.14),可能是因为它仅在图像数据上以自监督方式训练。[CLIP-I]在基线中表现最强(5.91),可能是因为图像字幕中有时存在一些抽象。'

'然而,CLIP-I仍然表现不如我们的方法,因为获得更好的分数可能需要达到更高层次的抽象,例如那些在匿名字幕中的抽象。'

在人类研究中,人类在所有基线中始终更喜欢relsim方法:

GPT-4o为每种方法分配的关系相似性得分。标准相似性指标如LPI נ.ב., DINO和CLIP-I得分较低,基于字幕的变体Qwen-T和CLIP-T表现仅略好。即使经过调优的DINO和CLIP也未能缩小差距。最高分6.77由relsim模型获得,使用基于组的监督训练。

作者指出:

'这非常令人鼓舞,因为它不仅表明我们的模型,רלסים,能够成功检索关系相似的图像,而且再次确认人类确实感知到关系相似性——不仅仅是属性相似性!'

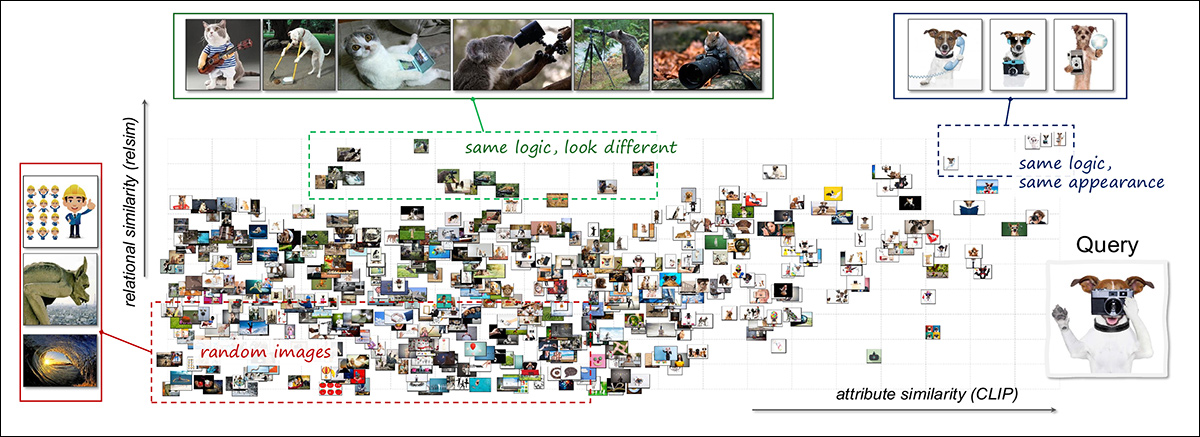

为了探索关系和属性相似性如何互补,研究人员使用了一种联合可视化方法。一个单一的查询图像('一只狗拿着相机')与3,000张随机图像进行了比较,并使用关系和属性模型计算相似性:

使用关系和属性轴的视觉相似性空间的联合可视化。一个单一的查询图像,描绘了一只狗使用相机,与3,000张其他图像进行了比较。结果按关系相似性(垂直)和属性相似性(水平)组织。右上区域包含在逻辑和外观上都类似于查询的图像,如其他使用工具的狗。左上区域包含语义相关但视觉上不同的案例,如不同动物执行与相机相关的动作。大多数剩余示例聚集在空间的较低区域,反映出较弱的相似性。布局展示了关系和属性模型如何突出视觉数据的互补方面。请参阅源论文以获得更好的分辨率。

结果揭示了不同类型相似性的聚类:一些图像在关系和视觉上都相似,如其他处于人类姿势的狗;其他图像共享关系逻辑但不共享外观,如不同动物模仿人类动作;其余则都不显示。

这种分析表明,两种相似性类型具有不同的作用,并在结合时产生更丄绰富

למשל

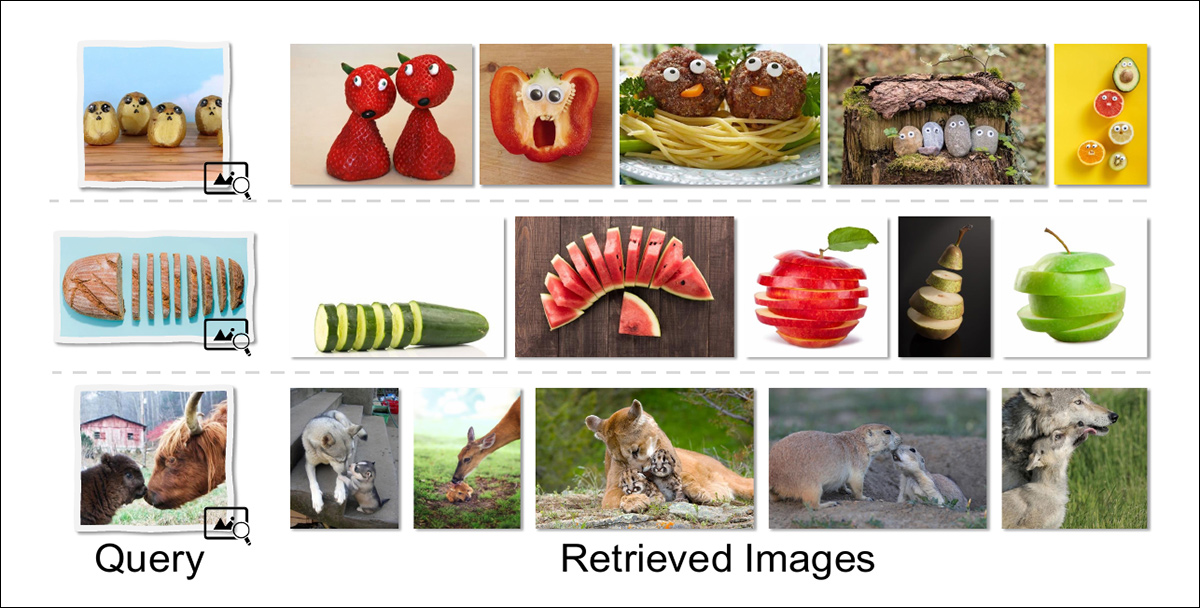

论文还探讨了一些关系相似性的可能最终用例,包括关系图像检索,这使得图像搜索更符合人类自身创造性看待世界的方式:

关系检索返回与查询共享更深层次概念结构的图像,而不是匹配表面特征。例如,设计成类似面孔的食物项目检索其他拟人化的餐点;切片物体产生其他切片形式;成人-后代互动场景返回具有类似关系角色的图像,即使物种和构图不同。

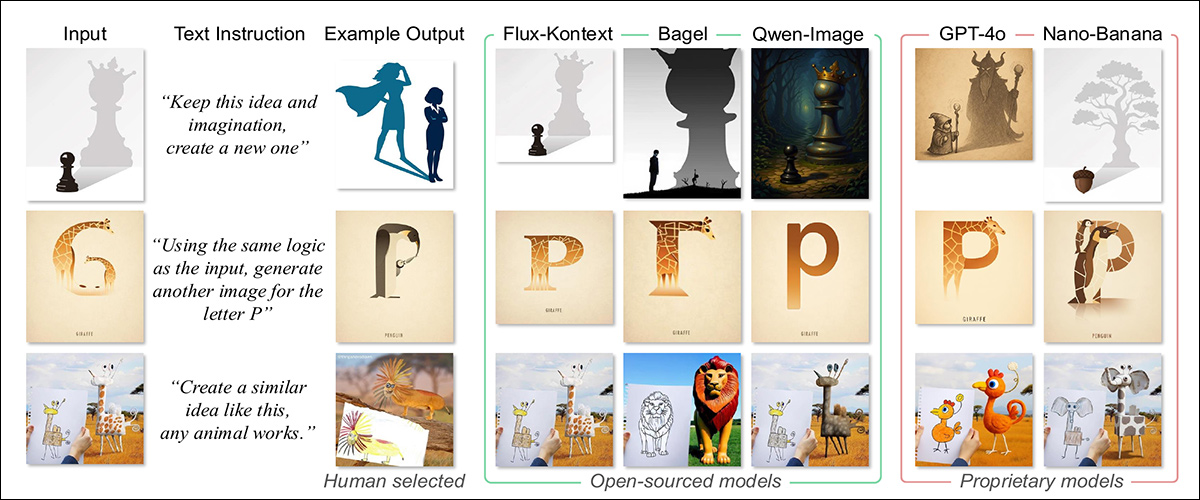

另一个可能性是类比图像生成,这将允许使用关系结构而不是直接描述进行查询的合成。在当前一煄俜本到图像模型中获得的结果比较中,我们可以看到这种方法的结果叠能果叠能

לסיכום

生成AI系统似乎会通过将抽象表示纳入其概念化中而显著增强。就目前而言,要求基于概念的图像如“愤怒”或“快乐”往往返回以数据集中这些关联最流行或最多的图像为风格的图像;这是一种זֵכֶר而不是抽象.

可以推测,如果这一原则可以应用于生成写作——特别是分析性、推测性或虚构性输出,可能会更有益。

按下播放. 来源

* A100可以有40GB或80GB的VRAM;论文中未指定.

** 作者的引用冗余且被排除.

首次发表于2025年12月16日星期二