Անդերսոնի անկյունը

Ինչու են լեզվական մոդելները «կորչում» զրույցի ընթացքում

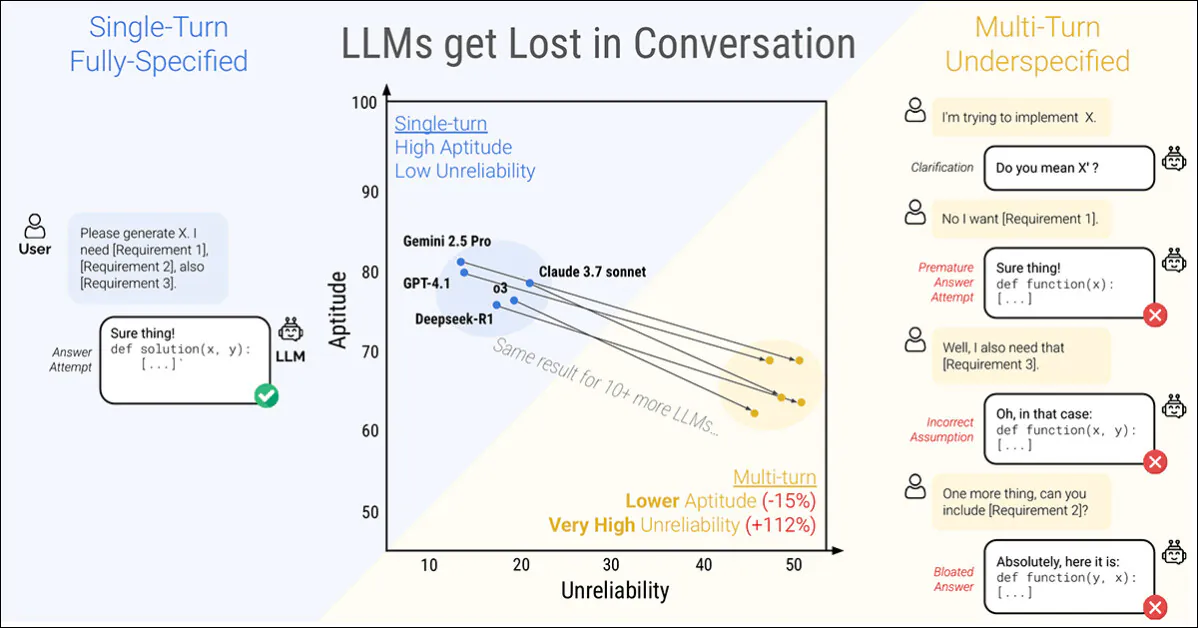

Microsoft Research-ի և Salesforce-ի նոր հոդվածը ցույց է տալիս, որ նույնիսկ ամենակարողները Լեզուների մեծ մոդելներ (LLM)-ները փլուզվում են, երբ հրահանգներ են տրվում։ փուլերով այլ ոչ թե միանգամից։ Հեղինակները պարզել են, որ վեց առաջադրանքների կատարման դեպքում միջինում 39 տոկոսով նվազում է կատարողականը, երբ հուշումը բաժանված մի քանի շրջադարձերի վրա:

Մեկ շրջադարձով զրույցը (ձախից) տալիս է լավագույն արդյունքները, սակայն դա անբնական է վերջնական օգտատիրոջ համար: Բազմափուլ զրույցը (աջից) ցույց է տալիս, որ նույնիսկ ամենաբարձր վարկանիշ ունեցող և ամենաարդյունավետ իրավաբանների գիտությունների մագիստրոսները կորցնում են զրույցի արդյունավետ խթանը: Աղբյուր՝ https://arxiv.org/pdf/2505.06120

Ավելի ցայտուն է, որ հուսալիություն արձագանքների թիվը կտրուկ անկում է ապրում՝ այնպիսի հեղինակավոր մոդելների հետ, ինչպիսիք են ChatGPT-4.1 և Երկվորյակ 2.5 Pro տատանվելով գրեթե կատարյալ պատասխանների և ակնհայտ ձախողումների միջև՝ կախված նրանից, թե ինչպես է նույն խնդիրը ձևակերպված։ Ավելին, արդյունքի հետևողականությունը կարող է նվազել ավելի քան կեսով այդ գործընթացում։

Այս վարքագիծը ուսումնասիրելու համար հոդվածում ներկայացված է մի մեթոդ, որը կոչվում է ցնցում*, որը լիովին նշված հուշումները բաժանում է ավելի փոքր հատվածների և մեկ առ մեկ թողարկում է զրույցի մեջ։

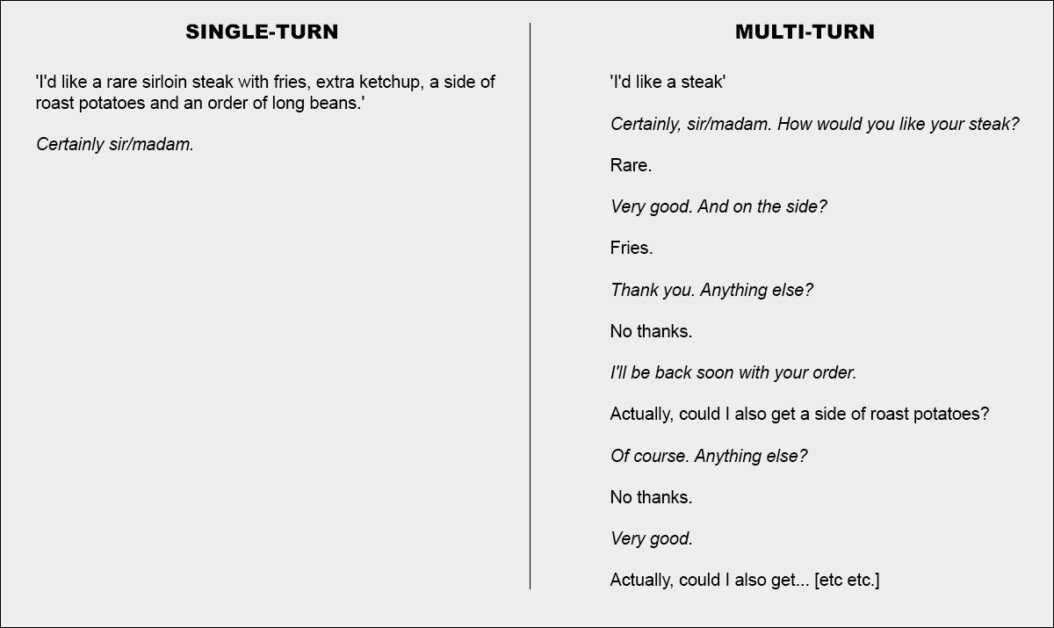

Ամենահիմնական իմաստով սա համարժեք է ռեստորանում միասնական և համապարփակ պատվեր տալուն, մատուցողին ոչինչ անելու տեղ չթողնելով, քան խնդրանքը ընդունելը, կամ հարցը համատեղ քննարկելու որոշմանը.

Ռեստորանային զրույցի երկու ծայրահեղ տարբերակ (ոչ թե նոր թերթից, միայն նկարազարդման նպատակով):

Շեշտադրման համար նշենք, որ վերը նշված օրինակը, թերևս, հաճախորդին ներկայացնում է բացասական լույսի ներքո։ Սակայն երկրորդ սյունակում պատկերված հիմնական գաղափարը գործարքային փոխանակման գաղափարն է, որը պարզաբանում է խնդիրների ամբողջությունը՝ դրանց անդրադառնալուց առաջ, ինչը, ըստ երևույթին, խնդրին մոտենալու ռացիոնալ և ողջամիտ միջոց է։

Այս դասավորությունը արտացոլվում է նոր աշխատանքի կաթիլային սնուցման մեջ, կոտրված մոտեցում LLM փոխազդեցությանը: Հեղինակները նշում են, որ LLM-ները հաճախ չափազանց երկար պատասխաններ են ստեղծում, ապա շարունակում են ապավինել իրենց սեփական պատկերացումներին: նույնիսկ այն բանից հետո, երբ այդ պատկերացումները սխալ կամ անտեղի են ապացուցվելԱյս միտումը, զուգորդված այլ գործոնների հետ, կարող է հանգեցնել նրան, որ համակարգը ամբողջությամբ կորցնի փոխանակման հետքը։

Իրականում, հետազոտողները նշում են, որ մեզանից շատերը անեկդոտային կերպով գտել են – որ զրույցը ճիշտ ուղու վրա դնելու լավագույն միջոցը իրավագիտության բակալավրի հետ նոր զրույց սկսելն է:

Եթե իրավագիտության մագիստրոսի հետ զրույցը չի հանգեցրել սպասվող արդյունքների, նույն տեղեկատվությունը կրկնող նոր զրույց սկսելը կարող է զգալիորեն ավելի լավ արդյունքներ տալ, քան շարունակական զրույցը շարունակելը։

«Սա պայմանավորված է նրանով, որ ներկայիս LLM-ները կարող են կորչել զրույցի մեջ, և մեր փորձերը ցույց են տալիս, որ մոդելի հետ զրույցի մեջ համառելը անարդյունավետ է: Բացի այդ, քանի որ LLM-ները տեքստ են ստեղծում պատահականորեն, նոր զրույցը կարող է հանգեցնել բարելավված արդյունքների»:

Հեղինակները ընդունում են, որ գործակալային համակարգերը, ինչպիսիք են՝ Ավտոգեն or LangChain կարող են պոտենցիալ բարելավել արդյունքները՝ գործելով որպես մեկնաբանական շերտեր վերջնական օգտատիրոջ և իրավունքի մասնագետի (LLM) միջև, հաղորդակցվելով LLM-ի հետ միայն այն դեպքում, երբ նրանք հավաքել են բավարար քանակությամբ «կտրատված» պատասխաններ՝ մեկ ամբողջական հարցման մեջ միավորվելու համար (որին վերջնական օգտատերը չի ենթարկվի):

Այնուամենայնիվ, հեղինակները պնդում են, որ առանձին աբստրակցիայի շերտը պարտադիր չէ, կամ այն պետք է ներկառուցվի անմիջապես սկզբնական LLM-ի մեջ։

«Կարելի է պնդել, որ բազմակի շրջադարձային հնարավորությունները LLM-ների անհրաժեշտ հատկանիշ չեն, քանի որ դրանք կարող են փոխանցվել գործակալի շրջանակին։ Այլ կերպ ասած՝ արդյո՞ք մեզ անհրաժեշտ է բնիկ բազմակի շրջադարձային աջակցություն LLM-ներում, երբ գործակալի շրջանակը կարող է կազմակերպել օգտատերերի հետ փոխազդեցությունները և օգտագործել LLM-ները միայն որպես մեկ շրջադարձային օպերատորներ։…»

Սակայն, իրենց օրինակների շարքում այս պնդումը փորձարկելով, նրանք եզրակացնում են.

«Տեղեկատվություն մշակելու համար գործակալանման շրջանակի վրա [հենվելը] կարող է սահմանափակող լինել, և մենք պնդում ենք, որ իրավագիտության մագիստրոսները պետք է բնականորեն աջակցեն բազմակի շրջադարձային փոխազդեցությանը»։

Սա հետաքրքիր է նոր թուղթ վերնագրված է Իրավագիտության մագիստրոսները կորչում են բազմակողմանի զրույցի մեջև գալիս է MS Research-ի և Salesforce-ի չորս հետազոտողների կողմից,

Կտրված զրույցներ

Նոր մեթոդը նախ բաժանում է ավանդական միակողմանի հրահանգները ավելի փոքր շարդերի, որոնք նախատեսված են LLM փոխազդեցության ընթացքում կարևոր պահերին ներդրվելու համար, մի կառուցվածք, որը արտացոլում է ChatGPT-ի կամ Google Gemini-ի նման համակարգերում հանդիպող հետազոտական, առաջ-ետ փոխազդեցության ոճը։

Յուրաքանչյուր սկզբնական հրահանգը մեկ, ինքնուրույն հուշում է, որը միանգամից կատարում է ամբողջ առաջադրանքը՝ համատեղելով բարձր մակարդակի հարցը, օժանդակ համատեքստը և ցանկացած համապատասխան պայման: Կտոր-կտոր տարբերակը այն բաժանում է մի քանի փոքր մասերի, որտեղ յուրաքանչյուր բեկոր ավելացնում է միայն մեկ տեղեկատվություն.

Զույգ հրահանգներ, որոնք ցույց են տալիս (ա) մեկ քայլով ներկայացված ամբողջական հուշումը և (բ) դրա մասնատված տարբերակը, որն օգտագործվում է թերնշված, բազմափուլ փոխազդեցությունը մոդելավորելու համար: Սեմանտիկ առումով, յուրաքանչյուր տարբերակ տրամադրում է նույն տեղեկատվական բեռը:

Առաջին հատվածը միշտ ներկայացնում է առաջադրանքի հիմնական նպատակը, մինչդեռ մնացածը տրամադրում են պարզաբանող մանրամասներ: Միասին դրանք ներկայացնում են նույն բովանդակությունը, ինչ սկզբնական հուշումը, բայց բնականորեն տարածվում են զրույցի մի քանի փուլերի վրա:

Յուրաքանչյուր սիմուլյացված զրույց ծավալվում է երեք բաղադրիչների միջև՝ օգնական, գնահատման ենթակա մոդելը; օգտագործողը, սիմուլյացված գործակալ, որն ունի ամբողջական հրահանգին մուտք՝ մասնատված տեսքով, և համակարգ, որը ստուգում է և գնահատում փոխանակումը։

Զրույցը սկսվում է նրանով, որ օգտատերը բացահայտում է առաջին բեկորը, և օգնականը ազատորեն պատասխանում է։ Այնուհետև համակարգը դասակարգում է այդ պատասխանը մի քանի կատեգորիաներից մեկով, օրինակ՝ պարզաբանման հարցում կամ ամբողջական պատասխանի փորձ.

Եթե մոդելը does Պատասխանը փորձելու դեպքում առանձին բաղադրիչը գնահատման համար արդյունահանում է միայն համապատասխան տիրույթը՝ անտեսելով շրջապատող ցանկացած տեքստ: Յուրաքանչյուր նոր քայլի ժամանակ օգտատերը բացահայտում է մեկ լրացուցիչ բեկոր՝ առաջացնելով մեկ այլ պատասխան: Փոխանակումը շարունակվում է մինչև մոդելը ճիշտ պատասխան ստանա, կամ մինչև չմնա որևէ բեկոր բացահայտելու համար:

Կտորացված զրույցի սիմուլյացիայի դիագրամ, որտեղ գնահատված մոդելը նշված է կարմիր գույնով։

Սկզբնական փորձարկումները ցույց տվեցին, որ մոդելները հաճախ հարցնում էին դեռևս չտրամադրված տեղեկատվության մասին, ուստի հեղինակները հրաժարվեցին բեկորները ֆիքսված հերթականությամբ բացահայտելու գաղափարից: Դրա փոխարեն, սիմուլյատոր օգտագործվեց՝ որոշելու համար, թե որ բեկորը բացահայտել հաջորդը՝ հիմնվելով զրույցի ընթացքի վրա:

Հետևաբար, GPT-4o-mini-ի միջոցով իրականացված օգտատիրոջ սիմուլյատորը լիարժեք հասանելիություն ստացավ ինչպես ամբողջ հրահանգին, այնպես էլ զրույցի պատմությանը՝ յուրաքանչյուր քայլին որոշելով, թե որ բեկորը բացահայտել հաջորդը՝ հիմնվելով փոխանակման ընթացքի վրա։

Օգտագործողի սիմուլյատորը նույնպես վերաձևակերպված յուրաքանչյուր բեկոր՝ զրույցի հոսքը պահպանելու համար՝ առանց իմաստը փոխելու: Սա թույլ տվեց սիմուլյացիային արտացոլել իրական երկխոսության «տալ-առնելը», միաժամանակ պահպանելով առաջադրանքի կառուցվածքի նկատմամբ վերահսկողությունը:

Զրույցի սկսվելուց առաջ օգնականին տրվում է միայն առաջադրանքն ավարտելու համար անհրաժեշտ հիմնական տեղեկատվությունը, ինչպիսիք են տվյալների բազայի սխեման կամ API հղումը: Այնտեղ չի ասվում, որ հրահանգները կբաժանվեն, և այն չի ուղղորդվում զրույցը վարելու որևէ կոնկրետ եղանակի: Սա արվում է միտումնավոր. իրական աշխարհում մոդելներին գրեթե երբեք չեն ասում, որ հուշումը կլինի թերի կամ կթարմացվի ժամանակի ընթացքում, և այս համատեքստը բաց թողնելը օգնում է սիմուլյացիային արտացոլել, թե ինչպես է մոդելը գործում ավելի իրատեսական համատեքստում:

GPT-4o-mini-ն օգտագործվել է նաև մոդելի պատասխանների դասակարգման եղանակը որոշելու և այդ պատասխաններից վերջնական պատասխաններ հանելու համար։ Սա օգնեց սիմուլյացիային մնալ ճկուն, բայց երբեմն սխալներ թույլ տվեց. սակայն, մի քանի հարյուր զրույց ձեռքով ստուգելուց հետո, հեղինակները պարզեցին, որ հինգ տոկոսից պակասը որևէ խնդիր ուներ, և երկու տոկոսից պակասը ցույց տվեց արդյունքի փոփոխություն դրանց պատճառով, և նրանք սա համարեցին նախագծի պարամետրերի շրջանակներում բավականաչափ ցածր սխալի մակարդակ։

Մոդելավորման սցենարներ

Հեղինակները օգտագործել են սիմուլյացիայի հինգ տեսակ՝ տարբեր պայմաններում մոդելի վարքագիծը ստուգելու համար, որոնցից յուրաքանչյուրը տարբերակ է այն բանի, թե ինչպես և երբ են բացահայտվում հրահանգի մասերը։

Է Լրիվ Այս կարգավորման դեպքում մոդելը մեկ պտույտով ստանում է ամբողջ հրահանգը։ Սա ներկայացնում է ստանդարտ չափանիշի ձևաչափը և ծառայում է որպես կատարողականի բազային ցուցանիշ։

Կտրված Այս կարգավորումը հրահանգը բաժանում է մի քանի մասերի և դրանք մատուցում մեկ առ մեկ՝ մոդելավորելով ավելի իրատեսական, թերճշտված զրույց։ Սա հիմնական կարգավորումն է, որն օգտագործվում է մոդելների կողմից բազմակի շրջադարձային մուտքագրմանը հարմարվելու որակը ստուգելու համար։

Է Կոնկատ Այս դեպքում, բեկորները միացվում են որպես մեկ միասնական ցուցակ՝ պահպանելով դրանց բառապաշարը, բայց հեռացնելով քայլ առ քայլ կառուցվածքը։ Սա օգնում է մեկուսացնել խոսակցական մասնատման հետևանքները վերաձևակերպումից կամ բովանդակության կորստից։

Հիշեցնենք կարգավորումը գործում է ինչպես Կտրված, սակայն ավելացնում է վերջին շրջադարձ, որտեղ բոլոր նախորդ բեկորները վերաձևակերպվում են, նախքան մոդելը վերջնական պատասխան տա: Սա ստուգում է, թե արդյոք ամփոփման հուշումը կարող է օգնել վերականգնել կորցրած համատեքստը:

Եվ, վերջապես, Ձնագնդի ավելի հեռու է գնում՝ կրկնելով բոլոր նախորդ բեկորները ամեն քայլափոխի, ամբողջական հրահանգը տեսանելի պահելով զրույցի ընթացքում և առաջարկելով բազմակի շրջադարձերով խոսելու ունակության ավելի ներողամիտ թեստ։

Սիմուլյացիայի տեսակները, որոնք հիմնված են մասնատված հրահանգների վրա: Լիովին նշված հուշումը բաժանվում է ավելի փոքր մասերի, որոնք այնուհետև կարող են օգտագործվել մեկ շրջադարձով (Լրիվ, Միաձուլված) կամ բազմապտույտ (Մասշտաբային, Ամփոփված, Ձնագնդի) զրույցները մոդելավորելու համար՝ կախված նրանից, թե որքան արագ է բացահայտվում տեղեկատվությունը:

Առաջադրանքներ և չափանիշներ

Ընտրվել են վեց սերնդի առաջադրանքներ՝ ծրագրավորման և բնական լեզվի ոլորտները ներառելու համար. կոդի ստեղծման հրահանգները վերցված են HumanEval և LiveCodeBench; Տեքստային-SQL հարցումները վերցված են Եռոտանի; API զանգերը կառուցվել են՝ օգտագործելով տվյալների Բերկլիի ֆունկցիաների կանչման վարկանիշային աղյուսակտարրական մաթեմատիկայի խնդիրները տրամադրվել են GSM8K; աղյուսակային ենթագրերի առաջադրանքները հիմնված էին Տոտտո; և բազմափաստաթղթերի ամփոփագրերը կազմվել են Խոտի դեզի ամփոփում տվյալների բազա։

Մոդելի արդյունավետությունը չափվել է երեք հիմնական չափանիշներով. միջին կատարողականություն, ընդունակություն, եւ անհուսալիություն.

Միջին կատարում ցույց տվեց, թե որքան լավ է մոդելը ընդհանուր առմամբ աշխատել բազմակի փորձերի ընթացքում։ ընդունակություն արտացոլում էր մոդելի կողմից հնարավոր լավագույն արդյունքները՝ հիմնվելով դրա ամենաբարձր գնահատականներ ստացած արդյունքների վրա, և անհուսալիություն չափվել է, թե որքանով են այդ արդյունքները տարբերվում, ընդ որում՝ լավագույն և վատագույն արդյունքների միջև ավելի մեծ բացերը վկայում են պակաս կայուն վարքագծի մասին։

Բոլոր միավորները դասակարգվել են 0-100 սանդղակով՝ առաջադրանքների միջև հետևողականությունն ապահովելու համար, և չափանիշները հաշվարկվել են յուրաքանչյուր հրահանգի համար, ապա միջինացվել՝ մոդելի կատարողականի ընդհանուր պատկերը ստանալու համար։

Փորձերում օգտագործվել են վեց մասնատված առաջադրանքներ, որոնք ընդգրկում են և՛ ծրագրավորում, և՛ բնական լեզվի ստեղծում: Յուրաքանչյուր առաջադրանք ներկայացված է ամբողջությամբ նշված հրահանգով և դրա մասնատված տարբերակով: Յուրաքանչյուր առաջադրանքի համար սահմանված չափանիշներից վերցվել են 90-ից 120 հրահանգներ:

Հավակնորդներ և թեստեր

Սկզբնական սիմուլյացիաներում (մոտավորապես 5000 դոլար արժողությամբ) վեց առաջադրանք ընդգրկող 600 հրահանգներ բաժանվեցին և օգտագործվեցին երեք տեսակի զրույցներ սիմուլյացնելու համար. Լրիվ, համակցված, եւ կոտրվածՄոդելի, հրահանգի և սիմուլյացիայի տեսակի յուրաքանչյուր համադրության համար իրականացվել է տասը զրույց, որոնք ընդհանուր առմամբ ստեղծել են ավելի քան 200,000 սիմուլյացիա՝ սխեմա, որը հնարավորություն է տվել գնահատել ինչպես ընդհանուր կատարողականը, այնպես էլ ընդունակությունների և հուսալիության ավելի խորը չափանիշները։

Փորձարկվել են տասնհինգ մոդելներ, որոնք ընդգրկում են մատակարարների և ճարտարապետությունների լայն շրջանակ՝ OpenAI մոդելները։ GPT-4o (տարբերակ 2024-11-20), GPT-4o-mini (2024-07-18) GPT-4.1 (2025-04-14), և մտածողության մոդելը o3 (2025-04 - 16).

Մարդաբանական մոդելներն էին Կլոդ 3 Հայկու (2024-03-07) և Կլոդ 3.7 Սոնետ (2025-02-19), մուտք գործվել է Amazon Bedrock-ի միջոցով։

Google-ի ներդրումը Երկվորյակ 2.5 Flash (նախադիտում-04-17) և Երկվորյակ 2.5 Pro (preview-03-25): Մետա մոդելները Լամա 3.1-8B-Instruct և Լամա 3.3-70B-Instruct, Ինչպես նաեւ Լամա 4 Սկաուտ-17Բ-16Ե, Together AI-ի միջոցով։

Մյուս գրառումներն էին՝ OLMo 2 13B, Phi-4, եւ Հրամանատարություն-Ա, բոլորին հասանելի է տեղական մակարդակով Ollama-ի կամ Cohere API-ի միջոցով, և Deepseek-R1, հասանելի է Amazon Bedrock-ի միջոցով։

Երկուսի համար «մտածող» մոդելներ (o3 և R1), տոկենների սահմանաչափեր բարձրացվեցին մինչև 10,000՝ ավելի երկար դատողական շղթաներ տեղավորելու համար։

Յուրաքանչյուր մոդելի միջին կատարողականի միավորները վեց առաջադրանքների համար՝ կոդ, տվյալների բազա, գործողություններ, տվյալների տեքստային փոխակերպում, մաթեմատիկա և ամփոփում: Արդյունքները ներկայացված են սիմուլյացիայի երեք տեսակների համար՝ լրիվ, կոնկատ և մասնատված: Մոդելները դասավորված են իրենց միջին լրիվ կարգավորման միավորի համաձայն: Ստվերավորումը արտացոլում է լրիվ կարգավորման համեմատ կատարողականի անկման աստիճանը, որտեղ վերջին երկու սյուները ցույց են տալիս կոնկատի և մասնատված մոդելների միջին անկումները լրիվի համեմատ:

Այս արդյունքների վերաբերյալ հեղինակները նշում են, որ†:

«Բարձր մակարդակով, Յուրաքանչյուր մոդելի կատարողականությունը նվազում է յուրաքանչյուր առաջադրանքի դեպքում՝ համեմատելով FULL և SHARDED կատարողականները։, միջինում -39% դեգրադացիայով։ Մենք այս երևույթը անվանում ենք Զրույցի մեջ կորածմոդելներ, որոնք հասնում են լաբորատոր պայմաններում 90%+ արդյունավետության՝ լիովին սահմանված, մեկ քայլով խոսակցական դժվարությունների պայմաններում։ ճիշտ նույն առաջադրանքների վրա ավելի իրատեսական միջավայրում, երբ զրույցը թերագնահատված է և բազմակողմանի։

Կոնկատ միավորները միջինում կազմել են 95 տոկոս Լրիվ, ինչը ցույց է տալիս, որ sharded կարգավորման մեջ կատարողականի անկումը չի կարող բացատրվել տեղեկատվության կորստով: Ավելի փոքր մոդելները, ինչպիսիք են Llama3.1-8B-Instruct-ը, OLMo-2-13B-ը և Claude 3 Haiku-ն, ավելի ցայտուն վատթարացում են ցուցաբերել համակցված, ինչը ենթադրում է, որ փոքր մոդելները, ընդհանուր առմամբ, ավելի քիչ դիմացկուն են վերաձևակերպման նկատմամբ, քան մեծերը։

Հեղինակները դիտարկում են†:

«Զարմանալիորեն, Ավելի արդյունավետ մոդելները (Claude 3.7 Sonnet, Gemini 2.5, GPT-4.1) հավասարապես կորչում են զրույցի մեջ՝ համեմատած ավելի փոքր մոդելների հետ (Llama3.1-8B-Instruct, Phi-4):), միջինում 30-40% վատթարացումներով։ Սա մասամբ պայմանավորված է մետրիկ սահմանումներով։ Քանի որ փոքր մոդելները ավելի ցածր բացարձակ միավորներ են ստանում FULL, դրանք ավելի քիչ քայքայման հնարավորություն ունեն, քան ավելի լավ մոդելները։

«Հակիրճ ասած, անկախ նրանից, թե որքան ուժեղ է իրավագիտության մագիստրոսի մեկ փուլով աշխատելու արդյունավետությունը, մենք նկատում ենք կատարողականի մեծ անկում բազմափուլ ռեժիմում»։

Սկզբնական թեստը ցույց է տալիս, որ որոշ մոդելներ ավելի լավ են աշխատել որոշակի առաջադրանքներում. Command-A-ն՝ գործողությունների, Claude 3.7 Sonnet-ի և GPT-4.1-ի դեպքում՝ կոդի, իսկ Gemini 2.5 Pro-ն՝ տվյալների տեքստի վրա, ինչը ցույց է տալիս, որ բազմակի շրջադարձերի ունակությունը տարբերվում է ըստ ոլորտների: O3-ի և Deepseek-R1-ի նման դատողությունների մոդելները ընդհանուր առմամբ ավելի լավ արդյունք չեն ցույց տվել, թերևս այն պատճառով, որ դրանց ավելի երկար պատասխանները ավելի շատ ենթադրություններ են ներմուծել, որոնք հակված են խճճել զրույցը:

հուսալիություն

Հմտության և հուսալիության միջև կապը, որը հստակ էր մեկ շրջադարձով մոդելավորումներում, կարծես թե խաթարվում էր բազմակի շրջադարձերի պայմաններում: Մինչդեռ հմտությունը միայն չափավոր կերպով նվազեց, անվստահելիությունը կրկնապատկվել է միջինում։ Լրիվ ձևաչափի հուշումներում կայուն մոդելները, ինչպիսիք են GPT-4.1-ը և Gemini 2.5 Pro-ն, հրահանգի մասնատումից հետո դարձան նույնքան անկայուն, որքան Llama3.1-8B-Instruct-ի կամ OLMo-2-13B-ի նման ավելի թույլ մոդելները։

Հմտության և անվստահելիության ընդհանուր պատկերը, ինչպես ցույց է տրված քառակուսի գրաֆիկում (ա), որին հաջորդում են տասնհինգ մոդելներով փորձերի հուսալիության արդյունքները (բ) և աստիճանական մասնատման թեստի արդյունքները, որտեղ հրահանգները բաժանվել են մեկից ութ մասնիկների (գ):

Մոդելի պատասխանները նույն առաջադրանքի դեպքում հաճախ տարբերվում էին մինչև 50 միավորով, նույնիսկ երբ ոչ մի նոր բան չէր ավելացվում, ինչը ենթադրում է, որ կատարողականի անկումը պայմանավորված չէր հմտության պակասով, այլ մոդելի՝ հերթափոխի ընթացքում ավելի ու ավելի անկայուն դառնալով։

Թերթում նշվում է†:

«[Չնայած] ավելի լավ մոդելները հակված են ունենալ մի փոքր ավելի բարձր բազմակի շրջադարձային հնարավորություններ, բոլոր մոդելները հակված են ունենալ անվստահելիության նմանատիպ մակարդակներ։ Այլ կերպ ասած՝ Բազմակի շրջադարձային, թերնշված կարգավորումներում, մեր կողմից փորձարկված բոլոր մոդելները ցուցաբերում են շատ բարձր անվստահելիություն, որտեղ կատարողականը միջինում 50 տոկոսային միավորով անկում է ապրում ֆիքսված հրահանգի համար լավագույն և վատագույն սիմուլյացված գործարկումների միջև։.'

Ստուգելու համար, թե արդյոք կատարողականի վատթարացումը կապված է պտույտների քանակի հետ, հեղինակները իրականացրեցին աստիճանական շարդինգի փորձ՝ յուրաքանչյուր հրահանգը բաժանելով մեկից ութ շարդերի (տե՛ս վերևում գտնվող պատկերի աջ անկյունային սյունը):

Քանի որ բեկորների քանակը մեծանում էր, անվստահելիությունը կայուն աճում էր՝ հաստատելով, որ նույնիսկ շրջադարձերի քանակի աննշան աճը մոդելներն ավելի անկայուն էր դարձնումՀմտությունը մեծ մասամբ անփոփոխ մնաց, ինչը հաստատում է, որ խնդիրը կայանում է հետեւողականություն, ոչ թե կարողություն։

Ջերմաստիճանը Control

Առանձին փորձերի շարքով ստուգվեց, թե արդյոք անվստահելիությունը պարզապես պատահականության կողմնակի արդյունք է։ Դրա համար հեղինակները փոփոխեցին օգնականի և օգտատիրոջ սիմուլյատորի ջերմաստիճանի կարգավորումները երեք արժեքներով՝ 1.0, 0.5 և 0.0։

Միանվագ ձևաչափերով, ինչպիսիք են Լրիվ և համակցվածօգնականի ջերմաստիճանը նվազեցնելը զգալիորեն բարելավել է հուսալիությունը՝ կրճատելով տատանումները մինչև 80 տոկոսով։ Սակայն կոտրված նույն միջավայրում նույն միջամտությունը քիչ ազդեցություն ունեցավ.

Անհուսալիության գնահատականներ օգնականի և օգտատիրոջ ջերմաստիճանի տարբեր համակցությունների համար՝ լրիվ, կոնկատ և շերտավորված կարգավորումներում, որտեղ ավելի ցածր արժեքները ցույց են տալիս արձագանքի ավելի մեծ հետևողականություն։

Նույնիսկ երբ և՛ օգնականը, և՛ օգտատերը զրոյական ջերմաստիճանի վրա էին դրված, անվստահելիությունը մնում էր բարձր, GPT-4-ն ցույց էր տալիս մոտ 30 տոկոս տատանում, ինչը ենթադրում է, որ բազմակի շրջադարձերով զրույցներում նկատվող անկայունությունը միայն... ստոխաստիկ աղմուկ, բայց կառուցվածքային թուլություն այն բանում, թե ինչպես են մոդելները մշակում մասնատված մուտքային տվյալները։

Հետեւանքները

Հոդվածի վերջում հեղինակները անսովոր երկարությամբ գրում են իրենց արդյունքների հետևանքների մասին՝ պնդելով, որ մեկ շրջադարձի ուժեղ կատարողականը չի երաշխավորում բազմակի շրջադարձի հուսալիությունը, և զգուշացնում են իրական աշխարհի պատրաստվածությունը գնահատելիս լիովին սահմանված չափանիշներին չափազանց շատ հույսը դնելուց (քանի որ նման չափանիշները քողարկում են անկայունությունը ավելի բնական, մասնատված փոխազդեցություններում):

Նրանք նաև ենթադրում են, որ անվստահելիությունը ոչ միայն նմուշառման արտեֆակտ է, այլև հիմնարար սահմանափակում թե ինչպես են ներկայիս մոդելները մշակում փոփոխվող մուտքային տվյալները, և նրանք ենթադրում են, որ սա մտահոգություններ է առաջացնում գործակալների շրջանակների համար, որոնք կախված են հերթափոխների միջև կայուն դատողությունից։

Վերջապես, նրանք պնդում են, որ բազմակի շրջադարձ կատարելու ունակությունը պետք է դիտարկել որպես իրավունքի կառավարման (LLM) հիմնական կարողություն, այլ ոչ թե որպես արտաքին համակարգերին տեղափոխված մի բան:

Հեղինակները նշում են, որ իրենց արդյունքները, հավանաբար, թերագնահատում խնդրի իրական մասշտաբը և ուշադրություն հրավիրել թեստի իդեալական պայմանների վրա. իրենց կարգավորումներում օգտագործողի սիմուլյատորն ուներ հրահանգներին լիարժեք մուտք և կարող էր բացահայտել բեկորները օպտիմալ հերթականությամբ, ինչը օգնականին տալիս էր անիրատեսորեն բարենպաստ համատեքստ (իրական աշխարհում օգտագործման դեպքում օգտատերերը հաճախ տրամադրում են մասնատված կամ երկիմաստ հուշումներ՝ չիմանալով, թե ինչ է մոդելը պետք է լսի հաջորդը):

Բացի այդ, օգնականը գնահատվել է անհապաղ յուրաքանչյուր քայլից հետո, մինչև ամբողջական զրույցի ծավալումը, կանխելով հետագա շփոթության կամ ինքնահարաբերության պատժումը, ինչը հակառակ դեպքում կվատթարացներ արդյունավետությունը: Այս ընտրությունները, չնայած անհրաժեշտ են փորձարարական վերահսկողության համար, նշանակում են, որ գործնականում դիտարկվող հուսալիության բացերը, հավանաբար, նույնիսկ ավելի մեծ կլինեն, քան հաղորդվածները:

Նրանք եզրակացնում են.

«[Մենք] կարծում ենք, որ անցկացված սիմուլյացիաները բարենպաստ փորձարկման հարթակ են LLM բազմակողմանի հնարավորությունների համար»։ Սիմուլյացիայի չափազանց պարզեցված պայմանների պատճառով մենք կարծում ենք, որ փորձերի ընթացքում դիտարկվող վատթարացումը, ամենայն հավանականությամբ, LLM-ի անվստահելիության և իրական աշխարհի պայմաններում LLM-ների խոսակցության մեջ կորելու հաճախականության թերագնահատում է։'

Եզրափակում

Յուրաքանչյուր ոք, ով զգալի ժամանակ է անցկացրել իրավագիտության մագիստրոսի կոչումով (LLM), հավանաբար, կճանաչի այստեղ ձևակերպված խնդիրները՝ ելնելով գործնական փորձից, և մեզանից շատերը, կարծում եմ, ինտուիտիվ կերպով հրաժարվել են «կորած» LLM զրույցներից՝ նորերը հաշվի առնելով՝ հույս ունենալով, որ LLM-ը կարող է «նորից սկսել» և դադարել կենտրոնանալ երկար, ոլորապտույտ և ավելի ու ավելի զայրացնող զրույցի ընթացքում ի հայտ եկած նյութի վրա։

Հետաքրքիր է նշել, որ խնդրին ավելի շատ համատեքստ հաղորդելը կարող է պարտադիր չէ, որ լուծի այն, և իրոք, պետք է նկատել, որ հոդվածն ավելի շատ հարցեր է բարձրացնում, քան պատասխաններ է տալիս (բացառությամբ խնդիրը շրջանցելու եղանակների):

* Շփոթեցնող կերպով, սա կապ չունի «Շարդինգ» բառի ավանդական իմաստը արհեստական բանականության մեջ.

† Հեղինակների սեփական համարձակ շեշտադրումները։

Առաջին անգամ հրապարակվել է երկուշաբթի, 12 մայիսի, 2025թ.