Mesterséges intelligencia

MINT-1T: Nyílt forráskódú multimodális adatok skálázása 10-szeresére

A határterületi nagy multimodális modellek (LMM) képzéséhez nagyméretű adatkészletekre van szükség, amelyek szabad formájú kép- és szövegsorozatokat tartalmaznak. Bár a nyílt forráskódú LMM-ek gyorsan fejlődtek, továbbra is jelentős hiányosságok vannak a nyílt forráskódú multimodális interleaved adatkészletekből. Ezeknek az adatkészleteknek a jelentőségét nem lehet túlbecsülni, mivel ezek képezik az alapot a fejlett AI-rendszerek létrehozásához, amelyek képesek megérteni és különböző módokon tartalmat generálni. Átfogó, átlapolt adatkészletek elegendő kínálata nélkül a kifinomultabb és képességesebb LMM-ek kifejlesztésének lehetősége jelentősen gátolt. Ezek az adatkészletek lehetővé teszik a modellek számára, hogy sokféle bemenetből tanuljanak, sokoldalúbbá és hatékonyabbá téve őket a különböző alkalmazásokban. Ezenkívül az ilyen adatkészletek szűkössége kihívást jelent a nyílt forráskódú közösség számára, amely megosztott erőforrásokra támaszkodik az innováció és az együttműködés előmozdítása érdekében.

A nyílt forráskódú LMM-ek jelentős előrelépéseket tettek az elmúlt években, de növekedésüket gátolja a nagyméretű, interleaved adatkészletek korlátozott elérhetősége. Ennek az akadálynak a leküzdéséhez összehangolt erőfeszítésekre van szükség a multimodális modellek folyamatos fejlesztését és finomítását támogató átfogóbb adatkészletek összegyűjtésére, megjegyzésekkel való ellátására és közzétételére. Ezen túlmenően ezen adatkészletek létrehozása és terjesztése számos technikai és logisztikai akadály leküzdésével jár. Az adatgyűjtésnek kiterjedtnek kell lennie, és reprezentatívnak kell lennie az LMM-ek alkalmazásának különböző kontextusaiban. Az annotáció alapos megfontolást igényel annak biztosítása érdekében, hogy a kép- és szövegsorok egymáshoz igazítása oly módon történjen, amely javítja a modell tanulási képességeit. Ezenkívül az adatkészletek nyílt forráskódú biztosítása magában foglalja az adatvédelemmel és az adathasználati jogokkal kapcsolatos jogi és etikai megfontolások kezelését. A kiváló minőségű, nagyméretű multimodális interleaved adatkészletek elérhetőségének bővítése elengedhetetlen az AI-kutatás és -fejlesztés jövője szempontjából. A jelenlegi szűkösség kezelésével a mesterséges intelligencia közössége előmozdíthatja az innovációt és az együttműködést, ami hatékonyabb és sokoldalúbb LMM-ek létrehozásához vezet, amelyek képesek megbirkózni a valós világban felmerülő összetett problémákkal.

Erre a megjegyzésre építve a MINT-1T, az eddigi legnagyobb és legváltozatosabb multimodális interleaved nyílt forráskódú adatkészlet. MINT-1T: A meglévő nyílt forráskódú adatkészleteknél 10-szer nagyobb méretarány, amely egybillió szöveges tokent és 3.4 milliárd képet tartalmaz. A MINT-1T adatkészlet olyan soha nem exponált forrásokat is bemutat, mint a PDF-fájlok, ArXiv-papírok. Mivel a multimodális interleaved adatkészletek nem skálázhatók könnyen, fontos, hogy a MINT-1T adatkészlet megosszák az adatkezelési folyamatot, így mások is végezhetnek kísérleteket ilyen információban gazdag változatokon. A MINT-1T adatkészlet azt mutatja, hogy a módszere; A MINT-1T-n kiképzett LM modellek (bár valamennyire) versenyképesek a korábbi csúcstechnológiás OBELICS-ekhez képest.

MINT-1T: Multimodális adatkészlet XNUMX billió tokennel

A nagy, nyílt forráskódú előképzési adatkészletek kulcsfontosságúak voltak a kutatói közösség számára az adattervezés és az átlátható, nyílt forráskódú modellek képzése során. A szöveges tartományban a korai munkák, mint például a C4 és a The Pile, döntő szerepet játszottak abban, hogy a közösség képessé tegyék a nyílt forráskódú nagy nyelvi modellek, például a GPT-J, GPT-Neo és mások első készletét. Ezek az alapvető erőfeszítések utat nyitottak az adatszűrési módszerek és a skálázás későbbi fejlesztéséhez is. Hasonlóképpen, a kép-szöveg térben a nagyméretű nyílt forráskódú adatkészletek ösztönözték a jobb adatkezelési módszerek innovációit, például az adatszűrő hálózatokat és a T-MARS-t. Érezhető elmozdulás van a határlaboratóriumoktól a képzés felé nagy multimodális modellek (LMM) amelyek kiterjedt multimodális interleaved adatkészleteket igényelnek, amelyek szabad formájú kép- és szövegsorozatokat tartalmaznak. Ahogy a határmodellek képességei gyorsan fejlődnek, jelentős szakadék bontakozik ki a multimodális képzési adatokban a zárt és nyílt forráskódú modellek között. A jelenlegi nyílt forráskódú multimodális interleaved adatkészletek kisebbek és kevésbé változatosak, mint a csak szöveges társaik, elsősorban HTML dokumentumokból származnak, ami korlátozza az adatok szélességét és sokféleségét. Ez a korlátozás akadályozza a robusztus nyílt forráskódú LMM-ek fejlesztését, és egyenlőtlenséget teremt a nyílt és zárt forráskódú modellek képességei között.

Ennek a hiányosságnak a kiküszöbölésére a MINT-1T az eddigi legnagyobb és legváltozatosabb nyílt forráskódú multimodális interleaved adatkészletként jött létre. A MINT-1T összesen egy billió szöveges tokent és hárommilliárd képet tartalmaz, amelyek különböző forrásokból származnak, például HTML-ből, PDF-ekből és ArXiv-ből. A MINT-1T előtt a legnagyobb nyílt forráskódú adatkészlet ezen a területen az OBELICS volt, amely 115 milliárd szöveges tokent és 353 millió képet tartalmazott, amelyek mindegyike HTML-ből származott.

A MINT-1T hozzájárulásai a következők:

- Adatkezelés: A multimodális átlapolt adatok méretezése nagyobb mérnöki kihívást jelent, mint akár csak szöveges, akár kép-szöveg páros adatkészletek készítése. A sokkal nagyobb méretű dokumentumok kezelése, valamint a képek és szövegek eredeti sorrendjének megőrzése kulcsfontosságú.

- Sokféleség: A MINT-1T az első a multimodális interleaved térben, amely kiváló minőségű multimodális dokumentumokat gyűjt nagy méretekben olyan forrásokból, mint a CommonCrawl PDF és az ArXiv.

- Modellkísérletek: A kísérletek azt mutatják, hogy a MINT-1T-n betanított LMM-ek nem csak egyeznek, de potenciálisan felülmúlják a legjobb létező nyílt forráskódú adatkészleten, az OBELICS-en kiképzett modellek teljesítményét, miközben tízszeres léptéknövelést kínálnak.

MINT-1T: Az adatkészlet felépítése

A MINT-1T egy nagyszabású, nyílt forráskódú adatkészletet gyűjt, amely az interleaved dokumentumok változatosabb forrásait használja fel, például PDF-eket és ArXiv-papírokat. Ez a rész részletezi a MINT-1T módszereit a multimodális dokumentumok beszerzésére, az alacsony minőségű tartalom szűrésére, az adatok duplikációjának megszüntetésére, valamint a munkavégzésre nem biztonságos, NSFW és nemkívánatos anyagok eltávolítására. A végső adatkészlet 922 milliárd (B) HTML tokent, 106 B PDF tokent és 9 B ArXiv tokent tartalmaz.

Nagy mennyiségű multimodális dokumentumok beszerzése

HTML Pipeline

A MINT-1T az OBELICS módszerét követi a CommonCrawl WARC fájlokból az interleaved multimodális dokumentumok kinyerésére az egyes WARC bejegyzések DOM fájának elemzésével. Míg az OBELICS csak 2020 februárja és 2023 februárja között dolgozott fel dokumentumokat a CommonCrawl kiíratásai között, a MINT-1T 2017 májusától 2024 áprilisáig bővítette a dokumentumkészletet HTML dokumentumokkal (2018 októberétől 2024 áprilisáig teljes kiíratással és a korábbi évek részleges kiíratásával). Az OBELICS-hez hasonlóan a MINT-1T kiszűri azokat a dokumentumokat, amelyek nem tartalmaznak képet, több mint harminc képet, vagy olyan képeket, amelyek URL-címe nem megfelelő részkarakterláncokat tartalmaz, például logót, avatárt, pornót és xxx-et.

PDF Pipeline

A MINT-1T a CommonCrawl WAT-fájlokból származó PDF dokumentumokat 2023 februárjától 2024 áprilisáig gyűjti. Kezdetben az összes PDF-hivatkozás ezekből a kiíratásokból kinyerhető. A MINT-1T ezután a PyMuPDF használatával próbálja meg letölteni és elolvasni a PDF-fájlokat, eldobja az 50 MB-nál nagyobb (valószínűleg nagy képeket tartalmazó) és az 50 oldalnál hosszabb PDF-eket. A szöveg nélküli oldalak ki vannak zárva, a fennmaradó oldalakra pedig olvasási sorrend jön létre. Az olvasási sorrendet úgy határozzuk meg, hogy megkeressük egy oldalon az összes szövegblokk határolókeretét, a blokkokat oszlopok alapján csoportosítjuk, és balról fentről jobbra lentre rendezzük. A képek az ugyanazon az oldalon lévő szövegblokkokhoz való közelségük alapján integrálódnak a sorozatba.

ArXiv Pipeline

A MINT-1T a LaTeX forráskódból készít ArXiv interleaved dokumentumokat a TexSoup segítségével, hogy megtalálja az ábracímkéket és a papírszöveggel átlapolt képeket. Több fájlból álló papírok esetén a MINT-1T azonosítja a fő Tex fájlt, és lecseréli a bemeneti címkéket a fájlok tartalmára. A LaTeX kódot az importálás, az irodalomjegyzék, a táblázatok és a hivatkozási címkék eltávolításával tisztítja meg. Mivel az ArXiv már eleve erősen gondozott adatforrás, nem történik további szűrés és duplikáció.

Szövegminőségi szűrés

A MINT-1T elkerüli a modellalapú heurisztikák használatát a szövegszűréshez, követve a RefinedWeb, a Dolma és a FineWeb gyakorlatát. Kezdetben a nem angol nyelvű dokumentumokat a Fasttext nyelvi azonosítási modellje (0.65-ös megbízhatósági küszöb mellett) távolítja el. A pornográf és nemkívánatos tartalmak kizárása érdekében az NSFW részkarakterláncokat tartalmazó URL-eket tartalmazó dokumentumokat is eltávolítjuk. A RefinedWeb szövegszűrési módszereit alkalmazzák, különösen eltávolítják a túlzottan duplikált n-gramokat tartalmazó dokumentumokat, vagy a MassiveText szabályok alapján rossz minőségűnek minősített dokumentumokat.

Képszűrés

A PDF- és HTML-fájlok összeválogatása után a MINT-1T megpróbálja letölteni a HTML-adatkészletben található összes kép URL-jét, elveti a nem visszakereshető hivatkozásokat, és eltávolítja az érvényes képhivatkozásokat nem tartalmazó dokumentumokat. A 150 pixelnél kisebb képeket a rendszer eldobja, hogy elkerülje a zajos képeket, például az emblémákat és az ikonokat, és a 20,000 XNUMX pixelnél nagyobb képeket is eltávolítja, mivel általában nem témába vágó képeknek felelnek meg. A HTML-dokumentumok esetében a kettőnél nagyobb képarányú képeket a rendszer eltávolítja, hogy kiszűrje a rossz minőségű képeket, például a reklámszalagokat. A PDF-ek esetében a küszöbérték háromra van állítva a tudományos adatok és táblázatok megőrzése érdekében.

A fenti ábra azt mutatja, hogy a MINT-1T egyedileg tartalmazza a PDF-ekből és ArXiv-dokumentumokból származó adatokat a HTML-forrásokon kívül.

Biztonsági szűrés

- NSFW képszűrés: A MINT-1T NSFW képérzékelőt alkalmaz az adatkészletben lévő összes képre. Ha egy dokumentum egyetlen NSFW-képet tartalmaz, a teljes dokumentum el lesz vetve.

- Személyazonosításra alkalmas adatok eltávolítása: A személyes adatok kiszivárgásának kockázatának csökkentése érdekében a szöveges adatokban szereplő e-mail címek és IP-címek anonimizálásra kerülnek. Az e-maileket olyan sablonok helyettesítik, mint például "[e-mail védett]” és véletlenszerűen generált, nem működő IP-címekkel rendelkező IP-címek.

Deduplikáció

A MINT-1T minden egyes CommonCrawl pillanatfelvételen és képen belül végrehajtja a bekezdés- és dokumentumszöveg-deduplikációt, hogy eltávolítsa az ismétlődő, nem informatív képeket, például ikonokat és logókat. Az összes deduplikációs lépést minden adatforrás esetében külön hajtják végre.

Bekezdés és dokumentum deduplikációja

A Dolma módszertanát követve a MINT-1T Bloom Filtert használ a hatékony szövegduplikáció érdekében, a hamis pozitív arányt 0.01-re állítja, és minden dokumentumból deduplikálja a 13 grammos bekezdéseket (ezt dupla újsor-határoló jelzi). Ha egy dokumentum bekezdéseinek több mint 80%-a ismétlődő, akkor a teljes dokumentumot el kell dobni.

A gyakori kazánlemez szövegének eltávolítása

A bekezdések duplikálása után a MINT-1T eltávolítja a HTML-dokumentumokból a rövid, gyakori sablonmondatokat, mint például a „Ugrás a tartalomhoz” vagy a „Blogarchívum”. Ez úgy történik, hogy a CCNet gyakorlatával összhangban minden CommonCrawl-pillanatkép 2%-án pontos bekezdés-deduplikációt futtatunk, amely többnyire a gyakori sablonszöveg eltávolítását biztosítja.

A fenti ábra a MINT-1T szűrési folyamatát mutatja be, és bemutatja, hogyan távolíthatók el a tokenek a HTML-, PDF- és ArXiv-papírok adatfolyamában.

Kép deduplikáció

A MINT-1T minden CommonCrawl-pillanatfelvételen belül eltávolítja a gyakran előforduló képeket az SHA256 hashek alapján. A szigorú deduplikáció helyett csak azokat a képeket távolítja el, amelyek tíznél többször jelennek meg egy pillanatfelvételen belül, a Multimodal-C4 gyakorlatot követve. Az OBELICS-szel összhangban az egyetlen dokumentumon belüli ismétlődő képek eltávolításra kerülnek, és csak az első előfordulás marad meg.

Infrastruktúra

Az adatfeldolgozás során a MINT-1T átlagosan 2,350 CPU maghoz férhetett hozzá a 190 processzoros és 90 processzoros csomópontok keverékéből. Összesen körülbelül 4.2 millió CPU-órát használtak fel ennek az adathalmaznak az elkészítéséhez.

A MINT-1T dokumentumösszetételének összehasonlítása az OBELICS-szel

Az interleaved adatkészletek összetételének értékelése során két fő jellemzőt vizsgálunk: a szöveges tokenek dokumentumonkénti megoszlását és a dokumentumokonkénti képek számát. Ehhez az elemzéshez véletlenszerűen 50,000 1 dokumentumot vettek ki az OBELICS-ből és a MINT-XNUMXT minden adatforrásából. GPT-2 tokenizert használták a szöveges tokenek számának kiszámításához. A kiugró értékeket úgy távolítottuk el, hogy kizártuk azokat a dokumentumokat, amelyek a szöveges tokenek és képek számának 1.5 interkvartilis tartományán kívül estek. Amint az a következő ábrán látható, a MINT-1T HTML részhalmaza szorosan igazodik az OBELICS-ben látható token eloszláshoz. A PDF-ből és ArXiv-ből származó dokumentumok azonban általában hosszabbak, mint a HTML-dokumentumok, ami kiemeli a különböző forrásokból származó adatok beszerzésének előnyeit. Az 5. ábra az összes dokumentum képsűrűségét vizsgálja, és feltárja, hogy a PDF- és ArXiv-dokumentumok több képet tartalmaznak, mint a HTML-dokumentumok, és az ArXiv-minták a legsűrűbbek.

Hogyan javítják a különböző adatforrások a dokumentumok sokféleségét?

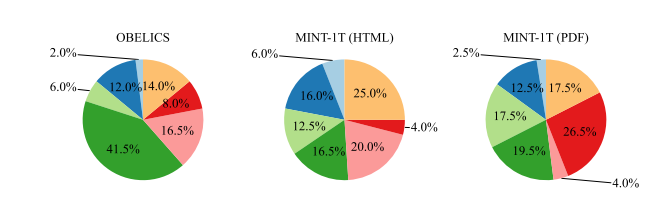

A multimodális dokumentumok HTML-n túli bővítésének fontos motivációja a domain lefedettség javítása. A lefedettség sokféleségének és mélységének számszerűsítésére egy látens dirichlet-kiosztási (LDA) modellt betanítottak 100,000 1 dokumentumon, amelyek az OBELICS adatkészletből, a MINT-1T HTML részhalmazából és a PDF részhalmazból (az ArXiv kivételével) a MINT-200T-ből származnak. kap 4 témát. Ezután a GPT-XNUMX segítségével osztályozták a szókészletet, hogy azonosítsák a domináns tartományokat – mint például az egészségügy és orvostudomány, a tudomány, az üzlet, a humán tudományok, a történelem stb. – az MMMU tartományok alapján. Az elemzés különböző tendenciákat tár fel a domain elosztásban:

- OBELICS: Ez az adatkészlet a „humán és társadalomtudományok” területén kifejezett koncentrációt mutat. Ez valószínűleg az adatszerkesztési folyamatának tudható be, amely magában foglalja a Wikipédia-cikkekre nem hasonlító dokumentumok kiszűrését, így potenciálisan megváltoztatja a terjesztést az általánosabb ismeretekre és a humán tudományokra fókuszáló tartalomra.

- A MINT-1T HTML részhalmaza: Az OBELICS-szel ellentétben a MINT-1T HTML részhalmaza nem erősen elfogult egyetlen tartomány felé sem, ami szélesebb és kiegyensúlyozottabb tartományábrázolást sugall.

- A MINT-1T PDF részhalmaza: A MINT-1T PDF dokumentumai között nagyobb arányban találhatók „Tudomány és Technológia” dokumentumok. Ez a tendencia valószínűleg a tudományos kommunikáció természetéből adódik, ahol a részletes kutatási cikkek és műszaki jelentések megosztásához a PDF-eket részesítik előnyben.

MINT-1T: Eredmények és kísérletek

A MINT-1T minden kísérlethez 50%-ban kép-szöveg feliratozási kötegekre és 50%-ban multimodális interleaved kötegekre tanítja a modellt. Legfeljebb 2048 multimodális tokent vesznek minta minden egyes átlapolt dokumentumból és 340 tokent minden kép-szöveg mintából. A Flamingóhoz hasonlóan egy „end” token is hozzáadásra kerül, hogy jelezze a szomszédos kép-szöveg sorozat végét. A képzés során az egyképes interleaved dokumentumok 50%-a véletlenszerűen átesik a többképes dokumentumokra. A kép-szöveg adatkészlet belsőleg összegyűjtött felirat-adatkészletek keverékéből áll. A modell azon képességét, hogy képes-e érvelni a multimodális átlapolt szekvenciákról, a kontextuson belüli tanulási képességei és a többképes érvelési teljesítménye alapján értékeljük.

A fenti ábra szemlélteti az egyes tartományokból származó dokumentumok százalékos arányát az MMMU-ban az OBELICS-hez és a MINT-1T részhalmazokhoz.

Kontextuson belüli tanulás: A modelleket négy és nyolc felvételes kontextus tanulási teljesítmény alapján értékelik különféle feliratozási benchmarkokon (COCO (Karpathy-teszt) és TextCaps (validáció)) és vizuális kérdésmegválaszolási adatkészleteken (VQAv2 (validáció), OK-VQA (validáció)). , TextVQA (ellenőrzés) és VizWiz (ellenőrzés)). A bemutatókat véletlenszerűen választják ki a képzési halmazból. A pontszámokat több értékelési futtatás során átlagolják, véletlenszerű demonstrációkkal, amelyek figyelembe veszik a kiválasztott felszólítások iránti érzékenységet. A legjobban teljesítők kiválasztásához minden egyes feladathoz különböző promptokat adunk meg.

Többképes érvelés: A modelleket az MMMU-n (egy- és többképes kérdéseket egyaránt tartalmazó) és a Mantis-Eval-on (mindegyik többképes kérdés) értékelik, hogy a kontextuson belüli tanulási értékeléseken túlmenően megvizsgálják a többképes érvelési képességeket.

Képzés a HTML dokumentumokról

Kezdetben a MINT-1T HTML részét az OBELICS-hez hasonlítják, mivel az OBELICS a korábbi vezető interleaved adatkészlet, amelyet szintén HTML dokumentumokból állítottak össze. Két modellt képeznek ki a MINT-1T és az OBELICS HTML részein, összesen 10B multimodális tokenhez. A kontextuson belüli tanulási teljesítményüket értékelik. Az alábbi táblázat a 4 és 8 lövés teljesítményét mutatja be általános benchmarkok alapján; a MINT-1T HTML dokumentumokon betanított modell jobban teljesít, mint az OBELICS a VQA feladatokban, de rosszabb a feliratozási referenciaértékeken. Az OBELICS átlagosan valamivel jobban teljesít, mint a MINT-1T (HTML).

PDF és ArXiv dokumentumok hozzáadása

Ezt követően a képzés a MINT-1T teljes adatforrásain zajlik, HTML, PDF és ArXiv dokumentumok keverékével. Az átlapolt dokumentumok 50%-a HTML-ből, 45%-a PDF-ből és 5%-a ArXiv-ből történik. A modell összesen 10B multimodális tokenre van kiképezve. Amint a fenti táblázatból látható, a teljes MINT-1T adatkeveréken betanított modell a legtöbb kontextuson belüli tanulási benchmarkon felülmúlja az OBELICS-t és a MINT-1T-t (HTML). Összetettebb multimodális érvelési benchmarkokon a MINT-1T modell felülmúlja az OBELICS-t MMMU-n, de rosszabb a Mantis-Eval.

Finomszemcsés trendek

Hogyan skálázódik a kontextuson belüli tanulás teljesítménye a bemutatókkal?

A kontextuson belüli tanulási teljesítményt akkor értékelik, ha egy-nyolc bemutatót kérnek. Lövésenkénti számlálónként egyetlen próba fut le minden értékelési referenciaértékhez. Amint az a következő ábrán látható, a MINT-1T-n betanított modell minden felvételen felülmúlja a MINT-1T és OBELICS HTML-részhalmazán betanított modellt. A MINT-1T (HTML) modell valamivel rosszabbul teljesít, mint az OBELICS.

Teljesítmény a feliratozás és a vizuális kérdések megválaszolása során

A következő ábra a szövegkörnyezeten belüli tanulás átlagos teljesítményét mutatja be a feliratozás és a vizuális kérdések megválaszolása (VQA) benchmarkokon. Az OBELICS felülmúlja az összes MINT-1T változatot a négyes feliratozási benchmarkokban, és valamivel rosszabbul teljesít a MINT-1T-hez képest a nyolc felvételes feliratozásnál. A MINT-1T azonban jelentősen felülmúlja mindkét alapvonalat a VQA benchmarkokon. A MINT-1T (HTML) a VQA feladatokban is felülmúlja az OBELICS-t.

Teljesítmény különböző domaineken

A különböző tartományok MINT-1T-be való bevonása a modell általánosításának javítását célozza. A korábbi ábra lebontja az MMMU teljesítményét az egyes tartományokra vonatkozóan. Az üzleti tartomány kivételével a MINT-1T jobban teljesít, mint az OBELICS és a MINT-1T (HTML). A MINT-1T tudomány és technológia tartományainak teljesítménynövekedése e tartományok ArXiv és PDF dokumentumokban való elterjedtségének tulajdonítható.

Záró gondolatok

Ebben a cikkben a MINT-1T-ről beszéltünk, amely az eddigi legnagyobb és legváltozatosabb multimodális interleaved nyílt forráskódú adatkészlet. MINT-1T: A meglévő nyílt forráskódú adatkészleteknél 10-szer nagyobb méretarány, amely egybillió szöveges tokent és 3.4 milliárd képet tartalmaz. A MINT-1T adatkészlet olyan soha nem exponált forrásokat is bemutat, mint a PDF-fájlok, ArXiv-papírok. Mivel a multimodális interleaved adatkészletek nem skálázhatók könnyen, fontos, hogy a MINT-1T adatkészlet megosszák az adatkezelési folyamatot, így mások is végezhetnek kísérleteket ilyen információban gazdag változatokon. A MINT-1T adatkészlet azt mutatja, hogy a módszere; A MINT-1T-n kiképzett LM modellek (bár valamennyire) versenyképesek a korábbi csúcstechnológiás OBELICS-ekhez képest.