Mesterséges intelligencia

EAGLE: A multimodális nagy nyelvű modellek tervezési terének feltárása kódolók keverékével

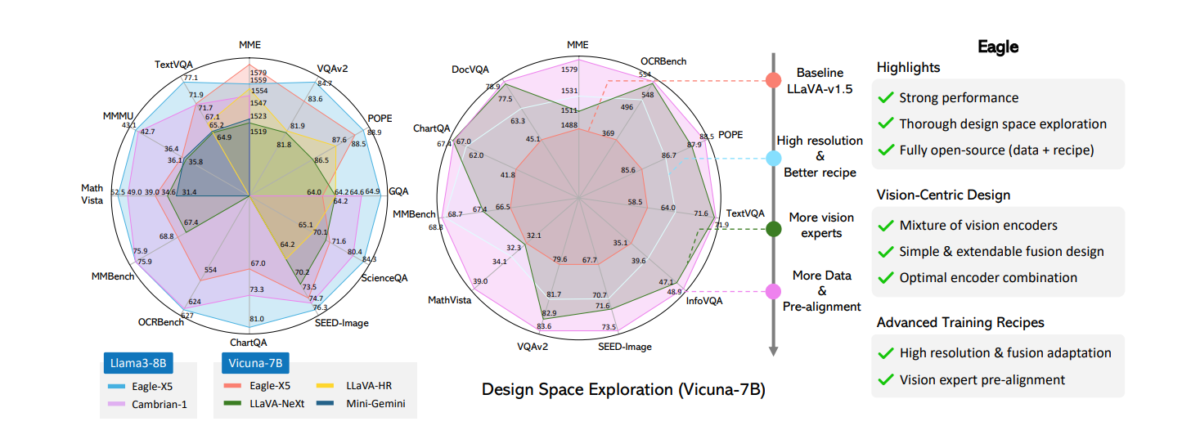

Az összetett vizuális információk pontos értelmezésének képessége a multimodális nagynyelvi modellek (MLLM-ek) kulcsfontosságú fókusza. A legújabb munkák azt mutatják, hogy a fokozott vizuális érzékelés jelentősen csökkenti a hallucinációkat, és javítja a teljesítményt a felbontás-érzékeny feladatoknál, mint például az optikai karakterfelismerés és a dokumentumelemzés. Számos közelmúltbeli MLLM ezt a látáskódolók keverékének felhasználásával éri el. Sikerük ellenére hiányoznak a szisztematikus összehasonlítások és a kritikus szempontokkal foglalkozó részletes ablációs tanulmányok, mint például a szakértők kiválasztása és a több látásszakértő integrációja. Ez a cikk az MLLM-ek tervezési terének kiterjedt feltárását tartalmazza a képkódolók és a felbontások keverékével, az Eagle keretrendszerrel, amely megpróbálja feltárni a multimodális nagy nyelvi modellek tervezési terét kódolók keverékével. Az eredmények feltárnak számos, a meglévő stratégiákban közös alapelvet, amelyek egy egyszerűsített, de hatékony tervezési megközelítéshez vezetnek. Az Eagle felfedezi, hogy a vizuális tokenek egyszerű összefűzése egy sor kiegészítő képkódolóból ugyanolyan hatékony, mint a bonyolultabb keverési architektúrák vagy stratégiák. Ezenkívül az Eagle bevezeti a Pre-Alignment-et, hogy áthidalja a látásközpontú kódolók és a nyelvi tokenek közötti szakadékot, javítva a modell koherenciáját. Az így létrejött MLLM-család, az Eagle, felülmúlja a többi vezető nyílt forráskódú modellt a főbb MLLM-benchmarkokon.

Eagle munkája a multimodális nagynyelvi modellek (MLLM-ek) általános architektúrájához kapcsolódik. A korábban említett reprezentatív nyílt forráskódú kutatások mellett az MLLM-ek egyéb figyelemre méltó családjai közé tartozik, de nem kizárólagosan, a MiniGPT-4, a Lynx, az Otter, a QwenVL, a CogVLM, a VILA, a GPT-4V, a Gemini és a Llama 3.1. Attól függően, hogy a látásjelek hogyan épülnek be a nyelvi modellbe, az MLLM-ek tágabb értelemben „keresztmodális figyelem” és „előtag-hangoló” modellekbe sorolhatók. Az előbbi a vizuális információkat az LLM-ek különböző rétegeibe injektálja keresztmodális figyelem segítségével, míg az utóbbi a vizuális tokeneket a nyelvi tokenszekvencia részeként kezeli, és közvetlenül hozzáfűzi őket szöveges beágyazásokhoz. Az Eagle modellje az előtag-tuning családba tartozik, egy LLaVA-stílusú multimodális architektúrát követve. Tekintettel arra, hogy az MLLM egy gyorsan növekvő terület, az Eagle azt javasolja, hogy részletesebb tanulmányokra és felmérésekre hivatkozzon további meglátásokért.

Az Eagle munkája szorosan kapcsolódik az MLLM-ek látáskódolóinak fejlesztésére irányuló kutatásokhoz. A korai munkák általában a látás-nyelv igazítási feladatokra előre kiképzett látáskódolókat alkalmaztak, mint például a CLIP és az EVA-CLIP. Erősebb látáskódolókat, például a SigLIP-et és az InternVL-t javasolták, hogy javítsák a látásnyelvi feladatokat jobb tervezéssel, nagyobb modellméretekkel és hatékonyabb képzési receptekkel. Mivel a modelleket gyakran alacsony felbontású képekre készítik elő, és előfordulhat, hogy nem képesek finom szemcsés részletek kódolására, gyakran nagyobb felbontású adaptációt hajtanak végre az MLLM bemeneti felbontás növelése érdekében. A nagyobb felbontású adaptáció mellett az olyan modellek, mint a LLaVA-NeXT, LLaVA-UHD, Monkey, InternLM-XComposer és InternVL, csempézést vagy adaptív csempézést használnak a nagy felbontású bevitel kezelésére, ahol a képeket kisebb felbontású foltokra osztják, és külön dolgozzák fel. Míg a nagyobb felbontás kezelését további látásszakértők bevonása teszi lehetővé, ez a megközelítés némileg eltér a csempézési technikáktól, bár mindkettő kompatibilis és kombinálható.

EAGLE: Kódolók keverékének használata a multimodális LLM-ek tervezési területeinek felfedezéséhez

A nagy nyelvi modellek (LLM) sikere jelentős érdeklődést váltott ki vizuális észlelési képességeik lehetővé tétele iránt, lehetővé téve számukra, hogy a való világban lássanak, megértsenek és gondolkodjanak. Ezek lényegében multimodális nagynyelvi modellek (MLLM-ek) egy tipikus kialakítás, ahol a képeket a látáskódolók vizuális tokenek sorozatává alakítják, és hozzáfűzik a szöveges beágyazásokhoz. A CLIP-et gyakran választják látáskódolónak, mert vizuális megjelenítése a kép-szöveg párokra való előzetes betanítással igazodik a szövegtérhez. Az architektúrától, a képzési receptektől és a látásjelzők nyelvi modellbe való beillesztésének módjától függően az MLLM-ek figyelemre méltó családjai közé tartozik a Flamingo, a BLIP, a PaLI, a PaLM-E és az LLaVA. A legtöbb ilyen modell viszonylag alacsony bemeneti felbontást tart fenn az előre betanított látáskódolók és az LLM szekvencia hosszának korlátai miatt. Az Eagle munkája szorosan illeszkedik azokhoz a modellekhez, amelyek több látáskódolót használnak a jobb észlelés érdekében. A Mini-Gemini és a LLaVA-HR azt javasolja, hogy a nagy felbontású vizuális funkciókat alacsony felbontású vizuális tokenekkel egyesítsék. A feloldási problémákon túl ezek az előre kiképzett látáskódolók nem rendelkeznek olyan speciális képességekkel, mint például a szövegolvasás vagy az objektumok lokalizálása. Ennek megoldására különféle modellek integrálják a különböző látási feladatokra előre kiképzett látáskódolókat, hogy javítsák a látáskódoló képességeit.

Például az olyan modellek, mint a Mousi és a Brave, a csatorna vagy a token iránya mentén összefűzve egyesítik a különböző látáskódolókból származó vizuális tokeneket. A RADIO egy több tanáros desztillációs módszert vezet be, amely a különböző látáskódolók képességeit egyetlen modellben egyesíti. A MoAI, az IVE és a Prismer a látásszakértők eredményeit, például az OCR-t, az észlelést vagy a mélységbecslést is felhasználja további információk kiegészítésére az MLLM-ek számára a válaszok generálásához. A MoVA kidolgoz egy útválasztó hálózatot, amely az adott kép és utasítások alapján optimális látásmodellt rendel hozzá.

A legújabb tanulmányok kimutatták, hogy az erősebb látáskódoló kialakítások fontosak a csökkentéshez MLLM hallucinációk és a teljesítmény javítása olyan felbontás-érzékeny feladatoknál, mint az optikai karakterfelismerés (OCR). Számos munka foglalkozik a látáskódoló képességének növelésével, akár az edzés előtti adatok és paraméterek felskálázásával, akár a képek kis felbontású foltokra való felosztásával. Ezek a megközelítések azonban gyakran nagy képzési erőforrásigényt követelnek meg. Hatékony, de hatékony stratégia a különböző feladatokra és bemeneti felbontásokra előre betanított vizuális kódolók keverése, akár a nagyobb felbontású kódolók CLIP-kódolóval való egyesítése, a különböző kódolók jellemzőinek egymás utáni hozzáfűzése, vagy bonyolultabb fúziós és útválasztási stratégiák alkalmazása az előnyök maximalizálása érdekében. különböző kódolók. Ez a „látás-szakértők keveréke” megközelítés hatékonynak bizonyult, bár még mindig hiányzik a szigorú ablációval végzett tervezési terület részletes tanulmányozása, ami arra ösztönzi az Eagle-t, hogy újra meglátogassa ezt a területet. A kulcskérdések továbbra is fennállnak: milyen látáskódoló-kombinációkat válasszunk, hogyan vegyítsük össze a különböző szakértőket, és hogyan állítsuk be a képzési stratégiákat több látáskódolóval.

E kérdések megválaszolása érdekében az Eagle szisztematikusan vizsgálja a látás-kódolók keverékének tervezési terét az MLLM jobb észlelése érdekében. Ennek a tervezési területnek a feltárása a következő lépésekből áll: 1) Különféle látáskódolók összehasonlítása és nagyobb felbontású adaptáció keresése; 2) „almától almáig” való összehasonlítás a látáskódoló fúziós stratégiái között; 3) A többszörös látáskódolók optimális kombinációjának fokozatos azonosítása; 4) A látásszakértői előzetes összehangolás és az adatok keverékének javítása. A feltárás lépéseit a következő kép szemlélteti.

Az Eagle tanulmánya a különböző feladatokra és felbontásokra előképzett látáskódolók teljesítményét fedi le, mint például a látás-nyelv igazítás, az önfelügyelt tanulás, az észlelés, a szegmentálás és az OCR. A körmérkőzéses megközelítést alkalmazva az Eagle az alap CLIP kódolóval kezdi, és egyszerre egy további szakértőt ad hozzá, kiválasztva azt a szakértőt, aki minden körben a legjobb fejlődést biztosítja.

Noha Eagle munkája nem az első, amely több látáskódolót alkalmaz az MLLM-ekben, a szisztematikus tanulmány számos kulcsfontosságú megállapításhoz vezet ebben a beállításban:

- A látáskódolók feloldása az MLLM képzés során számít. Ez ellentétben áll az olyan modellekkel, mint az LLaVA és mások, amelyek több látáskódolót vagy tanárt vesznek figyelembe, ahol a látáskódolók lefagyasztása általános gyakorlat.

- Néhány nemrégiben javasolt fúziós stratégia nem mutat jelentős előnyöket. Ehelyett az egyszerű csatornaösszefűzés egyszerű, de versenyképes fúziós stratégiaként jelenik meg, amely a legjobb hatékonyságot és teljesítményt kínálja.

- További látásszakértők bevonása következetes előnyökhöz vezet. Ez ígéretes utat jelent az MLLM-felfogás szisztematikus javításához, eltekintve az egyedi kódolók bővítésétől. A javulás különösen szembetűnő, ha a látáskódolók fel vannak oldva.

- Az előigazítási szakasz kulcsfontosságú. Az Eagle bevezet egy előigazítási szakaszt, ahol a nem szöveghez igazított látásszakértőket egyénileg finomhangolják egy fagyasztott LLM-mel, mielőtt közösen kiképzik őket. Ez a szakasz jelentősen javítja az MLLM teljesítményét a kevert látás-kódoló kialakítás mellett.

Eagle: Módszertan és építészet

Ellentétben a korábbi módszerekkel, amelyek a látáskódolók új fúziós stratégiáira vagy architektúráira összpontosítottak, az Eagle célja egy minimalista kialakítás azonosítása a különböző látáskódolók egyesítéséhez, amelyet részletes ablációk támogatnak és eltávolítanak minden szükségtelen összetevőt. Ahogy az alábbi ábrán is látható, az Eagle azzal kezdi, hogy az alapvető CLIP kódolót kiterjeszti a különböző architektúrákkal, előképzési feladatokkal és felbontásokkal rendelkező látásszakértőkre. Ezekkel a szakértőkkel az Eagle összehasonlítja a különböző fúziós architektúrákat és módszereket, és megvizsgálja, hogyan lehet optimalizálni az előképzési stratégiákat több kódolóval.

Végül az Eagle egyesíti az összes megállapítást, és kiterjeszti a megközelítést több szakértő látáskódolóra is, amelyek különböző felbontással és területi ismeretekkel rendelkeznek. Az 1.5 595 kép-szöveg párból álló LLaVA-1.5-tel azonos előképzési adatok felhasználásával az Eagle a felügyelt finomhangolási szakaszba lép azáltal, hogy egy sor feladatból adatokat gyűjt, és azokat multimodális beszélgetésekké alakítja, beleértve az LLaVA-4-öt, Laion-GPT4V, ShareGPT-2V, DocVQA, synDog-EN, ChartQA, DVQA és AI934D, ami XNUMX XNUMX mintát eredményez.

A modellt először kép-szöveg párokkal készítik elő egy korszakra, 256-os kötegmérettel, ahol a teljes modell le van fagyasztva, és csak a projektor réteg frissül. A második szakaszban a modell finomhangolása az egy korszakra vonatkozó felügyelt finomhangolási adatokon történik 128-as kötegmérettel. Ehhez a feltáráshoz az Eagle a Vicuna-7B-t használja alapul szolgáló nyelvi modellként. A tanulási arány az első szakaszban 1e-3, a második szakaszban pedig 2e-5.

Erősebb CLIP kódoló

Az Eagle a CLIP modellel kezdi a felfedezést, mivel sokak számára ez lett az elsődleges választás MLLM-ek. Míg a CLIP modellekről ismert, hogy javítják a multimodális feladatokat, korlátaik is jól dokumentáltak. Például sok létező MLLM általában az előre betanított CLIP felbontásokat (például 224 × 224 vagy 336 × 336) használja bemeneti felbontásként. Ezekben az esetekben a kódolóknak gyakran nehézségekbe ütköznek a finom szemcsés részletek rögzítése, amelyek fontosak a felbontás-érzékeny feladatokhoz, mint például az OCR és a dokumentumértés.

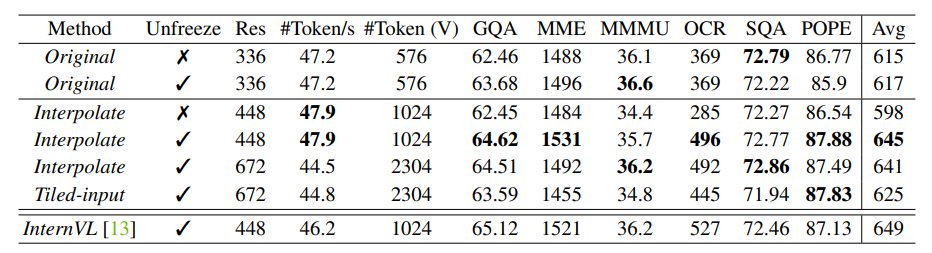

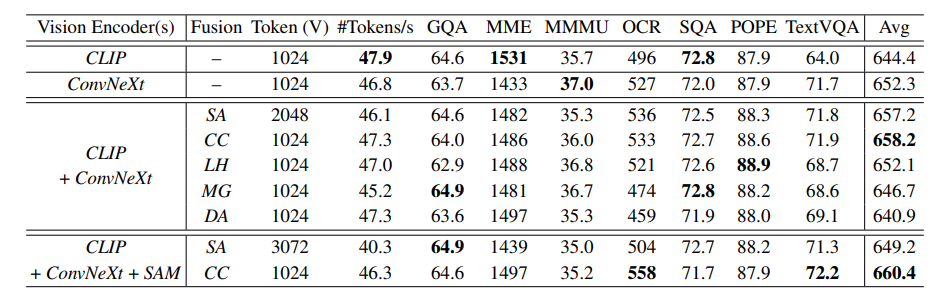

A megnövelt bemeneti felbontás kezelésére általánosan elterjedt megközelítés a csempézés, ahol a bemeneti képeket csempékre osztják, és külön kódolják. Egy másik egyszerűbb módszer a bemeneti felbontás közvetlen felskálázása és a látótranszformátor modell helyzetbeágyazásainak interpolálása, ha szükséges. Az Eagle összehasonlítja ezt a két megközelítést a fagyasztott és nem fagyasztott látáskódolókkal, különböző felbontásokban, a fenti táblázatban szereplő eredményekkel. A megállapítások a következőképpen foglalhatók össze:

- A CLIP kódoló lefagyásának feloldása jelentős javulást eredményez, ha nagyobb MLLM bemeneti felbontásra interpolál, amely eltér a CLIP edzés előtti felbontástól, anélkül, hogy a teljesítmény romlana, ha a felbontások változatlanok maradnak.

- A CLIP kódoló lefagyása és közvetlenül a magasabb MLLM bemeneti felbontáshoz való igazítása jelentősen rontja a teljesítményt.

- Az összehasonlított stratégiák közül a 448 × 448-as direkt interpoláció egy lefagyott CLIP kódolóval hatékonynak és hatékonynak bizonyult a teljesítmény és a költség szempontjából.

- A legjobb CLIP kódoló az InternVL-hez közeli teljesítményt ér el, annak ellenére, hogy sokkal kisebb modell (300M vs. 6B), kevesebb előképzési adattal.

Érdemes megjegyezni, hogy a CLIP-448 lehetővé teszi az Eagle számára, hogy megfeleljen a beállításnak az LLaVA-HR-rel és az InternVL-vel, ahol a CLIP kódolók hasonlóképpen 448 × 448-as bemeneti és kimeneti 1024 patch token fogadására alkalmasak. A további vizsgálatokhoz az Eagle ezt az egyszerű stratégiát követi: növeli a bemeneti felbontást és feloldja a látáskódolót az edzés során.

Eagle megjegyzi, hogy a létező népszerű fúziós stratégiák, tervezési változataik ellenére, nagyjából a következő kategóriákba sorolhatók:

- Sorozat Hozzáfűzés: Közvetlenül hozzáfűzi a különböző gerinchálózatokból származó vizuális tokenekeket hosszabb sorozatként.

- Csatorna összefűzése: A vizuális tokenek összefűzése a csatorna dimenziója mentén a sorozat hosszának növelése nélkül.

- LLaVA-HR: Nagy felbontású funkciók injektálása kis felbontású látáskódolókba vegyes felbontású adapter segítségével.

- Mini-Gemini: A CLIP tokenek használata kis felbontású lekérdezésekként egy másik, nagy felbontású képkódoló keresztezéséhez az azonos helyen lévő helyi ablakokban.

- Deformálódó figyelem: A Mini-Gemini tetején bevezetett új alapvonal, ahol a vaníliaablak-figyelmet felváltja a deformálható figyelem.

Ahelyett, hogy egy kivetítőt betanítanánk több látásszakértő egyidejű összehangolására, mint az LLaVA eredeti előképzési stratégiájában, először az egyes szakértők reprezentációját egy kisebb nyelvi modellel (a gyakorlatban Vicuna-7B) igazítjuk a következő token előrejelzési felügyelet segítségével. Amint az alábbi ábrán látható, az előigazítással a teljes képzési folyamat három lépésből áll: 1) minden előre képzett látásszakértő képzése saját projektorral az SFT-adatokon, miközben a nyelvi modellt lefagyva tartjuk; 2) az első lépéstől fogva az összes látásszakértő egyesítése, és csak a projektor betanítása kép-szöveg páros adatokkal; 3) a teljes modell betanítása az SFT adatokra.

Eagle: Kísérletek és eredmények

Stratégiáinak aprólékos kidolgozása után az Eagle a következő elveket állapította meg a modellhez: (1) több látásszakértő integrálása optimalizált képzési recepttel; (2) több látásszakértő kombinálása közvetlen csatornaösszefűzéssel; (3) a látásszakértők külön-külön történő előképzése előzetes összehangolással. Ebben a részben az Eagle modellek előnyeinek további bemutatása érdekében további képzési adatok kerülnek beépítésre, és az Eagle-t összehasonlítják a jelenlegi legmodernebb MLLM-ekkel a különböző feladatok során. Az Eagle a Vicuna-v1.5-7B, Llama3-8B és Vicuna-v1.5-13B nyelvi modelleket használja. A látáskódolók esetében a 2.6. szakasz eredményei alapján az Eagle modelleket Eagle-X4-ként jelölik, amely négy látáskódolót tartalmaz: CLIP, ConvNeXt, Pix2Struct és EVA-02, valamint Eagle-X5, amely egy további SAM látást tartalmaz. kódoló.

Vizuális kérdésmegválaszolási feladatok

Az Eagle összehasonlítja a modellsorozatot három Visual Question Answering (VQA) benchmark között, köztük a GQA, VQAv2 és VizWiz között. Ahogy a következő táblázat mutatja, az Eagle-X5 a legkorszerűbb teljesítményt nyújtja a GQA és VQAv2 rendszereken, kiemelve a további látásszakértők bevonásának előnyeit.

OCR és diagramértési feladatok

Az Eagle OCR-, dokumentum- és diagrammegértési képességeinek értékeléséhez a modellt az OCRBench, a TextVQA és a ChartQA szabványokon tesztelik. Amint a fenti táblázatból látható, az Eagle jelentősen felülmúlja a versenytársakat a TextVQA-ban, kihasználva a nagyfelbontású architektúráját és a különböző képkódolók integrálását. Figyelemre méltó, hogy az Eagle egyszerű dizájnnal rendelkezik, amely akár 1024 tokent is támogat, anélkül, hogy a képek bonyolult mozaikbontását igényelné.

Az alábbi ábra példákat mutat be az OCR- és a dokumentumértelmezési esetekre. A nagy felbontású adaptációval és több látásszakértő bevonásával az Eagle képes azonosítani a képeken belüli kis szövegeket, és a felhasználói utasítások alapján pontosan kinyerni az információkat.

Annak érdekében, hogy jobban megértsük az egyéb látási feladatokra előképzett szakértők bemutatásának előnyeit, a következő ábra egy olyan modell eredményeit jeleníti meg, amely csak ConvNeXt és CLIP látáskódolót tartalmaz, összehasonlítva az Eagle-X5 eredményeivel. A látáskódolók teljes készletével a modell sikeresen kijavítja a hibákat, bizonyítva, hogy még akkor is, ha nagy felbontású látáskódolókkal vannak felszerelve, amelyek a látás-nyelv igazítására előzetesen kiképzettek, az Eagle képességeit tovább erősíti a sokféle látásra előképzett további látásszakértők integrálása. feladatokat.

Multimodális benchmark értékelés

Az Eagle-t hét benchmark alapján értékelik az MLLM-ek számára, hogy különböző nézőpontokból demonstrálják képességeit, köztük az MME, az MMBench, a SEED, a MathVista, az MMMU, a ScienceQA és a POPE. Pontosabban, az MME, az MMBench és a SEED a különféle valós feladatok általános teljesítményét értékeli, beleértve az érvelést, a felismerést, a tudást és az OCR-t. Az MMMU a főiskolai szintű tudást igénylő, különböző területeken felmerülő kihívásokra összpontosít. A pápa értékeli az MLLM-ek vizuális hallucinációit. Az ebben az értékelésben használt mérőszámok megfelelnek a referenciaértékek alapértelmezett beállításainak. Az Eagle jelenti az MME észlelési pontszámát, az MMBench en_dev felosztását, a SEED képfelosztását, a MathVista teszt-mini felosztását, az MMMU val felosztását, a POPE F1-pontszámát és a ScienceQA képpontszámát, biztosítva az igazodást. más modellek jelentett pontszámaival.

Záró gondolatok

Ebben a cikkben az Eagle-ről beszéltünk, amely a látáskódolók multimodális nagynyelvi modellekbe való integrálásának tervezési területének mélyreható elemzése. Az új fúziós paradigmák tervezésére összpontosító korábbi munkákkal ellentétben az Eagle úgy találja, hogy a szisztematikus tervezési döntések számítanak, és számos hasznos technikát fedez fel. Az Eagle lépésről lépésre optimalizálja az egyes látáskódolók képzési receptjét, azonosít egy kiterjeszthető és hatékony fúziós módszert, és fokozatosan egyesíti a látáskódolókat a különböző tartományi ismeretekkel. Az eredmények rávilágítanak az alapvető tervezési térmegfontolások kritikus fontosságára.