Umjetna inteligencija

UniTune: Googleova alternativna neuronska tehnika za uređivanje slika

Čini se da Google Research napada uređivanje slika temeljeno na tekstu s brojnih frontova i, vjerojatno, čeka da vidi što je 'potrebno'. Na tragu ovotjednom izdanju svojeg Slikovni papir, pretraživački div predložio je dodatnu metodu temeljenu na latentnoj difuziji za izvođenje inače nemogućih uređivanja slika putem tekstualnih naredbi temeljenih na umjetnoj inteligenciji, ovaj put tzv. UniTune.

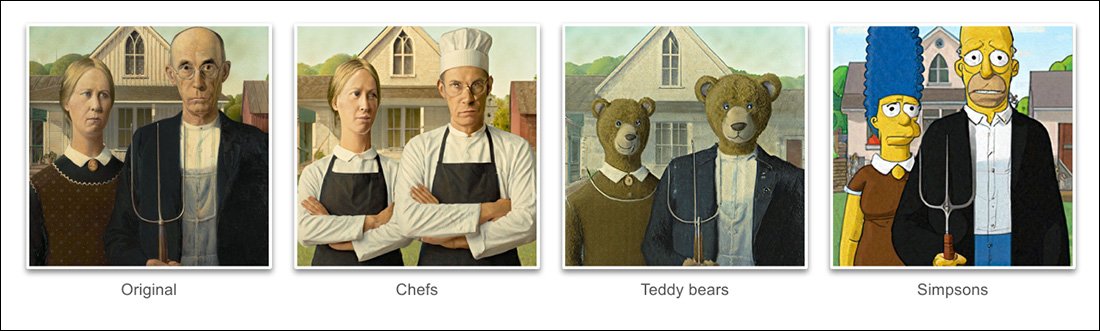

Na temelju primjera danih u projektu novom papiru, UniTune je postigao izvanredan stupanj prevazilaženje teškoća semantičke poze i ideje iz stvarnog sadržaja čvrste slike:

UniTuneovo upravljanje semantičkom kompozicijom je izvanredno. Obratite pažnju na to kako u gornjem redu slika lica dvoje ljudi nisu bila iskrivljena izvanrednom transformacijom na ostatku izvorne slike (desno). Izvor: https://arxiv.org/pdf/2210.09477.pdf

Kao što su ljubitelji Stable Diffusion do sada već naučili, primjena izmjena na djelomične dijelove slike bez negativnog mijenjanja ostatka slike može biti nezgodna, ponekad nemoguća operacija. Iako popularne distribucije kao što su AUTOMATSKI1111 može stvoriti maske za lokalna i ograničena uređivanja, proces je mukotrpan i često nepredvidiv.

Očigledan odgovor, barem stručnjaku za računalni vid, jest umetanje sloja semantička segmentacija koji je sposoban prepoznati i izolirati objekte na slici bez intervencije korisnika, i doista, u posljednje je vrijeme bilo nekoliko novih inicijativa u tom smjeru razmišljanja.

Drugi mogućnost za zaključavanje neurednih i zamršenih neuralnih operacija uređivanja slika je iskoristiti OpenAI-jev utjecajni Contrastive Language–Image Pre-trening (CLIP), koji je u središtu modela latentne difuzije kao što su DALL-E 2 i Stable Diffusion, da djeluje kao filtar u trenutku kada je model teksta u sliku spreman za slanje interpretiranog rendera natrag korisniku . U tom kontekstu, CLIP bi trebao djelovati kao nadzorni modul i modul za kontrolu kvalitete, odbijajući krivo oblikovane ili na drugi način neprikladne prikaze. Ovo je koji će biti pokrenut (Discord veza) na Stability.ai DreamStudio portalu koji pokreće API.

Međutim, budući da je CLIP nedvojbeno i krivac i rješenje u takvom scenariju (jer je u biti također informirao način na koji je slika evoluirala), i budući da hardverski zahtjevi mogu premašiti ono što je vjerojatno lokalno dostupno krajnjem korisniku, ovaj pristup možda nije idealan.

Komprimirani jezik

Predloženi UniTune umjesto toga 'fino podešava' postojeći model difuzije – u ovom slučaju, Googleov vlastiti Imagen, iako istraživači navode da je metoda kompatibilna s drugim arhitekturama latentne difuzije – tako da se u njega ubacuje jedinstveni token koji se može pozvati uključivanjem u tekstualni upit.

Rečeno, ovo zvuči kao Google kabina za snove, trenutno opsesija među obožavateljima i programerima Stable Diffusion, koji može ubaciti nove likove ili objekte u postojeću kontrolnu točku, često u manje od sat vremena, na temelju samo nekoliko izvornih slika; ili pak kao Tekstualna inverzija, koji stvara 'sidecar' datoteke za kontrolnu točku, koje se zatim tretiraju kao da su izvorno uvježbane u model, i može iskoristiti vlastite goleme resurse modela modificiranjem njegovog tekstualnog klasifikatora, što rezultira malenom datotekom (u usporedbi s minimalno 2 GB smanjenih kontrolnih točaka DreamBootha).

Zapravo, tvrde istraživači, UniTune je odbacio oba ova pristupa. Otkrili su da je Textual Inversion izostavio previše važnih detalja, dok je DreamBooth 'lošiji učinak i dulje mu je trebalo' nego rješenje na koje su se konačno odlučili.

Bez obzira na to, UniTune koristi isti enkapsulirani semantički 'metaprompt' pristup kao DreamBooth, s uvježbanim promjenama koje pozivaju jedinstvene riječi koje je odabrao trener, a koje se neće sukobljavati ni s jednim pojmom koji trenutno postoji u mukotrpno uvježbanom modelu javne objave.

'Da bismo izvršili operaciju uređivanja, uzorkujemo fino podešene modele s promptom “[rare_tokens] edit_prompt” (npr. “beikkpic two dogs in a restaurant” ili “beikkpic a minion”).'

Proces

Iako je mistificirajuće zašto bi dva gotovo identična dokumenta, u smislu njihove krajnje funkcionalnosti, trebala stići iz Googlea u istom tjednu, postoji, unatoč velikom broju sličnosti između dvije inicijative, barem jedna jasna razlika između UniTunea i Imagica – potonji koristi 'nekomprimirane' upute prirodnog jezika za vođenje operacija uređivanja slika, dok UniTune trenira u jedinstvenim tokenima u stilu DreamBooth.

Stoga, ako ste uređivali s Imagicom i željeli izvršiti transformaciju ove prirode...

Iz dokumenta UniTune – UniTune se suprotstavlja Googleovom omiljenom konkurentskom okviru za neuronsko uređivanje, SDEdit. Rezultati UniTune-a su krajnje desno, dok se procijenjena maska vidi na drugoj slici slijeva.

.. u Imagicu biste unijeli 'treća osoba, sjedi u pozadini, kao slatko krzneno čudovište'.

Ekvivalentna naredba UniTune bila bi 'Tip straga kao [x]', Gdje x je koja god čudna i jedinstvena riječ bila vezana za fino istrenirani koncept povezan s likom krznenog čudovišta.

Dok se brojne slike unose ili u DreamBooth ili Textual Inversion s namjerom stvaranja apstrakcije u stilu deepfakea kojoj se može naložiti mnogo poza, i UniTune i Imagic umjesto toga unose jednu sliku u sustav – izvornu, netaknutu sliku.

Ovo je slično načinu na koji rade mnogi alati za uređivanje koji se temelje na GAN-u posljednjih nekoliko godina – pretvaranjem ulazne slike u latentne kodove u latentnom prostoru GAN-a i zatim adresiranjem tih kodova i slanjem u druge dijelove latentnog prostora. prostor za modifikaciju (tj. unos slike mlade tamnokose osobe i njezino projiciranje kroz latentne kodove povezane sa 'starom' ili 'plavušom', itd.).

Međutim, rezultati u modelu difuzije i ovom metodom prilično su zapanjujuće točni u usporedbi i daleko manje dvosmisleni:

Proces finog podešavanja

Metoda UniTune u biti šalje izvornu sliku kroz difuzijski model sa skupom uputa o tome kako je treba modificirati, koristeći golema spremišta dostupnih podataka obučenih u model. Zapravo, to možete učiniti upravo sada sa Stable Diffusion's img2img funkcionalnost – ali ne bez iskrivljavanja ili na neki način mijenjanja dijelova slike koje biste radije zadržali.

Tijekom procesa UniTune, sustav je fino podešavanjed, što znači da UniTune prisiljava model da nastavi s uvježbavanjem, s većinom odmrznutih slojeva (vidi dolje). U većini slučajeva, fino podešavanje će pokvariti sveukupno opći gubitke vrijednosti teško stečenog modela visokih performansi u korist ubacivanja ili rafiniranja nekog drugog aspekta koji se želi stvoriti ili poboljšati.

Međutim, s UniTuneom se čini da će kopija modela na koju se djeluje, iako može težiti nekoliko gigabajta ili više, biti tretirana kao jednokratna kolateralna 'ljuska' i odbačena na kraju procesa, nakon što je služila jednom cilju. Ova vrsta povremene tonaže podataka postaje svakodnevna kriza pohrane za obožavatelje DreamBootha, čiji vlastiti modeli, čak i kada su smanjeni, nemaju manje od 2 GB po subjektu.

Kao i kod Imagica, glavno ugađanje u UniTuneu događa se na donja dva od tri sloja u Imagenu (baza 64px, 64px>256px i 256px>1024px). Za razliku od Imagica, istraživači vide neku potencijalnu vrijednost u optimiziranju podešavanja i za ovaj posljednji i najveći sloj super-razlučivosti (iako to još nisu pokušali).

Za najniži sloj od 64 px, model je pristran prema osnovnoj slici tijekom obuke, s više duplikata parova slike/teksta unesenih u sustav za 128 ponavljanja pri veličini serije od 4, i s Adafaktor kao funkcija gubitka, koja radi sa stopom učenja od 0.0001. Iako je T5 koder sam zamrznut tijekom ovog finog podešavanja, također je zamrznut tijekom primarne obuke Imagena

Gornja operacija se zatim ponavlja za sloj od 64>256 px, koristeći isti postupak povećanja buke koji je korišten u izvornom obučavanju Imagena.

Uzorkovanje

Postoje mnoge moguće metode uzorkovanja pomoću kojih se napravljene promjene mogu izvući iz fino podešenog modela, uključujući vođenje bez klasifikatora (CFG), oslonac također stabilne difuzije. CFG u osnovi definira do koje mjere model može slobodno 'slijediti svoju maštu' i istraživati mogućnosti renderiranja – ili pak, pri nižim postavkama, do koje mjere bi se trebao pridržavati podataka izvora unosa i raditi manje opsežne ili dramatične promjene .

Poput Textual Inversion (malo manje s DreamBoothom), UniTune je podložan primjeni različitih grafičkih stilova na izvorne slike, kao i fotorealističnijim izmjenama.

Istraživači su također eksperimentirali s SDEditTehnika 'kasnog početka', gdje se sustav potiče da sačuva izvorne detalje tako što je samo djelomično 'šum' od samog početka, nego zadržavajući svoje bitne karakteristike. Iako su istraživači ovo koristili samo na najnižem sloju (64 px), vjeruju da bi to mogla biti korisna pomoćna tehnika uzorkovanja u budućnosti.

Istraživači su također iskorištavali prompt-to-prompt kao dodatna tehnika temeljena na tekstu za uvjetovanje modela:

'U postavci "od upita do upita" otkrili smo da je tehnika koju zovemo Brzo navođenje osobito korisna za ugađanje vjernosti i izražajnosti.

'Prompt Guidance je sličan Classifier Free Guidance osim što je osnovna linija drugačiji prompt umjesto bezuvjetnog modela. Ovo vodi model prema delti između dva upita.'

Međutim, promptno vođenje, navode autori, bilo je potrebno samo povremeno u slučajevima kada CFG nije postigao željeni rezultat.

Još jedan novi pristup uzorkovanju na koji smo naišli tijekom razvoja UniTunea bio je interpolacija, gdje su područja slike dovoljno jasna da su i izvorna i izmijenjena slika vrlo slične kompozicije, što omogućuje korištenje 'naivnije' interpolacije.

Interpolacija može učiniti zahtjevnije procese UniTunea suvišnima u slučajevima kada su područja koja treba transformirati diskretna i dobro marginirana.

Autori sugeriraju da bi interpolacija potencijalno mogla funkcionirati tako dobro, za veliki broj ciljnih izvornih slika, da bi se mogla koristiti kao zadana postavka, te također opažaju da ima moć utjecati na izvanredne transformacije u slučajevima kada složene okluzije ne rade treba pregovarati intenzivnijim metodama.

UniTune može izvoditi lokalna uređivanja sa ili bez maski za uređivanje, ali također može jednostrano odlučiti gdje pozicionirati uređivanja, s neobičnom kombinacijom interpretativne moći i robusne esencijalizacije izvornih ulaznih podataka:

Na gornjoj slici u drugom stupcu, UniTune, zadužen za umetanje 'crvenog vlaka u pozadinu', postavio ga je na prikladnu i autentičnu poziciju. Obratite pažnju na druge primjere kako se semantički integritet izvorne slike održava čak i usred iznimnih promjena u sadržaju piksela i temeljnim stilovima slika.

skrivenost

Iako će prva iteracija bilo kojeg novog sustava biti spora i iako je moguće da će ili uključenost zajednice ili korporativna predanost (obično nije oboje) na kraju ubrzati i optimizirati rutinu koja zahtijeva mnogo resursa, i UniTune i Imagic izvode neke prilično velike manevre strojnog učenja kako bi se stvorila ova nevjerojatna uređivanja, te je upitno u kojoj bi se mjeri takav proces gladan resursa ikada mogao smanjiti na domaću upotrebu, umjesto pristupa vođenog API-jem (iako bi ovo drugo moglo biti poželjnije Googleu ).

Trenutačno povratni put od ulaza do rezultata traje oko 3 minute na T4 GPU-u, s dodatnih 30 sekundi za zaključivanje (prema bilo kojoj rutini zaključivanja). Autori priznaju da je ovo velika latencija i da se teško može kvalificirati kao 'interaktivan', ali također napominju da model ostaje dostupan za daljnja uređivanja nakon početnog podešavanja, sve dok korisnik ne završi s procesom, što skraćuje vrijeme za uređivanje .

Prvi put objavljeno 21. listopada 2022.