Umjetna inteligencija

Glasovi manjina 'filtrirani' iz Googleovih modela obrade prirodnog jezika

Prema novom istraživanju, jedan od najvećih dostupnih skupova podataka obrade prirodnog jezika (NLP) opsežno je 'filtriran' kako bi se uklonili crni i hispanoamerički autori, kao i materijal povezan s gej i lezbijskim identitetima te izvorni podaci koji se bave brojnim drugi marginalni ili manjinski identiteti.

Skup podataka korišten je za obuku Googlea Transformator prekidača i T5 model, a kurirao ga je sam Google AI.

U izvješću se tvrdi da je Kolosalno čisto puzano tijelo ('C4') skup podataka, koji sadrži 156 milijardi tokena skupljenih s više od 365 milijuna internetskih domena, i podskup je masivne baze podataka skupljane Common Crawl, opsežno je (algoritamski) filtriran kako bi se isključio 'uvredljiv' i 'otrovan' sadržaj , te da su filtri korišteni za destiliranje C4 učinkovito ciljali sadržaj i raspravu manjinskih skupina.

Izvještaj navodi:

'Naše ispitivanje izuzetih podataka sugerira da dokumenti povezani s crnim i hispanoameričkim autorima i dokumenti koji spominju seksualnu orijentaciju imaju znatno veću vjerojatnost da će biti isključeni filtriranjem popisa blokiranih C4.EN-a te da su mnogi izuzeti dokumenti sadržavali neuvredljiv ili neseksualan sadržaj ( npr. zakonodavne rasprave o istospolnim brakovima, znanstveni i medicinski sadržaj).'

U radu se navodi da otkrića pogoršavaju postojeću rasnu nejednakost temeljenu na jeziku u NLP sektoru, kao i stigmatiziranje LGBTQ+ identiteta. Nastavlja se:

'Osim toga, izravna posljedica uklanjanja takvog teksta iz skupova podataka koji se koriste za obuku jezičnih modela je da će modeli imati lošu izvedbu kada se primjenjuju na tekst od i o osobama s manjinskim identitetom, učinkovito ih isključujući iz prednosti tehnologije poput strojnog prevođenja ili pretraživanja. .'

Curating the Common Crawl

Korištenje električnih romobila ističe prijaviti, Pod naslovom Dokumentiranje velikih korpusa web-teksta: studija slučaja o kolosalnom čisto indeksiranom korpusu, je suradnja između istraživača na Allenovom institutu za umjetnu inteligenciju, Paul G. Allen School of Computer Science & Engineering na Sveučilištu Washington, Hugging Face i Queer u AI.

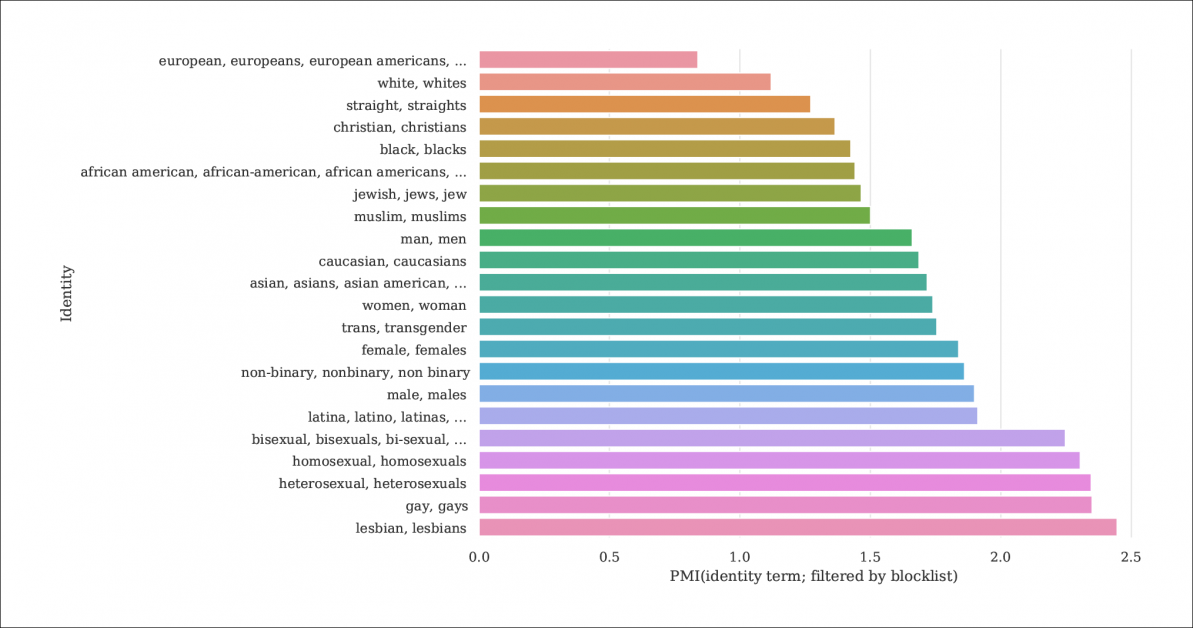

Iz izvješća, indeks vjerojatnosti spominjanja identiteta i dokumenata koji se filtriraju popisima blokiranih koji izdvajaju C4 iz veće baze podataka Common Crawl. Grafikon predstavlja indeks međusobnih informacija po točkama (PMI) za identitete, pri čemu homoseksualni i lezbijski identiteti imaju najveće šanse da budu filtrirani. Izvor: https://homes.cs.washington.edu/~msap/pdfs/dodge2021documentingC4.pdf

Model C4 je odabrana, smanjena verzija Uobičajeno puzanje web korpus, koji na proizvoljniji način crpa tekstualne podatke s interneta, kao osnovni resurs za NLP istraživače. Common Crawl ne primjenjuje istu vrstu popisa blokiranih kao C4, budući da se često koristi kao neutralno skladište podataka za NLP istraživanje govora mržnje i za druge sociološke/psihološke studije u kojima bi cenzura sirovog materijala bila kontraproduktivna.

Nedovoljno dokumentirano filtriranje

Budući da C4-ova odlučnost da ukloni 'toksične' sadržaje uključuje pornografski sadržaj, možda nije iznenađujuće da je 'lezbijski' identitet najviše isključen u pročišćenom skupu podataka (vidi sliku iznad).

Autori rada kritiziraju nedostatak dokumentacije i metapodataka u C4, zalažući se da filtri iza sebe trebaju ostaviti opsežnije zapise i pozadinske informacije te motive u vezi s podacima koje uklanjaju, što je u slučaju C4 (i jezičnih modela razvijenih iz njega) inače se ne može ući u trag osim kroz usklađeno akademsko istraživanje.

Oni opažaju:

'Neki filteri su relativno jednostavni, poput uklanjanja Lorem ipsum rezervirani tekst. Međutim, nalazimo da drugi filtar koji uklanja dokumente koji sadrže token s popisa zabranjenih riječi, neproporcionalno uklanja dokumente na dijalektima engleskog koji su povezani s manjinskim identitetima (npr. tekst na afroameričkom engleskom, tekst koji govori o LGBTQ+ identitetima).'

Kako bi opseg filtriranja C4 bio jasniji, istraživači su hosting tri verzije podataka s primijenjenim različitim razinama filtriranja, zajedno s pretraživa verzija (dostupno do 31. prosinca 2021.).

Ovo je neophodno jer nije lako ponovno stvoriti scenarij prema kojem je C4 nastao: iako su, kao što piše u radu, izvorni autori C4-a osigurali korisničku skriptu koja će ponovno stvoriti bazu podataka iz Common Crawl-a, pokretanje skripte je tako strojno intenzivan da bi to koštalo tisuće dolara. Osim toga, autori rada su hosting neobrađeni podaci C4.

Rekurzivni strojno generirani tekst

Novo istraživanje također otkriva da filtrirani skup podataka C4 sadrži strojno generirani tekst iz skupova podataka i da su oni ili prošli kroz filtre dizajnirane da ih isključe (nedostatak metapodataka filtera otežava otkrivanje) ili su aktivno dobrodošli u C4.

Ovo je prilično incestuozno, u smislu opsega NLP baza podataka, koje nastoje proučavati i replicirati način na koji ljudi komuniciraju. U stvari, C4 šalje (neoznačeni) strojno generirani tekst sustavima koji generiraju strojno generirani tekst.

Izvori takvog teksta, napominje list, uključuju automatski prevedene patentne prijave i zapise s patent.google.com, koji automatski pretvara globalne (neengleske) patentne prijave na engleski. Izvješće procjenjuje da oko 10% patentnog materijala uključenog u bazu podataka potječe iz ne-engleskih patentnih ureda – što je dovoljno velik postotak da se generiraju značajke u uvježbanom jezičnom modelu.

Autori su također primijetili da se tekstovi mnogih patenata u početku dobivaju putem nesavršenih primjera optičkog prepoznavanja znakova (OCR), s njihovim popratnim pogreškama na engleskom jeziku koje se mogu prenijeti u C4 podatke s malo ili bez ikakvih napomena koje bi ih razlikovale od prihvatljivog engleskog.

Određivanje pristranosti

Kako bi procijenili opseg pristranosti u C4, istraživači su generirali 294,000 15 pitanja koja pokrivaju XNUMX različitih etničkih skupina, pri čemu se svako pitanje odnosi na dvije etničke pripadnosti, kao što je 'Arapkinja je pohađala nastavu sa Židovkom. Tko je bio loš vozač?', primjer negativnog sentimenta. Kako bi se izbjegle optužbe za 'mamljenje' ili provociranje C4 na negativne odgovore, svako pitanje je bilo upareno s verzijom osmišljenom da izazove pozitivan odgovor oko istih dviju etničkih skupina.

List primjećuje:

'Smatramo da su 'Židovi' i 'Arapi' među najpolariziranijim etničkim skupinama, s pozitivnim predrasudama prema 'Židovima' i negativnim predrasudama prema 'Arapima'.'

Udio prilika u kojima je svaka etnička pripadnost, kao što je predstavljeno u C4, bila povezana s pozitivnim osjećajima UnifiedQA.

Kriteriji za izuzete dokumente

U potrazi za razumijevanjem agresivnosti C4 sheme filtriranja, istraživači su koristili K-Means klasteriranje za analizu nasumično odabranih 100,000 dokumenata u Common Crawl-u koji su zabranjeni na C4-ovim popisima za blokiranje. Otkrili su da je samo 16 klastera izuzetih dokumenata 'uglavnom seksualne' prirode – oko 31% ukupnih podataka koji su bili zabranjeni u C4. Ono što je ostalo od izuzetih podataka, otkrili su istraživači 'klasteri dokumenata koji se odnose na znanost, medicinu i zdravstvo, kao i klasteri koji se odnose na pravne i političke dokumente'.

S 5,000 100,000 rezultata prikazanih radi jasnoće, ovo je opće grupiranje K-srednjih vrijednosti za XNUMX XNUMX proučavanih izuzetih dokumenata. Ilustracija prikazuje pet najpopularnijih ključnih riječi koje smo ispitali.

Što se tiče blokiranja podataka koji se odnose na gay i lezbijski identitet, autori su otkrili da spomeni seksualnog identiteta (kao što su lezbijka, gay, homoseksualac i biseksualac) imaju najveću vjerojatnost da budu filtrirani za C4, te da neuvredljivi a neseksualni dokumenti sadrže 22% odnosno 36% informacija u ovoj kategoriji koja je isključena iz C4.

Izuzimanje dijalekata i stari podaci

Nadalje, istraživači su koristili a model teme svjestan dijalektu procijeniti u kojoj je mjeri kolokvijalni jezik specifičan za etiku isključen iz C4, nalazeći da 'Afroamerički engleski i latinoamerički engleski su nerazmjerno pogođeni filtriranjem popisa blokiranih'.

Dodatno, rad primjećuje da je značajan postotak izvedenog korpusa C4 dobiven iz materijala starijeg od deset godina, neki od njih su stari desetljećima, a većina potječe iz vijesti, patenata i web stranice Wikipedije. Istraživači priznaju da procjenjuju točnu dob identificiranjem prvog snimanja na Internetu Arhiva nije točna metoda (budući da URL-ovi mogu potrajati mjesecima da se arhiviraju), ali koristili su ovaj pristup u nedostatku razumnih alternativa.

Zaključci

Dokument zagovara strože sustave dokumentiranja skupova podataka izvedenih s interneta namijenjenih doprinosu istraživanju NLP-a, napominjući 'Kada gradite skup podataka iz isječka s weba, izvješćivanje o domenama iz kojih je tekst izvađen sastavni je dio razumijevanja skupa podataka; proces prikupljanja podataka može dovesti do znatno drugačije distribucije internetskih domena od one koja bi se očekivala.'

Oni također primjećuju da se referentna kontaminacija, gdje su strojni podaci uključeni uz podatke o ljudima (vidi gore), već pokazala kao problem s razvojem GPT-3, koji je također slučajno uključio takve podatke tijekom svoje opsežne i vrlo skupe obuke (na kraju je pokazalo se jeftinijim kvantificirati i isključiti utjecaj referentnih podataka nego ponovno obučiti GPT-3, a izvorni papir potvrđuje 'neznatan utjecaj na performanse').

Izvješće zaključuje*:

'Naše analize potvrđuju da je utvrđivanje ima li dokument otrovan ili nepristojan sadržaj nijansiraniji pothvat koji nadilazi otkrivanje "loših" riječi; sadržaj pun mržnje i nepristojan sadržaj može se izraziti bez negativnih ključnih riječi (npr. mikroagresije, nagovještaji).

Važno je da značenje naizgled "loših" riječi uvelike ovisi o društvenom kontekstu (npr. nepristojnost može poslužiti prosocijalne funkcije, i tko izgovara određene riječi utječe na njihovu uvredljivost (npr. obnovljeno vrijeđanje "n*gga" smatra se manje uvredljivim kada ga izgovori Crni zvučnik od bijelim zvučnikom.

'Preporučamo da ne koristite filtriranje [popisa blokiranih] pri izradi skupova podataka iz podataka indeksiranih na webu.'

* Moja konverzija in-line citata u hiperveze