Umjetna inteligencija

Bolja izvedba strojnog učenja kroz promjenu veličine slike temeljenu na CNN-u

Googleovo istraživanje predložilo je novu metodu za poboljšanje učinkovitosti i točnosti tijeka rada za obuku računalnog vida temeljenog na slikama poboljšanjem načina na koji se slike u skupu podataka smanjuju u fazi predobrade.

u papir Učenje mijenjanja veličine slika za zadatke računalnog vida, istraživači Hossein Talebi i Peyman Milanfar koriste CNN za stvaranje nove hibridne arhitekture promjene veličine slike koja proizvodi značajno poboljšanje u rezultatima prepoznavanja dobivenim preko četiri popularna skupa podataka računalnog vida.

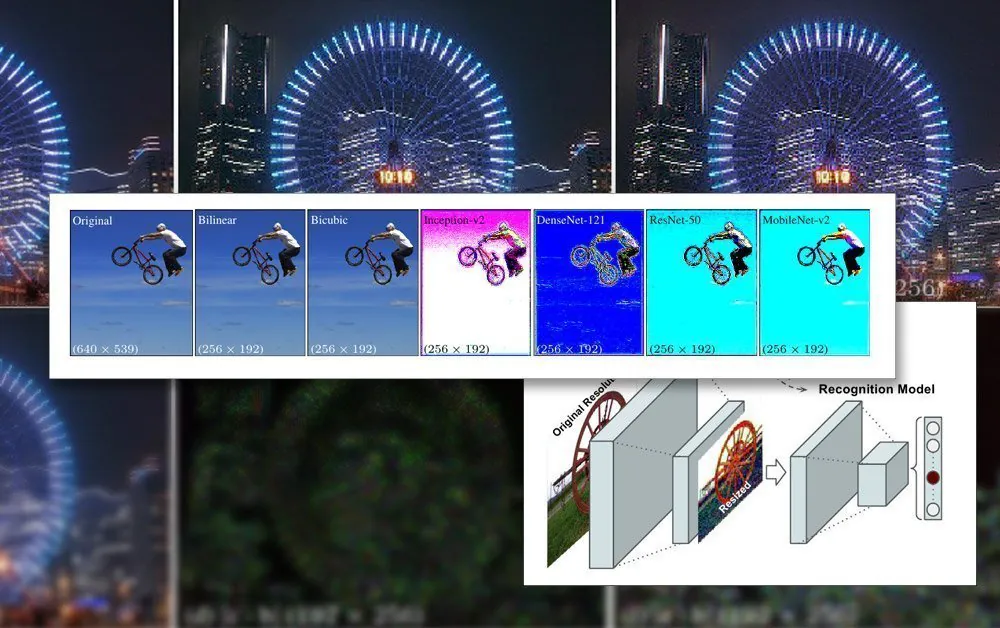

Predloženi zajednički okvir za prepoznavanje i promjenu veličine. Izvor: https://arxiv.org/pdf/2103.09950.pdf

U radu se primjećuje da su metode promjene veličine/veličine koje se trenutno koriste u cjevovodima automatiziranog strojnog učenja zastarjele desetljećima i da često koriste samo osnovne bilinearne, bikubične i najbliže susjede promjena veličine – metode koje tretiraju sve piksele bez razlike.

Nasuprot tome, predložena metoda povećava slikovne podatke putem CNN-a i uključuje taj unos u slike promijenjene veličine koje će u konačnici proći kroz arhitekturu modela.

Ograničenja slike u obuci umjetne inteligencije

Kako bi se obučavao model koji se bavi slikama, okvir strojnog učenja uključivat će fazu pretprocesiranja, gdje se različita raznolikost slika različitih veličina, prostora boja i rezolucija (koje će pridonijeti skupu podataka za obuku) sustavno izrezuje i promijenjene veličine u dosljedne dimenzije i stabilan, jedan format.

Općenito, ovo će uključivati određeni kompromis temeljen na PNG formatu, gdje će se uspostaviti kompromis između vremena obrade/resursa, veličine datoteke i kvalitete slike.

U većini slučajeva konačne dimenzije obrađene slike su vrlo male. Ispod vidimo primjer slike rezolucije 80×80 na kojoj su neki od najranijih deepfakes skupova podataka su generirani:

Budući da lica (i drugi mogući subjekti) rijetko stanu u traženi kvadratni omjer, možda će biti potrebno dodati crne trake (ili dopustiti gubitak prostora) kako bi se slike homogenizirale, dodatno smanjujući stvarne upotrebljive slikovne podatke:

Ovdje je lice izdvojeno iz većeg područja slike dok se ne izreže što je moguće ekonomičnije kako bi se obuhvatilo cijelo područje lica. Međutim, kao što se vidi na desnoj strani, velik dio preostalog područja neće se koristiti tijekom treninga, dodajući veću težinu važnosti kvalitete slike podataka promijenjene veličine.

Kako su se GPU mogućnosti poboljšale posljednjih godina, s novom generacijom NVIDIA kartica opremljenih sve veći iznosi video-RAM-a (VRAM), prosječne pridonosne veličine slike počinju se povećavati, iako je 224 × 224 piksela još uvijek prilično standard (na primjer, to je veličina ResNet-50 skup podataka).

Slika bez promjene veličine 224×244 piksela.

Uklapanje serija u VRAM

Razlog zašto sve slike moraju biti iste veličine je taj gradijentni spust, metoda kojom se model poboljšava tijekom vremena, zahtijeva jedinstvene podatke o obuci.

Razlog zašto slike moraju biti tako male je taj što se moraju učitati (potpuno dekomprimirati) u VRAM tijekom obuke u malim serijama, obično između 6-24 slike po seriji. Premalo slika po skupini i nema dovoljno grupnog materijala za dobro generaliziranje, uz produljenje vremena obuke; previše, a model možda neće uspjeti dobiti potrebne karakteristike i detalje (vidi dolje).

Ovaj dio 'učitavanja uživo' arhitekture obuke naziva se latentni prostor. Ovo je mjesto gdje se značajke opetovano izdvajaju iz istih podataka (tj. istih slika) sve dok model ne konvergira u stanje u kojem ima svo generalizirano znanje potrebno za izvođenje transformacija na kasnijim, nevidljivim podacima slične vrste.

Ovaj proces općenito traje danima, iako može potrajati čak mjesec dana ili više stalne i nepopustljive velike količine razmišljanja 24/7 da bi se postigla korisna generalizacija. Povećanja veličine VRAM-a korisna su samo do određene točke, budući da čak i manji porasti u razlučivosti slike mogu imati učinak reda veličine na kapacitet obrade i povezane učinke na točnost koji ne moraju uvijek biti povoljni.

Korištenje većeg kapaciteta VRAM-a za prilagodbu većim veličinama serija također je mješoviti blagoslov, budući da se time postižu veće brzine obuke. vjerojatno da će se kompenzirati manje preciznim rezultatima.

Stoga, budući da je arhitektura obuke toliko ograničena, sve što može utjecati na poboljšanje unutar postojećih ograničenja cjevovoda značajno je postignuće.

Kako superiorno smanjenje broja pomaže

Dokazano je da vrhunska kvaliteta slike koja će biti uključena u skup podataka za obuku ima bolji učinak na ishod obuke, posebno u zadacima prepoznavanja objekata. U 2018. istraživači s Instituta Max Planck za inteligentne sustave tvrdio da izbor metode ponovnog uzorkovanja značajno utječe na izvedbu i rezultate treninga.

Osim toga, Googleov prethodni rad (koji su napisali autori novog rada) otkrio je da se točnost klasifikacije može poboljšati održavanje kontrole artefakti nad kompresijom u slikama skupova podataka.

CNN model ugrađen u novi resampler kombinira bilinearnu promjenu veličine sa značajkom 'preskakanja veze' koja može uključiti izlaz iz uvježbane mreže u sliku promijenjene veličine.

Za razliku od tipične arhitekture kodera/dekodera, novi prijedlog može djelovati ne samo kao usko grlo za prijenos podataka, već i kao obrnuto usko grlo za skaliranje na bilo koju ciljnu veličinu i/ili omjer širine i visine. Dodatno, 'standardna' metoda ponovnog uzorkovanja može se zamijeniti bilo kojom drugom prikladnom tradicionalnom metodom, kao što je lansiranja.

Pojedinosti visoke frekvencije

Nova metoda proizvodi slike za koje se čini da 'peku' ključne značajke (koje će na kraju biti prepoznate u procesu obuke) izravno u izvornu sliku. U estetskom smislu, rezultati su nekonvencionalni:

Nova metoda primijenjena na četiri mreže – Inception V2; DenseNet-121; ResNet-50; i MobileNet-V2. Rezultati Google Research metode smanjivanja uzorkovanja/promjene veličine slike stvaraju slike s očiglednim skupljanjem piksela, predviđajući ključne značajke koje će se uočiti tijekom procesa obuke.

Istraživači primjećuju da su ovi početni eksperimenti isključivo optimizirani za zadatke prepoznavanja slika i da je u testovima njihov 'naučeni resizer' koji pokreće CNN uspio postići poboljšane stope pogrešaka u takvim zadacima. Istraživači namjeravaju u budućnosti primijeniti metodu na druge vrste aplikacija računalnog vida temeljenih na slikama.