Angle d'Anderson

Les risques de l'annotation d'images basée sur « Vibe »

Même s'ils ne sont payés que quelques dollars (voire rien), les anonymes qui évaluent les images pour y déceler du contenu « blessant » peuvent changer votre vie par leurs choix. Or, une importante étude de Google semble suggérer que ces annotateurs établissent leurs propres règles pour déterminer ce qui est ou n'est pas « blessant » ou offensant, aussi étrange ou personnel que soit leur réaction à une image. Qu'est-ce qui pourrait mal tourner ?

Opinion Cette semaine, une nouvelle collaboration entre Google Research et Google Mind a réuni pas moins de 13 contributeurs à un nouveau document qui explore si les « sentiments instinctifs » des annotateurs d'images doivent être pris en compte lorsque les gens évaluent des images pour des algorithmes, même si leurs réactions ne correspondent pas aux normes d'évaluation établies.

Ceci est important pour vous, car ce que les évaluateurs et les annotateurs trouvent offensant par règle de consensus aura tendance à être inscrit dans les systèmes automatiques de censure et de modération, et dans les critères de contenu « obscène » ou « inacceptable », dans des législations telles que la nouveau pare-feu NSFW* du Royaume-Uni (dont une version est venir en Australie (bientôt) et dans les systèmes d’évaluation de contenu sur les plateformes de médias sociaux, entre autres environnements.

Ainsi, plus les critères d’infraction sont larges, plus le niveau potentiel de censure est élevé.

Censure de l'ambiance

Ce n'est pas le seul point de vue que le nouveau document a à offrir ; il constate également que les personnes qui évaluent les images sont souvent plus critiques à l'égard de ce qu'elles pensent être offensant. d’autres des personnes autres qu’eux-mêmes ; et que les images de mauvaise qualité suscitent souvent des inquiétudes en matière de sécurité, même si la qualité de l’image n’a rien à voir avec son contenu.

Dans sa conclusion, l’article met l’accent sur ces deux résultats, comme si la position centrale de l’article avait échoué, mais que les chercheurs étaient obligés de publier quand même.

Bien que ce ne soit pas un scénario rare, l'article révèle, après une lecture attentive, un courant sous-jacent plus sinistre : les pratiques d'annotation pourraient envisager d'adopter ce que je ne peux décrire que comme annotation d'ambiance:

Nos résultats suggèrent que les cadres existants doivent prendre en compte les dimensions subjectives et contextuelles, telles que les réactions émotionnelles, les jugements implicites et les interprétations culturelles du préjudice. L'utilisation fréquente du langage émotionnel par les annotateurs et leur divergence par rapport aux étiquettes de préjudice prédéfinies mettent en évidence les lacunes des pratiques d'évaluation actuelles.

« L’élargissement des directives d’annotation pour inclure des exemples illustratifs d’interprétations culturelles et émotionnelles diverses peut aider à combler ces lacunes. »

Ce nouvel article, peu illustré, s'ouvre par des exemples clairs et compréhensibles pour le lecteur moyen, même si le contenu principal suscite bien d'autres questions. Sous chaque image, les réactions émotionnelles des annotateurs sont indiquées pour chaque image. Source : https://arxiv.org/pdf/2507.16033

À première vue, cela ressemble à une proposition visant à étendre et à mieux quantifier ce qui constitue un « préjudice » dans une image – une démarche louable ; mais le document réitère à plusieurs reprises que cela n’est ni souhaitable ni (nécessairement) faisable :

Nos résultats suggèrent que les cadres existants doivent prendre en compte les dimensions subjectives et contextuelles, telles que les réactions émotionnelles, les jugements implicites et les interprétations culturelles du préjudice. L'utilisation fréquente du langage émotionnel par les annotateurs et leur divergence par rapport aux étiquettes de préjudice prédéfinies mettent en évidence les lacunes des pratiques d'évaluation actuelles.

« L’élargissement des directives d’annotation pour inclure des exemples illustratifs d’interprétations culturelles et émotionnelles diverses peut aider à combler ces lacunes […]

« […] Le processus par lequel les annotateurs raisonnent sur des images ambiguës reflète souvent leurs perspectives personnelles, culturelles et émotionnelles, qui sont difficiles à étayer ou à normaliser. »

Il est difficile de voir comment « Élargir les directives d'annotation pour inclure des exemples illustratifs d'interprétations culturelles et émotionnelles diverses » peut s'intégrer dans un système de notation rationnel ; les auteurs peinent à clarifier ce point ou à formuler une théorie distincte, attaquant le sujet à maintes reprises, sans jamais parvenir à le maîtriser. À cet égard, leur thème central semble lui-même généré par une « ambiance », même s'il traite de psychologies intangibles.

En termes simples, il me semble que l'extension du pipeline d'annotation pour inclure des critères de ce type permet potentiellement « l'annulation » ou l'obscurcissement de tout matériel (ou classe de sujet) auquel un annotateur pourrait réagir fortement.

Jugement binaire

La mesure dans laquelle les images et les textes peuvent causer du tort est en effet difficile à quantifier, notamment parce que la haute culture croise souvent la culture « basse » (par exemple avec art et romans), ce qui a conduit aux premiers critères de censure basés sur « l'ambiance » : même si le matériel obscène échappe à la définition exacte, vous sachez le savoir quand vous le voyez.

Derrière la discussion approfondie et exploratoire du nouvel article sur l'empathie et les nuances qualitatives, l'ouvrage semble attaquer discrètement l'autorité des taxonomies centralisées et standardisées (« violence », « nudité », « haine », etc.) qui permettent aux plateformes de mettre en œuvre et d'adapter la modération avec des marges d'erreur tolérables (d'habitude).

L’argument qui émerge est que seul un retour humain décentralisé, subjectif et sensible au contexte peut juger correctement la sortie de GenAI.

Cependant, cette approche est clairement irréalisable, car il est impossible d'appliquer un filtre de plusieurs milliards d'images à partir de « vibes » et d'expériences vécues. Il faut quantifier les dommages en fonction de diverses propriétés ; fixer une limite à la portée du système de filtrage résultant ; et attendre de nouvelles directives pour les cas « limites » (tout comme les parties lésées doivent parfois attendre l'adoption de nouvelles lois adaptées à leur situation particulière).

Au lieu de cela, le nouveau document présente un mandat tacite pour un pipeline de modération automatisé qui étend sa portée. automatiquement , et pèche tellement par excès de prudence que même la réaction la plus particulière et non reproductible d'un annotateur pourrait pénaliser une image qui n'a offensé personne d'autre.

Expansion morale

Bien que l’article penche vers l’exploration plutôt que vers une prise de position ferme, il intègre des éléments de méthode scientifique : les auteurs ont développé un cadre pour identifier (mais pas mesurer strictement) un spectre plus large de réactions des annotateurs aux images, et pour examiner comment ces réactions varient selon le sexe et d’autres facteurs démographiques.

Outre l'analyse des tests de focalisation sur le préjudice†, le processus a analysé le « raisonnement moral » dans les commentaires auxiliaires des participants au test, à qui il a été demandé d'annoter un ensemble de données de test modifié contenant des images et des invites/textes associés.

Cet « auto-évaluateur du sentiment moral » a été conçu pour capturer les valeurs morales Soins, égalité, proportionnalité, loyauté, autoritéou Purity, tel que défini dans Théorie des fondements moraux – une théorie psychologique qui, en raison de sa nature fluide et évolutive, est antithétique à la création de définitions concrètes requises pour les systèmes d’évaluation humaine à grande échelle.

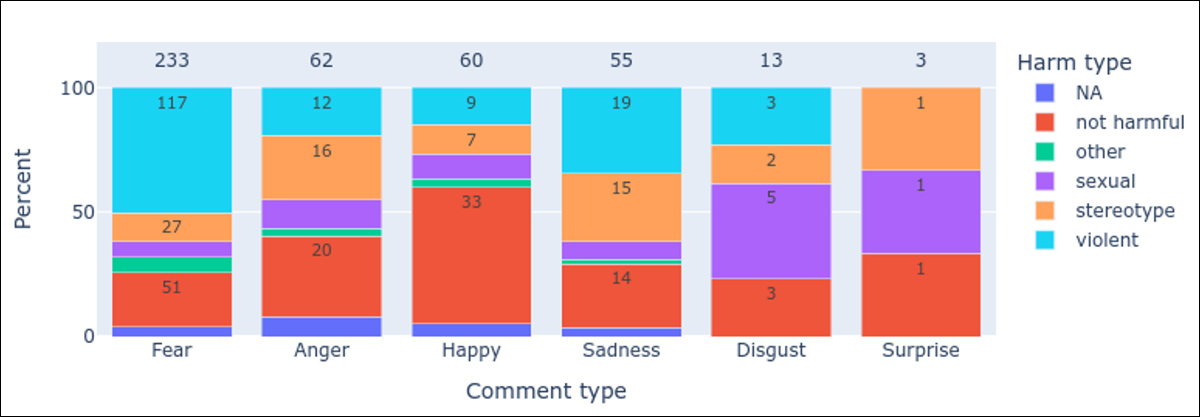

S’appuyant sur cette théorie, les auteurs ont catégorisé des dimensions supplémentaires de sécurité, notamment peur, la colère, tristesse, dégoût, confusionou étrangeté.

Les auteurs développent le premier d'entre eux, peur:

« De nombreux annotateurs ont utilisé des termes comme « effrayant » (par exemple, pour des visages déformés ou des images suggérant la violence comme une arme pointée sur un enfant), « dérangeant » (par exemple, « Absolument ignoble de voir quelqu'un se faire écraser, très pénible et dérangeant », ou « Dérangeant et ressemble à du sang » pour la peinture rouge), ou « bouleversant » (par exemple, « L'image du garçon a de nombreuses distorsions… Je trouve cela de mauvais goût car il semble que le garçon joue du mauvais côté des barrières latérales »).

« Le [graphique ci-dessous] quantifie la « peur » comme l’émotion la plus fréquemment mentionnée (233 mentions alors que près de la moitié de ces mentions sont associées à du contenu violent, le contenu jugé non nocif a également évoqué la deuxième mention la plus élevée de la peur). »

Répartition des termes liés aux émotions selon les catégories de préjudice, avec des hauteurs de barre indiquant les proportions de commentaires, des nombres affichés dans les barres et des nombres totaux de commentaires affichés au-dessus de chaque catégorie.

Concernant l’inclusion de ces nouvelles dimensions de sécurité, les auteurs déclarent :

« Ces thèmes émergents soulignent un besoin crucial d’enrichir les cadres d’évaluation des images de l’IA en intégrant des éléments subjectifs, émotionnels et perceptifs. »

Il s'agit peut-être d'une voie dangereuse à emprunter, car elle semble permettre aux processus d'annotation d'ajouter arbitrairement des règles basées sur les réactions que le matériel peut provoquer dans n'importe quel annotateur, au lieu d'exiger tous les annotateurs doivent adhérer aux normes et aux repères établis.

Si l’on pouvait attribuer un impératif économique à cette idée, c’est que cette approche permet annotation humaine à grande échelle, dans lequel le processus est sans friction, les participants s'autorégulent et décident eux-mêmes des règles et des limites.

Dans le cadre d'une annotation standard, les règles sont établies par consensus humain et respectées par des annotateurs humains ; dans le scénario envisagé dans l'article, cette couche initiale de surveillance est soit supprimée, soit dégradée : en effet, toute image susceptible d'offenser quiconque serait signalée (notamment parce que le consensus est coûteux et prend du temps).

Jugements de Rorschach

L'objectif de l'annotation est de parvenir à une description ou une définition précise, soit par le biais d'une expertise, soit par un consensus entre plusieurs annotateurs, soit (idéalement) des deux. Au contraire, élargir une hiérarchie limitée mais bien définie des préjudices à une position interprétative « intuitive » et hautement personnelle équivaut à annoter un test de Rorschach.

Par exemple, certains annotateurs, note l'article, ont interprété une mauvaise qualité d'image (comme Artefacts JPEG, ainsi que des défauts techniques insignifiants dans une image) comme 'inquiétant' or « indicatif d'un préjudice »:

Cela s'est produit malgré l'omission d'instructions sur la qualité de l'image dans la tâche. De plus, les annotateurs ont interprété ces artefacts de qualité comme ayant une signification sémantique.

Un annotateur a commenté : « L'image n'est absolument pas dangereuse ; son visage est juste légèrement déformé. » De même, certains annotateurs ont interprété les artefacts de qualité de l'image comme une atteinte intentionnelle, attribuant une signification émotionnelle aux défauts. Par exemple, un autre annotateur a interprété un visage déformé sur une autre image comme un « signe de douleur ».

En élevant les réactions subjectives, émotionnelles ou spécifiques au contexte au-dessus des catégories de sécurité prédéfinies, les idées présentées ici ouvrent la porte à un régime où quoi que ce soit d'artificiel peuvent être arbitrairement signalés comme nocifs, et où un « effet paralysant » de ad hoc les retraits ou la recatégorisation négative de matériel (c'est-à-dire de matériel susceptible d'« offenser » un groupe d'intérêt particulier) deviennent une perspective réelle.

Le papier « Juste une image étrange » : Évaluation de la « sécurité » dans les tâches d'annotation de sécurité d'images GenAI du point de vue de divers annotateurs is disponible sur Arxiv.

* Un raccourci, car ce n'est pas le sujet central ici ; en vertu de la nouvelle législation, les sites contrevenants sont censés soit se contrôler eux-mêmes, soit imposer des systèmes d'évaluation complexes et coûteux et des technologies de vérification de l'âge qui sont hors de portée de tous, sauf des plus grands sites ; soit bloquer leurs domaines au public britannique (là encore, à leurs propres frais).

† Exprimé simplement dans le mème « pensez aux enfants », qui satirise l'appropriation de l'agence morale d'autrui à des fins apparemment altruistes.

Première publication le vendredi 25 juillet 2025