Intelligence Artificielle

DALL-E 2 ne fait-il que «coller des choses ensemble» sans comprendre leurs relations?

Un nouveau document de recherche de l'Université de Harvard suggère que le cadre de synthèse texte-image DALL-E 2 d'OpenAI a des difficultés notables à reproduire même des relations de niveau infantile entre les éléments qu'il compose dans des photos synthétisées, malgré la sophistication éblouissante d'une grande partie de sa sortie.

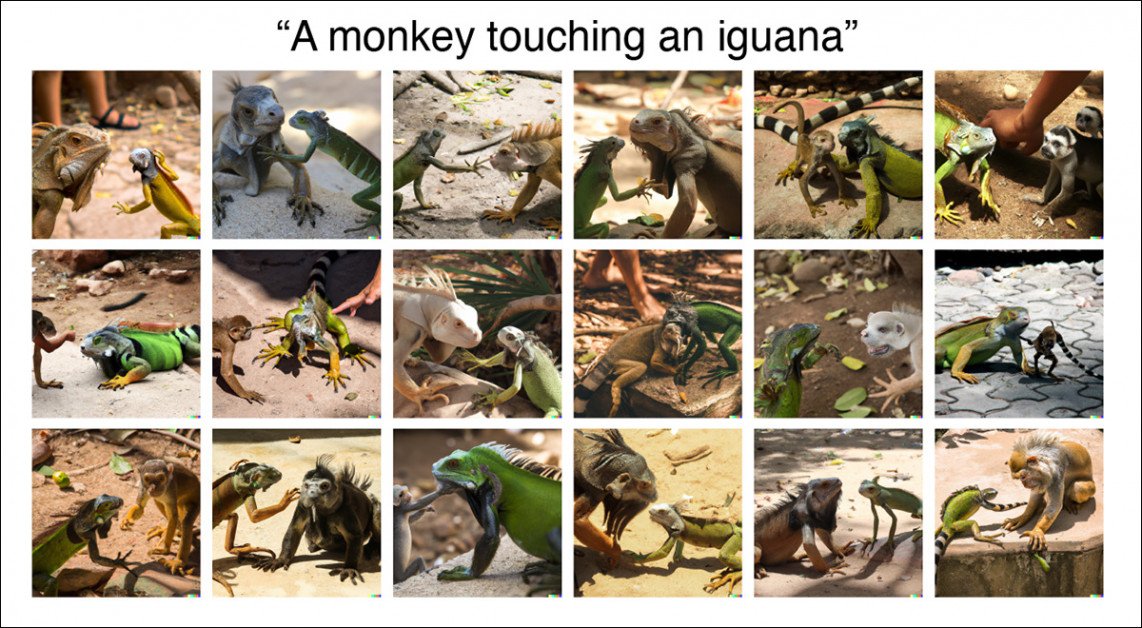

Les chercheurs ont entrepris une étude d'utilisateurs impliquant 169 participants en crowdsourcing, qui ont reçu des images DALL-E 2 basées sur les principes humains les plus élémentaires de la sémantique des relations, ainsi que les invites de texte qui les avaient créées. Lorsqu'on leur a demandé si les invites et les images étaient liées, moins de 22 % des images ont été perçues comme pertinentes pour leurs invites associées, en termes de relations très simples que DALL-E 2 a été invité à visualiser.

Une capture d'écran des essais menés pour le nouveau papier. Les participants ont été chargés de sélectionner toutes les images correspondant à l'invite. Malgré l'avertissement au bas de l'interface, dans tous les cas, les images, à l'insu des participants, ont en fait été générées à partir de l'invite associée affichée. Source : https://arxiv.org/pdf/2208.00005.pdf

Les résultats suggèrent également que la capacité apparente de DALL-E à joindre des éléments disparates peut diminuer à mesure que ces éléments deviennent moins susceptibles de s'être produits dans les données de formation réelles qui alimentent le système.

Par exemple, les images de l'invite "enfant touchant un bol" ont obtenu un taux d'accord de 87 % (c'est-à-dire que les participants ont cliqué sur la plupart des images comme étant pertinentes pour l'invite), alors que des rendus photoréalistes similaires d'un "singe touchant un iguane" ont obtenu seulement 11 % d'accord :

DALL-E a du mal à décrire l'événement improbable d'un «singe touchant un iguane», sans doute parce qu'il est rare, voire inexistant, dans l'ensemble de formation.

Dans le deuxième exemple, DALL-E 2 se trompe souvent d'échelle et même d'espèce, probablement en raison d'un manque d'images du monde réel qui décrivent cet événement. En revanche, il est raisonnable de s'attendre à un nombre élevé de photos de formation liées aux enfants et à la nourriture, et que ce sous-domaine/classe est bien développé.

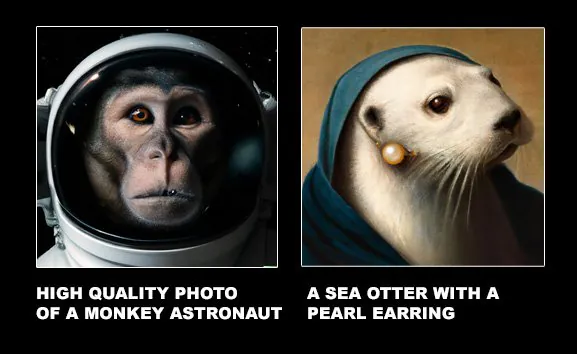

La difficulté de DALL-E à juxtaposer des éléments d'image extrêmement contrastés suggère que le public est actuellement tellement ébloui par les capacités photoréalistes et largement interprétatives du système qu'il n'a pas développé un œil critique pour les cas où le système a effectivement simplement "collé" un élément sur un autre , comme dans ces exemples du site officiel DALL-E 2 :

Synthèse par copier-coller, à partir des exemples officiels pour DALL-E 2. Source : https://openai.com/dall-e-2/

Le nouveau document indique * :

"La compréhension relationnelle est une composante fondamentale de l'intelligence humaine, qui se manifeste au début du développement, et est calculé rapidement et automatiquement dans la perception.

'La difficulté de DALL-E 2 avec même les relations spatiales de base (telles que in, on, sous) suggère que quoi qu'il ait appris, il n'a pas encore appris les types de représentations qui permettent aux humains de structurer le monde avec autant de souplesse et de robustesse.

"Une interprétation directe de cette difficulté est que les systèmes comme DALL-E 2 n'ont pas encore de compositionnalité relationnelle."

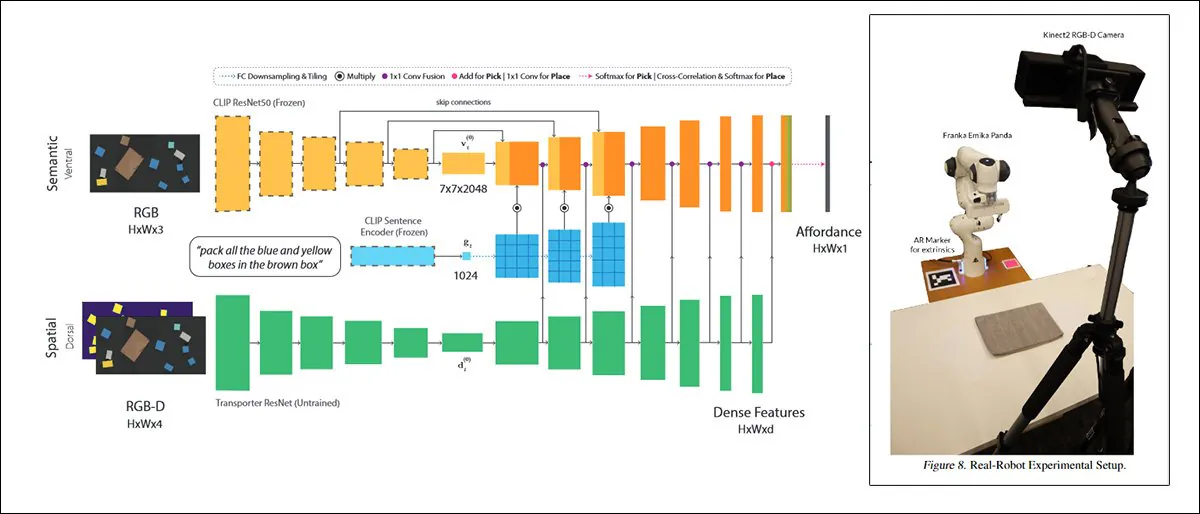

Les auteurs suggèrent que les systèmes de génération d'images guidés par le texte tels que la série DALL-E pourraient bénéficier de l'exploitation d'algorithmes communs à la robotique, qui modélisent simultanément les identités et les relations, en raison de la nécessité pour l'agent d'interagir réellement avec l'environnement plutôt que de simplement fabriquer un mélange d'éléments divers.

Une telle approche, intitulée Port CLI, utilise le même Mécanisme CLIP qui sert d'élément d'évaluation de la qualité dans DALL-E 2 :

CLIPort, une collaboration de 2021 entre l'Université de Washington et NVIDIA, utilise CLIP dans un contexte si pratique que les systèmes formés dessus doivent nécessairement développer une compréhension des relations physiques, un facteur de motivation qui est absent dans DALL-E 2 et similaire "fantastique" cadres de synthèse d'images. Source : https://arxiv.org/pdf/2109.12098.pdf

Les auteurs suggèrent en outre qu'"une autre mise à niveau plausible" pourrait être que l'architecture des systèmes de synthèse d'images tels que DALL-E intègre effets multiplicatifs dans une seule couche de calcul, permettant le calcul de relations d'une manière inspirée par les capacités de traitement de l'information de biologiques les systèmes.

Les nouveau papier est intitulé Test de la compréhension relationnelle dans la génération d'images guidée par texte, et vient de Colin Conwell et Tomer D. Ullman du département de psychologie de Harvard.

Au-delà des premières critiques

Commentant le «tour de passe-passe» derrière le réalisme et l'intégrité de la sortie de DALL-E 2, les auteurs notent des travaux antérieurs qui ont trouvé des lacunes dans les systèmes d'image générative de style DALL-E.

En juin de cette année, UoC Berkeley noté la difficulté de DALL-E à gérer les reflets et les ombres ; le même mois, une étude coréenne a enquêté sur le « caractère unique » et l'originalité de la sortie de style DALL-E 2 d'un oeil critique; à analyse préliminaire des images DALL-E 2, peu de temps après le lancement, de NYU et de l'Université du Texas, ont trouvé divers problèmes de composition et d'autres facteurs essentiels dans les images DALL-E 2 ; et le mois dernier, un travail en commun entre l'Université de l'Illinois et le MIT ont proposé des améliorations architecturales à ces systèmes en termes de compositionnalité.

Les chercheurs notent en outre que les luminaires DALL-E tels qu'Aditya Ramesh ont Concédé les problèmes du cadre avec la reliure, la taille relative, le texte et d'autres défis.

Les développeurs du système de synthèse d'images rival de Google, Imagen, ont également proposé Banc de tirage, un nouveau système de comparaison qui évalue la précision des images dans des cadres avec diverses métriques.

Au lieu de cela, les auteurs du nouvel article suggèrent qu'un meilleur résultat pourrait être obtenu en opposant l'estimation humaine - plutôt que des mesures algorithmiques internes - aux images résultantes, pour déterminer où se situent les faiblesses et ce qui pourrait être fait pour les atténuer.

L'Étude

À cette fin, le nouveau projet fonde son approche sur des principes psychologiques et cherche à se retirer de l'actuel montée d'intérêt in ingénierie rapide (ce qui est, en fait, une concession aux défauts de DALL-E 2, ou de tout système comparable), pour étudier et potentiellement résoudre les limitations qui rendent ces « contournements » nécessaires.

Le papier déclare:

« Le travail actuel se concentre sur un ensemble de 15 relations de base précédemment décrites, examinées ou proposées dans la littérature cognitive, développementale ou linguistique. L'ensemble contient à la fois des relations spatiales fondées (par exemple 'X sur Y') et des relations agentiques plus abstraites (par exemple 'X aidant Y').

"Les invites sont intentionnellement simples, sans complexité ni élaboration d'attributs. Autrement dit, au lieu d'une invite comme "un âne et une pieuvre jouent à un jeu". L'âne tient une corde à une extrémité, la pieuvre tient à l'autre. L'âne tient la corde dans sa bouche. Un chat saute par-dessus la corde », nous utilisons « une boîte sur un couteau ».

"La simplicité capture toujours un large éventail de relations dans divers sous-domaines de la psychologie humaine et rend les échecs potentiels des modèles plus frappants et plus spécifiques."

Pour leur étude, les auteurs ont recruté 169 participants de Prolific, tous situés aux États-Unis, avec une moyenne d'âge de 33 ans et 59 % de femmes.

Les participants ont vu 18 images organisées dans une grille 3 × 6 avec l'invite en haut et une clause de non-responsabilité en bas indiquant que toutes, certaines ou aucune des images peuvent avoir été générées à partir de l'invite affichée, et ont ensuite été invités à sélectionner les images qu'ils pensaient être liées de cette façon.

Les images présentées aux individus étaient basées sur la littérature linguistique, développementale et cognitive, comprenant un ensemble de huit relations physiques et de sept relations "agentiques" (cela deviendra clair dans un instant).

Relations physiques

dans, sur, sous, couvrant, près, occlus par, suspendu au-dessus, ou lié à.

Relations agentiques

pousser, tirer, toucher, frapper, donner des coups de pied, aider, ou entrave.

Toutes ces relations ont été tirées des domaines d'études non CS mentionnés précédemment.

Douze entités ont ainsi été dérivées pour être utilisées dans les invites, avec six objets et six agents :

Objets

boîte, cylindre, couverture, bol, tasse à thé, ou couteau.

Agents

homme, femme, enfant, robot, singe, ou iguane.

(Les chercheurs admettent que l'inclusion de l'iguane, qui n'est pas un pilier de la recherche sociologique ou psychologique sèche, était "un régal")

Pour chaque relation, cinq invites différentes ont été créées en échantillonnant au hasard deux entités cinq fois, ce qui a donné un total de 75 invites, dont chacune a été soumise à DALL-E 2, et pour chacune desquelles les 18 premières images fournies ont été utilisées, sans variations. ou seconde chance autorisée.

Résultats

Le papier précise* :

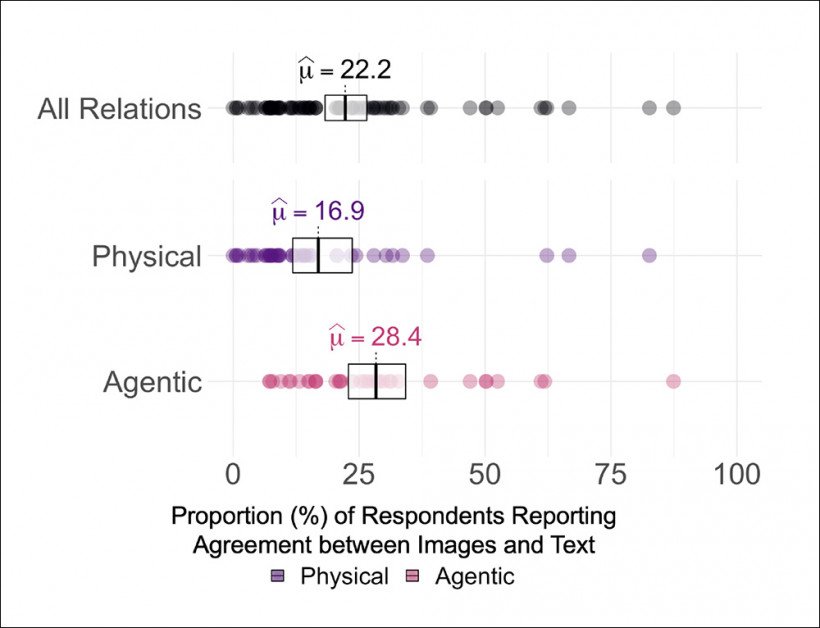

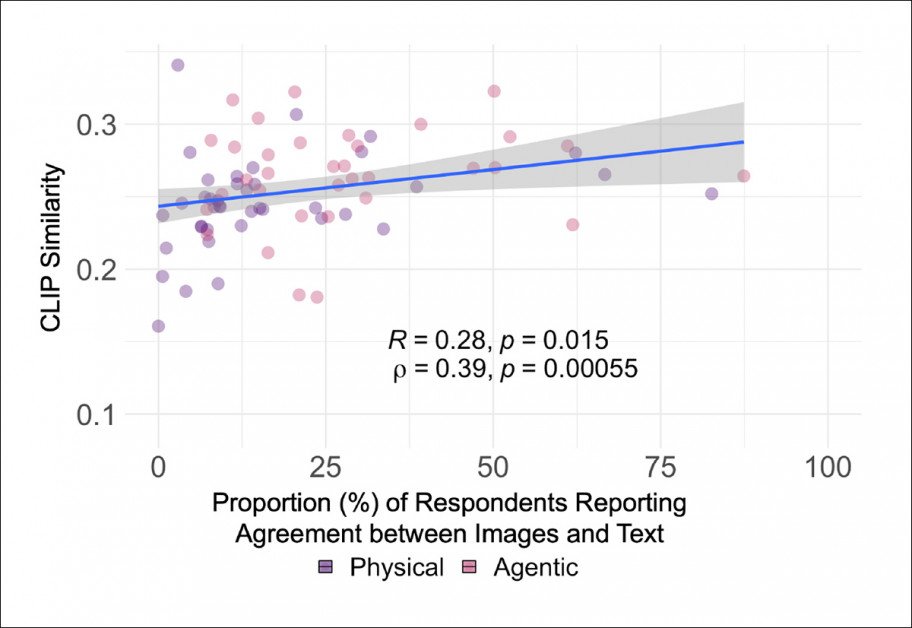

« En moyenne, les participants ont signalé une faible concordance entre les images de DALL-E 2 et les invites utilisées pour les générer, avec une moyenne de 22.2 % [18.3, 26.6] sur les 75 invites distinctes.

"Les invites d'agent, avec une moyenne de 28.4 % [22.8, 34.2] sur 35 invites, ont généré un accord plus élevé que les invites physiques, avec une moyenne de 16.9 % [11.9, 23.0] sur 40 invites."

Résultats de l'étude. Les points en noir indiquent toutes les invites, chaque point étant une invite individuelle, et la couleur se décompose selon que le sujet de l'invite était agentique ou physique (c'est-à-dire un objet).

Pour comparer la différence entre la perception humaine et algorithmique des images, les chercheurs ont exécuté leurs rendus via l'open source d'OpenAI ViT-L/14 Cadre basé sur CLIP. En faisant la moyenne des scores, ils ont trouvé une « relation modérée » entre les deux ensembles de résultats, ce qui est peut-être surprenant, compte tenu de la mesure dans laquelle CLIP lui-même aide à générer les images.

Résultats de la comparaison CLIP (ViT-L/14) avec les réponses humaines.

Les chercheurs suggèrent que d'autres mécanismes au sein de l'architecture, peut-être combinés à une prépondérance fortuite (ou à un manque) de données dans l'ensemble de formation, peuvent expliquer la façon dont CLIP peut reconnaître les limites de DALL-E sans pouvoir, dans tous les cas, faire quoi que ce soit. beaucoup sur le problème.

Les auteurs concluent que DALL-E 2 n'a qu'une capacité fictive, voire aucune, à reproduire des images qui intègrent la compréhension relationnelle, une facette fondamentale de l'intelligence humaine qui se développe en nous très tôt.

"L'idée que des systèmes comme DALL-E 2 n'ont pas de compositionnalité peut surprendre quiconque a vu les réponses étonnamment raisonnables de DALL-E 2 à des invites comme" un dessin animé d'un bébé radis daikon dans un tutu marchant avec un caniche ". Des invites telles que celles-ci génèrent souvent une approximation raisonnable d'un concept de composition, avec toutes les parties des invites présentes et présentes aux bons endroits.

«La compositionnalité, cependant, n'est pas seulement la capacité de coller des choses ensemble – même des choses que vous n'avez peut-être jamais observées ensemble auparavant. La compositionnalité nécessite une compréhension de la qui relient les choses. Les relations sont de telles règles.

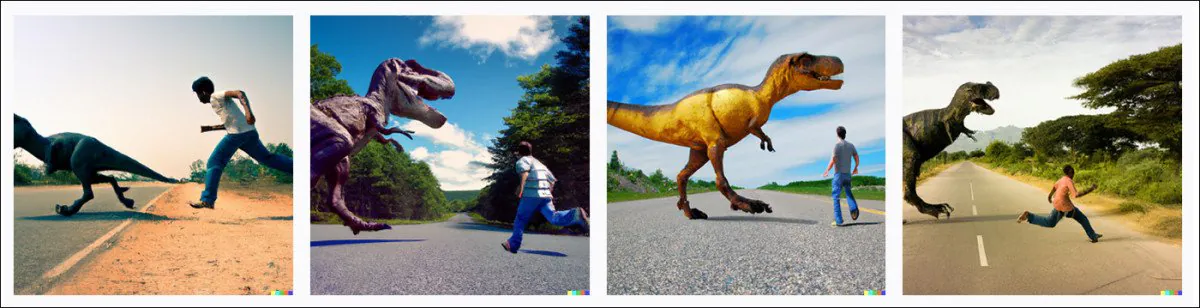

Un homme mord un T-Rex

Opinion Comme OpenAI embrasse un plus grand nombre d'utilisateurs après sa récente monétisation bêta de DALL-E 2, et puisqu'il faut maintenant payer pour la plupart des générations, les lacunes dans la compréhension relationnelle de DALL-E 2 peuvent devenir plus apparentes car chaque tentative "échouée" a un poids financier, et les remboursements ne sont pas disponibles.

Ceux d'entre nous qui ont reçu une invitation un peu plus tôt ont eu le temps (et, jusqu'à récemment, plus de temps pour jouer avec le système) d'observer certains des «problèmes relationnels» que DALL-E 2 peut émettre.

Par exemple, pour un Jurassic Park fan, il est très difficile de faire en sorte qu'un dinosaure poursuive une personne dans DALL-E 2, même si le concept de "poursuite" ne semble pas être dans DALL-E 2 système de censure, et même si le longue histoire de films de dinosaures devraient fournir de nombreux exemples de formation (au moins sous forme de bandes-annonces et de plans publicitaires) pour cette réunion d'espèces autrement impossible.

Une réponse DALL-E 2 typique à l'invite "Une photo couleur d'un T-Rex pourchassant un homme sur une route". Source : DALL-E 2

J'ai trouvé que les images ci-dessus sont typiques pour les variations sur le '[dinosaure] pourchassant [une personne]' conception rapide, et qu'aucune quantité d'élaboration dans l'invite ne peut amener le T-Rex à se conformer réellement. Sur les première et deuxième photos, l'homme poursuit (plus ou moins) le T-Rex ; dans le troisième, l'abordant avec un mépris désinvolte pour la sécurité; et dans l'image finale, apparemment jogging en parallèle à la grande bête. Au cours d'environ 10 à 15 tentatives sur ce thème, j'ai constaté que le dinosaure était également "distrait".

Il se pourrait que les seules données d'entraînement auxquelles DALL-E 2 puisse accéder se situent dans la ligne de 'l'homme combat le dinosaure', à partir de plans publicitaires pour des films plus anciens tels que One Million Years BC (1966), et que Jeff Goldblum vol célèbre du roi des prédateurs est simplement une valeur aberrante dans cette petite tranche de données.

* Ma conversion des citations en ligne des auteurs en hyperliens.

Première publication le 4 août 2022.