Cybersécurité

Comment sécuriser les données de formation de l'IA

L'intelligence artificielle (IA) a besoin de données, et de beaucoup de données. Rassembler les informations nécessaires n'est pas toujours un défi dans le contexte actuel, avec de nombreux ensembles de données publiques disponibles et de nombreuses données générées chaque jour. La sécurisation de ces données est toutefois une autre affaire.

La taille considérable des ensembles de données d’entraînement de l’IA et l’impact des modèles d’IA attirent l’attention des cybercriminels. À mesure que la dépendance à l’IA augmente, les équipes qui développent cette technologie doivent veiller à protéger leurs données d’entraînement.

Pourquoi les données d’entraînement de l’IA ont besoin d’une meilleure sécurité

Les données que vous utilisez pour former un modèle d'IA peuvent refléter des personnes, des entreprises ou des événements réels. Par conséquent, vous pourriez gérer une quantité considérable d'informations personnelles identifiables (PII), qui pourraient entraîner d'importantes violations de la vie privée si elles étaient exposées. En 2023, Microsoft a subi un tel incident, exposant accidentellement 38 téraoctets d'informations privées lors d'un projet de recherche en IA.

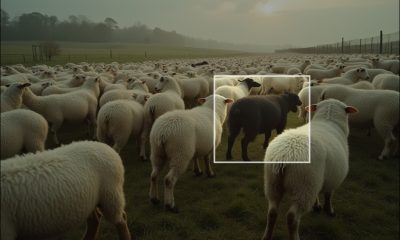

Les ensembles de données d'entraînement de l'IA peuvent également être vulnérables à des attaques adverses plus dangereuses. Les cybercriminels peuvent altérer la fiabilité d'un modèle d'apprentissage automatique en manipulant ses données d'entraînement s'ils peuvent y accéder. Il s'agit d'un type d'attaque connu sous le nom d'empoisonnement des données, et les développeurs d'IA peuvent ne pas remarquer les effets avant qu'il ne soit trop tard.

Des recherches montrent que l’empoisonnement seulement 0.001 % d'un ensemble de données Il suffit d'un certain temps pour corrompre un modèle d'IA. Sans protections adéquates, une attaque comme celle-ci pourrait avoir de graves conséquences une fois que le modèle sera mis en œuvre dans le monde réel. Par exemple, un algorithme de conduite autonome corrompu peut ne pas détecter les piétons. Par ailleurs, un outil d'IA d'analyse de CV peut produire des résultats biaisés.

Dans des circonstances moins graves, des attaquants pourraient voler des informations confidentielles à partir d'un ensemble de données de formation dans le cadre d'un acte d'espionnage industriel. Ils peuvent également bloquer l'accès des utilisateurs autorisés à la base de données et exiger une rançon.

L’IA devenant de plus en plus importante dans la vie quotidienne et dans les affaires, les cybercriminels ont tout intérêt à cibler les bases de données de formation. Tous ces risques, à leur tour, deviennent encore plus inquiétants.

5 étapes pour sécuriser les données de formation de l'IA

Face à ces menaces, prenez la sécurité au sérieux lors de la formation des modèles d'IA. Voici cinq étapes à suivre pour sécuriser vos données de formation d'IA.

1. Minimiser les informations sensibles dans les ensembles de données de formation

L’une des mesures les plus importantes consiste à supprimer la quantité de détails sensibles dans votre ensemble de données d’entraînement. Moins votre base de données contient d’informations personnelles identifiables ou d’autres informations précieuses, moins elle est une cible pour les pirates informatiques. Une violation aura également moins d’impact si elle se produit dans ces scénarios.

Les modèles d'IA n'ont souvent pas besoin d'utiliser des informations du monde réel pendant la phase de formation. Les données synthétiques constituent une alternative intéressante. Les modèles formés sur des données synthétiques peuvent être tout comme si ce n'était pas plus précis que d'autres, vous n'avez donc pas à vous soucier des problèmes de performances. Assurez-vous simplement que l'ensemble de données généré ressemble et agit comme des données du monde réel.

Vous pouvez également supprimer des ensembles de données existants les informations sensibles telles que les noms, les adresses et les informations financières des personnes. Lorsque ces facteurs sont nécessaires à votre modèle, envisagez de les remplacer par des données factices ou de les échanger entre les enregistrements.

2. Restreindre l’accès aux données de formation

Une fois que vous avez compilé votre ensemble de données de formation, vous devez en restreindre l'accès. Suivez le principe du moindre privilège, qui stipule que tout utilisateur ou programme ne doit pouvoir accéder qu'à ce qui est nécessaire pour effectuer correctement son travail. Toute personne non impliquée dans le processus de formation n'a pas besoin de voir ou d'interagir avec la base de données.

N'oubliez pas que les restrictions de privilèges ne sont efficaces que si vous implémentez également un moyen fiable de vérifier les utilisateurs. Un nom d'utilisateur et un mot de passe ne suffisent pas. L'authentification multifacteur (MFA) est essentielle, car elle empêche 80 à 90 % de toutes les attaques contre les comptes, mais toutes les méthodes d'authentification multifacteur ne sont pas égales. L'authentification multifacteur basée sur le texte et sur les applications est généralement plus sûre que les alternatives basées sur le courrier électronique.

Assurez-vous de restreindre les logiciels et les appareils, pas seulement les utilisateurs. Les seuls outils ayant accès à la base de données de formation doivent être le modèle d'IA lui-même et tous les programmes que vous utilisez pour gérer ces informations pendant la formation.

3. Crypter et sauvegarder les données

Le chiffrement est une autre mesure de protection essentielle. Bien que tous les algorithmes d'apprentissage automatique ne puissent pas s'entraîner activement sur des données chiffrées, vous pouvez les chiffrer et les déchiffrer pendant l'analyse. Vous pouvez ensuite les rechiffrer une fois que vous avez terminé. Vous pouvez également rechercher des structures de modèles capables d'analyser les informations tout en les chiffrant.

Il est important de conserver des sauvegardes de vos données d'entraînement au cas où quelque chose leur arriverait. Les sauvegardes doivent être situées dans un emplacement différent de la copie principale. Selon l'importance de votre ensemble de données, vous devrez peut-être conserver une sauvegarde hors ligne et une autre dans le cloud. N'oubliez pas de chiffrer également toutes les sauvegardes.

En matière de chiffrement, choisissez soigneusement votre méthode. Des normes plus élevées sont toujours préférables, mais vous pouvez envisager d'utiliser des algorithmes de cryptographie résistants aux attaques quantiques à mesure que la menace d'attaques quantiques augmente.

4. Surveiller l'accès et l'utilisation

Même si vous suivez ces autres étapes, les cybercriminels peuvent percer vos défenses. Par conséquent, vous devez surveiller en permanence les modèles d’accès et d’utilisation avec vos données d’entraînement d’IA.

Une solution de surveillance automatisée est probablement nécessaire ici, car peu d'organisations disposent des effectifs nécessaires pour surveiller les activités suspectes 24 heures sur 24. L'automatisation est également beaucoup plus rapide à réagir lorsqu'un événement inhabituel se produit, ce qui conduit à 2.22 $ de moins pour les coûts liés aux violations de données en moyenne, grâce à des réponses plus rapides et plus efficaces.

Enregistrez chaque fois que quelqu'un ou quelque chose accède à l'ensemble de données, demande à y accéder, le modifie ou interagit avec lui d'une autre manière. En plus de surveiller les éventuelles violations dans cette activité, examinez-la régulièrement pour détecter des tendances plus larges. Le comportement des utilisateurs autorisés peut changer au fil du temps, ce qui peut nécessiter un changement dans vos autorisations d'accès ou dans vos données biométriques comportementales si vous utilisez un tel système.

5. Réévaluer régulièrement les risques

De même, les équipes de développement d’IA doivent comprendre que la cybersécurité est un processus continu et non une solution ponctuelle. Les méthodes d’attaque évoluent rapidement : certaines vulnérabilités et menaces peuvent passer inaperçues avant même que vous ne les remarquiez. La seule façon de rester en sécurité est de réévaluer régulièrement votre posture de sécurité.

Au moins une fois par an, examinez votre modèle d'IA, ses données d'entraînement et tout incident de sécurité qui les a affectés. Auditez l'ensemble de données et l'algorithme pour vous assurer qu'ils fonctionnent correctement et qu'aucune donnée empoisonnée, trompeuse ou autrement nuisible n'est présente. Adaptez vos contrôles de sécurité si nécessaire à toute anomalie que vous remarquez.

Les tests de pénétration, où les experts en sécurité testent vos défenses en essayant de les percer, sont également bénéfiques. 17% des professionnels de la cybersécurité Ils effectuent des tests de pénétration au moins une fois par an et 72 % de ceux qui le font déclarent penser que cela a permis d'éviter une violation dans leur organisation.

La cybersécurité est la clé d'un développement sûr de l'IA

Le développement d'une IA éthique et sûre devient de plus en plus important à mesure que les problèmes potentiels liés à la dépendance à l'apprentissage automatique se font de plus en plus importants. La sécurisation de votre base de données de formation est une étape essentielle pour répondre à cette demande.

Les données d'entraînement de l'IA sont trop précieuses et vulnérables pour ignorer les cyber-risques qu'elles représentent. Suivez ces cinq étapes dès aujourd'hui pour protéger votre modèle et son ensemble de données.