Intelligence Artificielle

Les GPU peuvent être meilleurs, pas seulement plus rapides, pour former des réseaux de neurones profonds

Des chercheurs polonais et japonais, en collaboration avec Sony, ont découvert que les systèmes d'apprentissage automatique formés sur des GPU plutôt que sur des CPU peuvent contenir moins d'erreurs pendant le processus de formation et produire des résultats supérieurs, contredisant l'idée commune selon laquelle les GPU effectuent simplement de telles opérations plus rapidement. que n'importe quel meilleur.

La recherche, intitulée Impact de l'incertitude GPU sur la formation des réseaux de neurones profonds prédictifs, vient de la faculté de psychologie et des sciences cognitives de l'université Adam Mickiewicz et de deux universités japonaises, ainsi que des laboratoires d'informatique SONY.

L'étude suggère que « incertitudes » que les réseaux de neurones profonds présentent face à diverses configurations matérielles et logicielles favorisent plus cher (et de plus en plus rares) unités de traitement graphique, et ont découvert lors de tests qu'un réseau de neurones profond formé exclusivement sur le processeur produisait des taux d'erreur plus élevés sur le même nombre d'époques (le nombre de fois que le système retraite les données de formation au cours d'une session).

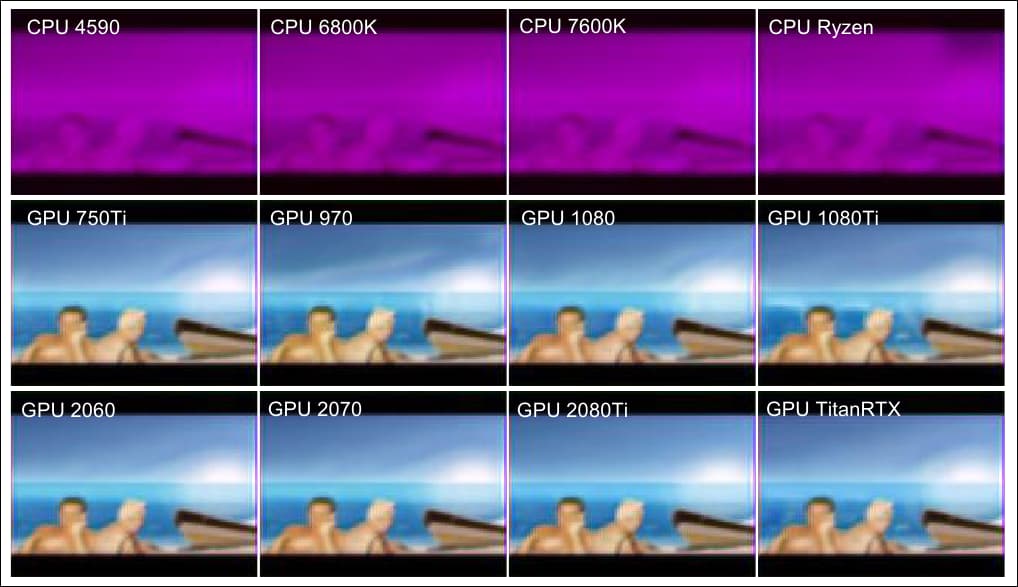

Dans cet exemple supplémentaire de l'article, nous voyons (deux rangées du bas), une qualité de résultat similaire obtenue à partir d'une variété de GPU, et (première rangée), les résultats inférieurs obtenus à partir d'une gamme de processeurs par ailleurs très performants. Source : https://arxiv.org/pdf/2109.01451.pdf

Phénomènes étranges

Ces résultats préliminaires ne s'appliquent pas uniformément aux algorithmes d'apprentissage automatique populaires, et dans le cas d'architectures d'auto-encodeurs simples, le phénomène n'apparaît pas.

Néanmoins, le travail suggère une possible « vitesse d'échappement » pour l'efficacité de la formation dans les réseaux neuronaux complexes, où couvrir les mêmes opérations à une vitesse inférieure et des temps de formation plus longs n'obtient pas la parité de performance que l'on attendrait des routines d'itération mathématique.

Les chercheurs suggèrent que cette disparité de performances pourrait être particulière à certains types de réseaux de neurones, et que les aspects indéterminés du traitement spécifique au GPU, souvent considérés comme un obstacle à éventuellement surmonter, pourraient non seulement offrir des avantages notables, mais pourraient éventuellement être intentionnellement intégré dans les systèmes ultérieurs. L'article suggère également que les résultats pourraient offrir des informations plus approfondies sur le traitement informatique lié au cerveau.

L’identification des particularités qui augmentent l’efficacité et la qualité des résultats de cette manière sur les GPU offre le potentiel d’obtenir une compréhension plus approfondie des architectures d’IA de type « boîte noire », et même d’améliorer les performances du processeur – bien qu’actuellement, les causes sous-jacentes soient insaisissables.

Autoencodeur Vs. PrédNet

Pour étudier les anomalies, les chercheurs ont utilisé un auto-encodeur de base ainsi que le réseau neuronal prédictif de l'Université Harvard. PrédNet, une recherche de 2016 conçue pour explorer et tenter de reproduire le comportement du cortex cérébral humain.

Les deux systèmes sont des réseaux neuronaux profonds conçus pour synthétiser des images pertinentes grâce à un apprentissage non supervisé (avec des données dont les étiquettes ont été omises), bien que l'auto-encodeur traite linéairement une image par lot, ce qui produirait ensuite une sortie comme image suivante dans un pipeline récurrent. L'auto-encodeur a été formé sur le MNIST base de données d'écriture manuscrite.

L'autoencodeur utilisé dans les tests des chercheurs a été formé sur la base de données MNIST, qui comprend 60,000 28 images d'entraînement à 28 × 10,000 pixels, anticrénelées pour l'induction en niveaux de gris, ainsi que XNUMX XNUMX images de test.

En revanche, PredNet évalue les entrées vidéo complexes et, dans le cas de cette recherche, a été formé sur le Jeu de données FPSI, qui présente de nombreuses séquences vidéo portées sur le corps d'une journée à Disney World à Orlando, en Floride (Disney était l'un des associés de recherche sur l'article de 2012).

Séquences d'images de FPSI, montrant des vues à la première personne lors d'une journée à Disney World.

Les deux architectures sont très différentes en termes de complexité. L'auto-encodeur est conçu pour reconstruire des images plutôt que pour prédire les valeurs cibles. En revanche, PredNet comporte quatre couches, chacune constituée de neurones de représentation utilisant la mémoire convolutionnelle à long terme (LSTM).

Les couches produisent des prédictions contextuelles qui sont ensuite comparées à une cible afin de produire un terme d'erreur qui se propage à travers le réseau. Chacun des deux modèles utilise un apprentissage non supervisé.

L'architecture simple et linéaire de l'auto-encodeur, et le réseau plus labyrinthique et récursif de PredNet.

Les deux systèmes ont été testés sur un éventail de configurations matérielles et logicielles, y compris des processeurs sans GPU (Intel i5-4590, i7-6800K, i5-7600K ou AMD Ryzen-5-3600) et des processeurs avec GPU (Intel i5-7600K + NVIDIA GTX-750Ti, i5-7600K + GTX-970, i7-6700K + GTX-1080, i7-7700K + GTX-1080Ti, i7-9700 + RTX-2080Ti, i5-7600K + RTX-2060 super, AMD Ryzen-5- 3600 + RTX-2070 super ou i5-9400 + Titan-RTX).

Le visualiseur de processus interactif htop a été utilisé pour s'assurer que toute la formation se produisait soit sur un seul thread (sur un Intel i7-6800K), sur quatre threads (sur un Intel i5-4590 et i5-7600K), soit sur six threads (sur un AMD Ryzen-5-3600 ).

Points de selle

Sur l'auto-encodeur, la différence moyenne entre toutes les configurations, avec et sans cuDNN, n'était pas significative. Pour PredNet, les résultats ont été plus surprenants, avec des différences notables dans l'évaluation des pertes et la qualité entre la formation CPU et GPU.

Les résultats de perte moyens pour la formation PredNet sur quatre CPU et huit GPU, avec le réseau formé sur 5000 images vidéo en 250 lots, avec une perte moyenne pour les 1000 dernières images (50 lots) représentées. cuDNN a été désactivé.

Les chercheurs concluent que « Bien que le mécanisme ne soit pas clair, le matériel GPU semble avoir la capacité de faire progresser la formation des DNN. »

Les résultats indiquent que les GPU pourraient être plus efficaces pour éviter les points de selle, les zones de descente en pente qui décrivent le bas d'une pente.

Le nadir des pentes dans une descente en pente est le « point de selle », nommé ainsi pour des raisons évidentes. Source : https://www.pinterest.com.au/pin/436849232581124086/

Les points de selle, bien qu'un obstacle, ont été largement rejetés comme facilement contournables dans la réflexion récente sur l'optimisation de la descente de gradient stochastique (SGD), mais le nouvel article suggère non seulement que les GPU peuvent être équipés de manière unique pour les éviter, mais que l'influence de les points de selle devraient peut-être être revus.