Videogeneraattorit

Miksi generatiiviset videojärjestelmät eivät voi tehdä kokonaisia elokuvia?

Generatiivisen tekoälyvideon tulo ja edistyminen on saanut monet satunnaiset tarkkailijat siihen ennustaa että koneoppiminen todistaa tunnetun elokuvateollisuuden kuoleman – sen sijaan yksittäiset tekijät voivat luoda Hollywood-tyylisiä menestyselokuvia kotona joko paikallisilla tai pilvipohjaisilla GPU-järjestelmillä.

Onko tämä mahdollista? Vaikka se on mahdollista, onko se lähestyvä, kuten monet uskovat?

On täysin mahdollista – ja ehkä jopa väistämätöntä – että yksilöt pystyvät lopulta luomaan elokuvia siinä muodossa, jossa me heidät tunnemme, johdonmukaisine hahmoineen, kerronnan jatkuvuudella ja täydellisellä fotorealismilla.

On kuitenkin useita todella perustavanlaatuisia syitä, miksi näin ei todennäköisesti tapahdu videojärjestelmissä, jotka perustuvat Piilevä diffuusiomallit.

Tämä viimeinen seikka on tärkeä, koska tällä hetkellä tämä luokka sisältää joka saatavilla suosittu tekstistä videoksi (T2) ja kuvasta videoksi (I2V) -järjestelmä, mukaan lukien Minimax, Kling, Sora, Imagen, Luma, Amazon Video Generator, Runway ML, Kaiber (ja sikäli kuin voimme havaita, Adobe Firefly odotettaessa videotoiminto); joukossa monet muut.

Tässä harkitsemme todennäköisyyttä kirjailija yksilöiden luomia täyspitkiä gen-AI-tuotantoja, joissa on johdonmukaiset hahmot, kuvaus ja visuaaliset tehosteet, jotka ovat vähintään Hollywoodin nykyisen huipputason mukaisia.

Katsotaanpa joitain suurimpia käytännön esteitä haasteisiin.

1: Et voi saada tarkkaa jatkolaukausta

Kerronnan epäjohdonmukaisuus on suurin näistä tiesulkuista. Tosiasia on, että mikään tällä hetkellä saatavilla oleva videontuotantojärjestelmä ei voi tehdä todella tarkkaa "seurantaa"*.

Tämä johtuu siitä, että vaimentava diffuusiomalli näiden järjestelmien ytimessä satunnainen melu, ja tätä ydinperiaatetta ei voida soveltaa täsmälleen saman sisällön uudelleentulkimiseen kahdesti (eli eri näkökulmista tai kehittämällä edellistä kuvaa jatkokuvaksi, joka säilyttää johdonmukaisuuden edellisen kuvan kanssa).

Missä tekstikehotteita käytetään, yksin tai yhdessä ladatut siemenkuvat (multimodaalinen syöttö), rahakkeita kehotteesta johdettu saa koulutetuilta semanttisesti sopivaa sisältöä piilevä tila mallin.

Kuitenkin, "satunnaisen kohina" vaikeuttaa entisestään, se tekee älä koskaan tee sitä samalla tavalla kahdesti.

Tämä tarkoittaa, että videon ihmisten identiteetit vaihtelevat ja kohteet ja ympäristöt eivät vastaa alkuperäistä kuvaa.

Tästä syystä poikkeuksellista visuaalista ja Hollywood-tason tulosta kuvaavat virusleikkeet ovat yleensä joko yksittäisiä otoksia tai järjestelmän ominaisuuksien "showcase-montaasi", jossa jokaisessa otoksessa on erilaisia hahmoja ja ympäristöjä.

Otteita Marco van Hylckama Vliegin generatiivisesta tekoälymontaasista – lähde: https://www.linkedin.com/posts/marcovhv_thanks-to-generative-ai-we-are-all-filmmakers-activity-7240024800906076160-nEXZ/

Vaikutus näissä kokoelmissa ad hoc videosukupolvet (mikä voi olla epäreilua kaupallisten järjestelmien tapauksessa) on taustalla oleva järjestelmä voida luoda yhtenäisiä ja johdonmukaisia kertomuksia.

Tässä hyödynnetty analogia on elokuvan traileri, joka sisältää vain minuutin tai kaksi materiaalia elokuvasta, mutta antaa katsojalle aiheen uskoa, että koko elokuva on olemassa.

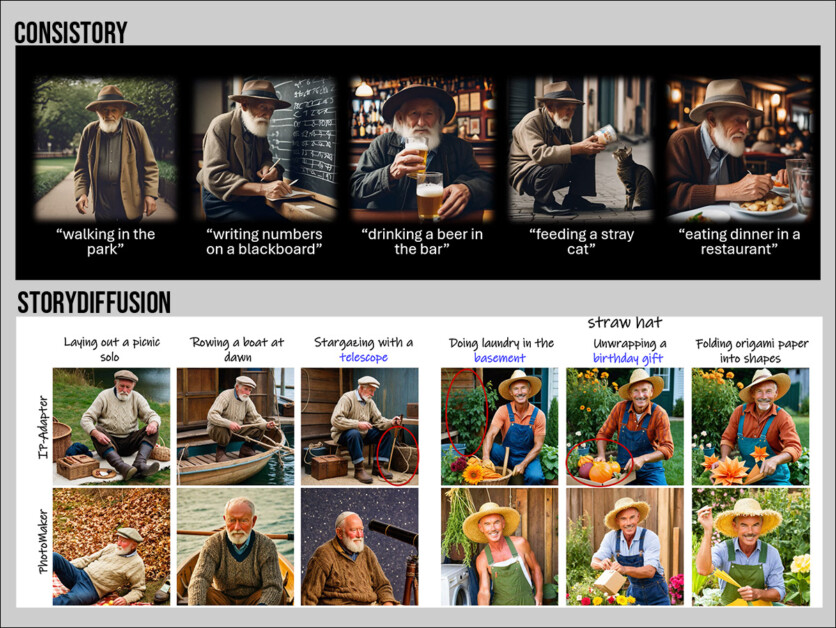

Ainoat järjestelmät, jotka tarjoavat tällä hetkellä kerronnan johdonmukaisuutta diffuusiomallissa, ovat ne, jotka tuottavat still-kuvia. Näihin kuuluvat NVIDIA:t Konsistori, ja erilaisia tieteellisen kirjallisuuden projekteja, kuten TheaterGen, DreamStoryja StoryDiffusion.

Kaksi esimerkkiä "staattisesta" kerronnan jatkuvuudesta, viimeaikaisista malleista: Lähteet: https://research.nvidia.com/labs/par/consistory/ ja https://arxiv.org/pdf/2405.01434

Teoriassa voitaisiin käyttää tällaisten järjestelmien parempaa versiota (mikään yllä olevista ei ole todella johdonmukainen) sarjan kuvasta videoon luomiseen, jotka voitaisiin yhdistää sarjaksi.

Nykyisellä tekniikan tasolla tämä lähestymistapa ei tuota uskottavia jatkokuvia; ja joka tapauksessa olemme jo poikennut kirjailija unelma lisäämällä monimutkaisuutta.

Voimme lisäksi käyttää Matala-arvoinen sopeutuminen (LoRA) -mallit, jotka on erityisesti koulutettu hahmoihin, asioihin tai ympäristöihin, jotta otosten välinen yhtenäisyys säilyisi paremmin.

Jos hahmo kuitenkin haluaa esiintyä uudessa asussa, on yleensä koulutettava kokonaan uusi LoRA, joka ilmentää tällä tavalla pukeutunutta hahmoa (vaikka alakäsitteitä, kuten "punainen mekko" voidaan kouluttaa yksittäisiksi LoRA-puvuiksi, yhdessä sopivien kuvien kanssa, niiden käsittely ei ole aina helppoa).

Tämä lisää huomattavasti monimutkaisuutta, jopa elokuvan aloituskohtaukseen, jossa henkilö nousee sängystä, pukee aamutakin, haukottelee, katsoo ulos makuuhuoneen ikkunasta ja menee vessaan pesemään hampaitaan.

Tällainen noin 4-8 otosta sisältävä kohtaus voidaan kuvata yhdessä aamussa tavanomaisilla elokuvantekomenetelmillä; generatiivisen tekoälyn nykyisellä tekniikan tasolla se edustaa mahdollisesti viikkoja työtä, useita koulutettuja LoRA:ita (tai muita lisäjärjestelmiä) ja huomattavaa määrää jälkikäsittelyä

Vaihtoehtoisesti voidaan käyttää videosta videoon, jossa arkipäiväinen tai CGI-materiaali muunnetaan tekstikehotteiden avulla vaihtoehtoisiksi tulkinnoiksi. Kiitotie tarjoukset esimerkiksi tällainen järjestelmä.

CGI (vasemmalla) Blenderistä, tulkinta Mathieu Visnjevecin tekstiavusteisessa Runway-videosta videoon -kokeessa – Lähde: https://www.linkedin.com/feed/update/urn:li:activity:7240525965309726721/

Tässä on kaksi ongelmaa: sinun on jo luotava ydinmateriaalia, joten olet jo tekemässä elokuvaa kahdesti, vaikka käyttäisit synteettistä järjestelmää, kuten UnRealin Metahuman.

Jos luot CGI-malleja (kuten yllä olevassa pätkässä) ja käytät niitä videosta kuvaksi -muunnoksessa, niiden johdonmukaisuuteen kuvien välillä ei voida luottaa.

Tämä johtuu siitä, että videon diffuusiomallit eivät näe "isoa kuvaa" vaan ne luovat uuden kehyksen aikaisempien ruutujen perusteella. jonkin verran tapauksissa, harkitse lähellä olevaa tulevaa kehystä; mutta verrattaessa prosessia shakkipeliin, he eivät voi ajatella "kymmentä siirtoa eteenpäin" eivätkä muista kymmentä siirtoa takana.

Toiseksi diffuusiomallilla on edelleen vaikeuksia säilyttää yhtenäisen ulkonäön kaikissa otoksissa, vaikka sisällytät useita LoRA:ita hahmolle, ympäristölle ja valaistustyylille tämän osion alussa mainituista syistä.

2: Et voi muokata kuvaa helposti

Jos kuvaat hahmoa kävelemässä kadulla vanhan koulukunnan CGI-menetelmillä ja päätät muuttaa kuvan osaa, voit säätää mallia ja hahmontaa sen uudelleen.

Jos kyseessä on tosielämän kuvaus, nollaa ja kuvaa se uudelleen sopivin muutoksin.

Kuitenkin, jos tuotat gen-AI-videon, jota rakastat, mutta haluat muuttaa yksi näkökohta Sen voit saavuttaa vain viimeisten 30–40 vuoden aikana kehitetyillä huolellisilla jälkituotantomenetelmillä: CGI, rotoskooppi, mallinnus ja matto – kaikki työvaltaisia ja kalliita, aikaavievä menettelyjä.

Tapa, jolla diffuusiomallit toimivat, yksinkertaisesti muuttamalla yhtä tekstikehotteen osa-aluetta (jopa multimodaalisessa kehotteessa, jossa annat täydellisen lähdekuvan) muuttuu. useita näkökohtia generoidusta lähdöstä, mikä johtaa peliin, jossa kehotetaan "whack-a-mole".

3: Et voi luottaa fysiikan lakeihin

Perinteiset CGI-menetelmät tarjoavat erilaisia algoritmisia fysiikkaan perustuvia malleja, jotka voivat simuloida asioita, kuten nesteen dynamiikkaa, kaasun liikettä, käänteistä kinematiikkaa (ihmisen liikkeen tarkka mallinnus), kangasdynamiikkaa, räjähdyksiä ja monia muita reaalimaailman ilmiöitä.

Kuitenkin, kuten olemme nähneet, diffuusiopohjaisilla menetelmillä on lyhyt muisti ja myös rajallinen valikoima motion priors (esimerkkejä sellaisista toimista, jotka sisältyvät harjoitustietoaineistoon) hyödyntää.

Vuonna aiempi versio OpenAI:n kehutun Sora-generatiivisen järjestelmän aloitussivulla yritys myönsi, että Soralla on rajoituksia tässä suhteessa (vaikka tämä teksti on sittemmin poistettu):

"[Soralla] voi olla vaikeuksia simuloida monimutkaisen kohtauksen fysiikkaa, eikä se välttämättä ymmärrä tiettyjä syyn ja seurauksen tapauksia (esimerkiksi: eväste ei ehkä näytä merkkiä hahmon puremisen jälkeen).

"Malli voi myös hämmentää kehotteeseen sisältyviä spatiaalisia yksityiskohtia, kuten vasemman ja oikean erottelua, tai kamppailla tarkkojen kuvausten kanssa ajan mittaan kehittyvistä tapahtumista, kuten tietyt kameran liikeradat."

Erilaisten API-pohjaisten generatiivisten videojärjestelmien käytännön käyttö paljastaa samanlaisia rajoituksia tarkan fysiikan kuvaamisessa. Tietyt yleiset fyysiset ilmiöt, kuten räjähdykset, näyttävät kuitenkin olevan paremmin edustettuina heidän harjoitustietosarjoissaan.

Jotkin liikettä edeltävät upotukset, jotka on joko koulutettu generatiiviseen malliin tai syötetty lähdevideosta, kestää jonkin aikaa (kuten henkilö, joka suorittaa monimutkaisen ja ei-toistuvan tanssisarjan taidokasasussa) ja jälleen kerran, diffuusio mallin likinäköinen huomioikkuna muuttaa todennäköisesti sisällön (kasvotunnus, pukutiedot jne.) siihen mennessä, kun liike on toistettu. LoRA:t voivat kuitenkin lieventää tätä jossain määrin.

Korjaus postissa

Puhtaalla "yhden käyttäjän" AI-videoiden luomisessa on muita puutteita, kuten vaikeus heillä on kuvatessaan nopeita liikkeitä ja yleistä ja paljon kiireellisempää ongelmaa saavuttaa ajallinen johdonmukaisuus ulostulovideossa.

Lisäksi tiettyjen kasvoesitysten luominen on melkoisesti onnenkysymys generatiivisessa videossa, samoin kuin huulten synkronointi dialogissa.

Molemmissa tapauksissa käytetään apujärjestelmiä, kuten LivePortrait ja AnimateDiff on tulossa erittäin suosituksi VFX-yhteisössä, koska tämä mahdollistaa ainakin laajan ilmeen ja huulten synkronoinnin olemassa olevaan tuotettuun ulostuloon.

Esimerkki ilmaisunsiirrosta (ajovideo vasemmassa alakulmassa), joka kohdistetaan kohdevideoon LivePortraitilla. Video on Generative Z TunisiaGenerativelta. Katso täyspitkä versio paremmalla laadulla osoitteessa https://www.linkedin.com/posts/genz-tunisia_digitalcreation-liveportrait-aianimation-activity-7240776811737972736-uxiB/?

Lisäksi lukemattomia monimutkaisia ratkaisuja, jotka sisältävät työkaluja, kuten Stable Diffusion GUI Mukava käyttöliittymä ja ammattimainen kompositio- ja manipulointisovellus ydinase, sekä piilevän tilan manipuloinnin ansiosta AI VFX -harjoittajat voivat hallita paremmin kasvojen ilmettä ja asennetta.

Vaikka hän kuvailee kasvojen animaatioprosessi ComfyUI:ssa "kidutuksena", VFX-ammattilainen Francisco Contreras on kehittänyt sellaisen menettelyn, joka mahdollistaa huulifoneemien ja muiden kasvojen/pään kuvauksen näkökohtien käyttöönoton."

Vakaa diffuusio, jota auttoi Nuke-käyttöinen ComfyUI-työnkulku, antoi VFX-ammattilaisen Francisco Contrerasin saada epätavallisen hallinnan kasvojen ominaisuuksiin. Katso koko video paremmalla resoluutiolla osoitteessa https://www.linkedin.com/feed/update/urn:li:activity:7243056650012495872/

Yhteenveto

Mikään näistä ei ole lupaavaa, jos yksittäinen käyttäjä voi luoda yhtenäisiä ja fotorealistisia täyspitkiä elokuvia, joissa on realistinen dialogi, huulisynkronointi, esitykset, ympäristöt ja jatkuvuus.

Lisäksi tässä kuvatut esteet, ainakaan diffuusiopohjaisten generatiivisten videomallien suhteen, eivät välttämättä ole ratkaistu nyt "minuutin hetkellä" huolimatta foorumin kommenteista ja mediahuomiosta, jotka tekevät asian. Kuvatut rajoitteet näyttävät olevan arkkitehtuurille luontaisia.

Tekoälyn synteesitutkimuksessa, kuten kaikessa tieteellisessä tutkimuksessa, loistavat ideat häikäisevät meidät ajoittain potentiaalillaan, vain lisätutkimuksessa paljastaakseen niiden perustavanlaatuiset rajoitukset.

Generatiivisessa/synteesitilassa tämä on jo tapahtunut Generative Adversarial Networks (GAN) ja hermosäteilykentät (NeRF), jotka molemmat osoittautuivat lopulta erittäin vaikeaksi instrumentalisoida tehokkaiksi kaupallisiksi järjestelmiksi huolimatta vuosien akateemisesta tutkimuksesta tämän tavoitteen saavuttamiseksi. Nämä tekniikat näkyvät nyt useimmiten lisäkomponentteina vaihtoehtoisissa arkkitehtuureissa.

Kuten elokuvastudiot saattavat toivoa, että laillisesti lisensoituja elokuvaluetteloita koskeva koulutus voisi tehdä poista VFX-artistit, AI on itse asiassa lisää työvoiman roolit tällä hetkellä.

Se, voidaanko diffuusiopohjaiset videojärjestelmät todella muuttaa kerronnallisesti johdonmukaisiksi ja fotorealistisiksi elokuvageneraattoreiksi vai onko koko liiketoiminta vain yksi alkeeminen harrastus, pitäisi ilmetä seuraavan 12 kuukauden aikana.

Voi olla, että tarvitsemme täysin uuden lähestymistavan; tai se voi olla sitä Gaussin splatting (GSplat), joka kehitettiin i1990-luvun alussa ja on äskettäin otettu pois kuvasynteesitilassa edustaa mahdollista vaihtoehtoa diffuusiopohjaiselle videon luomiselle.

Koska GSplatin esiintuominen kesti 34 vuotta, on mahdollista, että myös vanhemmat kilpailijat, kuten NeRF ja GAN – ja jopa piilevät diffuusiomallit – ovat vielä edessään.

* Vaikka Kaiberin AI Storyboard -ominaisuus tarjoaa tämänkaltaisia toimintoja, olen nähnyt tuloksia ei tuotannon laatua.

Martin Anderson on entinen metaphysic.ai:n tieteellisen tutkimuksen sisällön johtaja

Julkaistu ensimmäisen kerran maanantaina 23