Anderson se hoek

Herstel en redigering van menslike beelde met KI

'n Nuwe samewerking tussen die Universiteit van Kalifornië, Merced, en Adobe bied 'n vooruitgang op die nuutste tegnologie in menslike beeldvoltooiing – die veelbestudeerde taak om versteekte of verborge dele van beelde van mense te 'ontbloot', vir doeleindes soos virtuele aanpak, animasie en fotoredigering.

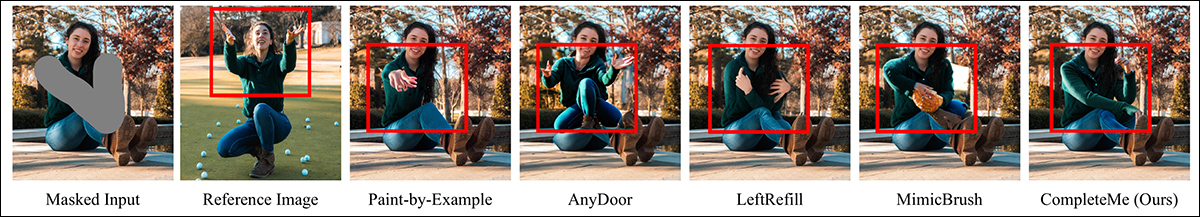

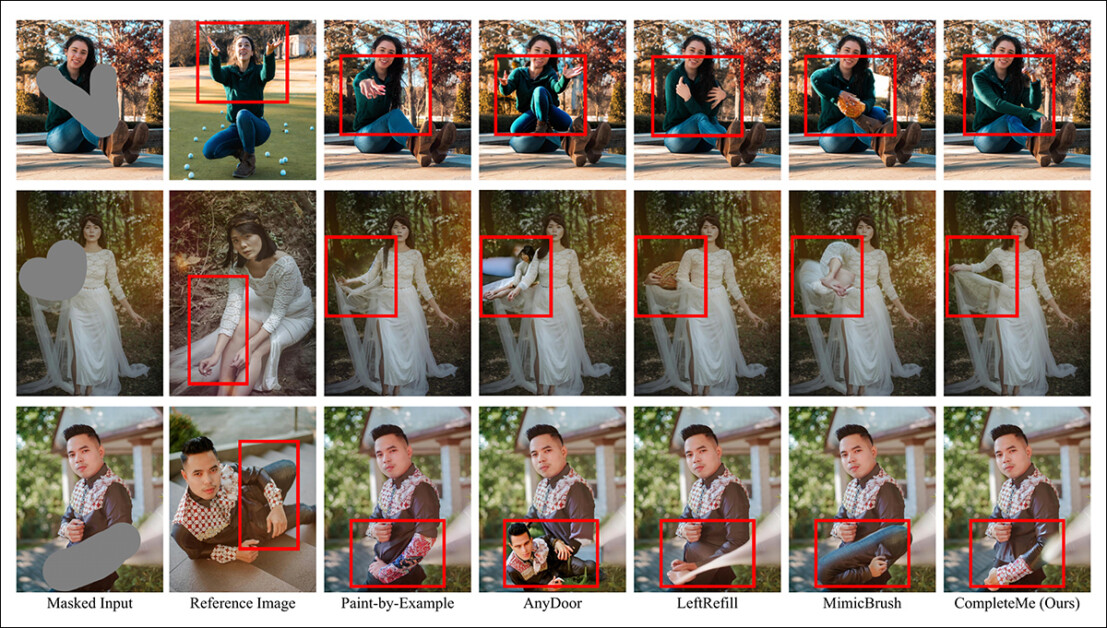

Behalwe dat beskadigde beelde herstel of na goeddunke verander word, kan menslike beeldvoltooiingstelsels soos CompleteMe nuwe klere (via 'n bykomende verwysingsbeeld, soos in die middelste kolom in hierdie twee voorbeelde) in bestaande beelde oplê. Hierdie voorbeelde is afkomstig van die uitgebreide aanvullende PDF vir die nuwe artikel. Bron: https://liagm.github.io/CompleteMe/pdf/supp.pdf

Die nuwe benadering, getitel CompleteMe: Verwysingsgebaseerde Menslike Beeldvoltooiing, gebruik aanvullende invoerbeelde om aan die stelsel te 'voorstel' watter inhoud die verborge of ontbrekende gedeelte van die menslike uitbeelding moet vervang (vandaar die toepaslikheid op mode-gebaseerde pasraamwerke):

Die CompleteMe-stelsel kan verwysingsinhoud aanpas by die verduisterde of versperde deel van 'n menslike beeld.

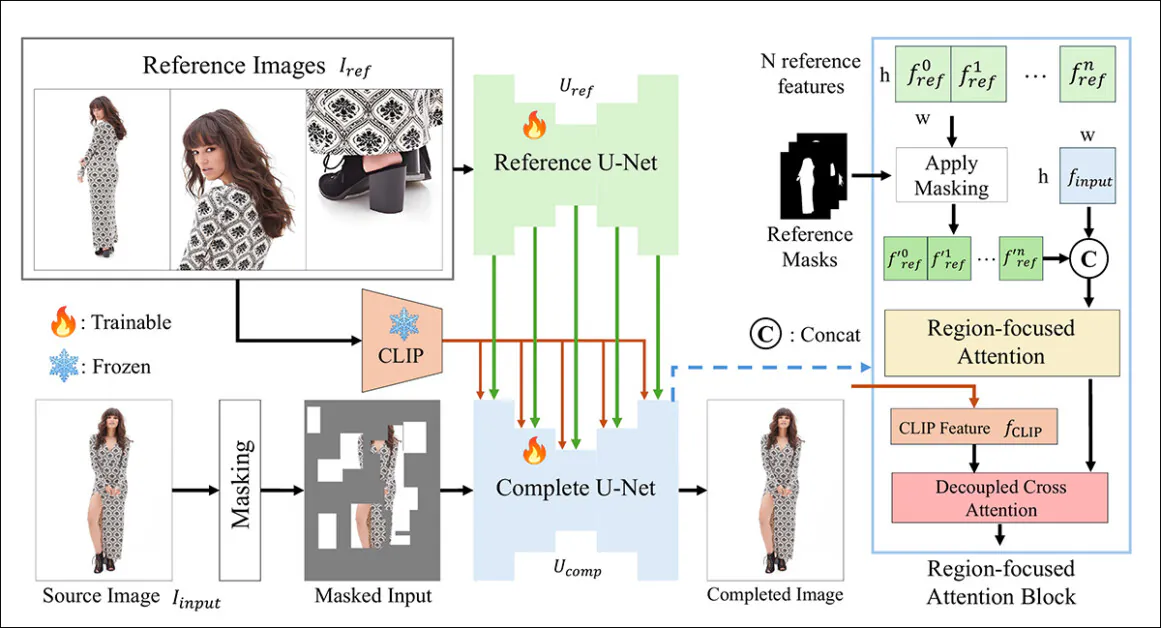

Die nuwe stelsel gebruik 'n dubbele U-Net argitektuur en 'n Streekgerigte aandag (RFA)-blok wat hulpbronne na die relevante area van die beeldherstel-instansie stuur.

Die navorsers bied ook 'n nuwe en uitdagende maatstafstelsel wat ontwerp is om verwysingsgebaseerde voltooiingstake te evalueer (aangesien CompleteMe deel is van 'n bestaande en deurlopende navorsingsstring in rekenaarvisie, alhoewel een wat tot dusver geen maatstafskema gehad het nie).

In toetse, en in 'n goed-geskaalde gebruikersstudie, het die nuwe metode in die meeste metrieke, en oor die algemeen, vooruit gevaar. In sekere gevalle is mededingende metodes heeltemal deur die verwysingsgebaseerde benadering oorskadu:

Uit die aanvullende materiaal: die AnyDoor-metode het besondere probleme om te besluit hoe om 'n verwysingsbeeld te interpreteer.

Die artikel sê:

Uitgebreide eksperimente op ons maatstaf toon dat CompleteMe beter presteer as die nuutste metodes, beide verwysingsgebaseerd en nie-verwysingsgebaseerd, in terme van kwantitatiewe metrieke, kwalitatiewe resultate en gebruikersstudies.

'Veral in uitdagende scenario's wat komplekse houdings, ingewikkelde klerepatrone en kenmerkende bykomstighede behels, bereik ons model konsekwent uitstekende visuele getrouheid en semantiese samehang.'

Ongelukkig, die projek se GitHub-teenwoordigheid bevat geen kode nie, en belowe ook geen, en die inisiatief, wat ook 'n beskeie Projek bladsy, lyk as 'n eie argitektuur geraam.

Verdere voorbeeld van die nuwe stelsel se subjektiewe prestasie teenoor vorige metodes. Meer besonderhede later in die artikel.

Metode

Die CompleteMe-raamwerk word ondersteun deur 'n Verwysings-U-Net, wat die integrasie van die bykomende materiaal in die proses hanteer, en 'n samehangende U-Net, wat 'n wyer reeks prosesse akkommodeer om die finale resultaat te verkry, soos geïllustreer in die konseptuele skema hieronder:

Die konseptuele skema vir CompleteMe. Bron: https://arxiv.org/pdf/2504.20042

Die stelsel kodeer eers die gemaskerde invoerbeeld in 'n latente voorstelling. Terselfdertyd verwerk die Reference U-Net verskeie verwysingsbeelde – elk wat verskillende liggaamsgebiede toon – om gedetailleerde ruimtelike inligting te onttrek. kenmerke.

Hierdie kenmerke gaan deur 'n streekgefokusde aandagblok wat in die 'volledige' U-Net ingebed is, waar hulle is selektief gemasker deur ooreenstemmende streekmaskers te gebruik, om te verseker dat die model slegs relevante areas in die verwysingsbeelde aandag gee.

Die gemaskerde kenmerke word dan geïntegreer met globale CLIP-afgeleide semantiese kenmerke deur ontkoppelde kruisaandag, wat die model toelaat om ontbrekende inhoud met beide fyn detail en semantiese samehang te rekonstrueer.

Om realisme en robuustheid te verbeter, kombineer die invoermaskeringsproses ewekansige roostergebaseerde okklusies met menslike liggaamsvormmaskers, elk toegepas met gelyke waarskynlikheid, wat die kompleksiteit van die ontbrekende streke wat die model moet voltooi, verhoog.

Slegs vir verwysing

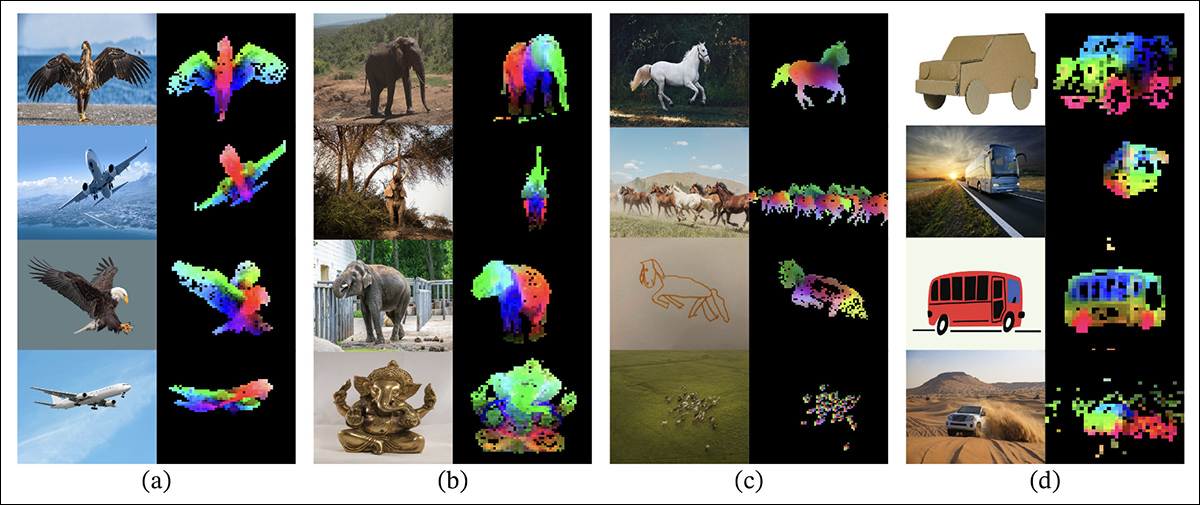

Vorige metodes vir verwysingsgebaseerde beeldinskildering het tipies staatgemaak op semantiese vlak enkodeerders. Projekte van hierdie aard sluit CLIP self in, en DINOv2, wat albei globale kenmerke uit verwysingsbeelde onttrek, maar dikwels die fyn ruimtelike besonderhede verloor wat nodig is vir akkurate identiteitsbewaring.

Uit die vrystellingsdokument vir die ouer DINOV2-benadering, wat in vergelykingstoetse in die nuwe studie ingesluit is: Die gekleurde oorlegsels toon die eerste drie hoofkomponente van Hoofkomponentanalise (PCA), toegepas op beeldkolle binne elke kolom, wat uitlig hoe DINOv2 soortgelyke voorwerpdele oor verskillende beelde groepeer. Ten spyte van verskille in houding, styl of weergawe, word ooreenstemmende streke (soos vlerke, ledemate of wiele) konsekwent ooreenstem, wat die model se vermoë illustreer om onderdeelgebaseerde struktuur sonder toesig te leer. Bron: https://arxiv.org/pdf/2304.07193

CompleteMe spreek hierdie aspek aan deur 'n gespesialiseerde verwysings-U-Net wat geïnisialiseer is vanaf Stabiele diffusie 1.5, maar werk sonder die diffusie geraas stap*.

Elke verwysingsbeeld, wat verskillende liggaamsgebiede dek, word deur hierdie U-Net in gedetailleerde latente kenmerke geënkodeer. Globale semantiese kenmerke word ook afsonderlik onttrek met behulp van CLIP, en beide stelle kenmerke word in die kas gestoor vir doeltreffende gebruik tydens aandaggebaseerde integrasie. Dus kan die stelsel verskeie verwysingsinsette buigsaam akkommodeer, terwyl fynkorrelige voorkomsinligting behoue bly.

orkestrasie

Die samehangende U-Net bestuur die finale stadiums van die voltooiingsproses. Aangepas vanaf die inskildervariant van Stabiele Diffusie 1.5, neem dit die gemaskerde bronbeeld in latente vorm as invoer, tesame met gedetailleerde ruimtelike kenmerke wat uit die verwysingsbeelde getrek is en globale semantiese kenmerke wat deur die CLIP-enkodeerder onttrek is.

Hierdie verskillende insette word deur die RFA-blok bymekaar gebring, wat 'n kritieke rol speel om die model se fokus na die mees relevante areas van die verwysingsmateriaal te stuur.

Voordat die aandagmeganisme betree word, word die verwysingskenmerke eksplisiet gemasker om onverwante streke te verwyder en dan saamgevoeg met die latente voorstelling van die bronbeeld, om te verseker dat die aandag so presies as moontlik gerig word.

Om hierdie integrasie te verbeter, bevat CompleteMe 'n ontkoppelde kruis-aandagmeganisme wat aangepas is vanaf die IP-adapter raamwerk:

IP-Adapter, waarvan 'n deel in CompleteMe opgeneem is, is een van die suksesvolste en mees gebruikte projekte van die afgelope drie onstuimige jare van ontwikkeling in latente diffusiemodelargitekture. Bron: https://ip-adapter.github.io/

Dit laat die model toe om ruimtelik gedetailleerde visuele kenmerke en breër semantiese konteks te verwerk deur afsonderlike aandagstrome, wat later gekombineer word, wat lei tot 'n samehangende rekonstruksie wat, volgens die outeurs, beide identiteit en fynkorrelige detail bewaar.

Benchmarking

In die afwesigheid van 'n gepaste datastel vir verwysingsgebaseerde menslike voltooiing, het die navorsers hul eie voorgestel. Die (naamlose) maatstaf is opgestel deur geselekteerde beeldpare uit die WPose-datastel te kureer wat vir Adobe Research se 2023 ontwerp is. UniHuman projek.

Voorbeelde van posisies uit die Adobe Research 2023 UniHuman-projek. Bron: https://github.com/adobe-research/UniHuman?tab=readme-ov-file#data-prep

Die navorsers het bronmaskers handmatig geteken om die inskilderingsareas aan te dui, en uiteindelik 417 drieledige beeldgroepe verkry wat 'n bronbeeld, masker en verwysingsbeeld vorm.

Twee voorbeelde van groepe wat aanvanklik afgelei is van die verwysings-WPose-datastel, en breedvoerig saamgestel is deur die navorsers van die nuwe artikel.

Die outeurs het gebruik gemaak van die LLaVA Groot Taalmodel (LLM) om teksaanwysings te genereer wat die bronbeelde beskryf.

Die gebruikte metrieke was meer uitgebreid as gewoonlik; benewens die gewone Piek sein-tot-geraas-verhouding (PSNR), Strukturele Eendersindeks (SSIM) en Aangeleerde Perseptuele Beeld-patch-ooreenkoms (LPIPS, in hierdie geval vir die evaluering van gemaskerde streke), het die navorsers DINO vir ooreenkomstellings gebruik; DroomSim vir die evaluering van genereringsresultate; en CLIP.

Data en toetse

Om die werk te toets, het die outeurs beide die standaard Stable Diffusion V1.5-model en die 1.5-inkleurmodel gebruik. Die stelsel se beeldenkodeerder het die CLIP-model gebruik. visie model, tesame met projeksielae – beskeie neurale netwerke wat die CLIP-uitsette hervorm of in lyn bring om by die interne kenmerkdimensies wat deur die model gebruik word, te pas.

Opleiding het plaasgevind vir 30,000 100 iterasies oor agt NVIDIA AXNUMX† GPU's, onder toesig van Gemiddelde kwadraatfout (MSE) verlies, teen 'n bondel grote van 64 en a leertempo van 2 × 10-5Verskeie elemente is lukraak tydens opleiding laat vaar om te verhoed dat die stelsel oorpas op die gegewens.

Die datastel is gewysig vanaf die Dele tot Geheel datastel, self gebaseer op die DeepFashion-MultiModal datastel.

Voorbeelde uit die Dele na Geheel-datastel, wat gebruik is in die ontwikkeling van die saamgestelde data vir CompleteMe. Bron: https://huanngzh.github.io/Parts2Whole/

Die skrywers sê:

Om aan ons vereistes te voldoen, het ons die oefenpare [herbou] deur gebruik te maak van versteekte beelde met veelvuldige verwysingsbeelde wat verskeie aspekte van menslike voorkoms saam met hul kort teksetikette vasvang.

'Elke steekproef in ons opleidingsdata sluit ses voorkomstipes in: bolyfklere, onderlyfklere, hele lyfklere, hare of hoofbedekkings, gesig en skoene. Vir die maskerstrategie pas ons 50% ewekansige roostermaskering tussen 1 en 30 keer toe, terwyl ons vir die ander 50% 'n menslike liggaamsvormmasker gebruik om maskeringskompleksiteit te verhoog.'

'Na die konstruksiepyplyn het ons 40,000 XNUMX beeldpare vir opleiding verkry.'

Mededinger vorige nie-verwysing metodes wat getoets is, was Groot versperde menslike beeldvoltooiing (LOHC) en die inprop-en-speel-beeldinskildermodel BorselNet; verwysingsgebaseerde modelle wat getoets is, was Verf-vir-Voorbeeld; EnigeDeur; Links HervulEn Nabootsborsel.

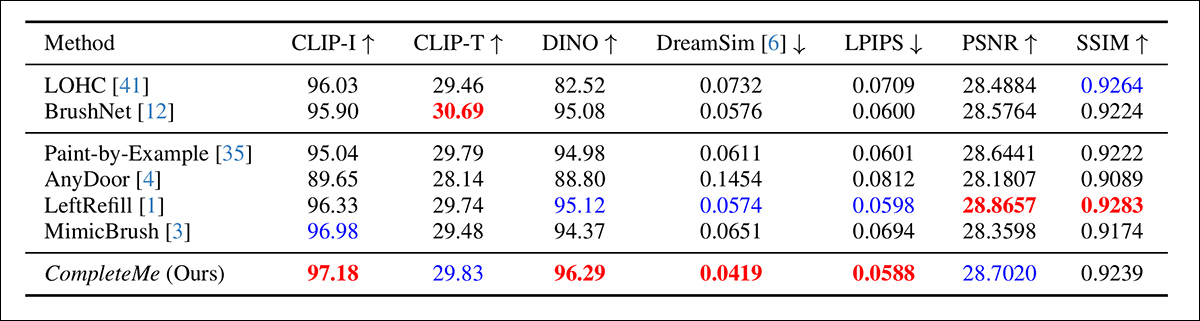

Die outeurs het begin met 'n kwantitatiewe vergelyking op die voorheen genoemde statistieke:

Resultate vir die aanvanklike kwantitatiewe vergelyking.

Wat die kwantitatiewe evaluering betref, merk die outeurs op dat CompleteMe die hoogste tellings op die meeste perseptuele metrieke behaal, insluitend CLIP-I, DINO, DreamSim en LPIPS, wat bedoel is om semantiese belyning en voorkomsgetrouheid tussen die uitvoer en die verwysingsbeeld vas te lê.

Die model presteer egter nie beter as alle basislyne nie. Dit is opmerklik dat BrushNet die hoogste punte behaal op CLIP-T, LeftRefill die beste in SSIM en PSNR, en MimicBrush effens beter presteer op CLIP-I.

Alhoewel CompleteMe oor die algemeen konsekwent sterk resultate toon, is die prestasieverskille in sommige gevalle beskeie, en sekere statistieke word steeds gelei deur mededingende vorige metodes. Miskien nie onregverdig nie, beskou die outeurs hierdie resultate as bewys van CompleteMe se gebalanseerde sterkte oor beide strukturele en perseptuele dimensies.

Illustrasies vir die kwalitatiewe toetse wat vir die studie onderneem is, is heeltemal te veel om hier weer te gee, en ons verwys die leser nie net na die bronartikel nie, maar ook na die uitgebreide aanvullende PDF, wat baie bykomende kwalitatiewe voorbeelde bevat.

Ons beklemtoon die primêre kwalitatiewe voorbeelde wat in die hoofartikel aangebied word, tesame met 'n seleksie van bykomende gevalle wat uit die aanvullende beeldpoel getrek is wat vroeër in hierdie artikel bekendgestel is:

Aanvanklike kwalitatiewe resultate word in die hoofartikel aangebied. Verwys asseblief na die bronartikel vir 'n beter resolusie.

Van die kwalitatiewe resultate wat hierbo getoon word, lewer die outeurs die volgende kommentaar:

Gegewe gemaskerde insette, genereer hierdie nie-verwysingsmetodes geloofwaardige inhoud vir die gemaskerde streke deur gebruik te maak van beeld-priors of teksaanwysings.

'Soos in die Rooi blokkie aangedui, kan hulle egter nie spesifieke besonderhede soos tatoeëermerke of unieke kledingpatrone reproduseer nie, aangesien hulle nie verwysingsbeelde het om die rekonstruksie van identiese inligting te lei nie.'

'n Tweede vergelyking, waarvan 'n deel hieronder getoon word, fokus op die vier verwysingsgebaseerde metodes Paint-by-Example, AnyDoor, LeftRefill en MimicBrush. Hier is slegs een verwysingsbeeld en 'n teksprompt verskaf.

Kwalitatiewe vergelyking met verwysingsgebaseerde metodes. CompleteMe lewer meer realistiese voltooiings en bewaar spesifieke besonderhede van die verwysingsbeeld beter. Die rooi blokkies beklemtoon areas van besondere belang.

Die skrywers sê:

Gegewe 'n gemaskerde menslike beeld en 'n verwysingsbeeld, kan ander metodes geloofwaardige inhoud genereer, maar misluk dikwels om kontekstuele inligting uit die verwysing akkuraat te bewaar.

'In sommige gevalle genereer hulle irrelevante inhoud of karteer hulle ooreenstemmende dele verkeerd van die verwysingsbeeld. In teenstelling hiermee voltooi CompleteMe die gemaskerde gebied effektief deur identiese inligting akkuraat te bewaar en ooreenstemmende dele van die menslike liggaam korrek van die verwysingsbeeld te karteer.'

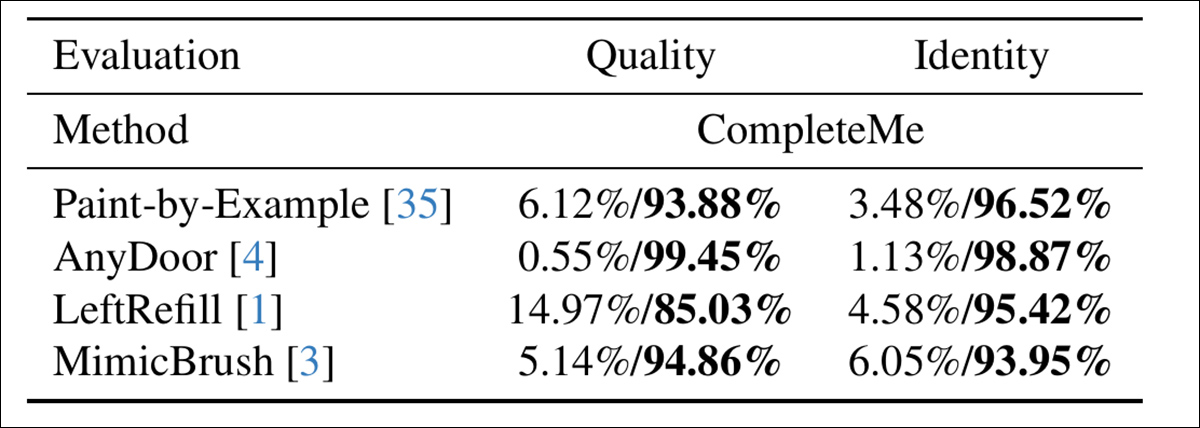

Om te bepaal hoe goed die modelle met menslike persepsie ooreenstem, het die outeurs 'n gebruikersstudie uitgevoer met 15 annoteerders en 2,895 XNUMX steekproefpare. Elke paar het die uitset van CompleteMe vergelyk met een van vier verwysingsgebaseerde basislyne: Paint-by-Example, AnyDoor, LeftRefill of MimicBrush.

Annoteerders het elke resultaat geëvalueer op grond van die visuele kwaliteit van die voltooide streek en die mate waarin dit identiteitskenmerke van die verwysing behoue gehou het – en hier, deur die algehele kwaliteit en identiteit te evalueer, het CompleteMe 'n meer definitiewe resultaat verkry:

Resultate van die gebruikersstudie.

Gevolgtrekking

Indien enigiets, word die kwalitatiewe resultate in hierdie studie ondermyn deur hul blote omvang, aangesien noukeurige ondersoek aandui dat die nuwe stelsel 'n baie effektiewe toetrede is tot hierdie relatief nis- maar gewilde gebied van neurale beeldbewerking.

Dit verg egter 'n bietjie ekstra sorg en inzoomen op die oorspronklike PDF om te waardeer hoe goed die stelsel die verwysingsmateriaal aanpas by die versperde area in vergelyking (in byna alle gevalle) met vorige metodes.

Ons beveel die leser sterk aan om die aanvanklik verwarrende, indien nie oorweldigende, stortvloed van resultate wat in die aanvullende materiaal aangebied word, noukeurig te ondersoek.

* Dit is interessant om daarop te let hoe die nou erg verouderde V1.5-weergawe steeds 'n gunsteling van navorsers is – deels as gevolg van ou soortgelyke toetse, maar ook omdat dit die minste gesensor en moontlik die maklikste opleibare van al die Stabiele Diffusie-iterasies is, en nie die ... deel nie. sensurerende hink van die FOSS Flux-vrystellings.

† VRAM-spesifikasie nie gegee nie – dit sou óf 40GB óf 80GB per kaart wees.

Eerste gepubliseer Dinsdag, 29 April 2025